NEWS

ioBroker sehr hohe Diskwrites in Proxmox

-

@crunchip

Hallo, die Diskussion hat mich angeregt, auch mein System zu überprüfen.

Ich setze zwei Proxmox-Nodes ein (Intel NUC6 und Intel NUC8).

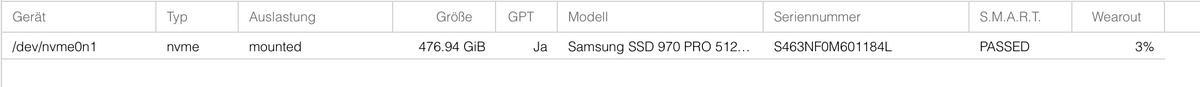

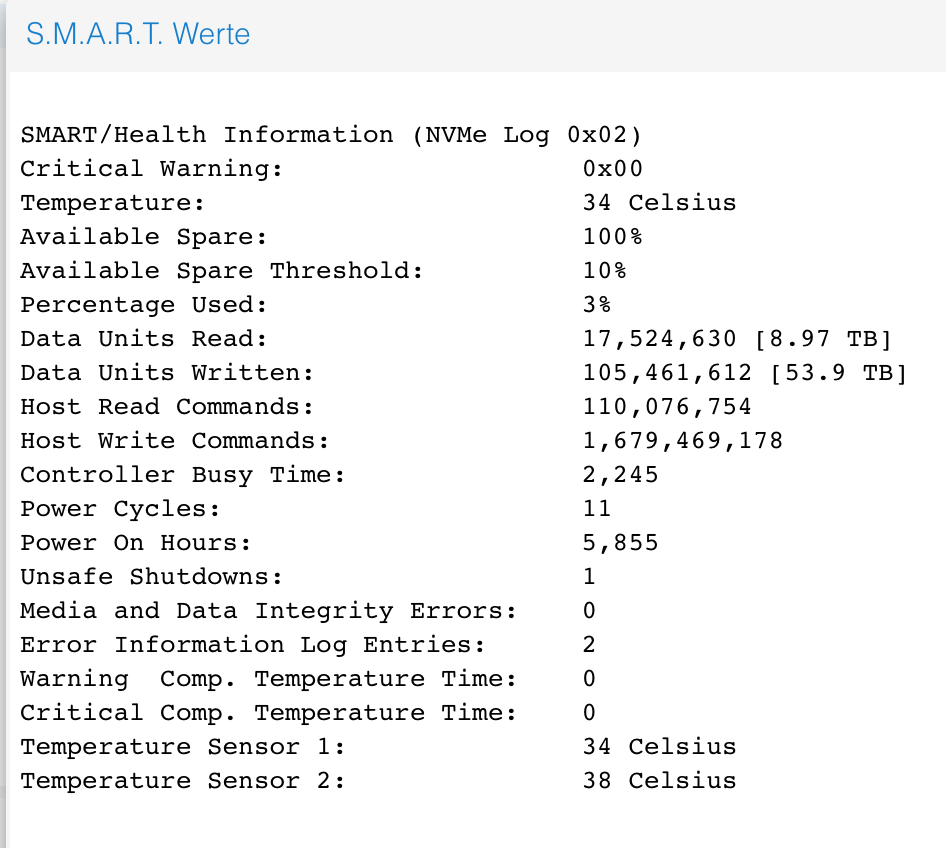

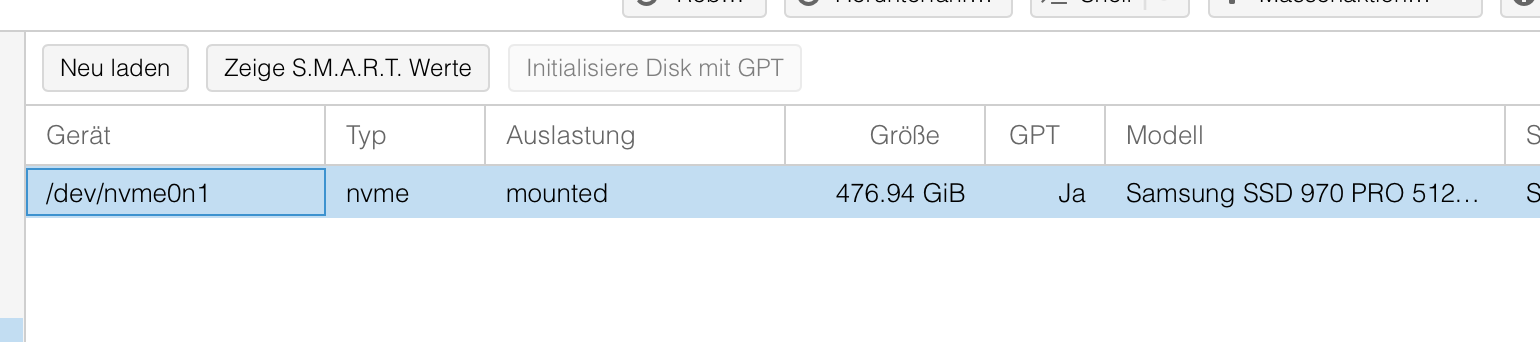

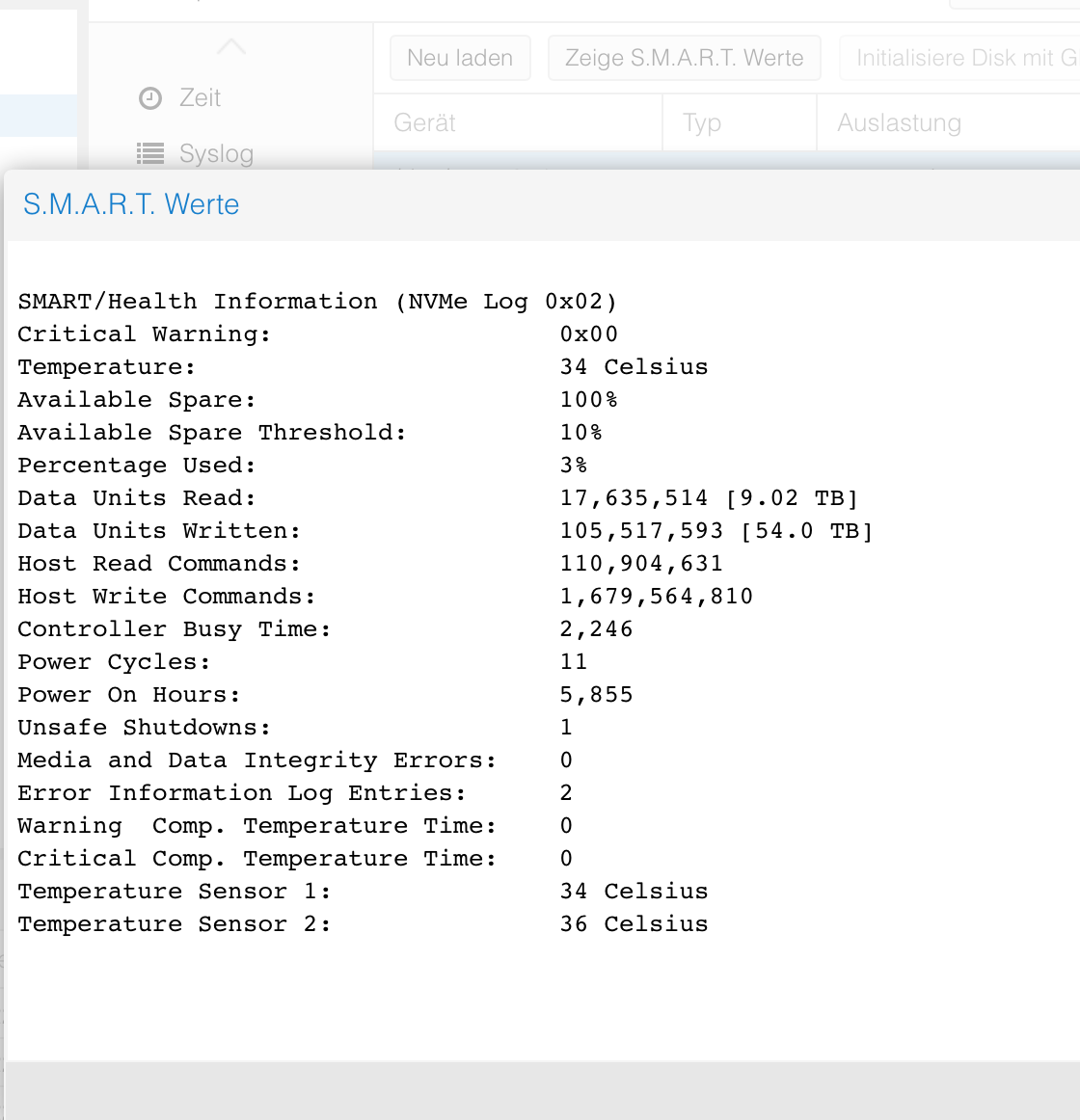

Der neuere Nuc8 (Gekauft Ende 2019) hat eine Samsung 500GB SSD (970Pro).Der Wert für Wearout liegt bei 3%.

Das sieht für mich kritisch aus!

Die 2 Jahre ältere SSD im Nuc6 (Cruxial 250GB) zeigt 42% an.

Nun mache ich mir nach der Diskussion Sorgen um die Datensicherheit.

Hier die Smart-Werte:

Das heißt, das System hat seit Ende 2019 53 TB geschrieben.

Meine Frage jetzt an die Experten: Ich würde gerne die SSD tauschen. In den Foren habe ich viel über Probleme beim Klonen gelesen, das z.B. der GPT nicht sauber oder gar nicht mit kopiert wird.

Da ich zwei Nodes habe, hier eine konkrete Frage:

Ich könnte die VMs auf den Node1 verschieben und den Node2 neu mit der Proxmox Boot-Stick erzeugen. Danach die Nodes miteinander verknüpfen und die Maschinen wieder rüberschicken.Würde das so gehen? Oder macht ihr das anders?

Danach muss ich dann das Problem der heftigen Schreibvorgänge angenommen.

Bitte hier um Unterstützung.

-

Warum sind in einem guten Jahr 3% wearout kritisch?

Und wie kann man diese smart Werte anzeigen? Ich kenne nur die unter pve —> disks

-

@saeft_2003

Hier war ja dieser Beitrag:

https://www.thomas-krenn.com/de/wiki/SMART_Attribute_von_Intel_SSDsDas heißt, der Wert sinkt von guten 100% auf 0%. Daher meine Rückfrage zum Austausch der SSD.

Vielleicht habe ich es auch total falsch verstanden?

-

@martybr sagte: das System hat seit Ende 2019 53 TB geschrieben.

Das ist bei 600 TBW (laut Samsung) nicht zu viel.

-

-

@martybr sagte in ioBroker sehr hohe Diskwrites in Proxmox:

@saeft_2003

In Proxmox - Disks - Kannst du auf Smart Werte anzeigen klicken

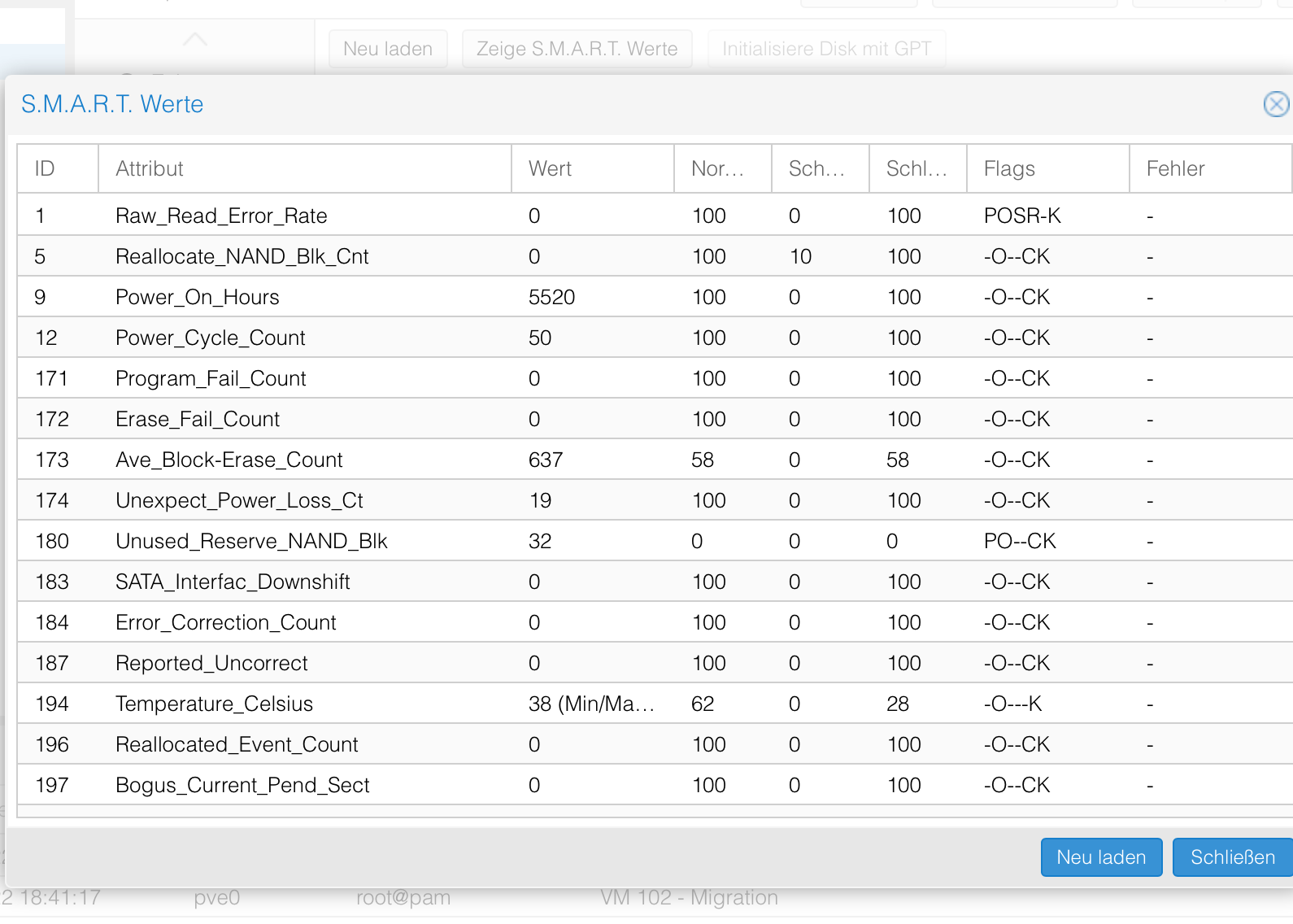

Ok das weiß ich bei mir sieht es aber anders aus...

-

@saeft_2003

Bei meiner Cruxial sieht es auch anders aus:

Beide Frage zieht auf Wearout = 3%

Hier mache ich mir Sorgen, ob die SSD nicht bald ausfällt.

-

@martybr sagte in ioBroker sehr hohe Diskwrites in Proxmox:

@saeft_2003

Hier war ja dieser Beitrag:

https://www.thomas-krenn.com/de/wiki/SMART_Attribute_von_Intel_SSDsDas heißt, der Wert sinkt von guten 100% auf 0%. Daher meine Rückfrage zum Austausch der SSD.

Vielleicht habe ich es auch total falsch verstanden?

Da steht folgendes:

Gibt die Anzahl der bisherigen Schreib-Lösch-Zyklen des NAND-Speichers an. Der normalisierte Wert sinkt linear von 100 bis auf 1, während die Zahl der durchschnittlichen Löschzyklen von 0 bis zum Nennwert für die Höchstzahl der Zyklen ansteigt. Nach dem Erreichen des normalisierten Werts 1 sinkt die Zahl nicht weiter, obwohl es wahrscheinlich ist, dass das Laufwerk auch noch deutlich höherer Abnutzung ausgesetzt werden könnte.

Dieser Wert ist bei mir auf 100 und bei wearout in der Übersicht zeigt mir proxmox 0% an.

-

-

Also ich deute das so, bin aber sicherlich kein Profi.

Vielleicht kann das jemand nochmal aufklären?

-

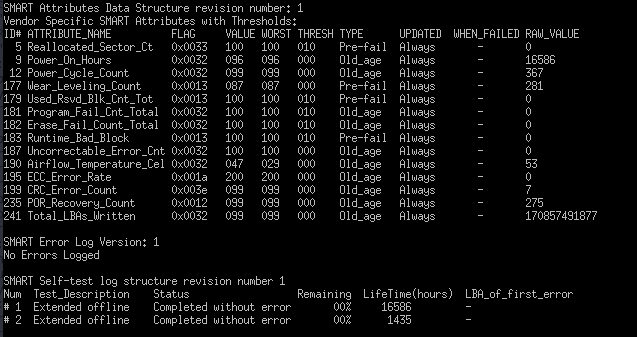

ich lass mal bei einer Platte

smartctllaufen, dauert ca 80 min, mal vergleichen ob das übereinstimmt, mit dem, was in Proxmox angezeigt wird.Während dessen, auf die Suche nach Adapter bzw Scripten machen

Edit:

smartctl hat hat nichts besonderes ergeben und deckt sich mit der Ausgabe in Proxmox

-

@martybr sagte in ioBroker sehr hohe Diskwrites in Proxmox:

erstmal keine Sorgen machen.

spätestens wenn in der Spalte S.M.A.R.T was anderes als PASSED steht, solltest du dir Gedanken machen, bzw Handeln

-

@crunchip

Okay, danke. Ich werde trotzdem die SSD tauschen. Ich habe mir eine 1TB SSD bestellt. Die kommt dann in den Haupt-Node rein, die 500 GB geht dann in meinen zweiten Node.Meine Idee zum Wechsel:

Ich verschiebe die VMs auf den "Reserve"-Proxmox-Node.

Installation von Proxmox auf der freigewordenen Maschine

Beide Systeme wieder verknüpfen

Die VMs zurück schieben.Was meint ihr dazu? Kann das erfolgreich umgesetzt werden?

-

@martybr sagte in ioBroker sehr hohe Diskwrites in Proxmox:

Was meint ihr dazu? Kann das erfolgreich umgesetzt werden?

sollte so funktionieren

-

@crunchip Dann setze ich da morgen mal dran.

Danke für die Ratschläge.

-

@paul53 also zumindest, so wie ich es sehe, wird die objects.json in unregelmässigen Abständen geändert, also kein fester Zyklus. Jedoch noch keinen Grund gefunden.

Jetzt fasse ich aber trotzdem nochmal kurz zusammen.

- wie sich die objects.json vor dem 15.01.21 verhalten hat, weiß ich nicht

- seit dem 15.01. hab ich diese hohen i/o, davor lief alles piano, ohne Auffälligkeiten

- ab diesem Tag wurde der Js-controller und alle dazu benötigten Adapter(admin, web, socket...) upgedatet

- es kamen keine neuen Adapter dazu, es wurden lediglich, die Updates der bestehenden Adapter ausgeführt

- es wurden auch keine neuen Scripte erstellt, keine aktiviert oder geändert

wenn ich redis auch für Objekte aktiviere, sollte es vermutlich etwas besser laufen?

-

Kann es auch hilfreich sein die Zeitplanung der einzelnen Instanzen zu prüfen / hinterfragen. Ich hab z.B. 5 ical Instanzen, welche bisher alle 15 min. gescheduled wurden. Gerade bei Geburtstagsterminen oder Müllkalendern ist ja sowas eher in der Häuffigkeit unnötig. Ich hab dies jetzt mal bei mir geändert und werde mal schauen ob und wie sich das Schreibverhalten ändert.

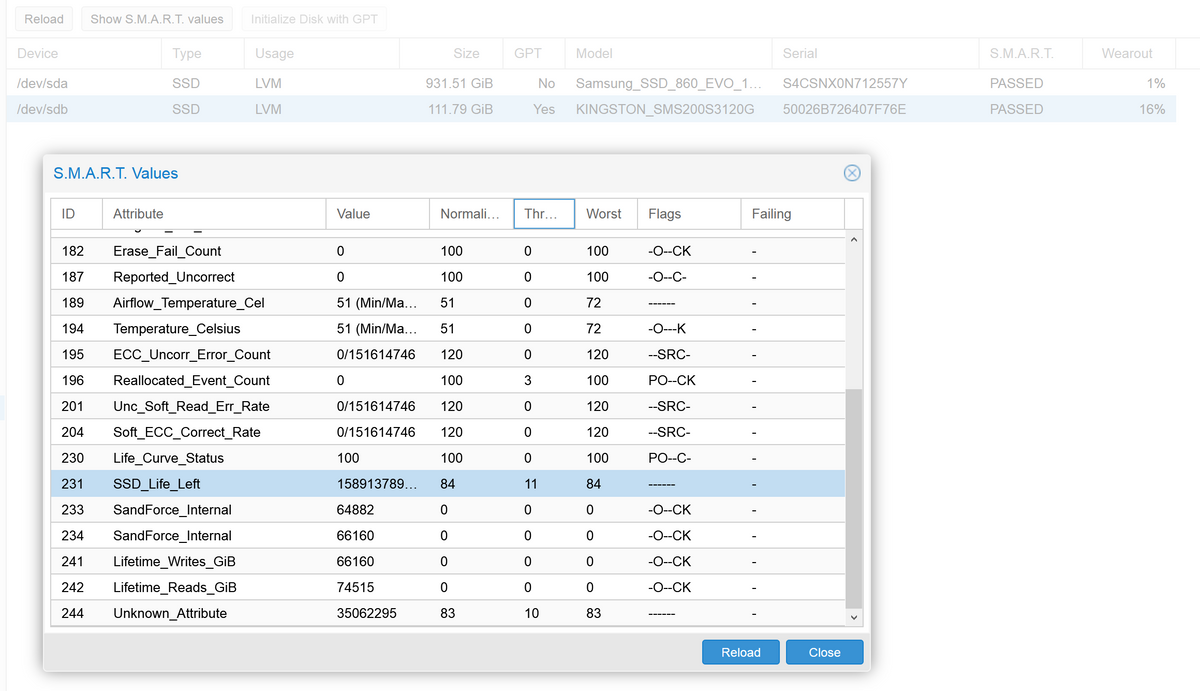

Meine "sdb" SSD ist jetzt seit knapp 4 Jahren im Einsatz und zeigt einen Wearout von 16% an.

Die "sda" SSD ist erst ein paar Monate alt.Ich hab mit der Veröffentlichung von js-controller 3.2.x eine "ioBroker Testumgebung" aufgesetzt. Bei dieser habe ich aktuell folgende Schreibwerte:

-

@martybr sagte in ioBroker sehr hohe Diskwrites in Proxmox:

Ich werde trotzdem die SSD tauschen

Was habe ich denn jetzt nicht verstanden?

Ein Wearout von 3% in einem Jahr gibt rein rechnerisch noch eine Lebensdauer von 30 Jahren, bis der Wearout 100% erreicht hat -

@crunchip sagte in ioBroker sehr hohe Diskwrites in Proxmox:

@paul53 also zumindest, so wie ich es sehe, wird die objects.json in unregelmässigen Abständen geändert, also kein fester Zyklus. Jedoch noch keinen Grund gefunden.

Im Prinzip habe ich das gleiche Problem (zumindest in Bezug auf den Stress der SSD), object.json ist deutlich grösser als states.json, wird aber genauso oft neu geschrieben.

Theoretisch sollte sich ein Hinweis auf die Ursache finden lassen, wenn man die Unterschiede zwischen objects.json und objects.json.bak sinnvoll extrahieren könnte. Fürchte aber, da müsste man erst bissel basteln mit json und diff o.ä.wenn ich redis auch für Objekte aktiviere, sollte es vermutlich etwas besser laufen?

Ja, da kannst du ja die Schreibfrequenz beliebig niedrig einstellen (allerdings auf Kosten der Datensicherheit - wenn die Kiste abschmiert mit 5 Minuten Daten im Redis-Ram, sind die dann halt weg. Muss man abwägen)

-

@jleg muss ich mir mal durch den Kopf gehen lassen, ob ich die Objekte auch auf redis umstelle.

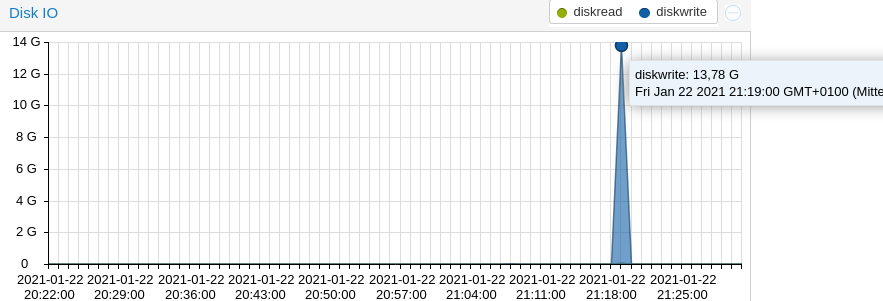

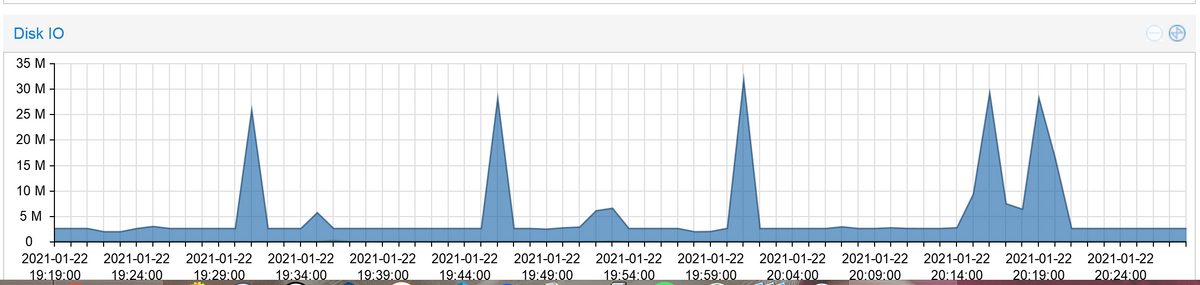

zu meinen Ausuferungen des i/o von 8G aufwärts, habe ich einen verdacht auf den Unifi Adapter.

Und zwar habe ich dieses gefunden, bzw ist gerade aufgetaucht, was zeitlich übereinstimmt. Ich kenne zwar die Meldung, bekomme sie aber nicht weg.unifi.0 2021-01-22 21:19:02.936 error (1876) Error: Login required. Check username and password. unifi.0 2021-01-22 21:19:02.639 error (1876) Error: Login required. Check username and password.