NEWS

-

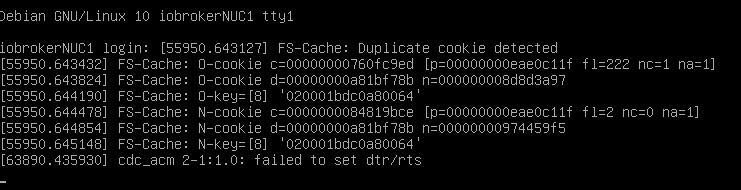

Systemdata Bitte Ausfüllen Hardwaresystem: NUC Arbeitsspeicher: 8 GB Festplattenart: SSD Betriebssystem: Ubuntu Debian 10 Node-Version: 14.19.3 Nodejs-Version: 14.19.3 NPM-Version: 614.17 Installationsart: Skript/Manuell Image genutzt: Ja/Nein Ort/Name der Imagedatei: Link Nach dem Update auf node 14.19. kam die Fehlermeldung das Zigbee einen rebulid benötigt. Das habe ich angestartet und wurde nach einiger Zeit über Putty getrennt. Nun bekomme ich dei Proxmox VM nicht mehr gestartet und über die Proxmox Konsole nur das hier angezeigt

Ideee was passiert ist und wie man das reparieren kann?

https://forum.iobroker.net/topic/53854/nach-nodejs-update-16-x-startet-zigbee-nicht-mehr/9@toki1973 was ...ein npm rebuild verursaht das nicht.. du hast ein anderes problem.

https://forum.proxmox.com/threads/fehlermeldung-auf-der-konsole-der-vm.84349/

-

Systemdata Bitte Ausfüllen Hardwaresystem: NUC Arbeitsspeicher: 8 GB Festplattenart: SSD Betriebssystem: Ubuntu Debian 10 Node-Version: 14.19.3 Nodejs-Version: 14.19.3 NPM-Version: 614.17 Installationsart: Skript/Manuell Image genutzt: Ja/Nein Ort/Name der Imagedatei: Link Nach dem Update auf node 14.19. kam die Fehlermeldung das Zigbee einen rebulid benötigt. Das habe ich angestartet und wurde nach einiger Zeit über Putty getrennt. Nun bekomme ich dei Proxmox VM nicht mehr gestartet und über die Proxmox Konsole nur das hier angezeigt

Ideee was passiert ist und wie man das reparieren kann?

https://forum.iobroker.net/topic/53854/nach-nodejs-update-16-x-startet-zigbee-nicht-mehr/9@toki1973 starte Proxmox mal neu, hatte kürzlich auch ein ähnliches Problem im laufenden Betrieb, VM konnte ich dadurch auch nicht mehr herunter fahren.

-

@toki1973 starte Proxmox mal neu, hatte kürzlich auch ein ähnliches Problem im laufenden Betrieb, VM konnte ich dadurch auch nicht mehr herunter fahren.

Dank für eure Rückmeldungen!

Ich habe zumindest den Zustand vor dem Update herstellen können über einen Snapshot.Werde es nochmals versuchen, denke aber dass das gleiche Problem wieder auftritt. Ist es ein Unterschied wenn ich nach der Installation wenn Zigbee die Versionsprobleme meldet iobroker rebuild oder npm rebuild durchführe?

Ich habe keinen Conbee Stick sondern das TI Board für Zigbee im Einsatz

-

Es ist ein Proxmox Speicher Problem, das auftritt wenn ich die Updates durchführe und der Platz knapp wird. Ein I/O Problem wird beim Status des Proxmox VN angezeigt in der ioBroker läuft.

Kann mir jemand Tips geben was zu zun ist?

WARNING: You have not turned on protection against thin pools running out of space. WARNING: Set activation/thin_pool_autoextend_threshold below 100 to trigger automatic extension of thin pools before they get full. Logical volume "vm-102-disk-0" created WARNING: Sum of all thin volume sizes (<407.58 GiB) exceeds the size of thin pool pve/data and the size of whole volume group (237.97 GiB) -

Es ist ein Proxmox Speicher Problem, das auftritt wenn ich die Updates durchführe und der Platz knapp wird. Ein I/O Problem wird beim Status des Proxmox VN angezeigt in der ioBroker läuft.

Kann mir jemand Tips geben was zu zun ist?

WARNING: You have not turned on protection against thin pools running out of space. WARNING: Set activation/thin_pool_autoextend_threshold below 100 to trigger automatic extension of thin pools before they get full. Logical volume "vm-102-disk-0" created WARNING: Sum of all thin volume sizes (<407.58 GiB) exceeds the size of thin pool pve/data and the size of whole volume group (237.97 GiB)@toki1973 zufällig snapshots angelegt,dann löschen

Andernfalls gibt es hier 2 Threads die das Thema behandeln -

Naja der eine Snapshot den ich im iobroker vm habe hat mich nun schon 2x gerettet.

Bisher habe ich noch keinen Thread gefunden der das Thema thin pool pve behandelt.@toki1973 sagte in Proxmox Fehler nach rebuild:

Bisher habe ich noch keinen Thread gefunden der das Thema thin pool pve behandelt.

https://forum.iobroker.net/search?term=thin pool pve &in=titlesposts

-

Naja der eine Snapshot den ich im iobroker vm habe hat mich nun schon 2x gerettet.

Bisher habe ich noch keinen Thread gefunden der das Thema thin pool pve behandelt.@toki1973 snapshot ist kein backup, ein backup erstellen und zurückspielen, im zweifelsfall rettet dich das ebenso und dauert auch nicht viel länger.

-

@toki1973 snapshot ist kein backup, ein backup erstellen und zurückspielen, im zweifelsfall rettet dich das ebenso und dauert auch nicht viel länger.

@crunchip Danke. Es schient so als ob ich das gleiche Problem mit der Speicherbelegung habe. Aber so ganz genau kann ich im verlinkten Thread nicht nachvollziehen wir ich vorgehen kann.

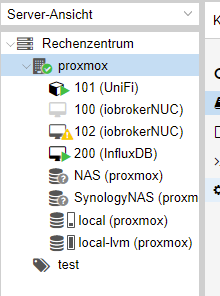

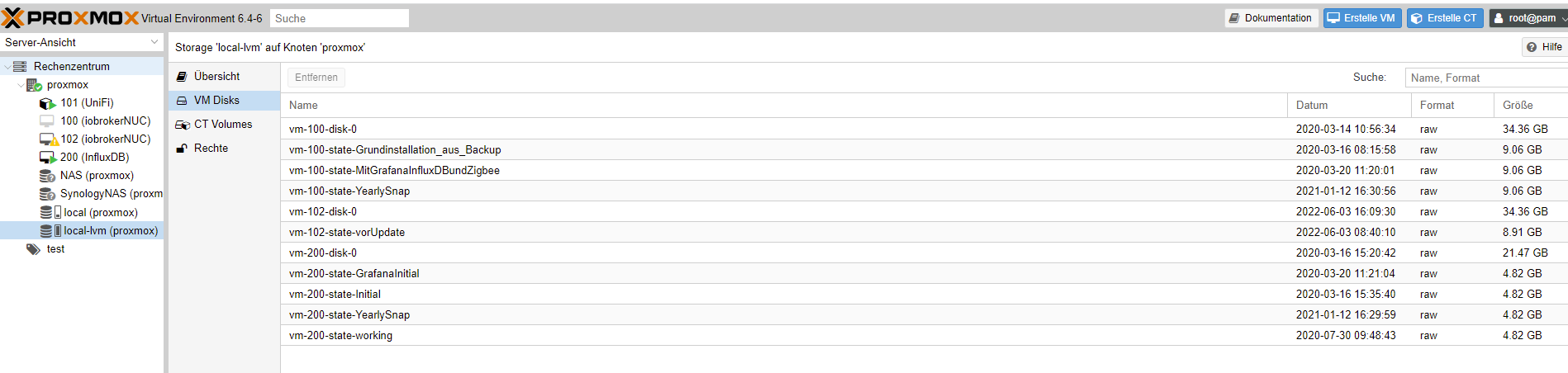

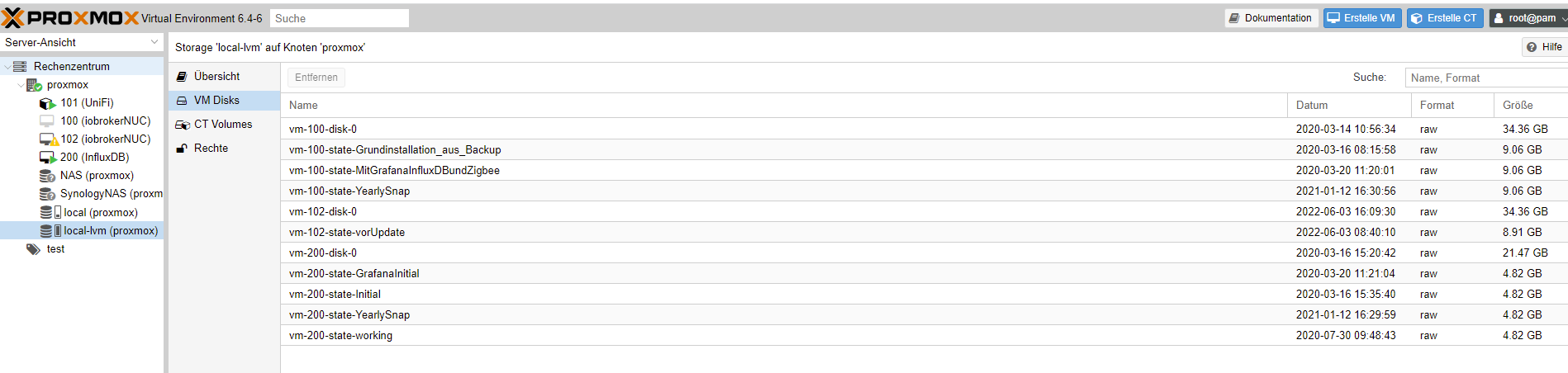

Hier mal ein paar infos zu meiner Konfiguration.root@proxmox:~# lvm lvm> root@proxmox:~# lvs LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert data pve twi-aotzD- <152.61g 100.00 5.85 root pve -wi-ao---- 59.25g snap_vm-100-disk-0_Grundinstallation_aus_Backup pve Vri---tz-k 32.00g data vm-100-disk-0 snap_vm-100-disk-0_MitGrafanaInfluxDBundZigbee pve Vri---tz-k 32.00g data vm-100-disk-0 snap_vm-100-disk-0_YearlySnap pve Vri---tz-k 32.00g data vm-100-disk-0 snap_vm-101-disk-0_Working pve Vri---tz-k 32.00g data vm-101-disk-0 snap_vm-102-disk-0_vorUpdate pve Vri---tz-k 32.00g data snap_vm-200-disk-0_GrafanaInitial pve Vri---tz-k 20.00g data vm-200-disk-0 snap_vm-200-disk-0_Initial pve Vri---tz-k 20.00g data vm-200-disk-0 snap_vm-200-disk-0_YearlySnap pve Vri---tz-k 20.00g data vm-200-disk-0 snap_vm-200-disk-0_working pve Vri---tz-k 20.00g data vm-200-disk-0 swap pve -wi-ao---- 7.00g vm-100-disk-0 pve Vwi-a-tz-- 32.00g data 99.87 vm-100-state-Grundinstallation_aus_Backup pve Vwi-a-tz-- 8.44g data 12.37 vm-100-state-MitGrafanaInfluxDBundZigbee pve Vwi-a-tz-- 8.44g data 35.17 vm-100-state-YearlySnap pve Vwi-a-tz-- 8.44g data 51.92 vm-101-disk-0 pve Vwi-aotz-- 32.00g data 34.32 vm-102-disk-0 pve Vwi-aotz-- 32.00g data snap_vm-102-disk-0_vorUpdate 99.51 vm-102-state-vorUpdate pve Vwi-a-tz-- 8.30g data 51.88 vm-200-disk-0 pve Vwi-aotz-- 20.00g data 85.86 vm-200-state-GrafanaInitial pve Vwi-a-tz-- <4.49g data 14.21 vm-200-state-Initial pve Vwi-a-tz-- <4.49g data 37.55 vm-200-state-YearlySnap pve Vwi-a-tz-- <4.49g data 43.57 vm-200-state-working pve Vwi-a-tz-- <4.49g data 23.40 root@proxmox:~#

Die 100er lvm war meine alte Konfiguration. diese läßt sich aber nicht löschen:

-

@crunchip Danke. Es schient so als ob ich das gleiche Problem mit der Speicherbelegung habe. Aber so ganz genau kann ich im verlinkten Thread nicht nachvollziehen wir ich vorgehen kann.

Hier mal ein paar infos zu meiner Konfiguration.root@proxmox:~# lvm lvm> root@proxmox:~# lvs LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert data pve twi-aotzD- <152.61g 100.00 5.85 root pve -wi-ao---- 59.25g snap_vm-100-disk-0_Grundinstallation_aus_Backup pve Vri---tz-k 32.00g data vm-100-disk-0 snap_vm-100-disk-0_MitGrafanaInfluxDBundZigbee pve Vri---tz-k 32.00g data vm-100-disk-0 snap_vm-100-disk-0_YearlySnap pve Vri---tz-k 32.00g data vm-100-disk-0 snap_vm-101-disk-0_Working pve Vri---tz-k 32.00g data vm-101-disk-0 snap_vm-102-disk-0_vorUpdate pve Vri---tz-k 32.00g data snap_vm-200-disk-0_GrafanaInitial pve Vri---tz-k 20.00g data vm-200-disk-0 snap_vm-200-disk-0_Initial pve Vri---tz-k 20.00g data vm-200-disk-0 snap_vm-200-disk-0_YearlySnap pve Vri---tz-k 20.00g data vm-200-disk-0 snap_vm-200-disk-0_working pve Vri---tz-k 20.00g data vm-200-disk-0 swap pve -wi-ao---- 7.00g vm-100-disk-0 pve Vwi-a-tz-- 32.00g data 99.87 vm-100-state-Grundinstallation_aus_Backup pve Vwi-a-tz-- 8.44g data 12.37 vm-100-state-MitGrafanaInfluxDBundZigbee pve Vwi-a-tz-- 8.44g data 35.17 vm-100-state-YearlySnap pve Vwi-a-tz-- 8.44g data 51.92 vm-101-disk-0 pve Vwi-aotz-- 32.00g data 34.32 vm-102-disk-0 pve Vwi-aotz-- 32.00g data snap_vm-102-disk-0_vorUpdate 99.51 vm-102-state-vorUpdate pve Vwi-a-tz-- 8.30g data 51.88 vm-200-disk-0 pve Vwi-aotz-- 20.00g data 85.86 vm-200-state-GrafanaInitial pve Vwi-a-tz-- <4.49g data 14.21 vm-200-state-Initial pve Vwi-a-tz-- <4.49g data 37.55 vm-200-state-YearlySnap pve Vwi-a-tz-- <4.49g data 43.57 vm-200-state-working pve Vwi-a-tz-- <4.49g data 23.40 root@proxmox:~#

Die 100er lvm war meine alte Konfiguration. diese läßt sich aber nicht löschen:

@toki1973 https://forum.iobroker.net/post/801905

Und warum so viele snaps?

-

@toki1973 https://forum.iobroker.net/post/801905

Und warum so viele snaps?

-

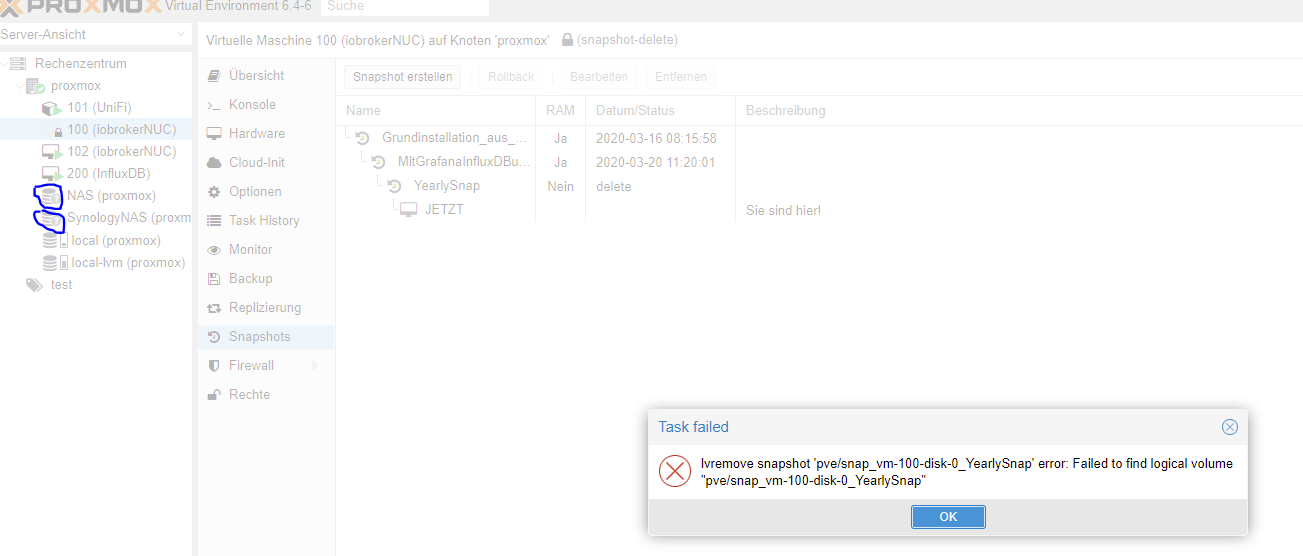

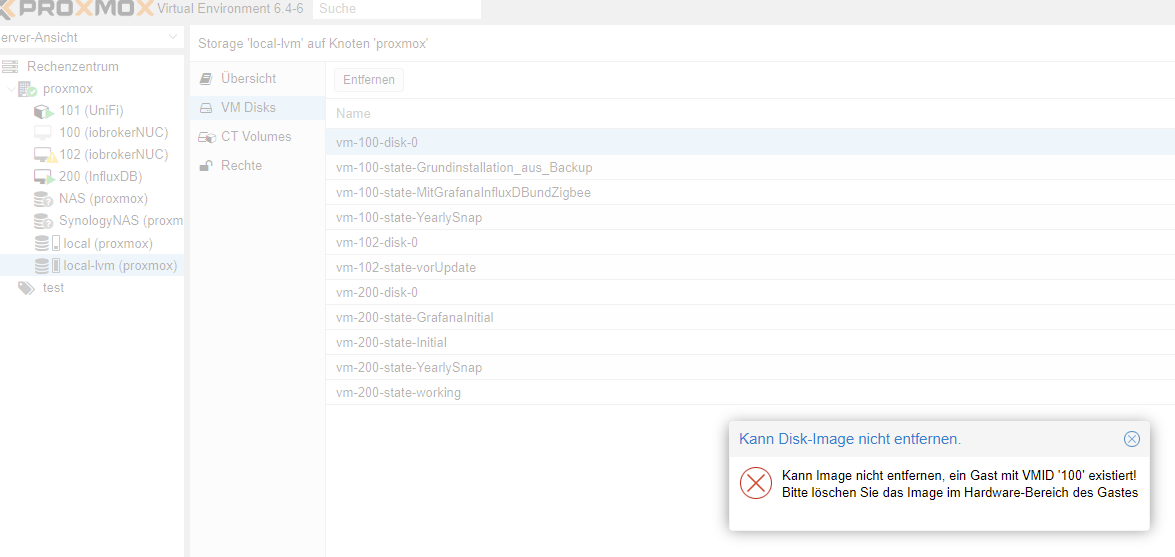

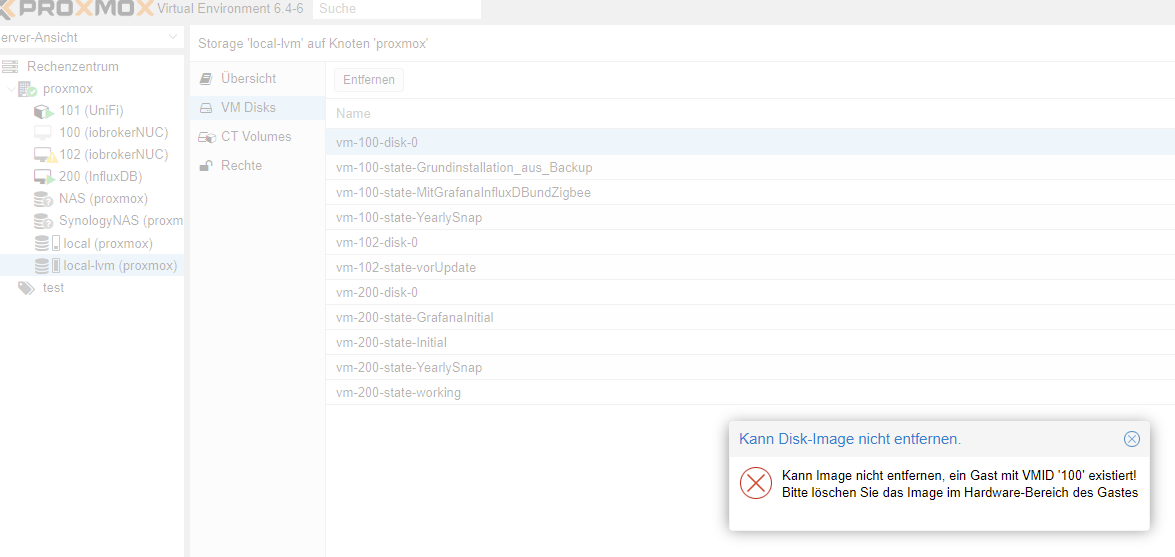

@crunchip Ich würde ja gerne etwas entfernen kann das aber nicht - siehe letzte Screen Shot. Auch die 100 würde ich gerne löschen ist aber nicht möglich.

Was kann ich denn tun? Geht das über die Konsole?@toki1973 sagte in Proxmox Fehler nach rebuild:

kann das aber nicht - siehe letzte Screen Shot

Hast du dir den link durchgelesen, da wird die Meldung behandelt

-

@toki1973 sagte in Proxmox Fehler nach rebuild:

kann das aber nicht - siehe letzte Screen Shot

Hast du dir den link durchgelesen, da wird die Meldung behandelt

-

@crunchip Ja habe ich - aber irgendwie komme ich da nicht ganz zurecht damit. Ich hatte gehofft durch das posten von Screen kann mir jemand konkret das vorgehen beschreiben

@toki1973 sagte in Proxmox Fehler nach rebuild:

das vorgehen beschreiben

Es steh doch genau ab hier (die vmid natürlich an deine Vm Nummer anpassen)

https://forum.iobroker.net/post/803090

Oder schau da https://forum.proxmox.com/threads/solved-nicht-mehr-benutztes-disk-image-von-vm-kann-nicht-gelöscht-werden.75131/pct rescan...für LXC

qm rescan...für VMUnd deinen Threadtitel solltest du anpassen

-

@toki1973 sagte in Proxmox Fehler nach rebuild:

das vorgehen beschreiben

Es steh doch genau ab hier (die vmid natürlich an deine Vm Nummer anpassen)

https://forum.iobroker.net/post/803090

Oder schau da https://forum.proxmox.com/threads/solved-nicht-mehr-benutztes-disk-image-von-vm-kann-nicht-gelöscht-werden.75131/pct rescan...für LXC

qm rescan...für VMUnd deinen Threadtitel solltest du anpassen

@crunchip

Danke für deine Geduld:Ich hatte das hier probiert: 'qm rescan --vmid 100 von https://forum.proxmox.com/threads/solved-nicht-mehr-benutztes-disk-image-von-vm-kann-nicht-gelöscht-werden.75131/

Das ging nicht mit der Fehlermeldung Volume not onlineroot@proxmox:~# qm rescan --vmid 100 rescan volumes... storage 'SynologyNAS' is not online root@proxmox:~# qm rescan --vmid 102 rescan volumes... storage 'SynologyNAS' is not online root@proxmox:~# qm rescan --vmid 200 rescan volumes... storage 'SynologyNAS' is not online root@proxmox:~# qm rescan --vmid 101 rescan volumes... storage 'SynologyNAS' is not online root@proxmox:~#Dieser Fehler kommt dann natürlich auch wenn ich über die GUI auf entfernen gehe

-

@crunchip

Danke für deine Geduld:Ich hatte das hier probiert: 'qm rescan --vmid 100 von https://forum.proxmox.com/threads/solved-nicht-mehr-benutztes-disk-image-von-vm-kann-nicht-gelöscht-werden.75131/

Das ging nicht mit der Fehlermeldung Volume not onlineroot@proxmox:~# qm rescan --vmid 100 rescan volumes... storage 'SynologyNAS' is not online root@proxmox:~# qm rescan --vmid 102 rescan volumes... storage 'SynologyNAS' is not online root@proxmox:~# qm rescan --vmid 200 rescan volumes... storage 'SynologyNAS' is not online root@proxmox:~# qm rescan --vmid 101 rescan volumes... storage 'SynologyNAS' is not online root@proxmox:~#Dieser Fehler kommt dann natürlich auch wenn ich über die GUI auf entfernen gehe

@toki1973 und warum sind beide Nas nicht verbunden?

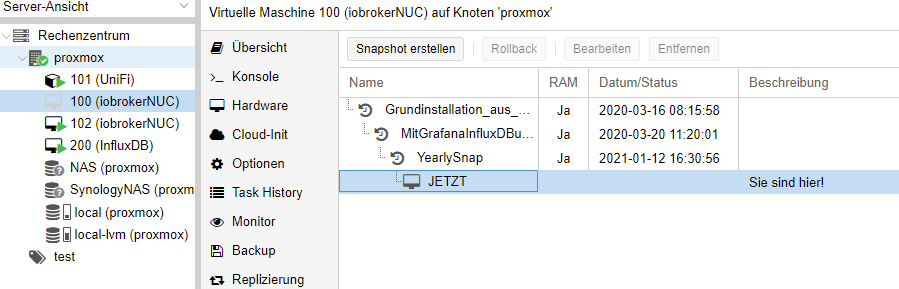

Wenn du den laufenden Lxc bzw Vm anklickst, kannst du doch in der Gui auf snapshot wechseln, zeig mal -

@toki1973 und warum sind beide Nas nicht verbunden?

Wenn du den laufenden Lxc bzw Vm anklickst, kannst du doch in der Gui auf snapshot wechseln, zeig mal -

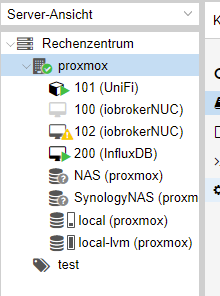

@toki1973 ja, aber irgendwas hast du doch gelöscht, dein local-lvm ist doch laut deinem screen, jetzt nicht mehr voll

-

@toki1973 ja, aber irgendwas hast du doch gelöscht, dein local-lvm ist doch laut deinem screen, jetzt nicht mehr voll

@crunchip

Hat den Snaphot wohl doch gelöscht trotz Fehlermeldung. War dann gelocked aber dazu habe ich auch etwas gefunden.

Aber bevor ich richtige Backups der VMs mache sollte ich noch irgendwie aufräumen. Ich schaue mir nochmal deinen Thread an in dem du @GOETSCHHOFER geholfen hast. Vlt. verstehe ich das Konstrukt dann besser...