NEWS

JS-Controller startet ständig neu (out of mem in Proxmox)

-

Hallo,

ich habe momentan folgendes Problem: Ich habe einen NUC8i5 mit 32GB Ram. Ich hatte bisher einige VMs darauf laufen und nun nach und nach diese auf Container umgestellt, da ich doch festgestellt habe, dass das etwas flotter läuft und wohl auch ressourcenschonender ist. Allerdings habe ich nun bei iobroker Probleme, was ich nicht ganz verstehen kann. Ich bekomme nun in unregelmäßigen Abständen (mehrmals am Tag) die Meldung , dass der JS Controller neu gestartet wurde. Im Proxmox syslog sehe ich dann die Meldung, neustart wegen out of memory, zumindest interpretierre ich das so :

(Dec 19 12:00:04 pve kernel: Memory cgroup out of memory: Killed process 2210726 (iobroker.js-con)

Dec 19 12:00:04 pve kernel: io.socketio.0 invoked oom-killer: gfp_mask=0x100cca(GFP_HIGHUSER_MOVABLE), order=0, oom_score_adj=0 Dec 19 12:00:04 pve kernel: CPU: 6 PID: 2223905 Comm: io.socketio.0 Tainted: P W O 5.13.19-2-pve #1 Dec 19 12:00:04 pve kernel: Hardware name: Intel(R) Client Systems NUC8i5BEH/NUC8BEB, BIOS BECFL357.86A.0087.2020.1209.1115 12/09/2020 Dec 19 12:00:04 pve kernel: Call Trace: Dec 19 12:00:04 pve kernel: dump_stack+0x7d/0x9c Dec 19 12:00:04 pve kernel: dump_header+0x4f/0x1f6 Dec 19 12:00:04 pve kernel: oom_kill_process.cold+0xb/0x10 Dec 19 12:00:04 pve kernel: out_of_memory+0x1cf/0x530 Dec 19 12:00:04 pve kernel: mem_cgroup_out_of_memory+0x139/0x150 Dec 19 12:00:04 pve kernel: try_charge+0x6f6/0x750 Dec 19 12:00:04 pve kernel: __mem_cgroup_charge+0x3e/0xb0 Dec 19 12:00:04 pve kernel: mem_cgroup_charge+0x36/0xa0 Dec 19 12:00:04 pve kernel: __add_to_page_cache_locked+0x30b/0x360 Dec 19 12:00:04 pve kernel: ? scan_shadow_nodes+0x30/0x30 Dec 19 12:00:04 pve kernel: add_to_page_cache_lru+0x4d/0xd0 Dec 19 12:00:04 pve kernel: pagecache_get_page+0x1ab/0x560 Dec 19 12:00:04 pve kernel: filemap_fault+0x5cd/0x880 Dec 19 12:00:04 pve kernel: __do_fault+0x3c/0xe0 Dec 19 12:00:04 pve kernel: __handle_mm_fault+0xf8c/0x16c0 Dec 19 12:00:04 pve kernel: handle_mm_fault+0xda/0x2c0 Dec 19 12:00:04 pve kernel: do_user_addr_fault+0x1bb/0x660 Dec 19 12:00:04 pve kernel: exc_page_fault+0x7d/0x170 Dec 19 12:00:04 pve kernel: ? asm_exc_page_fault+0x8/0x30 Dec 19 12:00:04 pve kernel: asm_exc_page_fault+0x1e/0x30 Dec 19 12:00:04 pve kernel: RIP: 0033:0x7f3eccaa3116 Dec 19 12:00:04 pve kernel: Code: Unable to access opcode bytes at RIP 0x7f3eccaa30ec. Dec 19 12:00:04 pve kernel: RSP: 002b:00007ffc036ba6e0 EFLAGS: 00010293 Dec 19 12:00:04 pve kernel: RAX: 0000000000000000 RBX: 00000000000003e8 RCX: 00007f3eccaa3116 Dec 19 12:00:04 pve kernel: RDX: 0000000000000400 RSI: 00007ffc036ba7e0 RDI: 000000000000000e Dec 19 12:00:04 pve kernel: RBP: 00007ffc036bd810 R08: 0000000000000000 R09: 0000000005bd7c20 Dec 19 12:00:04 pve kernel: R10: 00000000000003e8 R11: 0000000000000293 R12: 0000000000000000 Dec 19 12:00:04 pve kernel: R13: 0000000000000000 R14: 0000000000000001 R15: 00000000044f6880 Dec 19 12:00:04 pve kernel: memory: usage 4096000kB, limit 4096000kB, failcnt 99085 Dec 19 12:00:04 pve kernel: swap: usage 0kB, limit 524288kB, failcnt 0 Dec 19 12:00:04 pve kernel: Memory cgroup stats for /lxc/104: Dec 19 12:00:04 pve kernel: anon 4019650560 file 237568 kernel_stack 9666560 pagetables 122871808 percpu 648256 sock 1130496 shmem 102400 file_mapped 135168 file_dirty 131072 file_writeback 135168 swapcached 0 anon_thp 0 file_thp 0 shmem_thp 0 inactive_anon 4019429376 active_anon 323584 inactive_file 69632 active_file 65536 unevictable 0 slab_reclaimable 1712400 slab_unreclaimable 14783872 slab 16496272 workingset_refault_anon 0 workingset_refault_file 265293 workingset_activate_anon 0 workingset_activate_file 38418 workingset_restore_anon 0 workingset_restore_file 34970 workingset_nodereclaim 4196 pgfault 1336169215 pgmajfault 408838 pgrefill 1387534 pgscan 954407 pgsteal 391608 pgactivate 561679 pgdeactivate 585723 pglazyfree 0 pglazyfreed 0 thp_fault_alloc 0 thp_collapse_alloc 0 Dec 19 12:00:04 pve kernel: Tasks state (memory values in pages): Dec 19 12:00:04 pve kernel: [ pid ] uid tgid total_vm rss pgtables_bytes swapents oom_score_adj name Dec 19 12:00:04 pve kernel: [ 611435] 100000 611435 24993 594 73728 0 0 systemd Dec 19 12:00:04 pve kernel: [ 611856] 100000 611856 611 28 45056 0 0 agetty Dec 19 12:00:04 pve kernel: [ 611857] 100000 611857 611 27 40960 0 0 agetty Dec 19 12:00:04 pve kernel: [ 612056] 100000 612056 9996 163 73728 0 0 master Dec 19 12:00:04 pve kernel: [ 612058] 100101 612058 10116 166 77824 0 0 qmgr Dec 19 12:00:04 pve kernel: [2336131] 100101 2336131 10102 158 73728 0 0 pickup Dec 19 12:00:04 pve kernel: [ 611772] 100000 611772 56882 245 462848 0 0 systemd-journal Dec 19 12:00:04 pve kernel: [ 611791] 100104 611791 4038 226 73728 0 0 systemd-network Dec 19 12:00:04 pve kernel: [ 611831] 100107 611831 1960 114 57344 0 0 rpcbind Dec 19 12:00:04 pve kernel: [ 611835] 100000 611835 962 59 45056 0 0 cron Dec 19 12:00:04 pve kernel: [ 611836] 100106 611836 2048 151 53248 0 0 dbus-daemon Dec 19 12:00:04 pve kernel: [ 611838] 100000 611838 37782 377 65536 0 0 rsyslogd Dec 19 12:00:04 pve kernel: [ 611839] 100000 611839 3475 213 61440 0 0 systemd-logind Dec 19 12:00:04 pve kernel: [ 611846] 100105 611846 6011 1016 81920 0 0 systemd-resolve Dec 19 12:00:04 pve kernel: [ 611855] 100000 611855 611 27 45056 0 0 agetty Dec 19 12:00:04 pve kernel: [2210726] 101000 2210726 348095 164037 8327168 0 0 iobroker.js-con Dec 19 12:00:04 pve kernel: [2213125] 101000 2213125 228654 40353 4333568 0 0 io.admin.0 Dec 19 12:00:04 pve kernel: [2213343] 101000 2213343 159352 5537 1503232 0 0 io.email.0 Dec 19 12:00:04 pve kernel: [2213354] 101000 2213354 220911 15183 2703360 0 0 io.telegram.0 Dec 19 12:00:04 pve kernel: [2213588] 101000 2213588 198351 23429 2678784 0 0 io.influxdb.0 Dec 19 12:00:04 pve kernel: [2213793] 101000 2213793 249418 91753 7626752 0 0 io.javascript.0 Dec 19 12:00:04 pve kernel: [2213884] 101000 2213884 284518 92525 7626752 0 0 io.javascript.1 Dec 19 12:00:04 pve kernel: [2214158] 101000 2214158 292292 81370 7651328 0 0 io.javascript.2 Dec 19 12:00:04 pve kernel: [2214474] 101000 2214474 243247 84104 7331840 0 0 io.javascript.3 Dec 19 12:00:04 pve kernel: [2214786] 101000 2214786 171360 15365 2359296 0 0 io.scenes.0 Dec 19 12:00:04 pve kernel: [2215095] 101000 2215095 167280 9787 2396160 0 0 io.deconz.0 Dec 19 12:00:04 pve kernel: [2215319] 101000 2215319 231484 8123 2428928 0 0 io.ham.0 Dec 19 12:00:04 pve kernel: [2215365] 101000 2215365 231511 8326 2326528 0 0 io.alexa2.0 Dec 19 12:00:04 pve kernel: [2215512] 101000 2215512 166905 10359 2363392 0 0 io.hm-rega.0 Dec 19 12:00:04 pve kernel: [2215563] 101000 2215563 166294 8718 2428928 0 0 io.hm-rpc.0 Dec 19 12:00:04 pve kernel: [2216073] 101000 2216073 165268 7482 2347008 0 0 io.hm-rpc.1 Dec 19 12:00:04 pve kernel: [2216087] 101000 2216087 164602 6717 2269184 0 0 io.hm-rpc.2 Dec 19 12:00:04 pve kernel: [2216559] 101000 2216559 249164 7858 2473984 0 0 io.mihome-vacuu Dec 19 12:00:04 pve kernel: [2216647] 101000 2216647 253511 12978 2519040 0 0 io.mihome-vacuu Dec 19 12:00:04 pve kernel: [2216911] 101000 2216911 230068 6712 2248704 0 0 io.netatmo.0 Dec 19 12:00:04 pve kernel: [2217047] 101000 2217047 159978 6218 1585152 0 0 io.ping.0 Dec 19 12:00:04 pve kernel: [2217206] 101000 2217206 165804 8096 2416640 0 0 io.sonoff.0 Dec 19 12:00:04 pve kernel: [2217432] 101000 2217432 183881 9925 2670592 0 0 io.tr-064.0 Dec 19 12:00:04 pve kernel: [2217759] 101000 2217759 164952 7359 2273280 0 0 io.harmony.0 Dec 19 12:00:04 pve kernel: [2217775] 101000 2217775 160450 6573 1642496 0 0 io.adguard.0 Dec 19 12:00:04 pve kernel: [2218017] 101000 2218017 214907 7572 2383872 0 0 io.backitup.0 Dec 19 12:00:04 pve kernel: [2218150] 101000 2218150 231722 7946 2428928 0 0 io.bring.0 Dec 19 12:00:04 pve kernel: [2218523] 101000 2218523 232837 9348 2523136 0 0 io.discovergy.0 Dec 19 12:00:04 pve kernel: [2218752] 101000 2218752 159014 4933 1458176 0 0 io.echarts.0 Dec 19 12:00:04 pve kernel: [2219699] 101000 2219699 182420 8876 2195456 0 0 io.heatingcontr Dec 19 12:00:04 pve kernel: [2219720] 101000 2219720 159883 5658 1589248 0 0 node Dec 19 12:00:04 pve kernel: [2220141] 101000 2220141 231188 7431 2338816 0 0 io.homeconnect. Dec 19 12:00:04 pve kernel: [2220340] 101000 2220340 181291 6466 2203648 0 0 io.info.0 Dec 19 12:00:04 pve kernel: [2220863] 101000 2220863 205860 15575 2674688 0 0 io.iot.0 Dec 19 12:00:04 pve kernel: [2221010] 101000 2221010 197282 6368 2260992 0 0 io.linux-contro Dec 19 12:00:04 pve kernel: [2221219] 101000 2221219 165886 8595 2428928 0 0 io.logparser.0 Dec 19 12:00:04 pve kernel: [2221491] 101000 2221491 167626 9756 2445312 0 0 io.proxmox.0 Dec 19 12:00:04 pve kernel: [2222943] 101000 2222943 165576 7861 2301952 0 0 io.proxmox.1 Dec 19 12:00:04 pve kernel: [2223643] 101000 2223643 159478 5448 1519616 0 0 io.sayit.0 Dec 19 12:00:04 pve kernel: [2223790] 101000 2223790 159344 5588 1515520 0 0 io.simple-api.0 Dec 19 12:00:04 pve kernel: [2223905] 101000 2223905 181697 8135 2273280 0 0 io.socketio.0 Dec 19 12:00:04 pve kernel: [2224007] 101000 2224007 164848 7058 2252800 0 0 io.sourceanalyt Dec 19 12:00:04 pve kernel: [2224092] 101000 2224092 159444 5559 1527808 0 0 io.text2command Dec 19 12:00:04 pve kernel: [2224280] 101000 2224280 168214 10790 2105344 0 0 io.virtualpower Dec 19 12:00:04 pve kernel: [2224540] 101000 2224540 158905 4878 1441792 0 0 io.vis-inventwo Dec 19 12:00:04 pve kernel: [2224878] 101000 2224878 182752 8219 2445312 0 0 io.web.0 Dec 19 12:00:04 pve kernel: [2225335] 101000 2225335 163647 5349 2146304 0 0 io.yeelight-2.0 Dec 19 12:00:04 pve kernel: [2225439] 101000 2225439 159989 5617 1564672 0 0 io.lametric.0 Dec 19 12:00:04 pve kernel: [2368750] 101000 2368750 200733 17827 2650112 0 0 io.ical.0 Dec 19 12:00:04 pve kernel: [2368754] 101000 2368754 605 16 45056 0 0 sh Dec 19 12:00:04 pve kernel: [2368760] 101000 2368760 939 60 49152 0 0 iobroker Dec 19 12:00:04 pve kernel: [2368762] 101000 2368762 231390 29313 3022848 0 0 node Dec 19 12:00:04 pve kernel: [2368831] 101000 2368831 159087 7380 1503232 0 0 node Dec 19 12:00:04 pve kernel: [2368844] 101000 2368844 160905 8936 1736704 0 0 node Dec 19 12:00:04 pve kernel: oom-kill:constraint=CONSTRAINT_MEMCG,nodemask=(null),cpuset=ns,mems_allowed=0,oom_memcg=/lxc/104,task_memcg=/lxc/104/ns/system.slice/iobroker.service,task=iobroker.js-con,pid=2210726,uid=101000 Dec 19 12:00:04 pve kernel: Memory cgroup out of memory: Killed process 2210726 (iobroker.js-con) total-vm:1392380kB, anon-rss:656148kB, file-rss:0kB, shmem-rss:0kB, UID:101000 pgtables:8132kB oom_score_adj:0 Dec 19 12:00:04 pve kernel: oom_reaper: reaped process 2210726 (iobroker.js-con), now anon-rss:0kB, file-rss:0kB, shmem-rss:0kBTOP spuckt aktuell das aus:

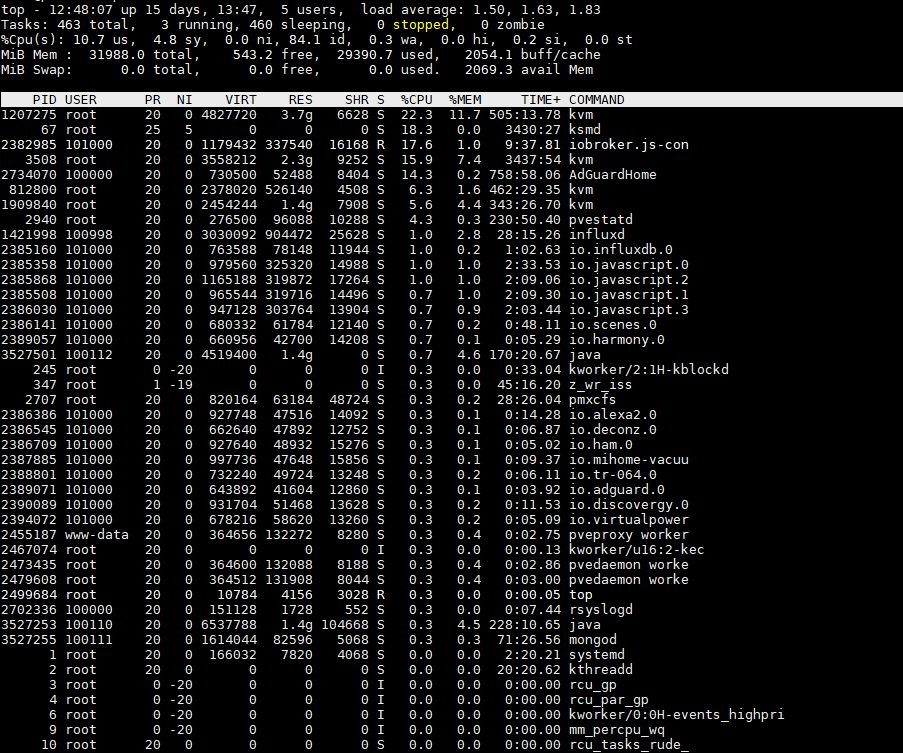

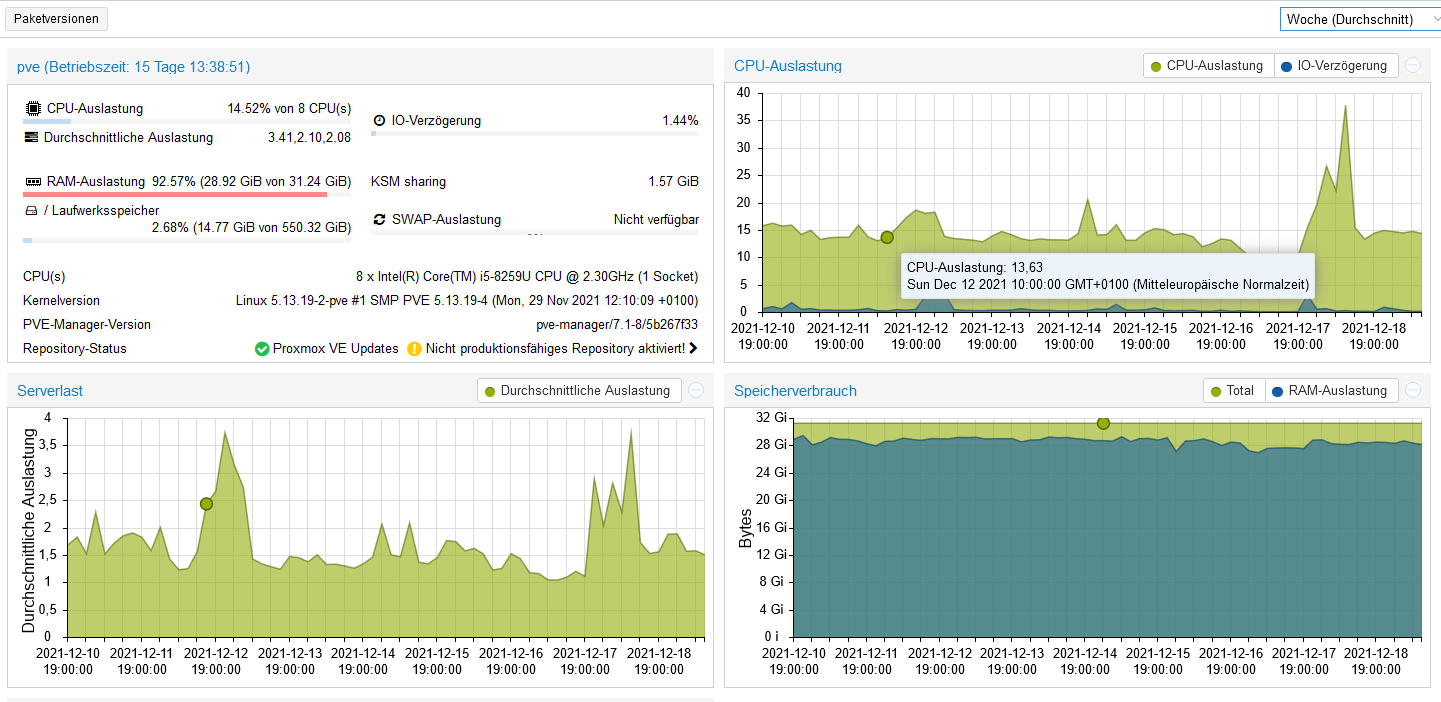

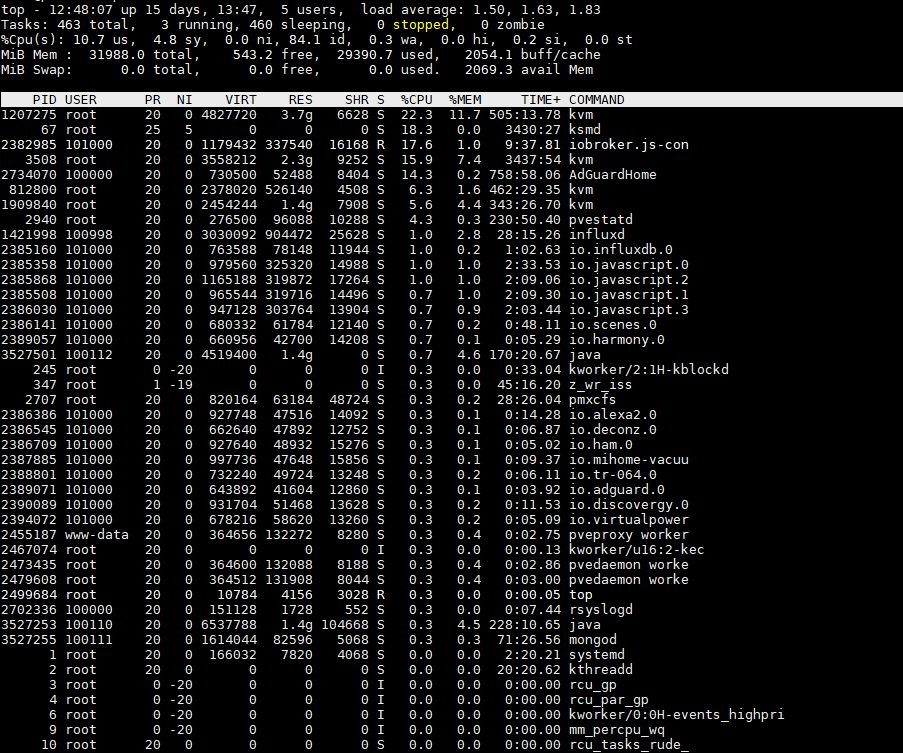

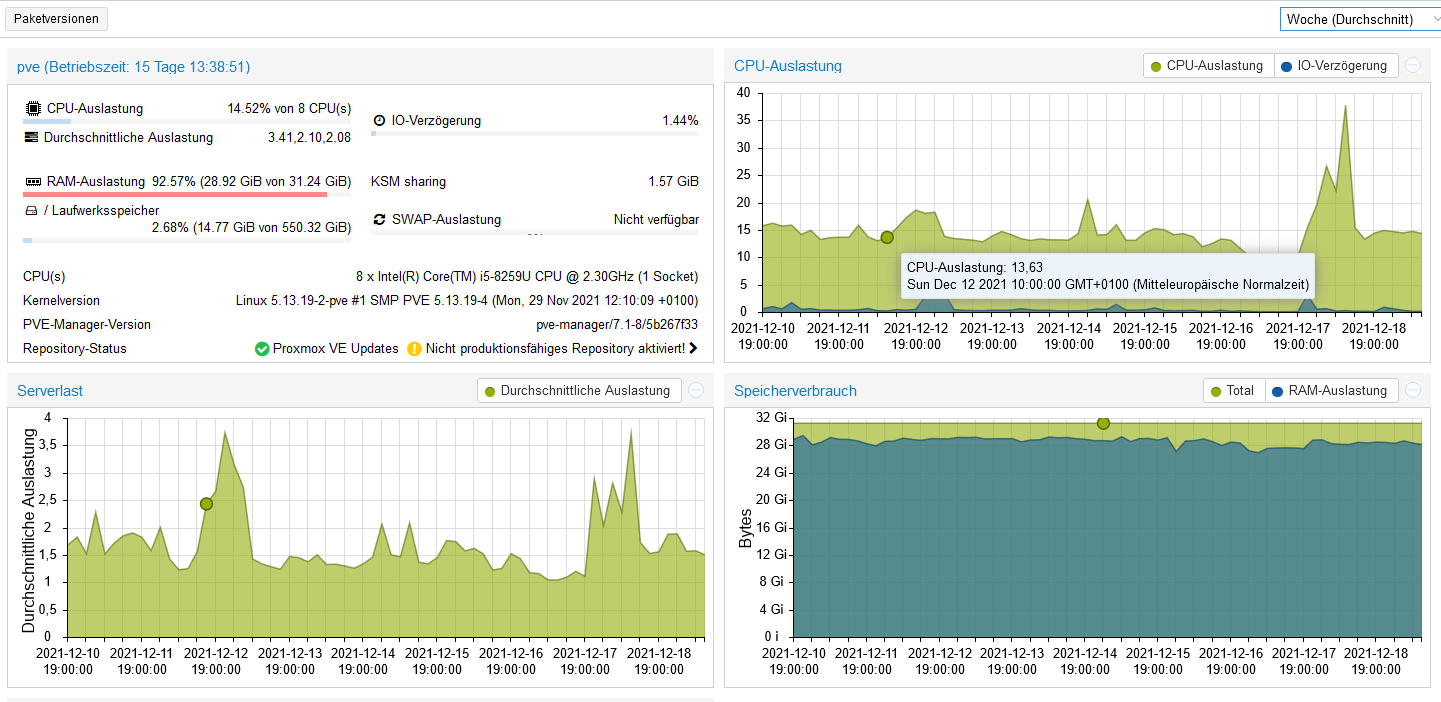

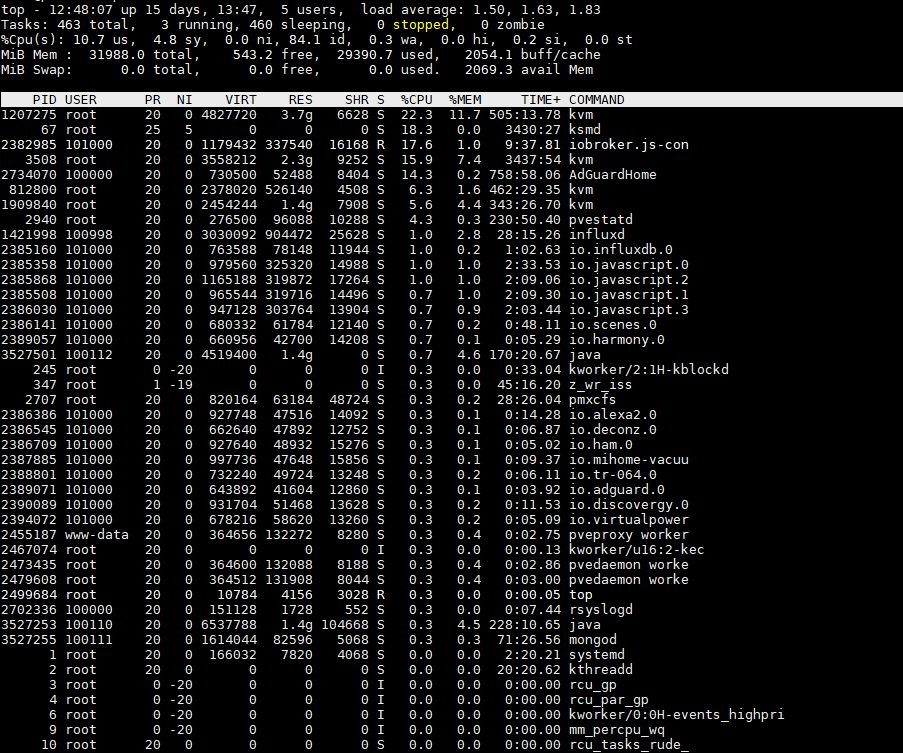

Wenn ich von allen Containern und VMs die Speicherzuweisung zusammen rechne, komme ich ca auf 17GB, im System sind 32 GB verbaut. Sollte doch eigentlich dicke reichen. Da es hier ja auch einige Proxmox Profis gibt, kann man da irgend etwas machen, damit der Prozess nicht gekillt wird ? ioBroker habe ich momentan 4GB zugewiesen, die RAM Auslastung liegt bei 80%.

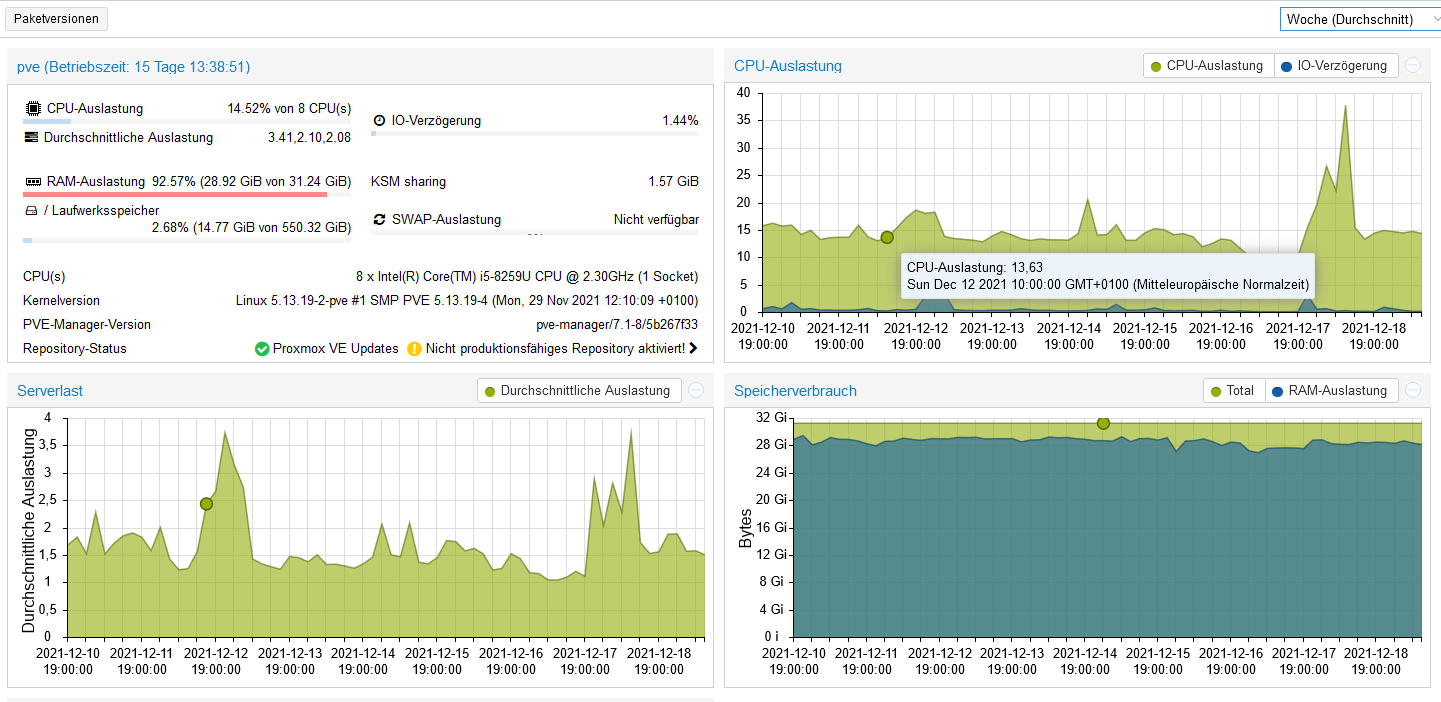

Allerdings liegt die Gesamtauslastung des RAMs schon bei 92% oder so. Allerdings denke ich, dass es der Effekt ist, da bei Linux ja nichts verschwendet wird und bei Bedarf freigegeben wird ?! Da bin ich überfragt, ob es in dieser Ansicht das gleiche ist. Ansonsten weiß ich nicht, wie der Verbrauch zustande kommt.

Danke schon mal für die AntwortenGruß Holger

-

Hallo,

ich habe momentan folgendes Problem: Ich habe einen NUC8i5 mit 32GB Ram. Ich hatte bisher einige VMs darauf laufen und nun nach und nach diese auf Container umgestellt, da ich doch festgestellt habe, dass das etwas flotter läuft und wohl auch ressourcenschonender ist. Allerdings habe ich nun bei iobroker Probleme, was ich nicht ganz verstehen kann. Ich bekomme nun in unregelmäßigen Abständen (mehrmals am Tag) die Meldung , dass der JS Controller neu gestartet wurde. Im Proxmox syslog sehe ich dann die Meldung, neustart wegen out of memory, zumindest interpretierre ich das so :

(Dec 19 12:00:04 pve kernel: Memory cgroup out of memory: Killed process 2210726 (iobroker.js-con)

Dec 19 12:00:04 pve kernel: io.socketio.0 invoked oom-killer: gfp_mask=0x100cca(GFP_HIGHUSER_MOVABLE), order=0, oom_score_adj=0 Dec 19 12:00:04 pve kernel: CPU: 6 PID: 2223905 Comm: io.socketio.0 Tainted: P W O 5.13.19-2-pve #1 Dec 19 12:00:04 pve kernel: Hardware name: Intel(R) Client Systems NUC8i5BEH/NUC8BEB, BIOS BECFL357.86A.0087.2020.1209.1115 12/09/2020 Dec 19 12:00:04 pve kernel: Call Trace: Dec 19 12:00:04 pve kernel: dump_stack+0x7d/0x9c Dec 19 12:00:04 pve kernel: dump_header+0x4f/0x1f6 Dec 19 12:00:04 pve kernel: oom_kill_process.cold+0xb/0x10 Dec 19 12:00:04 pve kernel: out_of_memory+0x1cf/0x530 Dec 19 12:00:04 pve kernel: mem_cgroup_out_of_memory+0x139/0x150 Dec 19 12:00:04 pve kernel: try_charge+0x6f6/0x750 Dec 19 12:00:04 pve kernel: __mem_cgroup_charge+0x3e/0xb0 Dec 19 12:00:04 pve kernel: mem_cgroup_charge+0x36/0xa0 Dec 19 12:00:04 pve kernel: __add_to_page_cache_locked+0x30b/0x360 Dec 19 12:00:04 pve kernel: ? scan_shadow_nodes+0x30/0x30 Dec 19 12:00:04 pve kernel: add_to_page_cache_lru+0x4d/0xd0 Dec 19 12:00:04 pve kernel: pagecache_get_page+0x1ab/0x560 Dec 19 12:00:04 pve kernel: filemap_fault+0x5cd/0x880 Dec 19 12:00:04 pve kernel: __do_fault+0x3c/0xe0 Dec 19 12:00:04 pve kernel: __handle_mm_fault+0xf8c/0x16c0 Dec 19 12:00:04 pve kernel: handle_mm_fault+0xda/0x2c0 Dec 19 12:00:04 pve kernel: do_user_addr_fault+0x1bb/0x660 Dec 19 12:00:04 pve kernel: exc_page_fault+0x7d/0x170 Dec 19 12:00:04 pve kernel: ? asm_exc_page_fault+0x8/0x30 Dec 19 12:00:04 pve kernel: asm_exc_page_fault+0x1e/0x30 Dec 19 12:00:04 pve kernel: RIP: 0033:0x7f3eccaa3116 Dec 19 12:00:04 pve kernel: Code: Unable to access opcode bytes at RIP 0x7f3eccaa30ec. Dec 19 12:00:04 pve kernel: RSP: 002b:00007ffc036ba6e0 EFLAGS: 00010293 Dec 19 12:00:04 pve kernel: RAX: 0000000000000000 RBX: 00000000000003e8 RCX: 00007f3eccaa3116 Dec 19 12:00:04 pve kernel: RDX: 0000000000000400 RSI: 00007ffc036ba7e0 RDI: 000000000000000e Dec 19 12:00:04 pve kernel: RBP: 00007ffc036bd810 R08: 0000000000000000 R09: 0000000005bd7c20 Dec 19 12:00:04 pve kernel: R10: 00000000000003e8 R11: 0000000000000293 R12: 0000000000000000 Dec 19 12:00:04 pve kernel: R13: 0000000000000000 R14: 0000000000000001 R15: 00000000044f6880 Dec 19 12:00:04 pve kernel: memory: usage 4096000kB, limit 4096000kB, failcnt 99085 Dec 19 12:00:04 pve kernel: swap: usage 0kB, limit 524288kB, failcnt 0 Dec 19 12:00:04 pve kernel: Memory cgroup stats for /lxc/104: Dec 19 12:00:04 pve kernel: anon 4019650560 file 237568 kernel_stack 9666560 pagetables 122871808 percpu 648256 sock 1130496 shmem 102400 file_mapped 135168 file_dirty 131072 file_writeback 135168 swapcached 0 anon_thp 0 file_thp 0 shmem_thp 0 inactive_anon 4019429376 active_anon 323584 inactive_file 69632 active_file 65536 unevictable 0 slab_reclaimable 1712400 slab_unreclaimable 14783872 slab 16496272 workingset_refault_anon 0 workingset_refault_file 265293 workingset_activate_anon 0 workingset_activate_file 38418 workingset_restore_anon 0 workingset_restore_file 34970 workingset_nodereclaim 4196 pgfault 1336169215 pgmajfault 408838 pgrefill 1387534 pgscan 954407 pgsteal 391608 pgactivate 561679 pgdeactivate 585723 pglazyfree 0 pglazyfreed 0 thp_fault_alloc 0 thp_collapse_alloc 0 Dec 19 12:00:04 pve kernel: Tasks state (memory values in pages): Dec 19 12:00:04 pve kernel: [ pid ] uid tgid total_vm rss pgtables_bytes swapents oom_score_adj name Dec 19 12:00:04 pve kernel: [ 611435] 100000 611435 24993 594 73728 0 0 systemd Dec 19 12:00:04 pve kernel: [ 611856] 100000 611856 611 28 45056 0 0 agetty Dec 19 12:00:04 pve kernel: [ 611857] 100000 611857 611 27 40960 0 0 agetty Dec 19 12:00:04 pve kernel: [ 612056] 100000 612056 9996 163 73728 0 0 master Dec 19 12:00:04 pve kernel: [ 612058] 100101 612058 10116 166 77824 0 0 qmgr Dec 19 12:00:04 pve kernel: [2336131] 100101 2336131 10102 158 73728 0 0 pickup Dec 19 12:00:04 pve kernel: [ 611772] 100000 611772 56882 245 462848 0 0 systemd-journal Dec 19 12:00:04 pve kernel: [ 611791] 100104 611791 4038 226 73728 0 0 systemd-network Dec 19 12:00:04 pve kernel: [ 611831] 100107 611831 1960 114 57344 0 0 rpcbind Dec 19 12:00:04 pve kernel: [ 611835] 100000 611835 962 59 45056 0 0 cron Dec 19 12:00:04 pve kernel: [ 611836] 100106 611836 2048 151 53248 0 0 dbus-daemon Dec 19 12:00:04 pve kernel: [ 611838] 100000 611838 37782 377 65536 0 0 rsyslogd Dec 19 12:00:04 pve kernel: [ 611839] 100000 611839 3475 213 61440 0 0 systemd-logind Dec 19 12:00:04 pve kernel: [ 611846] 100105 611846 6011 1016 81920 0 0 systemd-resolve Dec 19 12:00:04 pve kernel: [ 611855] 100000 611855 611 27 45056 0 0 agetty Dec 19 12:00:04 pve kernel: [2210726] 101000 2210726 348095 164037 8327168 0 0 iobroker.js-con Dec 19 12:00:04 pve kernel: [2213125] 101000 2213125 228654 40353 4333568 0 0 io.admin.0 Dec 19 12:00:04 pve kernel: [2213343] 101000 2213343 159352 5537 1503232 0 0 io.email.0 Dec 19 12:00:04 pve kernel: [2213354] 101000 2213354 220911 15183 2703360 0 0 io.telegram.0 Dec 19 12:00:04 pve kernel: [2213588] 101000 2213588 198351 23429 2678784 0 0 io.influxdb.0 Dec 19 12:00:04 pve kernel: [2213793] 101000 2213793 249418 91753 7626752 0 0 io.javascript.0 Dec 19 12:00:04 pve kernel: [2213884] 101000 2213884 284518 92525 7626752 0 0 io.javascript.1 Dec 19 12:00:04 pve kernel: [2214158] 101000 2214158 292292 81370 7651328 0 0 io.javascript.2 Dec 19 12:00:04 pve kernel: [2214474] 101000 2214474 243247 84104 7331840 0 0 io.javascript.3 Dec 19 12:00:04 pve kernel: [2214786] 101000 2214786 171360 15365 2359296 0 0 io.scenes.0 Dec 19 12:00:04 pve kernel: [2215095] 101000 2215095 167280 9787 2396160 0 0 io.deconz.0 Dec 19 12:00:04 pve kernel: [2215319] 101000 2215319 231484 8123 2428928 0 0 io.ham.0 Dec 19 12:00:04 pve kernel: [2215365] 101000 2215365 231511 8326 2326528 0 0 io.alexa2.0 Dec 19 12:00:04 pve kernel: [2215512] 101000 2215512 166905 10359 2363392 0 0 io.hm-rega.0 Dec 19 12:00:04 pve kernel: [2215563] 101000 2215563 166294 8718 2428928 0 0 io.hm-rpc.0 Dec 19 12:00:04 pve kernel: [2216073] 101000 2216073 165268 7482 2347008 0 0 io.hm-rpc.1 Dec 19 12:00:04 pve kernel: [2216087] 101000 2216087 164602 6717 2269184 0 0 io.hm-rpc.2 Dec 19 12:00:04 pve kernel: [2216559] 101000 2216559 249164 7858 2473984 0 0 io.mihome-vacuu Dec 19 12:00:04 pve kernel: [2216647] 101000 2216647 253511 12978 2519040 0 0 io.mihome-vacuu Dec 19 12:00:04 pve kernel: [2216911] 101000 2216911 230068 6712 2248704 0 0 io.netatmo.0 Dec 19 12:00:04 pve kernel: [2217047] 101000 2217047 159978 6218 1585152 0 0 io.ping.0 Dec 19 12:00:04 pve kernel: [2217206] 101000 2217206 165804 8096 2416640 0 0 io.sonoff.0 Dec 19 12:00:04 pve kernel: [2217432] 101000 2217432 183881 9925 2670592 0 0 io.tr-064.0 Dec 19 12:00:04 pve kernel: [2217759] 101000 2217759 164952 7359 2273280 0 0 io.harmony.0 Dec 19 12:00:04 pve kernel: [2217775] 101000 2217775 160450 6573 1642496 0 0 io.adguard.0 Dec 19 12:00:04 pve kernel: [2218017] 101000 2218017 214907 7572 2383872 0 0 io.backitup.0 Dec 19 12:00:04 pve kernel: [2218150] 101000 2218150 231722 7946 2428928 0 0 io.bring.0 Dec 19 12:00:04 pve kernel: [2218523] 101000 2218523 232837 9348 2523136 0 0 io.discovergy.0 Dec 19 12:00:04 pve kernel: [2218752] 101000 2218752 159014 4933 1458176 0 0 io.echarts.0 Dec 19 12:00:04 pve kernel: [2219699] 101000 2219699 182420 8876 2195456 0 0 io.heatingcontr Dec 19 12:00:04 pve kernel: [2219720] 101000 2219720 159883 5658 1589248 0 0 node Dec 19 12:00:04 pve kernel: [2220141] 101000 2220141 231188 7431 2338816 0 0 io.homeconnect. Dec 19 12:00:04 pve kernel: [2220340] 101000 2220340 181291 6466 2203648 0 0 io.info.0 Dec 19 12:00:04 pve kernel: [2220863] 101000 2220863 205860 15575 2674688 0 0 io.iot.0 Dec 19 12:00:04 pve kernel: [2221010] 101000 2221010 197282 6368 2260992 0 0 io.linux-contro Dec 19 12:00:04 pve kernel: [2221219] 101000 2221219 165886 8595 2428928 0 0 io.logparser.0 Dec 19 12:00:04 pve kernel: [2221491] 101000 2221491 167626 9756 2445312 0 0 io.proxmox.0 Dec 19 12:00:04 pve kernel: [2222943] 101000 2222943 165576 7861 2301952 0 0 io.proxmox.1 Dec 19 12:00:04 pve kernel: [2223643] 101000 2223643 159478 5448 1519616 0 0 io.sayit.0 Dec 19 12:00:04 pve kernel: [2223790] 101000 2223790 159344 5588 1515520 0 0 io.simple-api.0 Dec 19 12:00:04 pve kernel: [2223905] 101000 2223905 181697 8135 2273280 0 0 io.socketio.0 Dec 19 12:00:04 pve kernel: [2224007] 101000 2224007 164848 7058 2252800 0 0 io.sourceanalyt Dec 19 12:00:04 pve kernel: [2224092] 101000 2224092 159444 5559 1527808 0 0 io.text2command Dec 19 12:00:04 pve kernel: [2224280] 101000 2224280 168214 10790 2105344 0 0 io.virtualpower Dec 19 12:00:04 pve kernel: [2224540] 101000 2224540 158905 4878 1441792 0 0 io.vis-inventwo Dec 19 12:00:04 pve kernel: [2224878] 101000 2224878 182752 8219 2445312 0 0 io.web.0 Dec 19 12:00:04 pve kernel: [2225335] 101000 2225335 163647 5349 2146304 0 0 io.yeelight-2.0 Dec 19 12:00:04 pve kernel: [2225439] 101000 2225439 159989 5617 1564672 0 0 io.lametric.0 Dec 19 12:00:04 pve kernel: [2368750] 101000 2368750 200733 17827 2650112 0 0 io.ical.0 Dec 19 12:00:04 pve kernel: [2368754] 101000 2368754 605 16 45056 0 0 sh Dec 19 12:00:04 pve kernel: [2368760] 101000 2368760 939 60 49152 0 0 iobroker Dec 19 12:00:04 pve kernel: [2368762] 101000 2368762 231390 29313 3022848 0 0 node Dec 19 12:00:04 pve kernel: [2368831] 101000 2368831 159087 7380 1503232 0 0 node Dec 19 12:00:04 pve kernel: [2368844] 101000 2368844 160905 8936 1736704 0 0 node Dec 19 12:00:04 pve kernel: oom-kill:constraint=CONSTRAINT_MEMCG,nodemask=(null),cpuset=ns,mems_allowed=0,oom_memcg=/lxc/104,task_memcg=/lxc/104/ns/system.slice/iobroker.service,task=iobroker.js-con,pid=2210726,uid=101000 Dec 19 12:00:04 pve kernel: Memory cgroup out of memory: Killed process 2210726 (iobroker.js-con) total-vm:1392380kB, anon-rss:656148kB, file-rss:0kB, shmem-rss:0kB, UID:101000 pgtables:8132kB oom_score_adj:0 Dec 19 12:00:04 pve kernel: oom_reaper: reaped process 2210726 (iobroker.js-con), now anon-rss:0kB, file-rss:0kB, shmem-rss:0kBTOP spuckt aktuell das aus:

Wenn ich von allen Containern und VMs die Speicherzuweisung zusammen rechne, komme ich ca auf 17GB, im System sind 32 GB verbaut. Sollte doch eigentlich dicke reichen. Da es hier ja auch einige Proxmox Profis gibt, kann man da irgend etwas machen, damit der Prozess nicht gekillt wird ? ioBroker habe ich momentan 4GB zugewiesen, die RAM Auslastung liegt bei 80%.

Allerdings liegt die Gesamtauslastung des RAMs schon bei 92% oder so. Allerdings denke ich, dass es der Effekt ist, da bei Linux ja nichts verschwendet wird und bei Bedarf freigegeben wird ?! Da bin ich überfragt, ob es in dieser Ansicht das gleiche ist. Ansonsten weiß ich nicht, wie der Verbrauch zustande kommt.

Danke schon mal für die AntwortenGruß Holger

@holger76 sagte in JS-Controller startet ständig neu (out of mem in Proxmox):

Wenn ich von allen Containern und VMs die Speicherzuweisung zusammen rechne, komme ich ca auf 17GB, im System sind 32 GB verbaut

sieht man doch, das der Ram verbraucht ist, zumal Proxmox selbst ja auch Ram benötigt, desweiteren hast du den swap deaktiviert

-

@holger76 sagte in JS-Controller startet ständig neu (out of mem in Proxmox):

Wenn ich von allen Containern und VMs die Speicherzuweisung zusammen rechne, komme ich ca auf 17GB, im System sind 32 GB verbaut

sieht man doch, das der Ram verbraucht ist, zumal Proxmox selbst ja auch Ram benötigt, desweiteren hast du den swap deaktiviert

@crunchip

ja klar, proxmox braucht auch. aber 15GB ? Ich ging jetzt halt davon aus, dass der Stets aufgefüllt wird bis zur einer gewissen Grenze, eigtnlich keinne ich das auch nur so, dass er min. 80-90% hat, egal wieviel ich am laufen habe. Das ist schon extrem merkwürdig.Das mit dem swap stimmt natürlich, allerdings weiß ich nun nicht, wie ich das aktivieren kann. Wahrscheinlich gar nicht, ohne neu aufzusetzen ? Ich kann mir auch nicht erklären, wie das Zustande gekommen ist, dass da keiner aktiviert ist. Der lagert dann auf Festplatte aus, wenn ich das richtig verstanden habe. Heißt dann aber im klartext, da fehlt wirklich RAM. Wo man dann wohl sagen muss, das System an sich braucht wirklich min. genauso viel RAM, wie für die Cont.+VMs zugewiesen sind :face_with_rolling_eyes:

-

Hallo,

ich habe momentan folgendes Problem: Ich habe einen NUC8i5 mit 32GB Ram. Ich hatte bisher einige VMs darauf laufen und nun nach und nach diese auf Container umgestellt, da ich doch festgestellt habe, dass das etwas flotter läuft und wohl auch ressourcenschonender ist. Allerdings habe ich nun bei iobroker Probleme, was ich nicht ganz verstehen kann. Ich bekomme nun in unregelmäßigen Abständen (mehrmals am Tag) die Meldung , dass der JS Controller neu gestartet wurde. Im Proxmox syslog sehe ich dann die Meldung, neustart wegen out of memory, zumindest interpretierre ich das so :

(Dec 19 12:00:04 pve kernel: Memory cgroup out of memory: Killed process 2210726 (iobroker.js-con)

Dec 19 12:00:04 pve kernel: io.socketio.0 invoked oom-killer: gfp_mask=0x100cca(GFP_HIGHUSER_MOVABLE), order=0, oom_score_adj=0 Dec 19 12:00:04 pve kernel: CPU: 6 PID: 2223905 Comm: io.socketio.0 Tainted: P W O 5.13.19-2-pve #1 Dec 19 12:00:04 pve kernel: Hardware name: Intel(R) Client Systems NUC8i5BEH/NUC8BEB, BIOS BECFL357.86A.0087.2020.1209.1115 12/09/2020 Dec 19 12:00:04 pve kernel: Call Trace: Dec 19 12:00:04 pve kernel: dump_stack+0x7d/0x9c Dec 19 12:00:04 pve kernel: dump_header+0x4f/0x1f6 Dec 19 12:00:04 pve kernel: oom_kill_process.cold+0xb/0x10 Dec 19 12:00:04 pve kernel: out_of_memory+0x1cf/0x530 Dec 19 12:00:04 pve kernel: mem_cgroup_out_of_memory+0x139/0x150 Dec 19 12:00:04 pve kernel: try_charge+0x6f6/0x750 Dec 19 12:00:04 pve kernel: __mem_cgroup_charge+0x3e/0xb0 Dec 19 12:00:04 pve kernel: mem_cgroup_charge+0x36/0xa0 Dec 19 12:00:04 pve kernel: __add_to_page_cache_locked+0x30b/0x360 Dec 19 12:00:04 pve kernel: ? scan_shadow_nodes+0x30/0x30 Dec 19 12:00:04 pve kernel: add_to_page_cache_lru+0x4d/0xd0 Dec 19 12:00:04 pve kernel: pagecache_get_page+0x1ab/0x560 Dec 19 12:00:04 pve kernel: filemap_fault+0x5cd/0x880 Dec 19 12:00:04 pve kernel: __do_fault+0x3c/0xe0 Dec 19 12:00:04 pve kernel: __handle_mm_fault+0xf8c/0x16c0 Dec 19 12:00:04 pve kernel: handle_mm_fault+0xda/0x2c0 Dec 19 12:00:04 pve kernel: do_user_addr_fault+0x1bb/0x660 Dec 19 12:00:04 pve kernel: exc_page_fault+0x7d/0x170 Dec 19 12:00:04 pve kernel: ? asm_exc_page_fault+0x8/0x30 Dec 19 12:00:04 pve kernel: asm_exc_page_fault+0x1e/0x30 Dec 19 12:00:04 pve kernel: RIP: 0033:0x7f3eccaa3116 Dec 19 12:00:04 pve kernel: Code: Unable to access opcode bytes at RIP 0x7f3eccaa30ec. Dec 19 12:00:04 pve kernel: RSP: 002b:00007ffc036ba6e0 EFLAGS: 00010293 Dec 19 12:00:04 pve kernel: RAX: 0000000000000000 RBX: 00000000000003e8 RCX: 00007f3eccaa3116 Dec 19 12:00:04 pve kernel: RDX: 0000000000000400 RSI: 00007ffc036ba7e0 RDI: 000000000000000e Dec 19 12:00:04 pve kernel: RBP: 00007ffc036bd810 R08: 0000000000000000 R09: 0000000005bd7c20 Dec 19 12:00:04 pve kernel: R10: 00000000000003e8 R11: 0000000000000293 R12: 0000000000000000 Dec 19 12:00:04 pve kernel: R13: 0000000000000000 R14: 0000000000000001 R15: 00000000044f6880 Dec 19 12:00:04 pve kernel: memory: usage 4096000kB, limit 4096000kB, failcnt 99085 Dec 19 12:00:04 pve kernel: swap: usage 0kB, limit 524288kB, failcnt 0 Dec 19 12:00:04 pve kernel: Memory cgroup stats for /lxc/104: Dec 19 12:00:04 pve kernel: anon 4019650560 file 237568 kernel_stack 9666560 pagetables 122871808 percpu 648256 sock 1130496 shmem 102400 file_mapped 135168 file_dirty 131072 file_writeback 135168 swapcached 0 anon_thp 0 file_thp 0 shmem_thp 0 inactive_anon 4019429376 active_anon 323584 inactive_file 69632 active_file 65536 unevictable 0 slab_reclaimable 1712400 slab_unreclaimable 14783872 slab 16496272 workingset_refault_anon 0 workingset_refault_file 265293 workingset_activate_anon 0 workingset_activate_file 38418 workingset_restore_anon 0 workingset_restore_file 34970 workingset_nodereclaim 4196 pgfault 1336169215 pgmajfault 408838 pgrefill 1387534 pgscan 954407 pgsteal 391608 pgactivate 561679 pgdeactivate 585723 pglazyfree 0 pglazyfreed 0 thp_fault_alloc 0 thp_collapse_alloc 0 Dec 19 12:00:04 pve kernel: Tasks state (memory values in pages): Dec 19 12:00:04 pve kernel: [ pid ] uid tgid total_vm rss pgtables_bytes swapents oom_score_adj name Dec 19 12:00:04 pve kernel: [ 611435] 100000 611435 24993 594 73728 0 0 systemd Dec 19 12:00:04 pve kernel: [ 611856] 100000 611856 611 28 45056 0 0 agetty Dec 19 12:00:04 pve kernel: [ 611857] 100000 611857 611 27 40960 0 0 agetty Dec 19 12:00:04 pve kernel: [ 612056] 100000 612056 9996 163 73728 0 0 master Dec 19 12:00:04 pve kernel: [ 612058] 100101 612058 10116 166 77824 0 0 qmgr Dec 19 12:00:04 pve kernel: [2336131] 100101 2336131 10102 158 73728 0 0 pickup Dec 19 12:00:04 pve kernel: [ 611772] 100000 611772 56882 245 462848 0 0 systemd-journal Dec 19 12:00:04 pve kernel: [ 611791] 100104 611791 4038 226 73728 0 0 systemd-network Dec 19 12:00:04 pve kernel: [ 611831] 100107 611831 1960 114 57344 0 0 rpcbind Dec 19 12:00:04 pve kernel: [ 611835] 100000 611835 962 59 45056 0 0 cron Dec 19 12:00:04 pve kernel: [ 611836] 100106 611836 2048 151 53248 0 0 dbus-daemon Dec 19 12:00:04 pve kernel: [ 611838] 100000 611838 37782 377 65536 0 0 rsyslogd Dec 19 12:00:04 pve kernel: [ 611839] 100000 611839 3475 213 61440 0 0 systemd-logind Dec 19 12:00:04 pve kernel: [ 611846] 100105 611846 6011 1016 81920 0 0 systemd-resolve Dec 19 12:00:04 pve kernel: [ 611855] 100000 611855 611 27 45056 0 0 agetty Dec 19 12:00:04 pve kernel: [2210726] 101000 2210726 348095 164037 8327168 0 0 iobroker.js-con Dec 19 12:00:04 pve kernel: [2213125] 101000 2213125 228654 40353 4333568 0 0 io.admin.0 Dec 19 12:00:04 pve kernel: [2213343] 101000 2213343 159352 5537 1503232 0 0 io.email.0 Dec 19 12:00:04 pve kernel: [2213354] 101000 2213354 220911 15183 2703360 0 0 io.telegram.0 Dec 19 12:00:04 pve kernel: [2213588] 101000 2213588 198351 23429 2678784 0 0 io.influxdb.0 Dec 19 12:00:04 pve kernel: [2213793] 101000 2213793 249418 91753 7626752 0 0 io.javascript.0 Dec 19 12:00:04 pve kernel: [2213884] 101000 2213884 284518 92525 7626752 0 0 io.javascript.1 Dec 19 12:00:04 pve kernel: [2214158] 101000 2214158 292292 81370 7651328 0 0 io.javascript.2 Dec 19 12:00:04 pve kernel: [2214474] 101000 2214474 243247 84104 7331840 0 0 io.javascript.3 Dec 19 12:00:04 pve kernel: [2214786] 101000 2214786 171360 15365 2359296 0 0 io.scenes.0 Dec 19 12:00:04 pve kernel: [2215095] 101000 2215095 167280 9787 2396160 0 0 io.deconz.0 Dec 19 12:00:04 pve kernel: [2215319] 101000 2215319 231484 8123 2428928 0 0 io.ham.0 Dec 19 12:00:04 pve kernel: [2215365] 101000 2215365 231511 8326 2326528 0 0 io.alexa2.0 Dec 19 12:00:04 pve kernel: [2215512] 101000 2215512 166905 10359 2363392 0 0 io.hm-rega.0 Dec 19 12:00:04 pve kernel: [2215563] 101000 2215563 166294 8718 2428928 0 0 io.hm-rpc.0 Dec 19 12:00:04 pve kernel: [2216073] 101000 2216073 165268 7482 2347008 0 0 io.hm-rpc.1 Dec 19 12:00:04 pve kernel: [2216087] 101000 2216087 164602 6717 2269184 0 0 io.hm-rpc.2 Dec 19 12:00:04 pve kernel: [2216559] 101000 2216559 249164 7858 2473984 0 0 io.mihome-vacuu Dec 19 12:00:04 pve kernel: [2216647] 101000 2216647 253511 12978 2519040 0 0 io.mihome-vacuu Dec 19 12:00:04 pve kernel: [2216911] 101000 2216911 230068 6712 2248704 0 0 io.netatmo.0 Dec 19 12:00:04 pve kernel: [2217047] 101000 2217047 159978 6218 1585152 0 0 io.ping.0 Dec 19 12:00:04 pve kernel: [2217206] 101000 2217206 165804 8096 2416640 0 0 io.sonoff.0 Dec 19 12:00:04 pve kernel: [2217432] 101000 2217432 183881 9925 2670592 0 0 io.tr-064.0 Dec 19 12:00:04 pve kernel: [2217759] 101000 2217759 164952 7359 2273280 0 0 io.harmony.0 Dec 19 12:00:04 pve kernel: [2217775] 101000 2217775 160450 6573 1642496 0 0 io.adguard.0 Dec 19 12:00:04 pve kernel: [2218017] 101000 2218017 214907 7572 2383872 0 0 io.backitup.0 Dec 19 12:00:04 pve kernel: [2218150] 101000 2218150 231722 7946 2428928 0 0 io.bring.0 Dec 19 12:00:04 pve kernel: [2218523] 101000 2218523 232837 9348 2523136 0 0 io.discovergy.0 Dec 19 12:00:04 pve kernel: [2218752] 101000 2218752 159014 4933 1458176 0 0 io.echarts.0 Dec 19 12:00:04 pve kernel: [2219699] 101000 2219699 182420 8876 2195456 0 0 io.heatingcontr Dec 19 12:00:04 pve kernel: [2219720] 101000 2219720 159883 5658 1589248 0 0 node Dec 19 12:00:04 pve kernel: [2220141] 101000 2220141 231188 7431 2338816 0 0 io.homeconnect. Dec 19 12:00:04 pve kernel: [2220340] 101000 2220340 181291 6466 2203648 0 0 io.info.0 Dec 19 12:00:04 pve kernel: [2220863] 101000 2220863 205860 15575 2674688 0 0 io.iot.0 Dec 19 12:00:04 pve kernel: [2221010] 101000 2221010 197282 6368 2260992 0 0 io.linux-contro Dec 19 12:00:04 pve kernel: [2221219] 101000 2221219 165886 8595 2428928 0 0 io.logparser.0 Dec 19 12:00:04 pve kernel: [2221491] 101000 2221491 167626 9756 2445312 0 0 io.proxmox.0 Dec 19 12:00:04 pve kernel: [2222943] 101000 2222943 165576 7861 2301952 0 0 io.proxmox.1 Dec 19 12:00:04 pve kernel: [2223643] 101000 2223643 159478 5448 1519616 0 0 io.sayit.0 Dec 19 12:00:04 pve kernel: [2223790] 101000 2223790 159344 5588 1515520 0 0 io.simple-api.0 Dec 19 12:00:04 pve kernel: [2223905] 101000 2223905 181697 8135 2273280 0 0 io.socketio.0 Dec 19 12:00:04 pve kernel: [2224007] 101000 2224007 164848 7058 2252800 0 0 io.sourceanalyt Dec 19 12:00:04 pve kernel: [2224092] 101000 2224092 159444 5559 1527808 0 0 io.text2command Dec 19 12:00:04 pve kernel: [2224280] 101000 2224280 168214 10790 2105344 0 0 io.virtualpower Dec 19 12:00:04 pve kernel: [2224540] 101000 2224540 158905 4878 1441792 0 0 io.vis-inventwo Dec 19 12:00:04 pve kernel: [2224878] 101000 2224878 182752 8219 2445312 0 0 io.web.0 Dec 19 12:00:04 pve kernel: [2225335] 101000 2225335 163647 5349 2146304 0 0 io.yeelight-2.0 Dec 19 12:00:04 pve kernel: [2225439] 101000 2225439 159989 5617 1564672 0 0 io.lametric.0 Dec 19 12:00:04 pve kernel: [2368750] 101000 2368750 200733 17827 2650112 0 0 io.ical.0 Dec 19 12:00:04 pve kernel: [2368754] 101000 2368754 605 16 45056 0 0 sh Dec 19 12:00:04 pve kernel: [2368760] 101000 2368760 939 60 49152 0 0 iobroker Dec 19 12:00:04 pve kernel: [2368762] 101000 2368762 231390 29313 3022848 0 0 node Dec 19 12:00:04 pve kernel: [2368831] 101000 2368831 159087 7380 1503232 0 0 node Dec 19 12:00:04 pve kernel: [2368844] 101000 2368844 160905 8936 1736704 0 0 node Dec 19 12:00:04 pve kernel: oom-kill:constraint=CONSTRAINT_MEMCG,nodemask=(null),cpuset=ns,mems_allowed=0,oom_memcg=/lxc/104,task_memcg=/lxc/104/ns/system.slice/iobroker.service,task=iobroker.js-con,pid=2210726,uid=101000 Dec 19 12:00:04 pve kernel: Memory cgroup out of memory: Killed process 2210726 (iobroker.js-con) total-vm:1392380kB, anon-rss:656148kB, file-rss:0kB, shmem-rss:0kB, UID:101000 pgtables:8132kB oom_score_adj:0 Dec 19 12:00:04 pve kernel: oom_reaper: reaped process 2210726 (iobroker.js-con), now anon-rss:0kB, file-rss:0kB, shmem-rss:0kBTOP spuckt aktuell das aus:

Wenn ich von allen Containern und VMs die Speicherzuweisung zusammen rechne, komme ich ca auf 17GB, im System sind 32 GB verbaut. Sollte doch eigentlich dicke reichen. Da es hier ja auch einige Proxmox Profis gibt, kann man da irgend etwas machen, damit der Prozess nicht gekillt wird ? ioBroker habe ich momentan 4GB zugewiesen, die RAM Auslastung liegt bei 80%.

Allerdings liegt die Gesamtauslastung des RAMs schon bei 92% oder so. Allerdings denke ich, dass es der Effekt ist, da bei Linux ja nichts verschwendet wird und bei Bedarf freigegeben wird ?! Da bin ich überfragt, ob es in dieser Ansicht das gleiche ist. Ansonsten weiß ich nicht, wie der Verbrauch zustande kommt.

Danke schon mal für die AntwortenGruß Holger

@holger76 Ich habe meinem ioBroker Container 6 GB zugewiesen, weil er mit 4 GB auch instabil gelaufen ist.

Aber irgendwas stimmt mit deiner Speicherzuweisung bei den Containern nicht. Wenn du wirklich nur insgesamt 17 Gb verteilt hast dürfte das niemals mit 90% angezeigt werden. Hast du das sicher kontrolliert?

Wie viele VMs bzw. CT laufen da aktuell? -

@holger76 Ich habe meinem ioBroker Container 6 GB zugewiesen, weil er mit 4 GB auch instabil gelaufen ist.

Aber irgendwas stimmt mit deiner Speicherzuweisung bei den Containern nicht. Wenn du wirklich nur insgesamt 17 Gb verteilt hast dürfte das niemals mit 90% angezeigt werden. Hast du das sicher kontrolliert?

Wie viele VMs bzw. CT laufen da aktuell?@chaot

Ich find es auch komisch, weil ich nun bis auf 2 VMs alles auf Container habe und eigentlich nicht mehr habe. Ok, statt Loganalyzer nutze ich seit kurzem Graylog, was etwas mehr futtert, Erstes hatte ich vorher bei Influx mit in der VM, jetzt als separaten Container.

Ich hab die VMs noch nicht gelöscht, aber deaktiviert.. da sollten sie ja nichts verbrauchen. Wenn ich Win10 stoppe, habe ich wirklich ca 3000MB mehr und bin bei 80%.Hier mal meine aktuellen Container und zuweisungen:

Cont. Adguard 70MB von 400MB

Cont. iobroker 3000MB von 4000MB

Cont. InfluxDB2 900MB von 2000MB

Cont. Graylog 2700MB von 3000MB

VM OctoPrint 500MB von 1000MB

VM Raspberrymatic 450MB von 1300MB

VM Conbee 1700MB von 2000MB

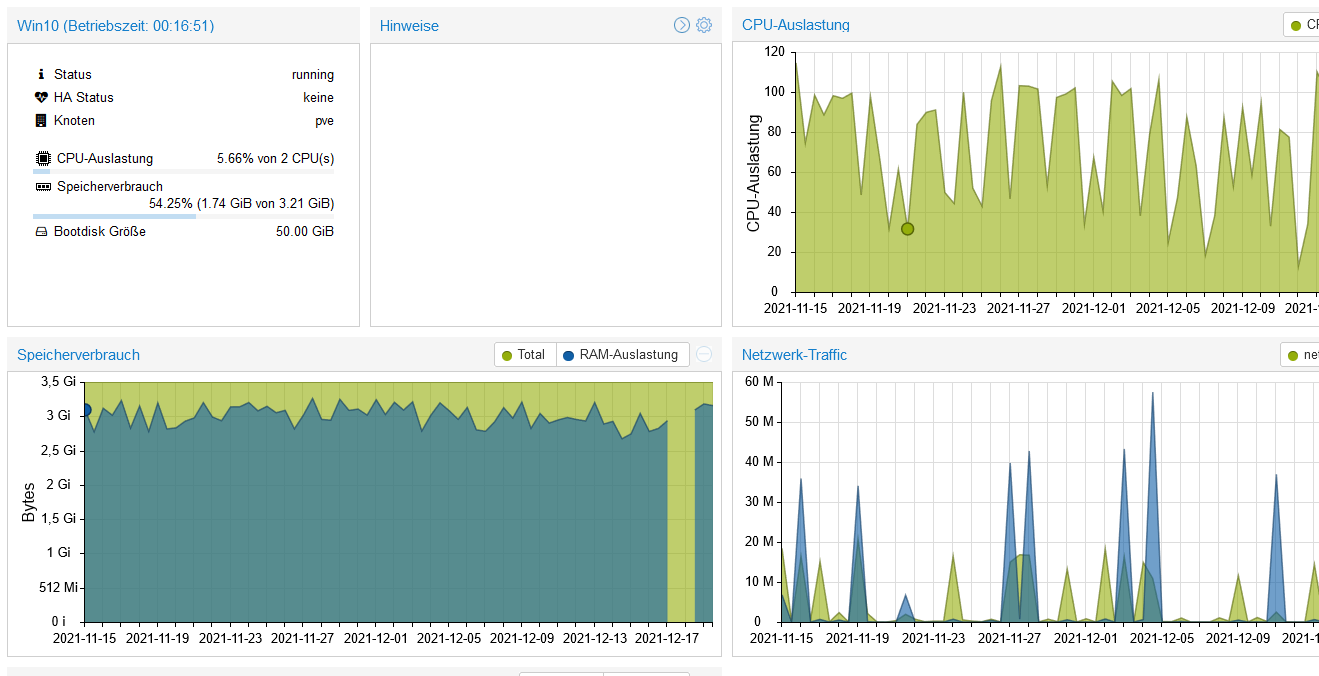

VM Win10 2700MB von 3200MBich hatte bei einigen Sachen testweise noch etwas gekürzt.

-

@chaot

Ich find es auch komisch, weil ich nun bis auf 2 VMs alles auf Container habe und eigentlich nicht mehr habe. Ok, statt Loganalyzer nutze ich seit kurzem Graylog, was etwas mehr futtert, Erstes hatte ich vorher bei Influx mit in der VM, jetzt als separaten Container.

Ich hab die VMs noch nicht gelöscht, aber deaktiviert.. da sollten sie ja nichts verbrauchen. Wenn ich Win10 stoppe, habe ich wirklich ca 3000MB mehr und bin bei 80%.Hier mal meine aktuellen Container und zuweisungen:

Cont. Adguard 70MB von 400MB

Cont. iobroker 3000MB von 4000MB

Cont. InfluxDB2 900MB von 2000MB

Cont. Graylog 2700MB von 3000MB

VM OctoPrint 500MB von 1000MB

VM Raspberrymatic 450MB von 1300MB

VM Conbee 1700MB von 2000MB

VM Win10 2700MB von 3200MBich hatte bei einigen Sachen testweise noch etwas gekürzt.

-

@holger76 Seltsam.

Aber mal so am Rande: Win 10 läuft mit 3 GB? Das kann ich mir fast nicht vorstellen. -

@crunchip

ja klar, proxmox braucht auch. aber 15GB ? Ich ging jetzt halt davon aus, dass der Stets aufgefüllt wird bis zur einer gewissen Grenze, eigtnlich keinne ich das auch nur so, dass er min. 80-90% hat, egal wieviel ich am laufen habe. Das ist schon extrem merkwürdig.Das mit dem swap stimmt natürlich, allerdings weiß ich nun nicht, wie ich das aktivieren kann. Wahrscheinlich gar nicht, ohne neu aufzusetzen ? Ich kann mir auch nicht erklären, wie das Zustande gekommen ist, dass da keiner aktiviert ist. Der lagert dann auf Festplatte aus, wenn ich das richtig verstanden habe. Heißt dann aber im klartext, da fehlt wirklich RAM. Wo man dann wohl sagen muss, das System an sich braucht wirklich min. genauso viel RAM, wie für die Cont.+VMs zugewiesen sind :face_with_rolling_eyes:

@holger76 sagte in JS-Controller startet ständig neu (out of mem in Proxmox):

Das mit dem swap stimmt natürlich, allerdings weiß ich nun nicht, wie ich das aktivieren kann

so wie du es auch deaktiviert hast:relaxed:

swaponhttps://wiki.ubuntuusers.de/Swap/

@holger76 sagte in JS-Controller startet ständig neu (out of mem in Proxmox):

Ich kann mir auch nicht erklären, wie das Zustande gekommen ist, dass da keiner aktiviert ist

den legst du doch beim installieren von Proxmox fest

-

@holger76 sagte in JS-Controller startet ständig neu (out of mem in Proxmox):

Das mit dem swap stimmt natürlich, allerdings weiß ich nun nicht, wie ich das aktivieren kann

so wie du es auch deaktiviert hast:relaxed:

swaponhttps://wiki.ubuntuusers.de/Swap/

@holger76 sagte in JS-Controller startet ständig neu (out of mem in Proxmox):

Ich kann mir auch nicht erklären, wie das Zustande gekommen ist, dass da keiner aktiviert ist

den legst du doch beim installieren von Proxmox fest

Ja so kenn ich das auch, jedoch war mir nicht bewusst, dass ich das wissentlich beim installieren deaktiviert habe.

Nachträglich zu ändern, stellt sich für mich als schwierig bis unmöglich dar, da die Platte komplett verplant ist. Da mit irgendwelchen tools Platz zu schaffen, shrinken usw. , werd ich wohl mit meinen laienhaften Linux Kenntnissen nicht wagen, auch wenn ich tgl Backups der Cont/VMs mache. Da hängt halt das ganze Haussystem dran, wo es hier einen großen Aufstand gibt, wenn es ein paar Stunden nicht läuft.. also mindestens. Naja wir werden sehen. Trotzdem, selbst wenn der Swap aktiv ist, bin ich nicht glücklich, wenn meine SSD dann dauernd benutzt wird für RAM Aufgaben. Ich versteh es halt einfach nicht, wohin der RAM ist. Linux ist doch eigentlich nicht so verfressen. -

@chaot sagte in JS-Controller startet ständig neu (out of mem in Proxmox):

@holger76 Seltsam.

Aber mal so am Rande: Win 10 läuft mit 3 GB? Das kann ich mir fast nicht vorstellen.Naja, viel läuft da nicht drin, aber ja... tut es

@holger76 sagte in JS-Controller startet ständig neu (out of mem in Proxmox):

aber ja... tut es

aber dauern am RAM-Limit

-

Ja so kenn ich das auch, jedoch war mir nicht bewusst, dass ich das wissentlich beim installieren deaktiviert habe.

Nachträglich zu ändern, stellt sich für mich als schwierig bis unmöglich dar, da die Platte komplett verplant ist. Da mit irgendwelchen tools Platz zu schaffen, shrinken usw. , werd ich wohl mit meinen laienhaften Linux Kenntnissen nicht wagen, auch wenn ich tgl Backups der Cont/VMs mache. Da hängt halt das ganze Haussystem dran, wo es hier einen großen Aufstand gibt, wenn es ein paar Stunden nicht läuft.. also mindestens. Naja wir werden sehen. Trotzdem, selbst wenn der Swap aktiv ist, bin ich nicht glücklich, wenn meine SSD dann dauernd benutzt wird für RAM Aufgaben. Ich versteh es halt einfach nicht, wohin der RAM ist. Linux ist doch eigentlich nicht so verfressen.@holger76 sagte in JS-Controller startet ständig neu (out of mem in Proxmox):

Ja so kenn ich das auch, jedoch war mir nicht bewusst, dass ich das wissentlich beim installieren deaktiviert habe.

dann guck doch nach

/etc/fstab, ob da ein swap eingetragen ist, vllt hast du den auch nur deaktiviert mittels (swapoff) -

@holger76 sagte in JS-Controller startet ständig neu (out of mem in Proxmox):

aber ja... tut es

aber dauern am RAM-Limit

@homoran sagte in JS-Controller startet ständig neu (out of mem in Proxmox):

@holger76 sagte in JS-Controller startet ständig neu (out of mem in Proxmox):

aber ja... tut es

aber dauern am RAM-Limit

Mag sein, aber da ich dort keine Probleme habe und stets das gleiche läuft, bleibt es halt so, zumindest bei der aktuellen Lage

Ansonsten, ich hab alles auf ZFS und gerade gelesen, dass das sehr speicherhungrig ist. Evtl liegt es ja daran und ich muss damit leben bzw schon wieder umsteigen uaf 64 GB zb. Leider kann mein nuc8i5beh lt spec keine 64GB.

Allerdings kann mein NUC6CAYH auch 16GB statt wie angegeben 8GB. -

@homoran sagte in JS-Controller startet ständig neu (out of mem in Proxmox):

@holger76 sagte in JS-Controller startet ständig neu (out of mem in Proxmox):

aber ja... tut es

aber dauern am RAM-Limit

Mag sein, aber da ich dort keine Probleme habe und stets das gleiche läuft, bleibt es halt so, zumindest bei der aktuellen Lage

Ansonsten, ich hab alles auf ZFS und gerade gelesen, dass das sehr speicherhungrig ist. Evtl liegt es ja daran und ich muss damit leben bzw schon wieder umsteigen uaf 64 GB zb. Leider kann mein nuc8i5beh lt spec keine 64GB.

Allerdings kann mein NUC6CAYH auch 16GB statt wie angegeben 8GB.@holger76 sagte in JS-Controller startet ständig neu (out of mem in Proxmox):

aber da ich dort keine Probleme habe

wieso nicht?

deine gesamte PVE bricht zusammenpve kernel: Memory cgroup out of memory: Killed process 2210726 (iobroker.js-con)

oder habe ich das falsch verstanden?

-

@holger76 sagte in JS-Controller startet ständig neu (out of mem in Proxmox):

aber da ich dort keine Probleme habe

wieso nicht?

deine gesamte PVE bricht zusammenpve kernel: Memory cgroup out of memory: Killed process 2210726 (iobroker.js-con)

oder habe ich das falsch verstanden?

@homoran

also bisher war es so, wenn ich in einer VM Probleme hatte, hab ich das nur direkt darin gemerkt. Alles andere war nicht betroffen. Wenn ich in Proxmox zu wenig Speicher hatte, ausschließlich auf VMs gesetzt habe, hat er unter Umständen die ganze VM gestoppt. Nun, wo ich viel auf Container setze, werden halt auch einzelne Prozesse gestoppt bzw. neu gestartet. Also sehe ich das momentan so, entweder die Win VM läuft komplett oder gar nicht , weil gestoppt. Ansonsten sollte es dem Proxmox system eigentlich ansonsten egal sein, ob das Windows System in der VM irgendwelche Probleme hat. Außer natürlich, man hat dafür alle Kerne etc freigegeben und die CPU arbeitet am Anschlag. Tut es aber nicht. Aber ich glaube, das führt hier etwas weg vom eigentlichen Problem und Windows ist bei mir wirklich das, was am Unwichtigsten ist. Notfalls stoppe ich das Ding vorerst komplett.Die Frage war ja, wieso braucht Proxmox 50% des Speichers für sich allein. Hat da jemand ähnliche Erfahrung oder wie sieht es bei den anderen aus ? Ggf. noch mit Info, welches Dateisystem oder sonstige Besonderheiten. Cluster zb. nutze ich nicht. Es ist nur ein SMB als Speicher eingebunden, wo wöchentlich ein Backup darauf gemacht wird und täglich auf ein anderes System per Proxmox Backup Server.

-

@holger76 sagte in JS-Controller startet ständig neu (out of mem in Proxmox):

Ja so kenn ich das auch, jedoch war mir nicht bewusst, dass ich das wissentlich beim installieren deaktiviert habe.

dann guck doch nach

/etc/fstab, ob da ein swap eingetragen ist, vllt hast du den auch nur deaktiviert mittels (swapoff)@crunchip sagte in JS-Controller startet ständig neu (out of mem in Proxmox):

dann guck doch nach

/etc/fstab, ob da ein swap eingetragen ist, vllt hast du den auch nur deaktiviert mittels (swapoff)proc /proc proc defaults 0 0

mehr steht nicht drin. Genau das gleiche steht auch in meinem anderen Proxmox System, da gibt es auch kein Swap.

Ich kann es nicht mehr genau sagen, unter Umständen hatte ich damals etwas gelesen, das besser nicht zu nutzen, wegen irgendwelchen Problemen damit. Anders kann ich es mir auch nicht mehr erklären. -

@homoran

also bisher war es so, wenn ich in einer VM Probleme hatte, hab ich das nur direkt darin gemerkt. Alles andere war nicht betroffen. Wenn ich in Proxmox zu wenig Speicher hatte, ausschließlich auf VMs gesetzt habe, hat er unter Umständen die ganze VM gestoppt. Nun, wo ich viel auf Container setze, werden halt auch einzelne Prozesse gestoppt bzw. neu gestartet. Also sehe ich das momentan so, entweder die Win VM läuft komplett oder gar nicht , weil gestoppt. Ansonsten sollte es dem Proxmox system eigentlich ansonsten egal sein, ob das Windows System in der VM irgendwelche Probleme hat. Außer natürlich, man hat dafür alle Kerne etc freigegeben und die CPU arbeitet am Anschlag. Tut es aber nicht. Aber ich glaube, das führt hier etwas weg vom eigentlichen Problem und Windows ist bei mir wirklich das, was am Unwichtigsten ist. Notfalls stoppe ich das Ding vorerst komplett.Die Frage war ja, wieso braucht Proxmox 50% des Speichers für sich allein. Hat da jemand ähnliche Erfahrung oder wie sieht es bei den anderen aus ? Ggf. noch mit Info, welches Dateisystem oder sonstige Besonderheiten. Cluster zb. nutze ich nicht. Es ist nur ein SMB als Speicher eingebunden, wo wöchentlich ein Backup darauf gemacht wird und täglich auf ein anderes System per Proxmox Backup Server.

@holger76 sagte in JS-Controller startet ständig neu (out of mem in Proxmox):

Die Frage war ja, wieso braucht Proxmox 50% des Speichers für sich allein.

hast du dir doch schon selbst beantwortet, zfs benötigt wesentlich mehr Ram, stellt sich nur die Frage, warum überhaupt zfs?

@holger76 sagte in JS-Controller startet ständig neu (out of mem in Proxmox):

hab ich das nur direkt darin gemerkt. Alles andere war nicht betroffen. Wenn ich in Proxmox zu wenig Speicher hatte

das müsstest ja auch entspechend im syslog sehen

-

@crunchip sagte in JS-Controller startet ständig neu (out of mem in Proxmox):

stellt sich nur die Frage, warum überhaupt zfs?

Seit ich auf zfs umgestellt habe, funktionieren snapshots und das Rückspielen selbiger pfeilschnell. Das ist schon cool!

-

@crunchip sagte in JS-Controller startet ständig neu (out of mem in Proxmox):

stellt sich nur die Frage, warum überhaupt zfs?

Seit ich auf zfs umgestellt habe, funktionieren snapshots und das Rückspielen selbiger pfeilschnell. Das ist schon cool!

Ich habe bisher uach nur gutes über ZFS gelesen und erfahren... ausser natürlich das mit dem Speicher. Wobei ich mich Frage, ob man das nicht evtl etwas drosseln kann, ist ja evtl auch irgendwo einzustellen, wieviel da so als Puffer oder was auch immer damit gemacht wird, benutzt wird.

-

@crunchip sagte in JS-Controller startet ständig neu (out of mem in Proxmox):

stellt sich nur die Frage, warum überhaupt zfs?

Seit ich auf zfs umgestellt habe, funktionieren snapshots und das Rückspielen selbiger pfeilschnell. Das ist schon cool!

@meister-mopper sagte in JS-Controller startet ständig neu (out of mem in Proxmox):

funktionieren snapshots und das Rückspielen selbiger pfeilschnell

nutze ich für gewöhnlich nicht:stuck_out_tongue_winking_eye:

aber unterm Strich macht es doch keinen Sinn zfs zu benutzen, bei nur einer Platte und wenn man nicht genug Ram über hat, erst recht nicht

-

Ich habe bisher uach nur gutes über ZFS gelesen und erfahren... ausser natürlich das mit dem Speicher. Wobei ich mich Frage, ob man das nicht evtl etwas drosseln kann, ist ja evtl auch irgendwo einzustellen, wieviel da so als Puffer oder was auch immer damit gemacht wird, benutzt wird.

@holger76 sagte in JS-Controller startet ständig neu (out of mem in Proxmox):

Wobei ich mich Frage, ob man das nicht evtl etwas drosseln kann, ist ja evtl auch irgendwo einzustellen

meine auch, das ich es mal irgendwo gelesen habe, das man den Ram Verbrauch einstellen kann