NEWS

[Linux Shell-Skript] WLAN-Wetterstation

-

@sebhoff sagte in [Linux Shell-Skript] WLAN-Wetterstation:

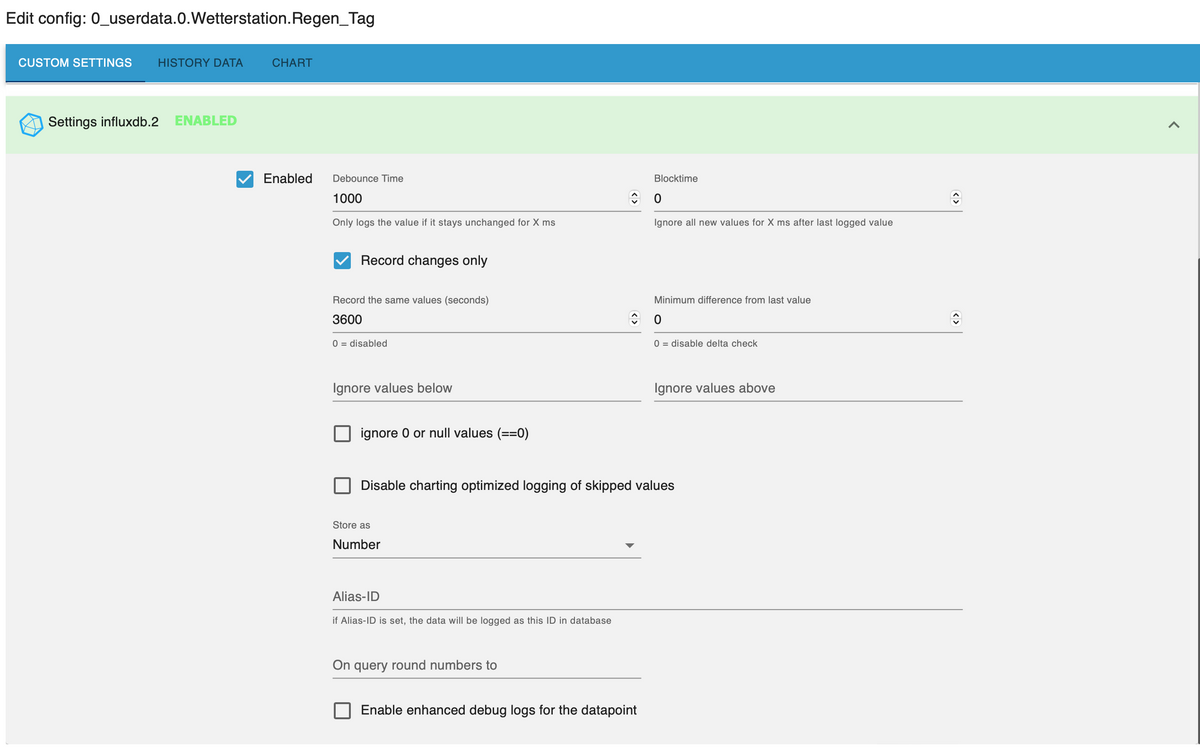

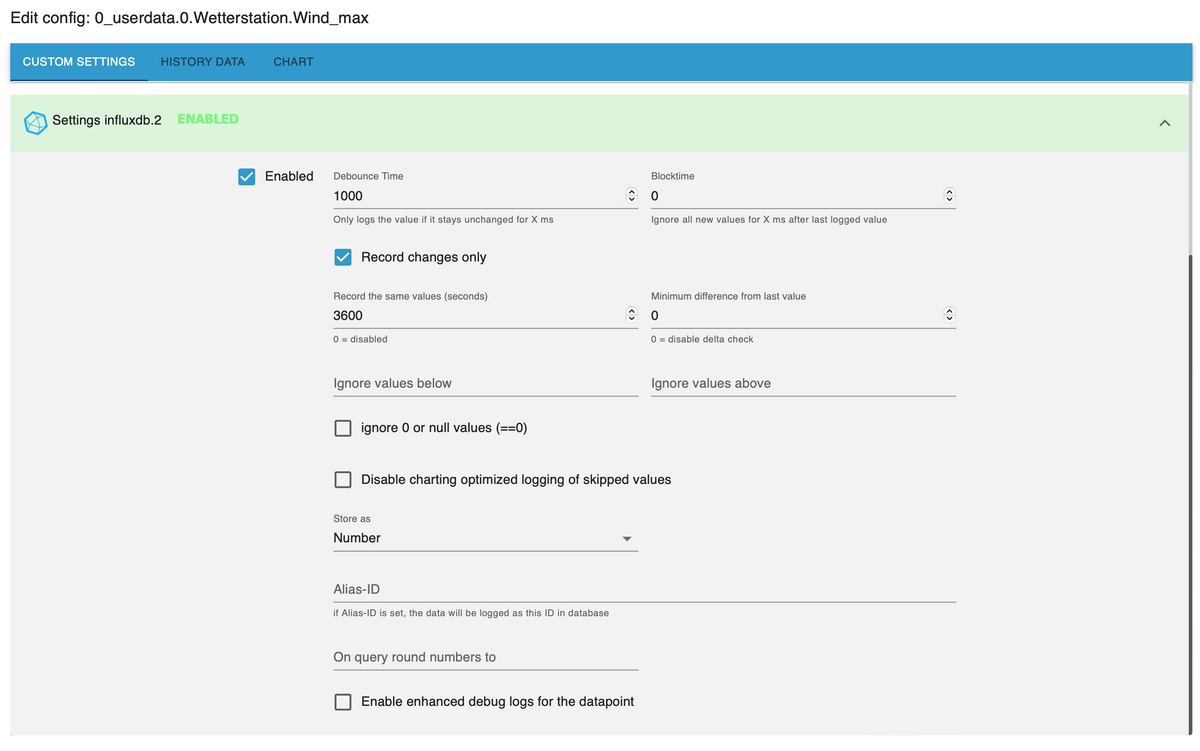

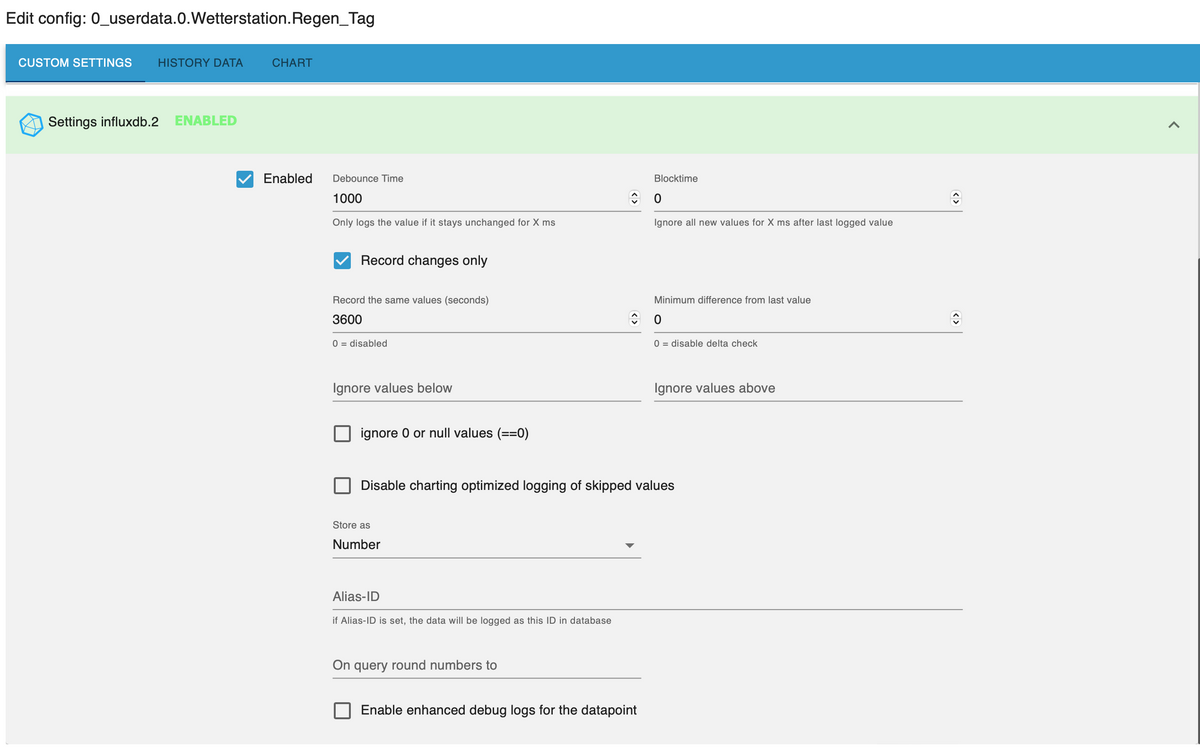

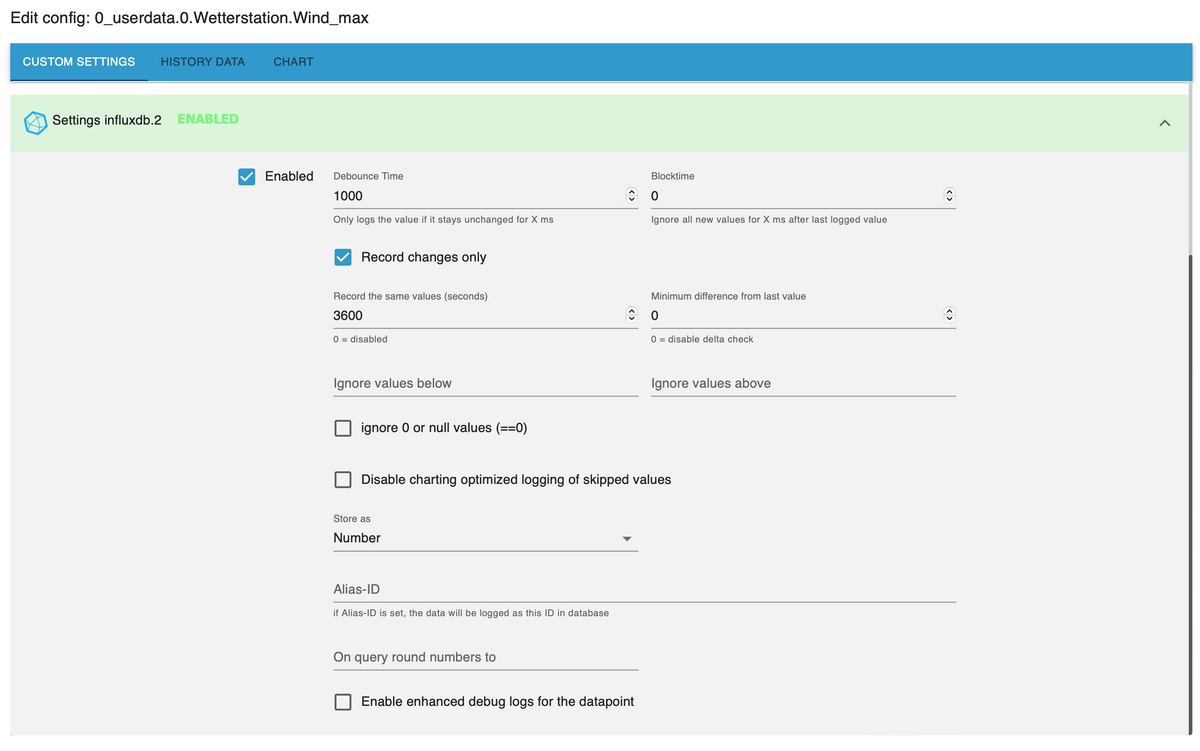

Also Regen_Tag wird in die shorttermBucket geschrieben - ebenso wie Wind_max

...und den Namen und Instanz hast du dann auch im Statistikscript angegeben?

So wie das aktuell aussieht schreibst du in ein anderes Bucket als das aus welchem du dann die Daten ließt.@sborg said in [Linux Shell-Skript] WLAN-Wetterstation:

@sebhoff sagte in [Linux Shell-Skript] WLAN-Wetterstation:

Also Regen_Tag wird in die shorttermBucket geschrieben - ebenso wie Wind_max

...und den Namen und Instanz hast du dann auch im Statistikscript angegeben?

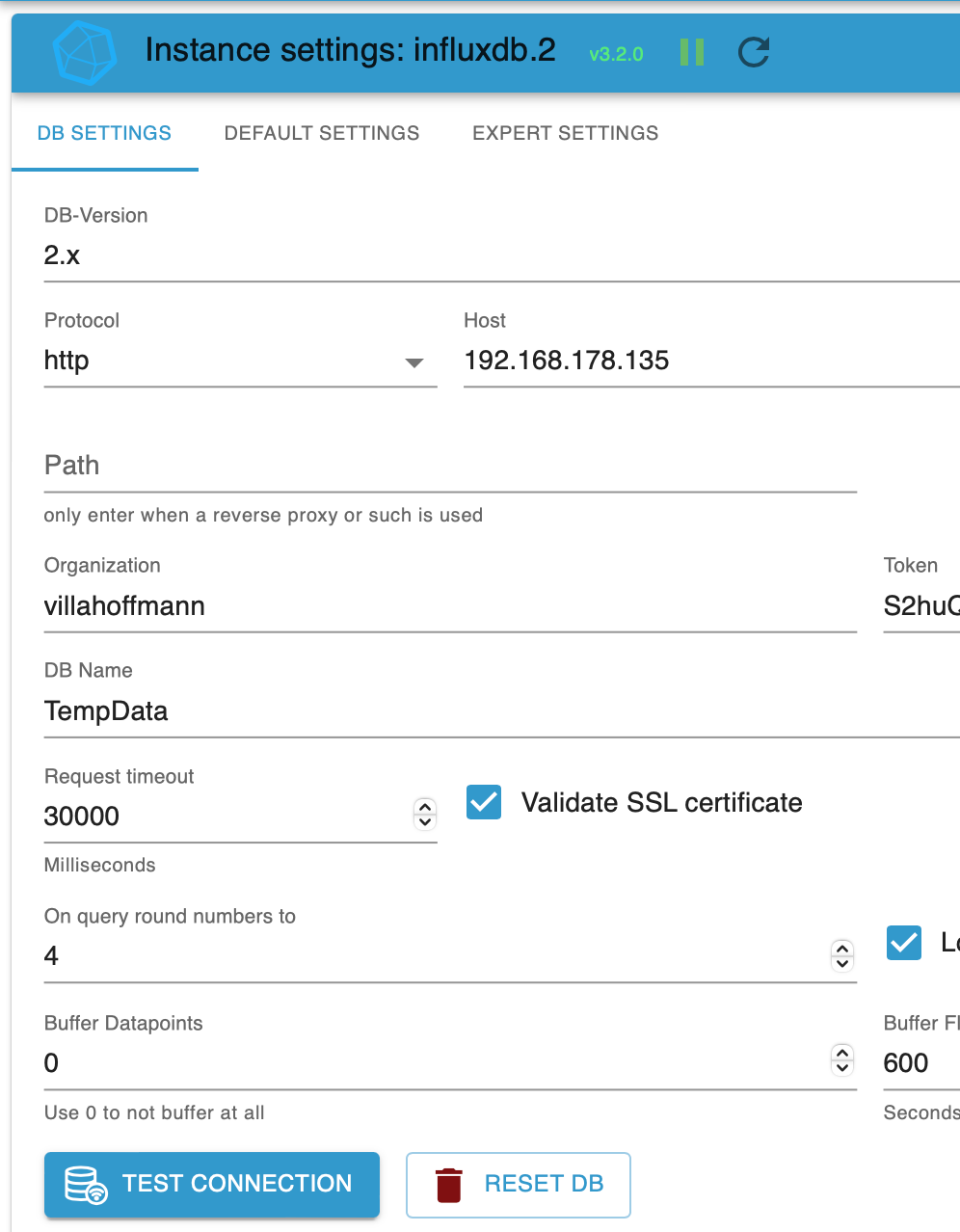

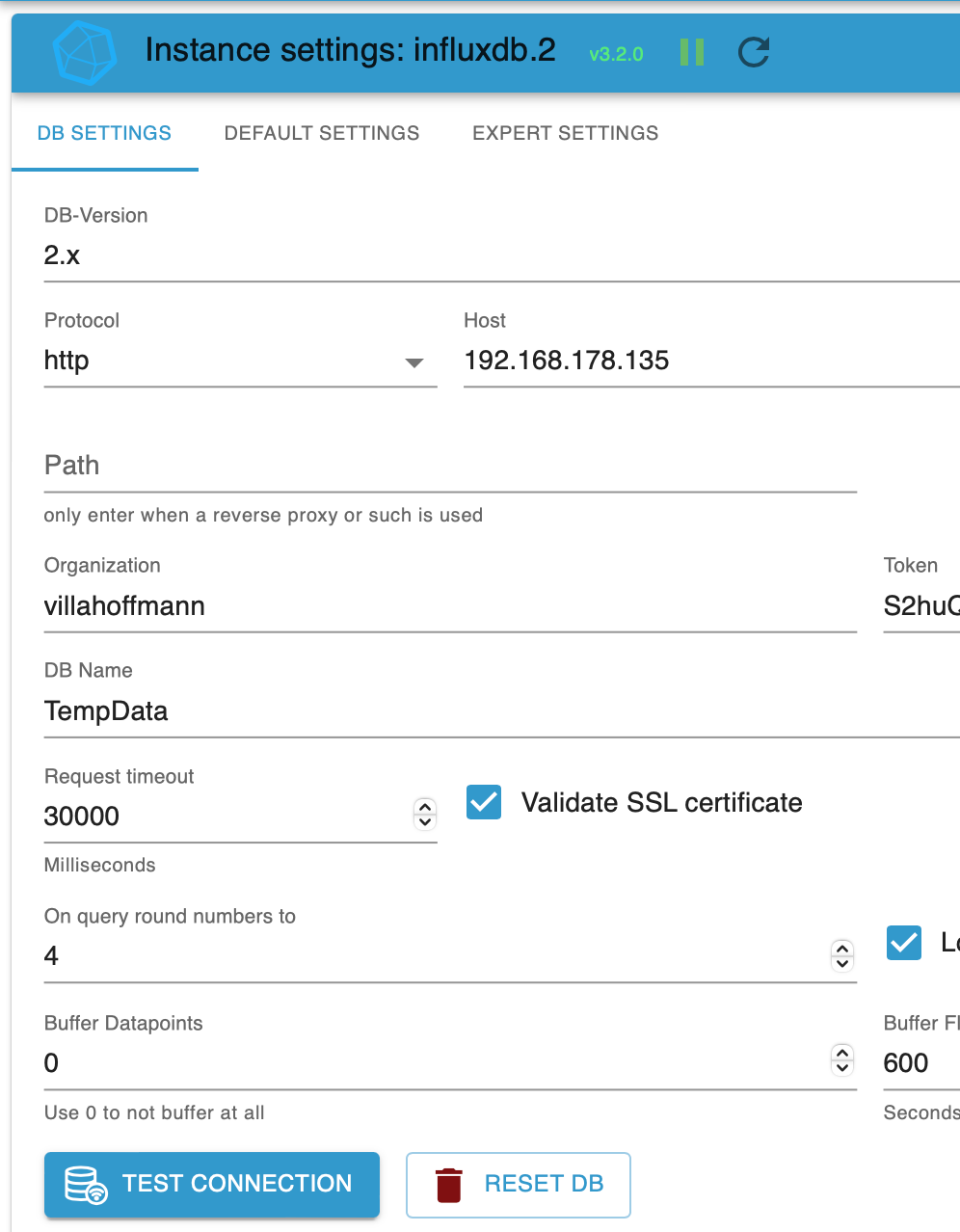

So wie das aktuell aussieht schreibst du in ein anderes Bucket als das aus welchem du dann die Daten ließt.Also bei mir sieht das so aus:

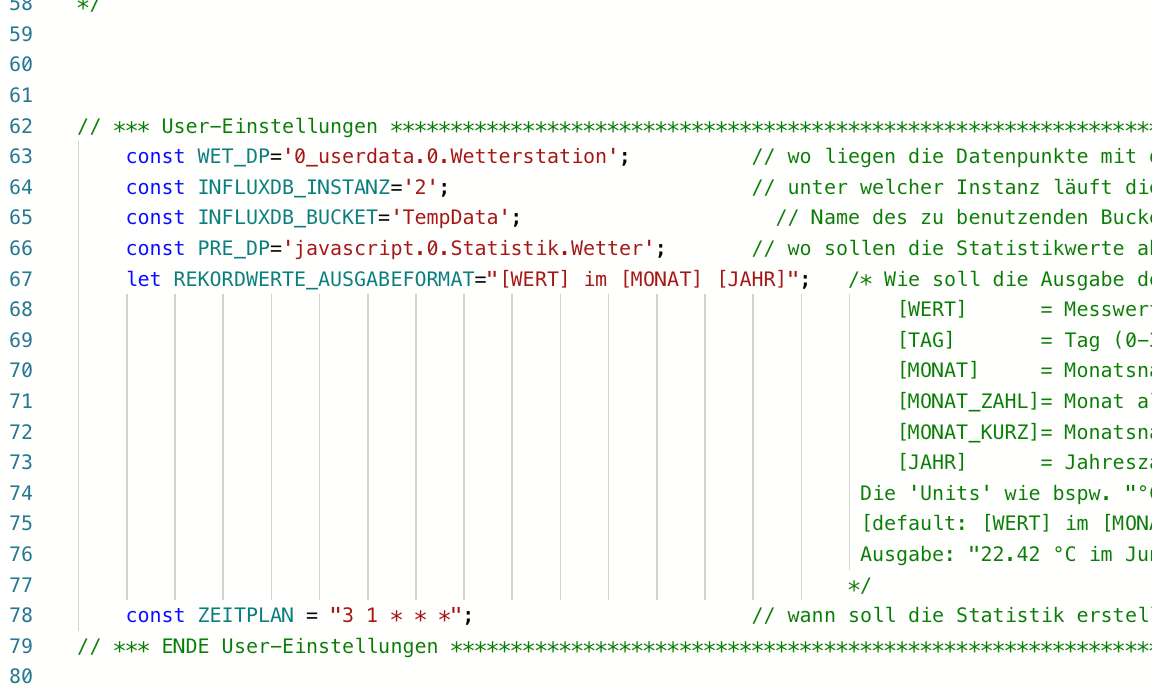

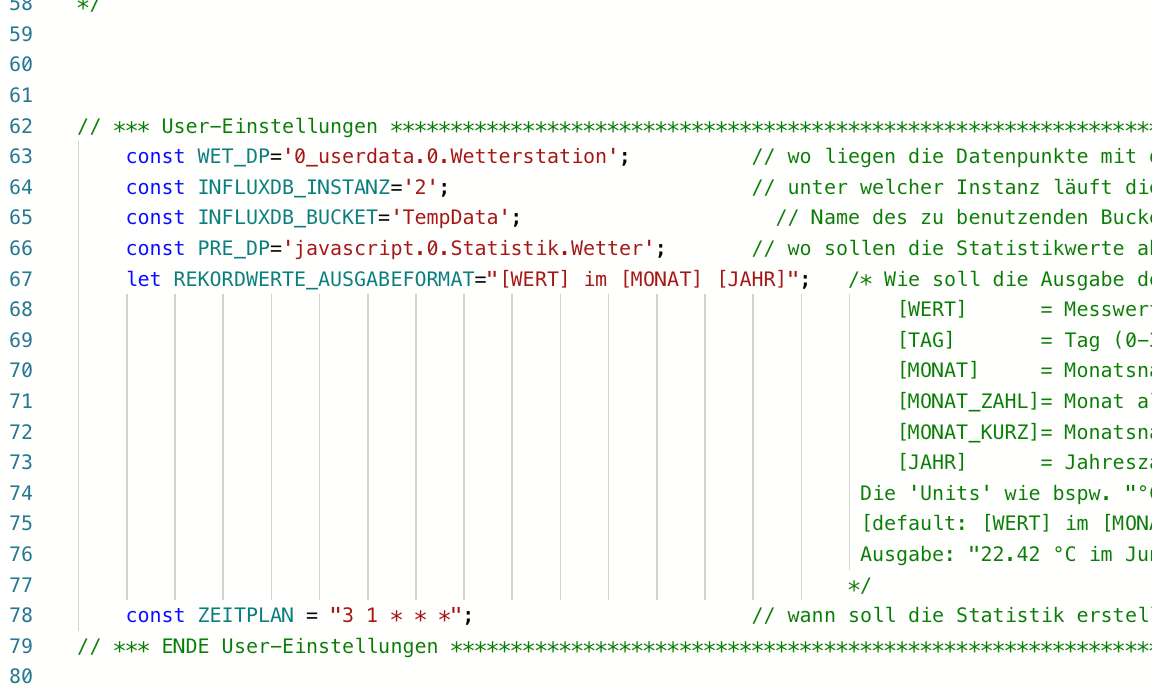

Und dann die Config des Statistik-Skripts:

Und die DB heißt auch definitiv TempData:

Ich weiß echt nicht mehr, was ich noch anders machen sollte...?

-

@sborg said in [Linux Shell-Skript] WLAN-Wetterstation:

@sebhoff sagte in [Linux Shell-Skript] WLAN-Wetterstation:

Also Regen_Tag wird in die shorttermBucket geschrieben - ebenso wie Wind_max

...und den Namen und Instanz hast du dann auch im Statistikscript angegeben?

So wie das aktuell aussieht schreibst du in ein anderes Bucket als das aus welchem du dann die Daten ließt.Also bei mir sieht das so aus:

Und dann die Config des Statistik-Skripts:

Und die DB heißt auch definitiv TempData:

Ich weiß echt nicht mehr, was ich noch anders machen sollte...?

Es ist schon Absicht, dass die Statistik-Daten unter javascript.0. abgelegt werden?

-

Es ist schon Absicht, dass die Statistik-Daten unter javascript.0. abgelegt werden?

@boronsbruder Ist aber nicht unbedingt maßgeblich, die werden ja nur dort abgespeichert und von nichts anderem sonst mehr angerührt, außer man greift da per Blockly etc. darauf zu.

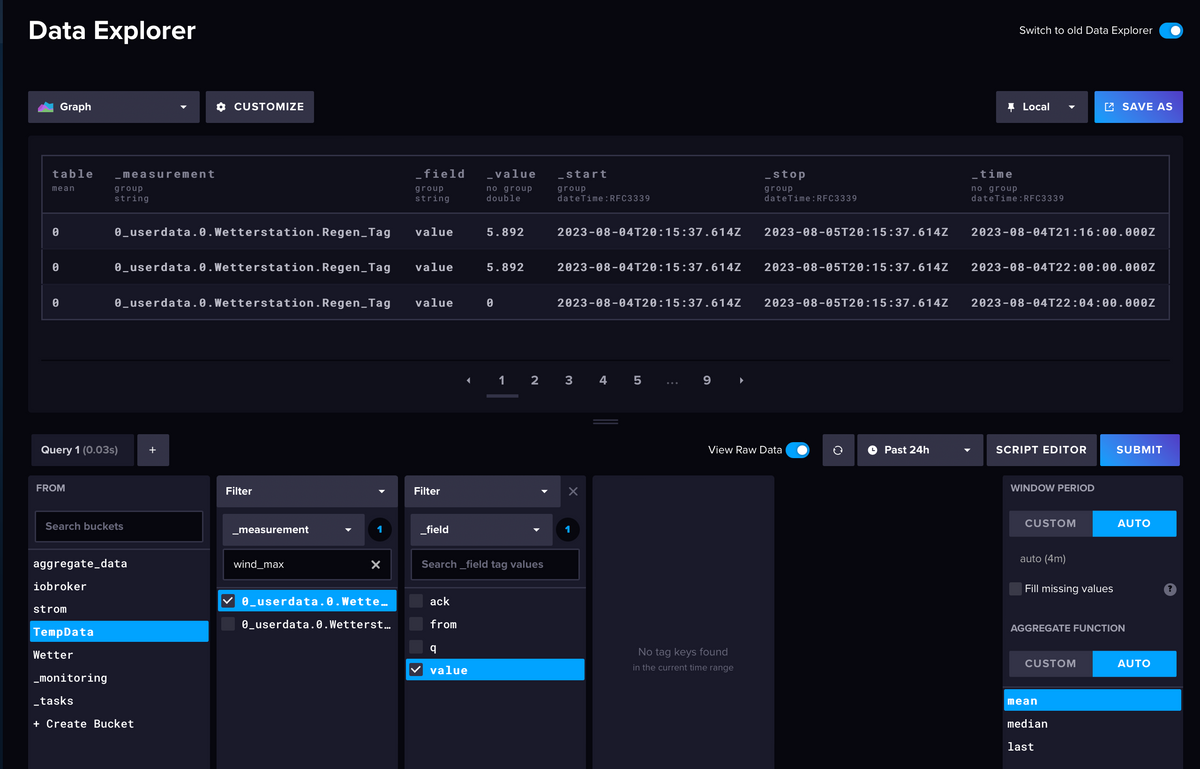

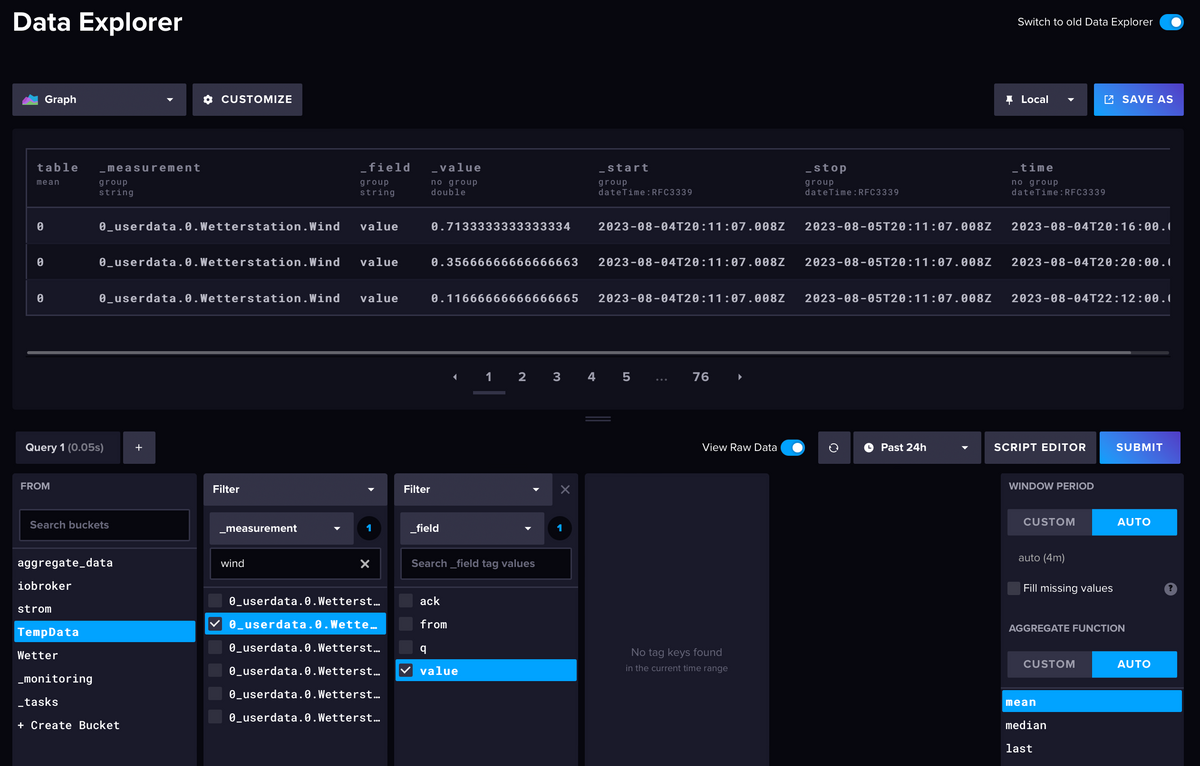

@sebhoff Sieht jetzt soweit gut aus. Hast du mal mit dem Influx-Explorer nachgeschaut ob auch wirklich Daten (Temp, wind und Regen) in deinem "TempData"-Bucket landen?

-

@boronsbruder Ist aber nicht unbedingt maßgeblich, die werden ja nur dort abgespeichert und von nichts anderem sonst mehr angerührt, außer man greift da per Blockly etc. darauf zu.

@sebhoff Sieht jetzt soweit gut aus. Hast du mal mit dem Influx-Explorer nachgeschaut ob auch wirklich Daten (Temp, wind und Regen) in deinem "TempData"-Bucket landen?

@sborg

Ich dachte eher, dass er umgestellt hat von 'javavscript.0.' auf '0_userdata.' und dort noch die alten Daten sind -

@boronsbruder Ist aber nicht unbedingt maßgeblich, die werden ja nur dort abgespeichert und von nichts anderem sonst mehr angerührt, außer man greift da per Blockly etc. darauf zu.

@sebhoff Sieht jetzt soweit gut aus. Hast du mal mit dem Influx-Explorer nachgeschaut ob auch wirklich Daten (Temp, wind und Regen) in deinem "TempData"-Bucket landen?

@sborg said in [Linux Shell-Skript] WLAN-Wetterstation:

@sebhoff Sieht jetzt soweit gut aus. Hast du mal mit dem Influx-Explorer nachgeschaut ob auch wirklich Daten (Temp, wind und Regen) in deinem "TempData"-Bucket landen?

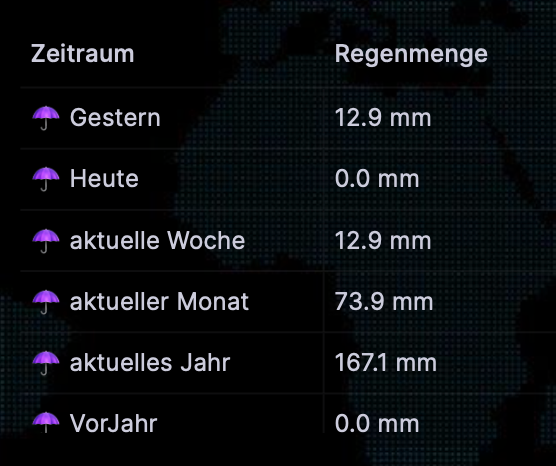

Also soweit ich sehen kann, kommt da alles an... Zum Beispiel:

-

@sborg

Ich dachte eher, dass er umgestellt hat von 'javavscript.0.' auf '0_userdata.' und dort noch die alten Daten sind@boronsbruder said in [Linux Shell-Skript] WLAN-Wetterstation:

@sborg

Ich dachte eher, dass er umgestellt hat von 'javavscript.0.' auf '0_userdata.' und dort noch die alten Daten sindJa - wäre möglich gewesen, danke! Der Statistik-Ordner ist aber nur unter 'javavscript.0.' zu finden...

-

OK - ich könnte die Fehlerquelle gefunden haben (?): 0_userdata.0.Wetterstation.Aussentemperatur wird bei mir nicht in TempData sondern in die andere Instanz abgespeichert.

Ich nehme an, dass dann der ganze flux-query in den Zeilen 171-2 im Statistik-Skript auf die Nase fällt und deshalb auch die Werte für Regen und Wind nicht gelesen/verarbeitet werden?

Ich muss zugeben, dass ich das mit dem Abspeichern in verschiedene Instanzen nicht ganz verstanden habe. Es leuchtet ein, dass man nicht alle Datenpunkte auf ewig speichern will - aber welche in die dauerhafte Bucket müssen/sollen habe ich anscheinend noch nicht ganz durchschaut. Werde wohl noch mehr lesen müssen...

Ich werde natürlich auch noch selber suchen, aber vielleicht ist das ja für jemanden hier ganz einfach: bekomme ich jetzt die Werte der letzten Wochen für 0_userdata.0.Wetterstation.Aussentemperatur irgendwie ganz einfach in die shorttermBucket? Oder soll ich einfach ab sofort umstellen?

-

@sborg

Ich dachte eher, dass er umgestellt hat von 'javavscript.0.' auf '0_userdata.' und dort noch die alten Daten sind@boronsbruder sagte in [Linux Shell-Skript] WLAN-Wetterstation:

@sborg

Ich dachte eher, dass er umgestellt hat von 'javavscript.0.' auf '0_userdata.' und dort noch die alten Daten sindZum Teil ja, aber die Eingangsfrage war Temp geht, nur Wind und Regen nicht. Bei falschem Verzeichnis müssten dann aber alle drei nicht gehen ;)

...auch wenn sie da offenbar gar nicht liegen sollen.@sebhoff sagte in [Linux Shell-Skript] WLAN-Wetterstation:

Der Statistik-Ordner ist aber nur unter 'javavscript.0.' zu finden...

So hast du es im Statistik-Skript aber eingetragen. Dass meinte @Boronsbruder auch mit seiner Frage "ob das Absicht ist".

-

OK - ich könnte die Fehlerquelle gefunden haben (?): 0_userdata.0.Wetterstation.Aussentemperatur wird bei mir nicht in TempData sondern in die andere Instanz abgespeichert.

Ich nehme an, dass dann der ganze flux-query in den Zeilen 171-2 im Statistik-Skript auf die Nase fällt und deshalb auch die Werte für Regen und Wind nicht gelesen/verarbeitet werden?

Ich muss zugeben, dass ich das mit dem Abspeichern in verschiedene Instanzen nicht ganz verstanden habe. Es leuchtet ein, dass man nicht alle Datenpunkte auf ewig speichern will - aber welche in die dauerhafte Bucket müssen/sollen habe ich anscheinend noch nicht ganz durchschaut. Werde wohl noch mehr lesen müssen...

Ich werde natürlich auch noch selber suchen, aber vielleicht ist das ja für jemanden hier ganz einfach: bekomme ich jetzt die Werte der letzten Wochen für 0_userdata.0.Wetterstation.Aussentemperatur irgendwie ganz einfach in die shorttermBucket? Oder soll ich einfach ab sofort umstellen?

@sebhoff sagte in [Linux Shell-Skript] WLAN-Wetterstation:

Ich nehme an, dass dann der ganze flux-query in den Zeilen 171-2 im Statistik-Skript auf die Nase fällt und deshalb auch die Werte für Regen und Wind nicht gelesen/verarbeitet werden?

Jepp, da dass eine einzige Abfrage für alle drei Werte ist.

Du musst die Daten alle in ein einziges Bucket loggen. Da die Datenflut aber immens ist (Standardmäßig so alle 30 Sekunden ein Datensatz), sollte man sich überlegen was man wie lange aufheben möchte.

Ich brauche bspw. keine Aussentemperatur vom 18.04.2023 (oder älter) um 14:23:58 Uhr.

Deshalb sollte man in ein Bucket loggen und dem eine feste Retention von bspw. 30 Tagen verpassen. Damit fliegt alles was älter als 30 Tage ist aus dem Bucket raus. Was ich länger aufheben möchte "shiftet" man nun mittels eines Influx-Tasks in ein anderes Bucket (zB. Retention "never") und kann dabei auch noch die Datenflut eingrenzen (zB. die Aussentemp auf ein 15 Minuten-Raster aggregieren). So werden aus ~43k Datensätzen alleine für die Temperatur täglich mal schlanke 96 (!) und ich habe trotzdem noch einen guten Temperaturverlauf bspw. von vor einem Jahr.Die Daten kannst du per Abfrage eingrenzen und als CSV exportieren, dann als Annotated CSV in ein anderes Bucket wieder importieren. Hatte ich so erst vor kurzem @Negalein hier im Thread ausfühtlicher erklärt.

-

@sebhoff sagte in [Linux Shell-Skript] WLAN-Wetterstation:

Ich nehme an, dass dann der ganze flux-query in den Zeilen 171-2 im Statistik-Skript auf die Nase fällt und deshalb auch die Werte für Regen und Wind nicht gelesen/verarbeitet werden?

Jepp, da dass eine einzige Abfrage für alle drei Werte ist.

Du musst die Daten alle in ein einziges Bucket loggen. Da die Datenflut aber immens ist (Standardmäßig so alle 30 Sekunden ein Datensatz), sollte man sich überlegen was man wie lange aufheben möchte.

Ich brauche bspw. keine Aussentemperatur vom 18.04.2023 (oder älter) um 14:23:58 Uhr.

Deshalb sollte man in ein Bucket loggen und dem eine feste Retention von bspw. 30 Tagen verpassen. Damit fliegt alles was älter als 30 Tage ist aus dem Bucket raus. Was ich länger aufheben möchte "shiftet" man nun mittels eines Influx-Tasks in ein anderes Bucket (zB. Retention "never") und kann dabei auch noch die Datenflut eingrenzen (zB. die Aussentemp auf ein 15 Minuten-Raster aggregieren). So werden aus ~43k Datensätzen alleine für die Temperatur täglich mal schlanke 96 (!) und ich habe trotzdem noch einen guten Temperaturverlauf bspw. von vor einem Jahr.Die Daten kannst du per Abfrage eingrenzen und als CSV exportieren, dann als Annotated CSV in ein anderes Bucket wieder importieren. Hatte ich so erst vor kurzem @Negalein hier im Thread ausfühtlicher erklärt.

@sborg said in [Linux Shell-Skript] WLAN-Wetterstation:

Die Daten kannst du per Abfrage eingrenzen und als CSV exportieren, dann als Annotated CSV in ein anderes Bucket wieder importieren. Hatte ich so erst vor kurzem @Negalein hier im Thread ausfühtlicher erklärt.

OK - danke für die Erklärungen. Das wird mich wohl wieder Stunden (wenn nicht Tage) kosten... :face_with_head_bandage: Anscheinend gibt es den simplen "Export CSV" Button seit 2.7.0 nicht mehr, wenn man nicht mit https arbeitet. Und ein mal kurz installiertes CLI produziert bei jedem Versuch, einen Query laufen zu lassen, den Fehler

Error: failed to execute query: 404 Not Found: unable to decode response content type "text/html" -

@sborg said in [Linux Shell-Skript] WLAN-Wetterstation:

Die Daten kannst du per Abfrage eingrenzen und als CSV exportieren, dann als Annotated CSV in ein anderes Bucket wieder importieren. Hatte ich so erst vor kurzem @Negalein hier im Thread ausfühtlicher erklärt.

OK - danke für die Erklärungen. Das wird mich wohl wieder Stunden (wenn nicht Tage) kosten... :face_with_head_bandage: Anscheinend gibt es den simplen "Export CSV" Button seit 2.7.0 nicht mehr, wenn man nicht mit https arbeitet. Und ein mal kurz installiertes CLI produziert bei jedem Versuch, einen Query laufen zu lassen, den Fehler

Error: failed to execute query: 404 Not Found: unable to decode response content type "text/html"@sebhoff frage:

muß ich für die Wetterstation und die Statistik, eine neue influx instanz anlegen, da ja die default nur in die iobroker influx schreibt oder wie läuft das genau ab, denn ich habe mir in der influxdb ein neues bucket erstellt so daß nicht sämtliche daten in das bucket iobroker geschrieben werden aber so richtig blicke ich da noch nicht durch, sorry dafür. Alles andere läuft bereits danke @SBorg

-

@sborg said in [Linux Shell-Skript] WLAN-Wetterstation:

Die Daten kannst du per Abfrage eingrenzen und als CSV exportieren, dann als Annotated CSV in ein anderes Bucket wieder importieren. Hatte ich so erst vor kurzem @Negalein hier im Thread ausfühtlicher erklärt.

OK - danke für die Erklärungen. Das wird mich wohl wieder Stunden (wenn nicht Tage) kosten... :face_with_head_bandage: Anscheinend gibt es den simplen "Export CSV" Button seit 2.7.0 nicht mehr, wenn man nicht mit https arbeitet. Und ein mal kurz installiertes CLI produziert bei jedem Versuch, einen Query laufen zu lassen, den Fehler

Error: failed to execute query: 404 Not Found: unable to decode response content type "text/html"@sebhoff said in [Linux Shell-Skript] WLAN-Wetterstation:

Das wird mich wohl wieder Stunden (wenn nicht Tage) kosten...

OK - habe wohl eine einfache Möglichkeit gefunden. Ich stoppe das logging in das longtermBucket und starte sofort mit dem logging in das shorttermBucket. Dann mache ich via "Data Explorer" eine Abfrage, die alle Einträge aus dem longtermBucket als Resultat hat, erstelle einen Task, der diesen Flux Query theoretisch regelmäßig ausführen könnte und schreibe die Resultate in das shorttermBucket. Diesen Task lasse ich einmal manuell laufen und lösche ihn anschließend wieder - et voilà, alles ist drüben. Oder habe ich da was falsch verstanden?

Dann werde ich nun wieder mal bis morgen früh warten und schauen, ob es nun endlich funktioniert. Anschließend kann ich mir dann Gedanken machen, wie ich ausgedünnte Daten in einem longtermBucket dauerhaft speichere.

(PS: Ist es eigentlich die, der oder das Bucket? :clown_face: ) -

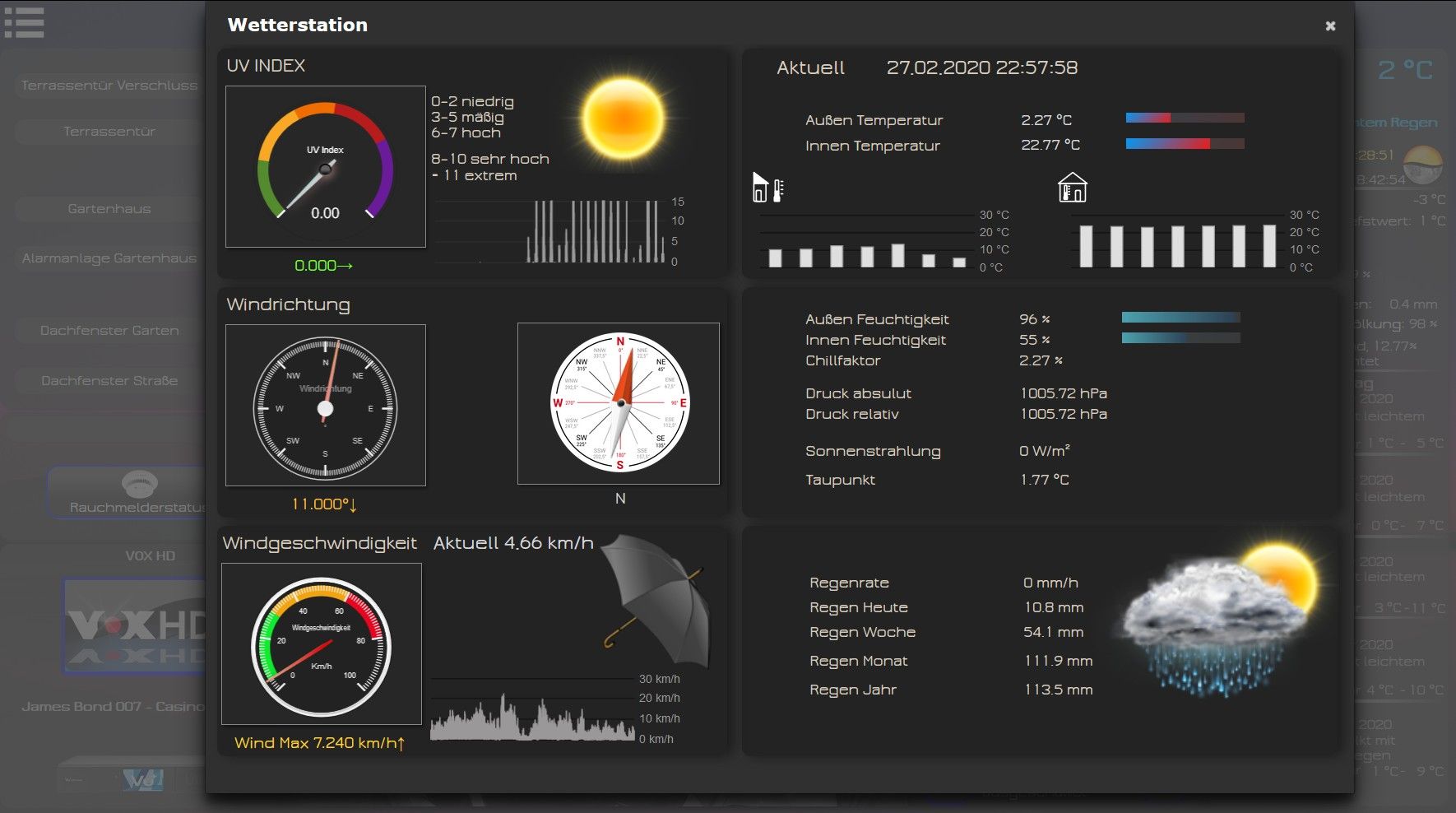

Das ganze entstand aus diesem Thread.

Damit ist es möglich mit einem Linux-Client die Daten einer WLAN-Wetterstation und/oder mit Hilfe eines Gateways und Zusatzsensoren zu empfangen, aufzubereiten und im ioBroker zur Verfügung zu stellen. Optional können die Daten auch bei AWEKAS.at, OpenSenseMap, Windy und wetter.com zur Verfügung gestellt werden.

Mein Dank geht an @Latzi für das testen in der Entwicklungsphase und dessen Unterstützung bei der Verfassung der WiKi-Artikel.

Aktuelle Version auf GitHub:

Neue Versionen im Thread sind ab V2.15.0 (Juli 2022) unterschiedlich farblich gekennzeichnet:- Beta-Releases haben dann eine rote Versionsnummer

- stabile Releases haben dann eine grüne Versionsnummer

Projektseite (inkl. WiKi): https://sborg2014.github.io/WLAN-Wetterstation/

Da es sich um keinen Adapter handelt, ist dies eine "Vorschaltseite" von GitHub. Nicht das wer auf die Idee kommt von der URL im ioBroker installieren zu wollen ;)

Zum Download/WiKi geht es dann weiter per View on GitHubBisher geteste Stationen:

- BRESSER

- WLAN Farb-Wetter Center mit 5-in-1 Profi-Sensor V (1) @pandor

- WLAN Comfort Wetterstation mit 7-in-1 Profi-Sensor (1)

- ChiliTec Funk Wetterstation 12in1 @tege0

- DNT Weatherscreen PRO @Petersilie

- Ecowitt

- GW1000

- GW2000A

- GW3000A @MartyBr

- WS2910 @Nashra

- WS3800A @hoschi2007

- WS3900 @Mike77

- ELV WS980WiFi @sonystar

- Eurochron EFWS2900 @Latzi, @ilovegym, @SBorg (baugleich mit Ambient Weather WS-2902, Chilitec CTW-902, Sainlogic 10 in 1)

- Froggit

- Gateway/USB-Dongle DP1500/DP2000 @Boronsbruder

- HP1000SE Pro @Stormbringer

- WH3000 SE @ToxSox, @crunchip

- WH4000 SE @unltdnetworx, @Glasfaser, @Negalein, @Boronsbruder

- WH6000 Pro @Mugel80

- Renkforce WH2600

- Sainlogic

- Ventus W830 @CiroCool, @Rushmed

(1) Abfrage per DNS-Server wie bspw. PiHole oder dnsmasq

Bisher unterstütze Zusatzsensoren per Station oder mittels DP1500/DP2000/GW1000/GW2000A - Gateway:

- bis zu 8 Stück DP35/WN34 Wassertemperatur-Sensoren

- ein DP40/WH32 (bzw. WH26) Außentemperatur- und Luftfeuchtigkeitssensor

- bis zu 8 Stück DP50/WH31 Temperatur-/Luftfeuchtigkeit-Sensoren

- ein DP60/WH57 Blitzsensor

- bis zu 4 Stück DP70/WH55 Wasserleckage-Sensoren

- bis zu 16 Stück DP100/WH51 Bodenfeuchte-Sensoren

- bis zu 4 Stück DP200/WH43 PM2.5 Feinstaub-Sensoren

- ein DP250/WH45 5-In-1 CO2 / PM2.5 / PM10 / Temperatur / Luftfeuchte Innenraumsensor

- ein DP300/WS68 Solarunterstütztes Anemometer mit UV-Lichtsensor

- ein WH31 (bzw. WH25) Sensor

- ein WH40H Sensor

- ein WS80 Sensor

- ein WS90 "Wittboy" Sensor

- BRESSER (1)

- bis zu 4 Stück(2) BRESSER Thermo-/Hygro-Sensor 7 Kanal #7009999

Für den WFC01 hat @Rand nun hier und folgende ein kleines Javascript gebaut, um diesen auch auslesen zu können.

(1) nicht alle Bresser-Stationen unterstützen Zusatzsensoren! siehe hier

(2) durch das verwendete Wunderground-Protokoll limitiertDie mögliche Anzahl der Zusatzsensoren ist nicht durch das Skript begrenzt, sondern wird vom Display und/oder Gateway bestimmt.

Es besteht ferner auch die Möglichkeit Stationen (wie bspw. Sainlogic Profi Wlan Wetterstation FT0300) einzubinden die nicht per WS View[+] App konfiguriert werden können und nur ein Web-Interface bieten, dass keine Angabe eines eigenen Wetterdienst-Servers zulässt. Hierfür kann man den Umweg eines eigenen DNS-Servers wie dnsmasq oder Pi-hole gehen. Für Pi-hole hat @XxJooO freundlicherweise hier im Forum eine ausführliche Doku erstellt: klick mich

Wäre schön wenn sich weitere User mit entsprechenden Modellen melden bei denen es funktioniert (auch wenn es baugleiche sein sollten, so ist man sich wenigstens sicher ;) )

Update von einer Vorgängerversion (bei Nutzung per systemd):

Im Installationsverzeichnis

./ws_updater.shausführen.

Alternativ (falls die aktuell installierte Version kleiner als V2.12.0 ist): im Installationsverzeichnisbash <(curl -s https://raw.githubusercontent.com/SBorg2014/WLAN-Wetterstation/master/ws_updater.sh)ausführenUpdate von einer Vorgängerversion (bei Nutzung als cronjob):

Am besten das laufende Skript mit

pkill -9 wetterstation.shstoppen, wetterstation.sh und -.sub ersetzen (-.conf und -.js nur nach Aufforderung nötig; conf dann neu konfigurieren / js ersetzen und einmalig ausführen), dann entweder- direkt am Linux-Client

./wetterstation.sh & - oder per Putty oä.

nohup ./wetterstation.sh &(erzeugt dabei eine Datei nohup.out) - oder reboot des Systemes (Skript wird dann per cronjob wieder gestartet)

jeweils im Installationsverzeichnis ausführen. Sonst befindet sich ggf. noch das alte Skript im RAM und läuft munter bis zum nächsten Reboot weiter ;)

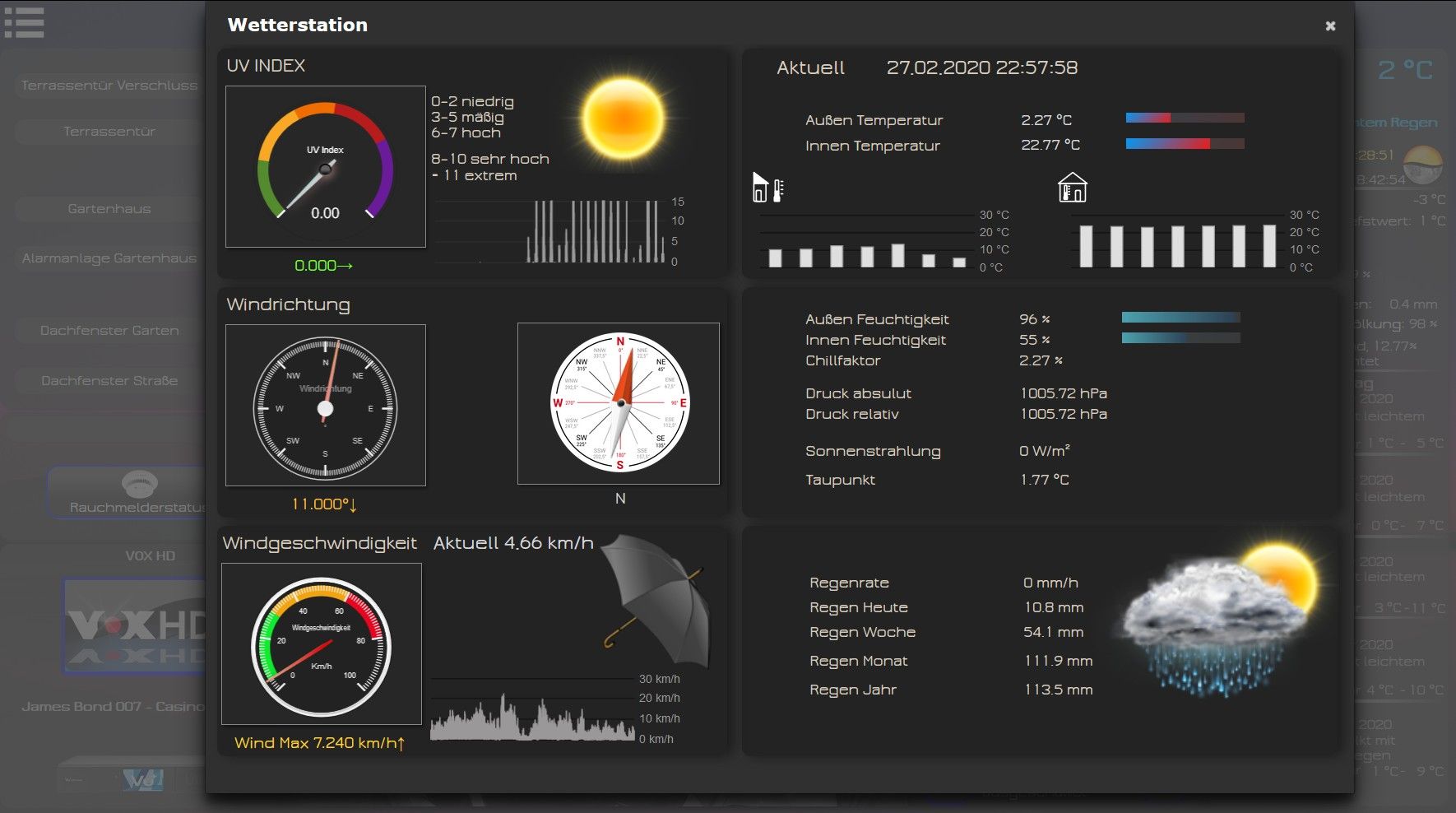

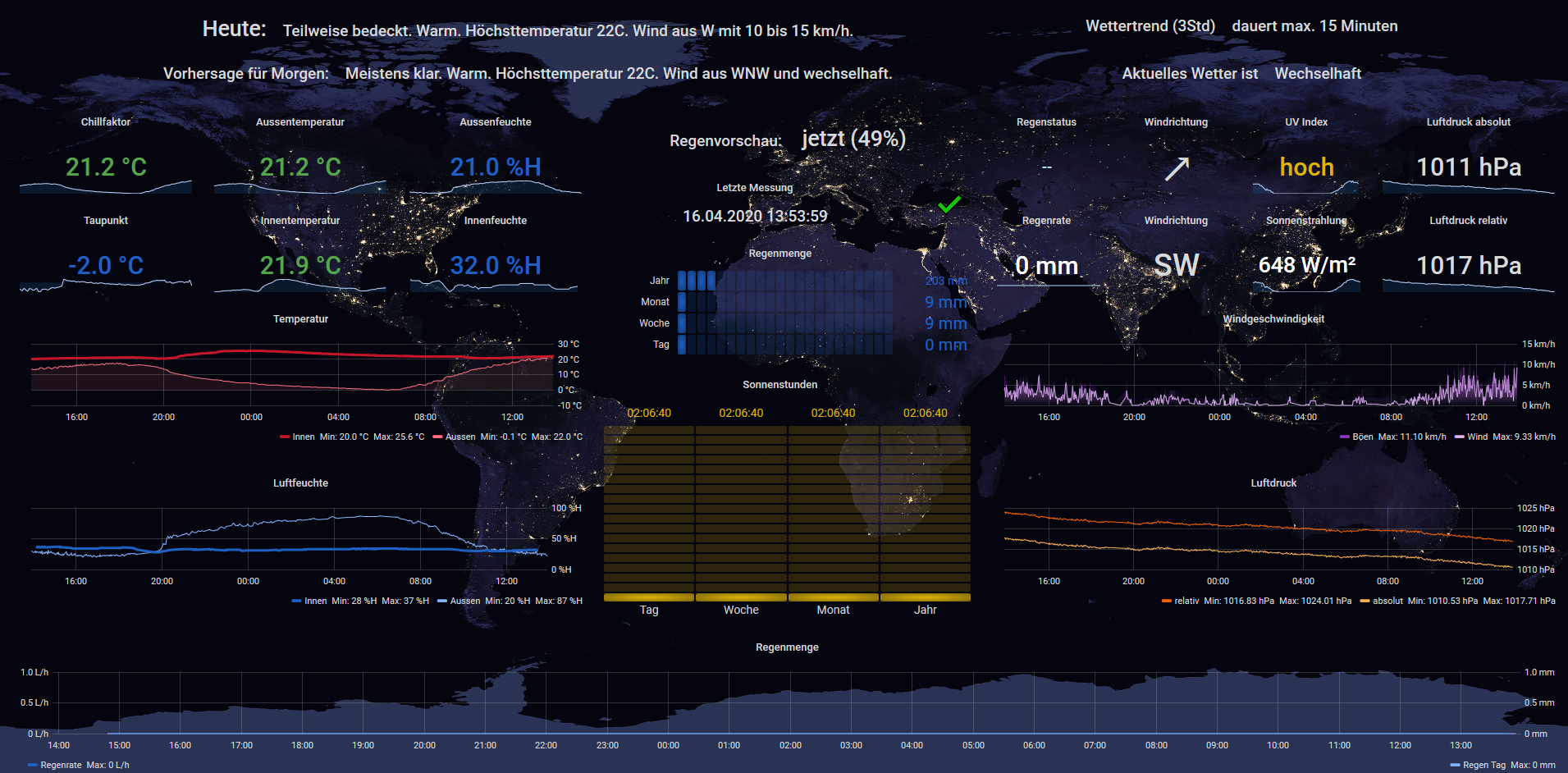

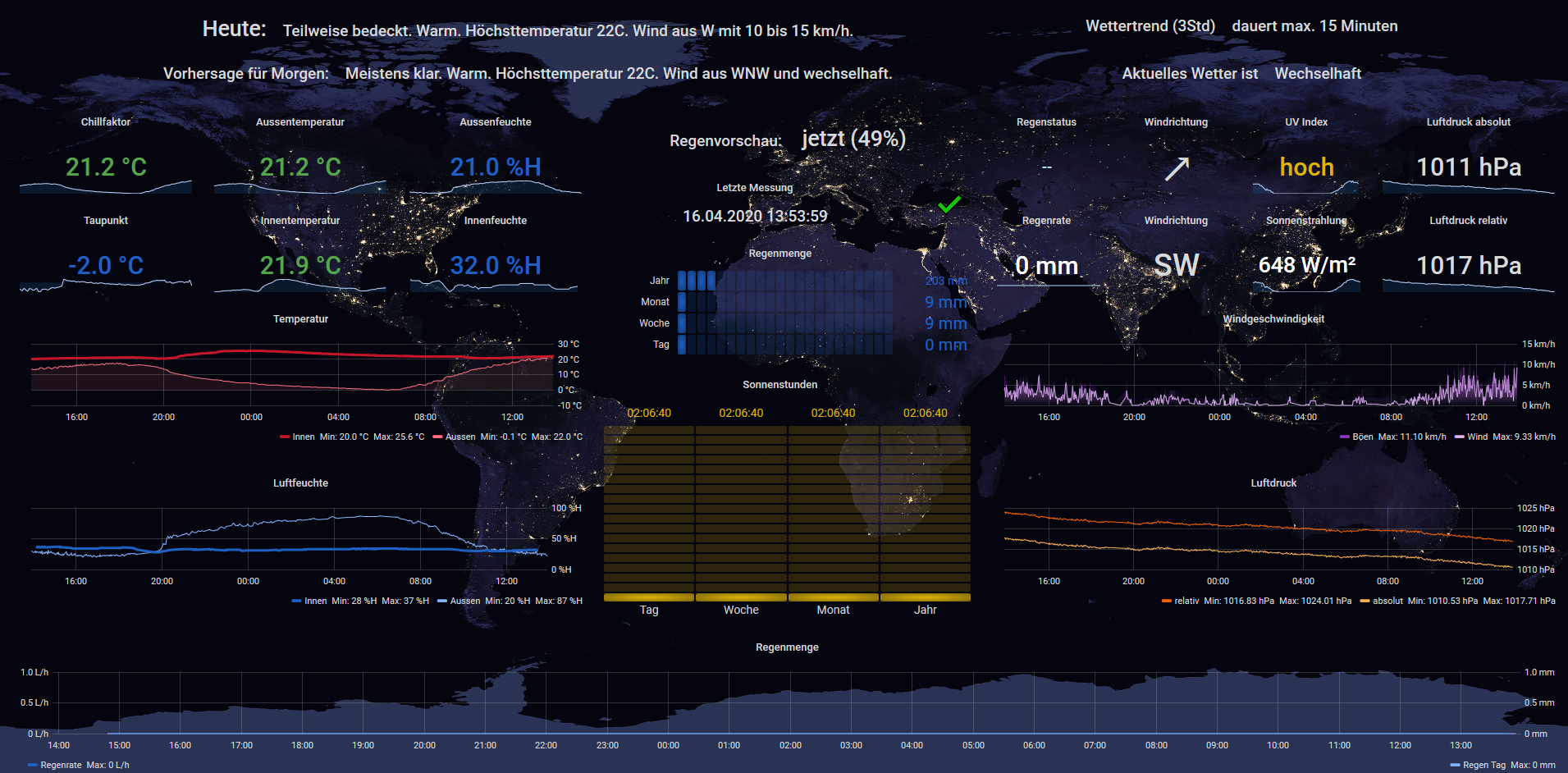

Beispiele einer grafischen Umsetzung:

@Glasfaser: View / zum Beitrag

@crunchip: Grafana / zum Beitrag

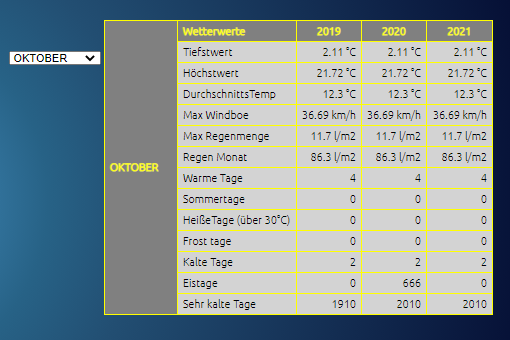

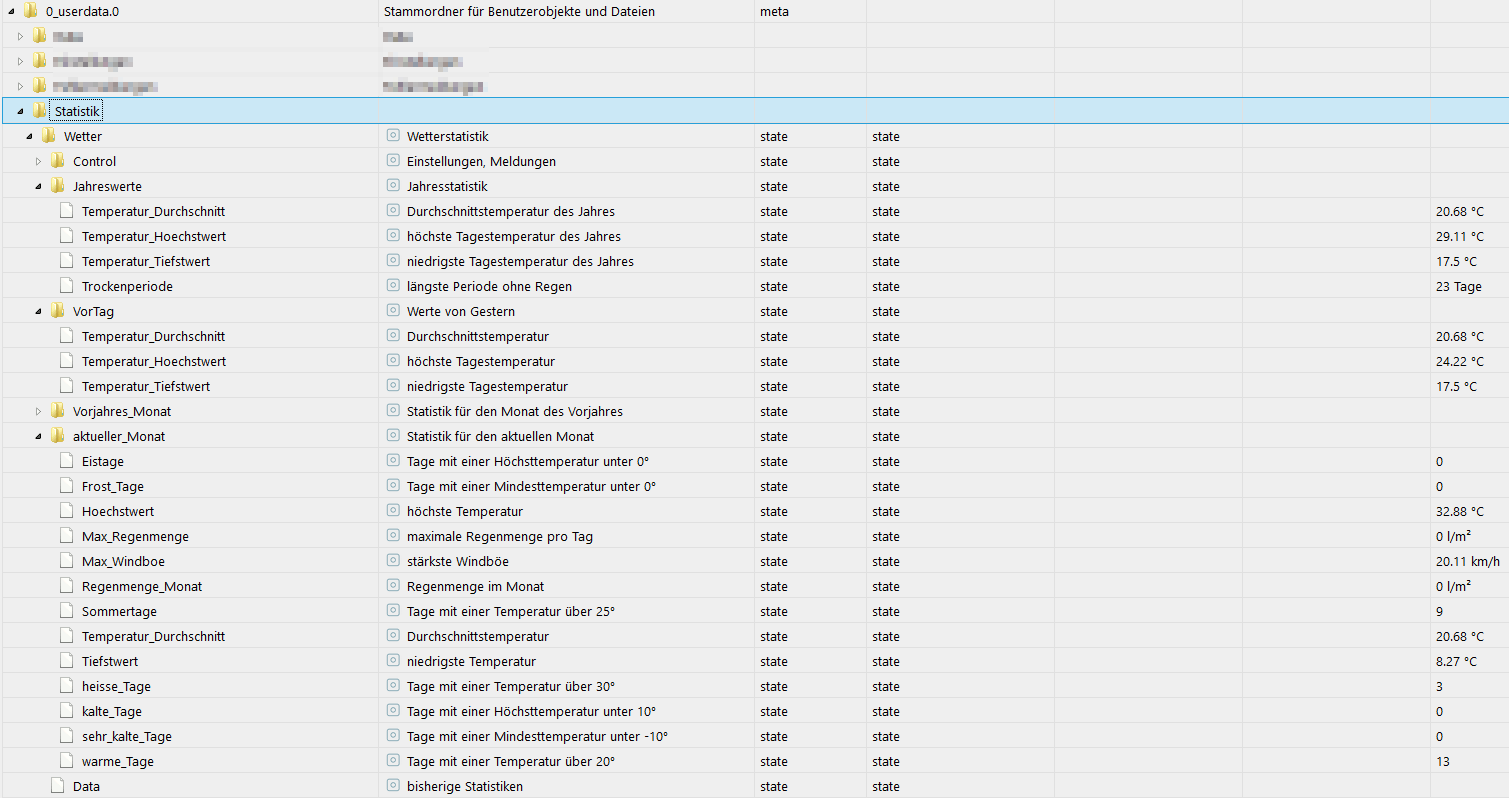

Wetterstation-Statistik (JS-Addon)

Statistikmodul als Javascript. Liefert diverse Statistiken:

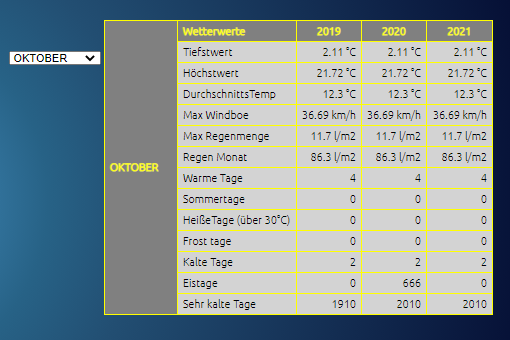

Javascript für eine HTML-Tabelle vorheriger Monatswerte ( @liv-in-sky ) :

zum ThreadNeues Projekt PimpMyStation (14.11.2020)

Kein Support per PM/Chat !

Mir ist ein Thema aufgefallen. Ich weiß nicht ob ein Bug ist oder am User vor dem Monitor liegt. :face_with_rolling_eyes:

Ich habe das Statistik Scrript aktiviert und nutze die monatlichen Daten um sie mir in VIS anzuzeigen.

Jetzt habe mir zusätzlich in Grafana ein Dashboard gebaut und mir dort die monatlichen Regenmengen anzuzeigen.Allerdings weichen die Zahlen voneinander ab:

Quelle: 0_userdata.0.wetter.wetterstation.statistik.Data

Mai: 55,86 mm

Juni: 31,01 mm

Juli: 85,58 mmfür den aktuellen Monat erhalte ich hier:

August: 33,72 mm (0_userdata.0.wetter.wetterstation.statistik.aktueller_Monat.Regenmenge_Monat) + 11,988 mm (0_userdata.0.wetter.wetterstation.Regen_Tag)

Quelle: 0_userdata.0.wetter.wetterstation.Regen_Total (in Grafana aus einer InfluxDB)

Mai: 68,1 mm

Juni: 36,8 mm

Juli: 98,6 mmfür den aktuellen Monat erhalte ich hier:

August: 45,4 mm

Warum passen die historischen Daten nicht? Gibt es hier einen Bug oder mache ich einen Denkfehler.

Gruß

Michael -

Entschuldigung wenn ich da so reingrätsche. Ich hab gesehen wie Ihr zu uns (AWEKAS) die Daten überträgt. Ihr verwendet das WU Protokoll. Da gibt es einen viel besseren Weg mit unserer API. Ich hab leider keine Email gefunden, es wäre (wenn Interesse besteht) super wenn sich wer bei uns diesbezüglich per Mail meldet.

PS: Wir planen einen IObroker Adapter :-)Lg Othmar

-

Entschuldigung wenn ich da so reingrätsche. Ich hab gesehen wie Ihr zu uns (AWEKAS) die Daten überträgt. Ihr verwendet das WU Protokoll. Da gibt es einen viel besseren Weg mit unserer API. Ich hab leider keine Email gefunden, es wäre (wenn Interesse besteht) super wenn sich wer bei uns diesbezüglich per Mail meldet.

PS: Wir planen einen IObroker Adapter :-)Lg Othmar

@awekas sagte in [Linux Shell-Skript] WLAN-Wetterstation:

Da gibt es einen viel besseren Weg mit unserer API.

Hallo Othmar!

Cool, das wird @SBorg (der Entwickler des Scripts hier) sicher interessieren.

LG aus OÖ

-

@sborg said in [Linux Shell-Skript] WLAN-Wetterstation:

Die Daten kannst du per Abfrage eingrenzen und als CSV exportieren, dann als Annotated CSV in ein anderes Bucket wieder importieren. Hatte ich so erst vor kurzem @Negalein hier im Thread ausfühtlicher erklärt.

OK - danke für die Erklärungen. Das wird mich wohl wieder Stunden (wenn nicht Tage) kosten... :face_with_head_bandage: Anscheinend gibt es den simplen "Export CSV" Button seit 2.7.0 nicht mehr, wenn man nicht mit https arbeitet. Und ein mal kurz installiertes CLI produziert bei jedem Versuch, einen Query laufen zu lassen, den Fehler

Error: failed to execute query: 404 Not Found: unable to decode response content type "text/html"@sebhoff sagte in [Linux Shell-Skript] WLAN-Wetterstation:

Anscheinend gibt es den simplen "Export CSV" Button seit 2.7.0 nicht mehr, wenn man nicht mit https arbeitet.

Habe ich eben auch gelesen. Nutzt du FF? Angeblich soll es mit Chrome noch funktionieren. Ich könnt das zwar mittels Edge selbst probieren, nutze aber noch Influx 2.6.1

...oder dann doch zwangsweise auf HTTPS umstellen (und 100 Pro geht dann wieder etwas anderes nicht...)@sebhoff sagte in [Linux Shell-Skript] WLAN-Wetterstation:

Diesen Task lasse ich einmal manuell laufen und lösche ihn anschließend wieder - et voilà, alles ist drüben. Oder habe ich da was falsch verstanden?

Nö, das funktioniert so schon. Ich habe es nur überflogen, aber in Flux kann man auch direkt ex- und importieren. Bis das aber korrekt funktioniert ist die Lösung über Tasks sicherlich einfacher und schneller, zumal es eh nur einmalig ist.

-

@sebhoff sagte in [Linux Shell-Skript] WLAN-Wetterstation:

Anscheinend gibt es den simplen "Export CSV" Button seit 2.7.0 nicht mehr, wenn man nicht mit https arbeitet.

Habe ich eben auch gelesen. Nutzt du FF? Angeblich soll es mit Chrome noch funktionieren. Ich könnt das zwar mittels Edge selbst probieren, nutze aber noch Influx 2.6.1

...oder dann doch zwangsweise auf HTTPS umstellen (und 100 Pro geht dann wieder etwas anderes nicht...)@sebhoff sagte in [Linux Shell-Skript] WLAN-Wetterstation:

Diesen Task lasse ich einmal manuell laufen und lösche ihn anschließend wieder - et voilà, alles ist drüben. Oder habe ich da was falsch verstanden?

Nö, das funktioniert so schon. Ich habe es nur überflogen, aber in Flux kann man auch direkt ex- und importieren. Bis das aber korrekt funktioniert ist die Lösung über Tasks sicherlich einfacher und schneller, zumal es eh nur einmalig ist.

@sborg said in [Linux Shell-Skript] WLAN-Wetterstation:

Habe ich eben auch gelesen. Nutzt du FF? Angeblich soll es mit Chrome noch funktionieren. Ich könnt das zwar mittels Edge selbst probieren, nutze aber noch Influx 2.6.1

Safari auf nem Mac... Und Chrome funktioniert da leider auch nicht. Aber nun läuft es ja!

-

@sebhoff frage:

muß ich für die Wetterstation und die Statistik, eine neue influx instanz anlegen, da ja die default nur in die iobroker influx schreibt oder wie läuft das genau ab, denn ich habe mir in der influxdb ein neues bucket erstellt so daß nicht sämtliche daten in das bucket iobroker geschrieben werden aber so richtig blicke ich da noch nicht durch, sorry dafür. Alles andere läuft bereits danke @SBorg

@babl sagte in [Linux Shell-Skript] WLAN-Wetterstation:

muß ich für die Wetterstation und die Statistik, eine neue influx instanz anlegen

Kann man, muss man aber nicht. Jede Instanz kostet CPU und RAM, bringt aber so keinerlei signifikanten Vorteil. In einem "Monster-Bucket" (=alles mehr oder minder in einem Bucket) kann man

- die Werte auch wieder einfach separieren

- mittels Influx-Tasks alles sortieren und wegspeichern wie man es möchte (dann auch nachträglich in ein anderes Bucket)

-

@sborg said in [Linux Shell-Skript] WLAN-Wetterstation:

Habe ich eben auch gelesen. Nutzt du FF? Angeblich soll es mit Chrome noch funktionieren. Ich könnt das zwar mittels Edge selbst probieren, nutze aber noch Influx 2.6.1

Safari auf nem Mac... Und Chrome funktioniert da leider auch nicht. Aber nun läuft es ja!

@sebhoff sagte in [Linux Shell-Skript] WLAN-Wetterstation:

Aber nun läuft es ja!

:blush: Habe ich beim überfliegen schon gelesen, bin aber noch mitten im Beantworten der einzelnen Fragen.