NEWS

NUC gesucht

-

@agrippinenser was ist jetzt deine aktuelle Endkonfiguration und wo zu welchem Preis bestellt?

9W mit iobroker, kommt da noch eine DB (influx, miradb, ...) und vll grafische Auswertung (grafana, ...) dazu?wäre dann interessant was Endaufnahme an Leistung ist falls noch übliche VMs dazu kommen.

@maximal1981 sagte in NUC gesucht:

was ist jetzt deine aktuelle Endkonfiguration und wo zu welchem Preis bestellt?

Alternate: NUC - 268,00 + 7€ Versand

Snowgard: 1TB Samsung 980 Pro - 119,90 ; ja, die ist seitens Performance überdimensioniert, war aber an der Theke verfügbar :-)

Amazon: 1x Kingston ValueRAM 32GB 2666MHz DDR4 - 69,99; bei Bedarf kann ein weiterer rein.

Zusammen also rund 460,- €.9W mit iobroker, kommt da noch eine DB (influx, miradb, ...) und vll grafische Auswertung (grafana, ...) dazu?

Dann kommt das "übliche Zeugs" hinzu, also Grafana, Influxdb - da ich nun wieder neu aufsetze wahrscheinlich Influxdb2.

Das dauert aber ein Weilchen, muss mich erst mal durchwühlen um nicht alles 3x machen zu müssen. Der eine hat IOB im Container der andere auf einer VM laufen. Vielleicht probiere ich beides aus und schau was passiert. Ein Conbee2 -Stick muss auch laufen. Na ja - alles mit der Zeit :v: -

@agrippinenser ,

Intel Hardwarebeschleunigung aktivieren

Im Proxmox-Host :nano /etc/udev/rules.d/99-intel-chmod666.ruleseinfügen :

KERNEL=="renderD128", MODE="0666"Neustart !

In der Container Config einfügen:

lxc.cgroup2.devices.allow: c 226:128 rwm lxc.mount.entry: /dev/dri/renderD128 dev/dri/renderD128 none bind,optional,create=filewie die dann in Motioneye aktiviert wird, weis ich jetzt nicht.

Motioneye arbeitet auch mit ffmpeg, da gibt es dann Schalter dafür.Mit Frigate habe ich mit 1 Kamerastream ca. 3% Last auf einem Intel i5-6500

@wal sagte in NUC gesucht:

nano /etc/udev/rules.d/99-intel-chmod666.rules

muss nachfragen: ist das eine existierende Datei oder neu anlegen ?

Bei mir gibt es unter

/etc/udev/rules.d/nur60-bridge-network-interface.rules -

@maximal1981 sagte in NUC gesucht:

was ist jetzt deine aktuelle Endkonfiguration und wo zu welchem Preis bestellt?

Alternate: NUC - 268,00 + 7€ Versand

Snowgard: 1TB Samsung 980 Pro - 119,90 ; ja, die ist seitens Performance überdimensioniert, war aber an der Theke verfügbar :-)

Amazon: 1x Kingston ValueRAM 32GB 2666MHz DDR4 - 69,99; bei Bedarf kann ein weiterer rein.

Zusammen also rund 460,- €.9W mit iobroker, kommt da noch eine DB (influx, miradb, ...) und vll grafische Auswertung (grafana, ...) dazu?

Dann kommt das "übliche Zeugs" hinzu, also Grafana, Influxdb - da ich nun wieder neu aufsetze wahrscheinlich Influxdb2.

Das dauert aber ein Weilchen, muss mich erst mal durchwühlen um nicht alles 3x machen zu müssen. Der eine hat IOB im Container der andere auf einer VM laufen. Vielleicht probiere ich beides aus und schau was passiert. Ein Conbee2 -Stick muss auch laufen. Na ja - alles mit der Zeit :v:@agrippinenser sagte in NUC gesucht:

war aber an der Theke verfügbar

schade dass der Drache keine brauchbaren NUCs im Lager hat.

Wäre sonst längst mal da gewesen. -

-

@agrippinenser was ist jetzt deine aktuelle Endkonfiguration und wo zu welchem Preis bestellt?

9W mit iobroker, kommt da noch eine DB (influx, miradb, ...) und vll grafische Auswertung (grafana, ...) dazu?wäre dann interessant was Endaufnahme an Leistung ist falls noch übliche VMs dazu kommen.

@maximal1981

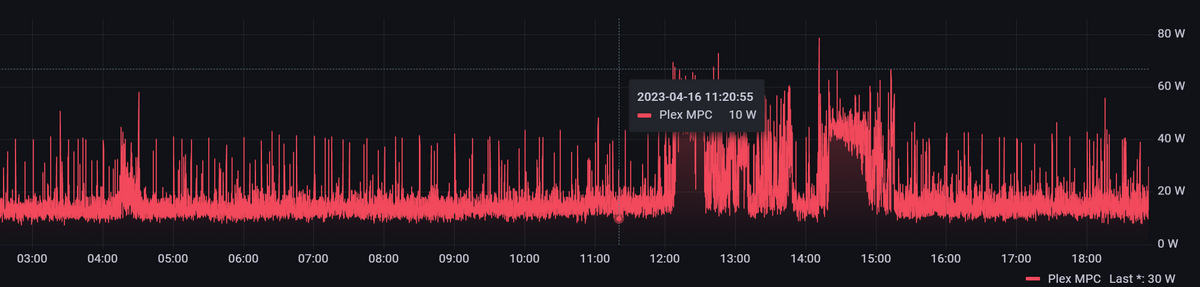

Wenn der NUC vollgepackt wird sieht das dann so aus:

NUC10i5FNK, 64GB RAM, 2TB NVME M.2

Windows 11 pro, Virtualbox mit 2 VMs, (IOB, HASS), Grafana, Influx und PLEX Server.

Der wird per RDP auch noch für andere Hobbys genutzt.

Super Teile die NUCs, habe ich der Firma auch 15 Büro-Arbeitsplätze mit ausgestattet. Da dann aber mit i7 (6Kern) -

@wal sagte in NUC gesucht:

nano /etc/udev/rules.d/99-intel-chmod666.rules

muss nachfragen: ist das eine existierende Datei oder neu anlegen ?

Bei mir gibt es unter

/etc/udev/rules.d/nur60-bridge-network-interface.rules@agrippinenser sagte in NUC gesucht:

@wal sagte in NUC gesucht:

nano /etc/udev/rules.d/99-intel-chmod666.rules

muss nachfragen: ist das eine existierende Datei oder neu anlegen ?

Bei mir gibt es unter

/etc/udev/rules.d/nur60-bridge-network-interface.rulesNeu anlegen.

-

@agrippinenser sagte in NUC gesucht:

@wal sagte in NUC gesucht:

hier gibt es ein Thread zum Thema.

das ist Hardcore für mich ;-)

Ich würde sagen, das motioneye es aktiviert wenn er eine Hardware findet.

Für Plex braucht man doch auch Hardewarebeschleunigung.

-

@agrippinenser ,

Intel Hardwarebeschleunigung aktivieren

Im Proxmox-Host :nano /etc/udev/rules.d/99-intel-chmod666.ruleseinfügen :

KERNEL=="renderD128", MODE="0666"Neustart !

In der Container Config einfügen:

lxc.cgroup2.devices.allow: c 226:128 rwm lxc.mount.entry: /dev/dri/renderD128 dev/dri/renderD128 none bind,optional,create=filewie die dann in Motioneye aktiviert wird, weis ich jetzt nicht.

Motioneye arbeitet auch mit ffmpeg, da gibt es dann Schalter dafür.Mit Frigate habe ich mit 1 Kamerastream ca. 3% Last auf einem Intel i5-6500

@wal sagte in NUC gesucht:

Intel Hardwarebeschleunigung aktivieren

Im Proxmox-Host :[..]

In der Container Config einfügen:

.. ich bin dem so gefolgt hat aber keine messbare Änderung erzeugt.

Zur Zeit nutze ich Motioneye 0.42.1. Bei früheren Versionen konnte man unter "Expert Einstellung" zumindest GPU Speicher oder sowas konfigurieren. Das steht in meiner Version nicht mehr zur Verfügung.in

/etc/motioneye/motion.confbzw.motioneye.conffinde ich auch keinen Ansatz.Ich habe das nun erst einmal auf meine lange ToDo Liste gesetzt :-)

Auf jeden Fall was dazugelernt vielen Dank !

LG

-

@wal sagte in NUC gesucht:

Intel Hardwarebeschleunigung aktivieren

Im Proxmox-Host :[..]

In der Container Config einfügen:

.. ich bin dem so gefolgt hat aber keine messbare Änderung erzeugt.

Zur Zeit nutze ich Motioneye 0.42.1. Bei früheren Versionen konnte man unter "Expert Einstellung" zumindest GPU Speicher oder sowas konfigurieren. Das steht in meiner Version nicht mehr zur Verfügung.in

/etc/motioneye/motion.confbzw.motioneye.conffinde ich auch keinen Ansatz.Ich habe das nun erst einmal auf meine lange ToDo Liste gesetzt :-)

Auf jeden Fall was dazugelernt vielen Dank !

LG

@agrippinenser,

wenn du das im Host so installiert hast, kannst du das im LXC falls nötig jederzeit aktivieren.

Frisst ja kein Brot.

Ich muss sagen das mich Frigate immer mehr begeistert, die Objekt Erkennung ist phänomenal selbst ohne Coral TPU.

Ich denke das ich mal anfange einen Adapter für die Objektauslösung zu schreiben, ohne mir Druck zu machen.

Für Hass gibt es ja ein Plugin, muss mal schauen was das alles kann. -

@agrippinenser ,

Intel Hardwarebeschleunigung aktivieren

Im Proxmox-Host :nano /etc/udev/rules.d/99-intel-chmod666.ruleseinfügen :

KERNEL=="renderD128", MODE="0666"Neustart !

In der Container Config einfügen:

lxc.cgroup2.devices.allow: c 226:128 rwm lxc.mount.entry: /dev/dri/renderD128 dev/dri/renderD128 none bind,optional,create=filewie die dann in Motioneye aktiviert wird, weis ich jetzt nicht.

Motioneye arbeitet auch mit ffmpeg, da gibt es dann Schalter dafür.Mit Frigate habe ich mit 1 Kamerastream ca. 3% Last auf einem Intel i5-6500

@wal Hi Wal, kannst Du mal beschreiben wie dir frigate installiert hast.

Ich habe mir mal vor einer Weile einen google coral usb besorgt und würde den jetzt auch gerne am NUC betreiben.Vielen Dank

Johnny

-

@wal Hi Wal, kannst Du mal beschreiben wie dir frigate installiert hast.

Ich habe mir mal vor einer Weile einen google coral usb besorgt und würde den jetzt auch gerne am NUC betreiben.Vielen Dank

Johnny

-

@prinzeisenherz1 ,

gibt es einen Thread.@wal Danke für die Info :-)

-

@agrippinenser ,

Intel Hardwarebeschleunigung aktivieren

Im Proxmox-Host :nano /etc/udev/rules.d/99-intel-chmod666.ruleseinfügen :

KERNEL=="renderD128", MODE="0666"Neustart !

In der Container Config einfügen:

lxc.cgroup2.devices.allow: c 226:128 rwm lxc.mount.entry: /dev/dri/renderD128 dev/dri/renderD128 none bind,optional,create=filewie die dann in Motioneye aktiviert wird, weis ich jetzt nicht.

Motioneye arbeitet auch mit ffmpeg, da gibt es dann Schalter dafür.Mit Frigate habe ich mit 1 Kamerastream ca. 3% Last auf einem Intel i5-6500

@wal sagte in NUC gesucht:

@agrippinenser ,

Intel Hardwarebeschleunigung aktivieren

Im Proxmox-Host :nano /etc/udev/rules.d/99-intel-chmod666.ruleseinfügen :

KERNEL=="renderD128", MODE="0666"Neustart !

In der Container Config einfügen:

lxc.cgroup2.devices.allow: c 226:128 rwm lxc.mount.entry: /dev/dri/renderD128 dev/dri/renderD128 none bind,optional,create=filewie die dann in Motioneye aktiviert wird, weis ich jetzt nicht.

Motioneye arbeitet auch mit ffmpeg, da gibt es dann Schalter dafür.Mit Frigate habe ich mit 1 Kamerastream ca. 3% Last auf einem Intel i5-6500

@Wal

weißt du, was das bedeutet, wenn das setting für den lxc wieder gelöscht ist, nachdem ich den lxc wieder gestartet habe ? muss proxmox neu gestartet werden nach dem erstellen von 99-intel-chmod666.rules? -

@wal sagte in NUC gesucht:

@agrippinenser ,

Intel Hardwarebeschleunigung aktivieren

Im Proxmox-Host :nano /etc/udev/rules.d/99-intel-chmod666.ruleseinfügen :

KERNEL=="renderD128", MODE="0666"Neustart !

In der Container Config einfügen:

lxc.cgroup2.devices.allow: c 226:128 rwm lxc.mount.entry: /dev/dri/renderD128 dev/dri/renderD128 none bind,optional,create=filewie die dann in Motioneye aktiviert wird, weis ich jetzt nicht.

Motioneye arbeitet auch mit ffmpeg, da gibt es dann Schalter dafür.Mit Frigate habe ich mit 1 Kamerastream ca. 3% Last auf einem Intel i5-6500

@Wal

weißt du, was das bedeutet, wenn das setting für den lxc wieder gelöscht ist, nachdem ich den lxc wieder gestartet habe ? muss proxmox neu gestartet werden nach dem erstellen von 99-intel-chmod666.rules?@liv-in-sky ,

du kannst es so ändern und beim nächsten Start ist es aktiv.In der Proxmox-Host-Console gibst du das ein:

chmod 666 /dev/dri/renderD128und es bleibt bis zum nächsten Start aktiv, d.h. du brauchst nicht extra neu starten.

Edit: Für TVHeadend, Plex ... LXC nutzt man für gewöhnlich Hardwarebeschleunigung, da kann die Rules nicht schaden.

-

@wal sagte in NUC gesucht:

@agrippinenser ,

Intel Hardwarebeschleunigung aktivieren

Im Proxmox-Host :nano /etc/udev/rules.d/99-intel-chmod666.ruleseinfügen :

KERNEL=="renderD128", MODE="0666"Neustart !

In der Container Config einfügen:

lxc.cgroup2.devices.allow: c 226:128 rwm lxc.mount.entry: /dev/dri/renderD128 dev/dri/renderD128 none bind,optional,create=filewie die dann in Motioneye aktiviert wird, weis ich jetzt nicht.

Motioneye arbeitet auch mit ffmpeg, da gibt es dann Schalter dafür.Mit Frigate habe ich mit 1 Kamerastream ca. 3% Last auf einem Intel i5-6500

@Wal

weißt du, was das bedeutet, wenn das setting für den lxc wieder gelöscht ist, nachdem ich den lxc wieder gestartet habe ? muss proxmox neu gestartet werden nach dem erstellen von 99-intel-chmod666.rules?@liv-in-sky sagte in NUC gesucht:

In der Container Config einfügen:

lxc.cgroup2.devices.allow: c 226:128 rwm lxc.mount.entry: /dev/dri/renderD128 dev/dri/renderD128 none bind,optional,create=file@Wal

weißt du, was das bedeutet, wenn das setting für den lxc wieder gelöscht ist, nachdem ich den lxc wieder gestartet habe ?Die settings-Datei vom LXC lässt sic nur dauerhaft bearbeiten, wenn der Container vor der Bearbeitung gestoppt ist. Wenn der läuft, während Du die Datei bearbeitest, wird spätestens beim nächsten Container-Neustart das alte setting wieder hergestellt und Deine Änderungen sind weg.

Gruss, Jürgen

-

@liv-in-sky sagte in NUC gesucht:

In der Container Config einfügen:

lxc.cgroup2.devices.allow: c 226:128 rwm lxc.mount.entry: /dev/dri/renderD128 dev/dri/renderD128 none bind,optional,create=file@Wal

weißt du, was das bedeutet, wenn das setting für den lxc wieder gelöscht ist, nachdem ich den lxc wieder gestartet habe ?Die settings-Datei vom LXC lässt sic nur dauerhaft bearbeiten, wenn der Container vor der Bearbeitung gestoppt ist. Wenn der läuft, während Du die Datei bearbeitest, wird spätestens beim nächsten Container-Neustart das alte setting wieder hergestellt und Deine Änderungen sind weg.

Gruss, Jürgen

@wildbill danke - war aber runtergefahren - muss das heute nochmal probieren

-

@wildbill danke - war aber runtergefahren - muss das heute nochmal probieren

@liv-in-sky ,

ich kann das nicht bestätigen.

Wenn ich die Settingsdatei bearbeitenano /etc/pve/lxc/105.confund danach den LXC neu starte, werden die Settings übernommen und sind nicht weg.

Was anderes ist z.B. der Befehl

chmod 666 /dev/dri/......der ist nach dem Neustart des Proxmox-Servers wieder weg, deshalb wird das in den Rules geändert was nach jedem reboot abgearbeitet wird.

-

@liv-in-sky ,

ich kann das nicht bestätigen.

Wenn ich die Settingsdatei bearbeitenano /etc/pve/lxc/105.confund danach den LXC neu starte, werden die Settings übernommen und sind nicht weg.

Was anderes ist z.B. der Befehl

chmod 666 /dev/dri/......der ist nach dem Neustart des Proxmox-Servers wieder weg, deshalb wird das in den Rules geändert was nach jedem reboot abgearbeitet wird.

noch ne frage - das kann dann nur für einen lxc genutzt werden ? oder können da mehrere drauf zugreifen ?

-

@liv-in-sky ,

ich kann das nicht bestätigen.

Wenn ich die Settingsdatei bearbeitenano /etc/pve/lxc/105.confund danach den LXC neu starte, werden die Settings übernommen und sind nicht weg.

Was anderes ist z.B. der Befehl

chmod 666 /dev/dri/......der ist nach dem Neustart des Proxmox-Servers wieder weg, deshalb wird das in den Rules geändert was nach jedem reboot abgearbeitet wird.

hat jetzt geklappt - die cpu load geht tatsächlich um einiges runter - suuuuuuper tipp !!!!!!!!

-

noch ne frage - das kann dann nur für einen lxc genutzt werden ? oder können da mehrere drauf zugreifen ?

@liv-in-sky sagte in NUC gesucht:

noch ne frage - das kann dann nur für einen lxc genutzt werden ? oder können da mehrere drauf zugreifen ?

Das habe ich noch nicht getestet, habe ja nur frigate als LXC, den TVHeadend LXC habe ich schon seit 1 Jahr nicht mehr.