NEWS

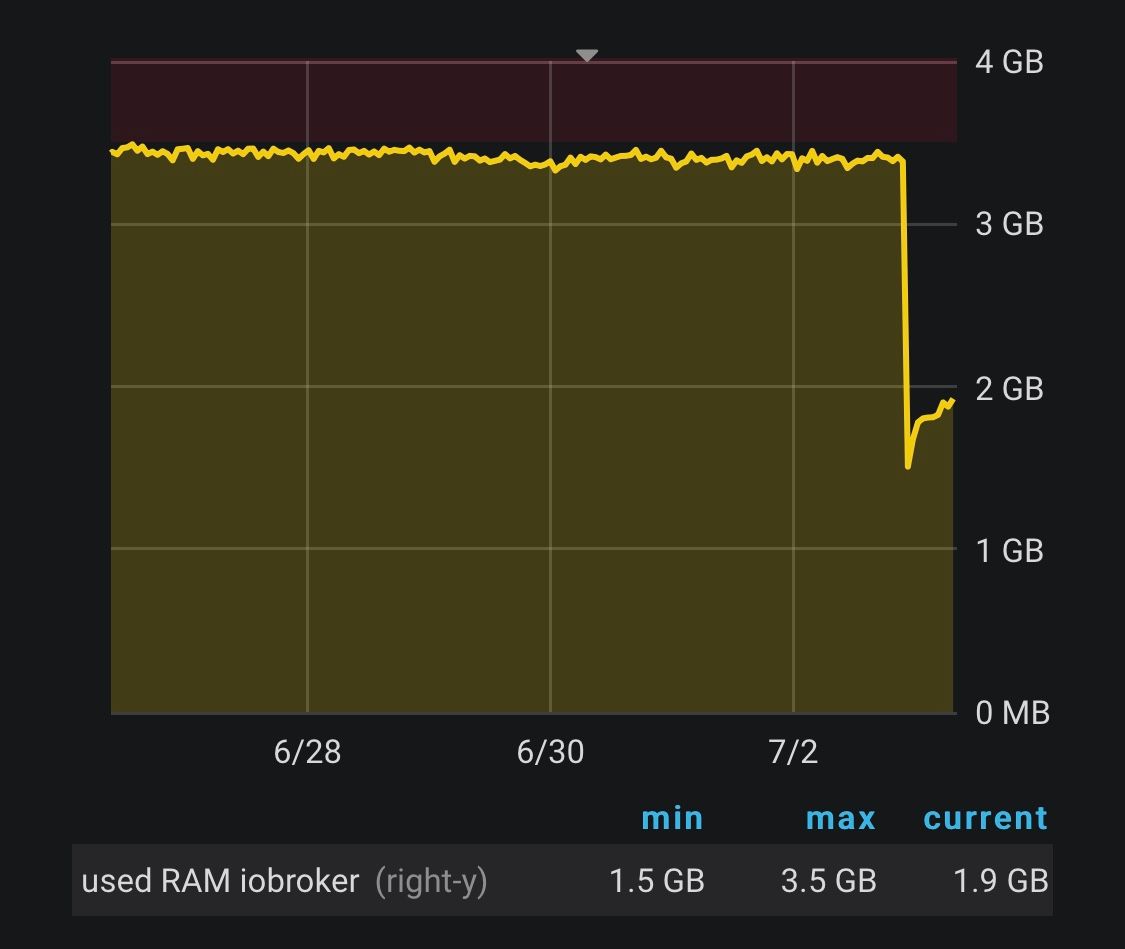

Durch proxmox VM neustart 1,5 GB mehr RAM

-

Hallo,

Ich nutze in proxmox eine debian VM mit 4 GB RAM auf der iobroker läuft, ungefähr 25 Instanzen sind aktiv. Zuletzt hatte ich nur noch 500 MB freien RAM.

Gestern musste ich aus einem anderen Grund die VM die seit 80 Tagen lief neustarten. Und jetzt habe ich auf einmal wieder 2 GB freien RAM.

Ist das normal? Falls ja startet ihr eure VMs regelmäßig neu? Warum wird der RAM nicht wieder ohne Neustart freigegeben?

-

das muss nicht unbedingt schlecht sein - linux will soviel ram wie möglich nutzen - daher ist es kein vorteil, wenn du nur 2 GB von 4GB nutzt (in der linux welt).

hier gibt es etwas mehr info :

https://www.linuxatemyram.com/

https://www.pc-erfahrung.de/linux/administration/linux-systemauslastung-analysieren.htmlauf den punkt bringt es :

https://www.doag.org/formes/pubfiles/3371993/2012_03_13-SIG-Dorlöchter_Linux_Performance.pdfWarum ist der Speicher bei Linux nach einer Weile immer „voll“?

„Ungenutzter Speicher ist verschwendeter Speicher“

Ungenutzter Speicher wird daher für Buffer und Cache verwendet

Buffer: Block-I/O (z.B. Inode-Table, etc)

Cache: Filesystem (Dateiinhalte)

Buffer und Cache sind potentieller freier Speicher und stehen sofort zur

Verfügung, falls Speicher von Prozessen benötigt wird

Eine kleine Menge freier Speicher reicht normalerweise aus, um akuten

Anforderungen der Prozesse sofort nachzukommen -

@liv-in-sky Ok danke habe ich nicht gewusst. Deine links muss ich mir in Ruhe mal durchlesen...

-

@saeft_2003 sagte in Durch proxmox VM neustart 1,5 GB mehr RAM:

Warum wird der RAM nicht wieder ohne Neustart freigegeben?

Weil er nicht verbraucht ist.

Er wurde nur den Prozessen zugewiesen, die ihn wahrscheinlich am nötigsten brauchen.Wen das RAM benötigt wird, ist es auch da

Free != Available

-

@Homoran

Wieso sehe ich erst nach meiner Antwort, dass da bereits seit 4 Stunden zwei Posts sind

-

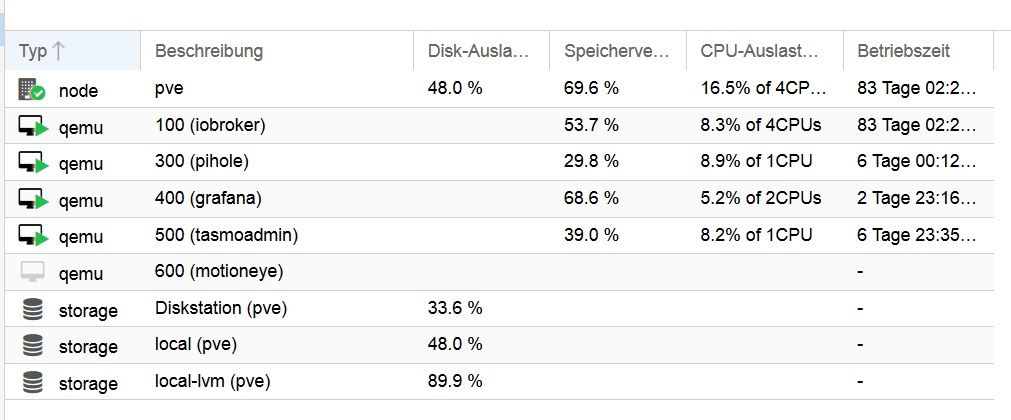

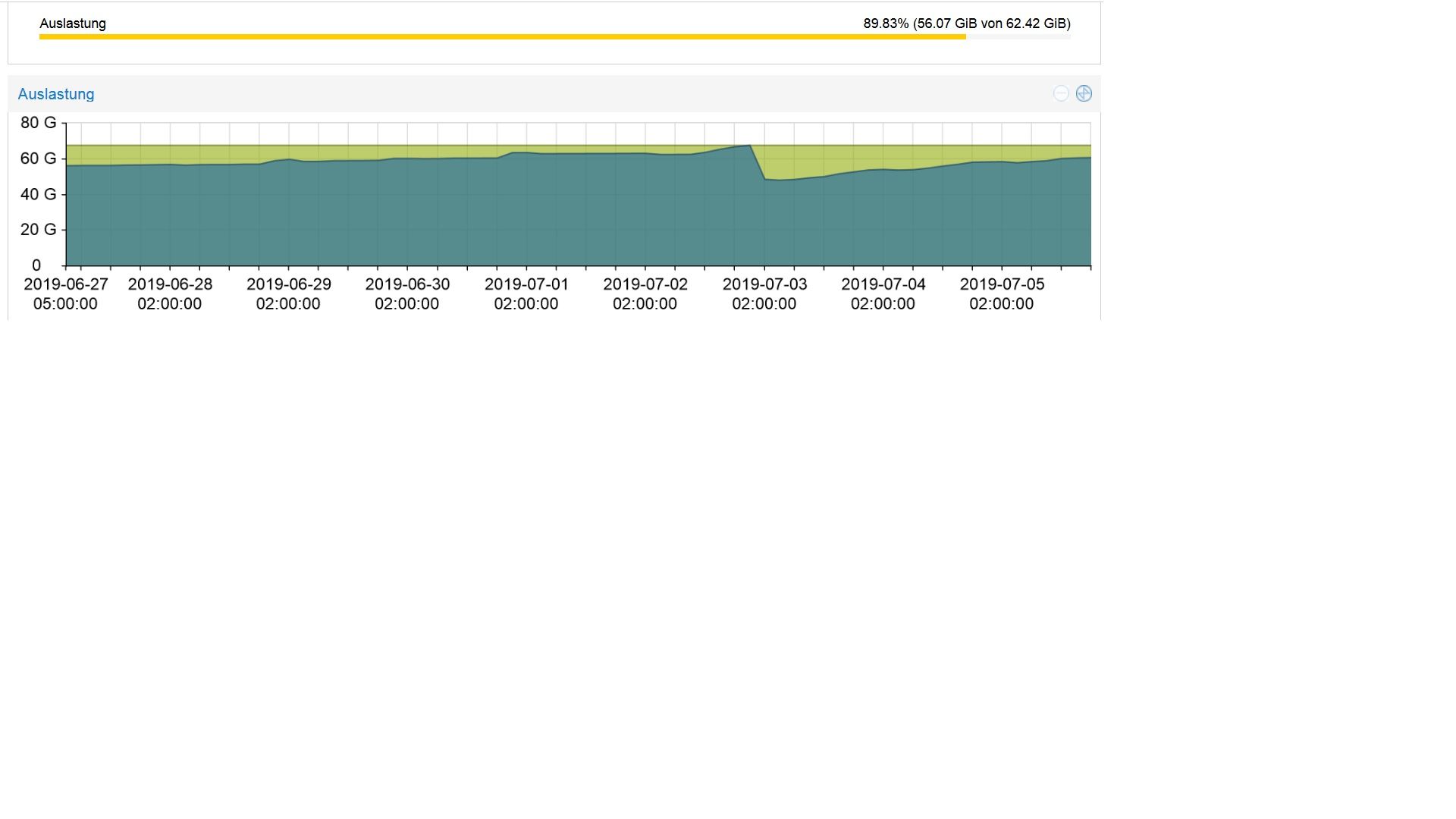

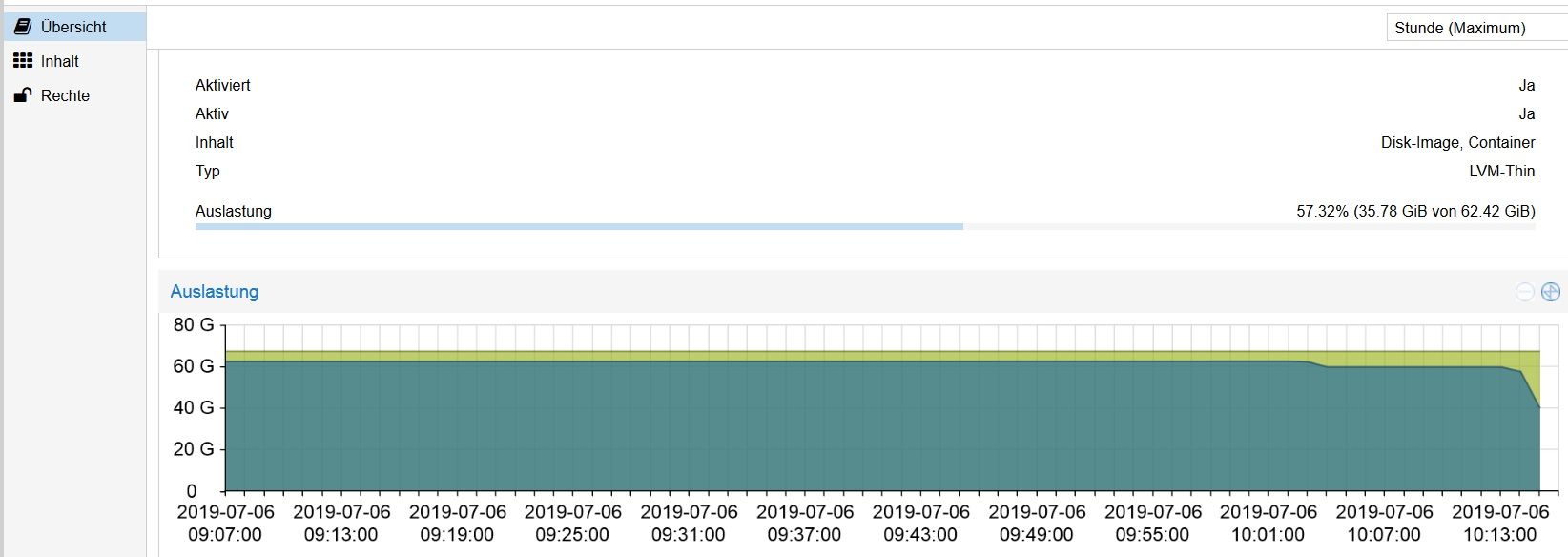

ich weiß nicht ob ihr proxmox nutzt oder nicht, aber vielleicht könnt ihr mir trotzdem weiter helfen. Mein Problem ist der sich der local-lvm Speicher von "alleine" füllt. Ich habe 5 VMs laufen mit 32, 10, 10, 5 und 5 GB Boot Disk größe macht zusammen 62 GB. Am 2.7. um 23:00 war die Auslastung von local-lvm bei 100% und zwei VMs liefen nicht mehr wegen IO Error.

Darauf hin habe ich eine VM gelöscht, dann war wieder genügend Speicher vorhanden, der sich aber jetzt wieder füllt obwohl ich gar nichts mache außer das die VMs laufen. Backups werden auf einem NAS gespeichert. Ich habe bedenken das die Auslastung wieder bis 100% steigt, oder will Linux auch hier einfach so viel Speicher wie möglich nutzen!?

Wenn ich mir über putty mit df -h den genutzen Speicher der einzelen VMs einzeigen lasse, dann wird nur ungefähr 1/3 von den 62GB verwendet. Wieso zeigt mir proxmox aber eine Auslastung von 90% an?

-

@saeft_2003 Hast Du denn eine Idee welches der 5 VMs sich scheinbar aufbläht?

Wenn Du im "Rechnzentrum" auf den Knoten von Proxmox gehst solltet Du unter "Suche" eine Liste der VMs mit u.a. der Disk-Auslastung sehen können

-

evtl vielleicht debian mit tasmoadmin. Aber diese VM hat nur eine boot disk größe von 5GB, wie kann das immer mehr werden?

root@tasmoadmin:~# df -h

Dateisystem Größe Benutzt Verf. Verw% Eingehängt auf

udev 230M 0 230M 0% /dev

tmpfs 49M 3,5M 45M 8% /run

/dev/sda1 4,4G 2,5G 1,7G 61% /

tmpfs 241M 0 241M 0% /dev/shm

tmpfs 5,0M 0 5,0M 0% /run/lock

tmpfs 241M 0 241M 0% /sys/fs/cgroup

tmpfs 49M 0 49M 0% /run/user/0 -

-

@saeft_2003

was sagt df -h auf dem server mit proxmox - nicht einzelne vms -

root@pve:~# df -h

Filesystem Size Used Avail Use % Mounted on

udev 3.9G 0 3.9G 0 % /dev

tmpfs 783M 78M 706M 10 % /run

/dev/mapper/pve-root 25G 12G 12G 51 % /

tmpfs 3.9G 43M 3.8G 2 % /dev/shm

tmpfs 5.0M 0 5.0M 0 % /run/lock

tmpfs 3.9G 0 3.9G 0 % /sys/fs/cgroup

/dev/sda2 511M 304K 511M 1 % /boot/efi

/dev/fuse 30M 20K 30M 1 % /etc/pve

192.168.178.97:/volume1/homes/Patrick/Drive/Backup proxmox 2.7T 924G 1.8T 34 % /mnt/pve/Diskstationdas habe ich gerade im proxmox forum gelesen:

Der Screenshot im ersten Post sagt lediglich aus, dass die Volume Group "pve" bereits 88% der darunterliegenden Disk in Anspruch nimmt was ja grundsätzlich nicht bedeutet, dass die Disk "voll" ist im Sinne von ich kann dort keine Daten mehr ablegen.

Am besten einmal den Output von folgenden Kommandos vergleichen:vgs

pvs

lvs

Thin provisioning heißt eigentlich lediglich, dass nur der tatsächlich genutzte Speicher auch wirklich reserviert wird. Das ganze hat eigentlich hauptsächlich damit zu tun, dass man generell dazu verleitet ist zu viel Speicherplatz zuzuweisen und dieser eigentlich effizienter genutzt werden könnte. Sprich ich hätte gerne 1TB, genutzt wird aber nur 200GB, ergo werden nur 200GB zur Verfügung gestellt. Am Ende muss man natürlich immer darauf achten, dass auch wirklich genug physischer Speicherplatz vorhanden ist auch wenn man virtuell über den tatsächlichen verfügbaren hinausgehen kann solange er nicht genutzt wird.

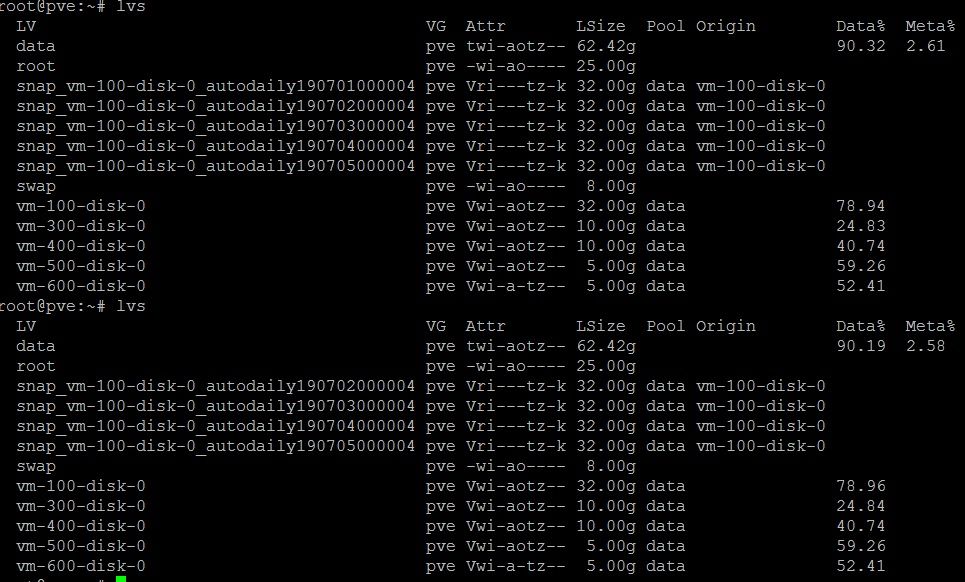

Das sagt lvs:

root@pve:~# lvs

LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert

data pve twi-aotz-- 62.42g 90.19 2.61

root pve -wi-ao---- 25.00g

snap_vm-100-disk-0_autodaily190701000004 pve Vri---tz-k 32.00g data vm-100-disk-0

snap_vm-100-disk-0_autodaily190702000004 pve Vri---tz-k 32.00g data vm-100-disk-0

snap_vm-100-disk-0_autodaily190703000004 pve Vri---tz-k 32.00g data vm-100-disk-0

snap_vm-100-disk-0_autodaily190704000004 pve Vri---tz-k 32.00g data vm-100-disk-0

snap_vm-100-disk-0_autodaily190705000004 pve Vri---tz-k 32.00g data vm-100-disk-0

swap pve -wi-ao---- 8.00g

vm-100-disk-0 pve Vwi-aotz-- 32.00g data 78.94

vm-300-disk-0 pve Vwi-aotz-- 10.00g data 24.83

vm-400-disk-0 pve Vwi-aotz-- 10.00g data 40.74

vm-500-disk-0 pve Vwi-aotz-- 5.00g data 59.26

vm-600-disk-0 pve Vwi-a-tz-- 5.00g data 52.41 -

sorry aber ich denke, da kann ich keine hilfe sein - bei mir sieht das alles ganz anders aus - da reicht meine kenntnis über proxmox nicht aus

könnte es irgendein log sein, dass explodiert - hatte das vor kurzem: var/log/daemon.log und syslog waren jeweils 5GB groß - platte voll - server tot - der simple-api adapter (nach update) hat plötzlich mehr ins syslog geschrieben - wurde in neuer version dank apollon gefixt

mehr fällt mir leider dazu nicht ein (was aber df -h aufzeigen müßte)

-

ok danke. mit dem befehl lvs sieht man das die vm 100 größer geworden ist darauf läuft iobroker mit history und auf der vm 300 die auch größer geworden ist läuft grafana mit einer influxdb.

Wo kann man die history daten löschen?

-

@saeft_2003 bevor du etwas löscht

kennst du ncdu (apt-get install ncdu) - vielleicht hilft es ja bei der suche - man kann ähnlich wie bei treesize (windows) durch die ordner "hüpfen"

damit kannst du sehr einfach und schnell die ordnergrößen checken z.b.

cd /opt/iobroker

ncduzu history:

https://forum.iobroker.net/post/229496entweder hast du den pfad selbst angelegt im setting der history oder es ist unter /opt/iobroker/iobroker-data/history

ps: machst du automatische backups unter /opt/iobroker/backups - evtl dort zu viele files ?

-

Hi,

für mich sieht es so aus, als ob Du von der VM100 (iobroker?) in Proxmox automatisch tägliche Snapshots anlegen lässt, die aber anscheindend nicht in Deinen Backup-Ordner wandern, sondern direkt in local-lvm. Da würde ich mal schauen, ob da das falsche ausgewählt wurde.

Gruss, Jürgen

-

ich habe die snaps gelöscht, diese haben einen großen Teil ausgemacht! Danke für den Tipp...

-

Danke. Ne in backups liegen nur ein paar files. Die snapshots haben einen großen Teil ausgemacht.