NEWS

Proxmox / Influxdb V1 zu V2... wie?

-

nachdem ich den token hinzugefügt habe, musste ich 2x ein PW eingeben, danach kam diese Meldung

root@d838f40c3dd2:/# influx v1 auth create --org-id universe --read-bucket 51f77c18f32e8b3d --username grafana -t iuLUDd54DwIKgUl8gfJwjU92shXM8Gp1EML7bNoapea7E-bQG26LGxxZfV98i06P5U4qLGQYCHdA4K32JA1BEA== ? Please type your password ********** ? Please type your password again ********** Error: failed to create new authorization: 400 Bad Request: invalid json structure: id must have a length of 16 bytes@massiveattack sagte in Proxmox / Influxdb V1 zu V2... wie?:

nachdem ich den token hinzugefügt habe, musste ich 2x ein PW eingeben, danach kam diese Meldung

root@d838f40c3dd2:/# influx v1 auth create --org-id universe --read-bucket 51f77c18f32e8b3d --username grafana -t iuLUDd54DwIKgUl8gfJwjU92shXM8Gp1EML7bNoapea7E-bQG26LGxxZfV98i06P5U4qLGQYCHdA4K32JA1BEA== ? Please type your password ********** ? Please type your password again ********** Error: failed to create new authorization: 400 Bad Request: invalid json structure: id must have a length of 16 bytesWenn Du die Option "--org-id" angibst, erwartet er eine ID und keinen Namen, ansonsten "--org" nutzen.

-

@massiveattack sagte in Proxmox / Influxdb V1 zu V2... wie?:

nachdem ich den token hinzugefügt habe, musste ich 2x ein PW eingeben, danach kam diese Meldung

root@d838f40c3dd2:/# influx v1 auth create --org-id universe --read-bucket 51f77c18f32e8b3d --username grafana -t iuLUDd54DwIKgUl8gfJwjU92shXM8Gp1EML7bNoapea7E-bQG26LGxxZfV98i06P5U4qLGQYCHdA4K32JA1BEA== ? Please type your password ********** ? Please type your password again ********** Error: failed to create new authorization: 400 Bad Request: invalid json structure: id must have a length of 16 bytesWenn Du die Option "--org-id" angibst, erwartet er eine ID und keinen Namen, ansonsten "--org" nutzen.

jo, da hast du wohl recht :)

das ging mal durch

ID Description Username v2 User Name v2 User ID Permissions 0ab5bb263263b000 grafana Jochen 0ab57e1742211000 [read:orgs/bcc1c2a945a2c408/buckets/51f77c18f32e8b3d]beim nächste Schritt hatte ich wieder ein Berechtigungsproblem, mit dem token gings wieder:

root@d838f40c3dd2:/# influx v1 dbrp create --org-id bcc1c2a945a2c408 --db iobroker --rp autogen --bucket-id 51f77c18f32e8b3d --default -t KUArezBLNDbZWty0PcwTbD0rme4qIR2JZ0sffRAU8mcT2eXMB12jp6-aTRiH0Gtw0UsY4aEr1U3JXMiYWFTlWg== ID Database Bucket ID Retention Policy Default Organization ID 0ab5bc988fa3b000 iobroker 51f77c18f32e8b3d autogen true bcc1c2a945a2c408und jetzt funktioniert influxql?

-

jo, da hast du wohl recht :)

das ging mal durch

ID Description Username v2 User Name v2 User ID Permissions 0ab5bb263263b000 grafana Jochen 0ab57e1742211000 [read:orgs/bcc1c2a945a2c408/buckets/51f77c18f32e8b3d]beim nächste Schritt hatte ich wieder ein Berechtigungsproblem, mit dem token gings wieder:

root@d838f40c3dd2:/# influx v1 dbrp create --org-id bcc1c2a945a2c408 --db iobroker --rp autogen --bucket-id 51f77c18f32e8b3d --default -t KUArezBLNDbZWty0PcwTbD0rme4qIR2JZ0sffRAU8mcT2eXMB12jp6-aTRiH0Gtw0UsY4aEr1U3JXMiYWFTlWg== ID Database Bucket ID Retention Policy Default Organization ID 0ab5bc988fa3b000 iobroker 51f77c18f32e8b3d autogen true bcc1c2a945a2c408und jetzt funktioniert influxql?

@massiveattack sagte in Proxmox / Influxdb V1 zu V2... wie?:

und jetzt funktioniert influxql?

Jetzt noch einen dedizierten API-Key anlegen und dann eine Grafana-Datenquelle wie in meinen Screenshots.

Wichtig ist der Custom HTTP Header "Authorization" mit dem Inhalt "Token <API Token>", also mit dem Wort "Token" vor dem Token...

Also z.B. "Token 1234ab......cdef=="

-

@massiveattack sagte in Proxmox / Influxdb V1 zu V2... wie?:

und jetzt funktioniert influxql?

Jetzt noch einen dedizierten API-Key anlegen und dann eine Grafana-Datenquelle wie in meinen Screenshots.

Wichtig ist der Custom HTTP Header "Authorization" mit dem Inhalt "Token <API Token>", also mit dem Wort "Token" vor dem Token...

Also z.B. "Token 1234ab......cdef=="

sensationell, funktioniert :) :) :)

Vielen Dank dafür!!

Werde jetzt noch versuchen, die Werte aus v1 in die v2 zu bekommen.==>

<<Export mit:

influx_inspect export -database iobroker -out /tmp/export.gz -compress -lponly

und Import mit:

influx write -b iobroker_test -f export.gzevtl. müssen die Datenverzeichnisse bei Export mit angegeben werden

-datadir /var/lib/influxdb/data/ -waldir /var/lib/influxdb/wal/>>Funktioniert das damit? Wie kann ich den Pfad zum Export mitangeben?

-

sensationell, funktioniert :) :) :)

Vielen Dank dafür!!

Werde jetzt noch versuchen, die Werte aus v1 in die v2 zu bekommen.==>

<<Export mit:

influx_inspect export -database iobroker -out /tmp/export.gz -compress -lponly

und Import mit:

influx write -b iobroker_test -f export.gzevtl. müssen die Datenverzeichnisse bei Export mit angegeben werden

-datadir /var/lib/influxdb/data/ -waldir /var/lib/influxdb/wal/>>Funktioniert das damit? Wie kann ich den Pfad zum Export mitangeben?

@massiveattack sagte in Proxmox / Influxdb V1 zu V2... wie?:

Funktioniert das damit? Wie kann ich den Pfad zum Export mitangeben?

Da bin ich nicht fit und müsste selbst recherchieren. Ich habe "damals" ein Update der InfluxDB via Docker gemacht. Das ging zum Glück reibungslos.

-

@massiveattack sagte in Proxmox / Influxdb V1 zu V2... wie?:

Funktioniert das damit? Wie kann ich den Pfad zum Export mitangeben?

Da bin ich nicht fit und müsste selbst recherchieren. Ich habe "damals" ein Update der InfluxDB via Docker gemacht. Das ging zum Glück reibungslos.

@marc-berg

anyway, du hast mir sehr geholfen, danke nochmals!

Werd mich damit weiter beschäftigen, und meine Ergebnisse dann berichten -

@massiveattack sagte in Proxmox / Influxdb V1 zu V2... wie?:

und jetzt funktioniert influxql?

Jetzt noch einen dedizierten API-Key anlegen und dann eine Grafana-Datenquelle wie in meinen Screenshots.

Wichtig ist der Custom HTTP Header "Authorization" mit dem Inhalt "Token <API Token>", also mit dem Wort "Token" vor dem Token...

Also z.B. "Token 1234ab......cdef=="

Servus Marc!

Sorry, wenn ich mich da kurz einklinke. :)

Ich hab Influx 2 frisch installiert (kein Upgrade).

Wenn ich

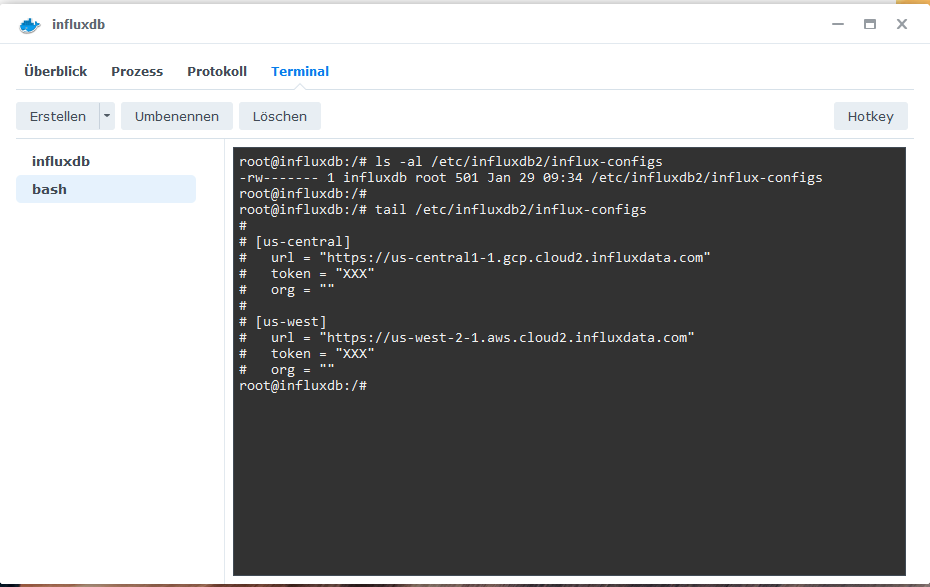

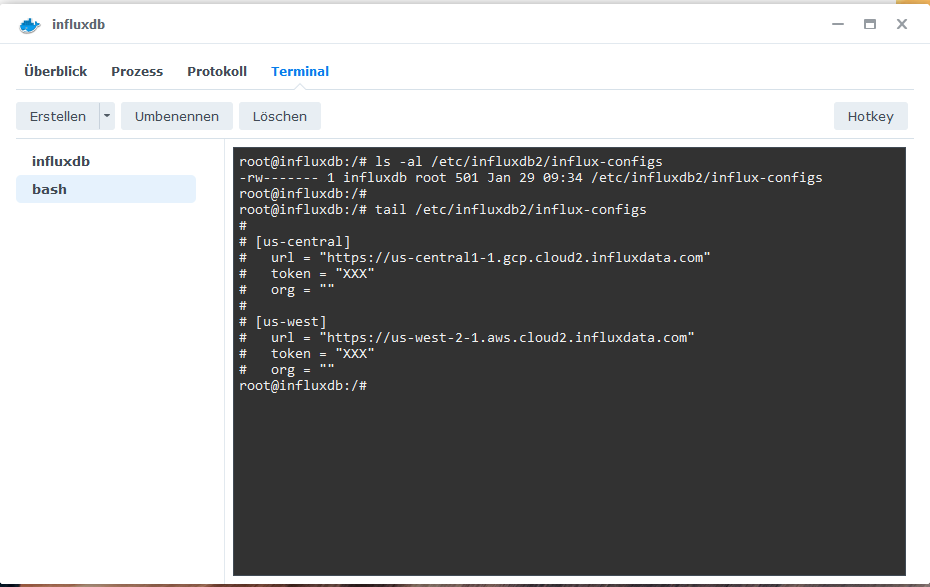

influx config listeingebe, kommtnega@influxdb:~$ influx config list Active Name URL Org * default http://localhost:8086 daheimDas passt so?

Oder muss nun noch was erledigt werden, um mit dem Adapter zu beginnen?

DB wird ja dann vom Adapter angelegt? -

Servus Marc!

Sorry, wenn ich mich da kurz einklinke. :)

Ich hab Influx 2 frisch installiert (kein Upgrade).

Wenn ich

influx config listeingebe, kommtnega@influxdb:~$ influx config list Active Name URL Org * default http://localhost:8086 daheimDas passt so?

Oder muss nun noch was erledigt werden, um mit dem Adapter zu beginnen?

DB wird ja dann vom Adapter angelegt?@negalein sagte in Proxmox / Influxdb V1 zu V2... wie?:

Das passt so?

Oder muss nun noch was erledigt werden, um mit dem Adapter zu beginnen?

DB wird ja dann vom Adapter angelegt?Nein, das sieht gut aus. Mit diesen Einstellungen solltest Du die Org+Token weglassen können, wenn Du Kommandozeilenbefehle verwendest. Er nimmt dann immer das Active Profil, das mit einem "*" gekennzeichnet ist. Man könnte da auch mehrere Profile anlegen.

-

@da_woody sagte in Proxmox / Influxdb V1 zu V2... wie?:

aber ich fummel halt nicht mit docker rum

ich auch nicht mehr.

Influx war das letzte Teil im Docker.

Komm ja nichtmal zur influxdb.cfg

Geht zwar mit cd /etc/ usw.

Aber keine .cfg auffindbar.Deshalb weg damit und mit V2 neu beginnen.

Denke Influx mit der Wetterstation ist nur für das Statistik-Script und Grafana nötig.

Awekas funktioniert auch ohne Influx. Oder @SBorg ?@negalein sagte in Proxmox / Influxdb V1 zu V2... wie?:

Aber keine .cfg auffindbar.

Deshalb weg damit und mit V2 neu beginnen.

Denke Influx mit der Wetterstation ist nur für das Statistik-Script und Grafana nötig.

Awekas funktioniert auch ohne Influx. Oder @SBorg ?Dann haste den Docker nicht richtig konfiguriert, da gibt es sehr wohl cfg's ;)

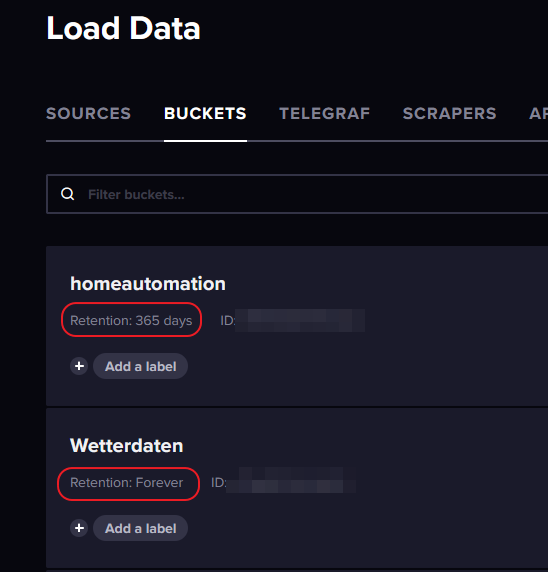

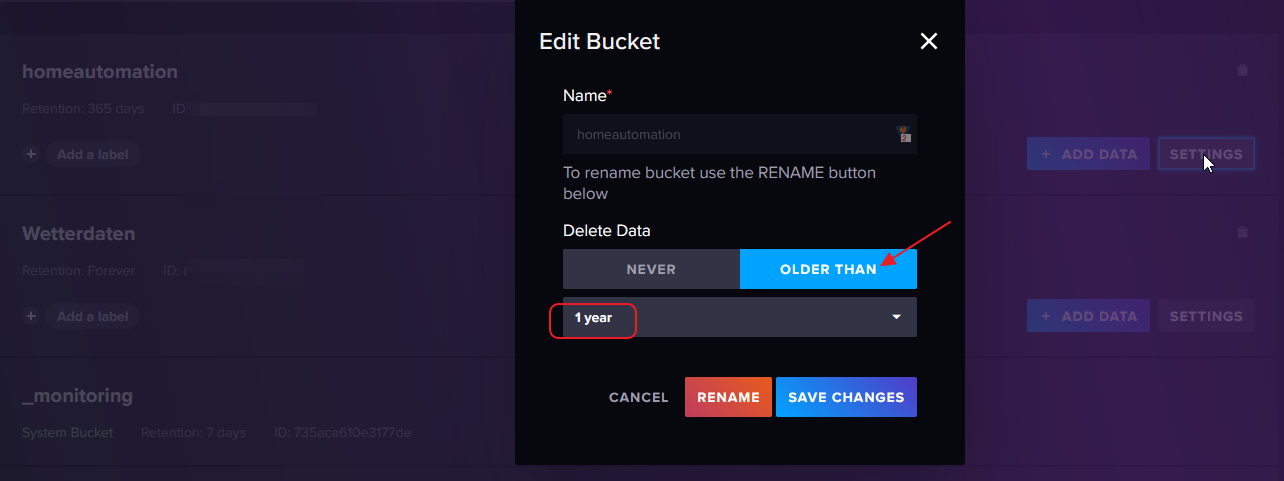

...und beides Ja. Influx ist im Bereich "Wetter" nur für alles zuständig was nicht aktuell als Wert vorliegt. Die Station meldet bspw. nur die aktuelle Temperatur. Am Display kann man dann zwar Min/Max etc. abfragen, aber senden tut sie das nicht. Deswegen müssen die Werte per Influx geloggt werden, dann kann ich das Tagesmaximum etc. pp ermitteln.

Wenn man aber bspw. für Grafana eine Statusanzeige der Datenübermittlung möchte, kommt man hier um Influx auch nicht herum (wird aber für den reinen Betrieb nicht benötigt).

Kurz gesagt: alles mit "4" braucht Influx https://github.com/SBorg2014/WLAN-Wetterstation/wiki

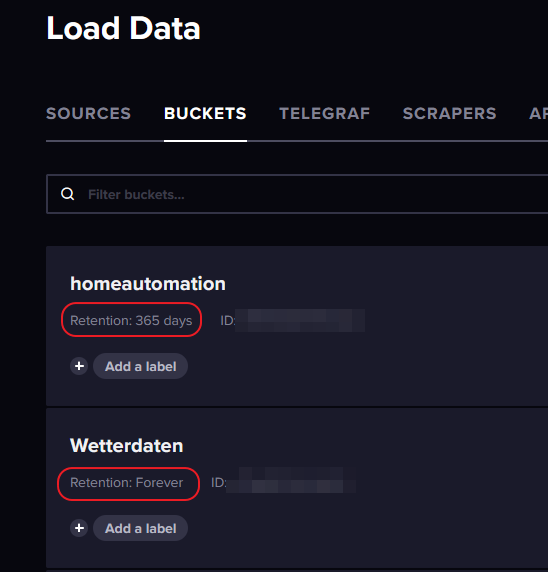

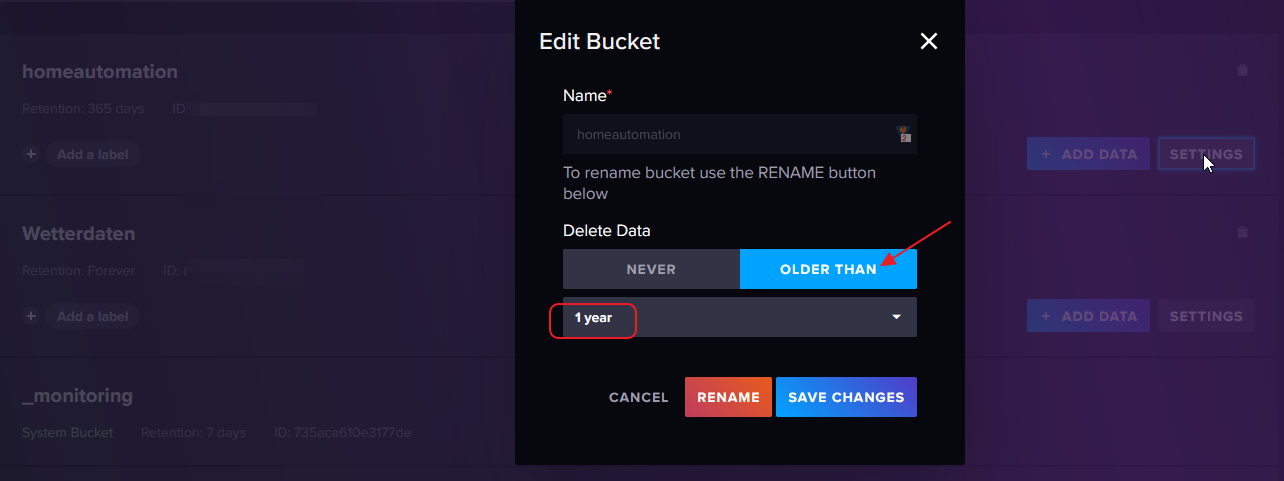

...und für die Statusanzeige ist dann bspw. wieder der Bucket wichtig. Steht hier die RP auf "never", wird der true/false Wert der Datenübertragung bis zum Skt. Nimmerleinstag gespeichert. So etwas gehört dann in einen "Mülleimer"-Bucket (nenne nur ich jetzt so), wo nichts wichtiges drin landet und mit einer RP von bspw. 3 Tagen...

-

@negalein sagte in Proxmox / Influxdb V1 zu V2... wie?:

Aber keine .cfg auffindbar.

Deshalb weg damit und mit V2 neu beginnen.

Denke Influx mit der Wetterstation ist nur für das Statistik-Script und Grafana nötig.

Awekas funktioniert auch ohne Influx. Oder @SBorg ?Dann haste den Docker nicht richtig konfiguriert, da gibt es sehr wohl cfg's ;)

...und beides Ja. Influx ist im Bereich "Wetter" nur für alles zuständig was nicht aktuell als Wert vorliegt. Die Station meldet bspw. nur die aktuelle Temperatur. Am Display kann man dann zwar Min/Max etc. abfragen, aber senden tut sie das nicht. Deswegen müssen die Werte per Influx geloggt werden, dann kann ich das Tagesmaximum etc. pp ermitteln.

Wenn man aber bspw. für Grafana eine Statusanzeige der Datenübermittlung möchte, kommt man hier um Influx auch nicht herum (wird aber für den reinen Betrieb nicht benötigt).

Kurz gesagt: alles mit "4" braucht Influx https://github.com/SBorg2014/WLAN-Wetterstation/wiki

...und für die Statusanzeige ist dann bspw. wieder der Bucket wichtig. Steht hier die RP auf "never", wird der true/false Wert der Datenübertragung bis zum Skt. Nimmerleinstag gespeichert. So etwas gehört dann in einen "Mülleimer"-Bucket (nenne nur ich jetzt so), wo nichts wichtiges drin landet und mit einer RP von bspw. 3 Tagen...

@sborg sagte in Proxmox / Influxdb V1 zu V2... wie?:

Kurz gesagt: alles mit "4" braucht Influx https://github.com/SBorg2014/WLAN-Wetterstation/wiki

Ok, dann lass ich mal beide paralell laufen.

Aber für die Werte an Awekas & Co. ist es nicht notwendig?

-

@sborg sagte in Proxmox / Influxdb V1 zu V2... wie?:

Kurz gesagt: alles mit "4" braucht Influx https://github.com/SBorg2014/WLAN-Wetterstation/wiki

Ok, dann lass ich mal beide paralell laufen.

Aber für die Werte an Awekas & Co. ist es nicht notwendig?

@negalein sagte in Proxmox / Influxdb V1 zu V2... wie?:

Aber für die Werte an Awekas & Co. ist es nicht notwendig?

Nein, die kriegen nur aktuelle Messwerte. AWEKAS würde auch nur den WU-String bekommen, mehr sendet das Display nicht.

-

@negalein sagte in Proxmox / Influxdb V1 zu V2... wie?:

Aber für die Werte an Awekas & Co. ist es nicht notwendig?

Nein, die kriegen nur aktuelle Messwerte. AWEKAS würde auch nur den WU-String bekommen, mehr sendet das Display nicht.

@sborg sagte in Proxmox / Influxdb V1 zu V2... wie?:

Nein, die kriegen nur aktuelle Messwerte. AWEKAS würde auch nur den WU-String bekommen, mehr sendet das Display nicht.

das ist perfekt! :)

-

Für ganze Datenbanken

Export mit:

influx_inspect export -database iobroker -out /tmp/export.gz -compress -lponly

und Import mit:

influx write -b iobroker_test -f export.gzscheint zu funktionieren.

evtl. müssen die Datenverzeichnisse bei Export mit angegeben werden

-datadir /var/lib/influxdb/data/ -waldir /var/lib/influxdb/wal/

(bei mir)ABER

Die Dateien sind sehr groß (hier für 2 Jahre ca. 800MB)

Das dauert...Nur der Import über die WebGUI geht anscheinend nicht...

@boronsbruder sagte in Proxmox / Influxdb V1 zu V2... wie?:

Für ganze Datenbanken

Export mit:

influx_inspect export -database iobroker -out /tmp/export.gz -compress -lponly

und Import mit:

influx write -b iobroker_test -f export.gzscheint zu funktionieren.

evtl. müssen die Datenverzeichnisse bei Export mit angegeben werden

-datadir /var/lib/influxdb/data/ -waldir /var/lib/influxdb/wal/

(bei mir)ABER

Die Dateien sind sehr groß (hier für 2 Jahre ca. 800MB)

Das dauert...Nur der Import über die WebGUI geht anscheinend nicht...

Der Export hat funktioniert:

influx_inspect export -database iobroker -out /tmp/export.gz -compress -datadir /var/lib/influxdb/data/ -waldir /var/lib/influxdb/wal/ influx write -b iobroker -f export.gzDer Import schlägt fehl:

root@InfluxDB2:/backup# influx write -b iobroker -o universe -t GN_rdOseDJAA_RY5Akp5qLexrrDmolABpr0pmYrpMiRVUJk9NYwCg6I4GPM3luNvRRXfOs86kqN9IIgXCxfwPw== -f export.gz Error: failed to write data: 400 Bad Request: unable to parse 'CREATE DATABASE iobroker WITH NAME autogen': invalid field format@Boronsbruder

hast du eine Idee? -

@boronsbruder sagte in Proxmox / Influxdb V1 zu V2... wie?:

Für ganze Datenbanken

Export mit:

influx_inspect export -database iobroker -out /tmp/export.gz -compress -lponly

und Import mit:

influx write -b iobroker_test -f export.gzscheint zu funktionieren.

evtl. müssen die Datenverzeichnisse bei Export mit angegeben werden

-datadir /var/lib/influxdb/data/ -waldir /var/lib/influxdb/wal/

(bei mir)ABER

Die Dateien sind sehr groß (hier für 2 Jahre ca. 800MB)

Das dauert...Nur der Import über die WebGUI geht anscheinend nicht...

Der Export hat funktioniert:

influx_inspect export -database iobroker -out /tmp/export.gz -compress -datadir /var/lib/influxdb/data/ -waldir /var/lib/influxdb/wal/ influx write -b iobroker -f export.gzDer Import schlägt fehl:

root@InfluxDB2:/backup# influx write -b iobroker -o universe -t GN_rdOseDJAA_RY5Akp5qLexrrDmolABpr0pmYrpMiRVUJk9NYwCg6I4GPM3luNvRRXfOs86kqN9IIgXCxfwPw== -f export.gz Error: failed to write data: 400 Bad Request: unable to parse 'CREATE DATABASE iobroker WITH NAME autogen': invalid field format@Boronsbruder

hast du eine Idee?@massiveattack

Versuch nochmal mit -lponly, wie ich geschrieben hab?Und warum machst gleich noch ein write?

influx write -b iobroker -f export.gzgehört auf den neuen Host -

@massiveattack

Versuch nochmal mit -lponly, wie ich geschrieben hab?Und warum machst gleich noch ein write?

influx write -b iobroker -f export.gzgehört auf den neuen Hostflag provided but not defined: -lponly Exports TSM files into InfluxDB line protocol format.logisch :)

war ein copy paste Fehler -

flag provided but not defined: -lponly Exports TSM files into InfluxDB line protocol format.logisch :)

war ein copy paste Fehler@massiveattack

Posted doch bitte die cmdline die den Fehler auslöst immer mit dazu -

@massiveattack

Posted doch bitte die cmdline die den Fehler auslöst immer mit dazuroot@QNAP:/# influx_inspect export -database iobroker -out /tmp/test.lp -lponly flag provided but not defined: -lponly Exports TSM files into InfluxDB line protocol format. -

root@QNAP:/# influx_inspect export -database iobroker -out /tmp/test.lp -lponly flag provided but not defined: -lponly Exports TSM files into InfluxDB line protocol format.@massiveattack

poste doch mal bitte

influx -v -

@massiveattack

poste doch mal bitte

influx -vroot@QNAP:/# influx -v flag provided but not defined: -v Usage of influx: -version Display the version and exit. -path-prefix 'url path' Path that follows the host and port -host 'host name' Host to connect to. -port 'port #' Port to connect to. -socket 'unix domain socket' Unix socket to connect to. -database 'database name' Database to connect to the server. -password 'password' Password to connect to the server. Leaving blank will prompt for password (--password ''). -username 'username' Username to connect to the server. -ssl Use https for requests. -unsafeSsl Set this when connecting to the cluster using https and not use SSL verification. -execute 'command' Execute command and quit. -type 'influxql|flux' Type specifies the query language for executing commands or when invoking the REPL. -format 'json|csv|column' Format specifies the format of the server responses: json, csv, or column. -precision 'rfc3339|h|m|s|ms|u|ns' Precision specifies the format of the timestamp: rfc3339, h, m, s, ms, u or ns. -consistency 'any|one|quorum|all' Set write consistency level: any, one, quorum, or all -pretty Turns on pretty print for the json format. -import Import a previous database export from file -pps How many points per second the import will allow. By default it is zero and will not throttle importing. -path Path to file to import -compressed Set to true if the import file is compressed Examples: # Use influx in a non-interactive mode to query the database "metrics" and pretty print json: $ influx -database 'metrics' -execute 'select * from cpu' -format 'json' -pretty # Connect to a specific database on startup and set database context: $ influx -database 'metrics' -host 'localhost' -port '8086' -

root@QNAP:/# influx -v flag provided but not defined: -v Usage of influx: -version Display the version and exit. -path-prefix 'url path' Path that follows the host and port -host 'host name' Host to connect to. -port 'port #' Port to connect to. -socket 'unix domain socket' Unix socket to connect to. -database 'database name' Database to connect to the server. -password 'password' Password to connect to the server. Leaving blank will prompt for password (--password ''). -username 'username' Username to connect to the server. -ssl Use https for requests. -unsafeSsl Set this when connecting to the cluster using https and not use SSL verification. -execute 'command' Execute command and quit. -type 'influxql|flux' Type specifies the query language for executing commands or when invoking the REPL. -format 'json|csv|column' Format specifies the format of the server responses: json, csv, or column. -precision 'rfc3339|h|m|s|ms|u|ns' Precision specifies the format of the timestamp: rfc3339, h, m, s, ms, u or ns. -consistency 'any|one|quorum|all' Set write consistency level: any, one, quorum, or all -pretty Turns on pretty print for the json format. -import Import a previous database export from file -pps How many points per second the import will allow. By default it is zero and will not throttle importing. -path Path to file to import -compressed Set to true if the import file is compressed Examples: # Use influx in a non-interactive mode to query the database "metrics" and pretty print json: $ influx -database 'metrics' -execute 'select * from cpu' -format 'json' -pretty # Connect to a specific database on startup and set database context: $ influx -database 'metrics' -host 'localhost' -port '8086'@massiveattack

influx -version