NEWS

Zeitraum Datensätze

-

Hallo,

es gab doch mal eine Befehlszeile in der ich bei den Objektdaten, die Länge der Speicherzeit des einzelnen Datenfelds bestimmen konnte. Z.B. dass die Daten nur für 2 Wochen oder 2 Monate gespeichert werden sollen. Der Standard Wert für die Speicherzeit, sollte weiterhin bei „immer“ bleiben. Bzw. muss die Bereinigung der Datenbank dann getrennt noch angestoßen werden oder wann lösch die Datenbank die nichtmehr benötigten Datensätze?

Mit freundlichen Grüßen

Th. Seide -

Hallo,

es gab doch mal eine Befehlszeile in der ich bei den Objektdaten, die Länge der Speicherzeit des einzelnen Datenfelds bestimmen konnte. Z.B. dass die Daten nur für 2 Wochen oder 2 Monate gespeichert werden sollen. Der Standard Wert für die Speicherzeit, sollte weiterhin bei „immer“ bleiben. Bzw. muss die Bereinigung der Datenbank dann getrennt noch angestoßen werden oder wann lösch die Datenbank die nichtmehr benötigten Datensätze?

Mit freundlichen Grüßen

Th. Seide@seide-th sagte in Zeitraum Datensätze:

eine Befehlszeile in der ich bei den Objektdaten, die Länge der Speicherzeit des einzelnen Datenfelds bestimmen konnte

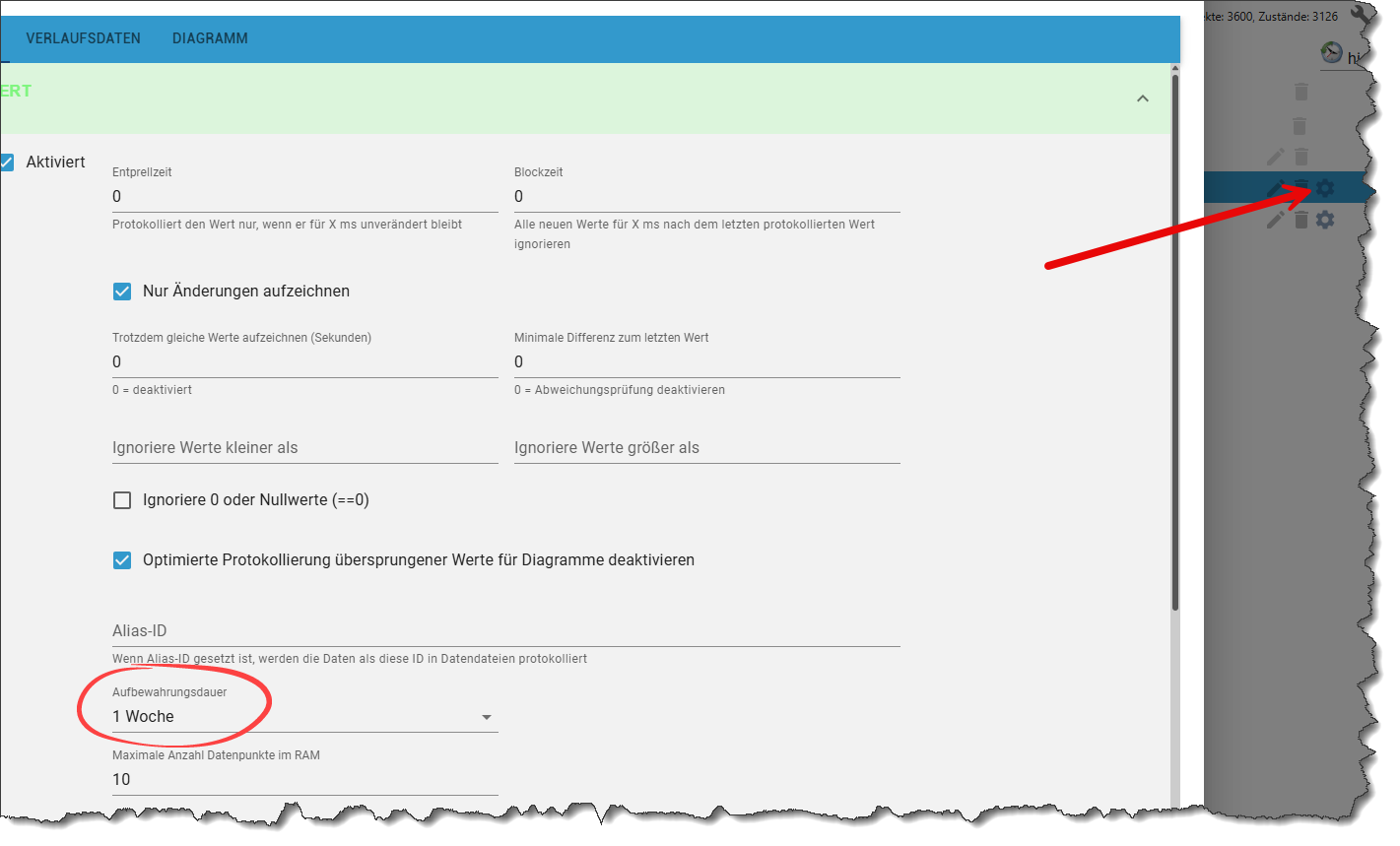

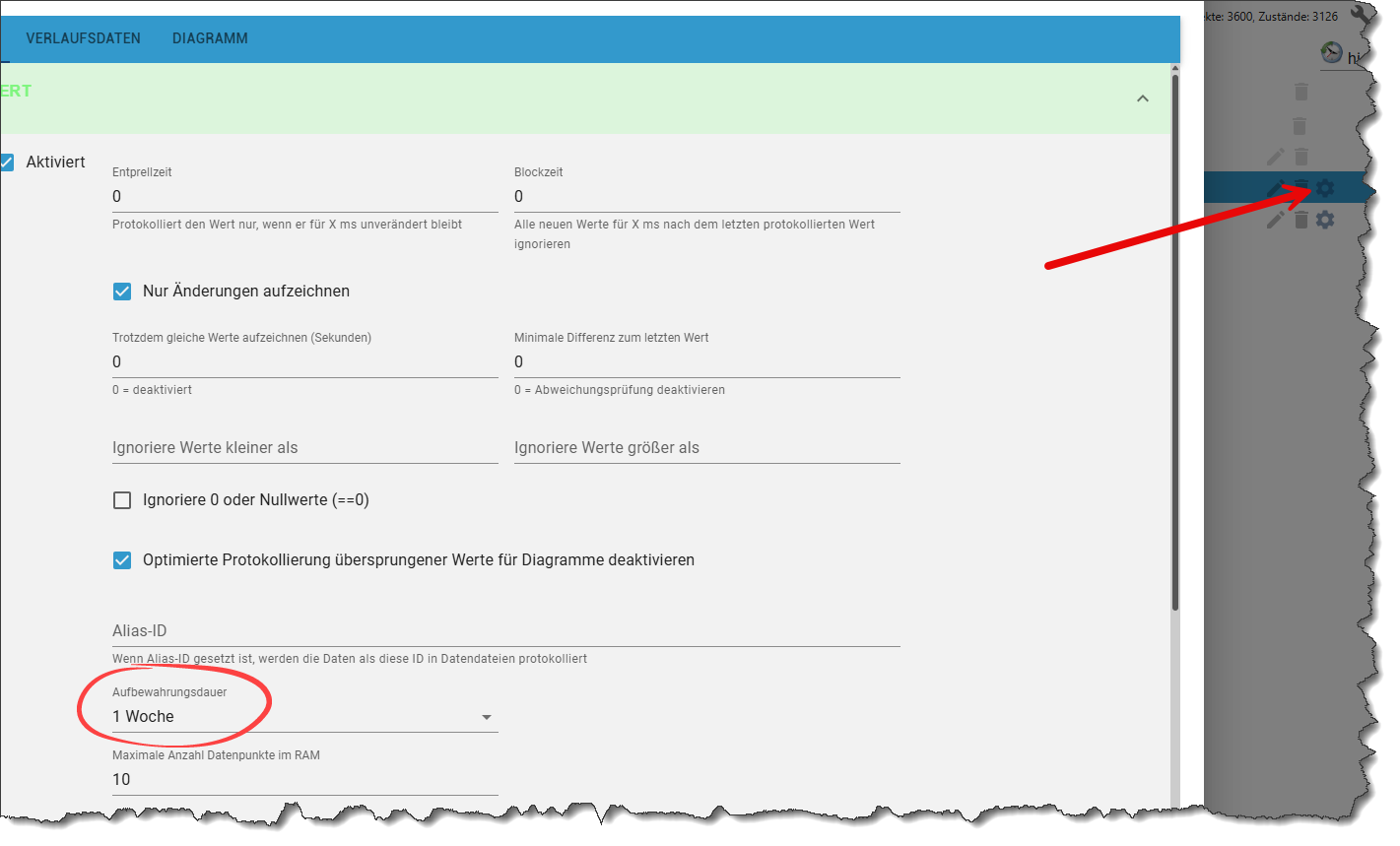

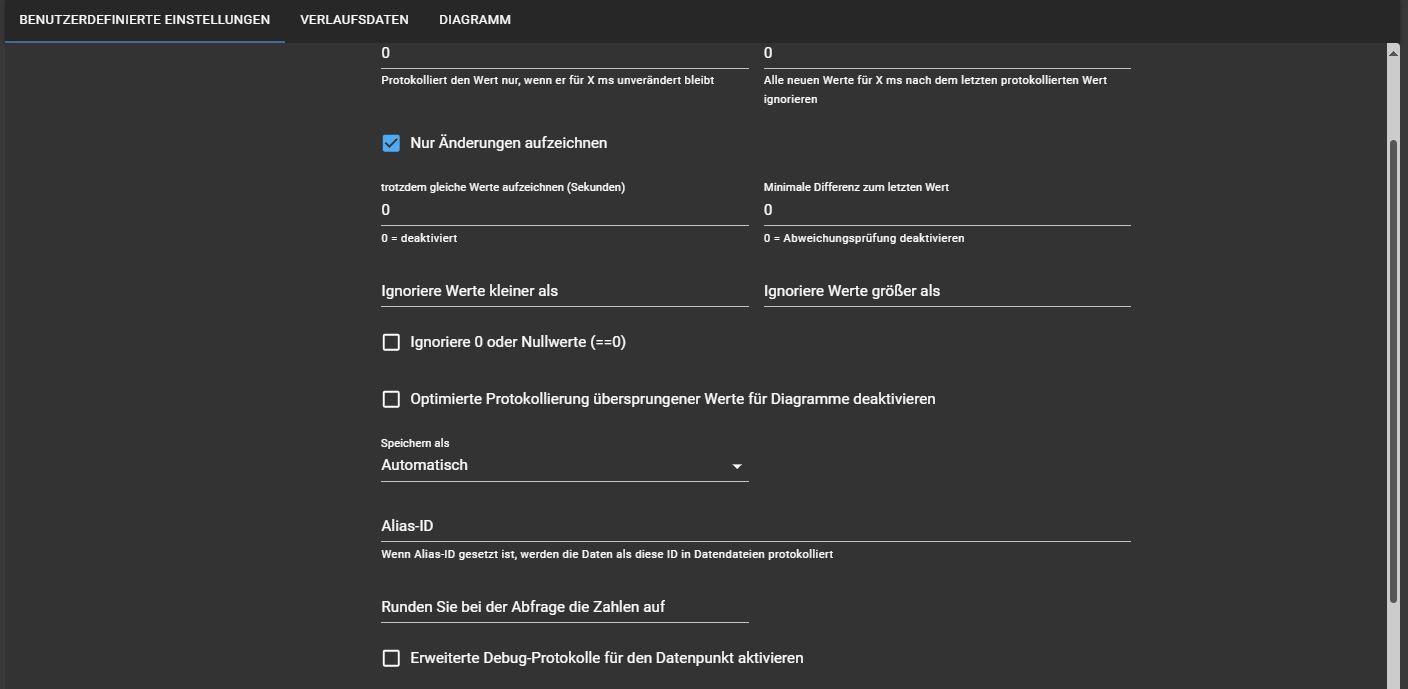

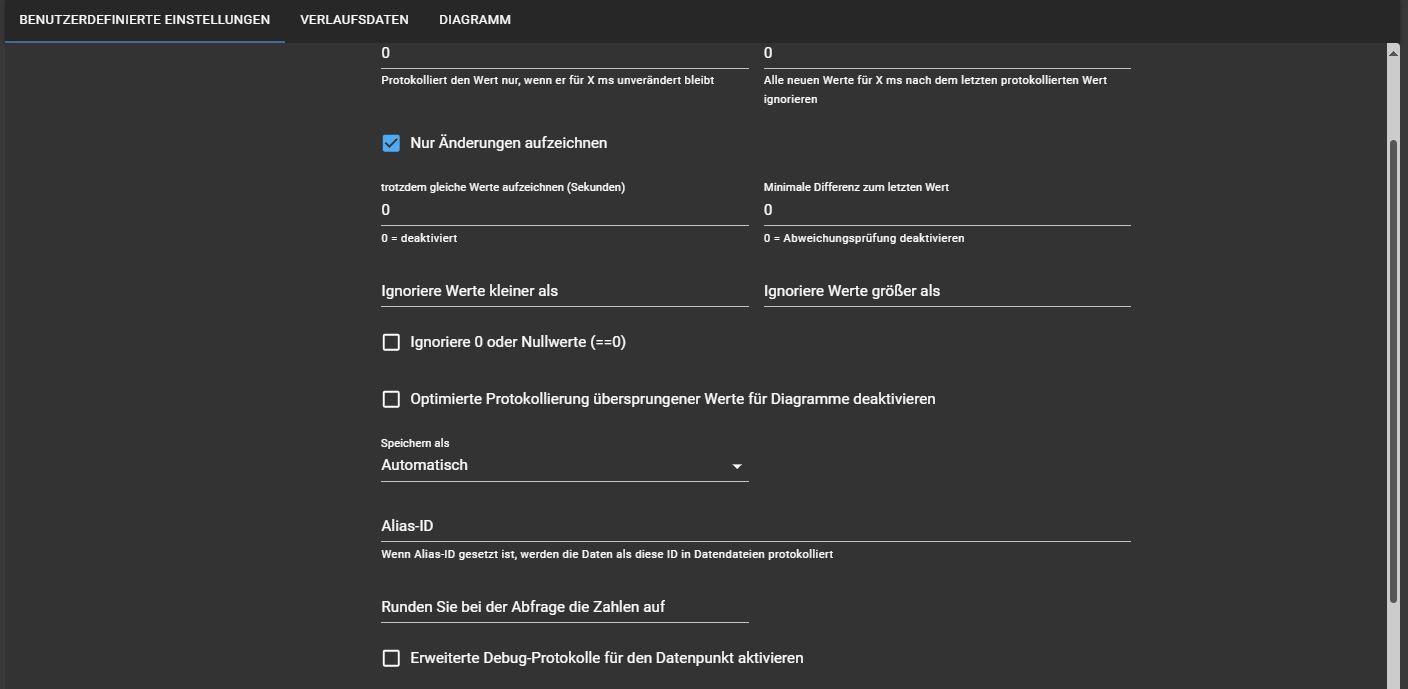

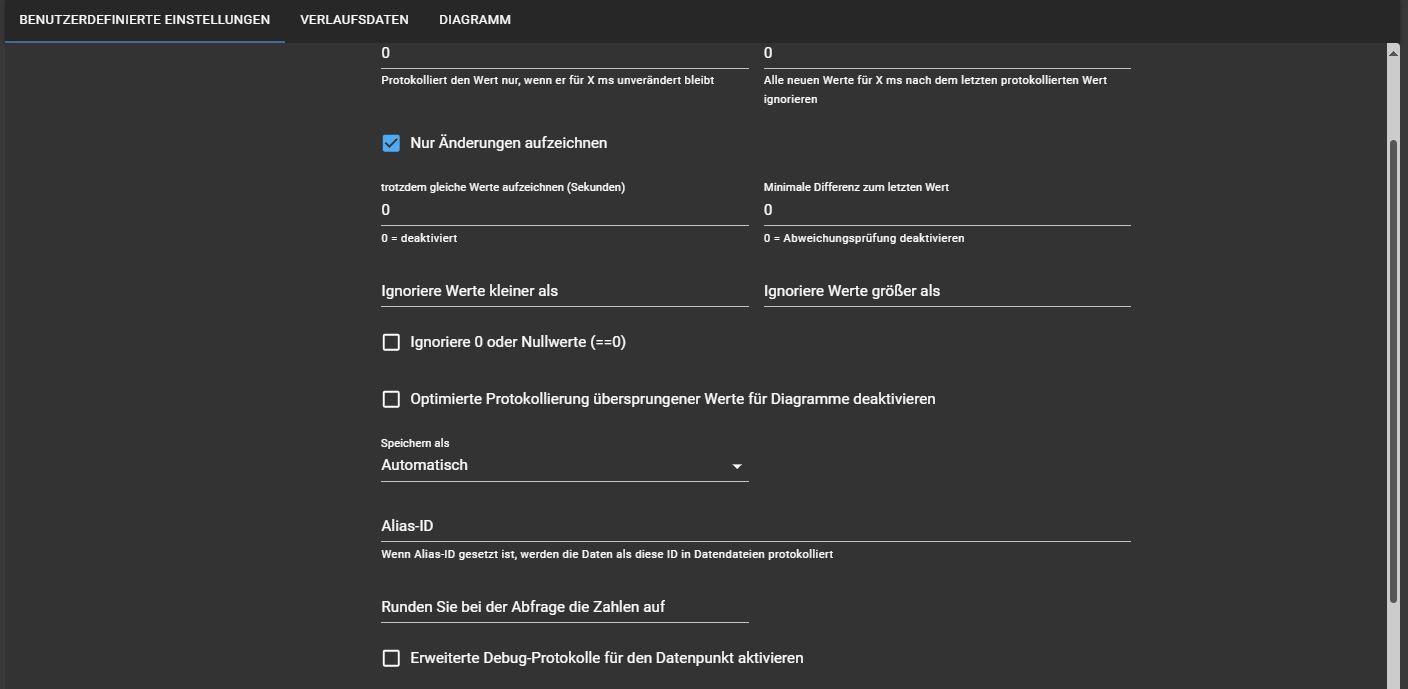

Meinst Du das hier?

Das erreichst Du über das Zahnrad neben dem DP

-

@seide-th sagte in Zeitraum Datensätze:

eine Befehlszeile in der ich bei den Objektdaten, die Länge der Speicherzeit des einzelnen Datenfelds bestimmen konnte

Meinst Du das hier?

Das erreichst Du über das Zahnrad neben dem DP

@codierknecht Nein, das ist ja aus der aktuellen Version schon lange verschwunden. Ich meine eine Befahlszeile in dem Skript, von den Objektdaten. Ich hatte da mal was vor Jahren gefunden und leider wieder vergessen

-

@codierknecht Nein, das ist ja aus der aktuellen Version schon lange verschwunden. Ich meine eine Befahlszeile in dem Skript, von den Objektdaten. Ich hatte da mal was vor Jahren gefunden und leider wieder vergessen

@seide-th sagte in Zeitraum Datensätze:

das ist ja aus der aktuellen Version schon lange verschwunden

welche Version?

von welchem Adapter?Ich hab das noch

-

@seide-th sagte in Zeitraum Datensätze:

das ist ja aus der aktuellen Version schon lange verschwunden

welche Version?

von welchem Adapter?Ich hab das noch

@homoran die Hostdatei ist 7.x, Influx ist 4.0.2. Das ist ja auch nicht Adapter abhängig

Wenn man nicht das Zahnrad wählt sondern den Stift, kann man unter Objektdaten die einzelnen Zeile edetieren.

Hier gab es mal einen Befehl der die Speicherzeit defenierte, den suche ich und ob die Datenbankbereinigung noch mal getrennt angestoßen werden muss. -

@homoran die Hostdatei ist 7.x, Influx ist 4.0.2. Das ist ja auch nicht Adapter abhängig

Wenn man nicht das Zahnrad wählt sondern den Stift, kann man unter Objektdaten die einzelnen Zeile edetieren.

Hier gab es mal einen Befehl der die Speicherzeit defenierte, den suche ich und ob die Datenbankbereinigung noch mal getrennt angestoßen werden muss.@seide-th ich verstehe jetzt überhaupt nichts mehr

wovon redest du?@Codierknecht hat dir einen aktuellen Screenshot eingestellt

Das ist bei mir genausoda kannst du die Vorhaltezeit nach wie vor einstellen.

@seide-th sagte in Zeitraum Datensätze:

das ist ja aus der aktuellen Version schon lange verschwunden

kann ich nicht bestätigen

und warum willst du in den Objektdaten manipulieren?

Das ist nicht ohne Grund nur im Expertenmodus sichtbar -

@seide-th sagte in Zeitraum Datensätze:

die Hostdatei ist 7.x

??

welche Hostdatei?@seide-th sagte in Zeitraum Datensätze:

Influx ist 4.0.2.

gut, ich nutze history, das sollte aber auch beim influx Adapter nicht anders sein.

@seide-th sagte in Zeitraum Datensätze:

Hier gab es mal einen Befehl der die Speicherzeit defenierte,

Hier sind nur Konfigurationseinträge in diesem JSON.

Keine Befehle!oder redest du von der InfluxDB selbst, und nicht vom Adapter?

-

Sorry, jetzt bin ich bei den AWs verwirrt.

Ich habe den Punkt nicht, bei dem ich die Vorhaltezeit einstellen kann Der war vor längerer Zeit nach einem Update weg. Wenn der nur ausgeblendet ist, ok. Wie ich es hinbekomme, dass einzelene Datensätze unterschiedlich lange Vorhaltezeiten haben, ist mir egal.

Der war vor längerer Zeit nach einem Update weg. Wenn der nur ausgeblendet ist, ok. Wie ich es hinbekomme, dass einzelene Datensätze unterschiedlich lange Vorhaltezeiten haben, ist mir egal.Das ist bei allen Datensätze so, egal von welchem Adapter die Daten stammen.

Deswegen bin ich auf die Objektdaten gekommen, sorry wenn ich da auf dem falschen Weg war und für Verwirrung sorge

-

Sorry, jetzt bin ich bei den AWs verwirrt.

Ich habe den Punkt nicht, bei dem ich die Vorhaltezeit einstellen kann Der war vor längerer Zeit nach einem Update weg. Wenn der nur ausgeblendet ist, ok. Wie ich es hinbekomme, dass einzelene Datensätze unterschiedlich lange Vorhaltezeiten haben, ist mir egal.

Der war vor längerer Zeit nach einem Update weg. Wenn der nur ausgeblendet ist, ok. Wie ich es hinbekomme, dass einzelene Datensätze unterschiedlich lange Vorhaltezeiten haben, ist mir egal.Das ist bei allen Datensätze so, egal von welchem Adapter die Daten stammen.

Deswegen bin ich auf die Objektdaten gekommen, sorry wenn ich da auf dem falschen Weg war und für Verwirrung sorge

@seide-th sagte in Zeitraum Datensätze:

egal von welchem Adapter die Daten stammen.

das ist jetzt wieder eine andere Info!

ich dachte du redest bei

@seide-th sagte in Zeitraum Datensätze:

Das ist ja auch nicht Adapter abhängig

von den verschiedenen Historisierungsadaptern (history, influx, sql)

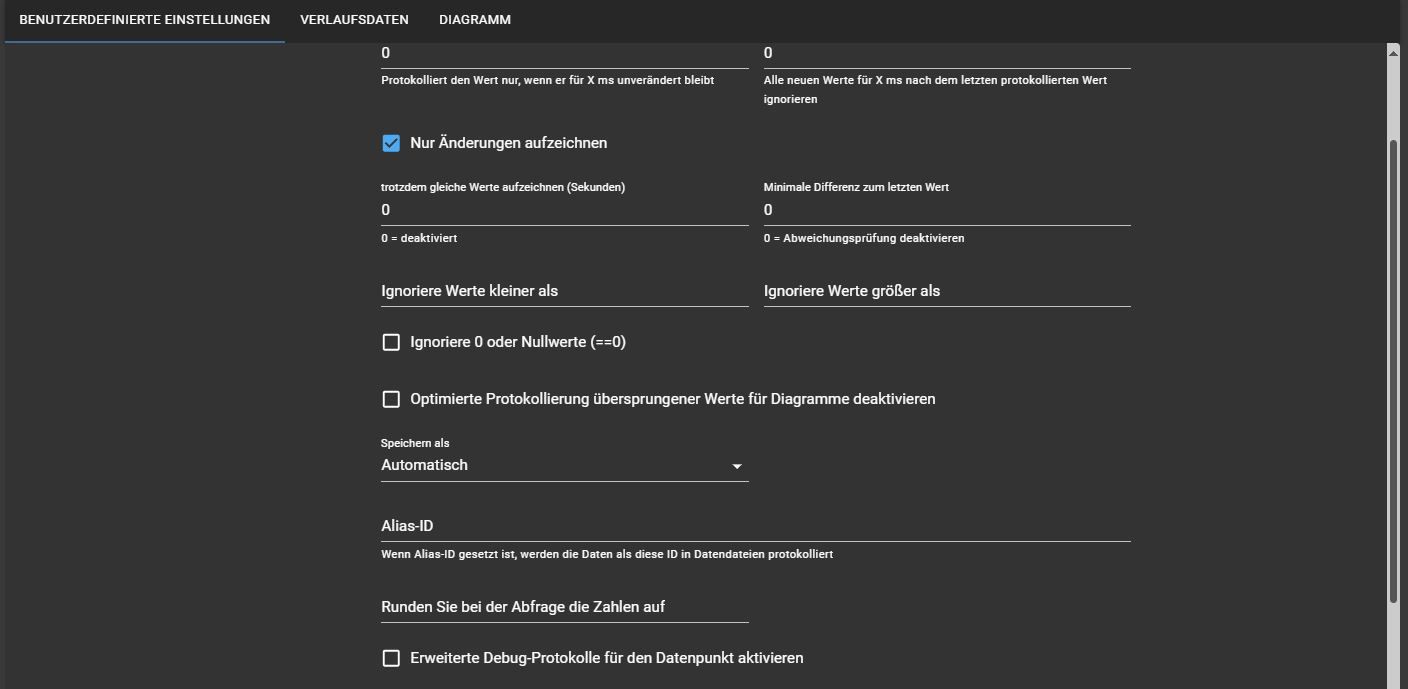

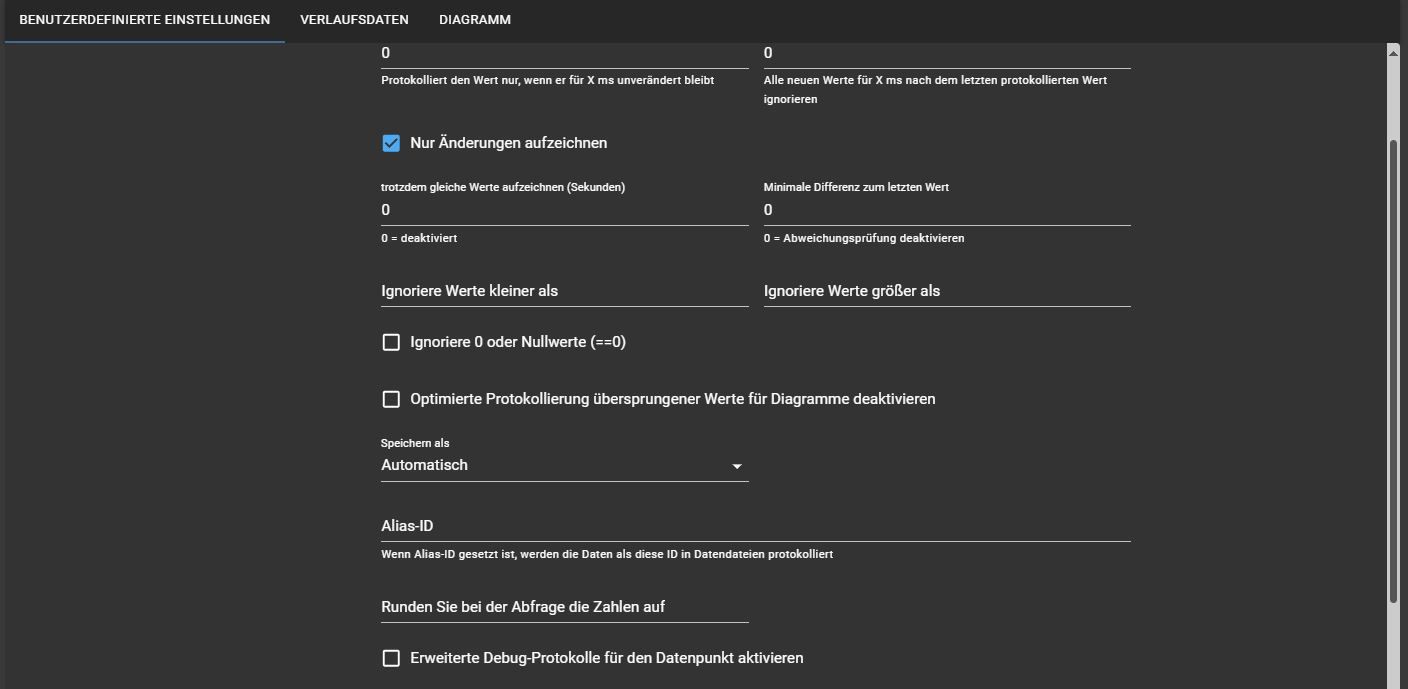

Zumindest redeten wir in dem Zusammenhang davon.bei mir ist es beim history Adapter noch da

und in den Objektdaten ist es bei dir auch.

Da ich aber influxdb nicht nutze kann ich dir nicht sagen was du ggf. zerschiesst, wenn du das änderst, obwohl es in dem User-Interface nicht vorhanden ist

-

Sorry, jetzt bin ich bei den AWs verwirrt.

Ich habe den Punkt nicht, bei dem ich die Vorhaltezeit einstellen kann Der war vor längerer Zeit nach einem Update weg. Wenn der nur ausgeblendet ist, ok. Wie ich es hinbekomme, dass einzelene Datensätze unterschiedlich lange Vorhaltezeiten haben, ist mir egal.

Der war vor längerer Zeit nach einem Update weg. Wenn der nur ausgeblendet ist, ok. Wie ich es hinbekomme, dass einzelene Datensätze unterschiedlich lange Vorhaltezeiten haben, ist mir egal.Das ist bei allen Datensätze so, egal von welchem Adapter die Daten stammen.

Deswegen bin ich auf die Objektdaten gekommen, sorry wenn ich da auf dem falschen Weg war und für Verwirrung sorge

@seide-th sagte in Zeitraum Datensätze:

Wie ich es hinbekomme, dass einzelene Datensätze unterschiedlich lange Vorhaltezeiten haben, ist mir egal.

Es gibt bei der InfluxDB keine Möglichkeit, die Vorhaltezeit auf "Datensatz"ebene einzustellen. Deshalb ist die Option ja auch rausgeflogen.

Stattdessen musst du mehrere Datenbanken/Buckets anlegen.

-

@seide-th sagte in Zeitraum Datensätze:

Wie ich es hinbekomme, dass einzelene Datensätze unterschiedlich lange Vorhaltezeiten haben, ist mir egal.

Es gibt bei der InfluxDB keine Möglichkeit, die Vorhaltezeit auf "Datensatz"ebene einzustellen. Deshalb ist die Option ja auch rausgeflogen.

Stattdessen musst du mehrere Datenbanken/Buckets anlegen.

@marc-berg Schade, aber danke für die AW. Dann muss ich ja nicht weiter suchen.

Da die Datenbanksicherung der InfluxDB bei mir inzwischen 17Gb ist...., kann ich denn die Datensätze die nicht solange vorgehalten werden sollen einzeln Löschen, ohne dass ich das Datenfeld unter Objekte komplett löschen muss?

Und wenn ich es dann richtig verstehe, würde ich eine oder zwei weitere Datenbanken (influxDB) anlegen und da dann die zeitlich begrenzten Datensätze aufzeichnen. Die Vorhaltezeit gebe ich dann in den „Instanzen“ und dann unter „Standardeinstellungen“ vor. Die Löschung erfolgt dann automatisch ohne dass ich noch was anstoßen muss.

Danke für die Hilfe

Mit freundlichen Grüßen -

@marc-berg Schade, aber danke für die AW. Dann muss ich ja nicht weiter suchen.

Da die Datenbanksicherung der InfluxDB bei mir inzwischen 17Gb ist...., kann ich denn die Datensätze die nicht solange vorgehalten werden sollen einzeln Löschen, ohne dass ich das Datenfeld unter Objekte komplett löschen muss?

Und wenn ich es dann richtig verstehe, würde ich eine oder zwei weitere Datenbanken (influxDB) anlegen und da dann die zeitlich begrenzten Datensätze aufzeichnen. Die Vorhaltezeit gebe ich dann in den „Instanzen“ und dann unter „Standardeinstellungen“ vor. Die Löschung erfolgt dann automatisch ohne dass ich noch was anstoßen muss.

Danke für die Hilfe

Mit freundlichen Grüßen@seide-th sagte in Zeitraum Datensätze:

Da die Datenbanksicherung der InfluxDB bei mir inzwischen 17Gb ist....,

Bei der Größe stelle ich mal die Behauptung in den Raum, dass du schon bei der Aufzeichnung deutlich optimieren könntest.

kann ich denn die Datensätze die nicht solange vorgehalten werden sollen einzeln Löschen, ohne dass ich das Datenfeld unter Objekte komplett löschen muss?

Ja. Wie das geht, hängt von der Version der InfluxDB ab, die du noch nicht verraten hast.

Und wenn ich es dann richtig verstehe, würde ich eine oder zwei weitere Datenbanken (influxDB) anlegen und da dann die zeitlich begrenzten Datensätze aufzeichnen. Die Vorhaltezeit gebe ich dann in den „Instanzen“ und dann unter „Standardeinstellungen“ vor. Die Löschung erfolgt dann automatisch ohne dass ich noch was anstoßen muss.

Korrekt, ja.

-

@seide-th sagte in Zeitraum Datensätze:

Da die Datenbanksicherung der InfluxDB bei mir inzwischen 17Gb ist....,

Bei der Größe stelle ich mal die Behauptung in den Raum, dass du schon bei der Aufzeichnung deutlich optimieren könntest.

kann ich denn die Datensätze die nicht solange vorgehalten werden sollen einzeln Löschen, ohne dass ich das Datenfeld unter Objekte komplett löschen muss?

Ja. Wie das geht, hängt von der Version der InfluxDB ab, die du noch nicht verraten hast.

Und wenn ich es dann richtig verstehe, würde ich eine oder zwei weitere Datenbanken (influxDB) anlegen und da dann die zeitlich begrenzten Datensätze aufzeichnen. Die Vorhaltezeit gebe ich dann in den „Instanzen“ und dann unter „Standardeinstellungen“ vor. Die Löschung erfolgt dann automatisch ohne dass ich noch was anstoßen muss.

Korrekt, ja.

@marc-berg Super die AW hilft mir dann weiter.

Zum Punkt Datensätze löschen ohne das Objekt zu löschen:

Ich habe noch die DB Version 1.x eingestellt und der Adapter hat die Version 4.0.2Da ich nur geringe Kenntnisse habe, wollte ich nicht auf DB Version 2 oder 3 umsteigen. Da soll ja die Auswertung in Grafana komplizierter sein.

Ich hatte 2019 damit angefangen und mir am Anfang keine Gedaken gemacht wie sich es über die Jahre entwickelt. Naja die vergangenheit holt einen ein....

VG

-

@marc-berg Super die AW hilft mir dann weiter.

Zum Punkt Datensätze löschen ohne das Objekt zu löschen:

Ich habe noch die DB Version 1.x eingestellt und der Adapter hat die Version 4.0.2Da ich nur geringe Kenntnisse habe, wollte ich nicht auf DB Version 2 oder 3 umsteigen. Da soll ja die Auswertung in Grafana komplizierter sein.

Ich hatte 2019 damit angefangen und mir am Anfang keine Gedaken gemacht wie sich es über die Jahre entwickelt. Naja die vergangenheit holt einen ein....

VG

@seide-th sagte in Zeitraum Datensätze:

Zum Punkt Datensätze löschen ohne das Objekt zu löschen:

Ich habe noch die DB Version 1.x eingestellt und der Adapter hat die Version 4.0.2Das Löschen alter Datensätze ist recht simpel.

- Per CLI auf die Datenbank verbinden:

influx - Datenbank auswählen:

USE <datenbankname> - Daten älter als ... löschen (in UTC):

DELETE FROM "<measurement>" WHERE time < '2024-12-31T23:00:00Z'Das muss dann pro Measurement gemacht werden.

- Per CLI auf die Datenbank verbinden:

-

@seide-th sagte in Zeitraum Datensätze:

Da die Datenbanksicherung der InfluxDB bei mir inzwischen 17Gb ist....,

Bei der Größe stelle ich mal die Behauptung in den Raum, dass du schon bei der Aufzeichnung deutlich optimieren könntest.

kann ich denn die Datensätze die nicht solange vorgehalten werden sollen einzeln Löschen, ohne dass ich das Datenfeld unter Objekte komplett löschen muss?

Ja. Wie das geht, hängt von der Version der InfluxDB ab, die du noch nicht verraten hast.

Und wenn ich es dann richtig verstehe, würde ich eine oder zwei weitere Datenbanken (influxDB) anlegen und da dann die zeitlich begrenzten Datensätze aufzeichnen. Die Vorhaltezeit gebe ich dann in den „Instanzen“ und dann unter „Standardeinstellungen“ vor. Die Löschung erfolgt dann automatisch ohne dass ich noch was anstoßen muss.

Korrekt, ja.

@marc-berg sagte in Zeitraum Datensätze:

@seide-th sagte in Zeitraum Datensätze:

Da die Datenbanksicherung der InfluxDB bei mir inzwischen 17Gb ist....,

Bei der Größe stelle ich mal die Behauptung in den Raum, dass du schon bei der Aufzeichnung deutlich optimieren könntest.

kann ich denn die Datensätze die nicht solange vorgehalten werden sollen einzeln Löschen, ohne dass ich das Datenfeld unter Objekte komplett löschen muss?

Ja. Wie das geht, hängt von der Version der InfluxDB ab, die du noch nicht verraten hast.

Und wenn ich es dann richtig verstehe, würde ich eine oder zwei weitere Datenbanken (influxDB) anlegen und da dann die zeitlich begrenzten Datensätze aufzeichnen. Die Vorhaltezeit gebe ich dann in den „Instanzen“ und dann unter „Standardeinstellungen“ vor. Die Löschung erfolgt dann automatisch ohne dass ich noch was anstoßen muss.

Korrekt, ja.

Ein oder mehrere Langzeit-Buckets für die Influx-DB habe ich auch noch auf der to-Do Liste.

Da will ich den Ansatz wählen, die Daten auszudünnen, und influx-intern vom Jahres Bucket zu den Langzeit Bucket(s) zu transferieren ...

Bei Energiewerten vielleicht nur Tagesverbräuche und keine Stundenwerte.

Manche Datenreihen vielleicht gar nicht in das Langzeitbucket übertragen...Derzeit habe ich das aber leider noch nicht gemacht, und z. B. der Gasverbrauch kann nur ein Jahr in die Vergangenheit bestimmt werden. Alles was älter ist wird "weggefressen"

-

@seide-th sagte in Zeitraum Datensätze:

Zum Punkt Datensätze löschen ohne das Objekt zu löschen:

Ich habe noch die DB Version 1.x eingestellt und der Adapter hat die Version 4.0.2Das Löschen alter Datensätze ist recht simpel.

- Per CLI auf die Datenbank verbinden:

influx - Datenbank auswählen:

USE <datenbankname> - Daten älter als ... löschen (in UTC):

DELETE FROM "<measurement>" WHERE time < '2024-12-31T23:00:00Z'Das muss dann pro Measurement gemacht werden.

@marc-berg Moin

ich muss leider noch mal nachfragen. Ich bekomme immer folgende Rückmeldung, nachden ich in der CLI von influx die Datenbank mitUSE <iobroker>aufgefrufen habe.

ERR: unable to parse authentication credentials DB does not exist!Ich habe es auch mit der Eingabe

SHOW DATABASESversucht, um zu vermeiden das ich den falschen Namen verwendet habe. Leider kommt dann folgende Meldung.

- Per CLI auf die Datenbank verbinden:

-

@marc-berg Moin

ich muss leider noch mal nachfragen. Ich bekomme immer folgende Rückmeldung, nachden ich in der CLI von influx die Datenbank mitUSE <iobroker>aufgefrufen habe.

ERR: unable to parse authentication credentials DB does not exist!Ich habe es auch mit der Eingabe

SHOW DATABASESversucht, um zu vermeiden das ich den falschen Namen verwendet habe. Leider kommt dann folgende Meldung.

@seide-th sagte in Zeitraum Datensätze:

@marc-berg Moin

ich muss leider noch mal nachfragen. Ich bekomme immer folgende Rückmeldung, nachden ich in der CLI von influx die Datenbank mitUSE <iobroker>Die eckigen Klammern (größer als/kleiner als) dienen als Platzhalter und müssen weggelassen werden.