NEWS

Speicherbelegung Proxmox

-

@dp20eic

Danke für die Rückmeldung. Ich habe in der Tat eine alte Version Virtual Environment 6.4-6.

Ich schaue direkt im Proxmox. Ich habe Debian und VMs installiert.

Das Problem ist, das ich kein Update machen kann weil der freie Speicher zu gering ist. Die VM Platte für ioBroker hat 32GB. Irgendwas belegt da unnötig Speicher

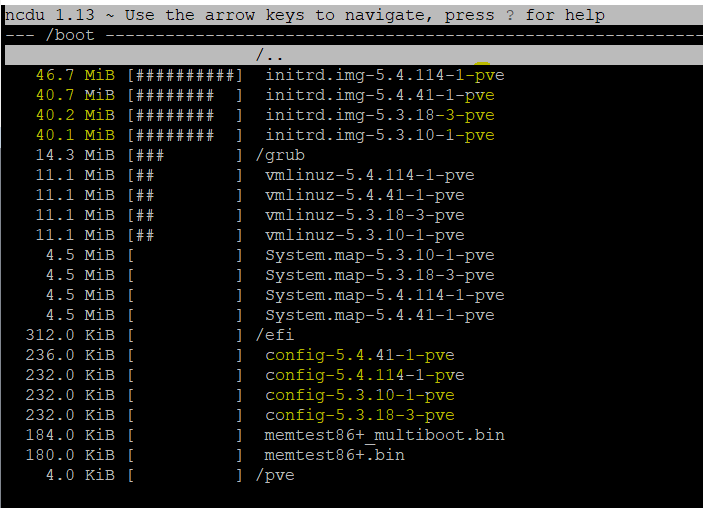

Nun habe ich mal ein bischen gegooglet und habe mal ein Image deinstalliert, aber nicht mehr freier Speicher bekommen. Das mir der garbage Bereinigung bekomme ich nicht hin.root@proxmox:~# dpkg -l |grep pve-kernel ii pve-firmware 3.2-3 all Binary firmware code for the pve-kernel ii pve-kernel-5.3 6.1-6 all Latest Proxmox VE Kernel Image ii pve-kernel-5.3.10-1-pve 5.3.10-1 amd64 The Proxmox PVE Kernel Image ii pve-kernel-5.3.18-3-pve 5.3.18-3 amd64 The Proxmox PVE Kernel Image ii pve-kernel-5.4 6.4-2 all Latest Proxmox VE Kernel Image ii pve-kernel-5.4.114-1-pve 5.4.114-1 amd64 The Proxmox PVE Kernel Image ii pve-kernel-5.4.41-1-pve 5.4.41-1 amd64 The Proxmox PVE Kernel Image ii pve-kernel-helper 6.4-2 all Function for various kernel maintenance tasks. root@proxmox:~# apt purge pve-kernel-5.3.10-1-pveMoin,

also wenn Du in der Konsole vom PVE bist, dann

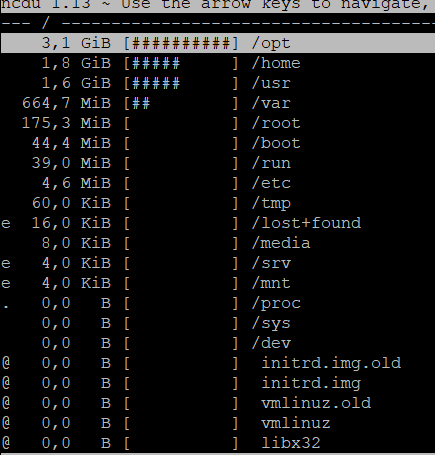

root@pve:~# ncdu / root@pve:~#Dann sollte sowas wie bei mir oben zu sehen sein, vielleicht nicht

/ct_data -- /mnt -- /vm_data, das sind zusätzliche SSDs, auf denen die RootFS meiner LXC Container liegen, ich nutze keine VMs.VG

Bernd -

@dp20eic

Danke für die Rückmeldung. Ich habe in der Tat eine alte Version Virtual Environment 6.4-6.

Ich schaue direkt im Proxmox. Ich habe Debian und VMs installiert.

Das Problem ist, das ich kein Update machen kann weil der freie Speicher zu gering ist. Die VM Platte für ioBroker hat 32GB. Irgendwas belegt da unnötig Speicher

Nun habe ich mal ein bischen gegooglet und habe mal ein Image deinstalliert, aber nicht mehr freier Speicher bekommen. Das mir der garbage Bereinigung bekomme ich nicht hin.root@proxmox:~# dpkg -l |grep pve-kernel ii pve-firmware 3.2-3 all Binary firmware code for the pve-kernel ii pve-kernel-5.3 6.1-6 all Latest Proxmox VE Kernel Image ii pve-kernel-5.3.10-1-pve 5.3.10-1 amd64 The Proxmox PVE Kernel Image ii pve-kernel-5.3.18-3-pve 5.3.18-3 amd64 The Proxmox PVE Kernel Image ii pve-kernel-5.4 6.4-2 all Latest Proxmox VE Kernel Image ii pve-kernel-5.4.114-1-pve 5.4.114-1 amd64 The Proxmox PVE Kernel Image ii pve-kernel-5.4.41-1-pve 5.4.41-1 amd64 The Proxmox PVE Kernel Image ii pve-kernel-helper 6.4-2 all Function for various kernel maintenance tasks. root@proxmox:~# apt purge pve-kernel-5.3.10-1-pve@toki1973 sagte in Speicherbelegung Proxmox:

Nun habe ich mal ein bischen gegooglet und habe mal ein Image deinstalliert, aber nicht mehr freier Speicher bekommen. Das mir der garbage Bereinigung bekomme ich nicht hin.

Moin,

wie ich schon oben sagte, ist das nur Kleinvieh!

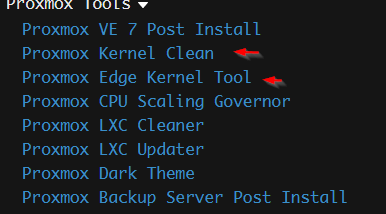

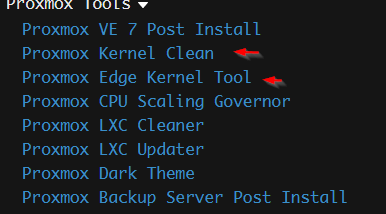

Ich möchte dich nicht verleiten etwas zu tun, es gibt aber ein gutes Skript, welches dir beim Aufräumen hilft.

Schau dir das mal bei Github - PVEKCLEAN an und entscheide selbst, ob du dir das zutraust.VG

Bernd -

@toki1973 sagte in Speicherbelegung Proxmox:

Nun habe ich mal ein bischen gegooglet und habe mal ein Image deinstalliert, aber nicht mehr freier Speicher bekommen. Das mir der garbage Bereinigung bekomme ich nicht hin.

Moin,

wie ich schon oben sagte, ist das nur Kleinvieh!

Ich möchte dich nicht verleiten etwas zu tun, es gibt aber ein gutes Skript, welches dir beim Aufräumen hilft.

Schau dir das mal bei Github - PVEKCLEAN an und entscheide selbst, ob du dir das zutraust.VG

Bernd@dp20eic oder

https://tteck.github.io/Proxmox/

ein

apt autoremovewürde ja erstmal schon reichen um überflüssiges zu beseitigenwenn allerdings ne 32GB VM voll ist, liegt wohl eher in

/opt/iobrokerder Hund begraben@toki1973 schau mal mit

du -sh /opt/iobroker -

@dp20eic oder

https://tteck.github.io/Proxmox/

ein

apt autoremovewürde ja erstmal schon reichen um überflüssiges zu beseitigenwenn allerdings ne 32GB VM voll ist, liegt wohl eher in

/opt/iobrokerder Hund begraben@toki1973 schau mal mit

du -sh /opt/iobrokerDanke für eure Unterstützung!

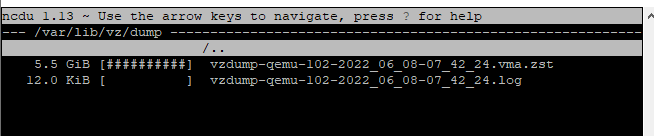

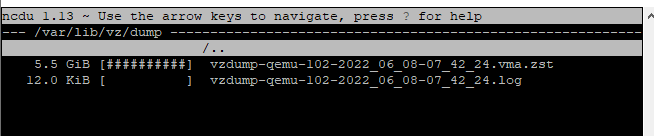

Hier im VA Verzeichnis liegt das monatliche Backup mit 5GB. Das ist das größte in var.

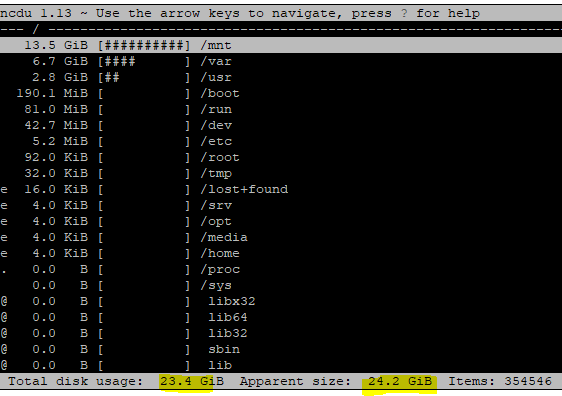

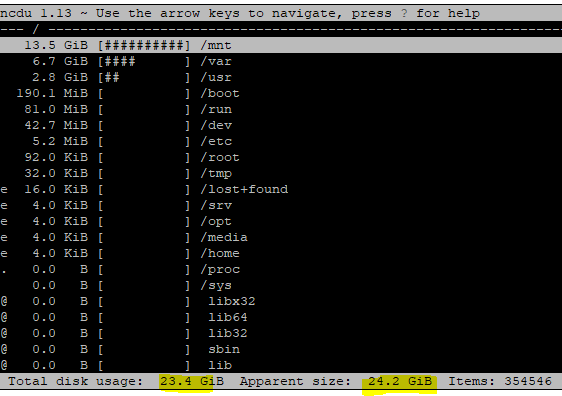

Da ist die volle Proxmox Disk:

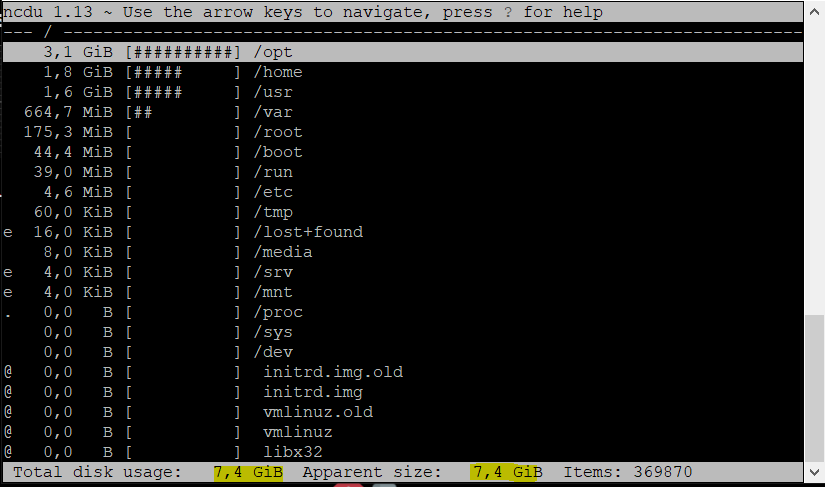

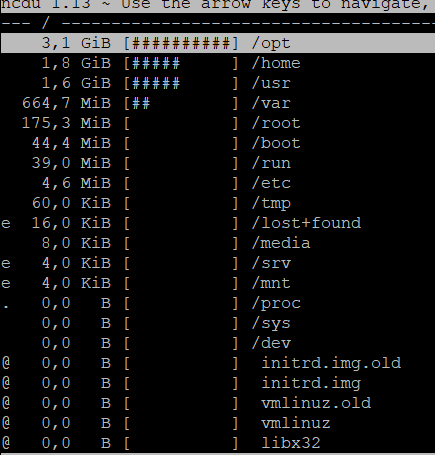

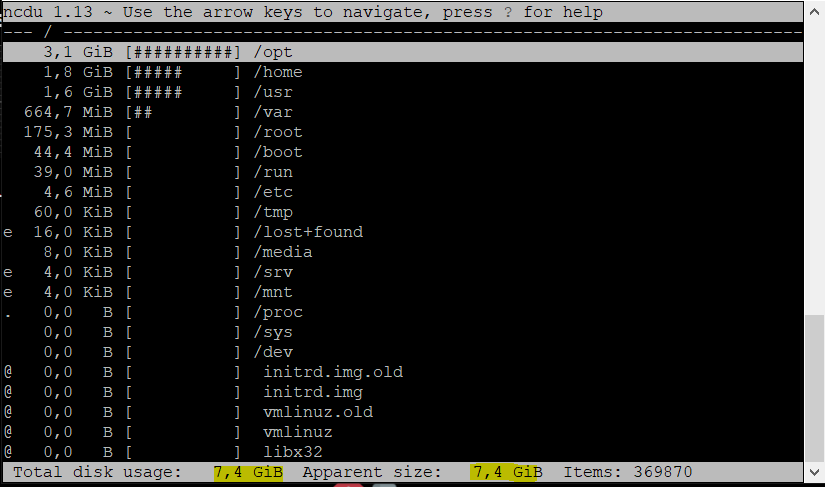

Das hier ist die ioBroker VM:

root@iobrokerNUC1:~# du -sh /opt/iobroker 3,2G /opt/iobrokerHier der knappe iobroker Speicher

-

@dp20eic oder

https://tteck.github.io/Proxmox/

ein

apt autoremovewürde ja erstmal schon reichen um überflüssiges zu beseitigenwenn allerdings ne 32GB VM voll ist, liegt wohl eher in

/opt/iobrokerder Hund begraben@toki1973 schau mal mit

du -sh /opt/iobroker -

Danke für eure Unterstützung!

Hier im VA Verzeichnis liegt das monatliche Backup mit 5GB. Das ist das größte in var.

Da ist die volle Proxmox Disk:

Das hier ist die ioBroker VM:

root@iobrokerNUC1:~# du -sh /opt/iobroker 3,2G /opt/iobrokerHier der knappe iobroker Speicher

Moin,

sorry ich bin verwirrt und verstehe Dich nicht :(

Wo genau befindest Du Dich?

Reden wir jetzt von einer VM / LXC Container, der voll ist oder davon, dass Dir der gesamte

proxmoxServer aus allen Nähten platzt?Was ist denn in

/mnt?Mach doch mal ein

df -himPVEund/oder in der VM/LXC Container.VG

Bernd -

Moin,

sorry ich bin verwirrt und verstehe Dich nicht :(

Wo genau befindest Du Dich?

Reden wir jetzt von einer VM / LXC Container, der voll ist oder davon, dass Dir der gesamte

proxmoxServer aus allen Nähten platzt?Was ist denn in

/mnt?Mach doch mal ein

df -himPVEund/oder in der VM/LXC Container.VG

Bernd@dp20eic said in Speicherbelegung Proxmox:

df -h

Beide Disk sind am Anschlag

Das hier ist von Proxmox:

root@proxmox:~# /mnt -bash: /mnt: Is a directory root@proxmox:~# df -h Filesystem Size Used Avail Use% Mounted on udev 3.7G 0 3.7G 0% /dev tmpfs 755M 82M 674M 11% /run /dev/mapper/pve-root 59G 9.9G 46G 18% / tmpfs 3.7G 43M 3.7G 2% /dev/shm tmpfs 5.0M 0 5.0M 0% /run/lock tmpfs 3.7G 0 3.7G 0% /sys/fs/cgroup /dev/sda2 511M 312K 511M 1% /boot/efi /dev/fuse 30M 24K 30M 1% /etc/pve 192.168.0.100:/volume1/NetBackup 3.6T 3.6T 9.1G 100% /mnt/pve/NAS tmpfs 755M 0 755M 0% /run/user/0 root@proxmox:~#Und das hier im ioBroker VM:

root@iobrokerNUC1:~# /mnt -bash: /mnt: Ist ein Verzeichnis root@iobrokerNUC1:~# df -h Dateisystem Größe Benutzt Verf. Verw% Eingehängt auf udev 1,9G 0 1,9G 0% /dev tmpfs 386M 40M 347M 11% /run /dev/sda1 31G 7,5G 22G 26% / tmpfs 1,9G 0 1,9G 0% /dev/shm tmpfs 5,0M 0 5,0M 0% /run/lock tmpfs 1,9G 0 1,9G 0% /sys/fs/cgroup tmpfs 386M 0 386M 0% /run/user/0 root@iobrokerNUC1:~# root@iobrokerNUC1:~# /mnt tmpfs 1,9G 0 1,9G 0% /dev/shm tmpfs 5,0M 0 5,0M 0% /run/lock tmpfs 1,9G 0 1,9G 0% /sys/fs/cgroup tmpfs 386M 0 386M 0% /run/user/0 root@iobrokerNUC1:~# -

@toki1973 sagte in Speicherbelegung Proxmox:

Da ist die volle Proxmox Disk:

also ist nicht deine iobroker VM voll, sondern dein Proxmox root, oder täusche ich mich da jetzt

@toki1973 sagte in Speicherbelegung Proxmox:

Kann ich dann einigermaßen gefahrlos apt autoremove auf beiden Disks ausführen

ja

-

@dp20eic said in Speicherbelegung Proxmox:

df -h

Beide Disk sind am Anschlag

Das hier ist von Proxmox:

root@proxmox:~# /mnt -bash: /mnt: Is a directory root@proxmox:~# df -h Filesystem Size Used Avail Use% Mounted on udev 3.7G 0 3.7G 0% /dev tmpfs 755M 82M 674M 11% /run /dev/mapper/pve-root 59G 9.9G 46G 18% / tmpfs 3.7G 43M 3.7G 2% /dev/shm tmpfs 5.0M 0 5.0M 0% /run/lock tmpfs 3.7G 0 3.7G 0% /sys/fs/cgroup /dev/sda2 511M 312K 511M 1% /boot/efi /dev/fuse 30M 24K 30M 1% /etc/pve 192.168.0.100:/volume1/NetBackup 3.6T 3.6T 9.1G 100% /mnt/pve/NAS tmpfs 755M 0 755M 0% /run/user/0 root@proxmox:~#Und das hier im ioBroker VM:

root@iobrokerNUC1:~# /mnt -bash: /mnt: Ist ein Verzeichnis root@iobrokerNUC1:~# df -h Dateisystem Größe Benutzt Verf. Verw% Eingehängt auf udev 1,9G 0 1,9G 0% /dev tmpfs 386M 40M 347M 11% /run /dev/sda1 31G 7,5G 22G 26% / tmpfs 1,9G 0 1,9G 0% /dev/shm tmpfs 5,0M 0 5,0M 0% /run/lock tmpfs 1,9G 0 1,9G 0% /sys/fs/cgroup tmpfs 386M 0 386M 0% /run/user/0 root@iobrokerNUC1:~# root@iobrokerNUC1:~# /mnt tmpfs 1,9G 0 1,9G 0% /dev/shm tmpfs 5,0M 0 5,0M 0% /run/lock tmpfs 1,9G 0 1,9G 0% /sys/fs/cgroup tmpfs 386M 0 386M 0% /run/user/0 root@iobrokerNUC1:~#@toki1973 sagte in Speicherbelegung Proxmox:

Beide Disk sind am Anschlag

nö

@toki1973 sagte in Speicherbelegung Proxmox:

dev/mapper/pve-root 59G 9.9G 46G 18% /

nur 18% belegt, also 46GB frei

@toki1973 sagte in Speicherbelegung Proxmox:

/dev/sda1 31G 7,5G 22G 26% /

hier dein iobroker, auch nur 26% belegt

-

@toki1973 sagte in Speicherbelegung Proxmox:

Beide Disk sind am Anschlag

nö

@toki1973 sagte in Speicherbelegung Proxmox:

dev/mapper/pve-root 59G 9.9G 46G 18% /

nur 18% belegt, also 46GB frei

@toki1973 sagte in Speicherbelegung Proxmox:

/dev/sda1 31G 7,5G 22G 26% /

hier dein iobroker, auch nur 26% belegt

Das ist allerdings dicht:

192.168.0.100:/volume1/NetBackup 3.6T 3.6T 9.1G 100% /mnt/pve/NAS -

Das ist allerdings dicht:

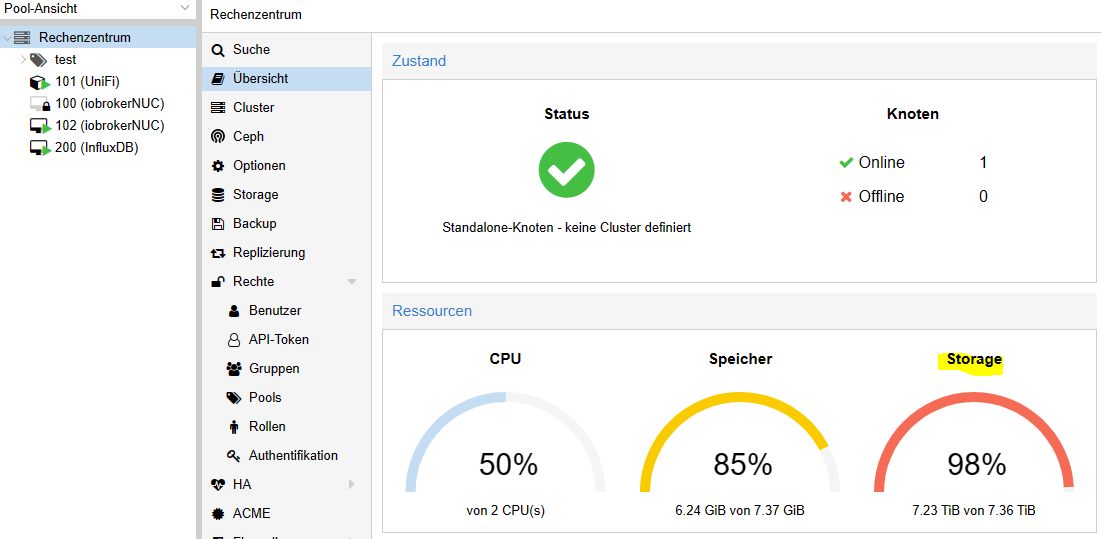

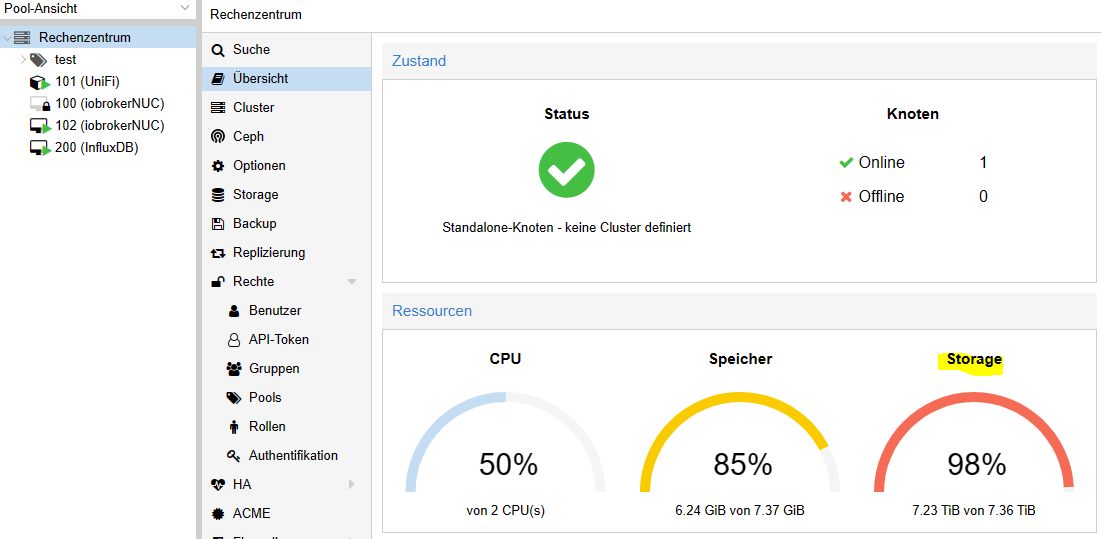

192.168.0.100:/volume1/NetBackup 3.6T 3.6T 9.1G 100% /mnt/pve/NASHm und wo kommen die 98% her?

Und beim Update von Adaptern bekomme ich ```

$ ./iobroker upgrade history

ERROR: spawn ENOMEMUnd bei starten von Instanzen ``` instance system.adapter.javascript.0 could not be started: Error: spawn ENOMEMUnd wie interpretiert man die Disk Size die ich oben über ncdu / bekommen habe?

Wo klemmt es denn? Bin verwirrt :(

-

@dp20eic said in Speicherbelegung Proxmox:

df -h

Beide Disk sind am Anschlag

Das hier ist von Proxmox:

root@proxmox:~# /mnt -bash: /mnt: Is a directory root@proxmox:~# df -h Filesystem Size Used Avail Use% Mounted on udev 3.7G 0 3.7G 0% /dev tmpfs 755M 82M 674M 11% /run /dev/mapper/pve-root 59G 9.9G 46G 18% / tmpfs 3.7G 43M 3.7G 2% /dev/shm tmpfs 5.0M 0 5.0M 0% /run/lock tmpfs 3.7G 0 3.7G 0% /sys/fs/cgroup /dev/sda2 511M 312K 511M 1% /boot/efi /dev/fuse 30M 24K 30M 1% /etc/pve 192.168.0.100:/volume1/NetBackup 3.6T 3.6T 9.1G 100% /mnt/pve/NAS tmpfs 755M 0 755M 0% /run/user/0 root@proxmox:~#Und das hier im ioBroker VM:

root@iobrokerNUC1:~# /mnt -bash: /mnt: Ist ein Verzeichnis root@iobrokerNUC1:~# df -h Dateisystem Größe Benutzt Verf. Verw% Eingehängt auf udev 1,9G 0 1,9G 0% /dev tmpfs 386M 40M 347M 11% /run /dev/sda1 31G 7,5G 22G 26% / tmpfs 1,9G 0 1,9G 0% /dev/shm tmpfs 5,0M 0 5,0M 0% /run/lock tmpfs 1,9G 0 1,9G 0% /sys/fs/cgroup tmpfs 386M 0 386M 0% /run/user/0 root@iobrokerNUC1:~# root@iobrokerNUC1:~# /mnt tmpfs 1,9G 0 1,9G 0% /dev/shm tmpfs 5,0M 0 5,0M 0% /run/lock tmpfs 1,9G 0 1,9G 0% /sys/fs/cgroup tmpfs 386M 0 386M 0% /run/user/0 root@iobrokerNUC1:~#@toki1973 sagte in Speicherbelegung Proxmox:

@dp20eic said in Speicherbelegung Proxmox:

df -h

Beide Disk sind am Anschlag

Nein sind Sie nicht, wurde ja auch schon von anderen bestätigt.

Erst einmal, es gibt kein Befehl

/mnt, um in ein Verzeichnis zu wechseln, musst Ducd /mnt cd /usr/bin cd /opt/iobrokerDann ist dieses Verzeichnis ein Mount, von Deinem NAS.

192.168.0.100:/volume1/NetBackup 3.6T 3.6T 9.1G 100% /mnt/pve/NASDu hast sicher lich den Mount auch in der VM und legst dort irgendetwas ab. Was sagt den wenn Du in der PVE Konsole bist,

root@proxmox:~# ls -la /mnt/VG

Bernd -

@toki1973 sagte in Speicherbelegung Proxmox:

@dp20eic said in Speicherbelegung Proxmox:

df -h

Beide Disk sind am Anschlag

Nein sind Sie nicht, wurde ja auch schon von anderen bestätigt.

Erst einmal, es gibt kein Befehl

/mnt, um in ein Verzeichnis zu wechseln, musst Ducd /mnt cd /usr/bin cd /opt/iobrokerDann ist dieses Verzeichnis ein Mount, von Deinem NAS.

192.168.0.100:/volume1/NetBackup 3.6T 3.6T 9.1G 100% /mnt/pve/NASDu hast sicher lich den Mount auch in der VM und legst dort irgendetwas ab. Was sagt den wenn Du in der PVE Konsole bist,

root@proxmox:~# ls -la /mnt/VG

Bernd@dp20eic Danke für die Geduld!

Ja die NAS ist am Anschlag. Aber warum bekomme ich denn den ENOMEM Fehler? Und warum wir in der Proxmox Oberfläche 98% Speicher angezeigt?

Übrigens hat apt autoremove hat nichts entfernt.

root@proxmox:~# ls -la /mnt/ total 20 drwxr-xr-x 5 root root 4096 Jun 20 2020 . drwxr-xr-x 18 root root 4096 Mar 14 2020 .. drwxr-xr-x 2 root root 4096 Mar 14 2020 hostrun drwxr-xr-x 4 root root 4096 Jul 30 2020 pve drwxr-xr-x 2 root root 4096 Jun 20 2020 vzsnap0 root@proxmox:~# -

Hm und wo kommen die 98% her?

Und beim Update von Adaptern bekomme ich ```

$ ./iobroker upgrade history

ERROR: spawn ENOMEMUnd bei starten von Instanzen ``` instance system.adapter.javascript.0 could not be started: Error: spawn ENOMEMUnd wie interpretiert man die Disk Size die ich oben über ncdu / bekommen habe?

Wo klemmt es denn? Bin verwirrt :(

@toki1973

Da muss mMn noch was faul sein.

Dein Screenshot zeigt 7,2 T und dasdf -hauf dem Server zeigt in Summe weniger an.

Außerdem ist laut df -t dein NAS voll. Was zeigt das NAS auf dem NAS selber an? -

@toki1973

Da muss mMn noch was faul sein.

Dein Screenshot zeigt 7,2 T und dasdf -hauf dem Server zeigt in Summe weniger an.

Außerdem ist laut df -t dein NAS voll. Was zeigt das NAS auf dem NAS selber an?@ostfrieseunterwegs

Ja genau irgendwas ist faul. Ich weiß nur nicht wo. Gibt es noch weitere Ideen?

Das die NAS voll ist weiß ich - das macht ja bzgl. der Probleme mit ioBroker Proxmox nichts aus. -

@ostfrieseunterwegs

Ja genau irgendwas ist faul. Ich weiß nur nicht wo. Gibt es noch weitere Ideen?

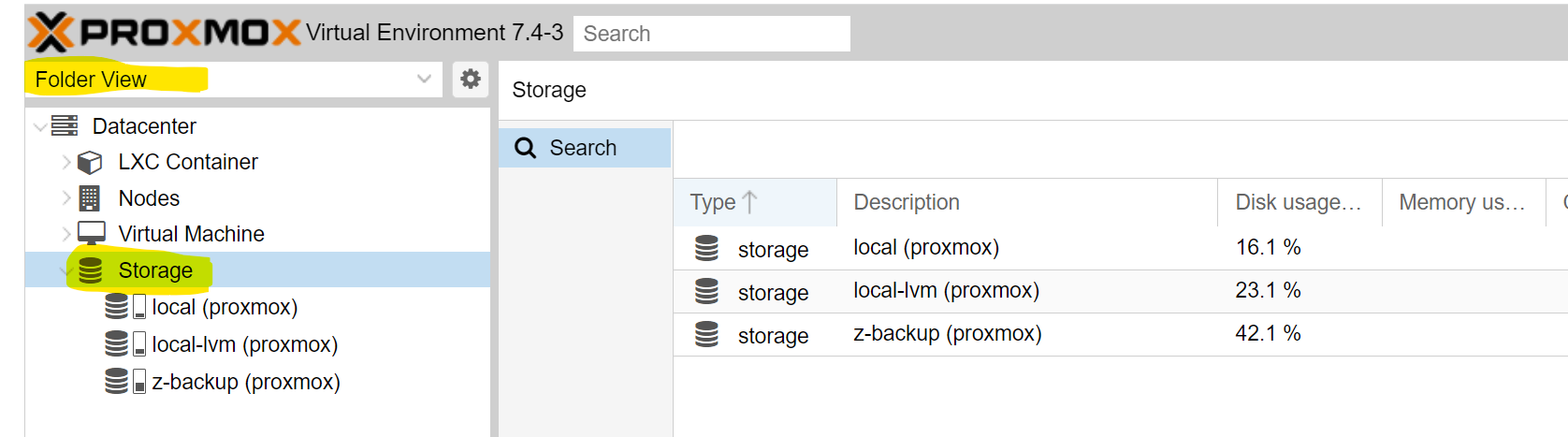

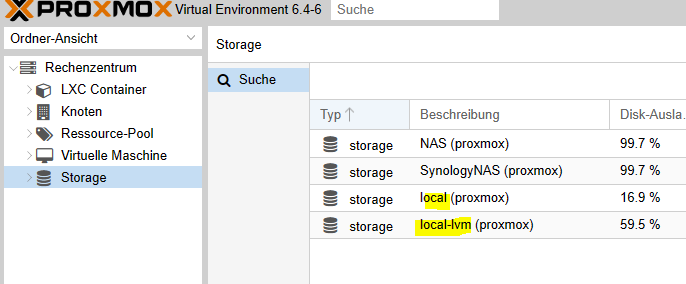

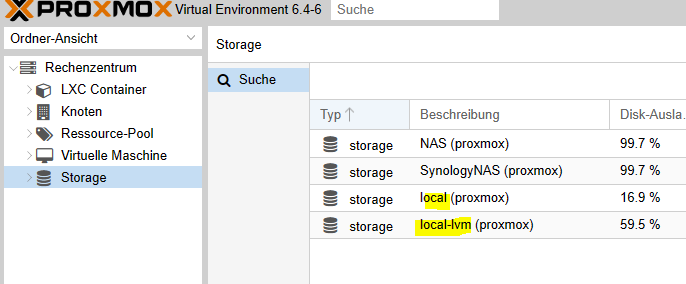

Das die NAS voll ist weiß ich - das macht ja bzgl. der Probleme mit ioBroker Proxmox nichts aus.Schau mal, was da für Storages eingebunden sind.

-

Schau mal, was da für Storages eingebunden sind.

@ostfrieseunterwegs

Hm okay dann sieht es lokal ja eigentlich ganz gut aus und nur die NAS ist voll. Erklärt aber immer noch nicht das ioBroke ENOMEM Problem

-

@ostfrieseunterwegs

Hm okay dann sieht es lokal ja eigentlich ganz gut aus und nur die NAS ist voll. Erklärt aber immer noch nicht das ioBroke ENOMEM Problem

@toki1973

Ja das volle NAS hat möglicherweise nichts mit dem ENOMEM Problem zu tun.

Aber ich dachte du suchtest eine Erklärung für die 98% ??

Auf jeden Fall scheinst Du das NAS doppelt in Proxmox eingebunden zu haben. Daher die 7.2 Tera.

Du musst dich mal durch die Menüs von Proxmox hangeln und schauen, was du auf den beiden Storage Volumes speicherst bzw wo die eingebunden sind. Irgendwelche Backups der VM/Container ? -

@dp20eic Danke für die Geduld!

Ja die NAS ist am Anschlag. Aber warum bekomme ich denn den ENOMEM Fehler? Und warum wir in der Proxmox Oberfläche 98% Speicher angezeigt?

Übrigens hat apt autoremove hat nichts entfernt.

root@proxmox:~# ls -la /mnt/ total 20 drwxr-xr-x 5 root root 4096 Jun 20 2020 . drwxr-xr-x 18 root root 4096 Mar 14 2020 .. drwxr-xr-x 2 root root 4096 Mar 14 2020 hostrun drwxr-xr-x 4 root root 4096 Jul 30 2020 pve drwxr-xr-x 2 root root 4096 Jun 20 2020 vzsnap0 root@proxmox:~#@toki1973 sagte in Speicherbelegung Proxmox:

@dp20eic Danke für die Geduld!

Ja die NAS ist am Anschlag. Aber warum bekomme ich denn den ENOMEM Fehler? Und warum wir in der Proxmox Oberfläche 98% Speicher angezeigt?

Übrigens hat apt autoremove hat nichts entfernt.

root@proxmox:~# ls -la /mnt/ total 20 drwxr-xr-x 5 root root 4096 Jun 20 2020 . drwxr-xr-x 18 root root 4096 Mar 14 2020 .. drwxr-xr-x 2 root root 4096 Mar 14 2020 hostrun drwxr-xr-x 4 root root 4096 Jul 30 2020 pve drwxr-xr-x 2 root root 4096 Jun 20 2020 vzsnap0 root@proxmox:~#Moin,

mach es Dir doch nicht so schwer! Du hast alle Befehle schon, Du musst sie nur noch richtig anwenden :)

Geh doch mal tiefer in die Verzeichnisse und schau wo, es kneift.

root@proxmox:~# ncdu /mnt ls -la /mnt/*Hör auf etwas Löschen zu wollen, wenn Du noch nicht mal weißt, was klemmt, finde doch erstmal raus was vorgeht, um dann dafür eine Lösung zu suchen.

Wie @OstfrieseUnterwegs schon fragte, liegen da Backups, Images etc. und wie er sagte, Du mountest das NAS zweimal.root@proxmox:~# mount | grep -i mntVG

Bernd -

@toki1973 sagte in Speicherbelegung Proxmox:

@dp20eic Danke für die Geduld!

Ja die NAS ist am Anschlag. Aber warum bekomme ich denn den ENOMEM Fehler? Und warum wir in der Proxmox Oberfläche 98% Speicher angezeigt?

Übrigens hat apt autoremove hat nichts entfernt.

root@proxmox:~# ls -la /mnt/ total 20 drwxr-xr-x 5 root root 4096 Jun 20 2020 . drwxr-xr-x 18 root root 4096 Mar 14 2020 .. drwxr-xr-x 2 root root 4096 Mar 14 2020 hostrun drwxr-xr-x 4 root root 4096 Jul 30 2020 pve drwxr-xr-x 2 root root 4096 Jun 20 2020 vzsnap0 root@proxmox:~#Moin,

mach es Dir doch nicht so schwer! Du hast alle Befehle schon, Du musst sie nur noch richtig anwenden :)

Geh doch mal tiefer in die Verzeichnisse und schau wo, es kneift.

root@proxmox:~# ncdu /mnt ls -la /mnt/*Hör auf etwas Löschen zu wollen, wenn Du noch nicht mal weißt, was klemmt, finde doch erstmal raus was vorgeht, um dann dafür eine Lösung zu suchen.

Wie @OstfrieseUnterwegs schon fragte, liegen da Backups, Images etc. und wie er sagte, Du mountest das NAS zweimal.root@proxmox:~# mount | grep -i mntVG

BerndJa ein Backup liegt da in der proxmox Umgebung von 5,5gb rum wie oben im screeshot gezeigt.

Okay dann schaue ich mal weches NAS mountig ich entfernen kann.Ich habe mal das RAM von 4 auf 6GB für die iobroker VM erhöht. Sieht schon besser aus....