NEWS

Test Adapter ioBroker.backitup v3.1.x

-

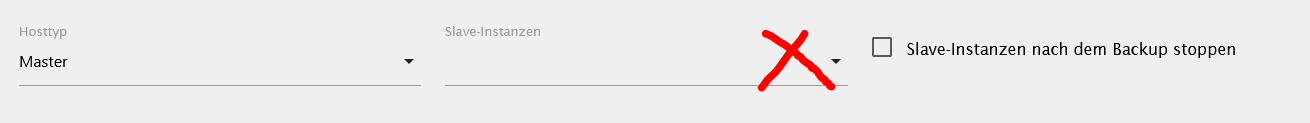

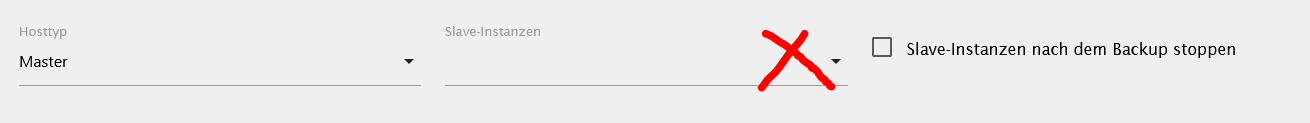

@ofbeqnpolkkl6mby5e13 Dann brauchst du ne zweite Instanz, die Du als Slave konfigurierst und die Backitup.0 als Master.

Backitup.1 als Slave und dort das Redis Backup für den zweiten Server aktivieren.

Die Instanz backitup.1 wird dann nur für das backup gestartet und im Anschluss wieder gestoppt@simatec sagte in Test Adapter Backitup v2.3.x:

@ofbeqnpolkkl6mby5e13 Dann brauchst du ne zweite Instanz, die Du als Slave konfigurierst und die Backitup.0 als Master.

Backitup.1 als Slave und dort das Redis Backup für den zweiten Server aktivieren.

Die Instanz backitup.1 wird dann nur für das backup gestartet und im Anschluss wieder gestopptDas hat einwandfrei so funktioniert. :+1:

-

@ofbeqnpolkkl6mby5e13 Muss ich mal mit ihm reden ...

Ich habe eine Synology als MASTER und einen Pi als Slave.

Hab gerade deinen Adapter installiert.

Ich kann hier bei der Eingabe keinen Slave auswählen und wenn ich speichere gibt es eine Warnmeldung im Log.

backitup.0 2022-03-03 19:56:11.965 warn (2887) undefined is not running. The slave backup for this instance is not possible -

Ich habe eine Synology als MASTER und einen Pi als Slave.

Hab gerade deinen Adapter installiert.

Ich kann hier bei der Eingabe keinen Slave auswählen und wenn ich speichere gibt es eine Warnmeldung im Log.

backitup.0 2022-03-03 19:56:11.965 warn (2887) undefined is not running. The slave backup for this instance is not possible@haselchen Hast du denn eine Instanz von Backitup auf dem Slave installiert?

-

@haselchen Hast du denn eine Instanz von Backitup auf dem Slave installiert?

Ich denke ich müsste auf die Frage wohl mit JA antworten :)

Nein, das habe ich bisher nicht gemacht.

Ich dachte , dass der Adapter aus den Tiefen des Iobroker Ordners die Infos des Slaves bezieht.Dann hole ich das nach und werde berichten......

-

Ich denke ich müsste auf die Frage wohl mit JA antworten :)

Nein, das habe ich bisher nicht gemacht.

Ich dachte , dass der Adapter aus den Tiefen des Iobroker Ordners die Infos des Slaves bezieht.Dann hole ich das nach und werde berichten......

@haselchen Naja klar kann ich Slaves in den iobroker Strukturen ermitteln, aber was macht das denn für einen Sinn, wenn keine Instanz auf dem Slave läuft 😬

-

Ich denke ich müsste auf die Frage wohl mit JA antworten :)

Nein, das habe ich bisher nicht gemacht.

Ich dachte , dass der Adapter aus den Tiefen des Iobroker Ordners die Infos des Slaves bezieht.Dann hole ich das nach und werde berichten......

@haselchen Das habe ich früher auch gedacht, aber wenn du dein logfile checkst wirst du da sehen, dass er warnings gibt weil er beim slave nix findet

-

@haselchen Das habe ich früher auch gedacht, aber wenn du dein logfile checkst wirst du da sehen, dass er warnings gibt weil er beim slave nix findet

-

@amg_666

Findet er nichts weil der Adapter dort nicht installiert ist ?

Weil ich habe dort 3 Adapter mit Instanzen installiert.@haselchen kannst deine Antwort bitte genauer erklären?

-

@amg_666

Findet er nichts weil der Adapter dort nicht installiert ist ?

Weil ich habe dort 3 Adapter mit Instanzen installiert.@haselchen du musst eine 2. Instanz vopn backituo auf dem Slave installieren. Alle Einstellungen machst du dann im "Master Backitup"

-

@haselchen du musst eine 2. Instanz vopn backituo auf dem Slave installieren. Alle Einstellungen machst du dann im "Master Backitup"

-

@haselchen ich meine auch, dass das früher so war, kann mich aber irren...

-

-

Ich bin gerade etwas verwirrt. Bei mir klappt das Backup nicht mehr.

Ich nutze für den ioBroker den Docker Container und habe einen Pfad in den Container gemountet. Auf der Console des Containers kann ich als ioBroker Nutzer Dateien innerhalb dieses Ordners löschen und erstellen.

Im ioBroker habe ich ein Backup angestoßen und erhalte den folgenden Output:

Started ccu ... [DEBUG] [mount] - done [DEBUG] [ccu] - CCU-Backup started ... [DEBUG] [ccu] - CCU Version: 3.61.7 [DEBUG] [ccu] - Requesting backup from CCU [DEBUG] [ccu] - CCU-Backup for is finish [DEBUG] [ccu] - done [ERROR] [cifs] - Path "/mnt/backitup/iobroker" not foundIch stelle mir die Frage, warum hier CIFS genutzt wird und nicht COPY. Kann es sein, dass dies ein Bug ist? Ich habe kurz auch auf CIFS gestellt und direkt wieder zu COPY geändert. Aber die Ausgabe bleibt die selbe.

Hat jemand eine Idee, was ich noch testen könnte?

-

Ich bin gerade etwas verwirrt. Bei mir klappt das Backup nicht mehr.

Ich nutze für den ioBroker den Docker Container und habe einen Pfad in den Container gemountet. Auf der Console des Containers kann ich als ioBroker Nutzer Dateien innerhalb dieses Ordners löschen und erstellen.

Im ioBroker habe ich ein Backup angestoßen und erhalte den folgenden Output:

Started ccu ... [DEBUG] [mount] - done [DEBUG] [ccu] - CCU-Backup started ... [DEBUG] [ccu] - CCU Version: 3.61.7 [DEBUG] [ccu] - Requesting backup from CCU [DEBUG] [ccu] - CCU-Backup for is finish [DEBUG] [ccu] - done [ERROR] [cifs] - Path "/mnt/backitup/iobroker" not foundIch stelle mir die Frage, warum hier CIFS genutzt wird und nicht COPY. Kann es sein, dass dies ein Bug ist? Ich habe kurz auch auf CIFS gestellt und direkt wieder zu COPY geändert. Aber die Ausgabe bleibt die selbe.

Hat jemand eine Idee, was ich noch testen könnte?

-

Ich bin gerade etwas verwirrt. Bei mir klappt das Backup nicht mehr.

Ich nutze für den ioBroker den Docker Container und habe einen Pfad in den Container gemountet. Auf der Console des Containers kann ich als ioBroker Nutzer Dateien innerhalb dieses Ordners löschen und erstellen.

Im ioBroker habe ich ein Backup angestoßen und erhalte den folgenden Output:

Started ccu ... [DEBUG] [mount] - done [DEBUG] [ccu] - CCU-Backup started ... [DEBUG] [ccu] - CCU Version: 3.61.7 [DEBUG] [ccu] - Requesting backup from CCU [DEBUG] [ccu] - CCU-Backup for is finish [DEBUG] [ccu] - done [ERROR] [cifs] - Path "/mnt/backitup/iobroker" not foundIch stelle mir die Frage, warum hier CIFS genutzt wird und nicht COPY. Kann es sein, dass dies ein Bug ist? Ich habe kurz auch auf CIFS gestellt und direkt wieder zu COPY geändert. Aber die Ausgabe bleibt die selbe.

Hat jemand eine Idee, was ich noch testen könnte?

Habe ich auch gehabt.

Ich hab ums verrecken kein Backup in einen spezifizierten Ordner bringen können.

Iobroker läuft auf ner Syno.

Entweder permission denied oder dein Fehler.

Passwörter und Brechtigungen stimmen alle.

Kann auch so von aussen auf die Syno zugreifen.Mach das ganze jetzt per FTP. Das klappt.

Edit: Wenn du Hilfe bei den Einstellungen brauchst, sach Bescheid.

-

Ich bin gerade etwas verwirrt. Bei mir klappt das Backup nicht mehr.

Ich nutze für den ioBroker den Docker Container und habe einen Pfad in den Container gemountet. Auf der Console des Containers kann ich als ioBroker Nutzer Dateien innerhalb dieses Ordners löschen und erstellen.

Im ioBroker habe ich ein Backup angestoßen und erhalte den folgenden Output:

Started ccu ... [DEBUG] [mount] - done [DEBUG] [ccu] - CCU-Backup started ... [DEBUG] [ccu] - CCU Version: 3.61.7 [DEBUG] [ccu] - Requesting backup from CCU [DEBUG] [ccu] - CCU-Backup for is finish [DEBUG] [ccu] - done [ERROR] [cifs] - Path "/mnt/backitup/iobroker" not foundIch stelle mir die Frage, warum hier CIFS genutzt wird und nicht COPY. Kann es sein, dass dies ein Bug ist? Ich habe kurz auch auf CIFS gestellt und direkt wieder zu COPY geändert. Aber die Ausgabe bleibt die selbe.

Hat jemand eine Idee, was ich noch testen könnte?

@dontobi Kannst du die Freigabe händisch mounten?

-

Habe ich auch gehabt.

Ich hab ums verrecken kein Backup in einen spezifizierten Ordner bringen können.

Iobroker läuft auf ner Syno.

Entweder permission denied oder dein Fehler.

Passwörter und Brechtigungen stimmen alle.

Kann auch so von aussen auf die Syno zugreifen.Mach das ganze jetzt per FTP. Das klappt.

Edit: Wenn du Hilfe bei den Einstellungen brauchst, sach Bescheid.

@haselchen Ich habe mir nun damit geholfen, dass ich die Backups per WebDAV zu meiner nextcloud Instanz schiebe und diese von dort auf einen Lokalen Speicher synchronisiere.

@dr-bakterius Da der ioBroker km Docker Container läuft, wird der Ordner automatisch beim starten in den Container verbunden (per Volume Bind). Ich habe daher per Console mich in den Container verbunden und dort Tests durchgeführt. Ordner und Dateien erstellen, sowie löschen klappt ohne Probleme als User (ioBroker) und auch per sudo. Daran kann es also nicht liegen.

-

Moin zusammen,

ich muss mal eine ganz blöde Frage stellen, bevor ich mir jetzt gleich alles zerschieße.Also BackitUp liegt als Komplett Sicherung für ioB, InfluxDB, Grafana, und die js-Skripte vor. Dieses Backup beruht auf einer ioB Windows Installation.

Nun habe ich mir einen NUC mit Proxmox und einer Linux VM für ioB aufgebaut. Auch InfluxDB und Grafana laufen auf dieser neuen Maschine in eigenen Containern.

Kann ich bedenkenlos die BackitUp Sicherung des Windows basierenden Systems als Restore Daten für die Linux Version nehmen? Bei InfluxDB und Grafana werde ich nach dem Restore die IP Adressen anpassen müssen, das ist mir soweit klar.

Ich frage deshalb so doof, weil ich ein ähnliches Szenario vor geraumer Zeit schon einmal auf zwei verschiedenen Windows Rechner ausprobiert hatte. Nach dem Restore auf dem neuen Windows Rechner ging jedoch gar nichts mehr und ioB war nicht mehr erreichbar.

Diesen Fehler würde ich mir jetzt gerne ersparen.

-

Moin zusammen,

ich muss mal eine ganz blöde Frage stellen, bevor ich mir jetzt gleich alles zerschieße.Also BackitUp liegt als Komplett Sicherung für ioB, InfluxDB, Grafana, und die js-Skripte vor. Dieses Backup beruht auf einer ioB Windows Installation.

Nun habe ich mir einen NUC mit Proxmox und einer Linux VM für ioB aufgebaut. Auch InfluxDB und Grafana laufen auf dieser neuen Maschine in eigenen Containern.

Kann ich bedenkenlos die BackitUp Sicherung des Windows basierenden Systems als Restore Daten für die Linux Version nehmen? Bei InfluxDB und Grafana werde ich nach dem Restore die IP Adressen anpassen müssen, das ist mir soweit klar.

Ich frage deshalb so doof, weil ich ein ähnliches Szenario vor geraumer Zeit schon einmal auf zwei verschiedenen Windows Rechner ausprobiert hatte. Nach dem Restore auf dem neuen Windows Rechner ging jedoch gar nichts mehr und ioB war nicht mehr erreichbar.

Diesen Fehler würde ich mir jetzt gerne ersparen.

@jb_sullivan

Im Prinzip kannst du einen Restore auf ein anderes System ohne Probleme machen.

Wo ich aber immer drauf achten würde, wäre auf die Datenbanken.Um nicht in Probleme zu laufen, sollten diese auf beiden Systemen identisch sein.

Wenn du also auf deinem Windows jsonl/jsonl hast, dann sollte auf deinem neuen System zum Zeitpunkt des Restores ebenfalls der Typ verwendet werden. Genau so auch mit File oder Redis -

Hi,

Diesen Post habe ich auch schon in "ioBroker allgemein", weil den Thread erst jetzt entdeckt habe, sorry.

Aber ich glaube, hier ist er richtiger aufgehoben.Ich habe Mitte des vorigen Jahres für BackItUp eine App auf Dropbox definiert und den Token eingetragen um das Backup gleich in die Cloud zu machen. Läuft auf dem Master in einem LXC auf Proxmox.

Jetzt habe ich einen Conbee2 auf einem Raspberry laufen und wollte die Zigbee-Daten ebenfalls auf die Dropbox senden.

Also eine neue App definiert (den alten Token habe ich mir natürlich nicht irgendwo gesichert :angry:) und auf dem Pi eine Instanz des Adapters erstellt, der im Master als Backitup.1 erscheint.Allerdings gibt es beim Upload Probleme:

Started iobroker ... [DEBUG] [iobroker] - host.pi-broker 8389 states saved [DEBUG] [iobroker] - host.pi-broker 9078 objects saved [DEBUG] [iobroker] - Backup created: /opt/iobroker/backups/iobroker_2022_03_12-12_44_04_backupiobroker.tar.gz [DEBUG] [iobroker] - done [DEBUG] [zigbee] - found zigbee database: zigbee.0 [DEBUG] [zigbee] - done [DEBUG] [ftp] - FTP connected. [DEBUG] [ftp] - Send iobroker_2022_03_12-12_44_04_backupiobroker.tar.gz [DEBUG] [ftp] - Send zigbee.0_2022_03_12-12_44_24_backupiobroker.tar.gz [DEBUG] [ftp] - done [DEBUG] [dropbox] - Dropbox: Copy iobroker_2022_03_12-12_44_04_backupiobroker.tar.gz... [ERROR] [dropbox] - upload Dropbox: {"code":400,"text":"Error in call to API function \"files/upload\": Bad HTTP \"Content-Type\" header: \"application/gzip\". Expecting one of \"application/octet-stream\", \"text/plain; charset=dropbox-cors-hack\"."} [DEBUG] [dropbox] - Dropbox: Copy zigbee.0_2022_03_12-12_44_24_backupiobroker.tar.gz... [ERROR] [dropbox] - upload Dropbox: {"code":400,"text":"Error in call to API function \"files/upload\": Bad HTTP \"Content-Type\" header: \"application/gzip\". Expecting one of \"application/octet-stream\", \"text/plain; charset=dropbox-cors-hack\"."} [DEBUG] [dropbox] - done [DEBUG] [clean] - done [DEBUG] [historyHTML] - new history html values created [DEBUG] [historyHTML] - done [DEBUG] [historyJSON] - new history json values created [DEBUG] [historyJSON] - done [EXIT] 0Ich glaube mich zu erinnern, dass sich an der API in Dropbox was getan hat, zumindest bekam ich mal Mails dafür.

Ich kenne die Api und die Auswahl dazu nicht, könnte mir aber vorstellen, dass aufgrund des Token die neue API angesprochen wird und es da einen Fehler gibt.

Die alte Version im LXC läuft weiterhin ohne Probleme.Aktuell auf beiden Rechnern laufende Adapter-Version: v2.3.5

Dass vor dem Upload ein FTP-Send zu sehen ist, liegt daran, dass ich das Backup, solange es nicht auf die Dropbox kommt auf ein NAS sichere.Kann das ein Konfigurationsfehler meinerseits sein (was ich nicht glaube, weil bei 3 Einstellungen sollte man doch wenig Fehler machen können :confused:) oder liegt es am Adapter?