NEWS

iobroker hochverfügbar

-

@apollon77 sagte in iobroker hochverfügbar:

@darkiop Genau, proxmox Root hat bei ir 15 oder 20 GB und der rest der SSD ist dann in einer partition gemacht. Das ganze identisch auf 3 rechnern. Dann glusterfs installieren direkt auf dem proxmox os und dann damit ein zB shared FS machen was dreifach repliziert ist.

glusterfs geht auch nur mit 2 nodes und einem "quorum node", dann ist es aber im Ausfallfall speziell was passiert. Wenn Dir der falsche Node ausfällt ist dann alles weg weil FS dann read only geht. Glusters ginge noch mit 2 replicas plus einem sog. "Arbiter" - der hlt nur meta daten, da könnte man nen raspi oder so als dritten nehmen ... dann gehts auch mit zwei Datennodes.

Aber ja brauchst ein Shared FS. Wenn dein FS auf der NAS liegt ast Du ja sonst wieder einen Single-point-of-Failure (ohh NAS macht ein update ... ohh mist, alles down) :-)Als Setup Link (zur Vorstellung wie es geht) zB https://forum.proxmox.com/threads/create-a-proxmox-6-2-cluster-glusterfs-storage.71971/ ... ich habs aber nicht ganz gelesen ob es wirklich so geht. ich könnte supporten - auch was man danach noch wie machen sollte weil es da bissl spezialiäten gibt die ich lernen musste ... vllt Fällt da ja ne anleitung raus :-)

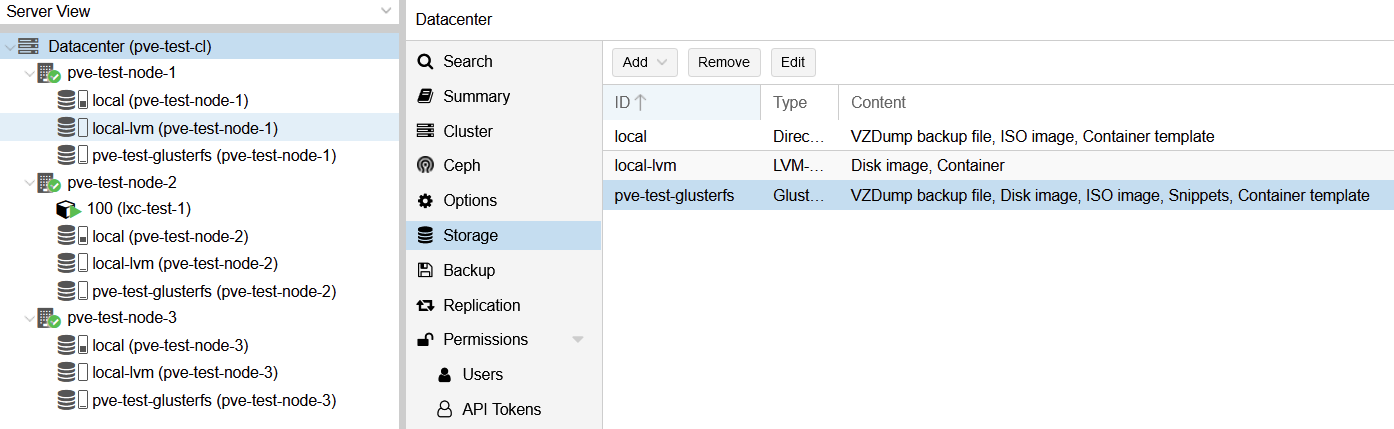

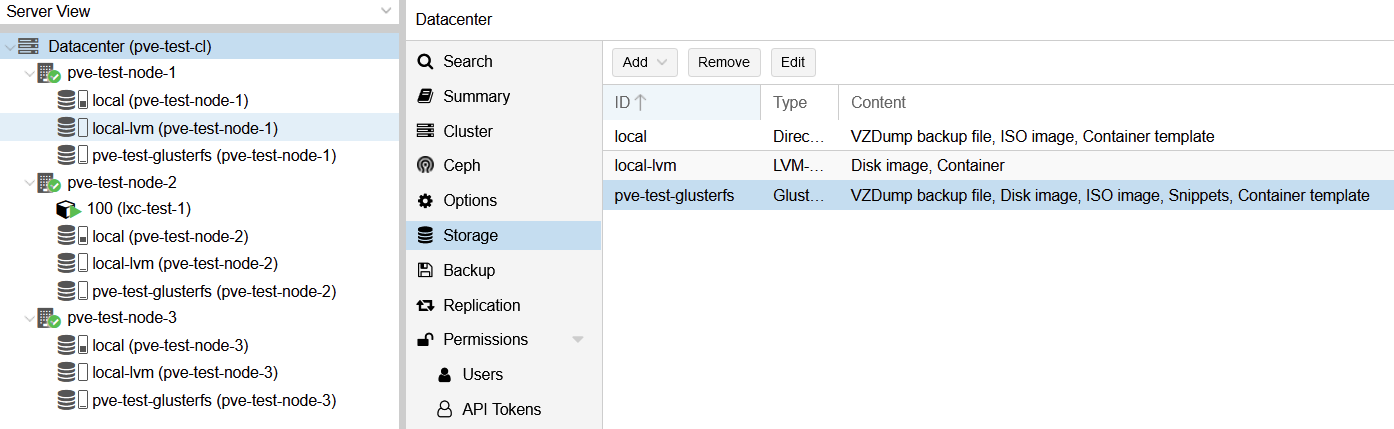

Ich schau mir das bei gelegenheit mal an - hab heut auf meinem Test Rechner Proxmox + 3 Proxmox VMs aufgesetzt - damit sollte sich jetzt etwas spielen lassen. Den Link zu GlusterFS aus dem Proxmox Forum hatte ich sogar schonmal in meiner Dokumentation im Kapitel HA gespeichert. Ich verpasse den 3 VMs mit Proxmox mal jeweils eine HDD und versuch mich mal an GlusterFS. Falls ich Hilfe brauche nehme ich das Support Angebot gerne an. Grundsätzlich dokumentiere ich auch immer schön mit, vielleicht kann das dann zu nem HowTo beitragen. Aber erstmal schauen wie es zeitlich passt.

Und das es bei mir 7 Nodes sind ist Historisch - 7 nodes NUC5PPYH mit max 8 GB waren am Ende billiger als 4 größere ... aber inzwischen haben die 8GB genervt und bin jetzt upgraded auf NUC8i5 mit je 16 GB (und kann noch auf 32GB hoch). Und ja es läuft inzwischen einiges da drauf neben meinem Prod System

Hehe OK :) Die ziehen sicher auch einiges an Strom. Glaub ich mache die Tage auch mal einen Thread "Zeigt her eure Virtualisierung" - Ideen geben und bekommen :) Bei mir läuft da mittlerweile auch einiges, hab nen NUC8i5 mit 32GB und die werden teils auch mal knapp :D

Du hast aber auch das ganze HA Zegs über die eine LAN-Schnittstelle des NUC laufen? Idealerweise sollte man das ja trennen ...

@paul53 sagte in iobroker hochverfügbar:

Ich meinte mit meiner Aussage, dass die Funk-Modems die Hochverfügbarkeit einschränken, da sie die angelernten Geräte verwalten (außer HomeMatic).

Was nutzt die Hochverfügbarkeit von ioBroker, wenn wichtige Geräte nicht mehr gesteuert werden können?

Da hast du absolut Recht - das sind dann Dinge die auch die bessere Hälfte direkt bemerkt - Licht, Bewegungsmelder, Garagentor, Bechattung, etc.

Aber auf dem Proxmox Cluster laufen ja noch mehr Dinge: lokaler DNS, Adblock, VPN, Kameras, Fileserver und eben auch ioBroker und Homematic in einer VM. Somit muss schon das Funkmodul aussteigen damits brenzlich wird. Das Szenario kaputte SD im Raspi und somit keine CCU mehr ist abgefangen.

Könnte man ggf. mit

https://homematic-forum.de/forum/viewtopic.php?t=60150

HomeMatic bzgl. Funk-Modul robuster bekommen?

@apollon77 sagte in iobroker hochverfügbar:

Auch für meine CCU könnte ich was bauen das ich die Reserve HW aufbaue und angeschlossen habe, regelmäßig das aktuellste Backup einspiele, sodass Sie falls die erste ausfällt dann von ioBroker erkannt eingeschaltet werden kann und Theoretisch die Arbeit übernehmen könnte. hab ich bisher noch nicht gemacht ... andere Dinge waren spassiger

Geht das denn so direkt, dachte bisher die HM Komponenten sind an das Funkmodul gebunden.

@darkiop sagte: HM Komponenten sind an das Funkmodul gebunden.

Das ist der Vorteil von HomeMatic (zumindest classic), dass sie nicht an das Funkmodul, sondern an die CCU gebunden sind, also nicht wissen, wenn eine andere CCU (mit gleicher ID) übernimmt. Es kann natürlich immer nur eine CCU "funken".

-

Hi Leute,

Ich habe mir folgendes zusammengestellt:

drei identische Laptop Lenovo G700 mit 8GB RAM und 256 GB SSD auf allen läuft Ubuntu Server 20.04 LTS, Redis Server, Redis Sentinel und iobroker mit bisher nur den Grundadaptern. Einzeln laufen alle drei ohne Probleme mit States und Objects auf Redis. Was mir bisher nicht gelingt ist die Verknüpfung der drei. So dass ich ein hochverfügbarkeits System habe. Das Problem beginnt schon wenn ich versuche zwei als Master/Slave als Multihost konfiguriere. Master läuft ohne Problem weiter und der Slave meldet immer kein Master gefunden. Kann mir jemand nochmal die Konfiguration in Redis zeigen? würde mich sehr freuen.

Grüße Frank -

@apollon77 sagte in iobroker hochverfügbar:

@darkiop Genau, proxmox Root hat bei ir 15 oder 20 GB und der rest der SSD ist dann in einer partition gemacht. Das ganze identisch auf 3 rechnern. Dann glusterfs installieren direkt auf dem proxmox os und dann damit ein zB shared FS machen was dreifach repliziert ist.

glusterfs geht auch nur mit 2 nodes und einem "quorum node", dann ist es aber im Ausfallfall speziell was passiert. Wenn Dir der falsche Node ausfällt ist dann alles weg weil FS dann read only geht. Glusters ginge noch mit 2 replicas plus einem sog. "Arbiter" - der hlt nur meta daten, da könnte man nen raspi oder so als dritten nehmen ... dann gehts auch mit zwei Datennodes.

Aber ja brauchst ein Shared FS. Wenn dein FS auf der NAS liegt ast Du ja sonst wieder einen Single-point-of-Failure (ohh NAS macht ein update ... ohh mist, alles down) :-)Als Setup Link (zur Vorstellung wie es geht) zB https://forum.proxmox.com/threads/create-a-proxmox-6-2-cluster-glusterfs-storage.71971/ ... ich habs aber nicht ganz gelesen ob es wirklich so geht. ich könnte supporten - auch was man danach noch wie machen sollte weil es da bissl spezialiäten gibt die ich lernen musste ... vllt Fällt da ja ne anleitung raus :-)

Ich schau mir das bei gelegenheit mal an - hab heut auf meinem Test Rechner Proxmox + 3 Proxmox VMs aufgesetzt - damit sollte sich jetzt etwas spielen lassen. Den Link zu GlusterFS aus dem Proxmox Forum hatte ich sogar schonmal in meiner Dokumentation im Kapitel HA gespeichert. Ich verpasse den 3 VMs mit Proxmox mal jeweils eine HDD und versuch mich mal an GlusterFS. Falls ich Hilfe brauche nehme ich das Support Angebot gerne an. Grundsätzlich dokumentiere ich auch immer schön mit, vielleicht kann das dann zu nem HowTo beitragen. Aber erstmal schauen wie es zeitlich passt.

Und das es bei mir 7 Nodes sind ist Historisch - 7 nodes NUC5PPYH mit max 8 GB waren am Ende billiger als 4 größere ... aber inzwischen haben die 8GB genervt und bin jetzt upgraded auf NUC8i5 mit je 16 GB (und kann noch auf 32GB hoch). Und ja es läuft inzwischen einiges da drauf neben meinem Prod System

Hehe OK :) Die ziehen sicher auch einiges an Strom. Glaub ich mache die Tage auch mal einen Thread "Zeigt her eure Virtualisierung" - Ideen geben und bekommen :) Bei mir läuft da mittlerweile auch einiges, hab nen NUC8i5 mit 32GB und die werden teils auch mal knapp :D

Du hast aber auch das ganze HA Zegs über die eine LAN-Schnittstelle des NUC laufen? Idealerweise sollte man das ja trennen ...

@paul53 sagte in iobroker hochverfügbar:

Ich meinte mit meiner Aussage, dass die Funk-Modems die Hochverfügbarkeit einschränken, da sie die angelernten Geräte verwalten (außer HomeMatic).

Was nutzt die Hochverfügbarkeit von ioBroker, wenn wichtige Geräte nicht mehr gesteuert werden können?

Da hast du absolut Recht - das sind dann Dinge die auch die bessere Hälfte direkt bemerkt - Licht, Bewegungsmelder, Garagentor, Bechattung, etc.

Aber auf dem Proxmox Cluster laufen ja noch mehr Dinge: lokaler DNS, Adblock, VPN, Kameras, Fileserver und eben auch ioBroker und Homematic in einer VM. Somit muss schon das Funkmodul aussteigen damits brenzlich wird. Das Szenario kaputte SD im Raspi und somit keine CCU mehr ist abgefangen.

Könnte man ggf. mit

https://homematic-forum.de/forum/viewtopic.php?t=60150

HomeMatic bzgl. Funk-Modul robuster bekommen?

@apollon77 sagte in iobroker hochverfügbar:

Auch für meine CCU könnte ich was bauen das ich die Reserve HW aufbaue und angeschlossen habe, regelmäßig das aktuellste Backup einspiele, sodass Sie falls die erste ausfällt dann von ioBroker erkannt eingeschaltet werden kann und Theoretisch die Arbeit übernehmen könnte. hab ich bisher noch nicht gemacht ... andere Dinge waren spassiger

Geht das denn so direkt, dachte bisher die HM Komponenten sind an das Funkmodul gebunden.

@darkiop sagte in iobroker hochverfügbar:

Du hast aber auch das ganze HA Zegs über die eine LAN-Schnittstelle des NUC laufen? Idealerweise sollte man das ja trennen ...

Ja habe alles über die eine LAN Schnittstelle, aber alles dann mit der Zeit auf 10G in der Verteilung hochgezogen. Also Faktisch kann damit jetzt wirklich jeder Nuc seine 1G ziehen und weder der Switch noch die Hauptverteilung limitiert das dann. Sonst müsste man ja ganz andere Hardware nutzen, weil auch mit Nuc und dann per USB ne zweite NIC bereitstellen hat wieder andere Probleme.

-

Ich habe mit ewas HM angeht entschieden ncht selbst zu basteln (also Debmatic und wie es alles heisst) sondern echt die CCU Hardware zu nutzen. Updates macht man das wenn nötig über die Firmware und so. Die CCU als "Hardwarekomponente" ist aktuell noch nie ausgefallen und ich kann es nicht kaputtspielen :-)

-

was hab ich Tage damit verbracht.. aber wenns einmal läuft musst du du dich mit dem Ausfall beschäftigen falls das cluster mal nicht will... und so lernt man immer was dazu..

ich habs so wie apollon.. nur mit 5 nucs.. das ganze auch im Haus verteilt an einzelnen USV's.. um beruhig in den Urlaub zu fahren.

der Spass beginnt wenn du eine Update Orgie startest.. mal eben so ist es nicht getan. da können Admins ein Lied von singen..

-

@darkiop sagte: HM Komponenten sind an das Funkmodul gebunden.

Das ist der Vorteil von HomeMatic (zumindest classic), dass sie nicht an das Funkmodul, sondern an die CCU gebunden sind, also nicht wissen, wenn eine andere CCU (mit gleicher ID) übernimmt. Es kann natürlich immer nur eine CCU "funken".

@paul53 sagte in iobroker hochverfügbar:

@darkiop sagte: HM Komponenten sind an das Funkmodul gebunden.

Das ist der Vorteil von HomeMatic (zumindest classic), dass sie nicht an das Funkmodul, sondern an die CCU gebunden sind, also nicht wissen, wenn eine andere CCU (mit gleicher ID) übernimmt. Es kann natürlich immer nur eine CCU "funken".

Ok, dann hatte ich das in meinem Kopf irgendwann mal falsch abgespeichert - dann bleibt nur die Frage ob das auch so bei HM IP ist. @Homoran kannst du dazu etwas sagen?

-

@oliverio sagte in iobroker hochverfügbar:

Was ist mit der 2. Stromschiene eines 2. Stromanbieters? :)

PV aufm Dach + Irgendwann ein Auto im Hof das als Puffer dient :D

-

@darkiop sagte in iobroker hochverfügbar:

Du hast aber auch das ganze HA Zegs über die eine LAN-Schnittstelle des NUC laufen? Idealerweise sollte man das ja trennen ...

Ja habe alles über die eine LAN Schnittstelle, aber alles dann mit der Zeit auf 10G in der Verteilung hochgezogen. Also Faktisch kann damit jetzt wirklich jeder Nuc seine 1G ziehen und weder der Switch noch die Hauptverteilung limitiert das dann. Sonst müsste man ja ganz andere Hardware nutzen, weil auch mit Nuc und dann per USB ne zweite NIC bereitstellen hat wieder andere Probleme.

@apollon77 sagte in iobroker hochverfügbar:

@darkiop sagte in iobroker hochverfügbar:

Du hast aber auch das ganze HA Zegs über die eine LAN-Schnittstelle des NUC laufen? Idealerweise sollte man das ja trennen ...

Ja habe alles über die eine LAN Schnittstelle, aber alles dann mit der Zeit auf 10G in der Verteilung hochgezogen. Also Faktisch kann damit jetzt wirklich jeder Nuc seine 1G ziehen und weder der Switch noch die Hauptverteilung limitiert das dann. Sonst müsste man ja ganz andere Hardware nutzen, weil auch mit Nuc und dann per USB ne zweite NIC bereitstellen hat wieder andere Probleme.

Ok, 10G hab ich auch aufm Schirm - allerdings, da ich im Unifi Universum bleiben möchte bisher noch nicht realisiert, Kosten für den Switch kommen auf 500-600€ - da muss dann auch der Usecase passen. Ggf. dann irgendwann mal, wenn HA ausgeprägter bei mir ist.

Wie hast du denn den NUCs 10Gb verpasst? Die können doch nur 1Gb. Per USB-C/Thunderbolt Adapter?

@apollon77 sagte in iobroker hochverfügbar:

Ich habe mit ewas HM angeht entschieden ncht selbst zu basteln (also Debmatic und wie es alles heisst) sondern echt die CCU Hardware zu nutzen. Updates macht man das wenn nötig über die Firmware und so. Die CCU als "Hardwarekomponente" ist aktuell noch nie ausgefallen und ich kann es nicht kaputtspielen :-)

Verstehe, ich hab die CCU bei mir in eine VM gezogen um den Raspi einzusparen und die "Sicherheit" (Backups, Snapshots) von Proxmox zu haben. Angebunden sind die aktuell über HB-RF-USB-2 mit HM-MOD-RPI-PCB und lauft komplett unauffällig.

-

was hab ich Tage damit verbracht.. aber wenns einmal läuft musst du du dich mit dem Ausfall beschäftigen falls das cluster mal nicht will... und so lernt man immer was dazu..

ich habs so wie apollon.. nur mit 5 nucs.. das ganze auch im Haus verteilt an einzelnen USV's.. um beruhig in den Urlaub zu fahren.

der Spass beginnt wenn du eine Update Orgie startest.. mal eben so ist es nicht getan. da können Admins ein Lied von singen..

@arteck sagte in iobroker hochverfügbar:

was hab ich Tage damit verbracht.. aber wenns einmal läuft musst du du dich mit dem Ausfall beschäftigen falls das cluster mal nicht will... und so lernt man immer was dazu..

ich habs so wie apollon.. nur mit 5 nucs.. das ganze auch im Haus verteilt an einzelnen USV's.. um beruhig in den Urlaub zu fahren.

Ich muss mir mal Gedanken und einen Plan machen was die nächsten Schritte sind. Und so Sinnvoll ein Schritt nach dem andern gehen :D Das Thema USV schiebe ich auch schon ewig im Kopf rum und vergesse es immer wieder :D Was habt ihr denn für Welche im Einsatz?

der Spass beginnt wenn du eine Update Orgie startest.. mal eben so ist es nicht getan. da können Admins ein Lied von singen..

Das ist es ja jetzt schon, bei >10 LXCs/VMs + diversen anderen Geräten. Aus diesem Grund hab ich letzte Woche in einigen LXCs/VMs unattended-upgrades aktiviert. Ich hatte eigentlich noch nicht Probleme nach einem Update - solange man vorher nicht komplett sein System verwurschtelt hatte :) Mal schauen wann ich die ersten negativen Erfahrungen damit mache :D

-

@paul53 sagte in iobroker hochverfügbar:

@darkiop sagte: HM Komponenten sind an das Funkmodul gebunden.

Das ist der Vorteil von HomeMatic (zumindest classic), dass sie nicht an das Funkmodul, sondern an die CCU gebunden sind, also nicht wissen, wenn eine andere CCU (mit gleicher ID) übernimmt. Es kann natürlich immer nur eine CCU "funken".

Ok, dann hatte ich das in meinem Kopf irgendwann mal falsch abgespeichert - dann bleibt nur die Frage ob das auch so bei HM IP ist. @Homoran kannst du dazu etwas sagen?

@darkiop sagte in iobroker hochverfügbar:

dann bleibt nur die Frage ob das auch so bei HM IP ist. @Homoran kannst du dazu etwas sagen?

müsste, da IMHO funkmodultechnisch diesbezüglich kein Unterschied besteht.

@darkiop sagte in iobroker hochverfügbar:

Irgendwann ein Auto im Hof das als Puffer dient

V2Home ist in D leider noch nicht zulässig.

du könntest ja kostenlos bei ikea laden und dann einspeisen.Batterie mi USV-Funktion wäre ja auch schon was

-

@darkiop sagte in iobroker hochverfügbar:

dann bleibt nur die Frage ob das auch so bei HM IP ist. @Homoran kannst du dazu etwas sagen?

müsste, da IMHO funkmodultechnisch diesbezüglich kein Unterschied besteht.

@darkiop sagte in iobroker hochverfügbar:

Irgendwann ein Auto im Hof das als Puffer dient

V2Home ist in D leider noch nicht zulässig.

du könntest ja kostenlos bei ikea laden und dann einspeisen.Batterie mi USV-Funktion wäre ja auch schon was

@homoran sagte in iobroker hochverfügbar:

@darkiop sagte in iobroker hochverfügbar:

dann bleibt nur die Frage ob das auch so bei HM IP ist. @Homoran kannst du dazu etwas sagen?

müsste, da IMHO funkmodultechnisch diesbezüglich kein Unterschied besteht.

Ok, gehe Ich auch davon aus ...

@darkiop sagte in iobroker hochverfügbar:

Irgendwann ein Auto im Hof das als Puffer dient

V2Home ist in D leider noch nicht zulässig.

du könntest ja kostenlos bei ikea laden und dann einspeisen.Ja, Zukunftsmusik - aber spannend :)

Solange halte ich es im Ikea nicht aus das sich das lohnen könnte :D

Batterie mi USV-Funktion wäre ja auch schon was

Ja, aber die müssen auch erstmal bezahlbar/rentabel werden - das ist aktuell noch nicht wirklich interessant.

-

@apollon77 sagte in iobroker hochverfügbar:

@darkiop sagte in iobroker hochverfügbar:

Du hast aber auch das ganze HA Zegs über die eine LAN-Schnittstelle des NUC laufen? Idealerweise sollte man das ja trennen ...

Ja habe alles über die eine LAN Schnittstelle, aber alles dann mit der Zeit auf 10G in der Verteilung hochgezogen. Also Faktisch kann damit jetzt wirklich jeder Nuc seine 1G ziehen und weder der Switch noch die Hauptverteilung limitiert das dann. Sonst müsste man ja ganz andere Hardware nutzen, weil auch mit Nuc und dann per USB ne zweite NIC bereitstellen hat wieder andere Probleme.

Ok, 10G hab ich auch aufm Schirm - allerdings, da ich im Unifi Universum bleiben möchte bisher noch nicht realisiert, Kosten für den Switch kommen auf 500-600€ - da muss dann auch der Usecase passen. Ggf. dann irgendwann mal, wenn HA ausgeprägter bei mir ist.

Wie hast du denn den NUCs 10Gb verpasst? Die können doch nur 1Gb. Per USB-C/Thunderbolt Adapter?

@apollon77 sagte in iobroker hochverfügbar:

Ich habe mit ewas HM angeht entschieden ncht selbst zu basteln (also Debmatic und wie es alles heisst) sondern echt die CCU Hardware zu nutzen. Updates macht man das wenn nötig über die Firmware und so. Die CCU als "Hardwarekomponente" ist aktuell noch nie ausgefallen und ich kann es nicht kaputtspielen :-)

Verstehe, ich hab die CCU bei mir in eine VM gezogen um den Raspi einzusparen und die "Sicherheit" (Backups, Snapshots) von Proxmox zu haben. Angebunden sind die aktuell über HB-RF-USB-2 mit HM-MOD-RPI-PCB und lauft komplett unauffällig.

@darkiop sagte in iobroker hochverfügbar:

Wie hast du denn den NUCs 10Gb verpasst? Die können doch nur 1Gb. Per USB-C/Thunderbolt Adapter?

Nee gar nicht. Die haben weiter je 1gb. Wenn aber der semwitxh dann in Richtung Hausverteilung auch nur 1gb kann dann kann es eng werden wenn mehrere 1gb Geräte an dem Switch in Summe mehr als 1gb „reden“ wollen zu hosts woanders im Haus. Daher können meine lokalen switche hin zur hausverteilung und dort der hauptswitch 10g auf einigen Ports. Damit istvder bottleneck „Verteilung raus“ und jeder nuc kann ggf seine 1gb voll ausnutzen.

Am Ende wenn du pro Host einen glusterfs brick hast ist das alles noch easy. Meine bricks sind anders verteilt und daher mehr und da wird es ggf eng wenn die mal alle Daten syncen wollen ;-)

-

@darkiop sagte in iobroker hochverfügbar:

Wie hast du denn den NUCs 10Gb verpasst? Die können doch nur 1Gb. Per USB-C/Thunderbolt Adapter?

Nee gar nicht. Die haben weiter je 1gb. Wenn aber der semwitxh dann in Richtung Hausverteilung auch nur 1gb kann dann kann es eng werden wenn mehrere 1gb Geräte an dem Switch in Summe mehr als 1gb „reden“ wollen zu hosts woanders im Haus. Daher können meine lokalen switche hin zur hausverteilung und dort der hauptswitch 10g auf einigen Ports. Damit istvder bottleneck „Verteilung raus“ und jeder nuc kann ggf seine 1gb voll ausnutzen.

Am Ende wenn du pro Host einen glusterfs brick hast ist das alles noch easy. Meine bricks sind anders verteilt und daher mehr und da wird es ggf eng wenn die mal alle Daten syncen wollen ;-)

@apollon77 sagte in iobroker hochverfügbar:

jeder nuc kann ggf seine 1gb voll ausnutze

Ok. Müsste mal schauen was meine Unifi Switchtes auf der Backplane liefern - sollte aber mehr als 1Gb sein. Die Dream Machine Pro ist allerdings beschnitten auf 1Gb.

@apollon77 sagte in iobroker hochverfügbar:

Am Ende wenn du pro Host einen glusterfs brick hast ist das alles noch easy. Meine bricks sind anders verteilt und daher mehr und da wird es ggf eng wenn die mal alle Daten syncen wollen

Ich versuche mich mal dran, komme sicher mit der ein oder anderen Frage auf dich zurück :)

-

@darkiop sagte in iobroker hochverfügbar:

dann bleibt nur die Frage ob das auch so bei HM IP ist. @Homoran kannst du dazu etwas sagen?

müsste, da IMHO funkmodultechnisch diesbezüglich kein Unterschied besteht.

@darkiop sagte in iobroker hochverfügbar:

Irgendwann ein Auto im Hof das als Puffer dient

V2Home ist in D leider noch nicht zulässig.

du könntest ja kostenlos bei ikea laden und dann einspeisen.Batterie mi USV-Funktion wäre ja auch schon was

-

@paul53 sagte in iobroker hochverfügbar:

@homoran sagte: da IMHO funkmodultechnisch diesbezüglich kein Unterschied besteht.

Bis auf das Rekeying über das Internet, was mich stören würde

stimmt! das dauert etwas.

hatte ich nicht auf dem Schirm -

@paul53 sagte in iobroker hochverfügbar:

@homoran sagte: da IMHO funkmodultechnisch diesbezüglich kein Unterschied besteht.

Bis auf das Rekeying über das Internet, was mich stören würde

stimmt! das dauert etwas.

hatte ich nicht auf dem Schirm -

@apollon77 sagte in iobroker hochverfügbar:

jeder nuc kann ggf seine 1gb voll ausnutze

Ok. Müsste mal schauen was meine Unifi Switchtes auf der Backplane liefern - sollte aber mehr als 1Gb sein. Die Dream Machine Pro ist allerdings beschnitten auf 1Gb.

@apollon77 sagte in iobroker hochverfügbar:

Am Ende wenn du pro Host einen glusterfs brick hast ist das alles noch easy. Meine bricks sind anders verteilt und daher mehr und da wird es ggf eng wenn die mal alle Daten syncen wollen

Ich versuche mich mal dran, komme sicher mit der ein oder anderen Frage auf dich zurück :)

-

@apollon77 sagte: Das sind aber die Limitierungen mit denen man leben muss denke ich

Was nutzt die Hochverfügbarkeit von ioBroker, wenn wichtige Geräte nicht mehr gesteuert werden können?

@paul53 sagte in iobroker hochverfügbar:

Was nutzt die Hochverfügbarkeit von ioBroker, wenn wichtige Geräte nicht mehr gesteuert werden können?

Das ist Salamitaktik, wie beim Testen. Wenn vollständig nicht geht, dann macht man das was geht. Besser als nicht starten.

Leider gibt es tatsächlich Quertreiber wie Zigbee, wo der Koordinator seine Schäfchen an sich bindet und ein Ersatz nicht vorgesehen ist.

Aber mit einem redundanten ioBroker hätte man zumindest Funktion während der Updates. Seit bei mir das gesamte Wohnungslicht über Zigbee und ioBroker läuft, bin ich da (noch) sensibler geworden.Aber zumindest habe ich bisher die Abhängigkeiten von USB für die Interfaces eliminiert. Smartmeter, RFLink und Zigbee laufen über TCP und können daher von verschiedenen Rechnern aus parallel angesprochen werden.

-

@darkiop wenn alles am gleichen Switch hängt ist ja erstmal easy mit Netzwerk. Die backplane hat meistens ne viel höhere Leistung. Dann user nur dein Switch halt auch ein SPOF :-)

@apollon77 sagte in iobroker hochverfügbar:

@darkiop wenn alles am gleichen Switch hängt ist ja erstmal easy mit Netzwerk. Die backplane hat meistens ne viel höhere Leistung. Dann user nur dein Switch halt auch ein SPOF :-)

Ja - das ist klar - aber das Risiko gehe ich erstmal ein.

Hab heut Morgen mit meinen 3 VMs mal mit GlusterFS gespielt, installation + config liefen ohne größere hürden. Doku im Anhang.

Aber eine Frage: GlusterFS kann nicht mit LXCs umgehen? Hast du das bei dir gelöst? Wenn ja, wie? :D

https://forum.proxmox.com/threads/container-on-gluster-volume-not-possible.40889/

-

@apollon77 sagte in iobroker hochverfügbar:

@darkiop wenn alles am gleichen Switch hängt ist ja erstmal easy mit Netzwerk. Die backplane hat meistens ne viel höhere Leistung. Dann user nur dein Switch halt auch ein SPOF :-)

Ja - das ist klar - aber das Risiko gehe ich erstmal ein.

Hab heut Morgen mit meinen 3 VMs mal mit GlusterFS gespielt, installation + config liefen ohne größere hürden. Doku im Anhang.

Aber eine Frage: GlusterFS kann nicht mit LXCs umgehen? Hast du das bei dir gelöst? Wenn ja, wie? :D

https://forum.proxmox.com/threads/container-on-gluster-volume-not-possible.40889/

@darkiop antworte ich dir heute Abend. Da muss ich an en Laptop. Da muss man bissl Tricksen. Und ja mir lxc soll es Performance technisch nicht ideal sein. Ich hatte bisher keine issues damit.

Die drei vms sind jetzt bei dir nicht HA sondern eine vm pro node fest. Gell? Mit Autostart on Boot? Dann könnte das vllt gehen.

Heißt du startest die vms mit dem proxmox node ind definierest das dann als glusterfs Host? Coole Idee.