NEWS

InfluxDB im Query unter _measurement keine Datenpunkte mehr

-

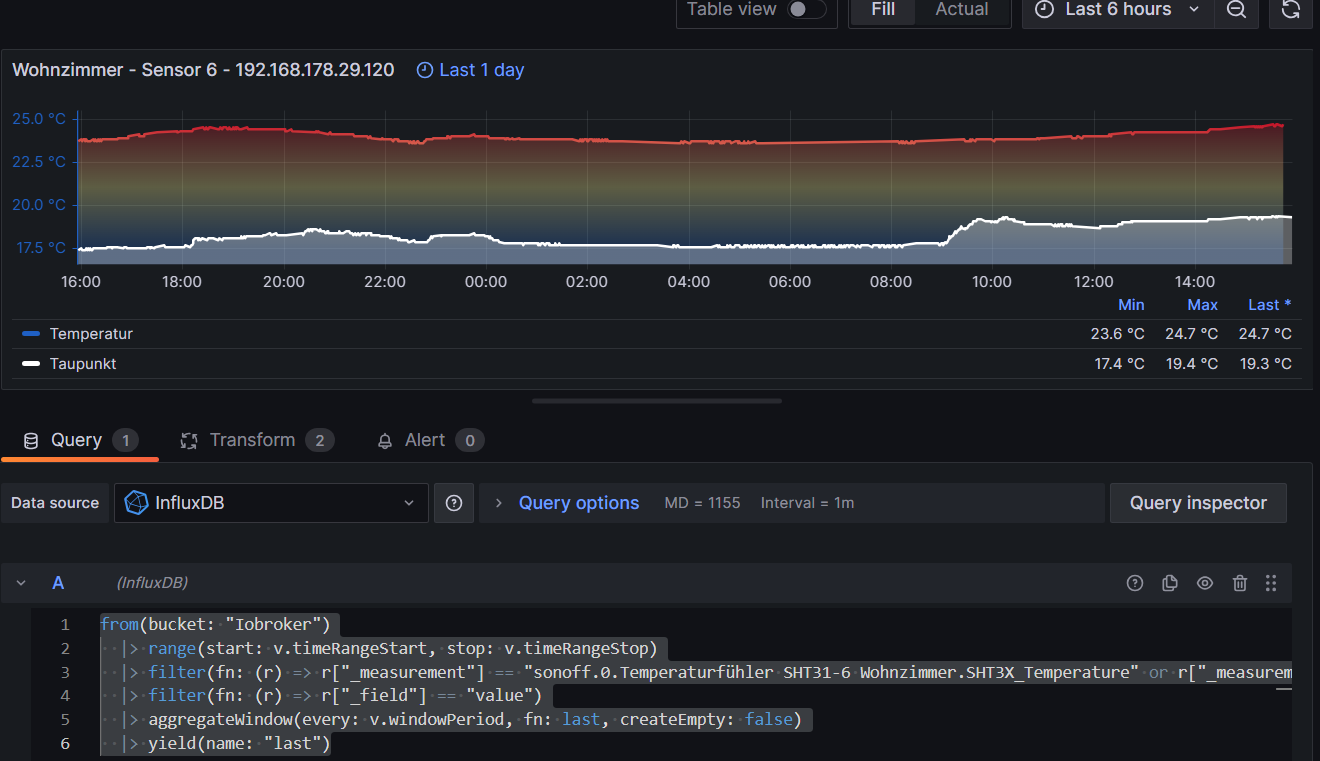

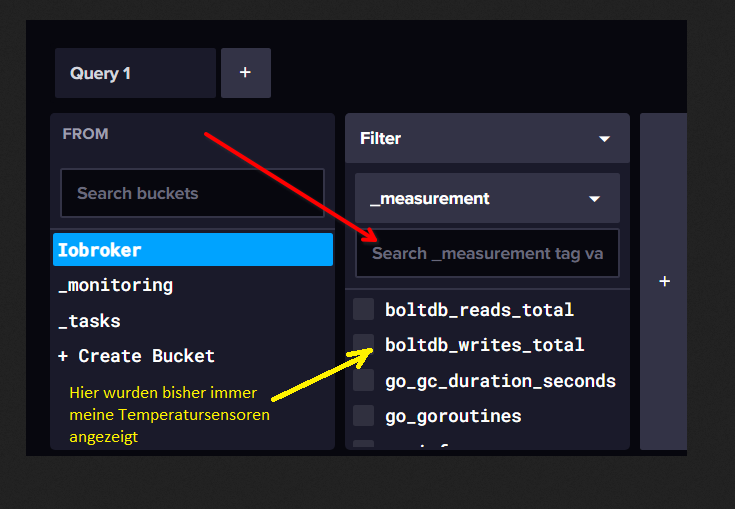

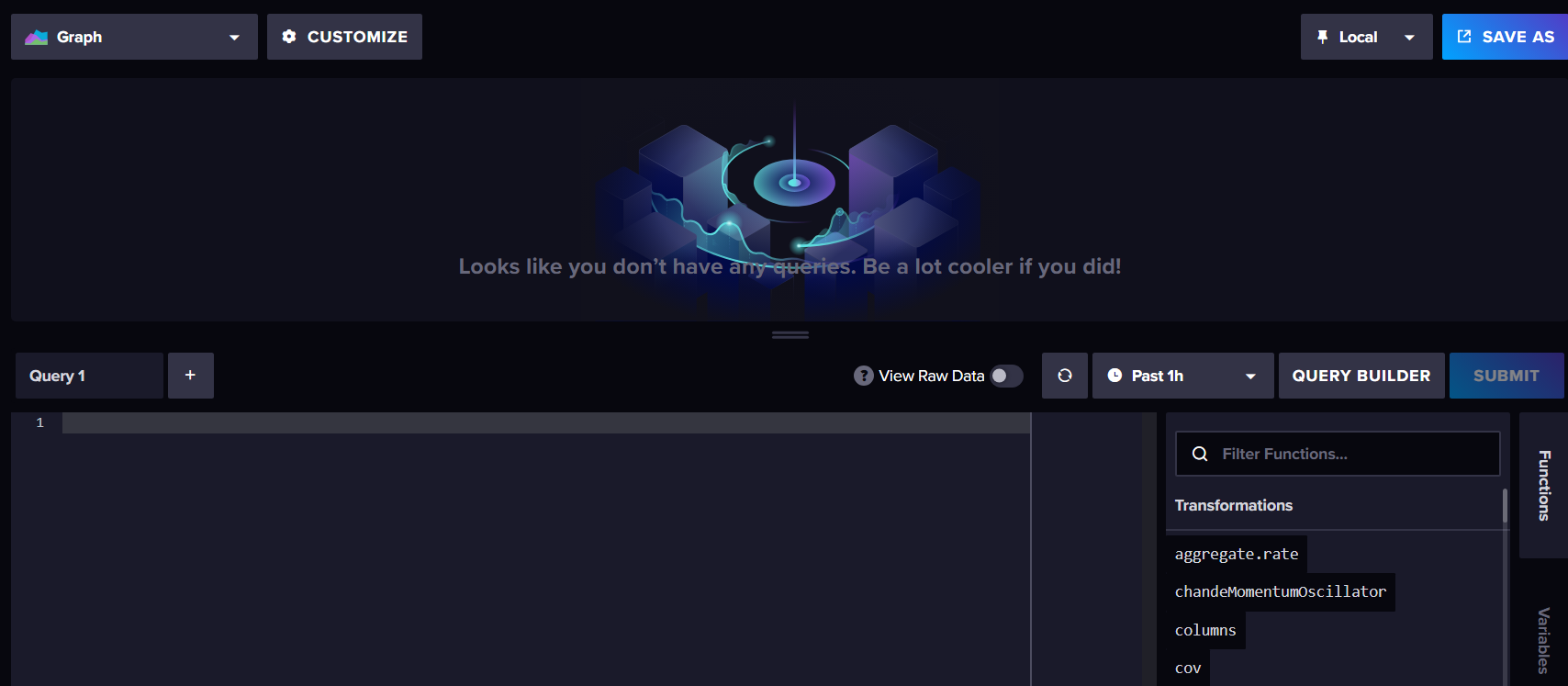

Ich habe das Problem das im InfluxDB, im Query unter _measurement meine Datenpunkte von meinen Temperatusnsoren nicht mehr angezeigt werden.

Ich weiß nicht was ich gemacht habe aber die Datenpunkte werden dort nicht mehr angezeigt.

Im Iobroker sind alle Sensoren unter Objekte Einstellungen mit Influx verbunden.

Beim Verbindungstest In den Instanzeinstellungen: influxdb.0 wird " OK " angezeigt

Vorhandene Grafana Visualisierungen bestehen weiterhin und werden auch weiterhin aktualisiert.

Es lassen sich nur keine neuen erstellen weil die Datenpunkte der Sensoren in InfluxDB nicht mehr angezeigt werden.

Kann mir da bitte jemand helfen.

Björn -

Ich habe das Problem das im InfluxDB, im Query unter _measurement meine Datenpunkte von meinen Temperatusnsoren nicht mehr angezeigt werden.

Ich weiß nicht was ich gemacht habe aber die Datenpunkte werden dort nicht mehr angezeigt.

Im Iobroker sind alle Sensoren unter Objekte Einstellungen mit Influx verbunden.

Beim Verbindungstest In den Instanzeinstellungen: influxdb.0 wird " OK " angezeigt

Vorhandene Grafana Visualisierungen bestehen weiterhin und werden auch weiterhin aktualisiert.

Es lassen sich nur keine neuen erstellen weil die Datenpunkte der Sensoren in InfluxDB nicht mehr angezeigt werden.

Kann mir da bitte jemand helfen.

Björn@geesthachter sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

Kann mir da bitte jemand helfen.

Moin,

keine Ahnung, aber fangen wir mal langsam an.

In der

influxDBWEB-GUI werden die Datenpunkte alphabetisch angezeigt, wenn das, wie im Grafana Bildsonoffsind, dann tauchen die auch nachgauf.Was passiert, wenn Du da mal einen Teil des Namens, den Du suchst, eintippst

VG

Bernd -

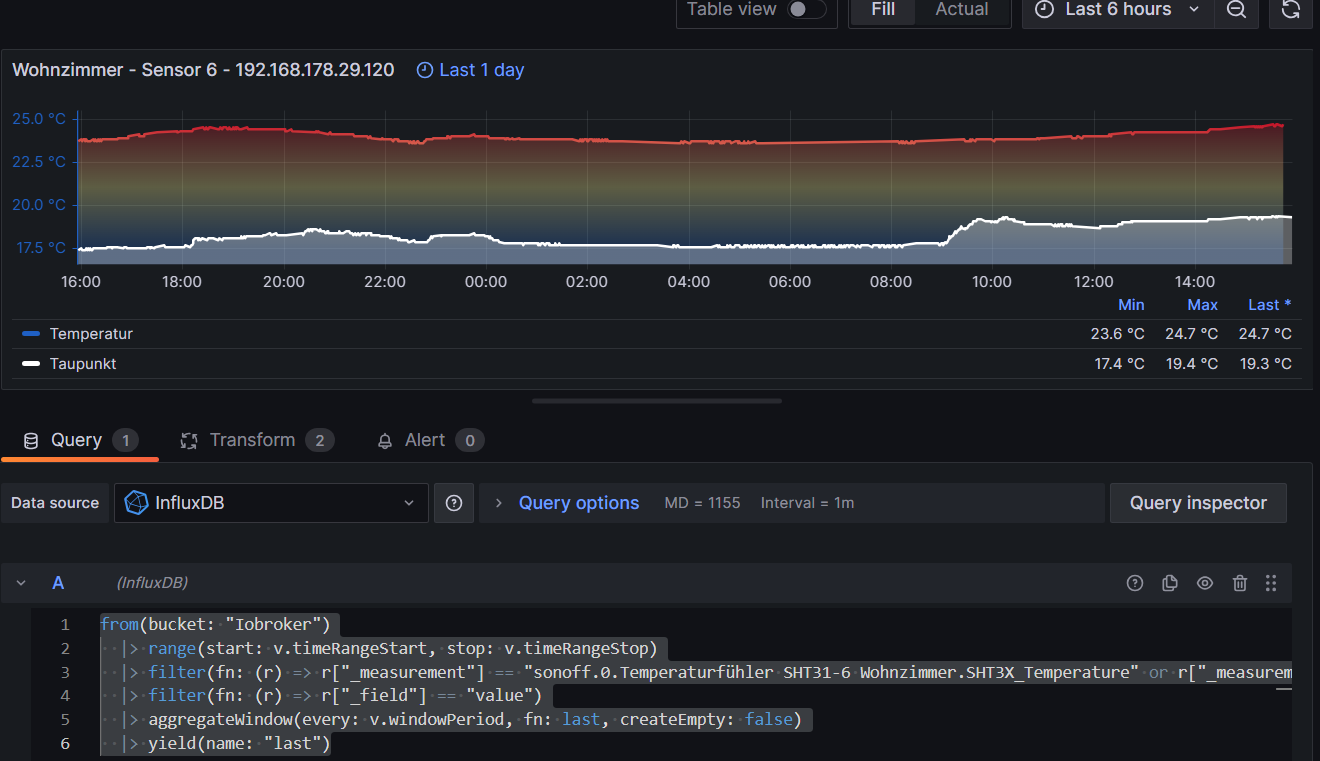

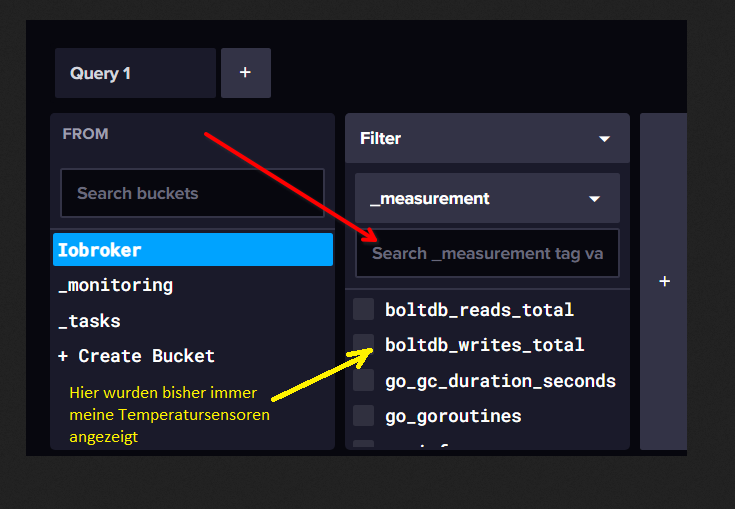

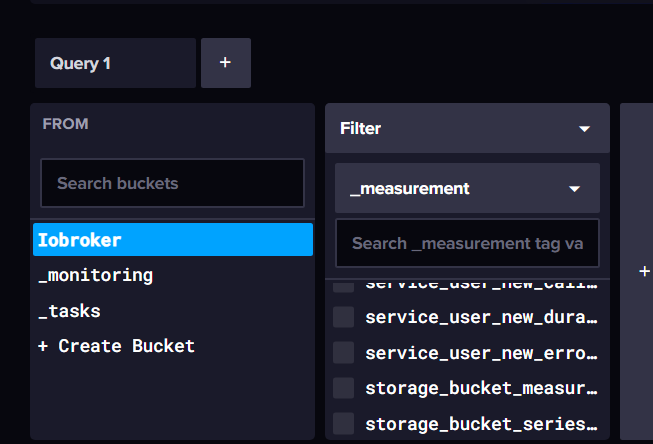

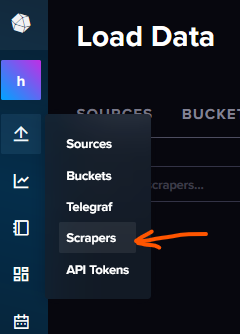

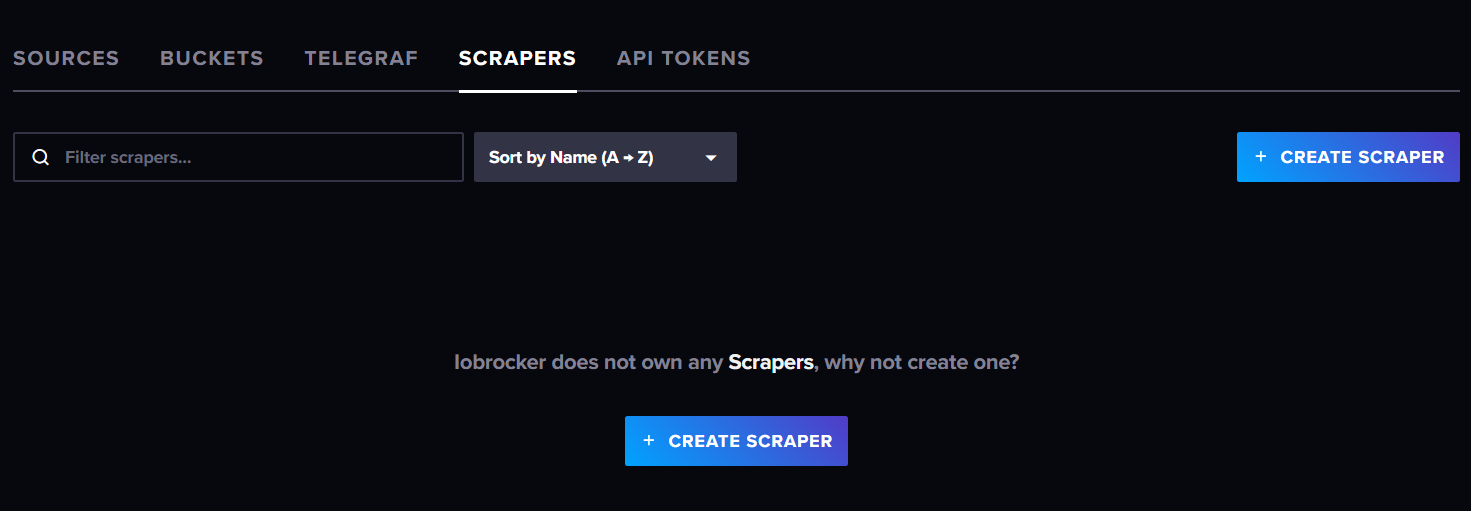

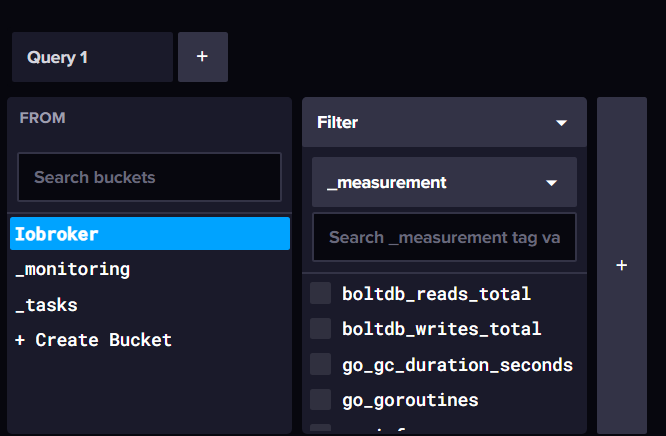

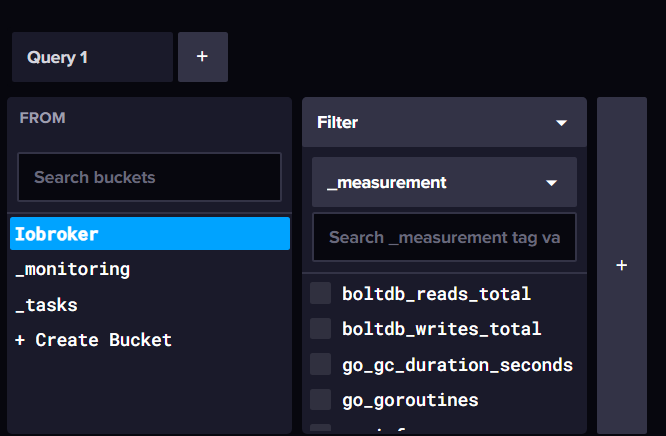

Abgesehen davon, was @dp20eic schon schreibt: Die Tatsache, dass du Measurements in deinem iobroker Bucket hast, die "boltdb..." usw. heißen, spricht dafür, dass du das Wegschreiben der metrics (Monitoring-Daten) aktiviert hast. Das passiert in der Regel, wenn man (warum auch immer) einen Scraper aktivert hat, der diese Daten sammelt.

Schau mal hier:

und lösche den Scraper, so er denn noch existiert. Denn sonst kommen hier große Mengen an Daten zusammen, die deine Datenbank vollmüllen.

-

@geesthachter sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

Kann mir da bitte jemand helfen.

Moin,

keine Ahnung, aber fangen wir mal langsam an.

In der

influxDBWEB-GUI werden die Datenpunkte alphabetisch angezeigt, wenn das, wie im Grafana Bildsonoffsind, dann tauchen die auch nachgauf.Was passiert, wenn Du da mal einen Teil des Namens, den Du suchst, eintippst

VG

Bernd@dp20eic

Runter gescrollt habe ich schon

Sonoff müsste dann ja zwischen service und storage auftauchen und wenn ich Sonoff als Suchbegriff eingebe taucht es auch nicht auf.

-

Abgesehen davon, was @dp20eic schon schreibt: Die Tatsache, dass du Measurements in deinem iobroker Bucket hast, die "boltdb..." usw. heißen, spricht dafür, dass du das Wegschreiben der metrics (Monitoring-Daten) aktiviert hast. Das passiert in der Regel, wenn man (warum auch immer) einen Scraper aktivert hat, der diese Daten sammelt.

Schau mal hier:

und lösche den Scraper, so er denn noch existiert. Denn sonst kommen hier große Mengen an Daten zusammen, die deine Datenbank vollmüllen.

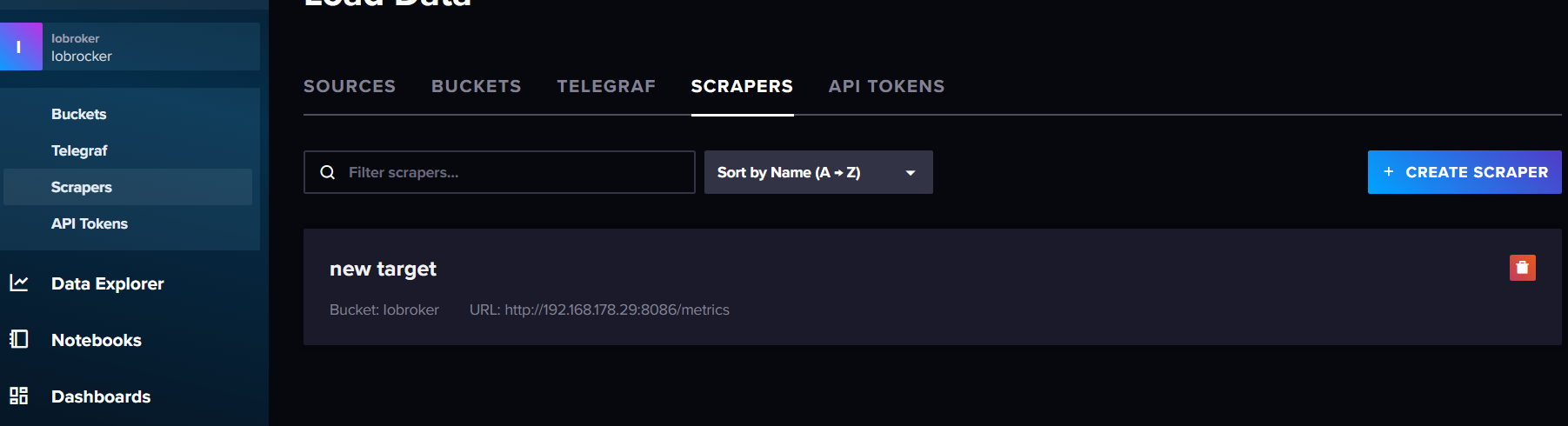

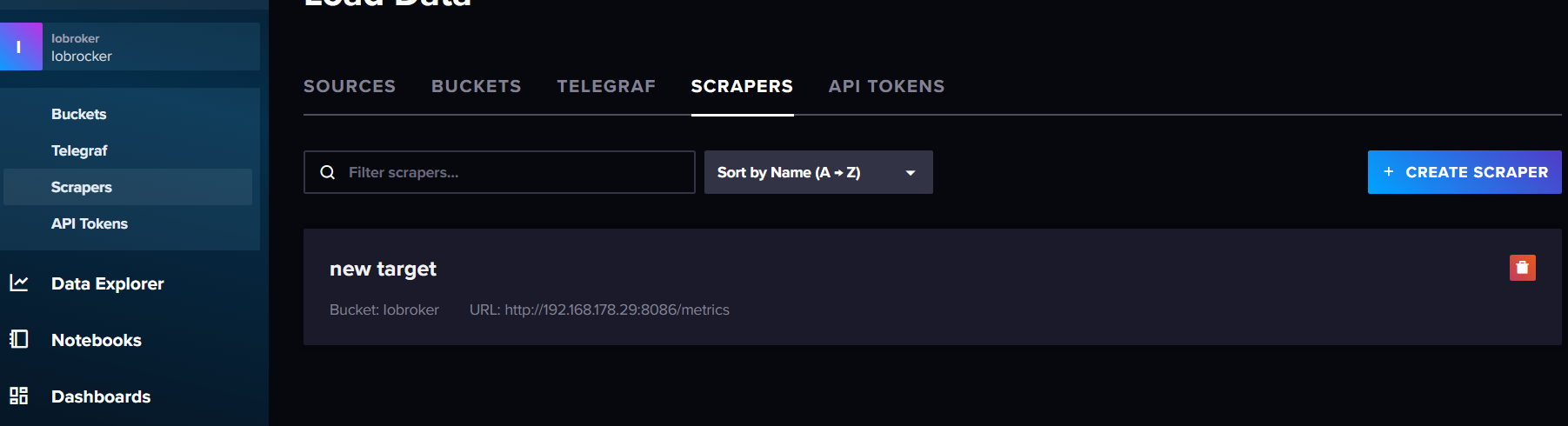

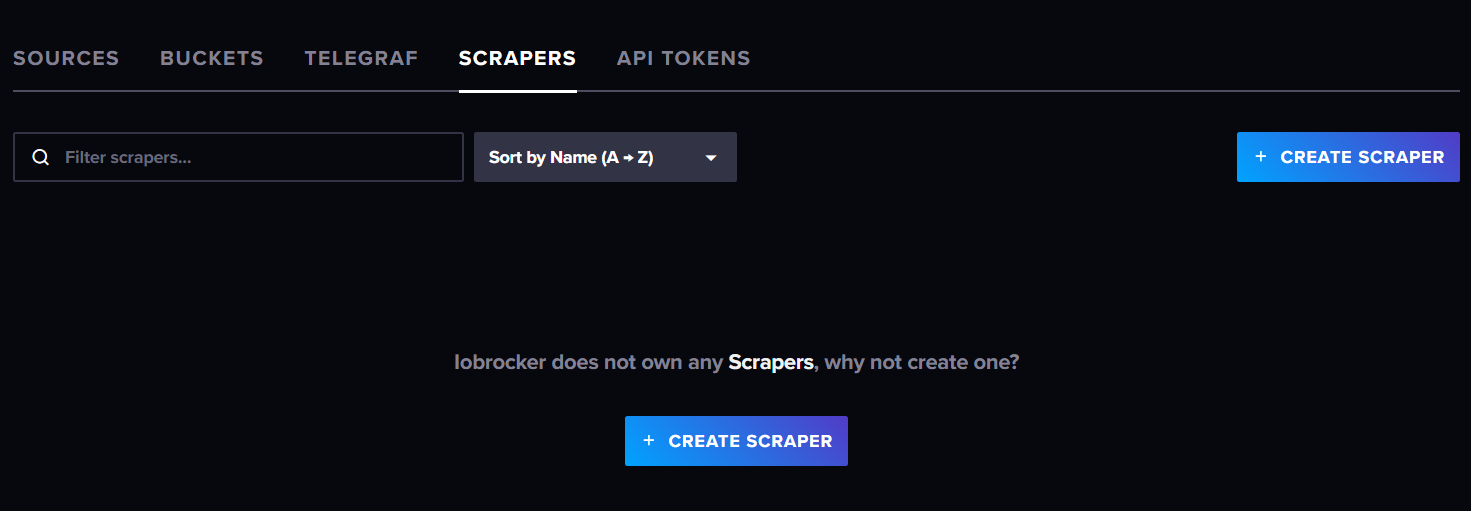

@marc-berg so sieht es bei mir dort aus.

das was da stand habe ich gelöscht.

jetzt sieht es dort so aus

Es hat sich aber nicht geändert

-

@marc-berg so sieht es bei mir dort aus.

das was da stand habe ich gelöscht.

jetzt sieht es dort so aus

Es hat sich aber nicht geändert

@geesthachter sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

Es hat sich aber nicht geändert

Korrekt. Die Daten, die bereits geschrieben wurden, verschwinden dadurch natürlich nicht. Es kommen aber keine weiteren dazu.

Die jetzt vorhandenen Measurements musst du manuell löschen.

-

@geesthachter sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

Es hat sich aber nicht geändert

Korrekt. Die Daten, die bereits geschrieben wurden, verschwinden dadurch natürlich nicht. Es kommen aber keine weiteren dazu.

Die jetzt vorhandenen Measurements musst du manuell löschen.

@marc-berg wie mach ich das?

-

@marc-berg wie mach ich das?

-

@marc-berg

ich steh da jetzt aufm Schlauch, Mach ich das ich über ssh?

oder irgendwo im InfluxDB? -

@marc-berg

ich steh da jetzt aufm Schlauch, Mach ich das ich über ssh?

oder irgendwo im InfluxDB?@geesthachter sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

ich steh da jetzt aufm Schlauch, Mach ich das ich über ssh?

oder irgendwo im InfluxDB?Moin,

das macht man auf der Kommandozeile, das sieht man ja am

influx delete --bucket iobroker --start '2022-03-18T19:03:00.000Z' --stop '2022-03-18T19:05:00.000Z' --predicate '_measurement="javascript.0.Solarertrag.Hour" AND exampleTag="-1.859"'Dazu muss aber auch auf dem Rechner, auf dem die

influxDBinstalliert ist auch nochinfluxdb2-cli o. influxdb2-clientinstalliert werden.VG

Bernd -

@geesthachter sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

ich steh da jetzt aufm Schlauch, Mach ich das ich über ssh?

oder irgendwo im InfluxDB?Moin,

das macht man auf der Kommandozeile, das sieht man ja am

influx delete --bucket iobroker --start '2022-03-18T19:03:00.000Z' --stop '2022-03-18T19:05:00.000Z' --predicate '_measurement="javascript.0.Solarertrag.Hour" AND exampleTag="-1.859"'Dazu muss aber auch auf dem Rechner, auf dem die

influxDBinstalliert ist auch nochinfluxdb2-cli o. influxdb2-clientinstalliert werden.VG

Bernd@dp20eic sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

@geesthachter sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

ich steh da jetzt aufm Schlauch, Mach ich das ich über ssh?

oder irgendwo im InfluxDB?Moin,

das macht man auf der Kommandozeile, das sieht man ja am

influx delete --bucket iobroker --start '2022-03-18T19:03:00.000Z' --stop '2022-03-18T19:05:00.000Z' --predicate '_measurement="javascript.0.Solarertrag.Hour" AND exampleTag="-1.859"'Dazu muss aber auch auf dem Rechner, auf dem die

influxDBinstalliert ist auch nochinfluxdb2-cli o. influxdb2-clientinstalliert werden.VG

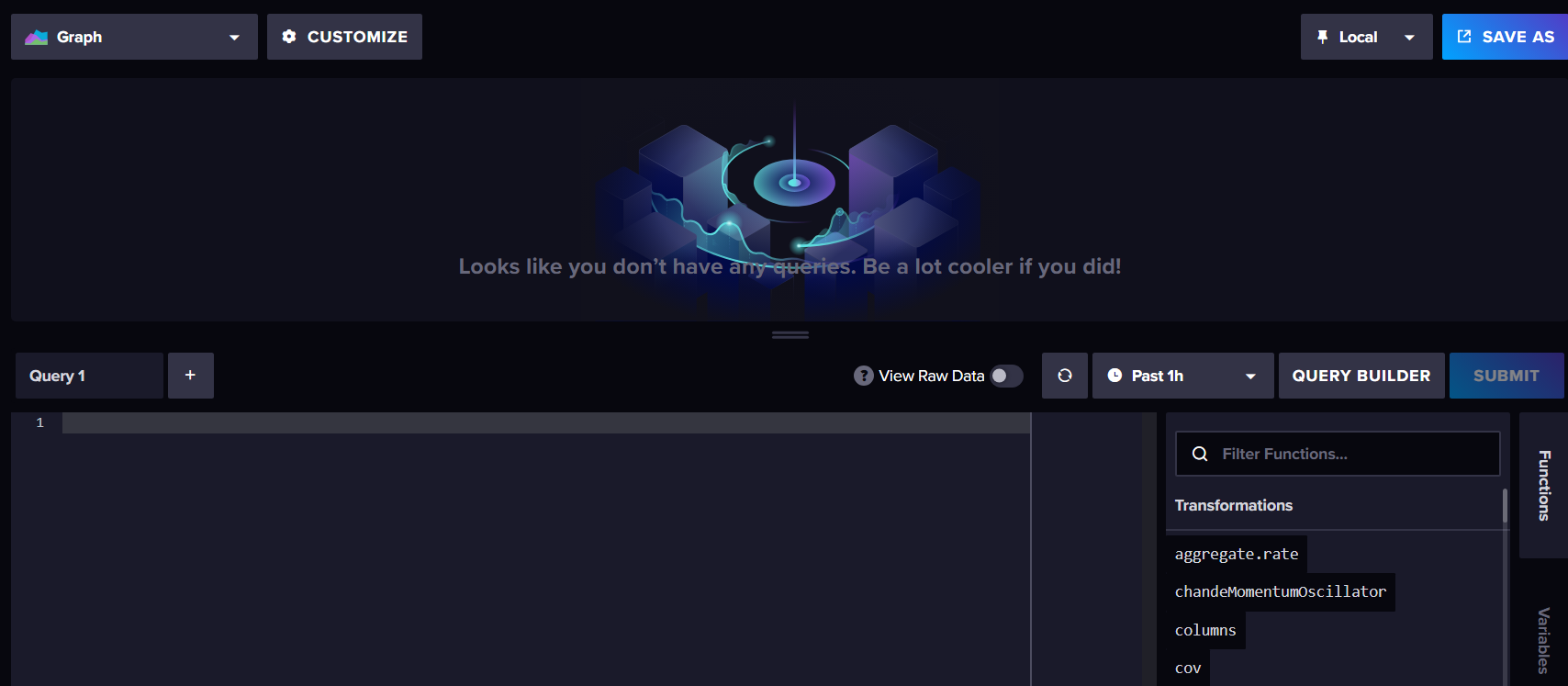

BerndMeinst du hier?

wird influxdb2-cli nicht bei der Installation von Influxdb mit installiert?

Influxdb ist bei mir auf einem Raspberry pi installiert. wo finde ich da die Kommandozeile? oder gebe ich es direkt über ssh im Startverzeichnis ein? -

@dp20eic sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

@geesthachter sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

ich steh da jetzt aufm Schlauch, Mach ich das ich über ssh?

oder irgendwo im InfluxDB?Moin,

das macht man auf der Kommandozeile, das sieht man ja am

influx delete --bucket iobroker --start '2022-03-18T19:03:00.000Z' --stop '2022-03-18T19:05:00.000Z' --predicate '_measurement="javascript.0.Solarertrag.Hour" AND exampleTag="-1.859"'Dazu muss aber auch auf dem Rechner, auf dem die

influxDBinstalliert ist auch nochinfluxdb2-cli o. influxdb2-clientinstalliert werden.VG

BerndMeinst du hier?

wird influxdb2-cli nicht bei der Installation von Influxdb mit installiert?

Influxdb ist bei mir auf einem Raspberry pi installiert. wo finde ich da die Kommandozeile? oder gebe ich es direkt über ssh im Startverzeichnis ein?@geesthachter sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

oder gebe ich es direkt über ssh im Startverzeichnis ein?

Moin,

die Kommandozeile ist das, wenn Du ein Terminal aufmachst, wenn Du ein RasPI hast, dann nutzt Du sicherlich

puttyvon Windows aus, um auf den RasPI zu kommen.@geesthachter sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

Meinst du hier?

Nein, das ist die WEB-GUI von

influxDB@geesthachter sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

wird influxdb2-cli nicht bei der Installation von Influxdb mit installiert?

Nein, das sind zwei unterschiedliche Pakete, normalerweise braucht man auf einem Datenbankserver nur den Datenbankmanager.

influxDB2ist der DatenbankmanagerinfluxDB2-Cli / influxDB2-clientsind die Kommandozeilen Tools, welche Du brauchst um von der Kommandozeile aus, den Datenbankmanager zu steuern und mit Daten zu arbeiten. Solltest DuBackitUpnutzen, dann hast Du sicherlich die Kommandozeilen Tools schon installiert, den der Adapter braucht die um ein Backup derinfluxDBzu erstellen.

influxdb2-cli 2.7.3-1 amd64 influxdb2-client 2.7.1-1 amd64 influxdb2 2.7.1-1 amd64Datenbankmanager von der Konsole:

$ influxd --help Start up the daemon configured with flags/env vars/config file. The order of precedence for config options are as follows (1 highest, 3 lowest): 1. flags 2. env vars 3. config file A config file can be provided via the INFLUXD_CONFIG_PATH env var. If a file is not provided via an env var, influxd will look in the current directory for a config.{json|toml|yaml|yml} file. If one does not exist, then it will continue unchanged. Usage: influxd [flags] influxd [command] Available Commands: downgrade Downgrade metadata schema used by influxd to match the expectations of an older release help Help about any command inspect Commands for inspecting on-disk database data recovery Commands used to recover / regenerate operator access to the DB run Start the influxd server upgrade Upgrade a 1.x version of InfluxDB version Print the influxd server version Flags: --assets-path string ....Datenbanktools

$ influx --help NAME: influx - Influx Client USAGE: influx [command] HINT: If you are looking for the InfluxQL shell from 1.x, run "influx v1 shell" COMMANDS: version Print the influx CLI version write Write points to InfluxDB bucket Bucket management commands completion Generates completion scripts query Execute a Flux query config Config management commands org, organization Organization management commands delete Delete points from InfluxDB user User management commands task Task management commands telegrafs List Telegraf configuration(s). Subcommands manage Telegraf configurations. dashboards List Dashboard(s). export Export existing resources as a template secret Secret management commands v1 InfluxDB v1 management commands auth, authorization Authorization management commands apply Apply a template to manage resources stacks List stack(s) and associated templates. Subcommands manage stacks. template Summarize the provided template bucket-schema Bucket schema management commands scripts Scripts management commands ping Check the InfluxDB /health endpoint setup Setup instance with initial user, org, bucket backup Backup database restore Restores a backup directory to InfluxDB remote Remote connection management commands replication Replication stream management commands server-config Display server config help, h Shows a list of commands or help for one commandVG

Bernd -

@geesthachter sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

oder gebe ich es direkt über ssh im Startverzeichnis ein?

Moin,

die Kommandozeile ist das, wenn Du ein Terminal aufmachst, wenn Du ein RasPI hast, dann nutzt Du sicherlich

puttyvon Windows aus, um auf den RasPI zu kommen.@geesthachter sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

Meinst du hier?

Nein, das ist die WEB-GUI von

influxDB@geesthachter sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

wird influxdb2-cli nicht bei der Installation von Influxdb mit installiert?

Nein, das sind zwei unterschiedliche Pakete, normalerweise braucht man auf einem Datenbankserver nur den Datenbankmanager.

influxDB2ist der DatenbankmanagerinfluxDB2-Cli / influxDB2-clientsind die Kommandozeilen Tools, welche Du brauchst um von der Kommandozeile aus, den Datenbankmanager zu steuern und mit Daten zu arbeiten. Solltest DuBackitUpnutzen, dann hast Du sicherlich die Kommandozeilen Tools schon installiert, den der Adapter braucht die um ein Backup derinfluxDBzu erstellen.

influxdb2-cli 2.7.3-1 amd64 influxdb2-client 2.7.1-1 amd64 influxdb2 2.7.1-1 amd64Datenbankmanager von der Konsole:

$ influxd --help Start up the daemon configured with flags/env vars/config file. The order of precedence for config options are as follows (1 highest, 3 lowest): 1. flags 2. env vars 3. config file A config file can be provided via the INFLUXD_CONFIG_PATH env var. If a file is not provided via an env var, influxd will look in the current directory for a config.{json|toml|yaml|yml} file. If one does not exist, then it will continue unchanged. Usage: influxd [flags] influxd [command] Available Commands: downgrade Downgrade metadata schema used by influxd to match the expectations of an older release help Help about any command inspect Commands for inspecting on-disk database data recovery Commands used to recover / regenerate operator access to the DB run Start the influxd server upgrade Upgrade a 1.x version of InfluxDB version Print the influxd server version Flags: --assets-path string ....Datenbanktools

$ influx --help NAME: influx - Influx Client USAGE: influx [command] HINT: If you are looking for the InfluxQL shell from 1.x, run "influx v1 shell" COMMANDS: version Print the influx CLI version write Write points to InfluxDB bucket Bucket management commands completion Generates completion scripts query Execute a Flux query config Config management commands org, organization Organization management commands delete Delete points from InfluxDB user User management commands task Task management commands telegrafs List Telegraf configuration(s). Subcommands manage Telegraf configurations. dashboards List Dashboard(s). export Export existing resources as a template secret Secret management commands v1 InfluxDB v1 management commands auth, authorization Authorization management commands apply Apply a template to manage resources stacks List stack(s) and associated templates. Subcommands manage stacks. template Summarize the provided template bucket-schema Bucket schema management commands scripts Scripts management commands ping Check the InfluxDB /health endpoint setup Setup instance with initial user, org, bucket backup Backup database restore Restores a backup directory to InfluxDB remote Remote connection management commands replication Replication stream management commands server-config Display server config help, h Shows a list of commands or help for one commandVG

Bernd@dp20eic sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

so sieht es bei mir aus, ja BackitUp nutze ich.

influxd --help

code_pi@raspberrypi:~ $ influxd --help Start up the daemon configured with flags/env vars/config file. The order of precedence for config options are as follows (1 highest, 3 lowest): 1. flags 2. env vars 3. config file A config file can be provided via the INFLUXD_CONFIG_PATH env var. If a file is not provided via an env var, influxd will look in the current directory for a config.{json|toml|yaml|yml} file. If one does not exist, then it will continue unchanged. Usage: influxd [flags] influxd [command] Available Commands: downgrade Downgrade metadata schema used by influxd to match the expectations of an older release help Help about any command inspect Commands for inspecting on-disk database data recovery Commands used to recover / regenerate operator access to the DB run Start the influxd server upgrade Upgrade a 1.x version of InfluxDB version Print the influxd server version Flags: --assets-path string override default assets by serving from a specific directory (developer mode) --bolt-path string path to boltdb database (default "/home/pi/.influxdbv2/influxd.bolt") --e2e-testing add /debug/flush endpoint to clear stores; used for end-to-end tests --engine-path string path to persistent engine files (default "/home/pi/.influxdbv2/engine") --feature-flags stringToString feature flag overrides (default []) --flux-log-enabled enables detailed logging for flux queries --hardening-enabled enable hardening options (disallow private IPs within flux and templates HTTP requests) -h, --help help for influxd --http-bind-address string bind address for the REST HTTP API (default ":8086") --http-idle-timeout duration max duration the server should keep established connections alive while waiting for new requests. Set to 0 for no timeout (default 3m0s) --http-read-header-timeout duration max duration the server should spend trying to read HTTP headers for new requests. Set to 0 for no timeout (default 10s) --http-read-timeout duration max duration the server should spend trying to read the entirety of new requests. Set to 0 for no timeout --http-write-timeout duration max duration the server should spend on processing+responding to requests. Set to 0 for no timeout --influxql-max-select-buckets int The maximum number of group by time bucket a SELECT can create. A value of zero will max the maximum number of buckets unlimited. --influxql-max-select-point int The maximum number of points a SELECT can process. A value of 0 will make the maximum point count unlimited. This will only be checked every second so queries will not be aborted immediately when hitting the limit. --influxql-max-select-series int The maximum number of series a SELECT can run. A value of 0 will make the maximum series count unlimited. --instance-id string add an instance id for replications to prevent collisions and allow querying by edge node --log-level Log-Level supported log levels are debug, info, and error (default info) --metrics-disabled Don't expose metrics over HTTP at /metrics --no-tasks disables the task scheduler --pprof-disabled Don't expose debugging information over HTTP at /debug/pprof --query-concurrency int32 the number of queries that are allowed to execute concurrently. Set to 0 to allow an unlimited number of concurrent queries (default 1024) --query-initial-memory-bytes int the initial number of bytes allocated for a query when it is started. If this is unset, then query-memory-bytes will be used --query-max-memory-bytes int the maximum amount of memory used for queries. Can only be set when query-concurrency is limited. If this is unset, then this number is query-concurrency * query-memory-bytes --query-memory-bytes int maximum number of bytes a query is allowed to use at any given time. This must be greater or equal to query-initial-memory-bytes --query-queue-size int32 the number of queries that are allowed to be awaiting execution before new queries are rejected. Must be > 0 if query-concurrency is not unlimited (default 1024) --reporting-disabled disable sending telemetry data to https://telemetry.influxdata.com every 8 hours --secret-store string data store for secrets (bolt or vault) (default "bolt") --session-length int ttl in minutes for newly created sessions (default 60) --session-renew-disabled disables automatically extending session ttl on request --sqlite-path string path to sqlite database. if not set, sqlite database will be stored in the bolt-path directory as "influxd.sqlite". --storage-cache-max-memory-size Size The maximum size a shard's cache can reach before it starts rejecting writes. (default 1.0 GiB) --storage-cache-snapshot-memory-size Size The size at which the engine will snapshot the cache and write it to a TSM file, freeing up memory. (default 25 MiB) --storage-cache-snapshot-write-cold-duration Duration The length of time at which the engine will snapshot the cache and write it to a new TSM file if the shard hasn't received writes or deletes. (default 10m0s) --storage-compact-full-write-cold-duration Duration The duration at which the engine will compact all TSM files in a shard if it hasn't received a write or delete. (default 4h0m0s) --storage-compact-throughput-burst Size The rate limit in bytes per second that we will allow TSM compactions to write to disk. (default 48 MiB) --storage-max-concurrent-compactions int The maximum number of concurrent full and level compactions that can run at one time. A value of 0 results in 50% of runtime.GOMAXPROCS(0) used at runtime. Any number greater than 0 limits compactions to that value. This setting does not apply to cache snapshotting. --storage-max-index-log-file-size Size The threshold, in bytes, when an index write-ahead log file will compact into an index file. Lower sizes will cause log files to be compacted more quickly and result in lower heap usage at the expense of write throughput. (default 1.0 MiB) --storage-no-validate-field-size Skip field-size validation on incoming writes. --storage-retention-check-interval Duration The interval of time when retention policy enforcement checks run. (default 30m0s) --storage-series-file-max-concurrent-snapshot-compactions int The maximum number of concurrent snapshot compactions that can be running at one time across all series partitions in a database. --storage-series-id-set-cache-size int The size of the internal cache used in the TSI index to store previously calculated series results. --storage-shard-precreator-advance-period Duration The default period ahead of the endtime of a shard group that its successor group is created. (default 30m0s) --storage-shard-precreator-check-interval Duration The interval of time when the check to pre-create new shards runs. (default 10m0s) --storage-tsm-use-madv-willneed Controls whether we hint to the kernel that we intend to page in mmap'd sections of TSM files. --storage-validate-keys Validates incoming writes to ensure keys only have valid unicode characters. --storage-wal-fsync-delay Duration The amount of time that a write will wait before fsyncing. A duration greater than 0 can be used to batch up multiple fsync calls. This is useful for slower disks or when WAL write contention is seen. (default 0s) --storage-wal-max-concurrent-writes int The max number of writes that will attempt to write to the WAL at a time. (default <nprocs> * 2) --storage-wal-max-write-delay storage-wal-max-concurrent-writes The max amount of time a write will wait when the WAL already has storage-wal-max-concurrent-writes active writes. Set to 0 to disable the timeout. (default 10m0s) --storage-write-timeout duration The max amount of time the engine will spend completing a write request before cancelling with a timeout. (default 10s) --store string backing store for REST resources (disk or memory) (default "disk") --testing-always-allow-setup ensures the /api/v2/setup endpoint always returns true to allow onboarding --tls-cert string TLS certificate for HTTPs --tls-key string TLS key for HTTPs --tls-min-version string Minimum accepted TLS version (default "1.2") --tls-strict-ciphers Restrict accept ciphers to: ECDHE_ECDSA_WITH_AES_128_GCM_SHA256, ECDHE_RSA_WITH_AES_128_GCM_SHA256, ECDHE_ECDSA_WITH_AES_256_GCM_SHA384, ECDHE_RSA_WITH_AES_256_GCM_SHA384, ECDHE_ECDSA_WITH_CHACHA20_POLY1305, ECDHE_RSA_WITH_CHACHA20_POLY1305 --tracing-type string supported tracing types are log, jaeger --ui-disabled Disable the InfluxDB UI --vault-addr string address of the Vault server expressed as a URL and port, for example: https://127.0.0.1:8200/. --vault-cacert string path to a PEM-encoded CA certificate file on the local disk. This file is used to verify the Vault server's SSL certificate. This environment variable takes precedence over VAULT_CAPATH. --vault-capath string path to a directory of PEM-encoded CA certificate files on the local disk. These certificates are used to verify the Vault server's SSL certificate. --vault-client-cert string path to a PEM-encoded client certificate on the local disk. This file is used for TLS communication with the Vault server. --vault-client-key string path to an unencrypted, PEM-encoded private key on disk which corresponds to the matching client certificate. --vault-client-timeout duration timeout variable. The default value is 60s. --vault-max-retries int maximum number of retries when a 5xx error code is encountered. The default is 2, for three total attempts. Set this to 0 or less to disable retrying. --vault-skip-verify do not verify Vault's presented certificate before communicating with it. Setting this variable is not recommended and voids Vault's security model. --vault-tls-server-name string name to use as the SNI host when connecting via TLS. --vault-token string vault authentication token Use "influxd [command] --help" for more information about a command. -

ehrlich gesagt weiß ich dennoch nicht was ich jetzt machen soll

-

ehrlich gesagt weiß ich dennoch nicht was ich jetzt machen soll

@geesthachter sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

ehrlich gesagt weiß ich dennoch nicht was ich jetzt machen soll

Moin,

das ist doch ganz einfach, geh mit

puttyoder wie auch immer persshauf Dein RasPI, dann suchst Du Dir in der WEB-GUI diemeasurementsraus, die Du löschen willst und rufst dann den Befehl mit dem zu löschendenmeasurementaufinflux delete --bucket "hier Dein Name des Buckets" --start '1970-01-01T00:00:00.000Z' --stop 'now' --predicate '_measurement="hier das zu löschende measurement"'Das musst Du dann für alle

measurementsdie Du löschen willst, wiederholen.Oder Du installierst Dir auf einem Win Rechner

InfluxDBStudiound löscht damit https://github.com/CymaticLabs/InfluxDBStudioVG

Bernd -

@geesthachter sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

ehrlich gesagt weiß ich dennoch nicht was ich jetzt machen soll

Moin,

das ist doch ganz einfach, geh mit

puttyoder wie auch immer persshauf Dein RasPI, dann suchst Du Dir in der WEB-GUI diemeasurementsraus, die Du löschen willst und rufst dann den Befehl mit dem zu löschendenmeasurementaufinflux delete --bucket "hier Dein Name des Buckets" --start '1970-01-01T00:00:00.000Z' --stop 'now' --predicate '_measurement="hier das zu löschende measurement"'Das musst Du dann für alle

measurementsdie Du löschen willst, wiederholen.Oder Du installierst Dir auf einem Win Rechner

InfluxDBStudiound löscht damit https://github.com/CymaticLabs/InfluxDBStudioVG

Bernd@dp20eic sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

Oder Du installierst Dir auf einem Win Rechner InfluxDBStudio und löscht damit https://github.com/CymaticLabs/InfluxDBStudio

funktioniert doch nur mit influxdb1.x, aber nicht mit v2.x

-

@dp20eic sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

Oder Du installierst Dir auf einem Win Rechner InfluxDBStudio und löscht damit https://github.com/CymaticLabs/InfluxDBStudio

funktioniert doch nur mit influxdb1.x, aber nicht mit v2.x

@crunchip sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

funktioniert doch nur mit influxdb1.x, aber nicht mit v2.x

Moin,

hab ich dann wohl beim Überfliegen übersehen, also doch am besten auf der Kommandozeile.

VG

Bernd -

@crunchip sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

funktioniert doch nur mit influxdb1.x, aber nicht mit v2.x

Moin,

hab ich dann wohl beim Überfliegen übersehen, also doch am besten auf der Kommandozeile.

VG

Bernd@dp20eic sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

@crunchip sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

funktioniert doch nur mit influxdb1.x, aber nicht mit v2.x

Moin,

hab ich dann wohl beim Überfliegen übersehen, also doch am besten auf der Kommandozeile.

VG

BerndDanke für deine Hilfe, mein Bucket heißt Iobroker

das habe ich hier mal eingetragen aber was meinst du mit dem zu löschenden masurement?code_influx delete --bucket Iobroker --start '1970-01-01T00:00:00.000Z' --stop 'now' --predicate '_measurement="hier das zu löschende measurement"'

-

@dp20eic sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

@crunchip sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

funktioniert doch nur mit influxdb1.x, aber nicht mit v2.x

Moin,

hab ich dann wohl beim Überfliegen übersehen, also doch am besten auf der Kommandozeile.

VG

BerndDanke für deine Hilfe, mein Bucket heißt Iobroker

das habe ich hier mal eingetragen aber was meinst du mit dem zu löschenden masurement?code_influx delete --bucket Iobroker --start '1970-01-01T00:00:00.000Z' --stop 'now' --predicate '_measurement="hier das zu löschende measurement"'

@geesthachter sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

was meinst du mit dem zu löschenden masurement?

in deinem unteren screen stehn doch die measurement(Datenpunkte) diesen musst du in die Zeile einfügen

und das für jeden einzelnen, den du löschen möchtest -

@geesthachter sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

was meinst du mit dem zu löschenden masurement?

in deinem unteren screen stehn doch die measurement(Datenpunkte) diesen musst du in die Zeile einfügen

und das für jeden einzelnen, den du löschen möchtest@crunchip sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

@geesthachter sagte in InfluxDB im Query unter _measurement keine Datenpunkte mehr:

was meinst du mit dem zu löschenden masurement?

in deinem unteren screen stehn doch die measurement(Datenpunkte) diesen musst du in die Zeile einfügen

und das für jeden einzelnen, den du löschen möchtestcode_pi@raspberrypi:~ $ influx delete --bucket Iobroker --start '1970-01-01T00:00:00.000Z' --stop 'now' --predicate '_measurement="boltdb_reads_total"' Error: must specify org ID or org nameWas mache ich falsch?

Ich bekomme eine Fehlermeldung