NEWS

influxdb cloud Daten importieren

-

@glasfaser

Kann man nicht die Daten unter Umständen in eine CSV exportieren und dann in der V2 wieder einlesen?Moin,

ja, natürlich geht das. Aber wieso noch umständlicher, so wie das bei

influxDBbeschrieben ist, muss das gehen.VG

Bernd -

Moin,

ja, natürlich geht das. Aber wieso noch umständlicher, so wie das bei

influxDBbeschrieben ist, muss das gehen.VG

Bernd -

@dp20eic

Dann warte ich mal auf deinen Test... wenn es bei dir läuft finde ich vielleicht ja meinen Fehler.gern, Frauchen ist morgen Arbeiten, da hab ich etwas Zeit zum Spielen, ähm Lernen :)

VG

Bernd -

@glasfaser said in influxdb cloud Daten importieren:

@dirk_1930 sagte in influxdb cloud Daten importieren:

allerdings schreibt er keine Daten...

Test mit lp :

sudo influx_inspect export -database iobroker -datadir /var/lib/influxdb/data -waldir /var/lib/influxdb/wal -retention autogen -out /tmp/iobroker_backup/influxv1backup.lp -lponlyauch nicht so !?

Jetzt passiert etwas

writing out tsm file data for iobroker/autogen...allerdings hört er nicht auf, und das Verzeichnis kann ich nicht aufrufen um zu sehen was drin steht :-(

Linux ist nicht wirklich meine Stärke...

@dirk_1930 sagte in influxdb cloud Daten importieren:

Jetzt passiert etwas

writing out tsm file data for iobroker/autogen...allerdings hört er nicht auf, und das Verzeichnis kann ich nicht aufrufen um zu sehen was drin steht

Moin,

den export habe ich auch gerade einmal gemacht, läuft bei mir durch, das Dauert etwas

Das ist was ich aufgerufen habe, ohne

-retentionaber dafür mit-compresssudo influx_inspect export -lponly -datadir /var/lib/influxdb/data/ -waldir /var/lib/influxdb/wal/ -database iobroker -compress -out /tmp/data/iobroker-lp.gzip writing out tsm file data for iobroker/global...complete. writing out wal file data for iobroker/global...complete.Ich glaube, das das

-retentionnicht gebraucht wird, es seiden Du hast für die Datenbanken eineretention policieserstellt, default ist* -retention flag with a specific retention policy to export. By default, all retention policies are exported.Und bei solchen Aktionen, immer eine zweite

sshSession auf haben, zum schauen was sich da so tut!Also dieser Schritt funktioniert erst einmal.

VG

Bernd -

@dirk_1930 sagte in influxdb cloud Daten importieren:

Jetzt passiert etwas

writing out tsm file data for iobroker/autogen...allerdings hört er nicht auf, und das Verzeichnis kann ich nicht aufrufen um zu sehen was drin steht

Moin,

den export habe ich auch gerade einmal gemacht, läuft bei mir durch, das Dauert etwas

Das ist was ich aufgerufen habe, ohne

-retentionaber dafür mit-compresssudo influx_inspect export -lponly -datadir /var/lib/influxdb/data/ -waldir /var/lib/influxdb/wal/ -database iobroker -compress -out /tmp/data/iobroker-lp.gzip writing out tsm file data for iobroker/global...complete. writing out wal file data for iobroker/global...complete.Ich glaube, das das

-retentionnicht gebraucht wird, es seiden Du hast für die Datenbanken eineretention policieserstellt, default ist* -retention flag with a specific retention policy to export. By default, all retention policies are exported.Und bei solchen Aktionen, immer eine zweite

sshSession auf haben, zum schauen was sich da so tut!Also dieser Schritt funktioniert erst einmal.

VG

Bernd -

Moin,

habe mir gestern mal einen Account angelegt und auch soweit eingerichtet.

Das Problem, das ich noch habe ist, das ich die Daten nicht rein bekomme 🤔

Erst war es ein Problem, das er die Datei nicht wollte wegen "text/plain, UTF-8", das habe ich aber hinbekommen, dann waren ihm die Daten(Struktur) wohl nicht genehm :)

Hab noch etwas gegooglet, bin gerade dran es noch mal zu versuchen :) Wurmt mich wenn etwas nicht funktioniert :)VG

Bernd -

Moin,

habe mir gestern mal einen Account angelegt und auch soweit eingerichtet.

Das Problem, das ich noch habe ist, das ich die Daten nicht rein bekomme 🤔

Erst war es ein Problem, das er die Datei nicht wollte wegen "text/plain, UTF-8", das habe ich aber hinbekommen, dann waren ihm die Daten(Struktur) wohl nicht genehm :)

Hab noch etwas gegooglet, bin gerade dran es noch mal zu versuchen :) Wurmt mich wenn etwas nicht funktioniert :)VG

Bernd -

Moin,

ich bastel an der Kombi von

influxdb V 1.8-->influxdb CloudAber ich kapiere es noch nich, denn obwohl er mir alles mittels

influx_inspectexportiert[dp20eic@influxDB ~]$ mkdir -p /tmp/data && sudo influx_inspect export -lponly -datadir /var/lib/influxdb/data/ -waldir /var/lib/influxdb/wal/ -database iobroker -retention global -out /tmp/data/chronograf-lp --compress gzipBekomme ich beim schreiben in die Cloud, ist jetzt nicht der original output, da ich zwischenzeitlich noch experimentiert habe

$ influx write --bucket influxdb/global --file /tmp/data/iobroker-lp --header "Content-Type: text/plain; charset=utf-8" --compression 2023/02/07 14:12:38 line 2: no measurement column found 2023/02/07 14:12:38 line 3: no measurement column found 2023/02/07 14:12:38 Unable to batcher to error-file: invalid argument 2023/02/07 14:12:38 line 4: no measurement column found 2023/02/07 14:12:38 Unable to batcher to error-file: invalid argument 2023/02/07 14:12:38 line 5: no measurement column found 2023/02/07 14:12:38 Unable to batcher to error-file: invalid argument 2023/02/07 14:12:38 line 6: no measurement column foundIch habe mir mal ein Beispiel gesucht

$ cat /tmp/data/example-lp mem,host=host1 used_percent=23.43234543 1556892576842902000 cpu,host=host1 usage_user=3.8234,usage_system=4.23874 1556892726597397000 mem,host=host1 used_percent=21.83599203 1556892777007291000Nur da bekomme ich auch

15:01:09 dp20eic@test ~ $ influx write --bucket proxmox/autogen --file /tmp/data/example-lp --header "Content-Type: text/plain; charset=utf-8" 2023/02/07 15:02:22 line 2: no measurement column found 2023/02/07 15:02:22 line 3: no measurement column found 2023/02/07 15:02:22 Unable to batcher to error-file: invalid argument 2023/02/07 15:02:22 line 4: no measurement column found 2023/02/07 15:02:22 Unable to batcher to error-file: invalid argumentVG

BerndEdit: Falsches Zeilen, kopiert 🤭

Edit: Aber auch mit dem korrekten Datenmem,host=host1 used_percent=64.23 1577836800000000000 mem,host=host2 used_percent=72.01 1577836800000000000 mem,host=host1 used_percent=62.61 1577836810000000000 mem,host=host2 used_percent=72.98 1577836810000000000 mem,host=host1 used_percent=63.40 1577836820000000000 mem,host=host2 used_percent=73.77 1577836820000000000kommt noch immer die Meldung:

Man bin ich ein döspaddel, es klappt :)

-

Moin,

ich bastel an der Kombi von

influxdb V 1.8-->influxdb CloudAber ich kapiere es noch nich, denn obwohl er mir alles mittels

influx_inspectexportiert[dp20eic@influxDB ~]$ mkdir -p /tmp/data && sudo influx_inspect export -lponly -datadir /var/lib/influxdb/data/ -waldir /var/lib/influxdb/wal/ -database iobroker -retention global -out /tmp/data/chronograf-lp --compress gzipBekomme ich beim schreiben in die Cloud, ist jetzt nicht der original output, da ich zwischenzeitlich noch experimentiert habe

$ influx write --bucket influxdb/global --file /tmp/data/iobroker-lp --header "Content-Type: text/plain; charset=utf-8" --compression 2023/02/07 14:12:38 line 2: no measurement column found 2023/02/07 14:12:38 line 3: no measurement column found 2023/02/07 14:12:38 Unable to batcher to error-file: invalid argument 2023/02/07 14:12:38 line 4: no measurement column found 2023/02/07 14:12:38 Unable to batcher to error-file: invalid argument 2023/02/07 14:12:38 line 5: no measurement column found 2023/02/07 14:12:38 Unable to batcher to error-file: invalid argument 2023/02/07 14:12:38 line 6: no measurement column foundIch habe mir mal ein Beispiel gesucht

$ cat /tmp/data/example-lp mem,host=host1 used_percent=23.43234543 1556892576842902000 cpu,host=host1 usage_user=3.8234,usage_system=4.23874 1556892726597397000 mem,host=host1 used_percent=21.83599203 1556892777007291000Nur da bekomme ich auch

15:01:09 dp20eic@test ~ $ influx write --bucket proxmox/autogen --file /tmp/data/example-lp --header "Content-Type: text/plain; charset=utf-8" 2023/02/07 15:02:22 line 2: no measurement column found 2023/02/07 15:02:22 line 3: no measurement column found 2023/02/07 15:02:22 Unable to batcher to error-file: invalid argument 2023/02/07 15:02:22 line 4: no measurement column found 2023/02/07 15:02:22 Unable to batcher to error-file: invalid argumentVG

BerndEdit: Falsches Zeilen, kopiert 🤭

Edit: Aber auch mit dem korrekten Datenmem,host=host1 used_percent=64.23 1577836800000000000 mem,host=host2 used_percent=72.01 1577836800000000000 mem,host=host1 used_percent=62.61 1577836810000000000 mem,host=host2 used_percent=72.98 1577836810000000000 mem,host=host1 used_percent=63.40 1577836820000000000 mem,host=host2 used_percent=73.77 1577836820000000000kommt noch immer die Meldung:

Man bin ich ein döspaddel, es klappt :)

@dp20eic

So ich Antworte mir mal selber, um zu beschreiben was, habe ich wie gemacht, um Daten aus einer lokalen

influxdb V1.8in dieinflux-Cloudzu bekommen.!!! Achtung !!!

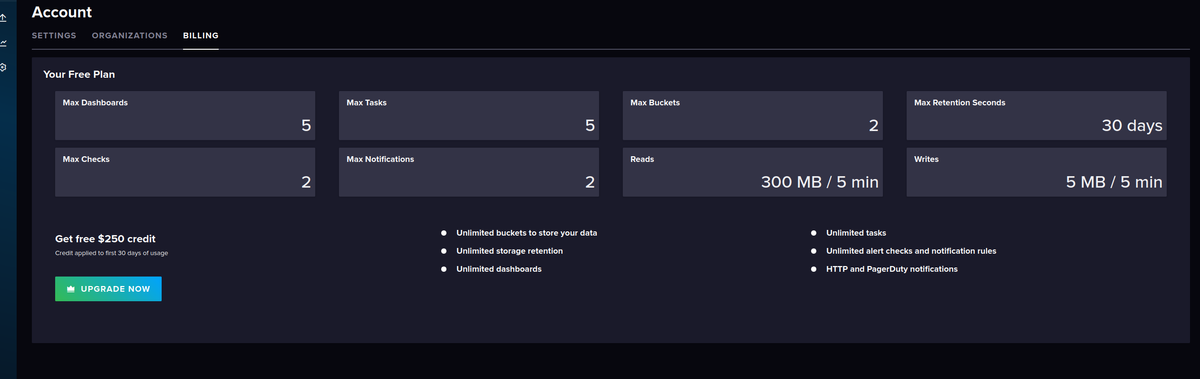

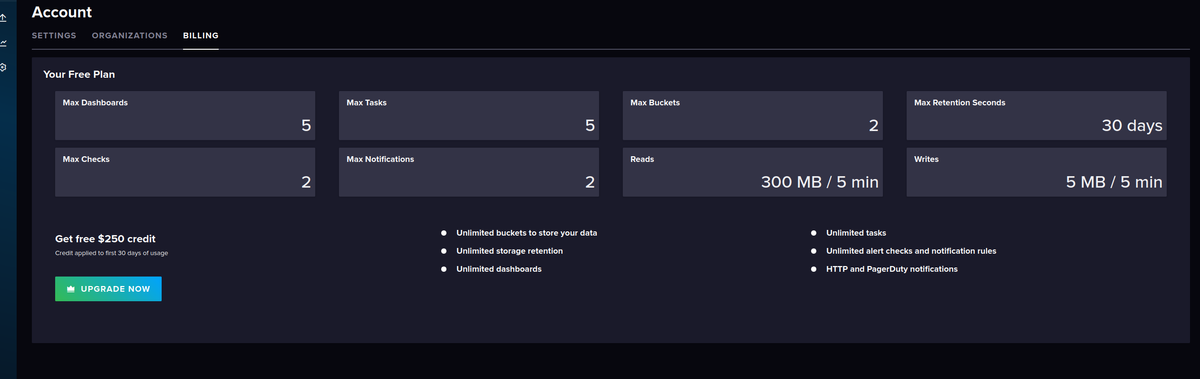

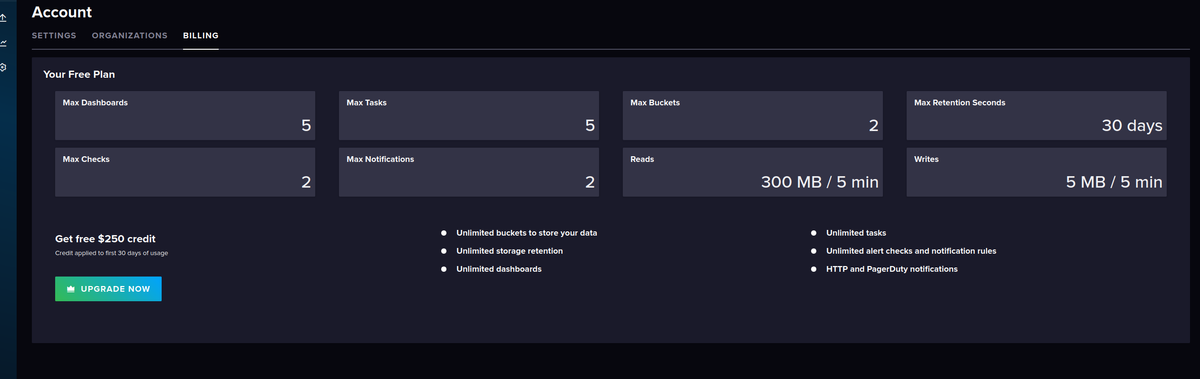

Folgende Einschränkungen, in der freeinfluxdb - CloudVersion, das habe ich beim Export der daten aus der Altinstallation berücksichtigt und nur die letzten 30 Tage exportiert.

- erst einmal eine Cloud Instanz beantragt und eingerichtet siehe influxdb-Cloud

- mir die nötigen Daten besorgt

- Cloud

Bucket anlegen z.B iobroker/autogen

Token Anlegen

User Id ermitteln

Bucket ID

Org

Org-Id - lokale Installation

welche DBs gibt es

welche Retetion gibt es für welche Datenbank

check ob space für den export vorhanden

- export der Daten

mkdir -p /tmp/data && sudo influx_inspect export -lponly -datadir /var/lib/influxdb/data/ -waldir /var/lib/influxdb/wal/ -database iobroker -retention global -out /tmp/data/iobroker-lp --compress gzip -start 2023-0107T00:00:00Z -end 2023-02-07Z00:00:00Z- um meine letzte 1.8

influxdbinstallation nicht zu verbiegen einen neuen LXC Container mit den passendeninfluxdb V 2.xaufgesetzt - Datei

/tmp/data/iobroker-lpauf den neuen LXC Container kopiert. - für meinen User im neuen LXC ein passendes Environment angelegt

export INFLUX_HOST=https://eu-central-1-1.aws.cloud2.influxdata.com export INFLUX_ORG=<Org Name wie oben unter Cloud ermittelt> export INFLUX_TOKEN=<Token wie unter Cloud ermittelt>- Im neuen LXC

influx v1 dbrp create --db influxdb --rp autogen --bucket-id <aus der Cloud Konfig> --default- check der Daten

zmore /tmp/data/iobroker-lp- Trockenlauf

16:39:20 dp20eic@test ~ $ influx write dryrun --bucket iobroker/autogen --file /tmp/data/iobroker-lp | more <hier erscheint der name der Organisation> system.adapter.nut.0.memRss value=60.52 1675764000088000000 system.adapter.nut.0.memRss from="system.adapter.nut.0" 1675764000088000000 system.adapter.nut.0.memRss q=0 1675764000088000000 system.adapter.nut.0.memRss ack=true 1675764000088000000 system.adapter.nut.0.memHeapUsed value=21.49 1675764000088000000 system.adapter.nut.0.memHeapUsed from="system.adapter.nut.0" 1675764000088000000 system.adapter.nut.0.memHeapUsed q=0 1675764000088000000 system.adapter.nut.0.memHeapUsed ack=true 1675764000088000000 system.adapter.nut.0.cpu value=0.07 1675764000148000000 ...- und abdafür

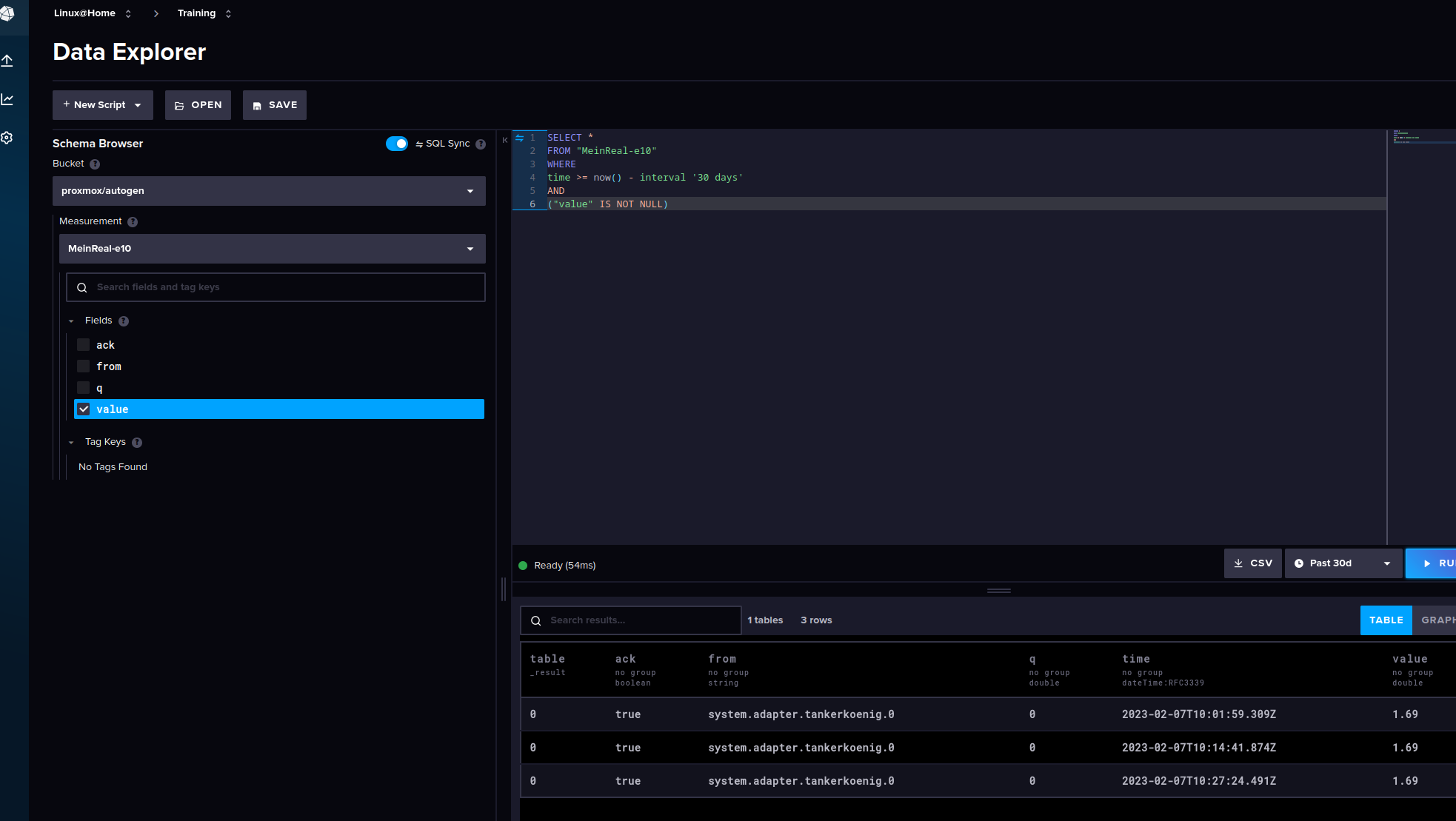

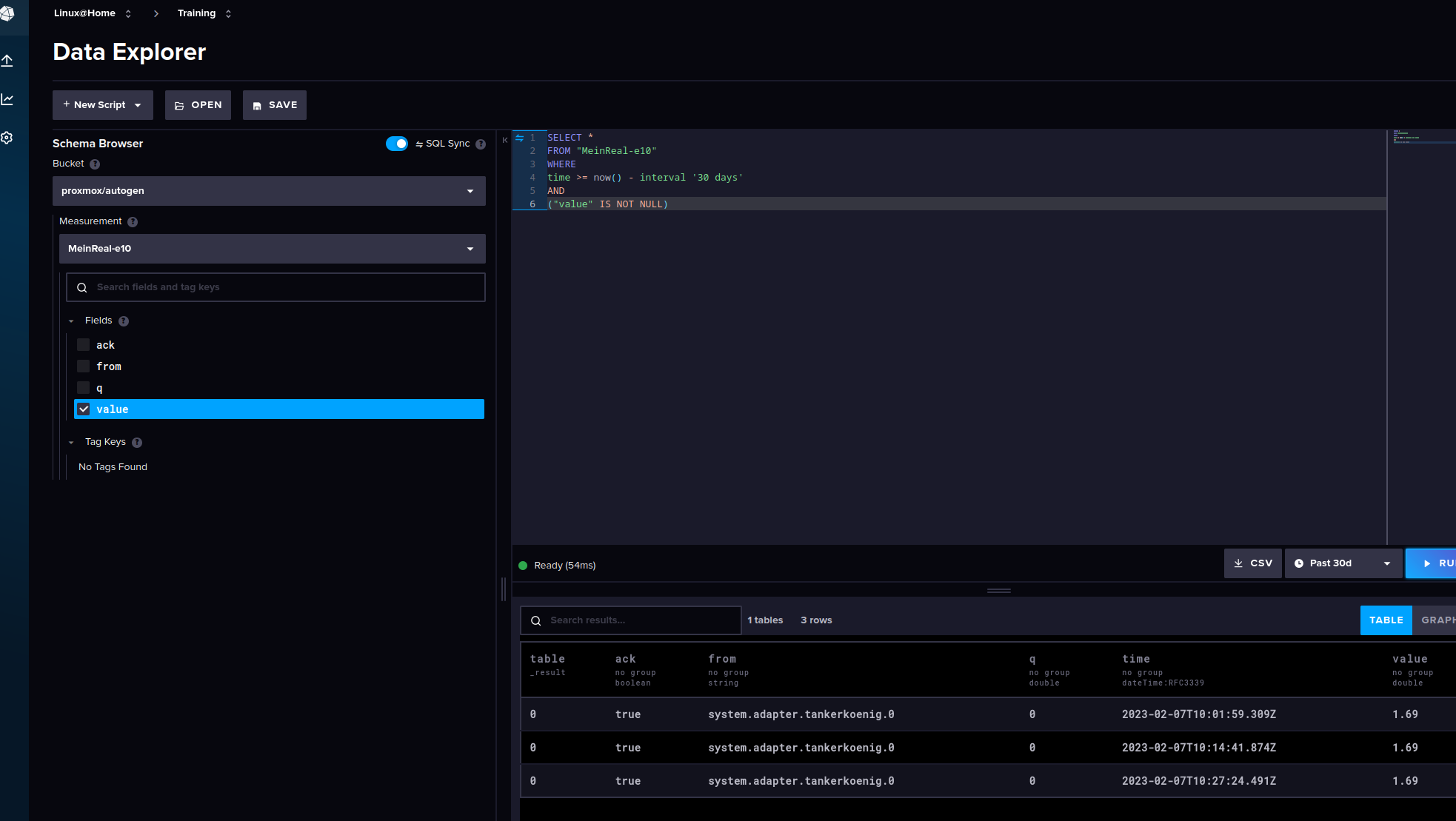

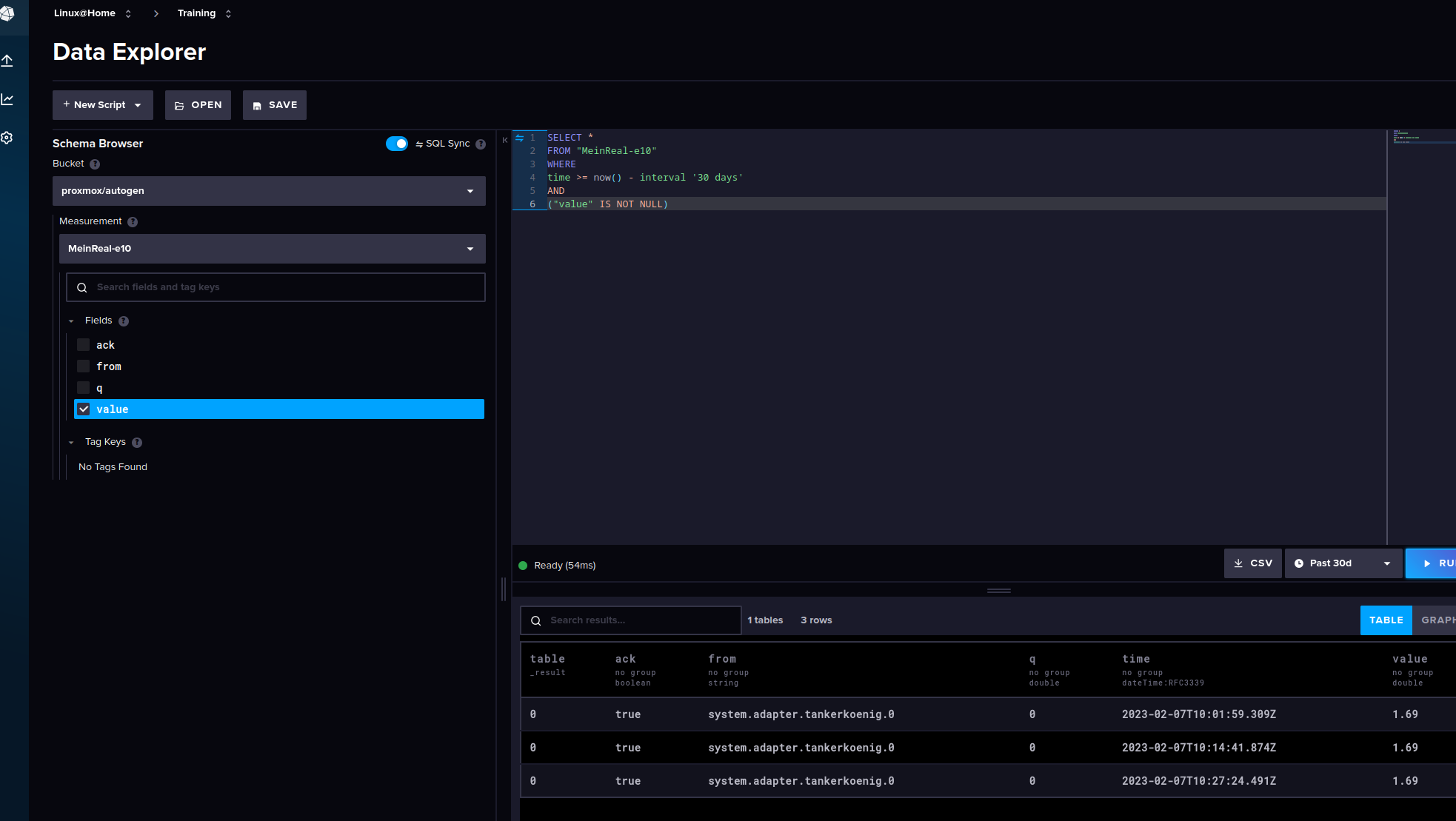

$ influx write --bucket iobroker/autogen --file /tmp/data/iobroker-lp- Check ob die Daten in der Cloud vorhanden sind, sie sind da :)

VG

Bernd -

@dp20eic

So ich Antworte mir mal selber, um zu beschreiben was, habe ich wie gemacht, um Daten aus einer lokalen

influxdb V1.8in dieinflux-Cloudzu bekommen.!!! Achtung !!!

Folgende Einschränkungen, in der freeinfluxdb - CloudVersion, das habe ich beim Export der daten aus der Altinstallation berücksichtigt und nur die letzten 30 Tage exportiert.

- erst einmal eine Cloud Instanz beantragt und eingerichtet siehe influxdb-Cloud

- mir die nötigen Daten besorgt

- Cloud

Bucket anlegen z.B iobroker/autogen

Token Anlegen

User Id ermitteln

Bucket ID

Org

Org-Id - lokale Installation

welche DBs gibt es

welche Retetion gibt es für welche Datenbank

check ob space für den export vorhanden

- export der Daten

mkdir -p /tmp/data && sudo influx_inspect export -lponly -datadir /var/lib/influxdb/data/ -waldir /var/lib/influxdb/wal/ -database iobroker -retention global -out /tmp/data/iobroker-lp --compress gzip -start 2023-0107T00:00:00Z -end 2023-02-07Z00:00:00Z- um meine letzte 1.8

influxdbinstallation nicht zu verbiegen einen neuen LXC Container mit den passendeninfluxdb V 2.xaufgesetzt - Datei

/tmp/data/iobroker-lpauf den neuen LXC Container kopiert. - für meinen User im neuen LXC ein passendes Environment angelegt

export INFLUX_HOST=https://eu-central-1-1.aws.cloud2.influxdata.com export INFLUX_ORG=<Org Name wie oben unter Cloud ermittelt> export INFLUX_TOKEN=<Token wie unter Cloud ermittelt>- Im neuen LXC

influx v1 dbrp create --db influxdb --rp autogen --bucket-id <aus der Cloud Konfig> --default- check der Daten

zmore /tmp/data/iobroker-lp- Trockenlauf

16:39:20 dp20eic@test ~ $ influx write dryrun --bucket iobroker/autogen --file /tmp/data/iobroker-lp | more <hier erscheint der name der Organisation> system.adapter.nut.0.memRss value=60.52 1675764000088000000 system.adapter.nut.0.memRss from="system.adapter.nut.0" 1675764000088000000 system.adapter.nut.0.memRss q=0 1675764000088000000 system.adapter.nut.0.memRss ack=true 1675764000088000000 system.adapter.nut.0.memHeapUsed value=21.49 1675764000088000000 system.adapter.nut.0.memHeapUsed from="system.adapter.nut.0" 1675764000088000000 system.adapter.nut.0.memHeapUsed q=0 1675764000088000000 system.adapter.nut.0.memHeapUsed ack=true 1675764000088000000 system.adapter.nut.0.cpu value=0.07 1675764000148000000 ...- und abdafür

$ influx write --bucket iobroker/autogen --file /tmp/data/iobroker-lp- Check ob die Daten in der Cloud vorhanden sind, sie sind da :)

VG

Bernd@dp20eic sagte in influxdb cloud Daten importieren:

gern, Frauchen ist morgen Arbeiten, da hab ich etwas Zeit zum Spielen, ähm Lernen

@dp20eic sagte in influxdb cloud Daten importieren:

So ich Antworte mir mal selber,

Daumen :+1: ,

.... ich selber habe nichts davon , aber ein Lob dafür muß mal sein !

-

@dp20eic

So ich Antworte mir mal selber, um zu beschreiben was, habe ich wie gemacht, um Daten aus einer lokalen

influxdb V1.8in dieinflux-Cloudzu bekommen.!!! Achtung !!!

Folgende Einschränkungen, in der freeinfluxdb - CloudVersion, das habe ich beim Export der daten aus der Altinstallation berücksichtigt und nur die letzten 30 Tage exportiert.

- erst einmal eine Cloud Instanz beantragt und eingerichtet siehe influxdb-Cloud

- mir die nötigen Daten besorgt

- Cloud

Bucket anlegen z.B iobroker/autogen

Token Anlegen

User Id ermitteln

Bucket ID

Org

Org-Id - lokale Installation

welche DBs gibt es

welche Retetion gibt es für welche Datenbank

check ob space für den export vorhanden

- export der Daten

mkdir -p /tmp/data && sudo influx_inspect export -lponly -datadir /var/lib/influxdb/data/ -waldir /var/lib/influxdb/wal/ -database iobroker -retention global -out /tmp/data/iobroker-lp --compress gzip -start 2023-0107T00:00:00Z -end 2023-02-07Z00:00:00Z- um meine letzte 1.8

influxdbinstallation nicht zu verbiegen einen neuen LXC Container mit den passendeninfluxdb V 2.xaufgesetzt - Datei

/tmp/data/iobroker-lpauf den neuen LXC Container kopiert. - für meinen User im neuen LXC ein passendes Environment angelegt

export INFLUX_HOST=https://eu-central-1-1.aws.cloud2.influxdata.com export INFLUX_ORG=<Org Name wie oben unter Cloud ermittelt> export INFLUX_TOKEN=<Token wie unter Cloud ermittelt>- Im neuen LXC

influx v1 dbrp create --db influxdb --rp autogen --bucket-id <aus der Cloud Konfig> --default- check der Daten

zmore /tmp/data/iobroker-lp- Trockenlauf

16:39:20 dp20eic@test ~ $ influx write dryrun --bucket iobroker/autogen --file /tmp/data/iobroker-lp | more <hier erscheint der name der Organisation> system.adapter.nut.0.memRss value=60.52 1675764000088000000 system.adapter.nut.0.memRss from="system.adapter.nut.0" 1675764000088000000 system.adapter.nut.0.memRss q=0 1675764000088000000 system.adapter.nut.0.memRss ack=true 1675764000088000000 system.adapter.nut.0.memHeapUsed value=21.49 1675764000088000000 system.adapter.nut.0.memHeapUsed from="system.adapter.nut.0" 1675764000088000000 system.adapter.nut.0.memHeapUsed q=0 1675764000088000000 system.adapter.nut.0.memHeapUsed ack=true 1675764000088000000 system.adapter.nut.0.cpu value=0.07 1675764000148000000 ...- und abdafür

$ influx write --bucket iobroker/autogen --file /tmp/data/iobroker-lp- Check ob die Daten in der Cloud vorhanden sind, sie sind da :)

VG

Bernd