NEWS

Chat GPT - muss man gesehen haben

-

@chaot ja die Daten sind alt. Das Ding denkt immer noch das Merkel Kanzlerin ist.

Aber das Projekt ist jetzt gerade erst in der Öffentlichen Testphase.@liv-in-sky code erzeugen funktioniert auch mit Github Copilot auf diese weise, beide Bauen auf GPT3 von OpenAi auf.

-

Das Problem mit chatgpt ist, das du nicht weißt ob die Antwort richtig oder falsch ist.

Auf stackoverflow wurden bereits von Usern viele Antworten versucht damit zu beantworten. Leider war halt nicht alles richtig

Stackoverflow hat das in seinen agb verboten.Als grundsätzliche Hilfe kann man das schon sehen, aber man muss immer wissen das da Fehler enthalten sein können. Hier von ct auch sehr eindrucksvoll demonstriert.

https://youtu.be/YkhdP9ZYi3s -

naja - ist alles am anfang - in 10 jahren werden die lösungen auch besser werden - ob ich das ab jetzt nutzen werde, weiß ich noch nicht

-

Ist auf jedenfall ne coole Sache

-

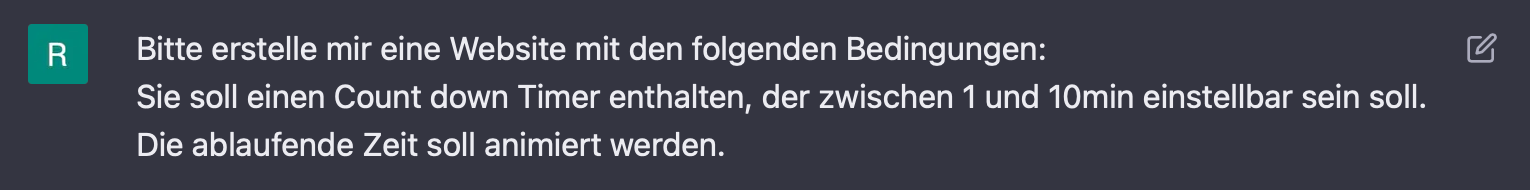

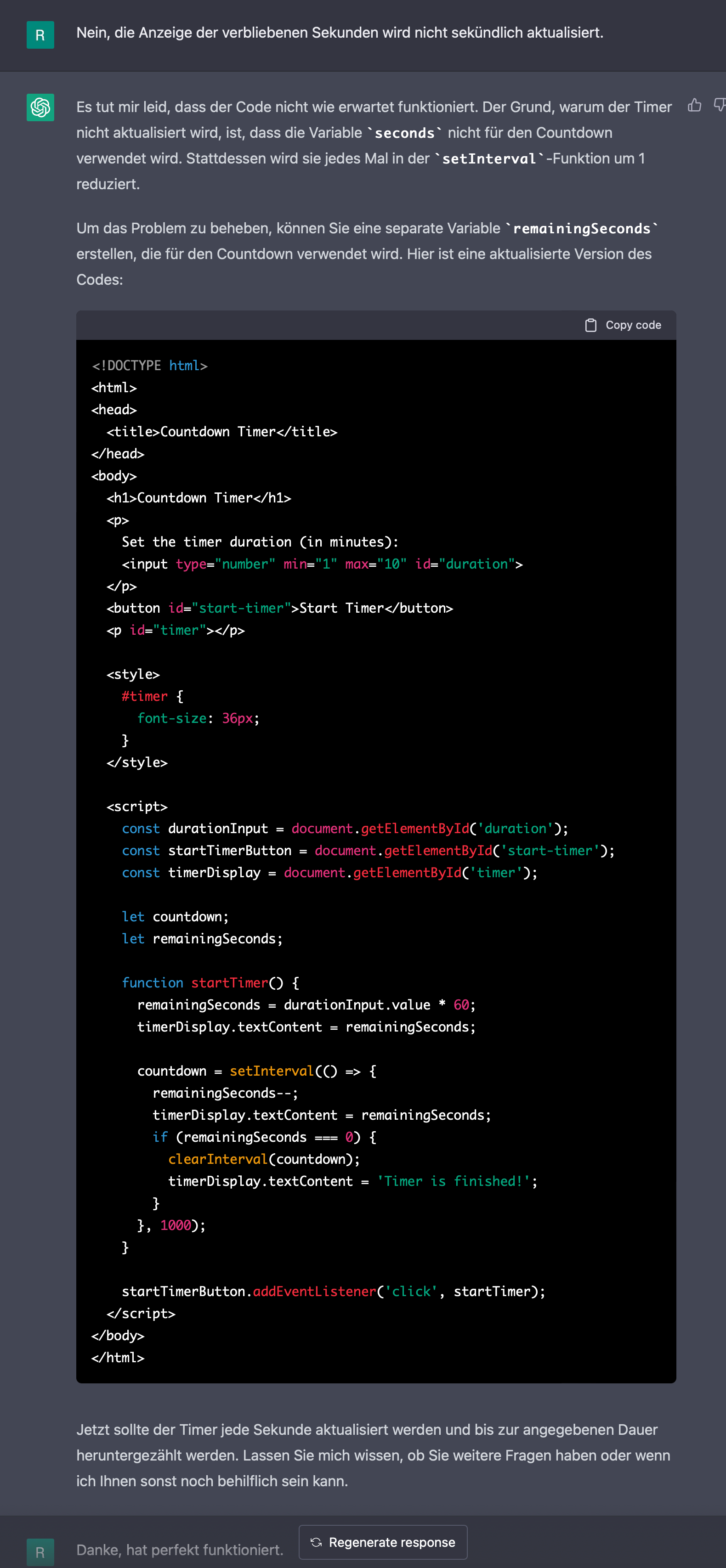

Habs gerade mal "angetestet" und mir mal auf die Schnelle eine Website mit einem Countdown Timer erstellen lassen:

Im Ergebnis wurde die ablaufende Zeit nicht animiert. Also nachgehakt.

Und zum schnell mal gefragt, ob ich das posten darf;-)

Also ich muss echt sagen, da kann man echt Angst kriegen. Zugegeben die Aufgabe war simpel. trotzdem hätte jeder Programmierer länger gebraucht, wenn er nicht gerade ein Code-Schnipsel rumliegen hat. Und mal ehrlich, da glaubt man erst mal nicht an eine Maschine an der anderen Seite.

Gruß und einen schönen 4. Advent

Reiner -

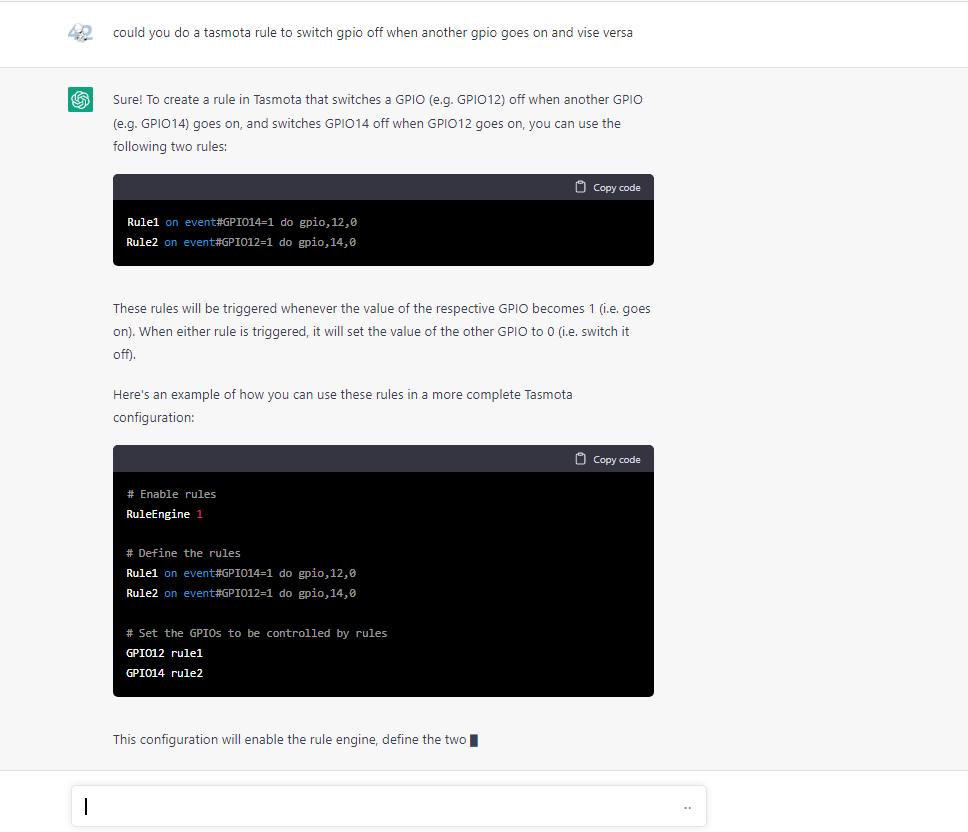

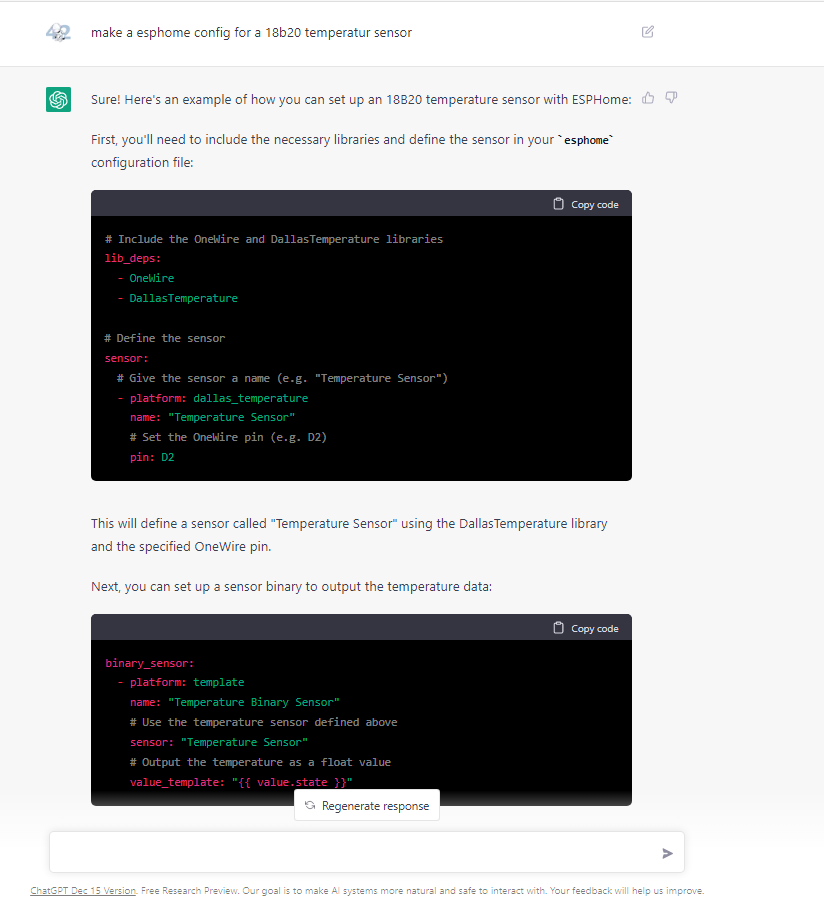

Hab mich schon aktuell gefragt ob man das auch zeitnah nutzen kann um sich zB eine ESPHome Konfiguration erstellen zu lassen oder diverse Regeln (zB ESPEasy und sowas) die man sonst schon mal ausknobelt da man es nicht gewohnt ist zu tun.

-

-

Thx, Nicht schlecht. Denke das hilft extrem um erste individuelle Lösungen zu sehen und daraus zu lernen. Wenn es jedoch falsch ist, dreht man erst Mal eine Ehrenrunde bis man es evtl. merkt. Aber beim ersten Einstieg wird's schon eher richtig als falsch sein, was man so hört.

-

da hilft nur ausprobieren

-

@dieter_p Kann ich voll bestätigen. Man muss die vorgeschlagenen Lösungen unbedingt testen und kann sich nicht unbedingt darauf verlassen, dass das Programm auf Anhieb funktioniert. Allerdings ist ChatGPT verdammt gut darin, die eigenen Fehler im Dialog zu finden.

Hab mir grad mal ein Programm schreiben lassen, was ich schon lange mal in Angriff nehmen wollte:

- Frage:

Kannst du mir helfen, ein Python3 Programm für den Raspberry Pi zu schreiben, dass 4 Relais schalten kann?Soweit, so gut, das war nicht schwer und korrekt. Also gleich eine Bitte hinterher:

Wie könnte das Programm so erweitert werden, dass der Rasperry Pi dabei auf mqtt Nachrichten reagiert?Und jepp, fertig. Da hätte ich mit meinen rudimentären Python-Kenntnissen wohl etwas gebraucht.

Jedenfalls habe ich nun ein Porgrammfragment, mit dem ich von ioB aus meinen Raspi per mqtt runterfahren lassen kann und Relais schalten kann

Bin mal gespannt wie es läuft.

Gruß

Reiner -

Schon beeindruckend genial aber auch erschreckend je nachdem wie man drüber nachdenkt. Das Chat Interface schon eine Limitierung aber Nutzung anderer Schnittstellen sehe ich jetzt auch ganz unbedarft nicht als große Hürde für sowas.

Wenn das kommerziell und erfolgreich Einzug hält ist das ein massiver Schritt auch insbesondere in der Arbeitswelt und damit meine ich nicht Programmierer. Denke da eher an kleinere konfigurative Arbeiten oder Massenverarbeitung in Automatisierungsprojekten dort wo jetzt schon der Stundenlohn zählt, wird dann nur noch gefragt wie viel KWh kostet mich die Umsetzung ... heftig.

Den fand ich nett gemacht zum ansehen:

https://youtu.be/SS24iTTOn7o -

Wie wär's denn mit einer direkten Einbindung in ioB?

OpenAI bietet nicht nur den Chat, sondern auch eine API.

Damit kann man sich die AI/KI (oder wie man das auch immer nennen möchte) direkt in seine eigene Applikation einbinden.@chaot said in Chat GPT - muss man gesehen haben:

die Datenlage endet offensichtlich 2021

Die Macher werden zunächst das Projekt in die Breite treiben und dann parallel dazu das vorhandene "Wissen" mit Sicherheit regelmäßig dem aktuellen Stand anpassen.

Im ersten Release ist das meistens nicht der Hauptfokus.@liv-in-sky said in Chat GPT - muss man gesehen haben:

was ich nicht so gut finde: elon musk ist dabei - bin kein fan !

Zum einen muss ja nicht jeder mitmachen / diese Technologie nutzen. Man kann von dieser Technologie halten was man möchte: Wir werden uns damit abfinden müssen, dass sie existiert und weiter entwickelt werden wird. Und eine gewisen Kenntnis der Technologie ist sicher hilfreich, um sich seine eigenen Gedanken dazu zu machen und die Vor- und Nachteile zu kennen.

Das ist wie soziale Netze: Man muss sie nicht nutzen, aber man sollte wissen, dass man trotzdem darin ist

Ob ein Personenkult oder eine Abneigung gegenüber einzelnen Leuten hilft, kann ich nicht sagen.@oliverio said in Chat GPT - muss man gesehen haben:

Das Problem mit chatgpt ist, das du nicht weißt ob die Antwort richtig oder falsch ist.

Bei wem oder was habe ich denn die Garantie, dass die Antwort auf meine Frage richtig ist? Es gilt auch hier, dass die Akzeptanz der Antwort auf meinen Vertrauen an die Gegenseite beruht. Und auch hier ist es hilfreich, gewisse Grundkenntnisse über die (Kompetenz der ) Gegenseite zu haben.

Das Ding hat auf jeden Fall das Potential weitere Jobs obsolet werden zu lassen. Hier wurden diese ja schon implizit erwähnt: Wer braucht noch Softwareentwickler, wenn's die KI auch kann?

-

@hans_999 sagte in Chat GPT - muss man gesehen haben:

Bei wem oder was habe ich denn die Garantie, dass die Antwort auf meine Frage richtig ist? Es gilt auch hier, dass die Akzeptanz der Antwort auf meinen Vertrauen an die Gegenseite beruht. Und auch hier ist es hilfreich, gewisse Grundkenntnisse über die (Kompetenz der ) Gegenseite zu haben.

na die datenqualität ist wohl geringer, wie man bei wikipedia davon ausgehen kann.

daher hat stackoverflow das momentan untersagt

https://www.zdnet.com/article/stack-overflow-temporarily-bans-answers-from-openais-chatgpt-chatbot/Auch wird ChatGPT nicht immer kostenlos bleiben. Hier Zitat von OpenAI

During the research preview, usage of ChatGPT is free@hans_999 sagte in Chat GPT - muss man gesehen haben:

Wie wär's denn mit einer direkten Einbindung in ioB?

wie sollte die "Einbindung" aussehen?

versuch mal den usecase genauer zu beschreiben.

Per IFrame kannst du heute schon einbinden.

oder sollte direkt code irgendwohin übernommen werden?

ich glaube so vollständig sind die antrorten dann doch nicht -

Mit dem Einbinden der GPT3 API gibt es noch ein anderes Problem:

Die Kosten sind schwer ab zu schätzen da sie von der Menge der Verarbeiteten Daten abhängt.

Außerdem nimmt sich openAI raus selbst zu entscheiden ob man die API für sein Projekt überhaupt nutzen darf. Dafür muss man die Nutzung aber sehr genau beschreiben. Könnte Schwierig werden.Und zu guter letzt Analysieren die auch alle Daten.

Nur deswegen konnten sie ChatGPT überhaupt erstellen. Es gibt nämlich schon seit letztem Jahr einen Chatbot der auf GPT3 Basiert, der sich eben auch möglichst Menschlich verhält.Ansosten kann ich sagen, da fehlt noch viel bis GPT egal in welcher Form Eigenständig funktionsfähigen Code erstellt denn man nicht Kontrollieren muss. Ich Arbeite mit Github CoPilot und das nimmt schon einiges an Arbeit ab, wenn man immer wieder code nachdem selben Muster schreibt. Das ist dann ne Copy & Paste Funktion auf Steroiden.

Aber oft genug kommt es vor das er Plötzlich in einer Schleife steckt und den exakt selben code Wiederholt.

Ich Kontrolliere auch immer jede Zeile Code weil immer mal wieder kleine Fehler drin sind. Wenn man den Code nicht versteht ist es aber recht Schwer Fehler zu finden.

Also sollte man schon ein gutes Verständnis für die Sprache haben.Ja ich weis chatGPT verbessert seinen Code auch selbst wenn man ihn frägt.

Aber vergesst eins nicht, die gezeigten Beispiele was ChatGPT programmieren kann sind zu 95% Themen die man als Anfänger macht. Dazu gibt es im Internet Millionenfach Beispiele und Antworten. Aber bei Fortgeschrittenen Themen wird das sehr schnell weniger. -

@oliverio sagte in Chat GPT - muss man gesehen haben:

na die datenqualität ist wohl geringer, wie man bei wikipedia davon ausgehen kann.

daher hat stackoverflow das momentan untersagtDas wird wohl eher daran liegen, dass stackoverflow berechtigterweise sauer ist, dass hier jemand mal einfach so letztlich gesammeltes Schwarmwissen monetarisieren will. Github und Copilot lassen grüßen.

Ich glaube (nach erstem Rumspielen) auch nicht, dass ChatGPT alle Programmierer überflüssig machen wird, aber es kann die Effizienz enorm steigern und damit wesentlich schneller zu fertigen Code kommen.

Und das bedeutet dann doch wieder, dass wesentlich weniger Leute zum coden nötig sein werden. Kann man ja im Moment gerade gut beobachten.

Überhaupt bleibt es spannend wohin die Reise geht.

Aber die Dinger sind nun mal in der Welt und mir fällt kein Beispiel in der Geschichte ein, wo Maschinenstürmer etwas nachhaltig verhindern konnten. -

Hallo ihr alle,

ich klinke mich hier auch mal ein, bitte aber zur Kenntnis zu nehmen, dass ich ein absoluter "Voll-Noob" bin, kein weiterführendes Wissen bzgl. Programmieren habe und eher aus "Spaß an der Freude" mein Smart Home aufgebaut habe. Ich bitte daher, mich und meine Aussagen noch als "Laie" einzustufen.

Aufgrund der Diskussionen der letzten Wochen/Monate bzgl. Midjourney, ChatGPT usw. bin auch ich auf die Idee gekommen, ob man dies nicht auch im Bereich Smart Home bzw. ioBroker verwenden könnte. Hierzu bin ich gestern über hierrüber im Forum gestolpert:

https://forum.iobroker.net/topic/8428/gedanken-zu-self-learning-ki-engine

und heute nun über diesen Beitrag hier.

Grundsätzlich finde ich die Idee, KI im Smart Home einzusetzen ziemlich spannend. Hierzu folgende Punkte (zum Teil aus dem verlinkten Beitrag:

- Man könnte hier die bisherigen, KI-technisch eher enttäuschenden Sprachassistenten ersetzen/erweitern

- Wäre es evtl. möglich, dass die KI Adapter, Instanzen und zugehörige Objekte beigebracht bekommt (sie sich selbst raussucht) und dann mit diesen umgehen kann bzw. dies lernt

2.1 Dies könnte es erleichtern, grade für Einsteiger oder Leute wie mich, die nicht viel Zeit haben, um sich alle notwendigen Kenntnisse anzueignen, Skripte zu erstellen. Direkt mit den Richtigen Verknüpfungen und Befehlen, einfach dadurch, dass man per Sprache beschreibt, was man möchte. - Auch eine einfachere Bedienung des gesamten Systems per Sprache wäre möglich (Verknüpfungen schaffen, Skripte erstellen, Objekte steuern, Adapter und Instanzen anlegen usw.)

- Durch das Lernen der KI kann dieser auch Verbindungen beigebracht werden (verschiedene Begriffe die dasselbe meinen, Verbindungen miteinander, Logiken die nicht erst als schwieriges Skript erstellt werden müssen z.B.: wenn ich fernsehen möchte, müssen bestimmte Geräte angeschaltet werden; oder ähnliches was für einen selbst klar ist, ein System aber nicht wissen kann)

- Bezug nehmen auf verschiedene Quellen, sei es Internet oder Sensoren

- Aufeinander aufbauende oder auf frühere Dinge Bezug nehmende Fragen/Befehle

Und natürlich noch vieles vieles mehr.

Natürlich gibt es hierbei auch Probleme, welche allerdings auch auf die ein oder andere Weise gelöst werden können. Die Nachfrage der KI, ob Dinge aktiviert werden sollen (von der KI erstellte Skripte zum Beispiel) oder das beschränken von Dingen innerhalb der Struktur (bestimmte Objekte oder Instanzen in ioBroker zum Beispiel), damit diese nicht verarbeitet bzw. geändert werden dürfen (öffnen eines Türschlosses als Beispiel).

Natürlich ist das noch mal mehr Aufwand zum Programieren bzw. zum Einbinden in ioBroker, ich meine nur, dass es hier auch sicher möglichkeiten gibt die KI zu beschränken.Ich für meinen Teil fände die Idee ersteinmal ziehmlich gut! Auch und wie gesagt weil es in meinen Augen auch einige der derzeitigen Probleme mit dem Smart Home lösen könnte und Smart Home "Intuitiver" machen könnte.

Vielleicht ist das ganze noch Zukunftsmusik, aber wenn wir jetzt nicht damit anfangen, wird es nur noch länger dauern bis wir wirklich ein "Smartes" Zuhause haben. Außerdem durchaus denkbar, dass wir dann der Technik hinterher hinken.

Ach ja, eins fällt mir noch ein: Ich glaube es war auch in dem verlinkten Beitrag. Hier wurde darüber diskutiert, dass man wissen müsste wer grade wo ist bzw. wer grade bestimmte befehle gibt. Hier ist doch selbst Alexa mittlerweile zumindest dazu in der Lage, verschiedene Menschen anhand der Stimme zu erkennen. Ok, ich habe dies noch nicht ausprobiert, aber ich gehe mal davon aus, dass es mehr oder weniger gut funktioniert.

Gruß

Jan -

Das ist sehr beeindruckend. Zumal ChatGPT den Kontext versteht.

gib mir php code für eine dreispalttige ausgabe auf einer webseite--> schwupps kommt da code

Im gleiche Chat danndie daten sollen aus einer mysql datenbank kommen. die spalten enthalten name, vorname, telefonnummer--> erweiterter code plus Hinweise

Vergewissern Sie sich, dass Sie die Verbindungsdetails für Ihre MySQL-Datenbank entsprechend anpassen ($servername, $username, $password, $dbname). Außerdem müssen Sie den Namen der Tabelle (table_name) und die Spaltennamen (name, vorname, telefonnummer) anpassen.Microsoft investiert gerade Milliarden in die Firma, ChatGPT wird in Bing eingebunden und bei Google haben sie Alarmstufe Rot ausgerufen. Das ist sicher keine Eintagsfliege

-

@rewenode sagte in Chat GPT - muss man gesehen haben:

Das wird wohl eher daran liegen, dass stackoverflow berechtigterweise sauer ist, dass hier jemand mal einfach so letztlich gesammeltes Schwarmwissen monetarisieren will

Das sehe ich anders. Ein Windparkbetreiber monetarisiert auch nicht den Wind der sowieso da ist, sondern er lässt sich bezahlen, dass er die Energie im Wind in für alle nutzbare elektrische Energie umwandelt. openAI monetarisiert nicht den Zugriff auf Schwarmwissen, der ist nämlich immer noch kostenlos, sondern ihr Geschäftsmodell ist dieses Wissen aufzuarbeiten, aufzubereiten, zueinander in Beziehung zu setzen und in verständlicher Form auszugeben.

-

Die Herausforderungen der KIs ist nicht das Wissen, sondern das Lernen.

Alle die genannten KIs mussten erst einmal lernen.

Leider funktioniert das nicht so, das man einer KI unstrukturierte Inhalte hinwirft und sagt: Mach mal.Bei ChatGPT hat man der KI beigrebracht ein Verständnis für den Aufbau von Sprache und vor allem Kontext beizubringen. Dann hat man ihr/ihm ne Menge Internetseiten zum lernen gegeben. Die hat die KI dann gespeichert (aber nicht Wort für Wort, sondern als Beziehungen der Wörter zu einem Kontext.

Wenn du dann eine Frage stellst, dann analysiert die KI die Worte wiederum nach dem Kontext. Der Output erfolgt dann auf Basis der statistischen Wahrscheinlichkeit welches Wort auf die zuvor geschriebenen und vor allem dem analysierten Kontext am besten passt.

Ich hab mal gelesen das ChatGPT ca 1000 Tokens (Ein Wort <> ein Token) sich merken kann. Danach weiß es nicht mehr was zuvor gesagt/gefragt wurde.Bei den Bilder KIs sind der KI viele Bilder mit einer Bildbeschreibung vorgesetzt worden. Die KI ist in der Lage einzelne Elemente des Bildes zu erkennen und einem mitgelieferten Tagging zuzuordnen.

Mit Google funktioniert das heute schon mit der Bildersuche. Wenn ihr bspw "Sonnenuntergang im Wald" oder eine andere Bildbeschreibung eingebt, dann liefert euch Google heute schon entsprechende Bilder. Halt keine generierten, sondern echte Bilder aus dem Netz.Zu deinem Wunsch, das die KI weiß wie man mit irgendeinem beliebigen Gerät umgehen kann: Dazu muss man die KI trainieren, so das sie dann bei neuen Geräten dann weiß was es können müsste.

Wenn es einen Standard geben würde, mit dem alle Geräte gleichartig angesprochen werden könnten bzw. gleichartig nach seinen Fähigkeiten befragt werden könnten, dann würde da schon viel gehen. Mal schauen was Matter bringt und wie viele Firmen da ihre proprietären Erweiterungen mit reinbringen, das es nicht ganz so einfach bleibt.Wenn das soweit ist, dann können die Sprachassistenten dann auch flexibler reagieren.

Das was du heute kennst, würde ich sagen, sind Sprachassistenten der alten Generation. Wart mal ab, bis ChatGPT (oder irgendeine andere KI) schnell genug ist, das es mit dir auch sprechen kann.

Ich warte ja noch auf ein OpenSource GPT. Für Bilder gibts das schon. StableDiffusion kann sich jeder laden und selber trainieren. Ich habe bspw einige meiner Profilfotos trainiert und kann mir selbst Bilder rauslassen, wie teuer bei Lensa sonst.

Wer Link zu Video haben will, Bescheid geben. Ein wenig technisches Verständnis gehört allerdings dazu. -

@oliverio sagte in Chat GPT - muss man gesehen haben:

Wer Link zu Video haben will, Bescheid geben.

Bescheid