NEWS

erneuert nicht [wieder erledigt] Tasmo Admin / VM Problem

-

@crunchip pöff. hab die kiste neu gestartet. IMHO hab ich da was ab dem start gefunden. sagt mir aber außer refused nichts.

Aug 15 16:13:43 Homeserver pvescheduler[1471]: starting server Aug 15 16:13:43 Homeserver systemd[1]: Started Proxmox VE scheduler. Aug 15 16:13:43 Homeserver systemd[1]: Reached target Multi-User System. Aug 15 16:13:43 Homeserver systemd[1]: Reached target Graphical Interface. Aug 15 16:13:43 Homeserver systemd[1]: Starting Update UTMP about System Runlevel Changes... Aug 15 16:13:43 Homeserver systemd[1]: systemd-update-utmp-runlevel.service: Succeeded. Aug 15 16:13:43 Homeserver systemd[1]: Finished Update UTMP about System Runlevel Changes. Aug 15 16:13:43 Homeserver systemd[1]: Startup finished in 3.794s (kernel) + 25.290s (userspace) = 29.085s. Aug 15 16:13:48 Homeserver systemd-timesyncd[643]: Initial synchronization to time server 185.144.161.170:123 (2.debian.pool.ntp.org). Aug 15 16:13:52 Homeserver pvestatd[1100]: qemu status update error: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:13:53 Homeserver systemd[1]: Stopping User Manager for UID 0... Aug 15 16:13:53 Homeserver systemd[1142]: Stopped target Main User Target. Aug 15 16:13:53 Homeserver systemd[1142]: Stopped target Basic System. Aug 15 16:13:53 Homeserver systemd[1142]: Stopped target Paths. Aug 15 16:13:53 Homeserver systemd[1142]: Stopped target Sockets. Aug 15 16:13:53 Homeserver systemd[1142]: Stopped target Timers. Aug 15 16:13:53 Homeserver systemd[1142]: dirmngr.socket: Succeeded. Aug 15 16:13:53 Homeserver systemd[1142]: Closed GnuPG network certificate management daemon. Aug 15 16:13:53 Homeserver systemd[1142]: gpg-agent-browser.socket: Succeeded. Aug 15 16:13:53 Homeserver systemd[1142]: Closed GnuPG cryptographic agent and passphrase cache (access for web browsers). Aug 15 16:13:53 Homeserver systemd[1142]: gpg-agent-extra.socket: Succeeded. Aug 15 16:13:53 Homeserver systemd[1142]: Closed GnuPG cryptographic agent and passphrase cache (restricted). Aug 15 16:13:53 Homeserver systemd[1142]: gpg-agent-ssh.socket: Succeeded. Aug 15 16:13:53 Homeserver systemd[1142]: Closed GnuPG cryptographic agent (ssh-agent emulation). Aug 15 16:13:53 Homeserver systemd[1142]: gpg-agent.socket: Succeeded. Aug 15 16:13:53 Homeserver systemd[1142]: Closed GnuPG cryptographic agent and passphrase cache. Aug 15 16:13:53 Homeserver systemd[1142]: Removed slice User Application Slice. Aug 15 16:13:53 Homeserver systemd[1142]: Reached target Shutdown. Aug 15 16:13:53 Homeserver systemd[1142]: systemd-exit.service: Succeeded. Aug 15 16:13:53 Homeserver systemd[1142]: Finished Exit the Session. Aug 15 16:13:53 Homeserver systemd[1142]: Reached target Exit the Session. Aug 15 16:13:53 Homeserver systemd[1143]: pam_unix(systemd-user:session): session closed for user root Aug 15 16:13:53 Homeserver systemd[1]: user@0.service: Succeeded. Aug 15 16:13:53 Homeserver systemd[1]: Stopped User Manager for UID 0. Aug 15 16:13:53 Homeserver systemd[1]: Stopping User Runtime Directory /run/user/0... Aug 15 16:13:53 Homeserver systemd[1]: run-user-0.mount: Succeeded. Aug 15 16:13:53 Homeserver systemd[1]: user-runtime-dir@0.service: Succeeded. Aug 15 16:13:53 Homeserver systemd[1]: Stopped User Runtime Directory /run/user/0. Aug 15 16:13:53 Homeserver systemd[1]: Removed slice User Slice of UID 0. Aug 15 16:14:13 Homeserver pvestatd[1100]: qemu status update error: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:14:32 Homeserver pvestatd[1100]: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:14:32 Homeserver pvestatd[1100]: qemu status update error: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:14:42 Homeserver pvestatd[1100]: qemu status update error: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:14:52 Homeserver pvestatd[1100]: qemu status update error: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:15:02 Homeserver pvestatd[1100]: qemu status update error: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:15:32 Homeserver pvestatd[1100]: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:15:32 Homeserver pvestatd[1100]: qemu status update error: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:15:42 Homeserver pvestatd[1100]: qemu status update error: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:15:53 Homeserver pvestatd[1100]: qemu status update error: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:16:02 Homeserver pvestatd[1100]: qemu status update error: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:16:12 Homeserver pvestatd[1100]: qemu status update error: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:16:15 Homeserver pvedaemon[1121]: <root@pam> successful auth for user 'root@pam' Aug 15 16:16:19 Homeserver pvedaemon[1120]: <root@pam> successful auth for user 'root@pam' Aug 15 16:16:22 Homeserver pvestatd[1100]: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:16:22 Homeserver pvestatd[1100]: qemu status update error: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:16:32 Homeserver pvestatd[1100]: qemu status update error: metrics send error 'Proxmox': failed to send metrics: Connection refusedwie gesagt, ioB, Motioneye und PiHole funktionieren. nur die eine VM macht probleme...

-

@crunchip pöff. hab die kiste neu gestartet. IMHO hab ich da was ab dem start gefunden. sagt mir aber außer refused nichts.

Aug 15 16:13:43 Homeserver pvescheduler[1471]: starting server Aug 15 16:13:43 Homeserver systemd[1]: Started Proxmox VE scheduler. Aug 15 16:13:43 Homeserver systemd[1]: Reached target Multi-User System. Aug 15 16:13:43 Homeserver systemd[1]: Reached target Graphical Interface. Aug 15 16:13:43 Homeserver systemd[1]: Starting Update UTMP about System Runlevel Changes... Aug 15 16:13:43 Homeserver systemd[1]: systemd-update-utmp-runlevel.service: Succeeded. Aug 15 16:13:43 Homeserver systemd[1]: Finished Update UTMP about System Runlevel Changes. Aug 15 16:13:43 Homeserver systemd[1]: Startup finished in 3.794s (kernel) + 25.290s (userspace) = 29.085s. Aug 15 16:13:48 Homeserver systemd-timesyncd[643]: Initial synchronization to time server 185.144.161.170:123 (2.debian.pool.ntp.org). Aug 15 16:13:52 Homeserver pvestatd[1100]: qemu status update error: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:13:53 Homeserver systemd[1]: Stopping User Manager for UID 0... Aug 15 16:13:53 Homeserver systemd[1142]: Stopped target Main User Target. Aug 15 16:13:53 Homeserver systemd[1142]: Stopped target Basic System. Aug 15 16:13:53 Homeserver systemd[1142]: Stopped target Paths. Aug 15 16:13:53 Homeserver systemd[1142]: Stopped target Sockets. Aug 15 16:13:53 Homeserver systemd[1142]: Stopped target Timers. Aug 15 16:13:53 Homeserver systemd[1142]: dirmngr.socket: Succeeded. Aug 15 16:13:53 Homeserver systemd[1142]: Closed GnuPG network certificate management daemon. Aug 15 16:13:53 Homeserver systemd[1142]: gpg-agent-browser.socket: Succeeded. Aug 15 16:13:53 Homeserver systemd[1142]: Closed GnuPG cryptographic agent and passphrase cache (access for web browsers). Aug 15 16:13:53 Homeserver systemd[1142]: gpg-agent-extra.socket: Succeeded. Aug 15 16:13:53 Homeserver systemd[1142]: Closed GnuPG cryptographic agent and passphrase cache (restricted). Aug 15 16:13:53 Homeserver systemd[1142]: gpg-agent-ssh.socket: Succeeded. Aug 15 16:13:53 Homeserver systemd[1142]: Closed GnuPG cryptographic agent (ssh-agent emulation). Aug 15 16:13:53 Homeserver systemd[1142]: gpg-agent.socket: Succeeded. Aug 15 16:13:53 Homeserver systemd[1142]: Closed GnuPG cryptographic agent and passphrase cache. Aug 15 16:13:53 Homeserver systemd[1142]: Removed slice User Application Slice. Aug 15 16:13:53 Homeserver systemd[1142]: Reached target Shutdown. Aug 15 16:13:53 Homeserver systemd[1142]: systemd-exit.service: Succeeded. Aug 15 16:13:53 Homeserver systemd[1142]: Finished Exit the Session. Aug 15 16:13:53 Homeserver systemd[1142]: Reached target Exit the Session. Aug 15 16:13:53 Homeserver systemd[1143]: pam_unix(systemd-user:session): session closed for user root Aug 15 16:13:53 Homeserver systemd[1]: user@0.service: Succeeded. Aug 15 16:13:53 Homeserver systemd[1]: Stopped User Manager for UID 0. Aug 15 16:13:53 Homeserver systemd[1]: Stopping User Runtime Directory /run/user/0... Aug 15 16:13:53 Homeserver systemd[1]: run-user-0.mount: Succeeded. Aug 15 16:13:53 Homeserver systemd[1]: user-runtime-dir@0.service: Succeeded. Aug 15 16:13:53 Homeserver systemd[1]: Stopped User Runtime Directory /run/user/0. Aug 15 16:13:53 Homeserver systemd[1]: Removed slice User Slice of UID 0. Aug 15 16:14:13 Homeserver pvestatd[1100]: qemu status update error: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:14:32 Homeserver pvestatd[1100]: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:14:32 Homeserver pvestatd[1100]: qemu status update error: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:14:42 Homeserver pvestatd[1100]: qemu status update error: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:14:52 Homeserver pvestatd[1100]: qemu status update error: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:15:02 Homeserver pvestatd[1100]: qemu status update error: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:15:32 Homeserver pvestatd[1100]: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:15:32 Homeserver pvestatd[1100]: qemu status update error: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:15:42 Homeserver pvestatd[1100]: qemu status update error: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:15:53 Homeserver pvestatd[1100]: qemu status update error: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:16:02 Homeserver pvestatd[1100]: qemu status update error: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:16:12 Homeserver pvestatd[1100]: qemu status update error: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:16:15 Homeserver pvedaemon[1121]: <root@pam> successful auth for user 'root@pam' Aug 15 16:16:19 Homeserver pvedaemon[1120]: <root@pam> successful auth for user 'root@pam' Aug 15 16:16:22 Homeserver pvestatd[1100]: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:16:22 Homeserver pvestatd[1100]: qemu status update error: metrics send error 'Proxmox': failed to send metrics: Connection refused Aug 15 16:16:32 Homeserver pvestatd[1100]: qemu status update error: metrics send error 'Proxmox': failed to send metrics: Connection refusedwie gesagt, ioB, Motioneye und PiHole funktionieren. nur die eine VM macht probleme...

@da_woody sagte in [wieder geöffnet] Tasmo Admin / VM Problem:

nur die eine VM macht probleme

und was zeigt die im Log

-

@da_woody sagte in [wieder geöffnet] Tasmo Admin / VM Problem:

nur die eine VM macht probleme

und was zeigt die im Log

-

@crunchip sorry, irgendwie hab ich irgendwie knopf im kopf. :(

wie komm ich da ran? in der proxmox verwaltung fin ich nixhts.@da_woody na wie auf jeder Maschine, im Verzeichnis /var/log/ findest du alle Möglichen Logs, daemon, dpkg, kern, syslog...

-

@da_woody na wie auf jeder Maschine, im Verzeichnis /var/log/ findest du alle Möglichen Logs, daemon, dpkg, kern, syslog...

@crunchip sag ja, knopf im kopf...

hab mal ins syslog reingelinst. anscheinend hab mal zu spät backups gelöscht.Aug 14 00:01:52 Debian systemd[1]: logrotate.service: Succeeded. AAug 14 00:01:52 Debian systemd[1]: rsyslog.service: Sent signal SIGHUP to main process 393 (rsyslogd) on client request. ug 14 00:01:52 Debian systemd[1]: Finished Rotate log files. Aug 14 00:01:52 Debian systemd[1]: logrotate.service: Consumed 1min 23.487s CPU time. Aug 14 00:01:52 Debian influxd[390]: ts=2022-08-13T22:01:52.860429Z lvl=info msg="Write failed" log_id=0cHFWMF0000 service=write shard=694 error="engine: error writing WAL entry: write /var/lib/influxdb/wal/Drassburg/autogen/694/_00187.wal: no space left on device" Aug 14 00:01:52 Debian influxd[390]: [httpd] 192.168.0.250 - admin [14/Aug/2022:00:01:52 +0200] "POST /write?database=Drassburg&db=Drassburg&p=%5BREDACTED%5D&precision=ms&u=admin HTTP/1.1" 500 131 "-" "-" 89ed0b16-1b53-11ed-96f0-76946d14c247 266 Aug 14 00:01:52 Debian influxd[390]: ts=2022-08-13T22:01:52.860518Z lvl=error msg="[500] - \"engine: error writing WAL entry: write /var/lib/influxdb/wal/Drassburg/autogen/694/_00187.wal: no space left on device\"" log_id=0cHFWMF0000 service=httpd Aug 14 00:01:52 Debian influxd[390]: ts=2022-08-13T22:01:52.861155Z lvl=info msg="Write failed" log_id=0cHFWMF0000 service=write shard=694 error="engine: error writing WAL entry: write /var/lib/influxdb/wal/Drassburg/autogen/694/_00187.wal: no space left on device" Aug 14 00:01:52 Debian influxd[390]: [httpd] 192.168.0.250 - admin [14/Aug/2022:00:01:52 +0200] "POST /write?database=Drassburg&db=Drassburg&p=%5BREDACTED%5D&precision=ms&u=admin HTTP/1.1" 500 131 "-" "-" 89ed27ab-1b53-11ed-96f1-76946d14c247 258 Aug 14 00:01:52 Debian influxd[390]: ts=2022-08-13T22:01:52.861244Z lvl=error msg="[500] - \"engine: error writing WAL entry: write /var/lib/influxdb/wal/Drassburg/autogen/694/_00187.wal: no space left on device\"" log_id=0cHFWMF0000 service=httpd Aug 14 00:01:52 Debian influxd[390]: ts=2022-08-13T22:01:52.861587Z lvl=info msg="Write failed" log_id=0cHFWMF0000 service=write shard=694 error="engine: error writing WAL entry: write /var/lib/influxdb/wal/Drassburg/autogen/694/_00187.wal: no space left on device"beim reinschauen in syslog.1 hab ich den anfang vom ende gefunden.

Aug 13 23:31:04 Debian influxd[390]: [httpd] 192.168.0.250 - admin [13/Aug/2022:23:31:04 +0200] "POST /write?database=Drassburg&db=Drassburg&p=%5BREDACTED%5D&precision=ms&u=admin HTTP/1.1" 204 0 "-" "-" 3c7d8d8b-1b4f-11ed-85bf-76946d14c247 30988 Aug 13 23:31:04 Debian influxd[390]: [httpd] 192.168.0.250 - admin [13/Aug/2022:23:31:04 +0200] "POST /write?database=Drassburg&db=Drassburg&p=%5BREDACTED%5D&precision=ms&u=admin HTTP/1.1" 204 0 "-" "-" 3c7ec94d-1b4f-11ed-85c1-76946d14c247 23024 Aug 13 23:31:04 Debian influxd[390]: [httpd] 192.168.0.250 - admin [13/Aug/2022:23:31:04 +0200] "POST /write?database=Drassburg&db=Drassburg&p=%5BREDACTED%5D&precision=ms&u=admin HTTP/1.1" 204 0 "-" "-" 3c7e6425-1b4f-11ed-85c0-76946d14c247 25475 Aug 13 23:31:04 Debian influxd[390]: [httpd] 192.168.0.250 - admin [13/Aug/2022:23:31:04 +0200] "POST /write?database=Drassburg&db=Drassburg&p=%5BREDACTED%5D&precision=ms&u=admin HTTP/1.1" 204 0 "-" "-" 3c7f277c-1b4f-11ed-85c2-76946d14c247 20685 Aug 13 23:31:05 Debian influxd[390]: [httpd] 192.168.0.250 - admin [13/Aug/2022:23:31:05 +0200] "POST /write?database=Drassburg&db=Drassburg&p=%5BREDACTED%5D&precision=ms&u=admin HTTP/1.1" 204 0 "-" "-" 3cbaa433-1b4f-11ed-85c4-76946d14c247 17374 Aug 13 23:31:05 Debian influxd[390]: ts=2022-08-13T21:31:05.376113Z lvl=info msg="Write failed" log_id=0cHFWMF0000 service=write shard=694 error="engine: error writing WAL entry: write /var/lib/influxdb/wal/Drassburg/autogen/694/_00187.wal: no space left on device" Aug 13 23:31:05 Debian influxd[390]: [httpd] 192.168.0.250 - admin [13/Aug/2022:23:31:05 +0200] "POST /write?database=Drassburg&db=Drassburg&p=%5BREDACTED%5D&precision=ms&u=admin HTTP/1.1" 500 131 "-" "-" 3cbd0265-1b4f-11ed-85cb-76946d14c247 2260 Aug 13 23:31:05 Debian influxd[390]: ts=2022-08-13T21:31:05.376245Z lvl=error msg="[500] - \"engine: error writing WAL entry: write /var/lib/influxdb/wal/Drassburg/autogen/694/_00187.wal: no space left on device\"" log_id=0cHFWMF0000 service=httpd Aug 13 23:31:05 Debian influxd[390]: ts=2022-08-13T21:31:05.376378Z lvl=info msg="Write failed" log_id=0cHFWMF0000 service=write shard=694 error="engine: error writing WAL entry: write /var/lib/influxdb/wal/Drassburg/autogen/694/_00187.wal: no space left on device" Aug 13 23:31:05 Debian influxd[390]: [httpd] 192.168.0.250 - admin [13/Aug/2022:23:31:05 +0200] "POST /write?database=Drassburg&db=Drassburg&p=%5BREDACTED%5D&precision=ms&u=admin HTTP/1.1" 500 131 "-" "-" 3cbab4d7-1b4f-11ed-85c5-76946d14c247 17557und ich volltrottel hab, nachdem alles wieder funktioniert hat zusammengeräumt und, entgegen meiner sonstigen gewohnheit die letzte sicherung stehn zu lassen, alle backups gelöscht... :face_with_head_bandage:

-

@crunchip sag ja, knopf im kopf...

hab mal ins syslog reingelinst. anscheinend hab mal zu spät backups gelöscht.Aug 14 00:01:52 Debian systemd[1]: logrotate.service: Succeeded. AAug 14 00:01:52 Debian systemd[1]: rsyslog.service: Sent signal SIGHUP to main process 393 (rsyslogd) on client request. ug 14 00:01:52 Debian systemd[1]: Finished Rotate log files. Aug 14 00:01:52 Debian systemd[1]: logrotate.service: Consumed 1min 23.487s CPU time. Aug 14 00:01:52 Debian influxd[390]: ts=2022-08-13T22:01:52.860429Z lvl=info msg="Write failed" log_id=0cHFWMF0000 service=write shard=694 error="engine: error writing WAL entry: write /var/lib/influxdb/wal/Drassburg/autogen/694/_00187.wal: no space left on device" Aug 14 00:01:52 Debian influxd[390]: [httpd] 192.168.0.250 - admin [14/Aug/2022:00:01:52 +0200] "POST /write?database=Drassburg&db=Drassburg&p=%5BREDACTED%5D&precision=ms&u=admin HTTP/1.1" 500 131 "-" "-" 89ed0b16-1b53-11ed-96f0-76946d14c247 266 Aug 14 00:01:52 Debian influxd[390]: ts=2022-08-13T22:01:52.860518Z lvl=error msg="[500] - \"engine: error writing WAL entry: write /var/lib/influxdb/wal/Drassburg/autogen/694/_00187.wal: no space left on device\"" log_id=0cHFWMF0000 service=httpd Aug 14 00:01:52 Debian influxd[390]: ts=2022-08-13T22:01:52.861155Z lvl=info msg="Write failed" log_id=0cHFWMF0000 service=write shard=694 error="engine: error writing WAL entry: write /var/lib/influxdb/wal/Drassburg/autogen/694/_00187.wal: no space left on device" Aug 14 00:01:52 Debian influxd[390]: [httpd] 192.168.0.250 - admin [14/Aug/2022:00:01:52 +0200] "POST /write?database=Drassburg&db=Drassburg&p=%5BREDACTED%5D&precision=ms&u=admin HTTP/1.1" 500 131 "-" "-" 89ed27ab-1b53-11ed-96f1-76946d14c247 258 Aug 14 00:01:52 Debian influxd[390]: ts=2022-08-13T22:01:52.861244Z lvl=error msg="[500] - \"engine: error writing WAL entry: write /var/lib/influxdb/wal/Drassburg/autogen/694/_00187.wal: no space left on device\"" log_id=0cHFWMF0000 service=httpd Aug 14 00:01:52 Debian influxd[390]: ts=2022-08-13T22:01:52.861587Z lvl=info msg="Write failed" log_id=0cHFWMF0000 service=write shard=694 error="engine: error writing WAL entry: write /var/lib/influxdb/wal/Drassburg/autogen/694/_00187.wal: no space left on device"beim reinschauen in syslog.1 hab ich den anfang vom ende gefunden.

Aug 13 23:31:04 Debian influxd[390]: [httpd] 192.168.0.250 - admin [13/Aug/2022:23:31:04 +0200] "POST /write?database=Drassburg&db=Drassburg&p=%5BREDACTED%5D&precision=ms&u=admin HTTP/1.1" 204 0 "-" "-" 3c7d8d8b-1b4f-11ed-85bf-76946d14c247 30988 Aug 13 23:31:04 Debian influxd[390]: [httpd] 192.168.0.250 - admin [13/Aug/2022:23:31:04 +0200] "POST /write?database=Drassburg&db=Drassburg&p=%5BREDACTED%5D&precision=ms&u=admin HTTP/1.1" 204 0 "-" "-" 3c7ec94d-1b4f-11ed-85c1-76946d14c247 23024 Aug 13 23:31:04 Debian influxd[390]: [httpd] 192.168.0.250 - admin [13/Aug/2022:23:31:04 +0200] "POST /write?database=Drassburg&db=Drassburg&p=%5BREDACTED%5D&precision=ms&u=admin HTTP/1.1" 204 0 "-" "-" 3c7e6425-1b4f-11ed-85c0-76946d14c247 25475 Aug 13 23:31:04 Debian influxd[390]: [httpd] 192.168.0.250 - admin [13/Aug/2022:23:31:04 +0200] "POST /write?database=Drassburg&db=Drassburg&p=%5BREDACTED%5D&precision=ms&u=admin HTTP/1.1" 204 0 "-" "-" 3c7f277c-1b4f-11ed-85c2-76946d14c247 20685 Aug 13 23:31:05 Debian influxd[390]: [httpd] 192.168.0.250 - admin [13/Aug/2022:23:31:05 +0200] "POST /write?database=Drassburg&db=Drassburg&p=%5BREDACTED%5D&precision=ms&u=admin HTTP/1.1" 204 0 "-" "-" 3cbaa433-1b4f-11ed-85c4-76946d14c247 17374 Aug 13 23:31:05 Debian influxd[390]: ts=2022-08-13T21:31:05.376113Z lvl=info msg="Write failed" log_id=0cHFWMF0000 service=write shard=694 error="engine: error writing WAL entry: write /var/lib/influxdb/wal/Drassburg/autogen/694/_00187.wal: no space left on device" Aug 13 23:31:05 Debian influxd[390]: [httpd] 192.168.0.250 - admin [13/Aug/2022:23:31:05 +0200] "POST /write?database=Drassburg&db=Drassburg&p=%5BREDACTED%5D&precision=ms&u=admin HTTP/1.1" 500 131 "-" "-" 3cbd0265-1b4f-11ed-85cb-76946d14c247 2260 Aug 13 23:31:05 Debian influxd[390]: ts=2022-08-13T21:31:05.376245Z lvl=error msg="[500] - \"engine: error writing WAL entry: write /var/lib/influxdb/wal/Drassburg/autogen/694/_00187.wal: no space left on device\"" log_id=0cHFWMF0000 service=httpd Aug 13 23:31:05 Debian influxd[390]: ts=2022-08-13T21:31:05.376378Z lvl=info msg="Write failed" log_id=0cHFWMF0000 service=write shard=694 error="engine: error writing WAL entry: write /var/lib/influxdb/wal/Drassburg/autogen/694/_00187.wal: no space left on device" Aug 13 23:31:05 Debian influxd[390]: [httpd] 192.168.0.250 - admin [13/Aug/2022:23:31:05 +0200] "POST /write?database=Drassburg&db=Drassburg&p=%5BREDACTED%5D&precision=ms&u=admin HTTP/1.1" 500 131 "-" "-" 3cbab4d7-1b4f-11ed-85c5-76946d14c247 17557und ich volltrottel hab, nachdem alles wieder funktioniert hat zusammengeräumt und, entgegen meiner sonstigen gewohnheit die letzte sicherung stehn zu lassen, alle backups gelöscht... :face_with_head_bandage:

@da_woody sagte in [wieder geöffnet] Tasmo Admin / VM Problem:

write /var/lib/influxdb/wal/Drassburg/autogen/694/_00187.wal: no space left on device"

na so wie es aussieht hast du da eigentlich nur ein kleines Platzproblem, deine Influxdb ist halt gewachsen. Wie groß ist denn die VM

-

@da_woody sagte in [wieder geöffnet] Tasmo Admin / VM Problem:

write /var/lib/influxdb/wal/Drassburg/autogen/694/_00187.wal: no space left on device"

na so wie es aussieht hast du da eigentlich nur ein kleines Platzproblem, deine Influxdb ist halt gewachsen. Wie groß ist denn die VM

-

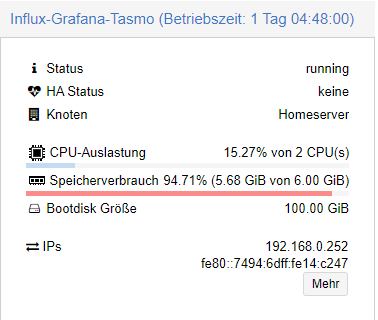

@da_woody so sieht man nur das deine Ram Auslastung am Limit ist

auf der VMdf -hbzw Datenbankgröße

sudo du -sh /var/lib/influxdb/data/ -

@da_woody so sieht man nur das deine Ram Auslastung am Limit ist

auf der VMdf -hbzw Datenbankgröße

sudo du -sh /var/lib/influxdb/data/@crunchip sagte in [wieder geöffnet] Tasmo Admin / VM Problem:

woody@Debian:~$ df -h Dateisystem Größe Benutzt Verf. Verw% Eingehängt auf udev 2,9G 0 2,9G 0% /dev tmpfs 595M 60M 535M 11% /run /dev/sda1 28G 28G 0 100% / tmpfs 3,0G 0 3,0G 0% /dev/shm tmpfs 5,0M 0 5,0M 0% /run/lock tmpfs 595M 0 595M 0% /run/user/1000 woody@Debian:~$ sudo du -sh /var/lib/influxdb/data/ [sudo] Passwort für woody: 7,4G /var/lib/influxdb/data/ woody@Debian:~$ -

@crunchip sagte in [wieder geöffnet] Tasmo Admin / VM Problem:

woody@Debian:~$ df -h Dateisystem Größe Benutzt Verf. Verw% Eingehängt auf udev 2,9G 0 2,9G 0% /dev tmpfs 595M 60M 535M 11% /run /dev/sda1 28G 28G 0 100% / tmpfs 3,0G 0 3,0G 0% /dev/shm tmpfs 5,0M 0 5,0M 0% /run/lock tmpfs 595M 0 595M 0% /run/user/1000 woody@Debian:~$ sudo du -sh /var/lib/influxdb/data/ [sudo] Passwort für woody: 7,4G /var/lib/influxdb/data/ woody@Debian:~$@da_woody kann es sein das du die VM in Proxmox vergössert hast? denn da steht 100 GB, du hast aber nur

@da_woody sagte in [wieder geöffnet] Tasmo Admin / VM Problem:

/dev/sda1 28G 28G 0 100% /

und die is VOLL

das heisst, du musst auch das Dateisystem erweitern, damit die 100GB erkannt werden

https://blog.bastii717.dev/speicherplatz-der-festplatte-erweitern/ -

@da_woody kann es sein das du die VM in Proxmox vergössert hast? denn da steht 100 GB, du hast aber nur

@da_woody sagte in [wieder geöffnet] Tasmo Admin / VM Problem:

/dev/sda1 28G 28G 0 100% /

und die is VOLL

das heisst, du musst auch das Dateisystem erweitern, damit die 100GB erkannt werden

https://blog.bastii717.dev/speicherplatz-der-festplatte-erweitern/@crunchip das hat mich auch irgendwie verwirrt. allerdings wurden die 100GB beim erstellen angegeben soweit ich mich erinnern kann. hab das jetzt mal auf 180GB vergrössert sinnloser weise.

der beitrag ist gut geschrieben, allerdings gibts fdisk -l, parted und co. in meinem debian nicht... -

@crunchip das hat mich auch irgendwie verwirrt. allerdings wurden die 100GB beim erstellen angegeben soweit ich mich erinnern kann. hab das jetzt mal auf 180GB vergrössert sinnloser weise.

der beitrag ist gut geschrieben, allerdings gibts fdisk -l, parted und co. in meinem debian nicht...@da_woody sagte in [wieder geöffnet] Tasmo Admin / VM Problem:

hab das jetzt mal auf 180GB vergrössert sinnloser weise.

warum machst du das, bedenke das ist begrenzt, deine Gesamtplatte/LVM ist wie groß?

sonst bekommst du die selben Probleme wie hier, https://forum.iobroker.net/post/795353@da_woody sagte in [wieder geöffnet] Tasmo Admin / VM Problem:

allerdings gibts fdisk -l, parted und co

kannst du nachinstallieren

alternativ kannst du es auch mit einer iso machen, siehe https://beyond.lol/disk-einer-vm-vergroessern-in-proxmox/#:~:text=Als erstes loggen wir uns,man die Disk vergrössern möchte

-

@da_woody sagte in [wieder geöffnet] Tasmo Admin / VM Problem:

hab das jetzt mal auf 180GB vergrössert sinnloser weise.

warum machst du das, bedenke das ist begrenzt, deine Gesamtplatte/LVM ist wie groß?

sonst bekommst du die selben Probleme wie hier, https://forum.iobroker.net/post/795353@da_woody sagte in [wieder geöffnet] Tasmo Admin / VM Problem:

allerdings gibts fdisk -l, parted und co

kannst du nachinstallieren

alternativ kannst du es auch mit einer iso machen, siehe https://beyond.lol/disk-einer-vm-vergroessern-in-proxmox/#:~:text=Als erstes loggen wir uns,man die Disk vergrössern möchte

@crunchip moin!

warum machst du das

aus blödheit? :D

hab aber entdeckt, daß ich mal proxmoxbackup eingerichtet habe und dort noch backup vom 2022-08-07 gefunden. das hab ich jetzt mal zurückgespielt. somit ist wieder 100GB bootdisk da. gparted iso hab ich auch schon am server. am nachmittag werd ich das mal probieren und danach nochmal das ganze posting durcharbeiten...

mal schauen. :)

thnx für den isotip! ist für mich sicher einfacher, als auf der konsole rumzuturnen. -

@crunchip moin!

warum machst du das

aus blödheit? :D

hab aber entdeckt, daß ich mal proxmoxbackup eingerichtet habe und dort noch backup vom 2022-08-07 gefunden. das hab ich jetzt mal zurückgespielt. somit ist wieder 100GB bootdisk da. gparted iso hab ich auch schon am server. am nachmittag werd ich das mal probieren und danach nochmal das ganze posting durcharbeiten...

mal schauen. :)

thnx für den isotip! ist für mich sicher einfacher, als auf der konsole rumzuturnen.@da_woody sagte in [wieder geöffnet] Tasmo Admin / VM Problem:

ist für mich sicher einfacher, als auf der konsole rumzuturnen.

deshalb der Link:stuck_out_tongue_winking_eye:

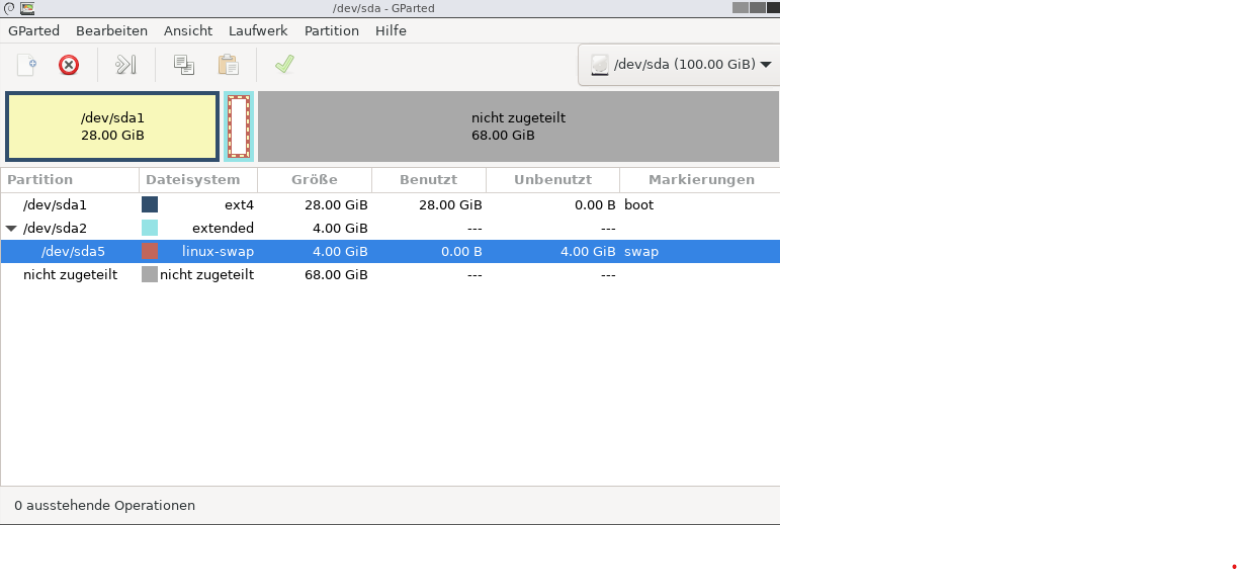

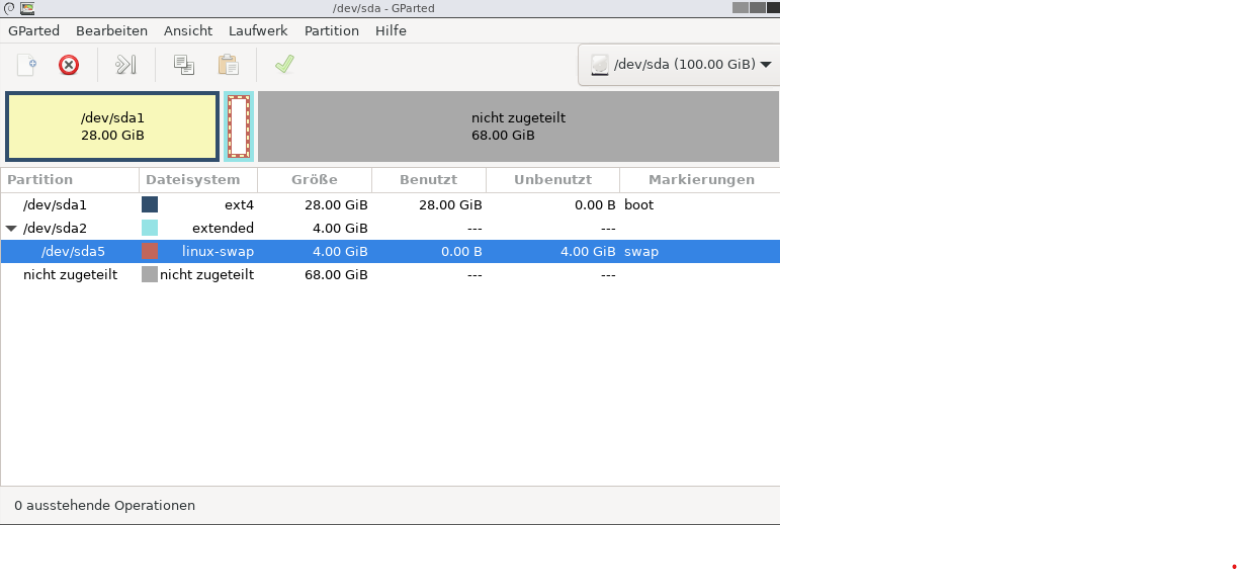

sollte normal klappen, einzige kann sein, je nach dem wie die Partition angelegt ist, das du das Volumen nicht erweitern kannst, weil die swap Partition in Weg ist. Sollte das der Fall sein, muss diese Weg, Volumen erweitern und danach die swap Partition wieder anfügen.

Falls Fragen, VORHER Fragen, bevor du Mist baust

-

@da_woody sagte in [wieder geöffnet] Tasmo Admin / VM Problem:

ist für mich sicher einfacher, als auf der konsole rumzuturnen.

deshalb der Link:stuck_out_tongue_winking_eye:

sollte normal klappen, einzige kann sein, je nach dem wie die Partition angelegt ist, das du das Volumen nicht erweitern kannst, weil die swap Partition in Weg ist. Sollte das der Fall sein, muss diese Weg, Volumen erweitern und danach die swap Partition wieder anfügen.

Falls Fragen, VORHER Fragen, bevor du Mist baust

@crunchip sagte in [wieder geöffnet] Tasmo Admin / VM Problem:

Falls Fragen, VORHER Fragen, bevor du Mist baust

ich schwöre! :D

ich hab mir vorher auch die 3 anderen VMs mit

df -hangeschaut. dort passen die größen. strange, warum das nur bei der einen auftritt. -

@crunchip sagte in [wieder geöffnet] Tasmo Admin / VM Problem:

Falls Fragen, VORHER Fragen, bevor du Mist baust

ich schwöre! :D

ich hab mir vorher auch die 3 anderen VMs mit

df -hangeschaut. dort passen die größen. strange, warum das nur bei der einen auftritt.@da_woody zo!

ich denk mal, ich kann erfolg vermelden. musste nach einem erstversuch nochmal das backup zurück spielen. my fault.

original, warum auch immer:

hab dann sda5, danach sda2 gekillt. sda1 vergrößert und hinten wieder ein swap gebastelt. allerdings nicht als extended, sondern als sda2. daten fluppen mal wieder rein, grafana funzt, ebenso wie influxDB-Studio.

jetzt noch den sermon wegen tasmoadmin durchgehn...

bascht das so? oder soll ich noch was anderes tun? -

@da_woody zo!

ich denk mal, ich kann erfolg vermelden. musste nach einem erstversuch nochmal das backup zurück spielen. my fault.

original, warum auch immer:

hab dann sda5, danach sda2 gekillt. sda1 vergrößert und hinten wieder ein swap gebastelt. allerdings nicht als extended, sondern als sda2. daten fluppen mal wieder rein, grafana funzt, ebenso wie influxDB-Studio.

jetzt noch den sermon wegen tasmoadmin durchgehn...

bascht das so? oder soll ich noch was anderes tun?@da_woody sagte in [wieder geöffnet] Tasmo Admin / VM Problem:

bascht das so?

weiss net, seh ich ja nicht:stuck_out_tongue_winking_eye:

wenn dein sda1 jetzt aufs max vergrößert ist, dann sollte es passen

df -h -

@da_woody sagte in [wieder geöffnet] Tasmo Admin / VM Problem:

bascht das so?

weiss net, seh ich ja nicht:stuck_out_tongue_winking_eye:

wenn dein sda1 jetzt aufs max vergrößert ist, dann sollte es passen

df -h@crunchip vor lauter begeisterung... :D

woody@Debian:~$ df -h Dateisystem Größe Benutzt Verf. Verw% Eingehängt auf udev 2,9G 0 2,9G 0% /dev tmpfs 595M 508K 594M 1% /run /dev/sda1 95G 21G 69G 24% / tmpfs 3,0G 0 3,0G 0% /dev/shm tmpfs 5,0M 0 5,0M 0% /run/lock tmpfs 595M 0 595M 0% /run/user/1000 woody@Debian:~$und damits nicht fad wird, ist mir der shelly 1pm vom poolfilter abgekackt... naja, 3 jahre im freien...

gerade neuen angelernt, aliasmanager wieder angepasst. einbauen is heute nicht mehr drinnen... definitiv zu hardcore in der prallen...

-

@da_woody sagte in [wieder geöffnet] Tasmo Admin / VM Problem:

bascht das so?

weiss net, seh ich ja nicht:stuck_out_tongue_winking_eye:

wenn dein sda1 jetzt aufs max vergrößert ist, dann sollte es passen

df -h -

@da_woody sagte in [done] Tasmo Admin Problem:

Dann installier php-curl und php-zip noch nach und dann sollte es auch für ein upgrade auf bookworm nächstes Jahr passen. Egal welche php-Version da genau aktuell sein wird.

@thomas-braun sagte in [wieder erledigt] Tasmo Admin / VM Problem:

@da_woody sagte in [done] Tasmo Admin Problem:

dann sollte es auch für ein upgrade auf bookworm nächstes Jahr passen. Egal welche php-Version da genau aktuell sein wird.

oder so...

nach wurmupdate wieder das selbe. kein zugriff auf tasmoadmin.

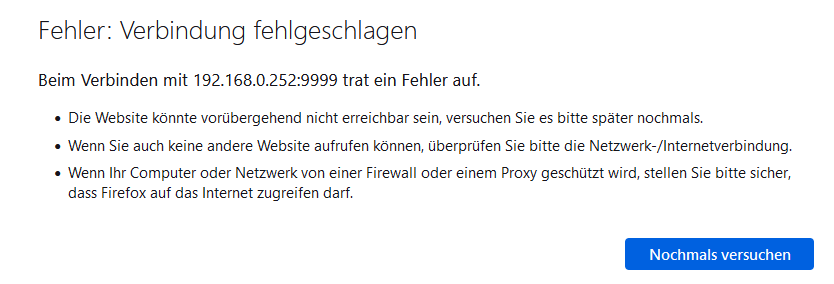

firefox:

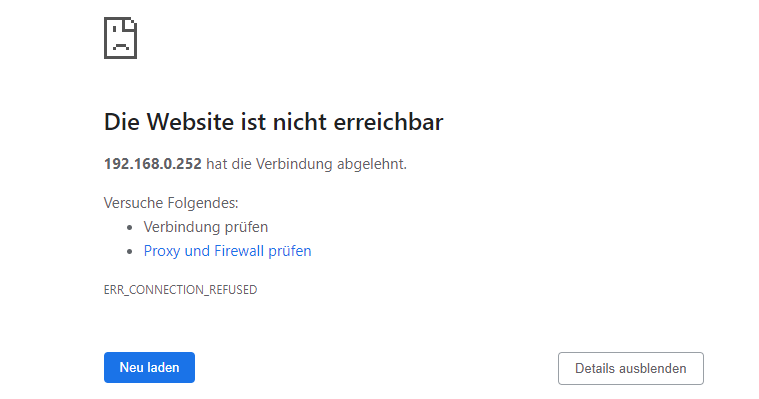

chrome:

woody@Debian:~$ apt policy libapache2-mod-php php php-curl php-zip libapache2-mod-php: Installiert: 2:8.2+93 Installationskandidat: 2:8.2+93 Versionstabelle: *** 2:8.2+93 500 500 http://deb.debian.org/debian bookworm/main amd64 Packages 100 /var/lib/dpkg/status php: Installiert: 2:8.2+93 Installationskandidat: 2:8.2+93 Versionstabelle: *** 2:8.2+93 500 500 http://deb.debian.org/debian bookworm/main amd64 Packages 100 /var/lib/dpkg/status php-curl: Installiert: 2:8.2+93 Installationskandidat: 2:8.2+93 Versionstabelle: *** 2:8.2+93 500 500 http://deb.debian.org/debian bookworm/main amd64 Packages 100 /var/lib/dpkg/status php-zip: Installiert: 2:8.2+93 Installationskandidat: 2:8.2+93 Versionstabelle: *** 2:8.2+93 500 500 http://deb.debian.org/debian bookworm/main amd64 Packages 100 /var/lib/dpkg/status woody@Debian:~$