NEWS

Test/Support für Adapter rssfeed und vis-2-widgets-rssfeed

-

hab eben den Adapter nochmal komplett gelöscht und neu installiert.

Admin 5.3.2Die Gui funktioniert nicht mehr, man kann nichts mehr speichern.

@skokarl sagte in Test und Support Adapter rssfeed v1.x.x:

hab eben den Adapter nochmal komplett gelöscht und neu installiert.

Admin 5.3.2Die Gui funktioniert nicht mehr, man kann nichts mehr speichern.

so ich habe auf dem testsystem mal für alles relevante ein update gemacht

iobroker 4.0.21

Admin 5.3.3

Web 4.2.1

rssfeed 1.0.0dann den adapter gelöscht und wieder hinzugefügt.

die adapter-konfigurationsseite rssfeed funktioniert wie vorher in chrome einwandfrei

auf firefox, wie gehabt das scroll-problem

aber ansonsten konnte ich alle rssfeeds neu hinzufügen und abspeichern.das speicherproblem würde ich ja gern nochmal nachvollziehen, leider hast du noch nicht geantwortet, ob der adapter selber abstürzt oder ob der browser so etwas anzeigt. auch wolltest du mal noch die ram-relevanten datenpunkte des adapter mal aufzeichnen (siehe weiter oben)

-

@skokarl sagte in Test und Support Adapter rssfeed v1.x.x:

hab eben den Adapter nochmal komplett gelöscht und neu installiert.

Admin 5.3.2Die Gui funktioniert nicht mehr, man kann nichts mehr speichern.

so ich habe auf dem testsystem mal für alles relevante ein update gemacht

iobroker 4.0.21

Admin 5.3.3

Web 4.2.1

rssfeed 1.0.0dann den adapter gelöscht und wieder hinzugefügt.

die adapter-konfigurationsseite rssfeed funktioniert wie vorher in chrome einwandfrei

auf firefox, wie gehabt das scroll-problem

aber ansonsten konnte ich alle rssfeeds neu hinzufügen und abspeichern.das speicherproblem würde ich ja gern nochmal nachvollziehen, leider hast du noch nicht geantwortet, ob der adapter selber abstürzt oder ob der browser so etwas anzeigt. auch wolltest du mal noch die ram-relevanten datenpunkte des adapter mal aufzeichnen (siehe weiter oben)

Hallo Oliver,

ja, wenn immer alles so einfach wäre.

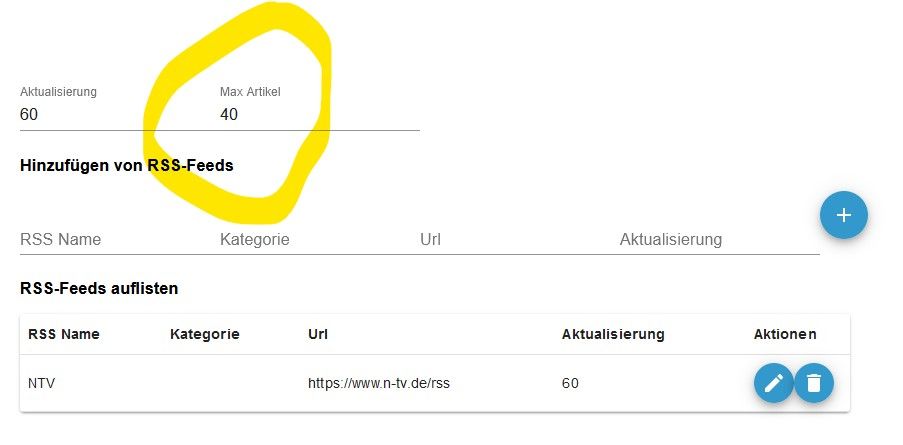

Erstmal kurz zur GUI, versuch mal die die "max Artikel" Einstellung zu ändern und abzuspeichern.

Ich nutze nur Firefox, kriegs aber gerade mit Chrome auch nicht hin.

Allerdings bestehe ich auch auf Firefox weil sonst wirklich alles im Browser funktioniert, und wg einem Adapter ggf auf Chrome zu gehen sehe ich nicht wirklich ein.Ansonsten bringt hier viel Schreiben wenig, da müssen wir mal Anydesk bemühen.

Zum Speicherproblem,...also, wie Du sicherlich mitbekommen hast hatte ich hier wochenlang riesen Theater mit Abstürzen. Ich war kurz davor ne neue NUC zu kaufen, da ich zwischenzeitlich Hardwareprobleme vermutet hatte.

( Speicher, SSD, Controller etc.)Selbst das System habe ich mehrmals komplett neu aufgesetzt, mit Proxmox, mal ein Container, mal eine VM, unterschiedliche Konfiguration usw, alles was man eben machen kann.

Da unser Tablet hier nicht zum Spaß hängt, und meine Frau es auch gerne nutzen möchte ( auch wenn es nur ein "Nice to have" ist), ist es schwierig ständig Experimente zu machen um Fehler zu suchen und zu finden.

Kurzum, aktuell habe ich wieder ein sehr stabiles System, und zwar seit der RSS nicht mehr läuft.

Bis zu diesem Zeitpunkt hatte ich alle Apdater immer mal tageweise abgeschaltet, um auch wirklich sicher zu sein was das Problem sein könnte. Auch die InfluxDB ist irgendwann rausgeflogen und aktuell noch nicht wieder drin, somit waren weitere Speicheraufzeichnungen nicht möglich.

Bis dahin waren die RAM Aufzeichnungen nicht wirklich hillfreich, weil unauffällig.

Aber wie gesagt, ich kann meiner Frau hier nicht tagelang das Radio wegnehmen nur um einen Fehler zu finden.Stand heute,

GUI hat irgendwie Probleme beim Aktivieren des Speicherbuttons ( zur Not machen wir nachher mal kurz ne Anydesk )

System ist stabil seit RSS aus ist.Was hilft Dir noch ?

Also, ich liebe den Adapter, kann ihn aber aktuell nicht nutzen da meine Frau dann wieder auf einige eine nützliche Dinge verzichten müsste.

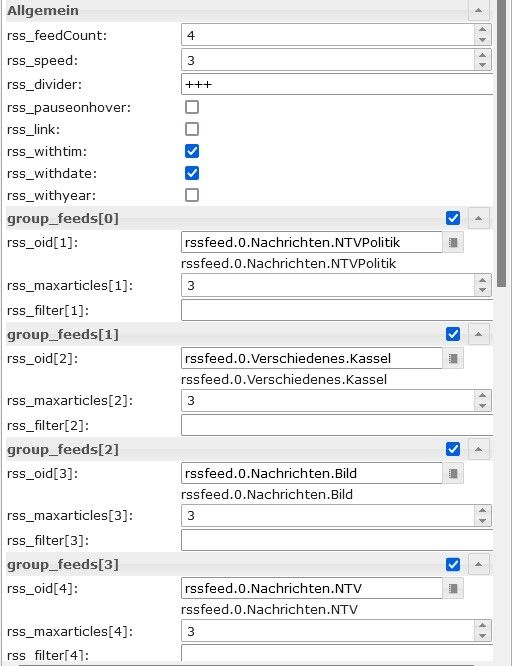

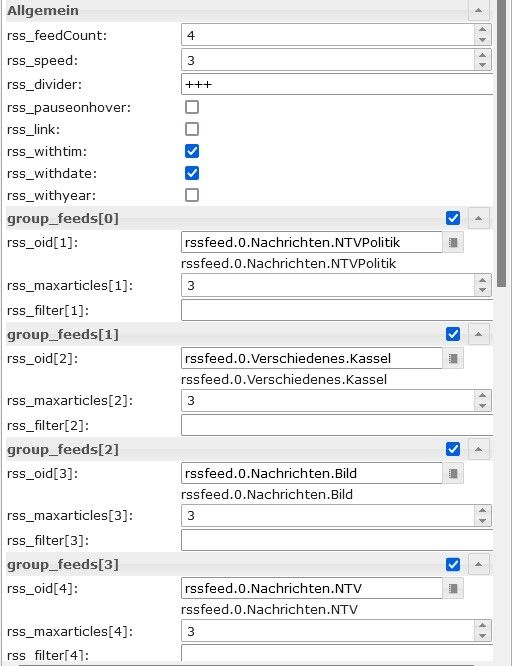

( mal nach ein paar Stunden, mal nach einem Tag )Seltsam ist, aber vielleicht doch hilfreich, dass die Abstürze mit dem vierten RSS Eintrag begonnen haben, ( so glaube ich mich erinnern zu können ). Ich nutze den Adapter vom ersten Tag an, der hat vorher nie Stress gemacht.

Dazu kommt evtl. die Anzahl der Feeds die sicherlich bedingt durch das aktuelle Geschehen nicht weniger geworden sind.Kannst Du mal testen

https://www.hna.de/kassel/kreis-kassel/rssfeed.xml https://www.n-tv.de/rss https://www.bild.de/rssfeeds/rss3-20745882,feed=alles.bild.html https://www.n-tv.de/politik/rss

Einstellungen dazu im Adpater kann ich Dir nicht mehr genau sagen, auf jeden Fall hatte ich die Anzahl oder die Aktualisierung nie negativ verändert, eher andersherum.

Kurzum, ich helfe Dir jederzeit gerne weiter, ich möchte den RSS ja auch wieder, allerdings habe ich keine Hardware für ein Testsystem, und hier im produktiven Betrieb kann ich nicht alles tagelang protokollieren und mir die Abstürze wieder ins Haus holen.

Am Schluss bleibt noch zu sagen..... DANKE für Deine tollen Adapter und Dein Support.

Bernd

p.s. vielleicht habe ich auch unrecht und es ist ein anderer Adapter der den RSS zum Absturz bringt, dann tut es mir leid, aber das werden wir wohl nie rauskriegen.

Absturz

2022-02-23 06:47:04.396 - info: daswetter.2 (3111) cleaned everything up... 2022-02-23 06:47:04.414 - info: host.iobroker instance system.adapter.daswetter.2 terminated with code 11 (ADAPTER_REQUESTED_TERMINATION) 2022-02-23 06:50:59.125 - error: host.iobroker Caught by controller[0]: <--- Last few GCs ---> 2022-02-23 06:50:59.129 - error: host.iobroker Caught by controller[0]: [1429:0x5ff9740] 52518066 ms: Mark-sweep (reduce) 1933.4 (2083.5) -> 1933.4 (2083.5) MB, 197.7 / 0.0 ms (average mu = 0.150, current mu = 0.000) last resort GC in old space requested 2022-02-23 06:50:59.130 - error: host.iobroker Caught by controller[0]: [1429:0x5ff9740] 52518281 ms: Mark-sweep (reduce) 1933.4 (2055.5) -> 1933.4 (2055.5) MB, 215.2 / 0.0 ms (average mu = 0.074, current mu = 0.000) last resort GC in old space requested 2022-02-23 06:50:59.130 - error: host.iobroker Caught by controller[0]: <--- JS stacktrace ---> 2022-02-23 06:50:59.130 - error: host.iobroker Caught by controller[0]: FATAL ERROR: CALL_AND_RETRY_LAST Allocation failed - JavaScript heap out of memory 2022-02-23 06:50:59.131 - error: host.iobroker Caught by controller[1]: 1: 0xa389b0 node::Abort() [io.web.0] 2022-02-23 06:50:59.131 - error: host.iobroker Caught by controller[2]: 2: 0x96e0af node::FatalError(char const*, char const*) [io.web.0] 2022-02-23 06:50:59.131 - error: host.iobroker Caught by controller[3]: 3: 0xbb7a4e v8::Utils::ReportOOMFailure(v8::internal::Isolate*, char const*, bool) [io.web.0] 2022-02-23 06:50:59.132 - error: host.iobroker Caught by controller[4]: 4: 0xbb7dc7 v8::internal::V8::FatalProcessOutOfMemory(v8::internal::Isolate*, char const*, bool) [io.web.0] 2022-02-23 06:50:59.132 - error: host.iobroker Caught by controller[5]: 5: 0xd73fd5 [io.web.0] 2022-02-23 06:50:59.132 - error: host.iobroker Caught by controller[6]: 6: 0xd865f1 v8::internal::Heap::AllocateRawWithRetryOrFailSlowPath(int, v8::internal::AllocationType, v8::internal::AllocationOrigin, v8::internal::AllocationAlignment) [io.web.0] 2022-02-23 06:50:59.132 - error: host.iobroker Caught by controller[7]: 7: 0xd4bd2d v8::internal::Factory::AllocateRaw(int, v8::internal::AllocationType, v8::internal::AllocationAlignment) [io.web.0] 2022-02-23 06:50:59.133 - error: host.iobroker Caught by controller[8]: 8: 0xd45bb4 v8::internal::FactoryBase::AllocateRawWithImmortalMap(int, v8::internal::AllocationType, v8::internal::Map, v8::internal::AllocationAlignment) [io.web.0] 2022-02-23 06:50:59.133 - error: host.iobroker Caught by controller[9]: 9: 0xd47f01 v8::internal::FactoryBase::NewRawTwoByteString(int, v8::internal::AllocationType) [io.web.0] 2022-02-23 06:50:59.133 - error: host.iobroker Caught by controller[10]: 10: 0xd4de9c v8::internal::Factory::NewStringFromUtf8(v8::internal::Vector const&, v8::internal::AllocationType) [io.web.0] 2022-02-23 06:50:59.133 - error: host.iobroker Caught by controller[11]: 11: 0xbcec02 v8::String::NewFromUtf8(v8::Isolate*, char const*, v8::NewStringType, int) [io.web.0] 2022-02-23 06:50:59.134 - error: host.iobroker Caught by controller[11]: 12: 0xb1c319 [io.web.0] 2022-02-23 06:50:59.134 - error: host.iobroker Caught by controller[12]: 13: 0xa14671 [io.web.0] 2022-02-23 06:50:59.134 - error: host.iobroker Caught by controller[13]: 14: 0x13ddced [io.web.0] 2022-02-23 06:50:59.134 - warn: host.iobroker instance system.adapter.web.0 terminated due to SIGABRT 2022-02-23 06:50:59.135 - info: host.iobroker instance system.adapter.web.0 terminated with code NaN () 2022-02-23 06:50:59.135 - info: host.iobroker Restart adapter system.adapter.web.0 because enabled -

Hallo Oliver,

ja, wenn immer alles so einfach wäre.

Erstmal kurz zur GUI, versuch mal die die "max Artikel" Einstellung zu ändern und abzuspeichern.

Ich nutze nur Firefox, kriegs aber gerade mit Chrome auch nicht hin.

Allerdings bestehe ich auch auf Firefox weil sonst wirklich alles im Browser funktioniert, und wg einem Adapter ggf auf Chrome zu gehen sehe ich nicht wirklich ein.Ansonsten bringt hier viel Schreiben wenig, da müssen wir mal Anydesk bemühen.

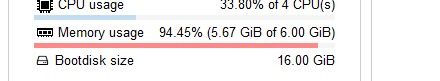

Zum Speicherproblem,...also, wie Du sicherlich mitbekommen hast hatte ich hier wochenlang riesen Theater mit Abstürzen. Ich war kurz davor ne neue NUC zu kaufen, da ich zwischenzeitlich Hardwareprobleme vermutet hatte.

( Speicher, SSD, Controller etc.)Selbst das System habe ich mehrmals komplett neu aufgesetzt, mit Proxmox, mal ein Container, mal eine VM, unterschiedliche Konfiguration usw, alles was man eben machen kann.

Da unser Tablet hier nicht zum Spaß hängt, und meine Frau es auch gerne nutzen möchte ( auch wenn es nur ein "Nice to have" ist), ist es schwierig ständig Experimente zu machen um Fehler zu suchen und zu finden.

Kurzum, aktuell habe ich wieder ein sehr stabiles System, und zwar seit der RSS nicht mehr läuft.

Bis zu diesem Zeitpunkt hatte ich alle Apdater immer mal tageweise abgeschaltet, um auch wirklich sicher zu sein was das Problem sein könnte. Auch die InfluxDB ist irgendwann rausgeflogen und aktuell noch nicht wieder drin, somit waren weitere Speicheraufzeichnungen nicht möglich.

Bis dahin waren die RAM Aufzeichnungen nicht wirklich hillfreich, weil unauffällig.

Aber wie gesagt, ich kann meiner Frau hier nicht tagelang das Radio wegnehmen nur um einen Fehler zu finden.Stand heute,

GUI hat irgendwie Probleme beim Aktivieren des Speicherbuttons ( zur Not machen wir nachher mal kurz ne Anydesk )

System ist stabil seit RSS aus ist.Was hilft Dir noch ?

Also, ich liebe den Adapter, kann ihn aber aktuell nicht nutzen da meine Frau dann wieder auf einige eine nützliche Dinge verzichten müsste.

( mal nach ein paar Stunden, mal nach einem Tag )Seltsam ist, aber vielleicht doch hilfreich, dass die Abstürze mit dem vierten RSS Eintrag begonnen haben, ( so glaube ich mich erinnern zu können ). Ich nutze den Adapter vom ersten Tag an, der hat vorher nie Stress gemacht.

Dazu kommt evtl. die Anzahl der Feeds die sicherlich bedingt durch das aktuelle Geschehen nicht weniger geworden sind.Kannst Du mal testen

https://www.hna.de/kassel/kreis-kassel/rssfeed.xml https://www.n-tv.de/rss https://www.bild.de/rssfeeds/rss3-20745882,feed=alles.bild.html https://www.n-tv.de/politik/rss

Einstellungen dazu im Adpater kann ich Dir nicht mehr genau sagen, auf jeden Fall hatte ich die Anzahl oder die Aktualisierung nie negativ verändert, eher andersherum.

Kurzum, ich helfe Dir jederzeit gerne weiter, ich möchte den RSS ja auch wieder, allerdings habe ich keine Hardware für ein Testsystem, und hier im produktiven Betrieb kann ich nicht alles tagelang protokollieren und mir die Abstürze wieder ins Haus holen.

Am Schluss bleibt noch zu sagen..... DANKE für Deine tollen Adapter und Dein Support.

Bernd

p.s. vielleicht habe ich auch unrecht und es ist ein anderer Adapter der den RSS zum Absturz bringt, dann tut es mir leid, aber das werden wir wohl nie rauskriegen.

Absturz

2022-02-23 06:47:04.396 - info: daswetter.2 (3111) cleaned everything up... 2022-02-23 06:47:04.414 - info: host.iobroker instance system.adapter.daswetter.2 terminated with code 11 (ADAPTER_REQUESTED_TERMINATION) 2022-02-23 06:50:59.125 - error: host.iobroker Caught by controller[0]: <--- Last few GCs ---> 2022-02-23 06:50:59.129 - error: host.iobroker Caught by controller[0]: [1429:0x5ff9740] 52518066 ms: Mark-sweep (reduce) 1933.4 (2083.5) -> 1933.4 (2083.5) MB, 197.7 / 0.0 ms (average mu = 0.150, current mu = 0.000) last resort GC in old space requested 2022-02-23 06:50:59.130 - error: host.iobroker Caught by controller[0]: [1429:0x5ff9740] 52518281 ms: Mark-sweep (reduce) 1933.4 (2055.5) -> 1933.4 (2055.5) MB, 215.2 / 0.0 ms (average mu = 0.074, current mu = 0.000) last resort GC in old space requested 2022-02-23 06:50:59.130 - error: host.iobroker Caught by controller[0]: <--- JS stacktrace ---> 2022-02-23 06:50:59.130 - error: host.iobroker Caught by controller[0]: FATAL ERROR: CALL_AND_RETRY_LAST Allocation failed - JavaScript heap out of memory 2022-02-23 06:50:59.131 - error: host.iobroker Caught by controller[1]: 1: 0xa389b0 node::Abort() [io.web.0] 2022-02-23 06:50:59.131 - error: host.iobroker Caught by controller[2]: 2: 0x96e0af node::FatalError(char const*, char const*) [io.web.0] 2022-02-23 06:50:59.131 - error: host.iobroker Caught by controller[3]: 3: 0xbb7a4e v8::Utils::ReportOOMFailure(v8::internal::Isolate*, char const*, bool) [io.web.0] 2022-02-23 06:50:59.132 - error: host.iobroker Caught by controller[4]: 4: 0xbb7dc7 v8::internal::V8::FatalProcessOutOfMemory(v8::internal::Isolate*, char const*, bool) [io.web.0] 2022-02-23 06:50:59.132 - error: host.iobroker Caught by controller[5]: 5: 0xd73fd5 [io.web.0] 2022-02-23 06:50:59.132 - error: host.iobroker Caught by controller[6]: 6: 0xd865f1 v8::internal::Heap::AllocateRawWithRetryOrFailSlowPath(int, v8::internal::AllocationType, v8::internal::AllocationOrigin, v8::internal::AllocationAlignment) [io.web.0] 2022-02-23 06:50:59.132 - error: host.iobroker Caught by controller[7]: 7: 0xd4bd2d v8::internal::Factory::AllocateRaw(int, v8::internal::AllocationType, v8::internal::AllocationAlignment) [io.web.0] 2022-02-23 06:50:59.133 - error: host.iobroker Caught by controller[8]: 8: 0xd45bb4 v8::internal::FactoryBase::AllocateRawWithImmortalMap(int, v8::internal::AllocationType, v8::internal::Map, v8::internal::AllocationAlignment) [io.web.0] 2022-02-23 06:50:59.133 - error: host.iobroker Caught by controller[9]: 9: 0xd47f01 v8::internal::FactoryBase::NewRawTwoByteString(int, v8::internal::AllocationType) [io.web.0] 2022-02-23 06:50:59.133 - error: host.iobroker Caught by controller[10]: 10: 0xd4de9c v8::internal::Factory::NewStringFromUtf8(v8::internal::Vector const&, v8::internal::AllocationType) [io.web.0] 2022-02-23 06:50:59.133 - error: host.iobroker Caught by controller[11]: 11: 0xbcec02 v8::String::NewFromUtf8(v8::Isolate*, char const*, v8::NewStringType, int) [io.web.0] 2022-02-23 06:50:59.134 - error: host.iobroker Caught by controller[11]: 12: 0xb1c319 [io.web.0] 2022-02-23 06:50:59.134 - error: host.iobroker Caught by controller[12]: 13: 0xa14671 [io.web.0] 2022-02-23 06:50:59.134 - error: host.iobroker Caught by controller[13]: 14: 0x13ddced [io.web.0] 2022-02-23 06:50:59.134 - warn: host.iobroker instance system.adapter.web.0 terminated due to SIGABRT 2022-02-23 06:50:59.135 - info: host.iobroker instance system.adapter.web.0 terminated with code NaN () 2022-02-23 06:50:59.135 - info: host.iobroker Restart adapter system.adapter.web.0 because enabledhm, was mach ich mit dir.

also der reihe nach- admin gui nicht mehr bedienbar.

wie gesagt, ich habe das nachvollzogen und bei mir funktioniert es.

leider habe ich aktuell nur in den randzeiten etwas zeit, zu denen du wahrscheinlich kein anydesk mehr machen kannst.

aber nochmal vorab. kannst du beim aufruf der admin gui bitte mal die browserkonsole (F12 chrome,edge und firefox) aufrufen und da schauen, ob da irgendwas nach Fehler im rssfeed aussieht? da werden die fehler, neben warnungen und debughinweisen auch explizit ausgewiesen. - absturz.

also nach log passiert das auf der serverseite. also iobroker. was mich etwas wundert, aber ich kann das log auch nicht so exakt lesen, es ist der web-adapter abgestürzt und nicht rssfeed.

erkennbar in den zeilen steht [io.web.0]

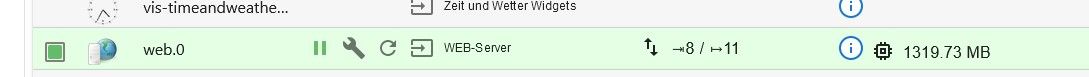

dieser adapter hat zu wenig speicher und hat sich dann beendet. das heißt den müsste man in die untersuchung mit einbeziehen.

mit dieser information würde mich der steigenden speicherverbrauch maL des web-adapters interessieren. aber ein typischer kandidat ist eigentlich immer auch der javascript-adapter.

ich gehe davon aus, das du den history-adapter laufen lassen hast?

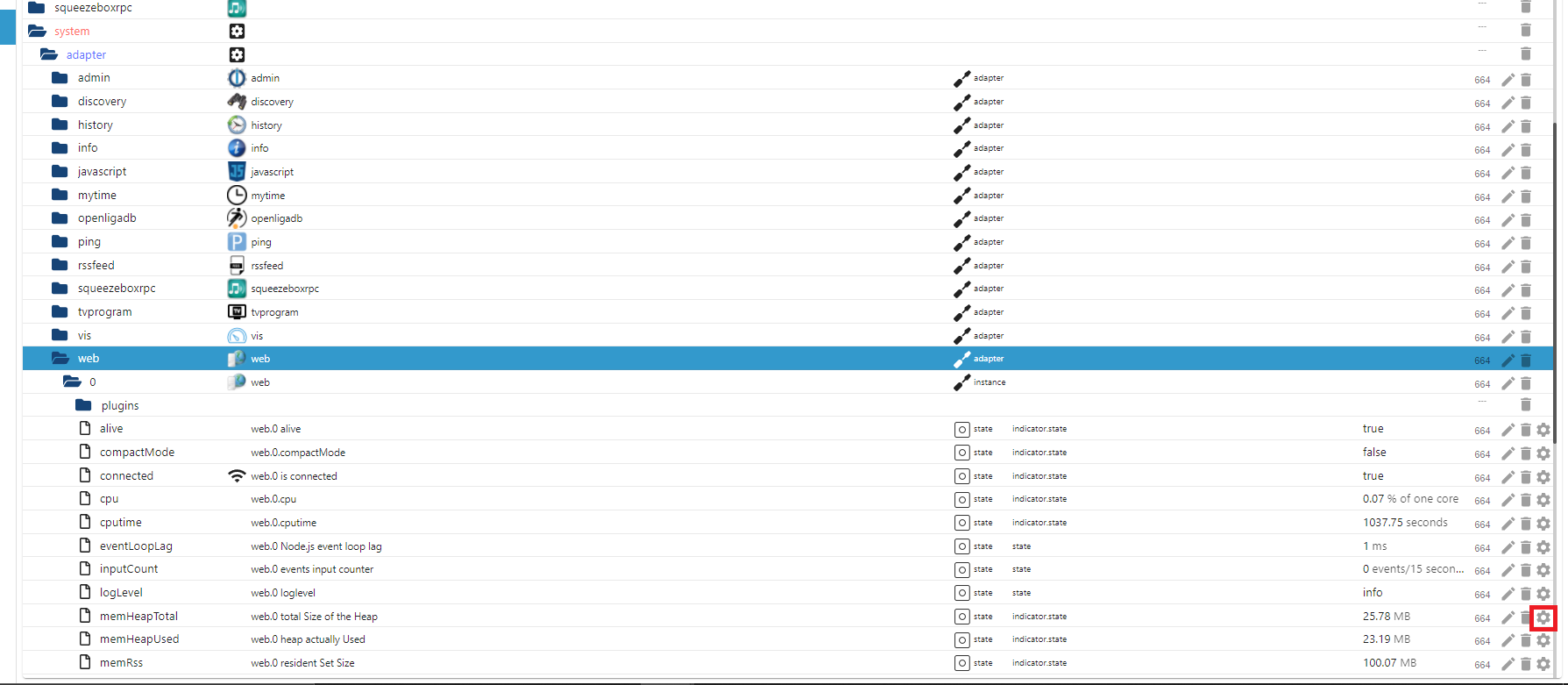

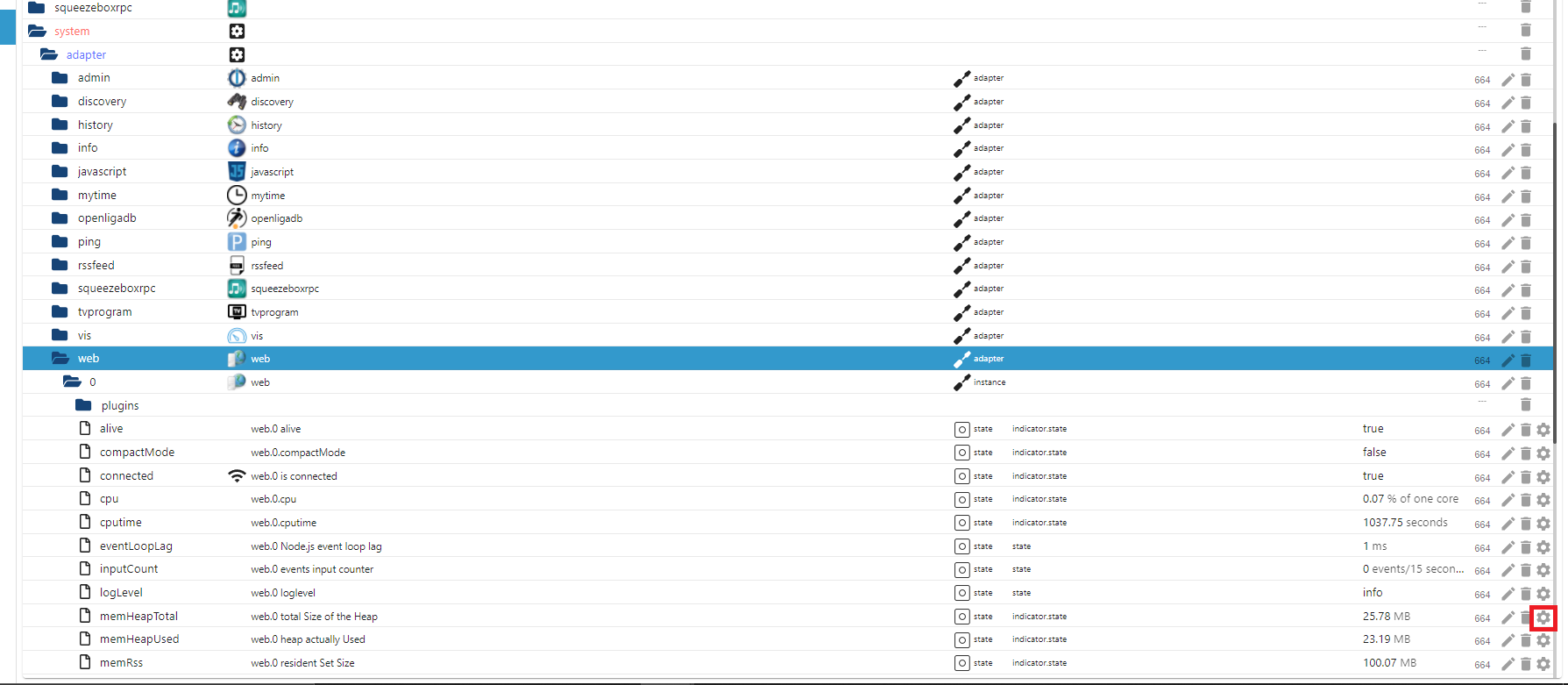

dann gehe bitte im objekte-tab im iobroker in den expertenmodus (kopf-knopf am oberen ende des bildschirms)

dann erscheint in der objektauflistung noch der system knoten.

den klappst du bitte auf bis die datenpunkte zum adapter web.0 sichtbar sind

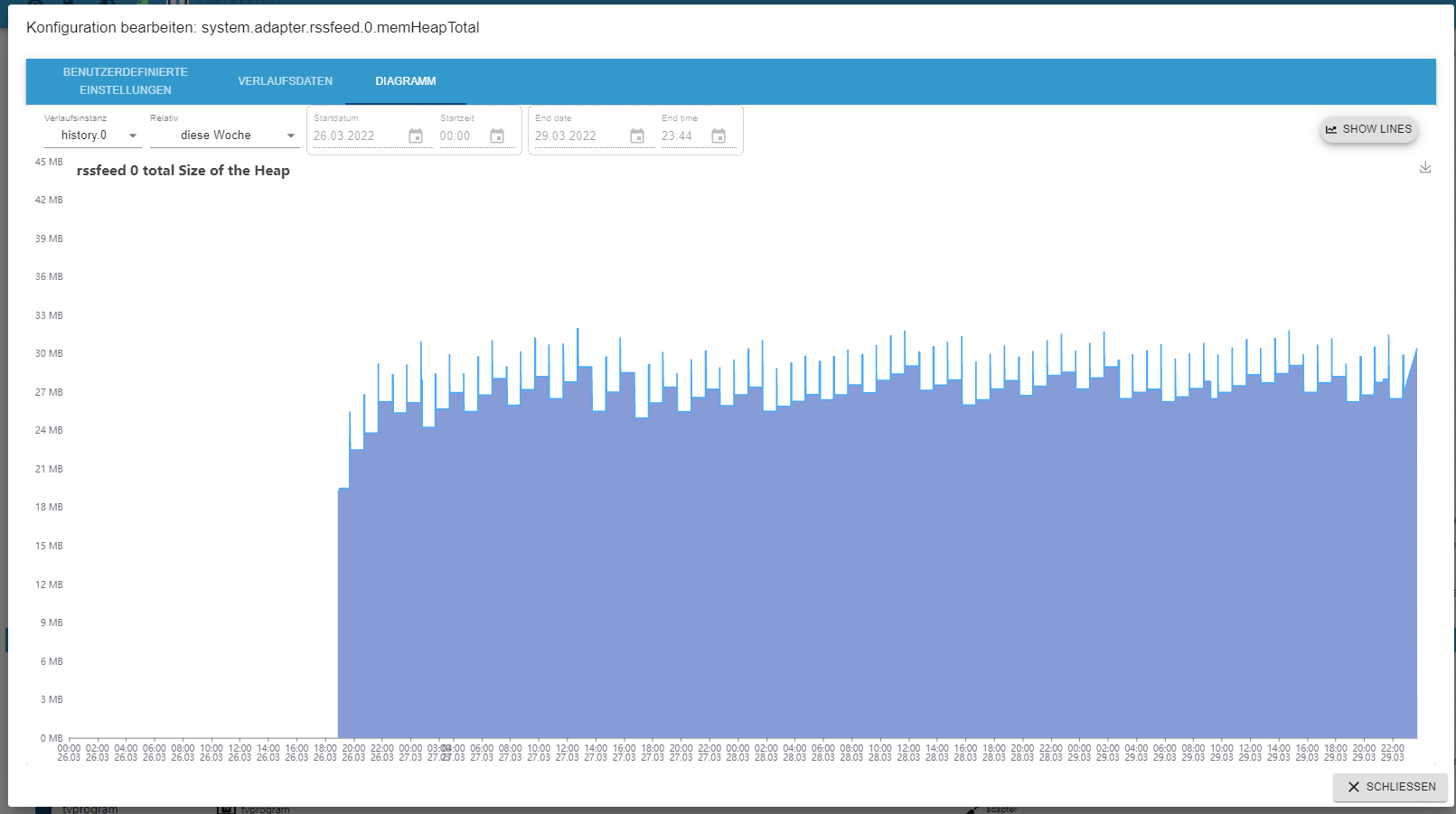

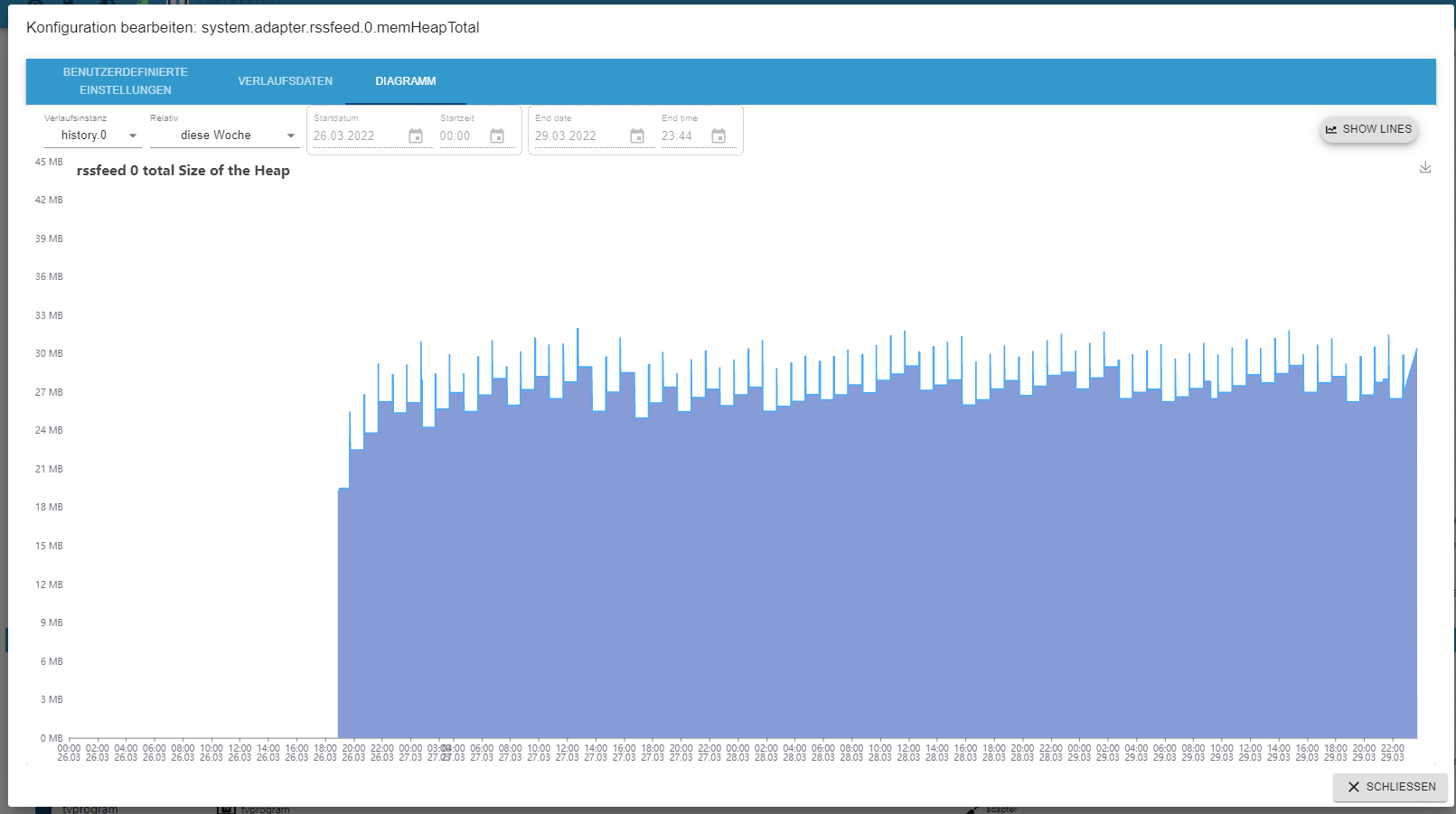

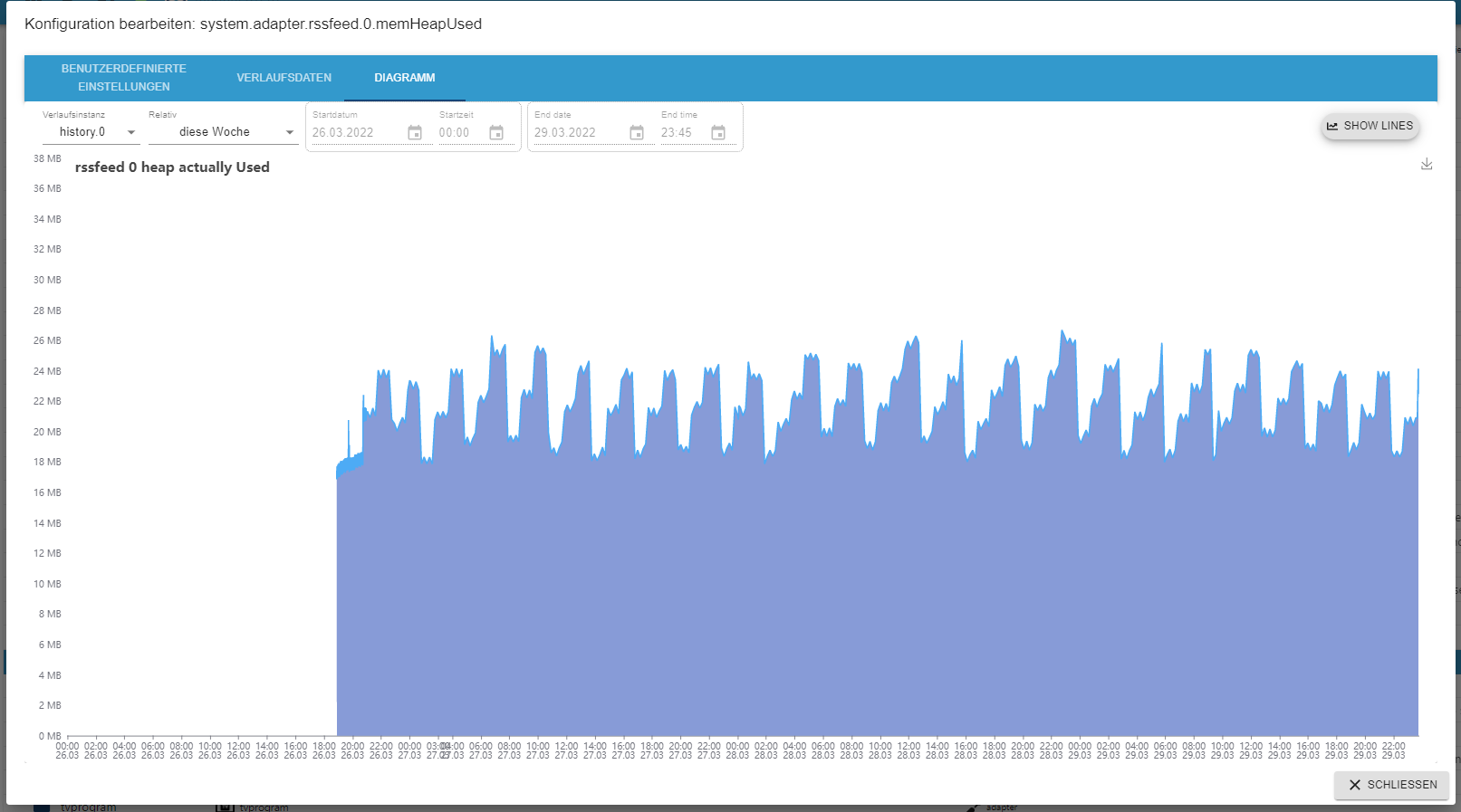

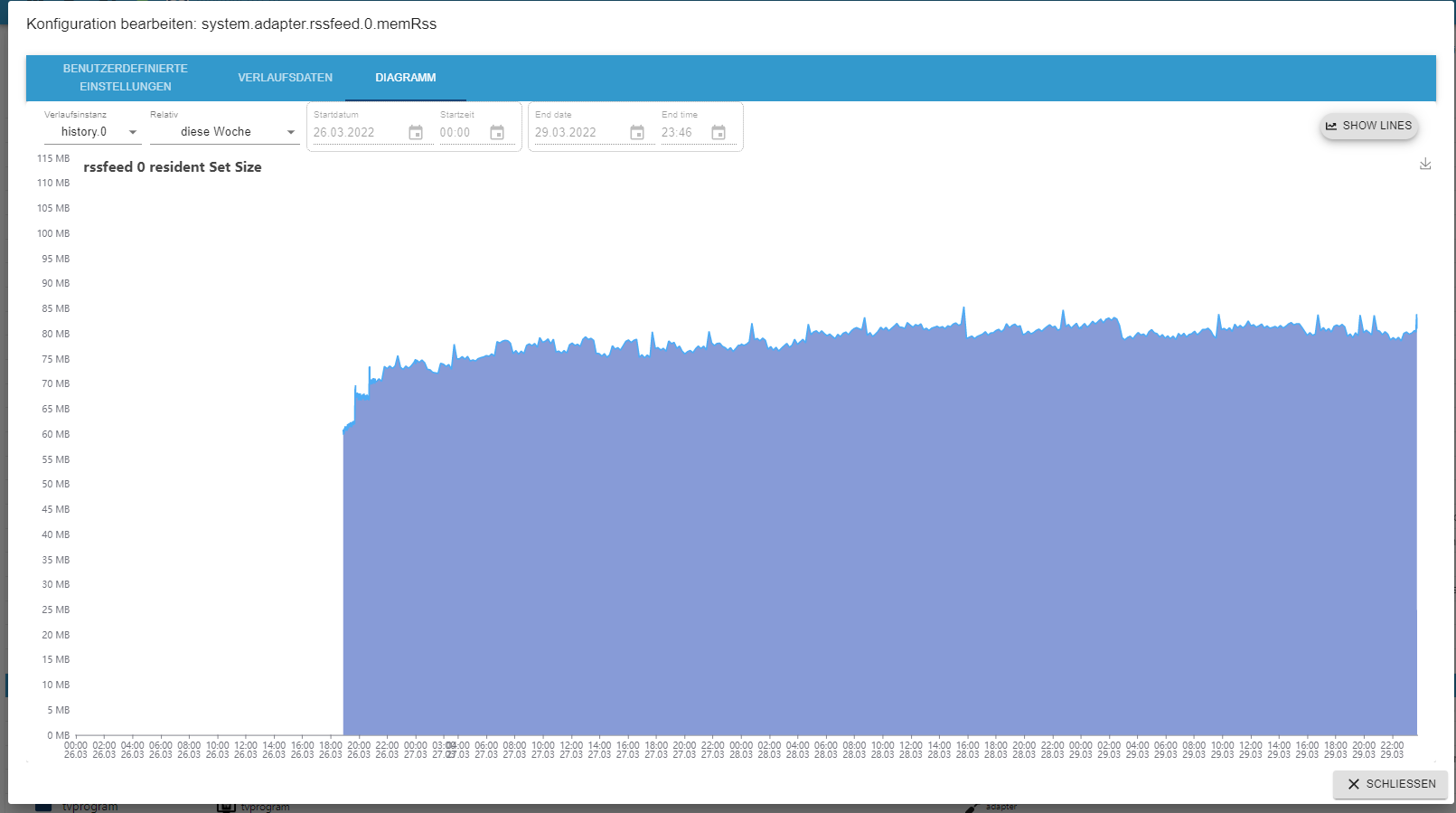

und drückst das zahlnrad für die 3 folgenden datenpunktesystem.adapter.web.0.memHeapTotal

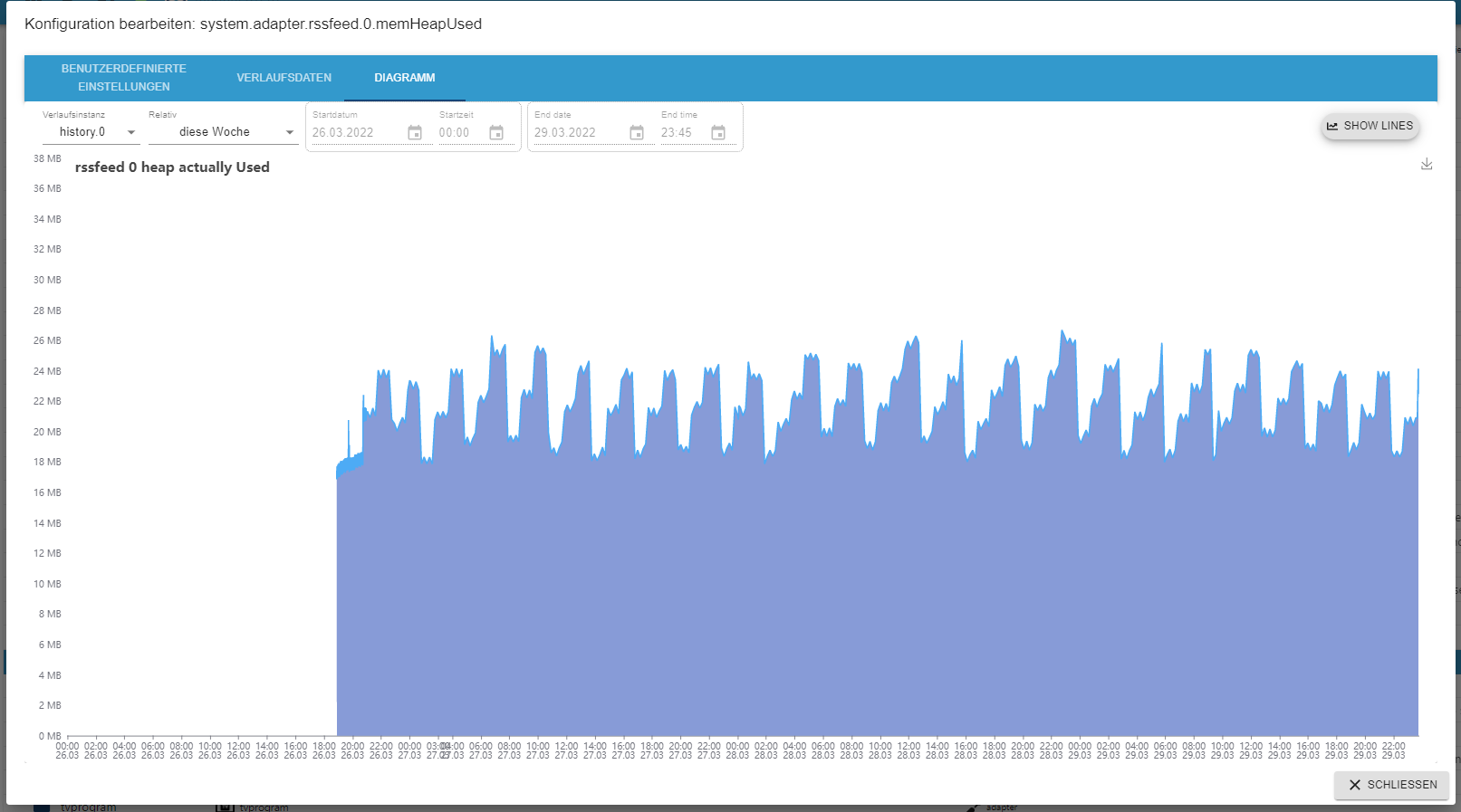

system.adapter.web.0.memHeapUsed

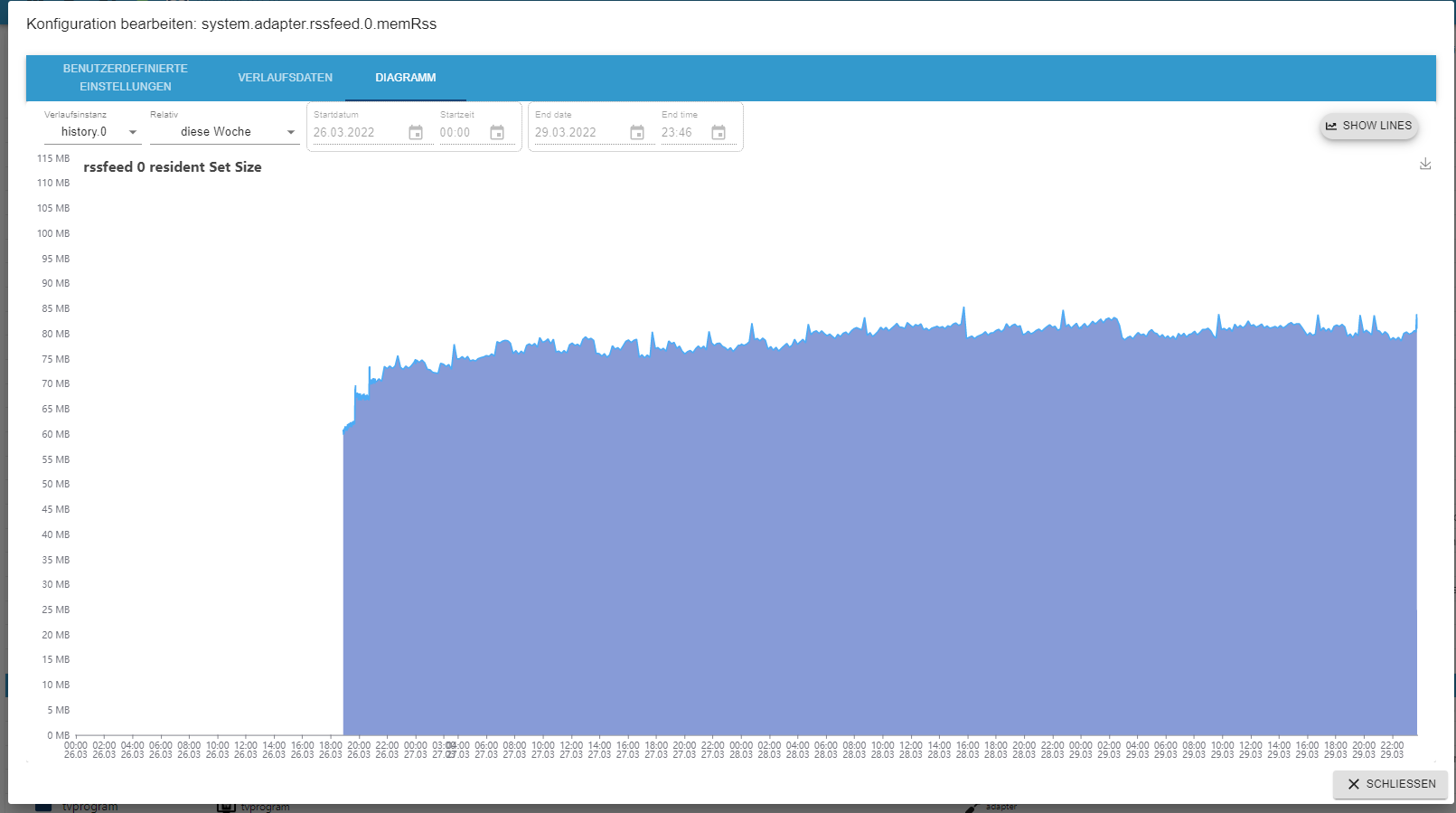

system.adapter.web.0.memRssim folgebildschirm aktivierst du bitte bei history.0 und speicherst danach ab. die zahnräder der 3 punkte leuchten dann blau

die ergebnisse kannst du dann als diagramm abrufen, wenn du wieder auf das zahnrad drückst.

hier mal meine ergebnisse des rssfeed adapters. da steigt über die zeit nix an und bleibt mehr oder weniger auf dem gleichen level. zeitraum ist fast eine woche,

ich vermute mal, das irgendwo bei dir noch der wurm drin ist.

durch stoppen des rssfeed-adapters hat dein system wieder genügend speicher und das problem verschiebt sich weiter in der zeit nach hinten.

da rssfeed die ganzen feeds im hauptspeicher behält frisst er natürlich je nach anzahl der feeds und umfang der artikel nicht wenig speicher. (bei mir mit 3 feeds 80MB) - admin gui nicht mehr bedienbar.

-

hm, was mach ich mit dir.

also der reihe nach- admin gui nicht mehr bedienbar.

wie gesagt, ich habe das nachvollzogen und bei mir funktioniert es.

leider habe ich aktuell nur in den randzeiten etwas zeit, zu denen du wahrscheinlich kein anydesk mehr machen kannst.

aber nochmal vorab. kannst du beim aufruf der admin gui bitte mal die browserkonsole (F12 chrome,edge und firefox) aufrufen und da schauen, ob da irgendwas nach Fehler im rssfeed aussieht? da werden die fehler, neben warnungen und debughinweisen auch explizit ausgewiesen. - absturz.

also nach log passiert das auf der serverseite. also iobroker. was mich etwas wundert, aber ich kann das log auch nicht so exakt lesen, es ist der web-adapter abgestürzt und nicht rssfeed.

erkennbar in den zeilen steht [io.web.0]

dieser adapter hat zu wenig speicher und hat sich dann beendet. das heißt den müsste man in die untersuchung mit einbeziehen.

mit dieser information würde mich der steigenden speicherverbrauch maL des web-adapters interessieren. aber ein typischer kandidat ist eigentlich immer auch der javascript-adapter.

ich gehe davon aus, das du den history-adapter laufen lassen hast?

dann gehe bitte im objekte-tab im iobroker in den expertenmodus (kopf-knopf am oberen ende des bildschirms)

dann erscheint in der objektauflistung noch der system knoten.

den klappst du bitte auf bis die datenpunkte zum adapter web.0 sichtbar sind

und drückst das zahlnrad für die 3 folgenden datenpunktesystem.adapter.web.0.memHeapTotal

system.adapter.web.0.memHeapUsed

system.adapter.web.0.memRssim folgebildschirm aktivierst du bitte bei history.0 und speicherst danach ab. die zahnräder der 3 punkte leuchten dann blau

die ergebnisse kannst du dann als diagramm abrufen, wenn du wieder auf das zahnrad drückst.

hier mal meine ergebnisse des rssfeed adapters. da steigt über die zeit nix an und bleibt mehr oder weniger auf dem gleichen level. zeitraum ist fast eine woche,

ich vermute mal, das irgendwo bei dir noch der wurm drin ist.

durch stoppen des rssfeed-adapters hat dein system wieder genügend speicher und das problem verschiebt sich weiter in der zeit nach hinten.

da rssfeed die ganzen feeds im hauptspeicher behält frisst er natürlich je nach anzahl der feeds und umfang der artikel nicht wenig speicher. (bei mir mit 3 feeds 80MB) - admin gui nicht mehr bedienbar.

-

-

@skokarl

ja, geht nicht.

hatte ich im januar als issue festgehalten

https://github.com/oweitman/ioBroker.rssfeed/issues/29

hatte ja gesagt, das ich die admin oberfläche überarbeiten muss -

So, die Influx DB läuft jetzt auch wieder ...... das ganze System läuft wieder kugelrund ....

werde jetzt morgen den RSS wieder einschalten und ein bisschen loggen .....

-

@oliverio Ich habe gerade einen Atom-Feed der nicht mehr will. Lief seit x Monaten problemlos, sehe aber so auch nichts was ihn daran hindern würde ihn zu verarbeiten ;)

Mit dem öffentlichen Feed habe ich es aktuell noch nicht probiert, sollte aber identisch sein. Der User-spezifische geht nur mit einem kostenlosen Account (enthält dann aber nur konfigurierte Sendungen).

Feed-Auszug (wg. Copyright Texte gekürzt):

<?xml version="1.0" encoding="utf-8"?> <feed xmlns="https://www.w3.org/2005/Atom"> <title>TV Wunschliste</title> <subtitle>Mein TV-Planer Wunschliste</subtitle> <link href="https://meine.wunschliste.de/updates" /> <link rel="self" href="https://www.wunschliste.de/xml/atom.pl" /> <updated>2022-05-06T11:20:48+02:00</updated> <author> <name>TV Wunschliste</name> </author> <id>https://meine.wunschliste.de/</id> <logo>https://www.wunschliste.de/gfx/logo.png</logo> <entry> <title>LeveragXXX (3.9) - Fr XX.05., XX.25 Uhr / VOXup</title> <link href="https://www.wunschliste.de/serie/leverage" /> <id>https://www.wunschliste.de/tv/2582052</id> <summary>Der InstallXXX ...</summary> <content type="xhtml" xml:base="https://example.org/"> <div xmlns="https://www.w3.org/1999/xhtml"> <strong>Im NamXXX</strong> <br />Der InstallXXX ... <br />mit TimoXXX <br />Regie: DeXXX </div> </content> <updated>2022-05-06T18:25:00+02:00</updated> </entry> </feed>Eine Idee :) ?

-

@oliverio Ich habe gerade einen Atom-Feed der nicht mehr will. Lief seit x Monaten problemlos, sehe aber so auch nichts was ihn daran hindern würde ihn zu verarbeiten ;)

Mit dem öffentlichen Feed habe ich es aktuell noch nicht probiert, sollte aber identisch sein. Der User-spezifische geht nur mit einem kostenlosen Account (enthält dann aber nur konfigurierte Sendungen).

Feed-Auszug (wg. Copyright Texte gekürzt):

<?xml version="1.0" encoding="utf-8"?> <feed xmlns="https://www.w3.org/2005/Atom"> <title>TV Wunschliste</title> <subtitle>Mein TV-Planer Wunschliste</subtitle> <link href="https://meine.wunschliste.de/updates" /> <link rel="self" href="https://www.wunschliste.de/xml/atom.pl" /> <updated>2022-05-06T11:20:48+02:00</updated> <author> <name>TV Wunschliste</name> </author> <id>https://meine.wunschliste.de/</id> <logo>https://www.wunschliste.de/gfx/logo.png</logo> <entry> <title>LeveragXXX (3.9) - Fr XX.05., XX.25 Uhr / VOXup</title> <link href="https://www.wunschliste.de/serie/leverage" /> <id>https://www.wunschliste.de/tv/2582052</id> <summary>Der InstallXXX ...</summary> <content type="xhtml" xml:base="https://example.org/"> <div xmlns="https://www.w3.org/1999/xhtml"> <strong>Im NamXXX</strong> <br />Der InstallXXX ... <br />mit TimoXXX <br />Regie: DeXXX </div> </content> <updated>2022-05-06T18:25:00+02:00</updated> </entry> </feed>Eine Idee :) ?

ok, der public feed hat das selbe problem.

muss da mal reindebuggen. melde michhier das ergebnis des offiziellen validators.

evtl liegts an den 2 gleichen IDs.

https://validator.w3.org/feed/check.cgi?url=https%3A%2F%2Fapi.wunschliste.de%2Fatom.pl

Das könnte ich aber lösen.

Mal schauen. -

@oliverio Ich habe gerade einen Atom-Feed der nicht mehr will. Lief seit x Monaten problemlos, sehe aber so auch nichts was ihn daran hindern würde ihn zu verarbeiten ;)

Mit dem öffentlichen Feed habe ich es aktuell noch nicht probiert, sollte aber identisch sein. Der User-spezifische geht nur mit einem kostenlosen Account (enthält dann aber nur konfigurierte Sendungen).

Feed-Auszug (wg. Copyright Texte gekürzt):

<?xml version="1.0" encoding="utf-8"?> <feed xmlns="https://www.w3.org/2005/Atom"> <title>TV Wunschliste</title> <subtitle>Mein TV-Planer Wunschliste</subtitle> <link href="https://meine.wunschliste.de/updates" /> <link rel="self" href="https://www.wunschliste.de/xml/atom.pl" /> <updated>2022-05-06T11:20:48+02:00</updated> <author> <name>TV Wunschliste</name> </author> <id>https://meine.wunschliste.de/</id> <logo>https://www.wunschliste.de/gfx/logo.png</logo> <entry> <title>LeveragXXX (3.9) - Fr XX.05., XX.25 Uhr / VOXup</title> <link href="https://www.wunschliste.de/serie/leverage" /> <id>https://www.wunschliste.de/tv/2582052</id> <summary>Der InstallXXX ...</summary> <content type="xhtml" xml:base="https://example.org/"> <div xmlns="https://www.w3.org/1999/xhtml"> <strong>Im NamXXX</strong> <br />Der InstallXXX ... <br />mit TimoXXX <br />Regie: DeXXX </div> </content> <updated>2022-05-06T18:25:00+02:00</updated> </entry> </feed>Eine Idee :) ?

@sborg

kann dieses wochenende nicht debuggen, aber ich habe eine starke Vermutung.

Die haben den xml-Namesapce falsch angegeben

Anstatt

http://www.w3.org/2005/Atom wurde

https://www.w3.org/2005/Atom

angegeben.

Der feedparser validiert die Namespaces. Auch der w3-Tester sagt das es falsch ist.Ich müsste jetzt die zugrundeliegende Bibliothek feedparser forken und

die dort enthaltenen Namespace-Definitionen erweitern:

https://github.com/danmactough/node-feedparser/blob/0a734f88195e4c7048a53867a8ec7c52f150fff2/lib/namespaces.jsWerde das aber durch debuggen nochmal verifizieren.

Lösung wäre halt rumpfuscheln an den Standards, nur weil jemand denkt der namespace sei ein Link und Links sind neuerdings alle https -

@sborg

kann dieses wochenende nicht debuggen, aber ich habe eine starke Vermutung.

Die haben den xml-Namesapce falsch angegeben

Anstatt

http://www.w3.org/2005/Atom wurde

https://www.w3.org/2005/Atom

angegeben.

Der feedparser validiert die Namespaces. Auch der w3-Tester sagt das es falsch ist.Ich müsste jetzt die zugrundeliegende Bibliothek feedparser forken und

die dort enthaltenen Namespace-Definitionen erweitern:

https://github.com/danmactough/node-feedparser/blob/0a734f88195e4c7048a53867a8ec7c52f150fff2/lib/namespaces.jsWerde das aber durch debuggen nochmal verifizieren.

Lösung wäre halt rumpfuscheln an den Standards, nur weil jemand denkt der namespace sei ein Link und Links sind neuerdings alle https@oliverio Danke schon mal :)

Ich könnte sie auch einfach anschreiben es rückgängig bzw. korrekt zu machen.

Die andere Lösung, die ich zum testen aber mal ausführen werde, ich lade den Feed lokal auf meinen Web-Server und ändere ihn dementsprechend ab. Dann sehe ich ja ob es funktioniert.(Notfalls kleines bash mit curl und sed mittels cronjob und ich ändere die Feed-URL ;) )

-

@oliverio Danke schon mal :)

Ich könnte sie auch einfach anschreiben es rückgängig bzw. korrekt zu machen.

Die andere Lösung, die ich zum testen aber mal ausführen werde, ich lade den Feed lokal auf meinen Web-Server und ändere ihn dementsprechend ab. Dann sehe ich ja ob es funktioniert.(Notfalls kleines bash mit curl und sed mittels cronjob und ich ändere die Feed-URL ;) )

-

@sborg said in Test und Support Adapter rssfeed v1.x.x:

Ich könnte sie auch einfach anschreiben

hehe, hab ich schon gemacht.

aber viel Hoffnung mach ich mir da nicht.

jetzt erst mal debuggen@oliverio sagte in Test und Support Adapter rssfeed v1.x.x:

hehe, hab ich schon gemacht.

:grinning: :+1:

Die sind aber eigentlich recht zugänglich. Sie stellen bspw. ihre Daten kostenlos dem SerienRecorder (Plugin für E2-Sat-Receiver) zur Verfügung 8)

-

@sborg said in Test und Support Adapter rssfeed v1.x.x:

Ich könnte sie auch einfach anschreiben

hehe, hab ich schon gemacht.

aber viel Hoffnung mach ich mir da nicht.

jetzt erst mal debuggen@oliverio Bin auch eben erst dazugekommen. Es liegt am "https". Patche ich den Feed funktioniert es.

Von daher Danke und problem solved :+1:

Ich warte mal ab ob sie den Feed aufgrund deiner Meldung ändern. Da ich ihn nur einmal täglich abfrage, genügt mir auch ein cronjob der ihn per curl lokal auf meinen Web-Server downlädt, per sed patcht und ich dann den Feed über meinen internen Web-Server abonniere. Sind ja nur zwei Programmzeilen ;)

-

@oliverio Bin auch eben erst dazugekommen. Es liegt am "https". Patche ich den Feed funktioniert es.

Von daher Danke und problem solved :+1:

Ich warte mal ab ob sie den Feed aufgrund deiner Meldung ändern. Da ich ihn nur einmal täglich abfrage, genügt mir auch ein cronjob der ihn per curl lokal auf meinen Web-Server downlädt, per sed patcht und ich dann den Feed über meinen internen Web-Server abonniere. Sind ja nur zwei Programmzeilen ;)

-

@oliverio Nein, läuft seit 26 ( :) ) Monaten ohne zu murren (sorry alter Haudegen @skokarl).

...und falls jemand zufällig per Suche hier landet und eine temporäre Lösung für den Atom-Feed von "Wunschliste" braucht:

#!/bin/bash #Feed in den Web-Serverspace laden sudo -s -u www-data curl -o ./tmp/feed.atom "https://api.wunschliste.de/atom.pl?user_id=1234567&key=123456789012" #Feed patchen sed -i 's/feed xmlns=\"https/feed xmlns=\"http/g' ./tmp/feed.atomDann den Feed vom eigenen Web-Server abonnieren. That's all 8)

-

So nach längerer Zeit mal eine

neue Version 2.0.0- Neuer Admin Konfigurationsdialog mittels jsonConfig

- Dadurch sind die Probleme in verschiedenen Browsern behoben

- Auch die falsche Farbdarstellung, wenn iobroker auf dunkles Design umgestellt wurde ist damit behoben

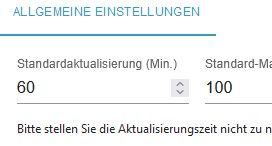

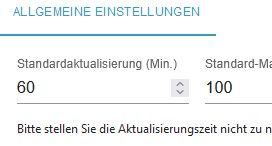

- Das untere Request/Refresh-Limit wurde auf 5 Minuten abgesenkt

- Die Einstellung maxarticles gibt es nun für jeden einzelnen feed separat

- wenn das widget rssfeed widget 2 platziert wird, erscheint nun keine hässliche Fehlermeldung mehr

- die Übersetzung wurde erneuert auf basis des iobroker übersetzers

- Bereiche des READMEs die nicht übersetzt werden sollten wurden nun als solche markiert

- Konfigurationsdaten müssten 1:1 übernommen werden, es muss nix migriert werden.

Ich freu mich über Tester und Fehlerberichte hier im Thread

-

So nach längerer Zeit mal eine

neue Version 2.0.0- Neuer Admin Konfigurationsdialog mittels jsonConfig

- Dadurch sind die Probleme in verschiedenen Browsern behoben

- Auch die falsche Farbdarstellung, wenn iobroker auf dunkles Design umgestellt wurde ist damit behoben

- Das untere Request/Refresh-Limit wurde auf 5 Minuten abgesenkt

- Die Einstellung maxarticles gibt es nun für jeden einzelnen feed separat

- wenn das widget rssfeed widget 2 platziert wird, erscheint nun keine hässliche Fehlermeldung mehr

- die Übersetzung wurde erneuert auf basis des iobroker übersetzers

- Bereiche des READMEs die nicht übersetzt werden sollten wurden nun als solche markiert

- Konfigurationsdaten müssten 1:1 übernommen werden, es muss nix migriert werden.

Ich freu mich über Tester und Fehlerberichte hier im Thread

Danke, hatte schon nicht mehr damit gerechnet. :+1:

Update fehlerfrei durchgelaufen. ( wesentlich besseres Design )

Mein Speicherproblem hatte ich zunächst damit behoben, dass ich einen von 4 Feeds gelöscht hatte, der kommt jetzt

natürlich wieder rein.kurze Frage, meinst Du wirklich Minuten ? Wäre 15 Minuten zu knapp ?

-

So nach längerer Zeit mal eine

neue Version 2.0.0- Neuer Admin Konfigurationsdialog mittels jsonConfig

- Dadurch sind die Probleme in verschiedenen Browsern behoben

- Auch die falsche Farbdarstellung, wenn iobroker auf dunkles Design umgestellt wurde ist damit behoben

- Das untere Request/Refresh-Limit wurde auf 5 Minuten abgesenkt

- Die Einstellung maxarticles gibt es nun für jeden einzelnen feed separat

- wenn das widget rssfeed widget 2 platziert wird, erscheint nun keine hässliche Fehlermeldung mehr

- die Übersetzung wurde erneuert auf basis des iobroker übersetzers

- Bereiche des READMEs die nicht übersetzt werden sollten wurden nun als solche markiert

- Konfigurationsdaten müssten 1:1 übernommen werden, es muss nix migriert werden.

Ich freu mich über Tester und Fehlerberichte hier im Thread

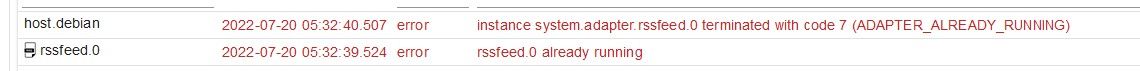

sieht nicht gut aus, hab den Adapter gestoppt

nach Absturz von IO und Neustart der VM

Wir können gerne mal zusammen drüber gucken, nur kann ich nicht zeitaufwändige Tests am Live System machen....

meine Frau nutzt das Tablet ..... aber der Fehler kam relativ schnell nach dem Start vom RSS Feed -

Danke, hatte schon nicht mehr damit gerechnet. :+1:

Update fehlerfrei durchgelaufen. ( wesentlich besseres Design )

Mein Speicherproblem hatte ich zunächst damit behoben, dass ich einen von 4 Feeds gelöscht hatte, der kommt jetzt

natürlich wieder rein.kurze Frage, meinst Du wirklich Minuten ? Wäre 15 Minuten zu knapp ?

@skokarl sagte in Test und Support Adapter rssfeed v1.x.x:

kurze Frage, meinst Du wirklich Minuten ? Wäre 15 Minuten zu knapp ?

ja Minuten, das niedrigste ist jetzt 5 Minuten

wie in der Warnung geschrieben kann man das nicht generell sagen.

Große Anbieter merken da nicht viel davon und setzten auch Caches ein.

Kleinere Anbieter merken da halt schon was davon, wenn regelmäßig viele Leute viele Daten abrufen.