NEWS

[gelöst]Systemload im Proxmox Host auf die schliche kommen

-

@dp20eic ein Problem war, das telegraf nicht mehr lief auf dem Host, hab ich jetzt gelöscht

einen weiteren Fehler verfolge ich, und zwar,habe auf dem Host den node_exporter laufen, ursprünglich in einer älteren Version(node_exporter-1.0.1.linux-amd64.tar.gz), dann angehoben auf die 1.4.0

nun zeitgleich zum upgrade von proxmox dann auch eine neuere version(1.6.0) installiert, so wie auch bei meinen anderen beiden Nodes(Proxmox Cluster)

allerdings sehe ich, das da auch noch eine version 1.4.0 läuft und bekomm die nicht mehr wegnun habe ich folgendes gemacht

systemctl stop node_exporter systemctl disable node_exporter systemctl daemon-reloaddas Startscript entfernt, danach den Host neu gestartet und sehe trotzdem noch/wieder die 1.4.0

root@zotac327:~# ls -lh /opt/node_exporter total 9.9M drwxr-xr-x 2 1001 1002 4.0K May 27 14:08 node_exporter-1.6.0.linux-amd64 -rw-r--r-- 1 root root 9.9M May 27 14:09 node_exporter-1.6.0.linux-amd64.tar.gzes gibt aber auch weiter keine Einträge in

/etc/systemd/system/multi-user.target.wants und /etc/systemd/system/default.target.wants, die auf v1.4.0 hinweisendie Frage, wo kann ich da noch suchen?

@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

habe auf dem Host den node_exporter laufen,

Moin,

da musst Du leider noch etwas ausholen, wir reden von

Prometheus?

Das hast Du wie wohin installiert, Du besitzt ein Proxmox Cluster?Kannst/willst Du das einmal komplett deinstallieren/löschen?

Wieso installierst Du das händisch, und nicht über ein Debian Repositoryroot@pve:~# apt list prometheus-node-exporter Listing... Done prometheus-node-exporter/stable 1.5.0-1+b6 amd64 root@pve:~#root@pve:~# apt install prometheus-node-exporter Reading package lists... Done Building dependency tree... Done Reading state information... Done The following additional packages will be installed: freeipmi-common ipmitool jq libfreeipmi17 libio-pty-perl libipc-run-perl libjq1 libonig5 libopenipmi0 libsnmp-base libsnmp40 libtime-duration-perl moreutils openipmi prometheus-node-exporter-collectors Suggested packages: freeipmi-tools snmp-mibs-downloader The following NEW packages will be installed: freeipmi-common ipmitool jq libfreeipmi17 libio-pty-perl libipc-run-perl libjq1 libonig5 libopenipmi0 libsnmp-base libsnmp40 libtime-duration-perl moreutils openipmi prometheus-node-exporter prometheus-node-exporter-collectors 0 upgraded, 16 newly installed, 0 to remove and 0 not upgraded. Need to get 11.7 MB of archives. After this operation, 34.0 MB of additional disk space will be used. Do you want to continue? [Y/n] Get:1 http://ftp.debian.org/debian bookworm/main amd64 freeipmi-common all 1.6.10-1 [354 kB] Get:2 http://ftp.debian.org/debian bookworm/main amd64 libfreeipmi17 amd64 1.6.10-1+b1 [1,036 kB] Get:3 http://ftp.debian.org/debian bookworm/main amd64 ipmitool amd64 1.8.19-4 [439 kB] Get:4 http://ftp.debian.org/debian bookworm/main amd64 prometheus-node-exporter amd64 1.5.0-1+b6 [4,079 kB] Get:5 http://ftp.debian.org/debian bookworm/main amd64 libonig5 amd64 6.9.8-1 [188 kB] Get:6 http://ftp.debian.org/debian bookworm/main amd64 libjq1 amd64 1.6-2.1 [135 kB] Get:7 http://ftp.debian.org/debian bookworm/main amd64 jq amd64 1.6-2.1 [64.9 kB] Get:8 http://ftp.debian.org/debian bookworm/main amd64 libio-pty-perl amd64 1:1.17-1 [34.9 kB] Get:9 http://ftp.debian.org/debian bookworm/main amd64 libipc-run-perl all 20220807.0-1 [104 kB] Get:10 http://ftp.debian.org/debian bookworm/main amd64 libopenipmi0 amd64 2.0.33-1+b1 [551 kB] Get:11 http://ftp.debian.org/debian bookworm/main amd64 libsnmp-base all 5.9.3+dfsg-2 [1,753 kB] Get:12 http://ftp.debian.org/debian bookworm/main amd64 libsnmp40 amd64 5.9.3+dfsg-2 [2,556 kB] Get:13 http://ftp.debian.org/debian bookworm/main amd64 libtime-duration-perl all 1.21-2 [13.1 kB] Get:14 http://ftp.debian.org/debian bookworm/main amd64 moreutils amd64 0.67-1 [76.1 kB] Get:15 http://ftp.debian.org/debian bookworm/main amd64 openipmi amd64 2.0.33-1+b1 [248 kB] Get:16 http://ftp.debian.org/debian bookworm/main amd64 prometheus-node-exporter-collectors all 0.0~git20230203.6f710f8-1 [28.5 kB] Fetched 11.7 MB in 1s (10.1 MB/s) Selecting previously unselected package freeipmi-common. (Reading database ... 59517 files and directories currently installed.) Preparing to unpack .../00-freeipmi-common_1.6.10-1_all.deb ... Unpacking freeipmi-common (1.6.10-1) ... Selecting previously unselected package libfreeipmi17. Preparing to unpack .../01-libfreeipmi17_1.6.10-1+b1_amd64.deb ... Unpacking libfreeipmi17 (1.6.10-1+b1) ... Selecting previously unselected package ipmitool. Preparing to unpack .../02-ipmitool_1.8.19-4_amd64.deb ... Unpacking ipmitool (1.8.19-4) ... Selecting previously unselected package prometheus-node-exporter. Preparing to unpack .../03-prometheus-node-exporter_1.5.0-1+b6_amd64.deb ... Unpacking prometheus-node-exporter (1.5.0-1+b6) ... Selecting previously unselected package libonig5:amd64. Preparing to unpack .../04-libonig5_6.9.8-1_amd64.deb ... Unpacking libonig5:amd64 (6.9.8-1) ... Selecting previously unselected package libjq1:amd64. Preparing to unpack .../05-libjq1_1.6-2.1_amd64.deb ... Unpacking libjq1:amd64 (1.6-2.1) ... Selecting previously unselected package jq. Preparing to unpack .../06-jq_1.6-2.1_amd64.deb ... Unpacking jq (1.6-2.1) ... Selecting previously unselected package libio-pty-perl. Preparing to unpack .../07-libio-pty-perl_1%3a1.17-1_amd64.deb ... Unpacking libio-pty-perl (1:1.17-1) ... Selecting previously unselected package libipc-run-perl. Preparing to unpack .../08-libipc-run-perl_20220807.0-1_all.deb ... Unpacking libipc-run-perl (20220807.0-1) ... Selecting previously unselected package libopenipmi0. Preparing to unpack .../09-libopenipmi0_2.0.33-1+b1_amd64.deb ... Unpacking libopenipmi0 (2.0.33-1+b1) ... Selecting previously unselected package libsnmp-base. Preparing to unpack .../10-libsnmp-base_5.9.3+dfsg-2_all.deb ... Unpacking libsnmp-base (5.9.3+dfsg-2) ... Selecting previously unselected package libsnmp40:amd64. Preparing to unpack .../11-libsnmp40_5.9.3+dfsg-2_amd64.deb ... Unpacking libsnmp40:amd64 (5.9.3+dfsg-2) ... Selecting previously unselected package libtime-duration-perl. Preparing to unpack .../12-libtime-duration-perl_1.21-2_all.deb ... Unpacking libtime-duration-perl (1.21-2) ... Selecting previously unselected package moreutils. Preparing to unpack .../13-moreutils_0.67-1_amd64.deb ... Unpacking moreutils (0.67-1) ... Selecting previously unselected package openipmi. Preparing to unpack .../14-openipmi_2.0.33-1+b1_amd64.deb ... Unpacking openipmi (2.0.33-1+b1) ... Selecting previously unselected package prometheus-node-exporter-collectors. Preparing to unpack .../15-prometheus-node-exporter-collectors_0.0~git20230203.6f710f8-1_all.deb ... Unpacking prometheus-node-exporter-collectors (0.0~git20230203.6f710f8-1) ... Setting up libio-pty-perl (1:1.17-1) ... Setting up freeipmi-common (1.6.10-1) ... Setting up libsnmp-base (5.9.3+dfsg-2) ... Setting up prometheus-node-exporter (1.5.0-1+b6) ... Created symlink /etc/systemd/system/multi-user.target.wants/prometheus-node-exporter.service → /lib/systemd/system/prometheus-node-exporter.service. Setting up libsnmp40:amd64 (5.9.3+dfsg-2) ... Setting up libipc-run-perl (20220807.0-1) ... Setting up libtime-duration-perl (1.21-2) ... Setting up libfreeipmi17 (1.6.10-1+b1) ... Setting up libopenipmi0 (2.0.33-1+b1) ... Setting up libonig5:amd64 (6.9.8-1) ... Setting up ipmitool (1.8.19-4) ... ipmievd.service is a disabled or a static unit, not starting it. Setting up moreutils (0.67-1) ... Setting up libjq1:amd64 (1.6-2.1) ... Setting up jq (1.6-2.1) ... Setting up openipmi (2.0.33-1+b1) ... Setting up prometheus-node-exporter-collectors (0.0~git20230203.6f710f8-1) ... Created symlink /etc/systemd/system/timers.target.wants/prometheus-node-exporter-apt.timer → /lib/systemd/system/prometheus-node-exporter-apt.timer. Created symlink /etc/systemd/system/timers.target.wants/prometheus-node-exporter-ipmitool-sensor.timer → /lib/systemd/system/prometheus-node-exporter-ipmitool-sensor.timer. Created symlink /etc/systemd/system/timers.target.wants/prometheus-node-exporter-mellanox-hca-temp.timer → /lib/systemd/system/prometheus-node-exporter-mellanox-hca-temp.timer. Created symlink /etc/systemd/system/timers.target.wants/prometheus-node-exporter-nvme.timer → /lib/systemd/system/prometheus-node-exporter-nvme.timer. Created symlink /etc/systemd/system/timers.target.wants/prometheus-node-exporter-smartmon.timer → /lib/systemd/system/prometheus-node-exporter-smartmon.timer. Processing triggers for man-db (2.11.2-2) ... Processing triggers for libc-bin (2.36-9+deb12u1) ... root@pve:~#Was kam denn so an Log Output, als Du die 1.6.x installiert hast?

Was passiert, wenn Du das Binary direkt aufrufstroot@pve:~# /usr/bin/prometheus-node-exporter --version node_exporter, version 1.5.0 (branch: debian/sid, revision: 1.5.0-1+b6) build user: team+pkg-go@tracker.debian.org build date: 20230409-10:11:09 go version: go1.19.8 platform: linux/amd64 root@pve:~#Die Kiste ist auch einmal rebootet?

Hast Du mal auf der ganzen Kiste gesucht, find ist Standard, die anderen muss man wohl installieren.find / -name '*node_exp* locate node_exp mlocate slocateVG

Bernd -

@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

habe auf dem Host den node_exporter laufen,

Moin,

da musst Du leider noch etwas ausholen, wir reden von

Prometheus?

Das hast Du wie wohin installiert, Du besitzt ein Proxmox Cluster?Kannst/willst Du das einmal komplett deinstallieren/löschen?

Wieso installierst Du das händisch, und nicht über ein Debian Repositoryroot@pve:~# apt list prometheus-node-exporter Listing... Done prometheus-node-exporter/stable 1.5.0-1+b6 amd64 root@pve:~#root@pve:~# apt install prometheus-node-exporter Reading package lists... Done Building dependency tree... Done Reading state information... Done The following additional packages will be installed: freeipmi-common ipmitool jq libfreeipmi17 libio-pty-perl libipc-run-perl libjq1 libonig5 libopenipmi0 libsnmp-base libsnmp40 libtime-duration-perl moreutils openipmi prometheus-node-exporter-collectors Suggested packages: freeipmi-tools snmp-mibs-downloader The following NEW packages will be installed: freeipmi-common ipmitool jq libfreeipmi17 libio-pty-perl libipc-run-perl libjq1 libonig5 libopenipmi0 libsnmp-base libsnmp40 libtime-duration-perl moreutils openipmi prometheus-node-exporter prometheus-node-exporter-collectors 0 upgraded, 16 newly installed, 0 to remove and 0 not upgraded. Need to get 11.7 MB of archives. After this operation, 34.0 MB of additional disk space will be used. Do you want to continue? [Y/n] Get:1 http://ftp.debian.org/debian bookworm/main amd64 freeipmi-common all 1.6.10-1 [354 kB] Get:2 http://ftp.debian.org/debian bookworm/main amd64 libfreeipmi17 amd64 1.6.10-1+b1 [1,036 kB] Get:3 http://ftp.debian.org/debian bookworm/main amd64 ipmitool amd64 1.8.19-4 [439 kB] Get:4 http://ftp.debian.org/debian bookworm/main amd64 prometheus-node-exporter amd64 1.5.0-1+b6 [4,079 kB] Get:5 http://ftp.debian.org/debian bookworm/main amd64 libonig5 amd64 6.9.8-1 [188 kB] Get:6 http://ftp.debian.org/debian bookworm/main amd64 libjq1 amd64 1.6-2.1 [135 kB] Get:7 http://ftp.debian.org/debian bookworm/main amd64 jq amd64 1.6-2.1 [64.9 kB] Get:8 http://ftp.debian.org/debian bookworm/main amd64 libio-pty-perl amd64 1:1.17-1 [34.9 kB] Get:9 http://ftp.debian.org/debian bookworm/main amd64 libipc-run-perl all 20220807.0-1 [104 kB] Get:10 http://ftp.debian.org/debian bookworm/main amd64 libopenipmi0 amd64 2.0.33-1+b1 [551 kB] Get:11 http://ftp.debian.org/debian bookworm/main amd64 libsnmp-base all 5.9.3+dfsg-2 [1,753 kB] Get:12 http://ftp.debian.org/debian bookworm/main amd64 libsnmp40 amd64 5.9.3+dfsg-2 [2,556 kB] Get:13 http://ftp.debian.org/debian bookworm/main amd64 libtime-duration-perl all 1.21-2 [13.1 kB] Get:14 http://ftp.debian.org/debian bookworm/main amd64 moreutils amd64 0.67-1 [76.1 kB] Get:15 http://ftp.debian.org/debian bookworm/main amd64 openipmi amd64 2.0.33-1+b1 [248 kB] Get:16 http://ftp.debian.org/debian bookworm/main amd64 prometheus-node-exporter-collectors all 0.0~git20230203.6f710f8-1 [28.5 kB] Fetched 11.7 MB in 1s (10.1 MB/s) Selecting previously unselected package freeipmi-common. (Reading database ... 59517 files and directories currently installed.) Preparing to unpack .../00-freeipmi-common_1.6.10-1_all.deb ... Unpacking freeipmi-common (1.6.10-1) ... Selecting previously unselected package libfreeipmi17. Preparing to unpack .../01-libfreeipmi17_1.6.10-1+b1_amd64.deb ... Unpacking libfreeipmi17 (1.6.10-1+b1) ... Selecting previously unselected package ipmitool. Preparing to unpack .../02-ipmitool_1.8.19-4_amd64.deb ... Unpacking ipmitool (1.8.19-4) ... Selecting previously unselected package prometheus-node-exporter. Preparing to unpack .../03-prometheus-node-exporter_1.5.0-1+b6_amd64.deb ... Unpacking prometheus-node-exporter (1.5.0-1+b6) ... Selecting previously unselected package libonig5:amd64. Preparing to unpack .../04-libonig5_6.9.8-1_amd64.deb ... Unpacking libonig5:amd64 (6.9.8-1) ... Selecting previously unselected package libjq1:amd64. Preparing to unpack .../05-libjq1_1.6-2.1_amd64.deb ... Unpacking libjq1:amd64 (1.6-2.1) ... Selecting previously unselected package jq. Preparing to unpack .../06-jq_1.6-2.1_amd64.deb ... Unpacking jq (1.6-2.1) ... Selecting previously unselected package libio-pty-perl. Preparing to unpack .../07-libio-pty-perl_1%3a1.17-1_amd64.deb ... Unpacking libio-pty-perl (1:1.17-1) ... Selecting previously unselected package libipc-run-perl. Preparing to unpack .../08-libipc-run-perl_20220807.0-1_all.deb ... Unpacking libipc-run-perl (20220807.0-1) ... Selecting previously unselected package libopenipmi0. Preparing to unpack .../09-libopenipmi0_2.0.33-1+b1_amd64.deb ... Unpacking libopenipmi0 (2.0.33-1+b1) ... Selecting previously unselected package libsnmp-base. Preparing to unpack .../10-libsnmp-base_5.9.3+dfsg-2_all.deb ... Unpacking libsnmp-base (5.9.3+dfsg-2) ... Selecting previously unselected package libsnmp40:amd64. Preparing to unpack .../11-libsnmp40_5.9.3+dfsg-2_amd64.deb ... Unpacking libsnmp40:amd64 (5.9.3+dfsg-2) ... Selecting previously unselected package libtime-duration-perl. Preparing to unpack .../12-libtime-duration-perl_1.21-2_all.deb ... Unpacking libtime-duration-perl (1.21-2) ... Selecting previously unselected package moreutils. Preparing to unpack .../13-moreutils_0.67-1_amd64.deb ... Unpacking moreutils (0.67-1) ... Selecting previously unselected package openipmi. Preparing to unpack .../14-openipmi_2.0.33-1+b1_amd64.deb ... Unpacking openipmi (2.0.33-1+b1) ... Selecting previously unselected package prometheus-node-exporter-collectors. Preparing to unpack .../15-prometheus-node-exporter-collectors_0.0~git20230203.6f710f8-1_all.deb ... Unpacking prometheus-node-exporter-collectors (0.0~git20230203.6f710f8-1) ... Setting up libio-pty-perl (1:1.17-1) ... Setting up freeipmi-common (1.6.10-1) ... Setting up libsnmp-base (5.9.3+dfsg-2) ... Setting up prometheus-node-exporter (1.5.0-1+b6) ... Created symlink /etc/systemd/system/multi-user.target.wants/prometheus-node-exporter.service → /lib/systemd/system/prometheus-node-exporter.service. Setting up libsnmp40:amd64 (5.9.3+dfsg-2) ... Setting up libipc-run-perl (20220807.0-1) ... Setting up libtime-duration-perl (1.21-2) ... Setting up libfreeipmi17 (1.6.10-1+b1) ... Setting up libopenipmi0 (2.0.33-1+b1) ... Setting up libonig5:amd64 (6.9.8-1) ... Setting up ipmitool (1.8.19-4) ... ipmievd.service is a disabled or a static unit, not starting it. Setting up moreutils (0.67-1) ... Setting up libjq1:amd64 (1.6-2.1) ... Setting up jq (1.6-2.1) ... Setting up openipmi (2.0.33-1+b1) ... Setting up prometheus-node-exporter-collectors (0.0~git20230203.6f710f8-1) ... Created symlink /etc/systemd/system/timers.target.wants/prometheus-node-exporter-apt.timer → /lib/systemd/system/prometheus-node-exporter-apt.timer. Created symlink /etc/systemd/system/timers.target.wants/prometheus-node-exporter-ipmitool-sensor.timer → /lib/systemd/system/prometheus-node-exporter-ipmitool-sensor.timer. Created symlink /etc/systemd/system/timers.target.wants/prometheus-node-exporter-mellanox-hca-temp.timer → /lib/systemd/system/prometheus-node-exporter-mellanox-hca-temp.timer. Created symlink /etc/systemd/system/timers.target.wants/prometheus-node-exporter-nvme.timer → /lib/systemd/system/prometheus-node-exporter-nvme.timer. Created symlink /etc/systemd/system/timers.target.wants/prometheus-node-exporter-smartmon.timer → /lib/systemd/system/prometheus-node-exporter-smartmon.timer. Processing triggers for man-db (2.11.2-2) ... Processing triggers for libc-bin (2.36-9+deb12u1) ... root@pve:~#Was kam denn so an Log Output, als Du die 1.6.x installiert hast?

Was passiert, wenn Du das Binary direkt aufrufstroot@pve:~# /usr/bin/prometheus-node-exporter --version node_exporter, version 1.5.0 (branch: debian/sid, revision: 1.5.0-1+b6) build user: team+pkg-go@tracker.debian.org build date: 20230409-10:11:09 go version: go1.19.8 platform: linux/amd64 root@pve:~#Die Kiste ist auch einmal rebootet?

Hast Du mal auf der ganzen Kiste gesucht, find ist Standard, die anderen muss man wohl installieren.find / -name '*node_exp* locate node_exp mlocate slocateVG

Bernd@dp20eic ja der prometheus-node-exporter

ja ein cluster, prometheus selbst läuft in einem LXC, den dazugehörigen node-exporter auf jedem Host installiert, überall gleich vorgegangenwie schon erwähnt, das Problem besteht nur auf dem einen

@dp20eic sagte in Systemload im Proxmox Host auf die schliche kommen:

Wieso installierst Du das händisch

weil ich die neuste version haben wollte

@dp20eic sagte in Systemload im Proxmox Host auf die schliche kommen:

Was kam denn so an Log Output, als Du die 1.6.x installiert hast

nix:joy: zumindest weiss ichs nimmer

@dp20eic sagte in Systemload im Proxmox Host auf die schliche kommen:

Was passiert, wenn Du das Binary direkt aufrufst

da kommt nix, da ja nix mehr aktiv

root@zotac327:~# /usr/bin/prometheus-node-exporter --version -bash: /usr/bin/prometheus-node-exporter: No such file or directory root@zotac327:~#@dp20eic sagte in Systemload im Proxmox Host auf die schliche kommen:

Die Kiste ist auch einmal rebootet?

ja, hab ich, aber es startet wieder die 1.4.0, siehe oben

@dp20eic sagte in Systemload im Proxmox Host auf die schliche kommen:

find ist Standard,

root@zotac327:~# find / -name '*node_exp* > -

@dp20eic ein Problem war, das telegraf nicht mehr lief auf dem Host, hab ich jetzt gelöscht

einen weiteren Fehler verfolge ich, und zwar,habe auf dem Host den node_exporter laufen, ursprünglich in einer älteren Version(node_exporter-1.0.1.linux-amd64.tar.gz), dann angehoben auf die 1.4.0

nun zeitgleich zum upgrade von proxmox dann auch eine neuere version(1.6.0) installiert, so wie auch bei meinen anderen beiden Nodes(Proxmox Cluster)

allerdings sehe ich, das da auch noch eine version 1.4.0 läuft und bekomm die nicht mehr wegnun habe ich folgendes gemacht

systemctl stop node_exporter systemctl disable node_exporter systemctl daemon-reloaddas Startscript entfernt, danach den Host neu gestartet und sehe trotzdem noch/wieder die 1.4.0

root@zotac327:~# ls -lh /opt/node_exporter total 9.9M drwxr-xr-x 2 1001 1002 4.0K May 27 14:08 node_exporter-1.6.0.linux-amd64 -rw-r--r-- 1 root root 9.9M May 27 14:09 node_exporter-1.6.0.linux-amd64.tar.gzes gibt aber auch weiter keine Einträge in

/etc/systemd/system/multi-user.target.wants und /etc/systemd/system/default.target.wants, die auf v1.4.0 hinweisendie Frage, wo kann ich da noch suchen?

@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

das Startscript entfernt, danach den Host neu gestartet und sehe trotzdem noch/wieder die 1.4.0

Moin,

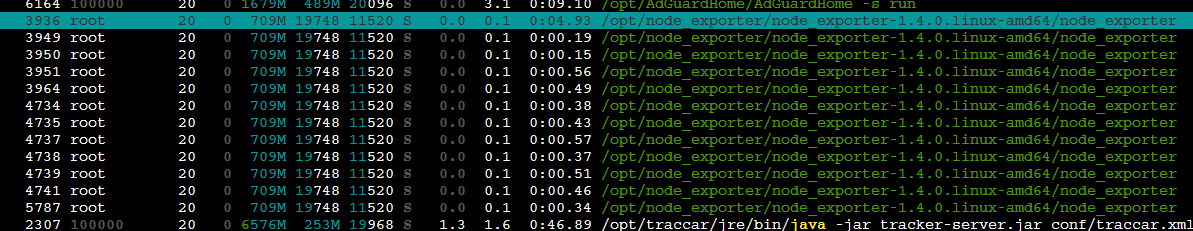

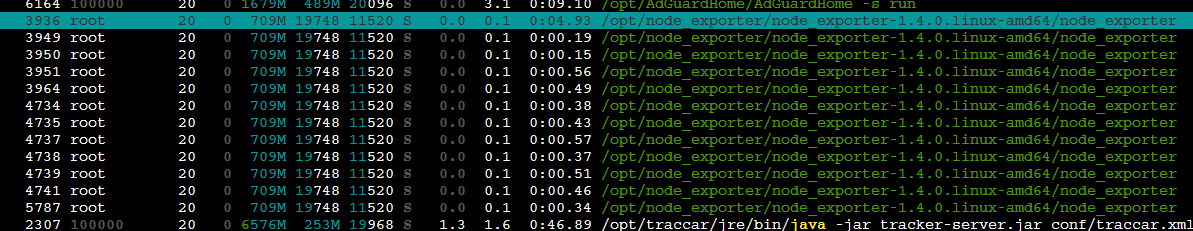

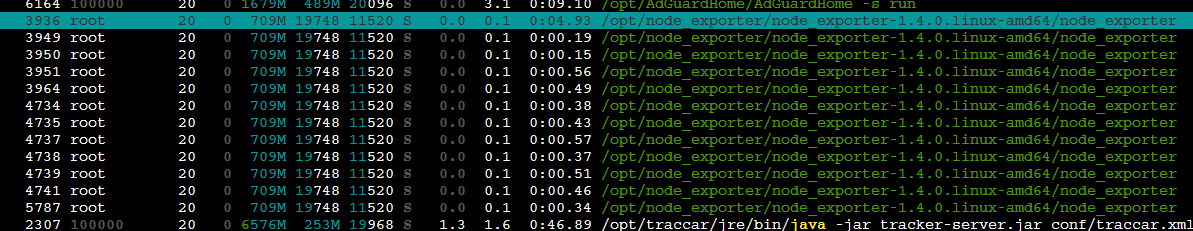

im Bild steht ja etwas von

/opt/node_export../@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

/usr/bin/prometheus-node-exporter --version

Welche services laufen denn noch?

root@pve:~# systemctl status | grep -i prome │ ├─prometheus-node-exporter.service │ │ └─435550 /usr/bin/prometheus-node-exporter │ └─599998 grep -i promeroot@pve:~# grep -siEl 'node-exporter|node_exporter' /lib/systemd/system/* /lib/systemd/system/prometheus-node-exporter-apt.service /lib/systemd/system/prometheus-node-exporter-ipmitool-sensor.service /lib/systemd/system/prometheus-node-exporter-mellanox-hca-temp.service /lib/systemd/system/prometheus-node-exporter-nvme.service /lib/systemd/system/prometheus-node-exporter.service /lib/systemd/system/prometheus-node-exporter-smartmon.serviceIch habe oben ein ' vergessen

find / -name '*node_exp*'VG

Bernd -

@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

das Startscript entfernt, danach den Host neu gestartet und sehe trotzdem noch/wieder die 1.4.0

Moin,

im Bild steht ja etwas von

/opt/node_export../@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

/usr/bin/prometheus-node-exporter --version

Welche services laufen denn noch?

root@pve:~# systemctl status | grep -i prome │ ├─prometheus-node-exporter.service │ │ └─435550 /usr/bin/prometheus-node-exporter │ └─599998 grep -i promeroot@pve:~# grep -siEl 'node-exporter|node_exporter' /lib/systemd/system/* /lib/systemd/system/prometheus-node-exporter-apt.service /lib/systemd/system/prometheus-node-exporter-ipmitool-sensor.service /lib/systemd/system/prometheus-node-exporter-mellanox-hca-temp.service /lib/systemd/system/prometheus-node-exporter-nvme.service /lib/systemd/system/prometheus-node-exporter.service /lib/systemd/system/prometheus-node-exporter-smartmon.serviceIch habe oben ein ' vergessen

find / -name '*node_exp*'VG

Bernd@dp20eic

root@zotac327:~# systemctl status | grep -i prome │ │ │ ├─3920 "avahi-daemon: running [Prometheus.local]" │ │ ├─prometheus.service │ │ │ └─3985 /usr/local/bin/prometheus --config.file=/etc/prometheus/prometheus.yml --storage.tsdb.path=/var/lib/prometheus --web.console.templates=/etc/prometheus/consoles --web.console.libraries=/etc/prometheus/console_libraries --web.listen-address=0.0.0.0:9090 --web.external-url= │ └─66189 grep -i promeroot@zotac327:~# systemctl status | grep -i expo │ │ ├─node_exporter.service │ │ │ └─3936 /opt/node_exporter/node_exporter-1.4.0.linux-amd64/node_exporter │ └─68493 grep -i expowenn ich den status abrufe, kommt

root@zotac327:~# systemctl status node_exporter Unit node_exporter.service could not be found.root@zotac327:~# grep -siEl 'node-exporter|node_exporter' /lib/systemd/system/* root@zotac327:~#da tut sich nix

root@zotac327:~# find / -name '*node_exp*' -

@dp20eic

root@zotac327:~# systemctl status | grep -i prome │ │ │ ├─3920 "avahi-daemon: running [Prometheus.local]" │ │ ├─prometheus.service │ │ │ └─3985 /usr/local/bin/prometheus --config.file=/etc/prometheus/prometheus.yml --storage.tsdb.path=/var/lib/prometheus --web.console.templates=/etc/prometheus/consoles --web.console.libraries=/etc/prometheus/console_libraries --web.listen-address=0.0.0.0:9090 --web.external-url= │ └─66189 grep -i promeroot@zotac327:~# systemctl status | grep -i expo │ │ ├─node_exporter.service │ │ │ └─3936 /opt/node_exporter/node_exporter-1.4.0.linux-amd64/node_exporter │ └─68493 grep -i expowenn ich den status abrufe, kommt

root@zotac327:~# systemctl status node_exporter Unit node_exporter.service could not be found.root@zotac327:~# grep -siEl 'node-exporter|node_exporter' /lib/systemd/system/* root@zotac327:~#da tut sich nix

root@zotac327:~# find / -name '*node_exp*'Moin,

@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

find /etc/systemd/ -name '*node-export*'Jup, da ich nicht weis, wie da die Namen sind mal mit Variationen spielen

find / -name '*node-exp*'VG

BerndP.S.: So Familienzeit, dann morgen weiter, ist sehr interessant und kurios.

-

Moin,

@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

find /etc/systemd/ -name '*node-export*'Jup, da ich nicht weis, wie da die Namen sind mal mit Variationen spielen

find / -name '*node-exp*'VG

BerndP.S.: So Familienzeit, dann morgen weiter, ist sehr interessant und kurios.

@dp20eic sagte in Systemload im Proxmox Host auf die schliche kommen:

So Familienzeit, dann morgen weiter, ist sehr interessant und kurios.

kurios allerdings, aber keine Eile, is hier nur ein Hobby

hab aus Spaß mal die version 1.4.0 geladen und installiert, dachte vllt bügelt sich das glatt, scheint so als würde das jetzt doppelt laufen

root@zotac327:/opt/node_exporter/node_exporter-1.4.0.linux-amd64# cd root@zotac327:~# nano /etc/systemd/system/node_exporter.service root@zotac327:~# systemctl daemon-reload systemctl start node_exporter systemctl enable node_exporter systemctl status node_exporter Created symlink /etc/systemd/system/multi-user.target.wants/node_exporter.service → /etc/systemd/system/node_exporter.service. ● node_exporter.service - Node Exporter Loaded: loaded (/etc/systemd/system/node_exporter.service; enabled; preset: enabled) Active: active (running) since Sun 2023-07-23 21:00:52 CEST; 1s ago Main PID: 16782 (node_exporter) Tasks: 7 (limit: 18915) Memory: 9.3M CPU: 182ms CGroup: /system.slice/node_exporter.service └─16782 /opt/node_exporter/node_exporter-1.4.0.linux-amd64/node_exporter Jul 23 21:00:52 zotac327 node_exporter[16782]: ts=2023-07-23T19:00:52.691Z caller=node_exporter.go:115 level=info collector=thermal_zone Jul 23 21:00:52 zotac327 node_exporter[16782]: ts=2023-07-23T19:00:52.691Z caller=node_exporter.go:115 level=info collector=time Jul 23 21:00:52 zotac327 node_exporter[16782]: ts=2023-07-23T19:00:52.691Z caller=node_exporter.go:115 level=info collector=timex Jul 23 21:00:52 zotac327 node_exporter[16782]: ts=2023-07-23T19:00:52.691Z caller=node_exporter.go:115 level=info collector=udp_queues Jul 23 21:00:52 zotac327 node_exporter[16782]: ts=2023-07-23T19:00:52.691Z caller=node_exporter.go:115 level=info collector=uname Jul 23 21:00:52 zotac327 node_exporter[16782]: ts=2023-07-23T19:00:52.691Z caller=node_exporter.go:115 level=info collector=vmstat Jul 23 21:00:52 zotac327 node_exporter[16782]: ts=2023-07-23T19:00:52.691Z caller=node_exporter.go:115 level=info collector=xfs Jul 23 21:00:52 zotac327 node_exporter[16782]: ts=2023-07-23T19:00:52.691Z caller=node_exporter.go:115 level=info collector=zfs Jul 23 21:00:52 zotac327 node_exporter[16782]: ts=2023-07-23T19:00:52.691Z caller=node_exporter.go:199 level=info msg="Listening on" address=:9> Jul 23 21:00:52 zotac327 node_exporter[16782]: ts=2023-07-23T19:00:52.692Z caller=tls_config.go:195 level=info msg="TLS is disabled." http2=fal> root@zotac327:~# systemctl status | grep -i expo │ │ ├─node_exporter.service │ │ │ └─20088 /opt/node_exporter/node_exporter-1.4.0.linux-amd64/node_exporter │ ├─node_exporter.service │ │ └─16782 /opt/node_exporter/node_exporter-1.4.0.linux-amd64/node_exporter │ └─22528 grep -i expohab dann nun die 1.4.0 wieder gelöscht incl service, jedoch bleibt die andere bestehen

nun auch das aktuelle proxmox upgrade gemacht und host anschließend neu gestartetroot@zotac327:~# systemctl status node_exporter Unit node_exporter.service could not be found. root@zotac327:~# systemctl status node_exporter Unit node_exporter.service could not be found. root@zotac327:~# systemctl status | grep -i expo │ │ ├─node_exporter.service │ │ │ └─3901 /opt/node_exporter/node_exporter-1.4.0.linux-amd64/node_exporter │ └─7706 grep -i expo root@zotac327:~#ich versteh echt nicht, woher und warum dieser service gestartet wird, zumal in prometheus gar keine Werte ankommen

-

@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

das Startscript entfernt, danach den Host neu gestartet und sehe trotzdem noch/wieder die 1.4.0

Moin,

im Bild steht ja etwas von

/opt/node_export../@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

/usr/bin/prometheus-node-exporter --version

Welche services laufen denn noch?

root@pve:~# systemctl status | grep -i prome │ ├─prometheus-node-exporter.service │ │ └─435550 /usr/bin/prometheus-node-exporter │ └─599998 grep -i promeroot@pve:~# grep -siEl 'node-exporter|node_exporter' /lib/systemd/system/* /lib/systemd/system/prometheus-node-exporter-apt.service /lib/systemd/system/prometheus-node-exporter-ipmitool-sensor.service /lib/systemd/system/prometheus-node-exporter-mellanox-hca-temp.service /lib/systemd/system/prometheus-node-exporter-nvme.service /lib/systemd/system/prometheus-node-exporter.service /lib/systemd/system/prometheus-node-exporter-smartmon.serviceIch habe oben ein ' vergessen

find / -name '*node_exp*'VG

Bernd@dp20eic sagte in Systemload im Proxmox Host auf die schliche kommen:

im Bild steht ja etwas von

Eine Nacht drüber schlafen bringt Wunder

jetzt ging mir ein Licht auf, es werden ja alle service angezeigt, auch die der laufenden LXC`s:wink:die 1.4.0 ist vom prometheus LXC selbst und nicht vom Host:man-facepalming:

somit kann man sich nun dem eigentlichen Problem des hohen Loads widmen

-

@dp20eic sagte in Systemload im Proxmox Host auf die schliche kommen:

im Bild steht ja etwas von

Eine Nacht drüber schlafen bringt Wunder

jetzt ging mir ein Licht auf, es werden ja alle service angezeigt, auch die der laufenden LXC`s:wink:die 1.4.0 ist vom prometheus LXC selbst und nicht vom Host:man-facepalming:

somit kann man sich nun dem eigentlichen Problem des hohen Loads widmen

@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

die 1.4.0 ist vom prometheus LXC selbst und nicht vom Host

Moin,

ich hatte mich auch immer wieder gewundert, denn das Verzeichnis

/opt/auf dem Host war ja leer, bzw. mit einer anderen Version/Verzeichnisstruktur.

Ich hatte, gestern Abend noch vorschlagen wollen, mal alle Container zu stoppen, hätte ich mal machen sollen :)VG

Bernd@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

Created symlink /etc/systemd/system/multi-user.target.wants/node_exporter.service → /etc/systemd/system/node_exporter.service.

Wobei ich das hier nicht verstehe, denn eigentlich ist das Standardverzeichnis für die Systemservices

ls -la /lib/systemd/system/Aus diesem Standardverzeichnis wird dann beim

enableein Link in das erstelltroot@pve:~# ls -la /etc/systemd/system/multi-user.target.wants/prometheus-node-exporter.service lrwxrwxrwx 1 root root 52 Jul 23 20:09 /etc/systemd/system/multi-user.target.wants/prometheus-node-exporter.service -> /lib/systemd/system/prometheus-node-exporter.serviceAber eh Wurst, ist echt gut, dass Du das gesehen hast, ich hätte das wohl nicht gefunden, ohne Zugriff auf Deinen Rechner zu haben.

VG

Bernd -

@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

die 1.4.0 ist vom prometheus LXC selbst und nicht vom Host

Moin,

ich hatte mich auch immer wieder gewundert, denn das Verzeichnis

/opt/auf dem Host war ja leer, bzw. mit einer anderen Version/Verzeichnisstruktur.

Ich hatte, gestern Abend noch vorschlagen wollen, mal alle Container zu stoppen, hätte ich mal machen sollen :)VG

Bernd@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

Created symlink /etc/systemd/system/multi-user.target.wants/node_exporter.service → /etc/systemd/system/node_exporter.service.

Wobei ich das hier nicht verstehe, denn eigentlich ist das Standardverzeichnis für die Systemservices

ls -la /lib/systemd/system/Aus diesem Standardverzeichnis wird dann beim

enableein Link in das erstelltroot@pve:~# ls -la /etc/systemd/system/multi-user.target.wants/prometheus-node-exporter.service lrwxrwxrwx 1 root root 52 Jul 23 20:09 /etc/systemd/system/multi-user.target.wants/prometheus-node-exporter.service -> /lib/systemd/system/prometheus-node-exporter.serviceAber eh Wurst, ist echt gut, dass Du das gesehen hast, ich hätte das wohl nicht gefunden, ohne Zugriff auf Deinen Rechner zu haben.

VG

Bernd@dp20eic sagte in Systemload im Proxmox Host auf die schliche kommen:

mal alle Container zu stoppen

das hatte ich zwischenzeitlich immer mal um zu sehen ob der load nach unten geht, aber nicht auf den Rest geachtet

nun bin ich weiter auf der Suche, was den Host von den anderen unterscheidet, hab mal das Log durchgesehen, nach einem Neustart

- eine Windows VM hatte ich mal auf dem Host eingerichtet, hängt ne separate SSD dafür im Rechner, entsprechend Hardware durchgereicht, war aber zur Anfangszeit meiner Proxmox Karriere:grin:

hier mal ein paar Zeilen, die ich gefunden hab

10:00:41 zotac327 kernel: Kernel command line: BOOT_IMAGE=/boot/vmlinuz-6.2.16-4-pve root=/dev/mapper/pve-root ro quiet intel_iommu=on vfio_iommu_type1.allow_unsafe_interrupts=1 Jul 24 10:00:41 zotac327 kernel: Unknown kernel command line parameters "BOOT_IMAGE=/boot/vmlinuz-6.2.16-4-pve", will be passed to user space. Jul 24 10:00:41 zotac327 systemd-modules-load[459]: Inserted module 'vfio_pci' Jul 24 10:00:41 zotac327 systemd-modules-load[459]: Failed to find module 'vfio_virqfd'- bluetooth firmware Problem

Jul 24 10:00:44 zotac327 kernel: Bluetooth: hci0: Legacy ROM 2.5 revision 1.0 build 3 week 17 2014 Jul 24 10:00:44 zotac327 kernel: bluetooth hci0: Direct firmware load for intel/ibt-hw-37.8.10-fw-1.10.3.11.e.bseq failed with error -2 Jul 24 10:00:44 zotac327 kernel: Bluetooth: hci0: failed to open Intel firmware file: intel/ibt-hw-37.8.10-fw-1.10.3.11.e.bseq (-2) Jul 24 10:00:44 zotac327 kernel: bluetooth hci0: Direct firmware load for intel/ibt-hw-37.8.bseq failed with error -2 Jul 24 10:00:44 zotac327 kernel: Bluetooth: hci0: failed to open default fw file: intel/ibt-hw-37.8.bseq Jul 24 10:00:44 zotac327 systemd[1]: Starting systemd-rfkill.service - Load/Save RF Kill Switch Status... Jul 24 10:00:44 zotac327 systemd[1]: Reached target bluetooth.target - Bluetooth Support.nut server, da ist aber alles i.o

ul 24 10:00:44 zotac327 nut-driver-enumerator[766]: Mon Jul 24 08:00:44 AM UTC 2023 : OK: No changes to reconcile between systemd service instances and device configurations in '/etc/nut/ups.conf' Jul 24 10:00:44 zotac327 systemd[1]: nut-driver-enumerator.service: Deactivated successfully. Jul 24 10:00:44 zotac327 systemd[1]: Finished nut-driver-enumerator.service - Network UPS Tools - enumeration of configure-file devices into systemd unit instances. Jul 24 10:00:44 zotac327 nut-driver@APC1400[849]: Using subdriver: APC HID 0.98 Jul 24 10:00:44 zotac327 nut-driver@APC1400[849]: Network UPS Tools - Generic HID driver 0.47 (2.8.0) Jul 24 10:00:44 zotac327 nut-driver@APC1400[849]: USB communication driver (libusb 1.0) 0.43 Jul 24 10:00:44 zotac327 nut-driver@APC1400[847]: Network UPS Tools - UPS driver controller 2.8.0 Jul 24 10:00:44 zotac327 systemd[1]: Started nut-driver@APC1400.service - Network UPS Tools - device driver for NUT device 'APC1400'. Jul 24 10:00:44 zotac327 usbhid-ups[891]: Startup successful Jul 24 10:00:44 zotac327 systemd[1]: Reached target nut-driver.target - Network UPS Tools - target for power device drivers on this system.ansonsten fällt mir weiter nichts auf, bzw wüsste ich nicht was da noch anderes läuft als auf den anderen

zwecks Hardware durchreichen hab ich jetzt mal

/etc/default/grubwieder auf Standart geändert, die Windows VM ist sowieso nicht in gebrauch -

@dp20eic sagte in Systemload im Proxmox Host auf die schliche kommen:

mal alle Container zu stoppen

das hatte ich zwischenzeitlich immer mal um zu sehen ob der load nach unten geht, aber nicht auf den Rest geachtet

nun bin ich weiter auf der Suche, was den Host von den anderen unterscheidet, hab mal das Log durchgesehen, nach einem Neustart

- eine Windows VM hatte ich mal auf dem Host eingerichtet, hängt ne separate SSD dafür im Rechner, entsprechend Hardware durchgereicht, war aber zur Anfangszeit meiner Proxmox Karriere:grin:

hier mal ein paar Zeilen, die ich gefunden hab

10:00:41 zotac327 kernel: Kernel command line: BOOT_IMAGE=/boot/vmlinuz-6.2.16-4-pve root=/dev/mapper/pve-root ro quiet intel_iommu=on vfio_iommu_type1.allow_unsafe_interrupts=1 Jul 24 10:00:41 zotac327 kernel: Unknown kernel command line parameters "BOOT_IMAGE=/boot/vmlinuz-6.2.16-4-pve", will be passed to user space. Jul 24 10:00:41 zotac327 systemd-modules-load[459]: Inserted module 'vfio_pci' Jul 24 10:00:41 zotac327 systemd-modules-load[459]: Failed to find module 'vfio_virqfd'- bluetooth firmware Problem

Jul 24 10:00:44 zotac327 kernel: Bluetooth: hci0: Legacy ROM 2.5 revision 1.0 build 3 week 17 2014 Jul 24 10:00:44 zotac327 kernel: bluetooth hci0: Direct firmware load for intel/ibt-hw-37.8.10-fw-1.10.3.11.e.bseq failed with error -2 Jul 24 10:00:44 zotac327 kernel: Bluetooth: hci0: failed to open Intel firmware file: intel/ibt-hw-37.8.10-fw-1.10.3.11.e.bseq (-2) Jul 24 10:00:44 zotac327 kernel: bluetooth hci0: Direct firmware load for intel/ibt-hw-37.8.bseq failed with error -2 Jul 24 10:00:44 zotac327 kernel: Bluetooth: hci0: failed to open default fw file: intel/ibt-hw-37.8.bseq Jul 24 10:00:44 zotac327 systemd[1]: Starting systemd-rfkill.service - Load/Save RF Kill Switch Status... Jul 24 10:00:44 zotac327 systemd[1]: Reached target bluetooth.target - Bluetooth Support.nut server, da ist aber alles i.o

ul 24 10:00:44 zotac327 nut-driver-enumerator[766]: Mon Jul 24 08:00:44 AM UTC 2023 : OK: No changes to reconcile between systemd service instances and device configurations in '/etc/nut/ups.conf' Jul 24 10:00:44 zotac327 systemd[1]: nut-driver-enumerator.service: Deactivated successfully. Jul 24 10:00:44 zotac327 systemd[1]: Finished nut-driver-enumerator.service - Network UPS Tools - enumeration of configure-file devices into systemd unit instances. Jul 24 10:00:44 zotac327 nut-driver@APC1400[849]: Using subdriver: APC HID 0.98 Jul 24 10:00:44 zotac327 nut-driver@APC1400[849]: Network UPS Tools - Generic HID driver 0.47 (2.8.0) Jul 24 10:00:44 zotac327 nut-driver@APC1400[849]: USB communication driver (libusb 1.0) 0.43 Jul 24 10:00:44 zotac327 nut-driver@APC1400[847]: Network UPS Tools - UPS driver controller 2.8.0 Jul 24 10:00:44 zotac327 systemd[1]: Started nut-driver@APC1400.service - Network UPS Tools - device driver for NUT device 'APC1400'. Jul 24 10:00:44 zotac327 usbhid-ups[891]: Startup successful Jul 24 10:00:44 zotac327 systemd[1]: Reached target nut-driver.target - Network UPS Tools - target for power device drivers on this system.ansonsten fällt mir weiter nichts auf, bzw wüsste ich nicht was da noch anderes läuft als auf den anderen

zwecks Hardware durchreichen hab ich jetzt mal

/etc/default/grubwieder auf Standart geändert, die Windows VM ist sowieso nicht in gebrauch@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

hier mal ein paar Zeilen, die ich gefunden hab

Moin,

da steht ein nicht gültiger Kernel Boot Parameter, laut Kernel Dokumentation gibt es

BOOT_IMAGEnicht, da solltest Du mal schauen was da in Deiner/etc/default/grubund/oder `/etc/grub.d/* steht.

Diesen Eintrag gibt es bei mir nicht.@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

bluetooth firmware Problem

Wenn Du das nicht brauchst, dann versuch das im BIOS abzuschalten. Ist das ein proprietärer Treiber für proprietäre Hardware, ist das der korrekte Treiber für die Hardware

# lshw # lspci # lsusb@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

nut server, da ist aber alles i.o

Ja, der sagt ja nur, dass es zwischen Systemdienst und NUT Konfiguration keine Diskrepanz gibt, also alles ok ist.

@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

zwecks Hardware durchreichen hab ich jetzt mal /etc/default/grub wieder auf Standart geändert, die Windows VM ist sowieso nicht in gebrauch

Das verstehe ich nicht, was reicht man denn an Hardware bei Grub durch? Wie sah das aus?

Grubist für mich der Bootmanager`, wo ich mir beim Booten aussuchen kann, welchen Kernel ich laden möchte, oder falls noch eine Partition mit Windows vorhanden ist, ob ich Windows starten möchte.@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

eine Windows VM hatte ich mal auf dem Host eingerichtet, hängt ne separate SSD dafür im Rechner, entsprechend Hardware durchgereicht, war aber zur Anfangszeit meiner Proxmox Karriere

Vielleicht habe ich Dich auch hier nicht korrekt verstanden?

Für mich hat eine VM, in die ich Windows installiere, nichts mit einem Windows auf einer eigenen Platte zu tun, wo ich mir dann ein Dual-Boot in Grub einrichte.

Bei der VM reiche ich doch virtuelle Hardware durch, das macht doch derqemuund Installiere Gast seitig, dann Treiber für die virtuelle Hardware.Was, wie sieht denn Dein aktuelles Problem auf dem Rechner aus, wie macht es sich bemerkbar?

VG

Bernd -

@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

hier mal ein paar Zeilen, die ich gefunden hab

Moin,

da steht ein nicht gültiger Kernel Boot Parameter, laut Kernel Dokumentation gibt es

BOOT_IMAGEnicht, da solltest Du mal schauen was da in Deiner/etc/default/grubund/oder `/etc/grub.d/* steht.

Diesen Eintrag gibt es bei mir nicht.@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

bluetooth firmware Problem

Wenn Du das nicht brauchst, dann versuch das im BIOS abzuschalten. Ist das ein proprietärer Treiber für proprietäre Hardware, ist das der korrekte Treiber für die Hardware

# lshw # lspci # lsusb@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

nut server, da ist aber alles i.o

Ja, der sagt ja nur, dass es zwischen Systemdienst und NUT Konfiguration keine Diskrepanz gibt, also alles ok ist.

@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

zwecks Hardware durchreichen hab ich jetzt mal /etc/default/grub wieder auf Standart geändert, die Windows VM ist sowieso nicht in gebrauch

Das verstehe ich nicht, was reicht man denn an Hardware bei Grub durch? Wie sah das aus?

Grubist für mich der Bootmanager`, wo ich mir beim Booten aussuchen kann, welchen Kernel ich laden möchte, oder falls noch eine Partition mit Windows vorhanden ist, ob ich Windows starten möchte.@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

eine Windows VM hatte ich mal auf dem Host eingerichtet, hängt ne separate SSD dafür im Rechner, entsprechend Hardware durchgereicht, war aber zur Anfangszeit meiner Proxmox Karriere

Vielleicht habe ich Dich auch hier nicht korrekt verstanden?

Für mich hat eine VM, in die ich Windows installiere, nichts mit einem Windows auf einer eigenen Platte zu tun, wo ich mir dann ein Dual-Boot in Grub einrichte.

Bei der VM reiche ich doch virtuelle Hardware durch, das macht doch derqemuund Installiere Gast seitig, dann Treiber für die virtuelle Hardware.Was, wie sieht denn Dein aktuelles Problem auf dem Rechner aus, wie macht es sich bemerkbar?

VG

Bernd@dp20eic sagte in Systemload im Proxmox Host auf die schliche kommen:

Was, wie sieht denn Dein aktuelles Problem auf dem Rechner aus, wie macht es sich bemerkbar?

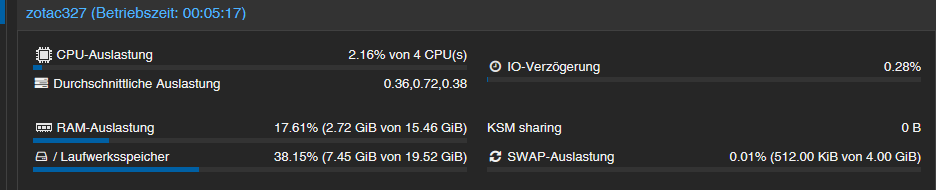

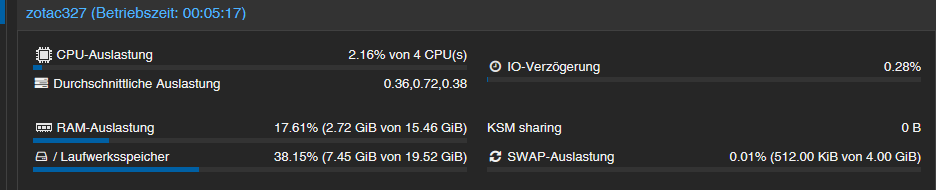

Wie bereits erwähnt, der load stieg von ca 0,4 auf 1.4, sprich um 1 konstant an, durch das Proxmox upgrade

Der load bleibt auch, wenn ich alle LXC/VM runter fahre.@dp20eic sagte in Systemload im Proxmox Host auf die schliche kommen:

Vielleicht habe ich Dich auch hier nicht korrekt verstanden?

Beim durchreichen ging es darum, die Grafikkarte durchzureichen. Darauf bezieht sich auch der Kernel Eintrag.

vfio_iommu_type1.allow_unsafe_interrupts=1

Hab ich mittlerweile schon auf Standard geändert und auch die vfio.conf gelöscht.

Allerdings noch nicht neu gebootet, da ich aktuell auf Arbeit bin(Spätschicht)Mit dem Nut Server wollte ich nur hinweisen, das dieser installiert ist, bzw klarstellen was speziell auf diesem Host läuft, was auf den anderen nicht läuft, um das Problem einzugrenzen.

@dp20eic sagte in Systemload im Proxmox Host auf die schliche kommen:

Wenn Du das nicht brauchst, dann versuch das im BIOS abzuschalten

Eigentlich schon, bluetooth sollte/funktioniert an sich ja auch, nötig für iobroker (radar2/ble Adapter)

Deshalb viel mir das auch gar nicht auf.

Aktuell läuft der iobroker allerdings auf nem anderen Host.Ich guck mir das heut abend oder morgen früh dann mal genauer an.

EDIT

so jetzt mal neu gebootet, scheinbar lag es an dem10:00:41 zotac327 kernel: Kernel command line: BOOT_IMAGE=/boot/vmlinuz-6.2.16-4-pve root=/dev/mapper/pve-root ro quiet intel_iommu=on vfio_iommu_type1.allow_unsafe_interrupts=1 Jul 24 10:00:41 zotac327 kernel: Unknown kernel command line parameters "BOOT_IMAGE=/boot/vmlinuz-6.2.16-4-pve", will be passed to user space. Jul 24 10:00:41 zotac327 systemd-modules-load[459]: Inserted module 'vfio_pci' Jul 24 10:00:41 zotac327 systemd-modules-load[459]: Failed to find module 'vfio_virqfd'Load passt jetzt wieder

was mich aber wundert, das dies seit 4 Jahren so eingetragen war, bzw ja eigentlich auch korrekt war und funktioniert hatte, aber nun mit proxmox v7 auf v8 zum Problem wurdebleibt noch bluetooth Firmware Problem seit v8, hab auf dem anderen Host ebenfalls den Fehler

könnte es vllt helfen, bookworm-backports wieder mit einzutragen? (zumindest hatte ich die, soweit ich mich erinner, genau wegen bluetooth drin stehen) -

@dp20eic sagte in Systemload im Proxmox Host auf die schliche kommen:

Was, wie sieht denn Dein aktuelles Problem auf dem Rechner aus, wie macht es sich bemerkbar?

Wie bereits erwähnt, der load stieg von ca 0,4 auf 1.4, sprich um 1 konstant an, durch das Proxmox upgrade

Der load bleibt auch, wenn ich alle LXC/VM runter fahre.@dp20eic sagte in Systemload im Proxmox Host auf die schliche kommen:

Vielleicht habe ich Dich auch hier nicht korrekt verstanden?

Beim durchreichen ging es darum, die Grafikkarte durchzureichen. Darauf bezieht sich auch der Kernel Eintrag.

vfio_iommu_type1.allow_unsafe_interrupts=1

Hab ich mittlerweile schon auf Standard geändert und auch die vfio.conf gelöscht.

Allerdings noch nicht neu gebootet, da ich aktuell auf Arbeit bin(Spätschicht)Mit dem Nut Server wollte ich nur hinweisen, das dieser installiert ist, bzw klarstellen was speziell auf diesem Host läuft, was auf den anderen nicht läuft, um das Problem einzugrenzen.

@dp20eic sagte in Systemload im Proxmox Host auf die schliche kommen:

Wenn Du das nicht brauchst, dann versuch das im BIOS abzuschalten

Eigentlich schon, bluetooth sollte/funktioniert an sich ja auch, nötig für iobroker (radar2/ble Adapter)

Deshalb viel mir das auch gar nicht auf.

Aktuell läuft der iobroker allerdings auf nem anderen Host.Ich guck mir das heut abend oder morgen früh dann mal genauer an.

EDIT

so jetzt mal neu gebootet, scheinbar lag es an dem10:00:41 zotac327 kernel: Kernel command line: BOOT_IMAGE=/boot/vmlinuz-6.2.16-4-pve root=/dev/mapper/pve-root ro quiet intel_iommu=on vfio_iommu_type1.allow_unsafe_interrupts=1 Jul 24 10:00:41 zotac327 kernel: Unknown kernel command line parameters "BOOT_IMAGE=/boot/vmlinuz-6.2.16-4-pve", will be passed to user space. Jul 24 10:00:41 zotac327 systemd-modules-load[459]: Inserted module 'vfio_pci' Jul 24 10:00:41 zotac327 systemd-modules-load[459]: Failed to find module 'vfio_virqfd'Load passt jetzt wieder

was mich aber wundert, das dies seit 4 Jahren so eingetragen war, bzw ja eigentlich auch korrekt war und funktioniert hatte, aber nun mit proxmox v7 auf v8 zum Problem wurdebleibt noch bluetooth Firmware Problem seit v8, hab auf dem anderen Host ebenfalls den Fehler

könnte es vllt helfen, bookworm-backports wieder mit einzutragen? (zumindest hatte ich die, soweit ich mich erinner, genau wegen bluetooth drin stehen)@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

was mich aber wundert, das dies seit 4 Jahren so eingetragen war, bzw ja eigentlich auch korrekt war und funktioniert hatte, aber nun mit proxmox v7 auf v8 zum Problem wurde

bleibt noch bluetooth Firmware Problem seit v8, hab auf dem anderen Host ebenfalls den Fehler

könnte es vllt helfen, bookworm-backports wieder mit einzutragen? (zumindest hatte ich die, soweit ich mich erinner, genau wegen bluetooth drin stehen)Moin,

suppie, dass Du Deine Probleme in den Griff bekommen hast.

Zum ersten, ich habe nicht geschaut, ob es diesen Eintrag

BOOT_IMAGEjemals gab, es kann aber sein, dass Einträge, die ein mal funktionierten, im besten Fall ignoriert wurden, jetzt mit neuem Kernel, Systemd, grub, oder, oder halt nicht mehr so funktionieren und dann halt in einem diffusen Fehlerbild resultieren.Zum zweiten, kann ich nichts sagen, da ich die Hardware nicht kenne und somit auch nicht abschätzen kann, was da an Firmware gebraucht wird und welche aktuell ist.

@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

Jul 24 10:00:41 zotac327 systemd-modules-load[459]: Inserted module 'vfio_pci'

Jul 24 10:00:41 zotac327 systemd-modules-load[459]: Failed to find module 'vfio_virqfd'Das ist der Output noch vor dem Booten?

Da ich Windows nicht brauche, oder brauchen werde, eher hole ich meinen alten Atari aus dem Keller wieder hoch :)

Habe ich mich gerade einmal auf die Suche gemacht https://wiki.archlinux.org/title/PCI_passthrough_via_OVMF, aber für mich aktuell nicht interessant, habe nicht einmal mehr eine GraKa im Rechner und da ich mit LXC Containern super zurechtkomme :)Dann mal weiter viel Erfolg.

VG

Bernd -

@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

was mich aber wundert, das dies seit 4 Jahren so eingetragen war, bzw ja eigentlich auch korrekt war und funktioniert hatte, aber nun mit proxmox v7 auf v8 zum Problem wurde

bleibt noch bluetooth Firmware Problem seit v8, hab auf dem anderen Host ebenfalls den Fehler

könnte es vllt helfen, bookworm-backports wieder mit einzutragen? (zumindest hatte ich die, soweit ich mich erinner, genau wegen bluetooth drin stehen)Moin,

suppie, dass Du Deine Probleme in den Griff bekommen hast.

Zum ersten, ich habe nicht geschaut, ob es diesen Eintrag

BOOT_IMAGEjemals gab, es kann aber sein, dass Einträge, die ein mal funktionierten, im besten Fall ignoriert wurden, jetzt mit neuem Kernel, Systemd, grub, oder, oder halt nicht mehr so funktionieren und dann halt in einem diffusen Fehlerbild resultieren.Zum zweiten, kann ich nichts sagen, da ich die Hardware nicht kenne und somit auch nicht abschätzen kann, was da an Firmware gebraucht wird und welche aktuell ist.

@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

Jul 24 10:00:41 zotac327 systemd-modules-load[459]: Inserted module 'vfio_pci'

Jul 24 10:00:41 zotac327 systemd-modules-load[459]: Failed to find module 'vfio_virqfd'Das ist der Output noch vor dem Booten?

Da ich Windows nicht brauche, oder brauchen werde, eher hole ich meinen alten Atari aus dem Keller wieder hoch :)

Habe ich mich gerade einmal auf die Suche gemacht https://wiki.archlinux.org/title/PCI_passthrough_via_OVMF, aber für mich aktuell nicht interessant, habe nicht einmal mehr eine GraKa im Rechner und da ich mit LXC Containern super zurechtkomme :)Dann mal weiter viel Erfolg.

VG

Bernd@dp20eic sagte in Systemload im Proxmox Host auf die schliche kommen:

Das ist der Output noch vor dem Booten

ja, das ist ja nun beseitigt

bluetooth läuft jetzt auch wieder, hab die 2 angemeckerten Dateien aus dmesg nach

/usr/lib/firmware/intelkopiert@dp20eic sagte in Systemload im Proxmox Host auf die schliche kommen:

Da ich Windows nicht brauche, oder brauchen werde, eher hole ich meinen alten Atari aus dem Keller wieder hoch

naja, war damals der Gedanke ne windows VM damit ich nicht noch zusätzlich einen Rechner hier rum stehen hab.

allerdings, Atari war schon ne coole Sache -

@dp20eic sagte in Systemload im Proxmox Host auf die schliche kommen:

Das ist der Output noch vor dem Booten

ja, das ist ja nun beseitigt

bluetooth läuft jetzt auch wieder, hab die 2 angemeckerten Dateien aus dmesg nach

/usr/lib/firmware/intelkopiert@dp20eic sagte in Systemload im Proxmox Host auf die schliche kommen:

Da ich Windows nicht brauche, oder brauchen werde, eher hole ich meinen alten Atari aus dem Keller wieder hoch

naja, war damals der Gedanke ne windows VM damit ich nicht noch zusätzlich einen Rechner hier rum stehen hab.

allerdings, Atari war schon ne coole Sache@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

Atari war schon ne coole Sache

Moin,

da kommt doch noch mal der Spieltrieb in mir hoch, sollte ich wirklich mal versuchen, ob das Teil noch funzt :)

http://www.medusacomputer.com/thes-hades.htmlVG

Bernd -

@crunchip sagte in Systemload im Proxmox Host auf die schliche kommen:

Atari war schon ne coole Sache

Moin,

da kommt doch noch mal der Spieltrieb in mir hoch, sollte ich wirklich mal versuchen, ob das Teil noch funzt :)

http://www.medusacomputer.com/thes-hades.htmlVG

Bernd@dp20eic dann versuch dein Glück:blush:

ich sag mal vielen Dank für deine Hilfsbereitschaft und Denkanstoß:+1: