NEWS

Nächtlicher Systemabsturz

-

@ilovegym Die InfluxDbs laufen in eigenen Container.

Auf diesem läuft ausschließlich der Broker@bloop sagte in Nächtlicher Systemabsturz:

Die InfluxDbs laufen in eigenen Container.

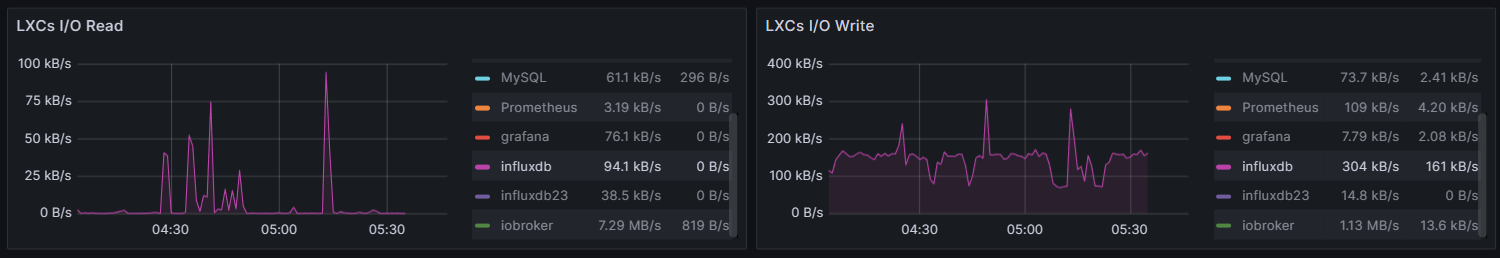

These: Die InfluxDBs sind so fett geworden, dass sie bei internen Reorganisationsläufen den gesamten RAM auffressen und die Festplatte lahm legen. Das lässt auch den ioBroker abschmieren.

Lösung: Datenbanken deutlich abspecken oder potentere HW nutzen.

-

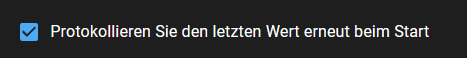

Kann es sein das der Rechner auch ganz gut ausgelastet ist?

Wenn ich das so überschlage bei 75-90%?

Load avg / Anzahl threads = 3 bis 3.6 / 4@oliverio

Gute Frage weshalb der Log eine so hohe Auslastung anzeigt.

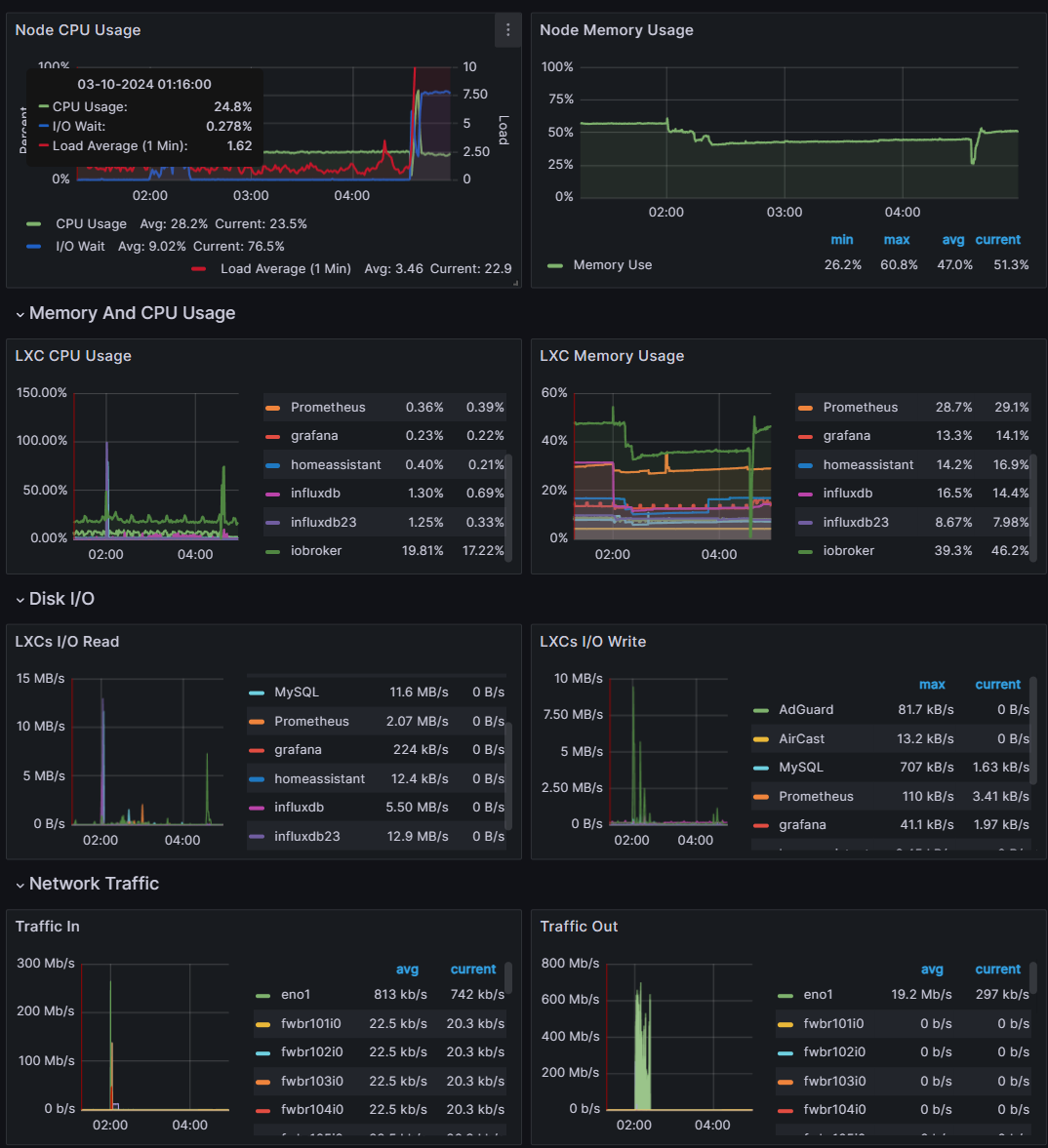

Dies hat sich scheinbar jetzt aber beruhigt.Systemuptime and Load: 10:20:31 up 14:40, 1 user, load average: 1.69, 1.78, 1.77 CPU threads: 4Der PVE hat eine Gesamtauslastung von 28% und einen durchschnittlichen Auslastung von 0.26,0.87,1.38

-

@bloop sagte in Nächtlicher Systemabsturz:

Die InfluxDbs laufen in eigenen Container.

These: Die InfluxDBs sind so fett geworden, dass sie bei internen Reorganisationsläufen den gesamten RAM auffressen und die Festplatte lahm legen. Das lässt auch den ioBroker abschmieren.

Lösung: Datenbanken deutlich abspecken oder potentere HW nutzen.

@marc-berg

Herzlichen Dank!

Einen ähnlichen Gedanken hatte ich auch schon.

Die LXC mit der InfluxDB hat sich aber erst nach 05:00 gefüllt.

Bereits vorher hat der ioBroker die Instanzen neu gestartet.

Hier muss etwas mit der Verbindung nicht gepasst haben. Was schlussendlich zum Systemabsturz führte.Ich habe nun die influxdb Instanz auf Logstufe Debug gestellt, eventuell lässt sich etwas finden.

-

Guten Abend,

Nach nun fast einem 3/4 Jahr ohne Probleme hat sich mein ioBroker gestern Nacht aufgehängt.

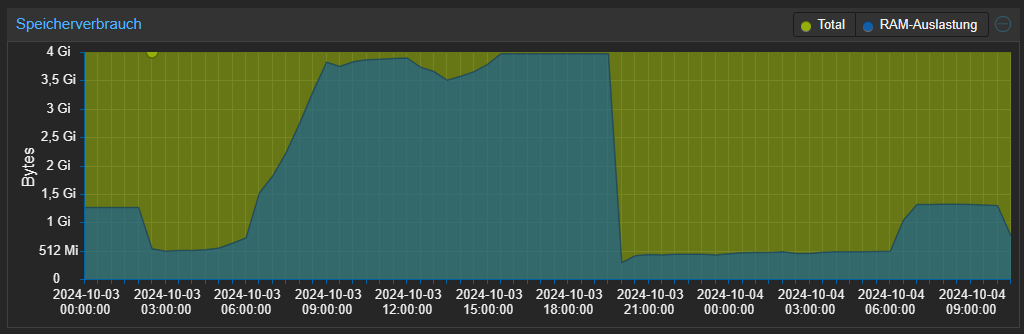

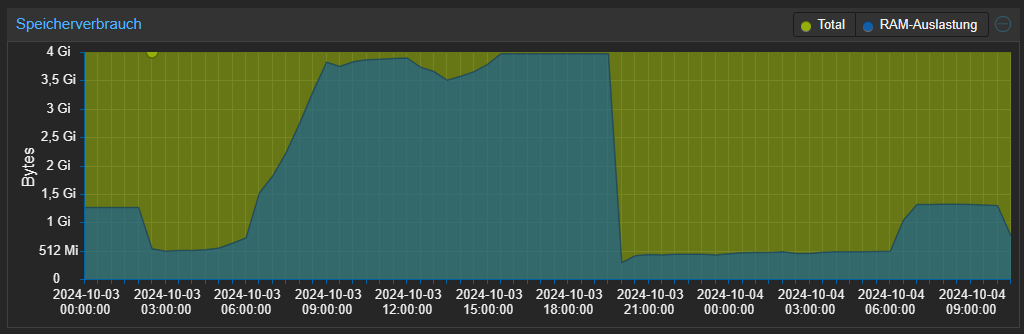

Der Ram lief systematisch zwischen 5 Uhr und 11 Uhr immer voller bis nichts mehr ging.

Zum Glück läuft jetzt wieder alles stabil.

Allerdings möchte ich vermeiden das so etwas erneut passiert.

Die Fehlerursache herauszufinden hat sich als etwas mühsam herausgestellt.Im Log lässt sich erkennen, das der ganze Spuck scheinbar um 04:34:00 angefangen hat:

2024-10-03 04:24:21.514 - info: hm-rpc.0 (1409126) State value to set for "hm-rpc.0.000A1D8991DA1B.1.LEVEL" has to be type "number" but received type "string" 2024-10-03 04:34:47.054 - info: javascript.0 (3676820) Stopping script script.js.common.Auto_.Auto 2024-10-03 04:34:47.083 - info: hm-rpc.0 (1409126) xmlrpc -> 192.168.0.225:2010/ init ["http://192.168.0.110:2010",""] 2024-10-03 04:34:47.062 - error: shelly.0 (1409346) States database error: read ECONNRESET 2024-10-03 04:34:47.092 - error: shelly.0 (1409346) Objects database error: read ECONNRESET 2024-10-03 04:34:47.131 - info: hm-rpc.0 (1409126) Disconnected 2024-10-03 04:34:47.085 - info: yahka.1 (1438947) cleaning up ... 2024-10-03 04:34:47.112 - info: yahka.1 (1438947) cleaned up ... 2024-10-03 04:34:47.072 - info: backitup.0 (3317475) cleaned everything up... 2024-10-03 04:34:47.194 - info: info.0 (1409676) cleaned everything up... 2024-10-03 04:34:47.058 - info: javascript.0 (3676820) Stopping script script.js.common.Benachrichtigungen.Benachrichtigung_Aktivieren 2024-10-03 04:34:47.066 - info: javascript.0 (3676820) Stopping script script.js.common.Benachrichtigungen.Benachrichtigung_Türschloss_Terrasse 2024-10-03 04:34:47.066 - info: javascript.0 (3676820) Stopping script script.js.common.Benachrichtigungen.Briefkasten 2024-10-03 04:34:47.067 - info: javascript.0 (3676820) Stopping script script.js.common.Benachrichtigungen.Digitalisiererusw.

Erst stoppten alle Skripte... anschließend die Instanzen

2024-10-03 04:34:47.272 - info: javascript.0 (3676820) Stopping script script.js.common.Heizung.Boilersteuerung 2024-10-03 04:34:47.275 - info: javascript.0 (3676820) Stopping script script.js.common.Klima.Stromsparen 2024-10-03 04:34:47.229 - error: wled.0 (1410509) Websocket connection error : Error: WebSocket was closed before the connection was established 2024-10-03 04:34:47.231 - info: hm-rpc.1 (1409153) xmlrpc -> 192.168.0.225:9292/groups/ init ["http://192.168.0.110:9292",""] 2024-10-03 04:34:47.143 - info: logparser.0 (1410151) cleaned everything up... 2024-10-03 04:34:47.364 - info: hm-rpc.1 (1409153) Disconnected 2024-10-03 04:34:47.181 - info: cloud.0 (76320) Connection changed: disconnect 2024-10-03 04:34:47.346 - info: cloud.0 (76320) Connection lost 2024-10-03 04:34:47.373 - info: sourceanalytix.0 (1410312) SourceAnalytix stopped, now you have to calculate by yourself :'( ... 2024-10-03 04:34:47.347 - info: linkeddevices.0 (1409711) cleaned everything up... 2024-10-03 04:34:47.454 - info: mqtt.0 (1233955) Disconnected from 192.168.0.110: undefined 2024-10-03 04:34:47.479 - info: mqtt.1 (1409231) Disconnected from eu1.cloud.thethings.network: undefined 2024-10-03 04:34:47.407 - info: admin.1 (76764) terminating http server on port 8081 2024-10-03 04:34:47.399 - info: sprinklecontrol.0 (1410342) cleaned everything up... 2024-10-03 04:34:47.356 - info: windows-control.0 (1410483) cleaned everything up... 2024-10-03 04:34:47.437 - info: simple-api.0 (1410247) terminating http server on port 8087 2024-10-03 04:34:47.525 - info: iot.0 (448777) Connection changed: disconnect 2024-10-03 04:34:47.567 - info: iot.0 (448777) Connection lost 2024-10-03 04:34:47.470 - info: yahka.0 (1410536) cleaning up ... 2024-10-03 04:34:47.592 - info: yahka.0 (1410536) cleaned up ... 2024-10-03 04:34:47.466 - info: vis-inventwo.0 (1410397) cleaned everything up... 2024-10-03 04:34:47.506 - info: socketio.0 (1410283) terminating http server on port 8084 2024-10-03 04:34:47.629 - error: web.0 (1410455) States database error: write EPIPE 2024-10-03 04:34:47.728 - warn: web.0 (1410455) setTimeout called, but adapter is shutting down 2024-10-03 04:34:48.173 - warn: sql.1 (1409014) No Connection to database 2024-10-03 04:34:48.181 - warn: sql.1 (1409014) No Connection to database 2024-10-03 04:34:48.183 - warn: sql.1 (1409014) No Connection to database 2024-10-03 04:34:48.548 - info: shelly.1 (1546431) terminating with timeout 2024-10-03 04:34:48.554 - info: javascript.0 (3676820) terminating with timeout 2024-10-03 04:34:48.555 - info: shelly.1 (1546431) Terminated (NO_ERROR): Without reason 2024-10-03 04:34:48.556 - debug: javascript.0 (3676820) Plugin sentry destroyed 2024-10-03 04:34:48.556 - info: javascript.0 (3676820) Terminated (NO_ERROR): Without reason 2024-10-03 04:34:48.554 - info: asuswrt.0 (1409545) terminating with timeout 2024-10-03 04:34:48.562 - info: asuswrt.0 (1409545) Terminated (NO_ERROR): Without reasontusw.

Anschließend jede menge Fehlermeldungen...

2024-10-03 04:34:49.230 - info: web.0 (1410455) terminating with timeout 2024-10-03 04:34:49.235 - info: web.0 (1410455) Terminated (NO_ERROR): Without reason 2024-10-03 04:34:49.351 - info: hm-rpc.1 (1409153) terminating with timeout 2024-10-03 04:34:49.354 - info: hm-rpc.1 (1409153) Terminated (NO_ERROR): Without reason 2024-10-03 04:34:52.041 - error: shelly.1 (1546431) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.046 - error: javascript.0 (3676820) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.049 - error: asuswrt.0 (1409545) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.059 - error: backitup.0 (3317475) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.058 - warn: javascript.0 (3676820) get state error: DB closed 2024-10-03 04:34:52.058 - warn: javascript.0 (3676820) get state error: DB closed 2024-10-03 04:34:52.059 - info: javascript.0 (3676820) terminating 2024-10-03 04:34:52.059 - info: javascript.0 (3676820) terminating 2024-10-03 04:34:52.064 - error: ping.0 (1409285) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.048 - error: influxdb.2 (1408833) States database error: connect ECONNREFUSED 192.168.0.110:9000 2024-10-03 04:34:52.070 - error: hm-rpc.0 (1409126) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.070 - warn: backitup.0 (3317475) get state error: Connection is closed. 2024-10-03 04:34:52.071 - error: adguard.0 (1409522) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.069 - error: influxdb.2 (1408833) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.079 - warn: ping.0 (1409285) get state error: Connection is closed. 2024-10-03 04:34:52.055 - error: influxdb.1 (1408792) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.077 - error: influxdb.1 (1408792) States database error: connect ECONNREFUSED 192.168.0.110:9000 2024-10-03 04:34:52.086 - warn: adguard.0 (1409522) get state error: Connection is closed. 2024-10-03 04:34:52.097 - error: logparser.0 (1410151) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.106 - error: shelly.0 (1409346) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.107 - warn: logparser.0 (1410151) get state error: Connection is closed. 2024-10-03 04:34:52.111 - warn: shelly.0 (1409346) get state error: DB closed 2024-10-03 04:34:52.111 - error: pushover.0 (1622829) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.111 - warn: shelly.0 (1409346) get state error: DB closed 2024-10-03 04:34:52.112 - warn: shelly.0 (1409346) get state error: DB closed 2024-10-03 04:34:52.112 - warn: shelly.0 (1409346) get state error: DB closed 2024-10-03 04:34:52.113 - warn: shelly.0 (1409346) get state error: DB closed 2024-10-03 04:34:52.113 - warn: shelly.0 (1409346) get state error: DB closed 2024-10-03 04:34:52.114 - warn: shelly.0 (1409346) get state error: DB closed 2024-10-03 04:34:52.114 - warn: shelly.0 (1409346) get state error: DB closed 2024-10-03 04:34:52.116 - warn: shelly.0 (1409346) get state error: DB closed 2024-10-03 04:34:52.117 - info: shelly.0 (1409346) terminating 2024-10-03 04:34:52.117 - info: shelly.0 (1409346) terminating 2024-10-03 04:34:52.129 - error: sql.1 (1409014) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.134 - error: sql.1 (1409014) States database error: connect ECONNREFUSED 192.168.0.110:9000 2024-10-03 04:34:52.137 - error: yahka.1 (1438947) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.142 - error: info.0 (1409676) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.143 - warn: yahka.1 (1438947) get state error: Connection is closed. 2024-10-03 04:34:52.154 - error: nut.0 (1409258) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.162 - warn: info.0 (1409676) get state error: Connection is closed. 2024-10-03 04:34:52.167 - error: cloud.0 (76320) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.179 - error: hm-rpc.1 (1409153) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.184 - warn: hm-rpc.1 (1409153) get state error: DB closed 2024-10-03 04:34:52.185 - warn: hm-rpc.1 (1409153) get state error: DB closed 2024-10-03 04:34:52.186 - info: hm-rpc.1 (1409153) terminating 2024-10-03 04:34:52.187 - info: hm-rpc.1 (1409153) terminating 2024-10-03 04:34:52.199 - error: pushover.2 (1622843) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.231 - error: mercedesme.0 (1410178) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.313 - error: admin.1 (76764) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.317 - error: wled.0 (1410509) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.329 - error: mqtt.0 (1233955) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.334 - warn: admin.1 (76764) get state error: Connection is closed. 2024-10-03 04:34:52.336 - warn: admin.1 (76764) get state error: DB closed 2024-10-03 04:34:52.341 - info: admin.1 (76764) terminating 2024-10-03 04:34:52.342 - info: admin.1 (76764) terminating 2024-10-03 04:34:52.351 - warn: mqtt.0 (1233955) get state error: Connection is closed. 2024-10-03 04:34:52.353 - error: linkeddevices.0 (1409711) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.355 - warn: mqtt.0 (1233955) get state error: DB closed 2024-10-03 04:34:52.358 - info: mqtt.0 (1233955) terminating 2024-10-03 04:34:52.358 - info: mqtt.0 (1233955) terminating 2024-10-03 04:34:52.381 - error: mqtt.1 (1409231) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.390 - warn: mqtt.1 (1409231) get state error: Connection is closed. 2024-10-03 04:34:52.392 - warn: mqtt.1 (1409231) get state error: DB closed 2024-10-03 04:34:52.397 - info: mqtt.1 (1409231) terminating 2024-10-03 04:34:52.397 - info: mqtt.1 (1409231) terminating 2024-10-03 04:34:52.406 - error: vesync.0 (1410707) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.414 - warn: vesync.0 (1410707) get state error: Connection is closed. 2024-10-03 04:34:52.418 - error: hm-rega.0 (1409099) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.419 - warn: vesync.0 (1410707) get state error: DB closed 2024-10-03 04:34:52.428 - info: vesync.0 (1410707) terminating 2024-10-03 04:34:52.429 - info: vesync.0 (1410707) terminating 2024-10-03 04:34:52.455 - error: iot.0 (448777) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.450 - error: imap.0 (1409648) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.468 - warn: iot.0 (448777) get state error: Connection is closed. 2024-10-03 04:34:52.473 - error: sourceanalytix.0 (1410312) Objects database error: connect ECONNREFUSED 192.168.0.110:9001 2024-10-03 04:34:52.472 - warn: iot.0 (448777) get state error: DB closedusw.

Kurz später - werden die Instanzen versucht erneut zu starten

2024-10-03 04:36:08.256 - info: host.iobroker Delete state "system.host.iobroker.versions.npmNewestNext" 2024-10-03 04:36:08.299 - info: host.iobroker Some obsolete host states deleted. 2024-10-03 04:36:09.716 - error: admin.1 (2301693) admin.1 already running 2024-10-03 04:36:09.719 - warn: admin.1 (2301693) Terminated (ADAPTER_ALREADY_RUNNING): Without reason 2024-10-03 04:36:10.327 - error: host.iobroker instance system.adapter.admin.1 terminated with code 7 (ADAPTER_ALREADY_RUNNING) 2024-10-03 04:36:10.328 - info: host.iobroker Restart adapter system.adapter.admin.1 because enabled 2024-10-03 04:36:12.065 - info: host.iobroker instance system.adapter.influxdb.1 in version "4.0.2" started with pid 2301716 2024-10-03 04:36:13.277 - error: influxdb.1 (2301716) influxdb.1 already running 2024-10-03 04:36:13.280 - warn: influxdb.1 (2301716) Terminated (ADAPTER_ALREADY_RUNNING): Without reason 2024-10-03 04:36:13.859 - error: host.iobroker instance system.adapter.influxdb.1 terminated with code 7 (ADAPTER_ALREADY_RUNNING) 2024-10-03 04:36:13.859 - info: host.iobroker Restart adapter system.adapter.influxdb.1 because enabled 2024-10-03 04:36:16.060 - info: host.iobroker instance system.adapter.influxdb.2 in version "4.0.2" started with pid 2301739 2024-10-03 04:36:17.056 - error: influxdb.2 (2301739) influxdb.2 already running 2024-10-03 04:36:17.059 - warn: influxdb.2 (2301739) Terminated (ADAPTER_ALREADY_RUNNING): Without reason 2024-10-03 04:36:17.641 - error: host.iobroker instance system.adapter.influxdb.2 terminated with code 7 (ADAPTER_ALREADY_RUNNING) 2024-10-03 04:36:17.641 - info: host.iobroker Restart adapter system.adapter.influxdb.2 because enabled 2024-10-03 04:36:20.071 - info: host.iobroker instance system.adapter.javascript.0 in version "8.7.6" started with pid 2301762Gegen 04:40:00 scheint sich wieder alles eingependelt zu haben nurmehr die InfuxDb scheint Probleme zu machen.

2024-10-03 04:40:10.676 - info: influxdb.2 (2301981) Connecting http://192.168.0.106:8086/ ... 2024-10-03 04:40:10.677 - info: influxdb.2 (2301981) Influx DB Version used: 2.x 2024-10-03 04:40:40.680 - error: influxdb.2 (2301981) RequestTimedOutError: Request timed out 2024-10-03 04:40:50.682 - info: influxdb.2 (2301981) Connecting http://192.168.0.106:8086/ ... 2024-10-03 04:40:50.682 - info: influxdb.2 (2301981) Influx DB Version used: 2.xDiese Meldung wiederholt sich bis ca. 11:00 - Laut Proxmox lief dadurch der Ram immer voller bis nichts mehr ging.

Nach Neustart von iobroker und Influx scheint wieder alles in geregelten Bahnen zu laufen.

Woran könnte dieses Ausfall gelegen haben?

Gerne kann ich auch das gesamte Log zur Verfügung stellen, allerdings würde dieser den Beitrag sprengen ^^

Herzlichen DANK für die Unterstützung!

iob Diag:

Static hostname: iobroker Icon name: computer-container Chassis: container Virtualization: lxc Operating System: Ubuntu 21.10 Kernel: Linux 6.8.8-4-pve Architecture: x86-64 OS is similar to: debian model name : Intel(R) Core(TM) i5-4250U CPU @ 1.30GHz Docker : false Virtualization : lxc Kernel : x86_64 Userland : 64 bit Systemuptime and Load: 20:27:01 up 47 min, 1 user, load average: 3.63, 3.29, 2.98 CPU threads: 4 *** Time and Time Zones *** Local time: Thu 2024-10-03 20:27:01 CEST Universal time: Thu 2024-10-03 18:27:01 UTC RTC time: n/a Time zone: Europe/Vienna (CEST, +0200) System clock synchronized: yes NTP service: inactive RTC in local TZ: no *** Users and Groups *** User that called 'iob diag': martin HOME=/home/martin GROUPS=martin sudo iobroker User that is running 'js-controller': iobroker HOME=/home/iobroker GROUPS=iobroker tty dialout audio video plugdev *** Display-Server-Setup *** Display-Server: false Desktop: Terminal: Boot Target: graphical.target *** MEMORY *** total used free shared buff/cache available Mem: 6.1G 3.1G 2.6G 0.0K 451M 3.0G Swap: 4.1G 70M 4.0G Total: 10G 3.2G 6.6G Active iob-Instances: 48 6144 M total memory 3125 M used memory 2851 M active memory 566 M inactive memory 2566 M free memory 0 M buffer memory 451 M swap cache 4096 M total swap 70 M used swap 4025 M free swap *** top - Table Of Processes *** top - 20:27:01 up 47 min, 1 user, load average: 3.63, 3.29, 2.98 Tasks: 83 total, 2 running, 81 sleeping, 0 stopped, 0 zombie %Cpu(s): 61.3 us, 8.1 sy, 0.0 ni, 30.6 id, 0.0 wa, 0.0 hi, 0.0 si, 0.0 st MiB Mem : 6144.0 total, 2565.8 free, 3126.6 used, 451.6 buff/cache MiB Swap: 4096.0 total, 4025.5 free, 70.5 used. 3017.4 avail Mem *** FAILED SERVICES *** UNIT LOAD ACTIVE SUB DESCRIPTION * mnt-nas-media.mount loaded failed failed /mnt/nas/media * run-rpc_pipefs.mount loaded failed failed RPC Pipe File System * systemd-networkd-wait-online.service loaded failed failed Wait for Network to be Configured LOAD = Reflects whether the unit definition was properly loaded. ACTIVE = The high-level unit activation state, i.e. generalization of SUB. SUB = The low-level unit activation state, values depend on unit type. 3 loaded units listed. *** FILESYSTEM *** Filesystem Type Size Used Avail Use% Mounted on /dev/mapper/pve-vm--100--disk--1 ext4 32G 16G 15G 53% / none tmpfs 492K 4.0K 488K 1% /dev efivarfs efivarfs 128K 115K 9.0K 93% /sys/firmware/efi/efivars tmpfs tmpfs 5.8G 0 5.8G 0% /dev/shm tmpfs tmpfs 2.4G 144K 2.4G 1% /run tmpfs tmpfs 5.0M 0 5.0M 0% /run/lock Messages concerning ext4 filesystem in dmesg: dmesg: read kernel buffer failed: Operation not permitted Show mounted filesystems: TARGET SOURCE FSTYPE OPTIONS / /dev/mapper/pve-vm--100--disk--1 ext4 rw,relatime,stripe=16 Files in neuralgic directories: /var: 4.6G /var/ 3.3G /var/log 3.1G /var/log/journal/999f4417959547e5b77accc47a55d4c2 3.1G /var/log/journal 763M /var/lib Hint: You are currently not seeing messages from other users and the system. Users in groups 'adm', 'systemd-journal' can see all messages. Pass -q to turn off this notice. Archived and active journals take up 16.0M in the file system. /opt/iobroker/backups: 2.9G /opt/iobroker/backups/ /opt/iobroker/iobroker-data: 1.4G /opt/iobroker/iobroker-data/ 1.2G /opt/iobroker/iobroker-data/files 441M /opt/iobroker/iobroker-data/files/javascript.admin 409M /opt/iobroker/iobroker-data/files/javascript.admin/static 408M /opt/iobroker/iobroker-data/files/javascript.admin/static/js The five largest files in iobroker-data are: 58M /opt/iobroker/iobroker-data/objects.jsonl 41M /opt/iobroker/iobroker-data/files/material/static/js/main.c5478f66.js.map 38M /opt/iobroker/iobroker-data/files/iot.admin/static/js/main.d3d286bd.js.map 35M /opt/iobroker/iobroker-data/files/devices.admin/static/js/main.24f2bb56.js.map 33M /opt/iobroker/iobroker-data/states.jsonl USB-Devices by-id: USB-Sticks - Avoid direct links to /dev/tty* in your adapter setups, please always prefer the links 'by-id': No Devices found 'by-id' *** NodeJS-Installation *** /usr/bin/nodejs v20.17.0 /usr/bin/node v20.17.0 /usr/bin/npm 10.8.2 /usr/bin/npx 10.8.2 /usr/bin/corepack 0.29.3 nodejs: Installed: 20.17.0-1nodesource1 Candidate: 20.17.0-1nodesource1 Version table: *** 20.17.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 100 /var/lib/dpkg/status 20.16.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.15.1-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.15.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.14.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.13.1-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.13.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.12.2-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.12.1-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.12.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.11.1-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.11.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.10.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.9.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.8.1-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.8.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.7.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.6.1-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.6.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.5.1-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.5.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.4.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.3.1-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.3.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.2.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.1.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 20.0.0-1nodesource1 1001 500 https://deb.nodesource.com/node_20.x nodistro/main amd64 Packages 12.22.5~dfsg-5ubuntu1 500 500 http://old-releases.ubuntu.com/ubuntu impish/universe amd64 Packages Temp directories causing npm8 problem: 0 No problems detected Errors in npm tree: *** ioBroker-Installation *** ioBroker Status iobroker is running on this host. Objects type: jsonl States type: jsonl Core adapters versions js-controller: 6.0.11 admin: 7.1.5 javascript: 8.7.6 nodejs modules from github: 5 +-- iobroker.bosch-ebike@0.1.7 (git+ssh://git@github.com/TA2k/ioBroker.bosch-ebike.git#cc0e6c329dc78be56a76c1b986808c4cb1c3072c) +-- iobroker.mercedesme@0.2.2 (git+ssh://git@github.com/TA2k/ioBroker.mercedesme.git#f2acce66e404a87569e9ccf5f3ab1f4e3369c8f4) +-- iobroker.parcel@0.2.8-beta.0 (git+ssh://git@github.com/TA2k/ioBroker.parcel.git#dcbbc8342dbe034924d354447d5d15e68497db1d) +-- iobroker.sourceanalytix@0.4.15-alpha.1 (git+ssh://git@github.com/iobroker-community-adapters/ioBroker.sourceanalytix.git#deb2bf5210576700734b590215a5f27bb8b72d7d) +-- iobroker.vesync@0.0.7 (git+ssh://git@github.com/TA2k/ioBroker.vesync.git#2e74f4a719302d87238d91031e7dda8ddf3302f0) Adapter State + system.adapter.adguard.0 : adguard : iobroker - enabled + system.adapter.admin.1 : admin : iobroker - enabled, port: 8081, bind: 0.0.0.0, run as: admin system.adapter.alias-manager.0 : alias-manager : iobroker - disabled + system.adapter.asuswrt.0 : asuswrt : iobroker - enabled + system.adapter.backitup.0 : backitup : iobroker - enabled system.adapter.bosch-ebike.0 : bosch-ebike : iobroker - disabled + system.adapter.cloud.0 : cloud : iobroker - enabled system.adapter.daswetter.0 : daswetter : iobroker - enabled system.adapter.devices.0 : devices : iobroker - disabled + system.adapter.discovery.0 : discovery : iobroker - enabled + system.adapter.hass.0 : hass : iobroker - enabled, port: 8123 + system.adapter.hm-rega.0 : hm-rega : iobroker - enabled + system.adapter.hm-rpc.0 : hm-rpc : iobroker - enabled, port: 0 + system.adapter.hm-rpc.1 : hm-rpc : iobroker - enabled, port: 0 system.adapter.ical.0 : ical : iobroker - enabled system.adapter.icons-mfd-svg.0 : icons-mfd-svg : iobroker - disabled + system.adapter.imap.0 : imap : iobroker - enabled + system.adapter.influxdb.1 : influxdb : iobroker - enabled, port: 8086 + system.adapter.influxdb.2 : influxdb : iobroker - enabled, port: 8086 + system.adapter.info.0 : info : iobroker - enabled + system.adapter.iot.0 : iot : iobroker - enabled + system.adapter.javascript.0 : javascript : iobroker - enabled + system.adapter.lightcontrol.0 : lightcontrol : iobroker - enabled + system.adapter.linkeddevices.0 : linkeddevices : iobroker - enabled + system.adapter.linux-control.0 : linux-control : iobroker - enabled + system.adapter.logparser.0 : logparser : iobroker - enabled + system.adapter.mercedesme.0 : mercedesme : iobroker - enabled + system.adapter.mqtt.0 : mqtt : iobroker - enabled, port: 1883, bind: 192.168.0.110 + system.adapter.mqtt.1 : mqtt : iobroker - enabled, port: 1883, bind: 0.0.0.0 + system.adapter.notification-manager.0 : notification-manager : iobroker - enabled + system.adapter.nut.0 : nut : iobroker - enabled system.adapter.parcel.0 : parcel : iobroker - disabled + system.adapter.parser.0 : parser : iobroker - enabled + system.adapter.ping.0 : ping : iobroker - enabled + system.adapter.proxmox.0 : proxmox : iobroker - enabled, port: 8006 + system.adapter.pushover.0 : pushover : iobroker - enabled + system.adapter.pushover.1 : pushover : iobroker - enabled + system.adapter.pushover.2 : pushover : iobroker - enabled + system.adapter.shelly.0 : shelly : iobroker - enabled, port: 1882, bind: 192.168.0.110 + system.adapter.shelly.1 : shelly : iobroker - enabled, port: 1882, bind: 0.0.0.0 + system.adapter.simple-api.0 : simple-api : iobroker - enabled, port: 8087, bind: 0.0.0.0, run as: admin + system.adapter.socketio.0 : socketio : iobroker - enabled, port: 8084, bind: 0.0.0.0, run as: admin + system.adapter.sourceanalytix.0 : sourceanalytix : iobroker - enabled + system.adapter.sprinklecontrol.0 : sprinklecontrol : iobroker - enabled + system.adapter.sql.1 : sql : iobroker - enabled, port: 3306 + system.adapter.trashschedule.0 : trashschedule : iobroker - enabled + system.adapter.vesync.0 : vesync : iobroker - enabled system.adapter.vis-2-widgets-material.0 : vis-2-widgets-material: iobroker - enabled + system.adapter.vis-2.0 : vis-2 : iobroker - enabled system.adapter.vis-icontwo.0 : vis-icontwo : iobroker - disabled + system.adapter.vis-inventwo.0 : vis-inventwo : iobroker - enabled system.adapter.vis-jqui-mfd.0 : vis-jqui-mfd : iobroker - disabled system.adapter.vis-justgage.0 : vis-justgage : iobroker - disabled system.adapter.vis-plumb.0 : vis-plumb : iobroker - disabled system.adapter.vis-rgraph.0 : vis-rgraph : iobroker - disabled system.adapter.vis-timeandweather.0 : vis-timeandweather : iobroker - disabled system.adapter.vis.0 : vis : iobroker - enabled + system.adapter.web.0 : web : iobroker - enabled, port: 80, bind: 0.0.0.0, run as: admin + system.adapter.windows-control.0 : windows-control : iobroker - enabled + system.adapter.wled.0 : wled : iobroker - enabled + system.adapter.yahka.0 : yahka : iobroker - enabled + system.adapter.yahka.1 : yahka : iobroker - enabled + instance is alive Enabled adapters with bindings + system.adapter.admin.1 : admin : iobroker - enabled, port: 8081, bind: 0.0.0.0, run as: admin + system.adapter.hass.0 : hass : iobroker - enabled, port: 8123 + system.adapter.hm-rpc.0 : hm-rpc : iobroker - enabled, port: 0 + system.adapter.hm-rpc.1 : hm-rpc : iobroker - enabled, port: 0 + system.adapter.influxdb.1 : influxdb : iobroker - enabled, port: 8086 + system.adapter.influxdb.2 : influxdb : iobroker - enabled, port: 8086 + system.adapter.mqtt.0 : mqtt : iobroker - enabled, port: 1883, bind: 192.168.0.110 + system.adapter.mqtt.1 : mqtt : iobroker - enabled, port: 1883, bind: 0.0.0.0 + system.adapter.proxmox.0 : proxmox : iobroker - enabled, port: 8006 + system.adapter.shelly.0 : shelly : iobroker - enabled, port: 1882, bind: 192.168.0.110 + system.adapter.shelly.1 : shelly : iobroker - enabled, port: 1882, bind: 0.0.0.0 + system.adapter.simple-api.0 : simple-api : iobroker - enabled, port: 8087, bind: 0.0.0.0, run as: admin + system.adapter.socketio.0 : socketio : iobroker - enabled, port: 8084, bind: 0.0.0.0, run as: admin + system.adapter.sql.1 : sql : iobroker - enabled, port: 3306 + system.adapter.web.0 : web : iobroker - enabled, port: 80, bind: 0.0.0.0, run as: admin ioBroker-Repositories ┌─────────┬─────────────────┬─────────────────────────────────────────────────────────┬──────────────┐ │ (index) │ name │ url │ auto upgrade │ ├─────────┼─────────────────┼─────────────────────────────────────────────────────────┼──────────────┤ │ 0 │ 'stable' │ 'http://download.iobroker.net/sources-dist.json' │ false │ │ 1 │ 'Beta (latest)' │ 'http://download.iobroker.net/sources-dist-latest.json' │ false │ └─────────┴─────────────────┴─────────────────────────────────────────────────────────┴──────────────┘ Active repo(s): stable Upgrade policy: patch Installed ioBroker-Instances Used repository: stable Adapter "adguard" : 0.0.8 , installed 0.0.8 Adapter "admin" : 7.1.5 , installed 7.1.5 Adapter "alias-manager": 1.2.6 , installed 1.2.6 Adapter "asuswrt" : 1.0.1 , installed 1.0.1 Adapter "backitup" : 3.0.22 , installed 3.0.22 Adapter "cloud" : 5.0.1 , installed 5.0.1 Adapter "daswetter" : 3.1.16 , installed 3.1.16 Adapter "devices" : 1.1.5 , installed 1.1.5 Adapter "discovery" : 5.0.0 , installed 5.0.0 Adapter "hass" : 1.4.0 , installed 1.4.0 Adapter "hm-rega" : 5.0.0 , installed 5.0.0 Adapter "hm-rpc" : 2.0.2 , installed 1.17.0 [Updatable] Adapter "ical" : 1.15.0 , installed 1.15.0 Adapter "icons-mfd-svg": 1.2.0 , installed 1.2.0 Adapter "imap" : 0.2.0 , installed 0.2.0 Adapter "influxdb" : 4.0.2 , installed 4.0.2 Adapter "iot" : 3.3.0 , installed 3.3.0 Adapter "javascript" : 8.7.6 , installed 8.7.6 Controller "js-controller": 6.0.11 , installed 6.0.11 Adapter "lightcontrol" : 0.8.0 , installed 0.8.0 Adapter "linkeddevices": 1.5.5 , installed 1.5.5 Adapter "linux-control": 1.1.5 , installed 1.1.5 Adapter "logparser" : 2.2.2 , installed 2.2.2 Adapter "mqtt" : 5.2.0 , installed 5.2.0 Adapter "notification-manager": 1.1.2, installed 1.1.2 Adapter "nut" : 1.6.0 , installed 1.6.0 Adapter "parser" : 2.2.4 , installed 2.2.2 [Updatable] Adapter "ping" : 1.6.2 , installed 1.6.2 Adapter "proxmox" : 2.3.0 , installed 2.3.0 Adapter "pushover" : 4.1.0 , installed 4.1.0 Adapter "shelly" : 7.0.0 , installed 7.0.0 Adapter "simple-api" : 2.8.0 , installed 2.8.0 Adapter "socketio" : 6.7.1 , installed 6.7.1 Adapter "sprinklecontrol": 0.2.13 , installed 0.2.13 Adapter "sql" : 3.0.1 , installed 3.0.1 Adapter "trashschedule": 3.3.0 , installed 3.3.0 Adapter "vis" : 1.5.6 , installed 1.5.6 Adapter "vis-2" : 2.9.32 , installed 2.9.32 Adapter "vis-2-widgets-material": 1.4.10, installed 1.4.8 [Updatable] Adapter "vis-icontwo" : 1.5.0 , installed 1.5.0 Adapter "vis-inventwo" : 3.3.4 , installed 3.3.4 Adapter "vis-jqui-mfd" : 1.1.1 , installed 1.1.1 Adapter "vis-justgage" : 2.1.7 , installed 2.1.7 Adapter "vis-plumb" : 1.0.2 , installed 1.0.2 Adapter "vis-rgraph" : 0.0.2 , installed 0.0.2 Adapter "vis-timeandweather": 1.2.2, installed 1.2.2 Adapter "web" : 6.2.5 , installed 6.2.5 Adapter "windows-control": 0.1.5 , installed 0.1.5 Adapter "wled" : 0.7.2 , installed 0.7.2 Adapter "yahka" : 1.0.3 , installed 1.0.3 Objects and States Please stand by - This may take a while Objects: 28834 States: 25753 *** OS-Repositories and Updates *** Hit:1 http://old-releases.ubuntu.com/ubuntu impish InRelease Hit:2 http://old-releases.ubuntu.com/ubuntu impish-updates InRelease Hit:3 http://old-releases.ubuntu.com/ubuntu impish-security InRelease Hit:4 https://deb.nodesource.com/node_20.x nodistro InRelease Reading package lists... Pending Updates: 0 *** Listening Ports *** Active Internet connections (only servers) Proto Recv-Q Send-Q Local Address Foreign Address State User Inode PID/Program name tcp 0 0 127.0.0.53:53 0.0.0.0:* LISTEN 106 10952 97/systemd-resolved tcp 0 0 127.0.0.1:35725 0.0.0.0:* LISTEN 1000 74963 2863/io.yahka.0 tcp 0 0 192.168.0.110:9001 0.0.0.0:* LISTEN 1000 35266 687/iobroker.js-con tcp 0 0 192.168.0.110:9000 0.0.0.0:* LISTEN 1000 33484 687/iobroker.js-con tcp 0 0 127.0.0.1:35681 0.0.0.0:* LISTEN 1000 74967 2863/io.yahka.0 tcp 0 0 0.0.0.0:35289 0.0.0.0:* LISTEN 1000 74150 2863/io.yahka.0 tcp 0 0 127.0.0.1:44279 0.0.0.0:* LISTEN 1000 75005 2883/io.yahka.1 tcp 0 0 0.0.0.0:3306 0.0.0.0:* LISTEN 113 11514 169/mariadbd tcp 0 0 192.168.0.110:9292 0.0.0.0:* LISTEN 1000 55598 1566/io.hm-rpc.1 tcp 0 0 0.0.0.0:33309 0.0.0.0:* LISTEN 1000 74158 2863/io.yahka.0 tcp 0 0 0.0.0.0:8554 0.0.0.0:* LISTEN 0 34383 688/neolink tcp 0 0 0.0.0.0:111 0.0.0.0:* LISTEN 0 10761 1/init tcp 0 0 127.0.0.1:25 0.0.0.0:* LISTEN 0 20873 412/master tcp 0 0 0.0.0.0:1883 0.0.0.0:* LISTEN 112 12578 115/mosquitto tcp 0 0 0.0.0.0:1882 0.0.0.0:* LISTEN 1000 57658 1862/io.shelly.1 tcp 0 0 0.0.0.0:2010 0.0.0.0:* LISTEN 1000 53374 1482/io.hm-rpc.0 tcp 0 0 127.0.0.1:34023 0.0.0.0:* LISTEN 1000 74959 2863/io.yahka.0 tcp 0 0 0.0.0.0:33965 0.0.0.0:* LISTEN 1000 73192 2883/io.yahka.1 tcp6 0 0 :::8081 :::* LISTEN 1000 45958 952/io.admin.1 tcp6 0 0 :::8084 :::* LISTEN 1000 65385 2390/io.socketio.0 tcp6 0 0 :::8087 :::* LISTEN 1000 66000 2316/io.simple-api. tcp6 0 0 ::1:25 :::* LISTEN 0 20874 412/master tcp6 0 0 :::33533 :::* LISTEN 1000 74147 2863/io.yahka.0 tcp6 0 0 :::111 :::* LISTEN 0 10763 1/init tcp6 0 0 :::80 :::* LISTEN 1000 75172 2839/io.web.0 tcp6 0 0 :::22 :::* LISTEN 0 11424 1/init tcp6 0 0 :::1883 :::* LISTEN 112 12579 115/mosquitto udp 0 0 0.0.0.0:47490 0.0.0.0:* 1000 47997 1194/io.pushover.2 udp 0 0 0.0.0.0:47673 0.0.0.0:* 1000 54943 1686/io.ping.0 udp 0 0 0.0.0.0:47831 0.0.0.0:* 1000 48076 1219/io.sql.1 udp 0 0 0.0.0.0:56179 0.0.0.0:* 1000 70112 2652/io.sprinklecon udp 0 0 0.0.0.0:48011 0.0.0.0:* 1000 66128 2390/io.socketio.0 udp 0 0 0.0.0.0:56384 0.0.0.0:* 1000 49090 1105/io.pushover.0 udp 0 0 0.0.0.0:40060 0.0.0.0:* 1000 49127 1170/io.pushover.1 udp 0 0 0.0.0.0:40251 0.0.0.0:* 1000 65999 2316/io.simple-api. udp 0 0 0.0.0.0:40503 0.0.0.0:* 1000 33480 687/iobroker.js-con udp 0 0 0.0.0.0:57122 0.0.0.0:* 1000 65899 2114/io.discovery.0 udp 0 0 0.0.0.0:40788 0.0.0.0:* 1000 76714 2873/io.wled.0 udp 0 0 127.0.0.53:53 0.0.0.0:* 106 10951 97/systemd-resolved udp 0 0 0.0.0.0:111 0.0.0.0:* 0 10762 1/init udp 0 0 0.0.0.0:57525 0.0.0.0:* 1000 66886 2258/io.logparser.0 udp 0 0 0.0.0.0:33067 0.0.0.0:* 1000 56846 1638/io.mqtt.1 udp 0 0 0.0.0.0:33201 0.0.0.0:* 1000 56951 1700/io.proxmox.0 udp 0 0 0.0.0.0:58007 0.0.0.0:* 1000 65926 2204/io.linkeddevic udp 0 0 0.0.0.0:58467 0.0.0.0:* 1000 60542 1935/io.adguard.0 udp 0 0 0.0.0.0:50308 0.0.0.0:* 1000 71951 2946/io.vis-2.0 udp 0 0 0.0.0.0:58530 0.0.0.0:* 1000 65967 2241/io.linux-contr udp 0 0 0.0.0.0:50431 0.0.0.0:* 1000 58082 2306/io.mercedesme. udp 0 0 0.0.0.0:50460 0.0.0.0:* 1000 60920 2001/io.asuswrt.0 udp 0 0 0.0.0.0:58787 0.0.0.0:* 1000 56771 1566/io.hm-rpc.1 udp 0 0 0.0.0.0:50966 0.0.0.0:* 1000 51864 1482/io.hm-rpc.0 udp 0 0 0.0.0.0:50991 0.0.0.0:* 1000 59497 1821/io.shelly.0 udp 0 0 0.0.0.0:43132 0.0.0.0:* 1000 75503 3004/io.vesync.0 udp 0 0 0.0.0.0:59682 0.0.0.0:* 1000 73414 2961/io.parser.0 udp 0 0 0.0.0.0:51666 0.0.0.0:* 1000 72911 2775/io.vis-inventw udp 0 0 0.0.0.0:35422 0.0.0.0:* 1000 51860 1364/io.cloud.0 udp 0 0 0.0.0.0:51834 0.0.0.0:* 1000 51202 1278/io.backitup.0 udp 0 0 0.0.0.0:43960 0.0.0.0:* 1000 51939 1466/io.hm-rega.0 udp 0 0 0.0.0.0:52155 0.0.0.0:* 1000 64999 2150/io.imap.0 udp 0 0 0.0.0.0:52289 0.0.0.0:* 1000 47357 989/io.influxdb.1 udp 0 0 0.0.0.0:44241 0.0.0.0:* 1000 58215 2178/io.info.0 udp 0 0 0.0.0.0:36264 0.0.0.0:* 1000 76039 3055/io.iot.0 udp 0 0 0.0.0.0:52694 0.0.0.0:* 1000 45769 1077/io.javascript. udp 0 0 0.0.0.0:60901 0.0.0.0:* 1000 74401 2851/io.windows-con udp 0 0 0.0.0.0:36540 0.0.0.0:* 115 12521 99/avahi-daemon: ru udp 0 0 0.0.0.0:53204 0.0.0.0:* 1000 56842 1624/io.mqtt.0 udp 0 0 0.0.0.0:45244 0.0.0.0:* 1000 74495 2839/io.web.0 udp 0 0 0.0.0.0:37415 0.0.0.0:* 1000 74916 2883/io.yahka.1 udp 0 0 0.0.0.0:53996 0.0.0.0:* 0 319826 688/neolink udp 0 0 0.0.0.0:37630 0.0.0.0:* 1000 65005 2129/io.sourceanaly udp 0 0 0.0.0.0:37969 0.0.0.0:* 1000 59773 1887/io.notificatio udp 0 0 0.0.0.0:37988 0.0.0.0:* 1000 54838 1650/io.nut.0 udp 0 0 0.0.0.0:38073 0.0.0.0:* 1000 45766 952/io.admin.1 udp 0 0 0.0.0.0:5353 0.0.0.0:* 1000 73195 2883/io.yahka.1 udp 0 0 0.0.0.0:5353 0.0.0.0:* 1000 73194 2883/io.yahka.1 udp 0 0 0.0.0.0:5353 0.0.0.0:* 1000 69377 2873/io.wled.0 udp 0 0 0.0.0.0:5353 0.0.0.0:* 115 12519 99/avahi-daemon: ru udp 0 0 0.0.0.0:38445 0.0.0.0:* 1000 74111 2863/io.yahka.0 udp 0 0 0.0.0.0:5683 0.0.0.0:* 1000 60715 1821/io.shelly.0 udp 0 0 0.0.0.0:46850 0.0.0.0:* 1000 48680 1029/io.influxdb.2 udp 0 0 0.0.0.0:55359 0.0.0.0:* 1000 452735 - udp 0 0 0.0.0.0:47238 0.0.0.0:* 1000 57604 1862/io.shelly.1 udp6 0 0 :::111 :::* 0 10764 1/init udp6 0 0 :::57720 :::* 115 12522 99/avahi-daemon: ru udp6 0 0 :::5353 :::* 115 12520 99/avahi-daemon: ru *** Log File - Last 25 Lines *** 2024-10-03 19:48:19.883 - info: daswetter.0 (1607) still wrong data structure from server received! repaired... 2024-10-03 19:48:20.889 - info: sourceanalytix.0 (2129) Initialization of shelly.0.SHPLG-S#ED6596#1.Relay0.Energy successfully 2024-10-03 19:48:20.897 - info: sourceanalytix.0 (2129) Successfully activated SourceAnalytix for all 17 of 17 states, will do my Job until you stop me! 2024-10-03 19:48:20.900 - error: daswetter.0 (1607) force terminate 2024-10-03 19:48:20.901 - warn: daswetter.0 (1607) Terminated (UNKNOWN_ERROR): Without reason 2024-10-03 19:48:21.404 - warn: daswetter.0 (1607) get state error: Connection is closed. 2024-10-03 19:48:21.408 - error: daswetter.0 (1607) exception in await insertIntoList [Error: DB closed] 2024-10-03 19:48:21.410 - error: daswetter.0 (1607) Cannot check object existence of "daswetter.0.NextHours2.Location_1.Day_1.Hour_7.uv_index": Connection is closed. 2024-10-03 19:48:21.412 - error: daswetter.0 (1607) exception in await insertIntoList [Error: Could not check object existence of daswetter.0.NextHours2.Location_1.Day_1.Hour_7.uv_index: Cannot check object existence of "daswetter.0.NextHours2.Location_1.Day_1.Hour_7.uv_index": Connection is closed.] 2024-10-03 19:48:21.413 - error: daswetter.0 (1607) Cannot check object existence of "daswetter.0.NextHours2.Location_1.Day_1.Hour_7.windchill": Connection is closed. 2024-10-03 19:48:21.536 - error: host.iobroker instance system.adapter.daswetter.0 terminated with code 15 (UNKNOWN_ERROR) 2024-10-03 19:49:15.116 - info: web.0 (2839) ==> Connected system.user.admin from ::ffff:192.168.0.156 2024-10-03 19:49:16.105 - info: web.0 (2839) <== Disconnect system.user.admin from ::ffff:192.168.0.156 vis.0 2024-10-03 19:49:17.232 - info: web.0 (2839) ==> Connected system.user.admin from ::ffff:192.168.0.156 2024-10-03 19:54:25.031 - info: influxdb.1 (989) Store 98 buffered influxDB history points 2024-10-03 19:54:33.269 - info: influxdb.2 (1029) Store 25144 buffered influxDB history points 2024-10-03 19:54:33.269 - info: influxdb.2 (1029) Too many data points (25144) to write at once; write per ID 2024-10-03 20:00:00.035 - info: javascript.0 (1077) script.js.common.Sicherheit.Leckortung: 445312 2024-10-03 20:00:00.035 - info: javascript.0 (1077) script.js.common.Sicherheit.Leckortung: 0 2024-10-03 20:01:02.378 - debug: javascript.0 (1077) script.js.common.Heizung.Boilersteuerung: 1 2024-10-03 20:07:38.191 - info: hm-rpc.0 (1482) State value to set for "hm-rpc.0.000A1D8991DA1B.1.LEVEL" has to be type "number" but received type "string" 2024-10-03 20:15:08.427 - info: hm-rpc.0 (1482) State value to set for "hm-rpc.0.000A1D8991DA1B.1.LEVEL" has to be type "number" but received type "string" 2024-10-03 20:22:05.813 - info: web.0 (2839) ==> Connected system.user.admin from ::ffff:192.168.0.156 2024-10-03 20:24:15.074 - info: admin.1 (952) ==> Connected system.user.admin from ::ffff:192.168.0.156 2024-10-03 20:24:20.371 - info: admin.1 (952) <== Disconnect system.user.admin from ::ffff:192.168.0.156 javascript@bloop said in Nächtlicher Systemabsturz:

2024-10-03 19:54:33.269 - info: influxdb.2 (1029) Store 25144 buffered influxDB history points

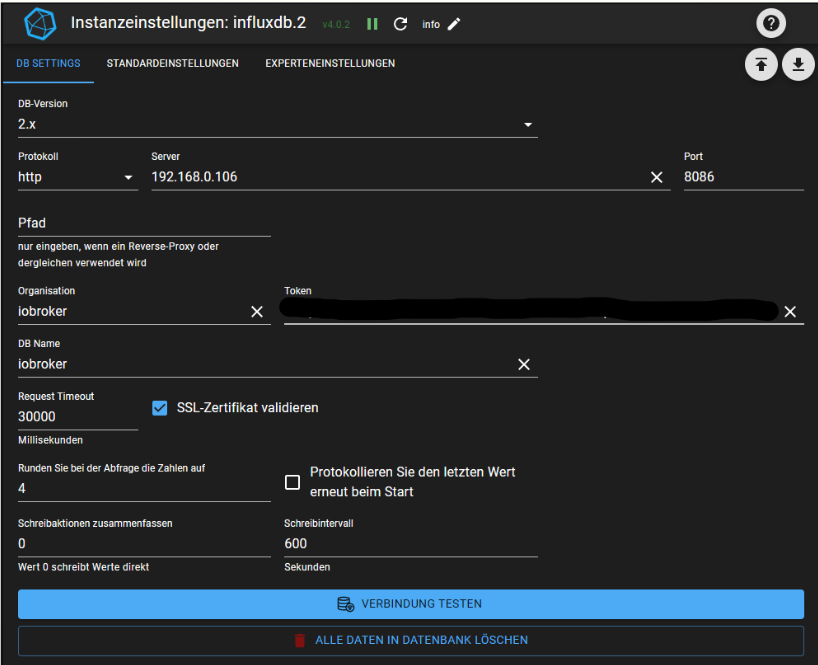

2024-10-03 19:54:33.269 - info: influxdb.2 (1029) Too many data points (25144) to write at once; write per IDWarum hast Du denn da überhaupt 2 Instanzen laufen und bei der 2.ten sammelst Du so viele

Daten im Ram, dass der Adapter die nicht mehr auf einmal schreiben kann.

Mach doch mal ein kleineres Schreibintervall.

Zeig mal Deine DB Settings von der Instanz und wozu noch mariadb?Wenn da Nachts noch backitup dazukommt, wird es schwarz am Bildschirm.

-

@bloop said in Nächtlicher Systemabsturz:

2024-10-03 19:54:33.269 - info: influxdb.2 (1029) Store 25144 buffered influxDB history points

2024-10-03 19:54:33.269 - info: influxdb.2 (1029) Too many data points (25144) to write at once; write per IDWarum hast Du denn da überhaupt 2 Instanzen laufen und bei der 2.ten sammelst Du so viele

Daten im Ram, dass der Adapter die nicht mehr auf einmal schreiben kann.

Mach doch mal ein kleineres Schreibintervall.

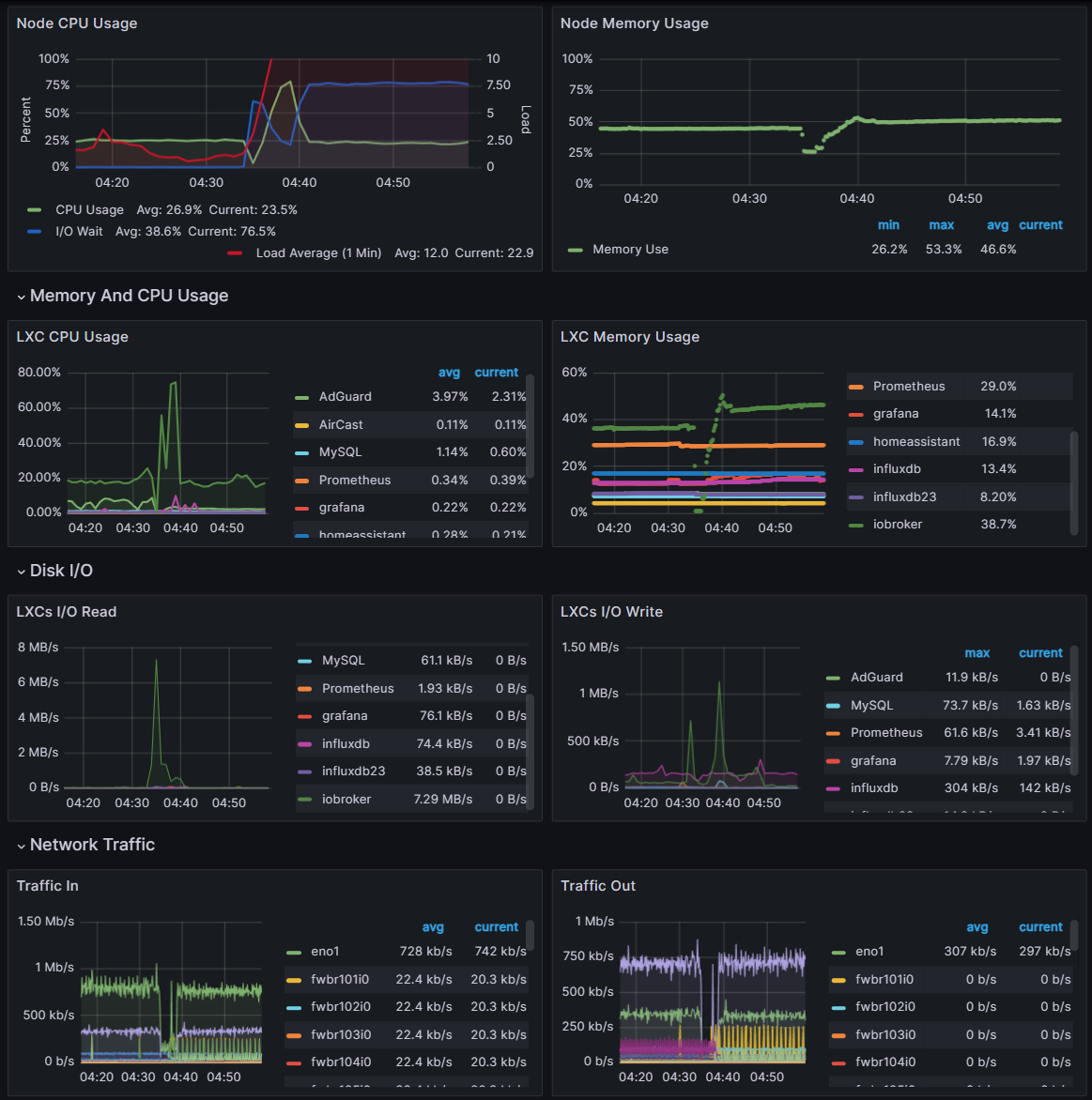

Zeig mal Deine DB Settings von der Instanz und wozu noch mariadb?Wenn da Nachts noch backitup dazukommt, wird es schwarz am Bildschirm.

@rscsb

Warum hast Du denn da überhaupt 2 Instanzen laufen und bei der 2.ten sammelst Du so viele

Daten im Ram, dass der Adapter die nicht mehr auf einmal schreiben kann.Mein System musste mit der Zeit immer mehr erweitert werden. Anfangs nur mit MariaDB mit dem Umstieg auf Grafana dann die InfluxDB 1.8 (influxdb.1). Nachdem ich damit aber keine monatliche bzw. jährlichen Summierungen in Grafana machen konnte, bin ich dann auf InfluxDb 2 (influxdb.2) umgestiegen.

MariaDB läuft noch wegen 3-5 Datenpunkten. Weils für mich einfacher war vergangene Werte im Skripts abzurufen.

Auf InfluxDB 1.8 nimmt das aufzeichnen stetig ab und ich steige auf die 2er Version um. Ich möchte aber weiterhin auf viele in 1.8 abgelegte Daten über Grafana zugreifen.Mach doch mal ein kleineres Schreibintervall.

Der Schreibintervall ist auf Standard 600sek

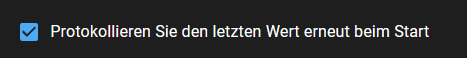

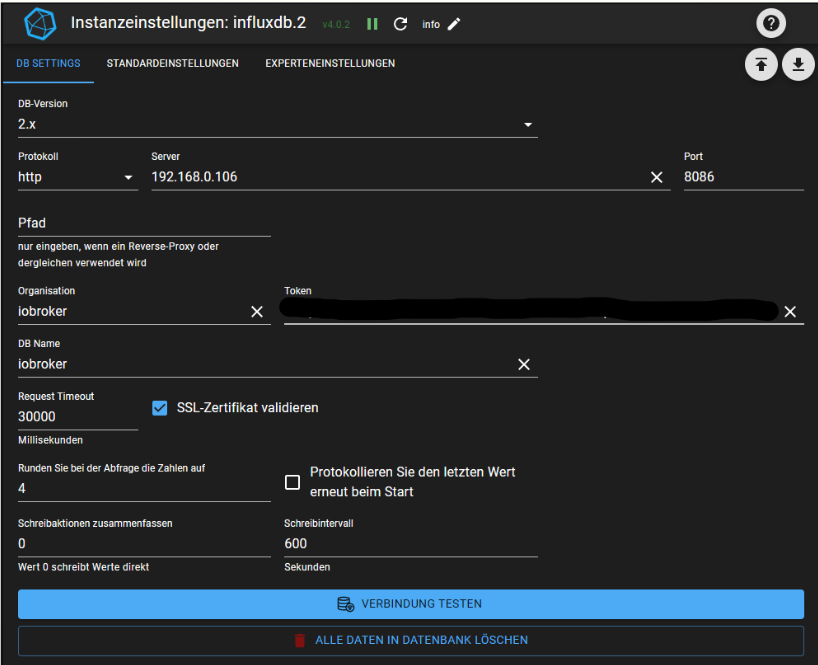

Beim Öffnen der Einstellungen ist mir aufgefallen das es an dieser Einstellung liegen könnte:

Wenn ich das richtig verstehe, schreibt er den letzten Wert. Ich glaube er schreibt dann nicht nur diese Werte, sondern alle vorherigen welche nicht in der Datenbank abgelegt werden konnten. Diese bleiben im Ram hängen. Nach dem Neustart, erst am Abend, ergab dies die unglaubliche Zahl von 25144 Datenpunkten welche nicht in die Datenbank geschrieben werden konnten.

Ich habe den Hacken jetzt raus genommen und hoffe es kommt nicht erneut vor.Wenn da Nachts noch backitup dazukommt, wird es schwarz am Bildschirm.

Das Backup findet um 1:30 statt. Zwischen beginn der Ram Auslastung und dem Backup lagen 3std

Bis 4:30 früh sieht alles völlig normal aus.

-

@rscsb

Warum hast Du denn da überhaupt 2 Instanzen laufen und bei der 2.ten sammelst Du so viele

Daten im Ram, dass der Adapter die nicht mehr auf einmal schreiben kann.Mein System musste mit der Zeit immer mehr erweitert werden. Anfangs nur mit MariaDB mit dem Umstieg auf Grafana dann die InfluxDB 1.8 (influxdb.1). Nachdem ich damit aber keine monatliche bzw. jährlichen Summierungen in Grafana machen konnte, bin ich dann auf InfluxDb 2 (influxdb.2) umgestiegen.

MariaDB läuft noch wegen 3-5 Datenpunkten. Weils für mich einfacher war vergangene Werte im Skripts abzurufen.

Auf InfluxDB 1.8 nimmt das aufzeichnen stetig ab und ich steige auf die 2er Version um. Ich möchte aber weiterhin auf viele in 1.8 abgelegte Daten über Grafana zugreifen.Mach doch mal ein kleineres Schreibintervall.

Der Schreibintervall ist auf Standard 600sek

Beim Öffnen der Einstellungen ist mir aufgefallen das es an dieser Einstellung liegen könnte:

Wenn ich das richtig verstehe, schreibt er den letzten Wert. Ich glaube er schreibt dann nicht nur diese Werte, sondern alle vorherigen welche nicht in der Datenbank abgelegt werden konnten. Diese bleiben im Ram hängen. Nach dem Neustart, erst am Abend, ergab dies die unglaubliche Zahl von 25144 Datenpunkten welche nicht in die Datenbank geschrieben werden konnten.

Ich habe den Hacken jetzt raus genommen und hoffe es kommt nicht erneut vor.Wenn da Nachts noch backitup dazukommt, wird es schwarz am Bildschirm.

Das Backup findet um 1:30 statt. Zwischen beginn der Ram Auslastung und dem Backup lagen 3std

Bis 4:30 früh sieht alles völlig normal aus.

Schluck...Beim Beschreiben Deiner Umgebung merkst Du bestimmt auch was Du da alles "aufgebaut" hast.

Eine Migration von Influxdb wäre wahrscheinlich sinnvoller gewesen.

Was auf Deinen Containern passiert, weißt wohl nur Du.Dass dieser deaktivierte Hacken an dem Problem etwas verändert bezweifle ich.

Ich habe den aktiviert, weil es wohl "Standard" ist.

Was hast Du bei "Schreibaktionen zusammenfassen" drin.

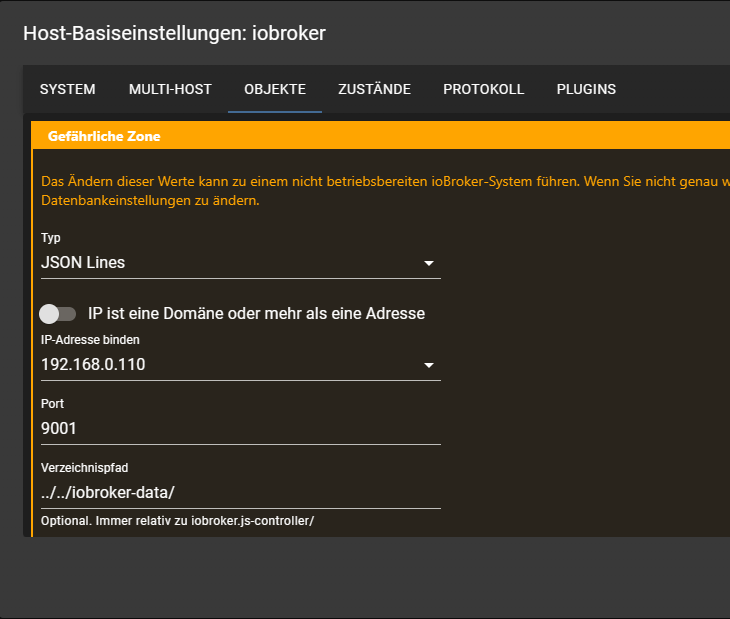

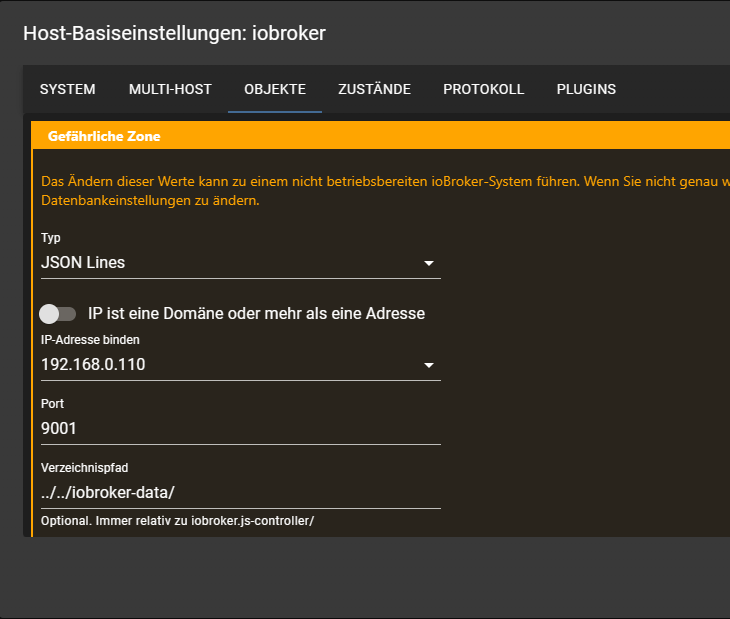

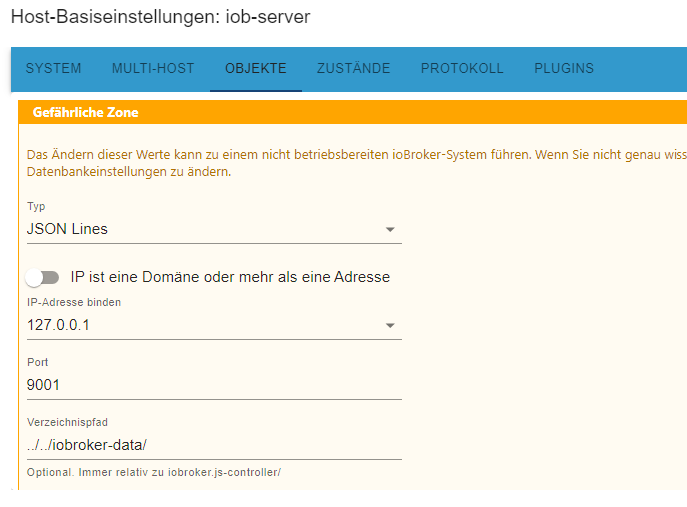

(Mit Screenshot müsste man nicht jeden Parameter abfragen)Was ich seltsam an Deiner Installation finde, ist, dass Du die Verbindung zu Deinen States/Objects mit Deiner IP-Adresse (192.168.0.110) konfiguriert hast.

Normal wäre doch meiner Meinung 127.0.0.1 bzw. 0.0.0.0.

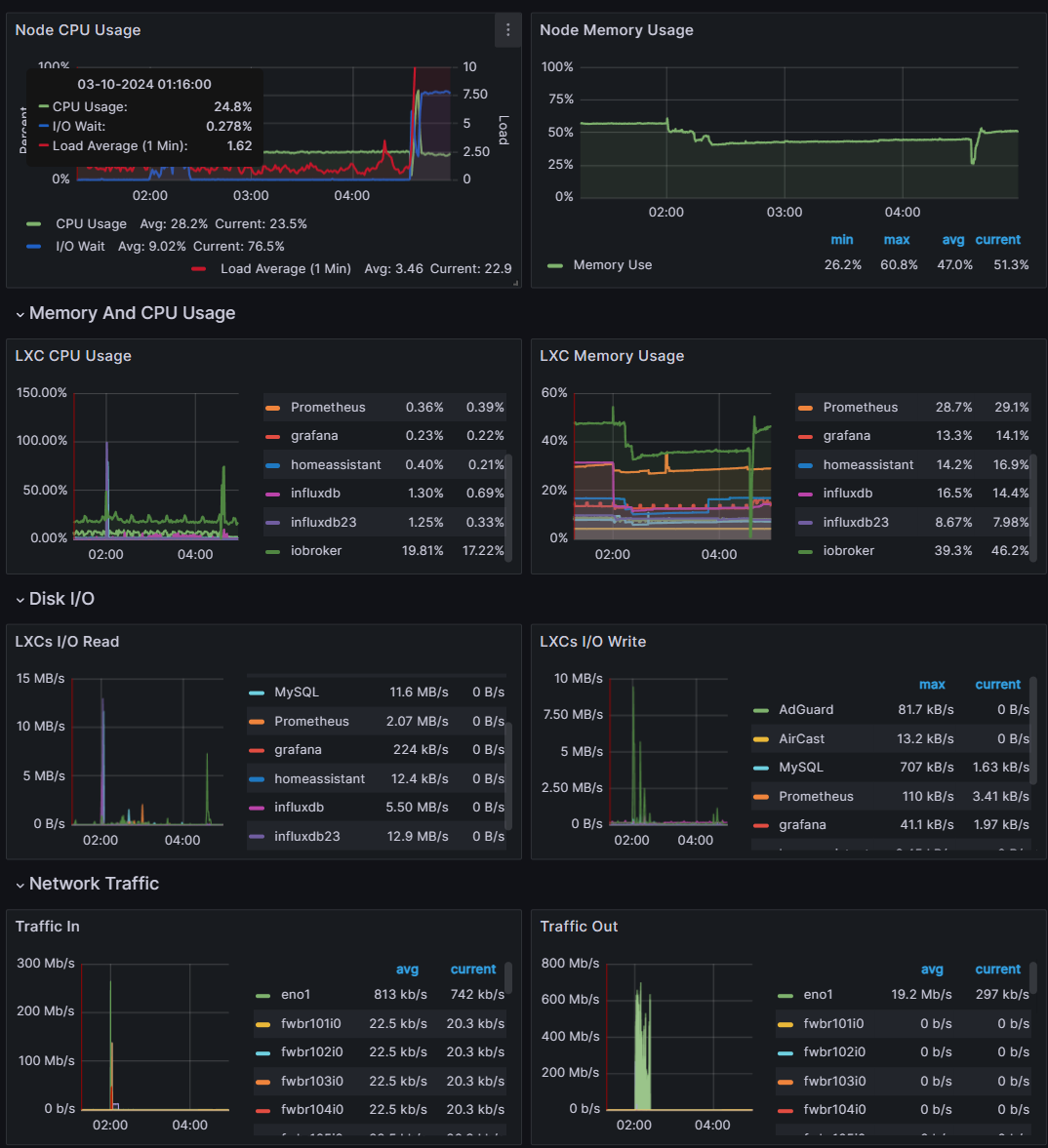

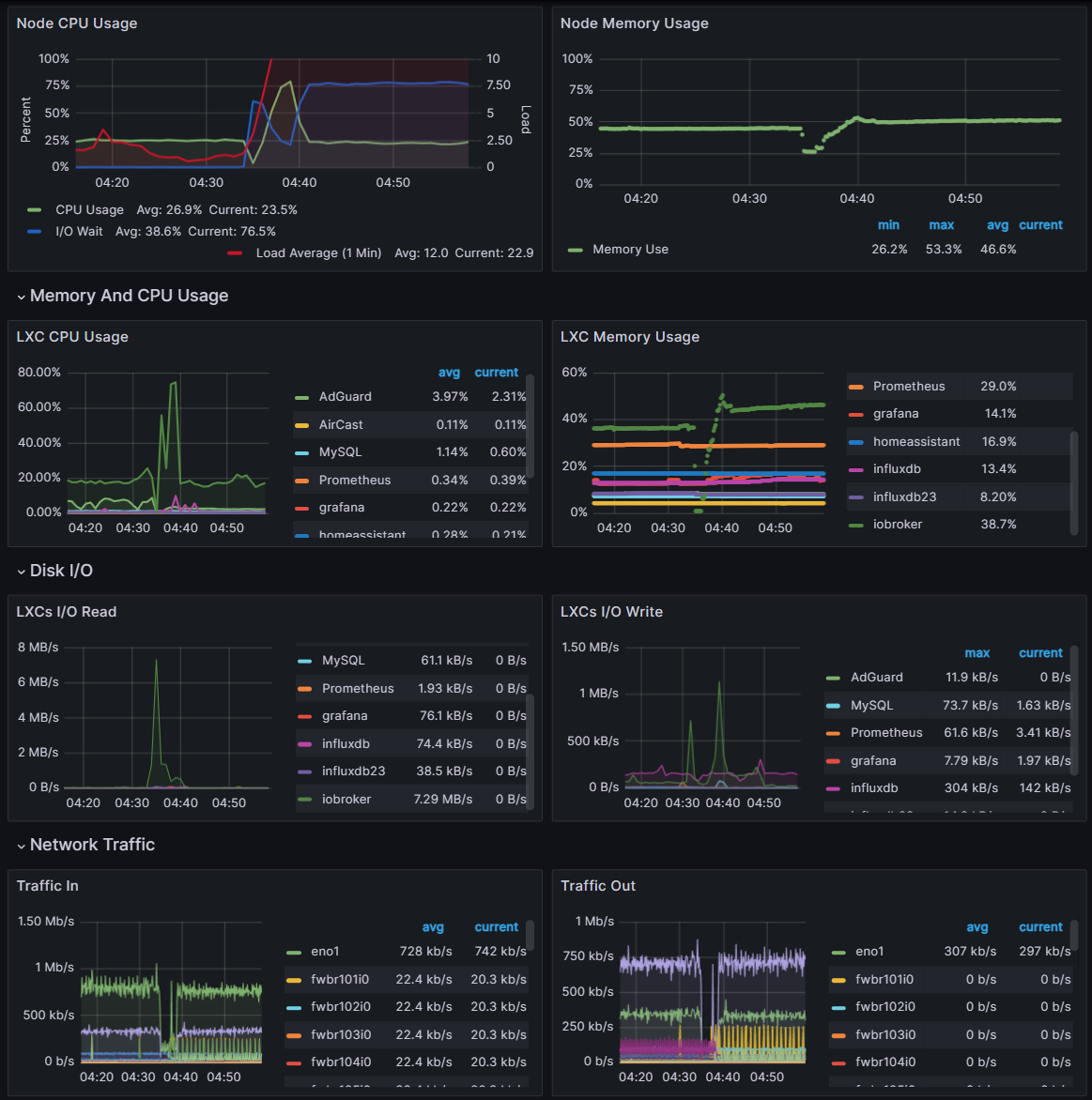

Um 04:34 Uhr bricht die Hölle los in IO/CPU und der Traffic fällt ab,

soweit, dass ioBroker sogar die Verbindung zur eigenen DB verliert.

Was zuerst in welcher Reihenfolge eintritt, musst Du Dir morgen früh mal anschauen. -

Schluck...Beim Beschreiben Deiner Umgebung merkst Du bestimmt auch was Du da alles "aufgebaut" hast.

Eine Migration von Influxdb wäre wahrscheinlich sinnvoller gewesen.

Was auf Deinen Containern passiert, weißt wohl nur Du.Dass dieser deaktivierte Hacken an dem Problem etwas verändert bezweifle ich.

Ich habe den aktiviert, weil es wohl "Standard" ist.

Was hast Du bei "Schreibaktionen zusammenfassen" drin.

(Mit Screenshot müsste man nicht jeden Parameter abfragen)Was ich seltsam an Deiner Installation finde, ist, dass Du die Verbindung zu Deinen States/Objects mit Deiner IP-Adresse (192.168.0.110) konfiguriert hast.

Normal wäre doch meiner Meinung 127.0.0.1 bzw. 0.0.0.0.

Um 04:34 Uhr bricht die Hölle los in IO/CPU und der Traffic fällt ab,

soweit, dass ioBroker sogar die Verbindung zur eigenen DB verliert.

Was zuerst in welcher Reihenfolge eintritt, musst Du Dir morgen früh mal anschauen.@rscsb

Danke für deine Unterstüttzung!

Eine Migration wäre im Nachhinein sicher besser gewesen. Anfangs kam dies jedoch nicht in Frage, da ich mir mir Flux echt schwer getan habe. Zudem wären über 20 Diagramme zu überarbeiten gewesen.

So nehm ich mir immer wieder einmal ein Diagramm vor und überarbeite alles.

Heute würde ich das auch nicht mehr so machen ^^Dass dieser deaktivierte Hacken an dem Problem etwas verändert bezweifle ich.

Ich habe den aktiviert, weil es wohl "Standard" ist.

Was hast Du bei "Schreibaktionen zusammenfassen" drin.

(Mit Screenshot müsste man nicht jeden Parameter abfragen)

Ebenfalls Standard Einstellung.

Was ich seltsam an Deiner Installation finde, ist, dass Du die Verbindung zu Deinen States/Objects mit Deiner IP-Adresse (192.168.0.110) konfiguriert hast.

Normal wäre doch meiner Meinung 127.0.0.1 bzw. 0.0.0.0.Auch in den Host Einstellungen habe ich nie etwas verändert.

Wie ist diese bei dir eingestellt?

These: Wenn der IoBroker die Datenbank auf der IPAdresse 192.168.0.110 "sucht". Es aber zu einem Problem beim Router kam, ließe sich mein Phänomen eventuell erklären?

Wäre durch umstellen auf 127.0.0.1 dies dann behoben? -

@rscsb

Danke für deine Unterstüttzung!

Eine Migration wäre im Nachhinein sicher besser gewesen. Anfangs kam dies jedoch nicht in Frage, da ich mir mir Flux echt schwer getan habe. Zudem wären über 20 Diagramme zu überarbeiten gewesen.

So nehm ich mir immer wieder einmal ein Diagramm vor und überarbeite alles.

Heute würde ich das auch nicht mehr so machen ^^Dass dieser deaktivierte Hacken an dem Problem etwas verändert bezweifle ich.

Ich habe den aktiviert, weil es wohl "Standard" ist.

Was hast Du bei "Schreibaktionen zusammenfassen" drin.

(Mit Screenshot müsste man nicht jeden Parameter abfragen)

Ebenfalls Standard Einstellung.

Was ich seltsam an Deiner Installation finde, ist, dass Du die Verbindung zu Deinen States/Objects mit Deiner IP-Adresse (192.168.0.110) konfiguriert hast.

Normal wäre doch meiner Meinung 127.0.0.1 bzw. 0.0.0.0.Auch in den Host Einstellungen habe ich nie etwas verändert.

Wie ist diese bei dir eingestellt?

These: Wenn der IoBroker die Datenbank auf der IPAdresse 192.168.0.110 "sucht". Es aber zu einem Problem beim Router kam, ließe sich mein Phänomen eventuell erklären?

Wäre durch umstellen auf 127.0.0.1 dies dann behoben?@bloop said in Nächtlicher Systemabsturz:

Zudem wären über 20 Diagramme zu überarbeiten gewesen.

Hmm, wie einige habe ich auch von influxdb_v1 auf influxdb_v2 migriert, habe aber kein einziges Diagramm angepasst. (Dies aber nur am Rande)

Deine DB Settings sehen "normal" aus.

Bei den ioBroker Settings benutzt er bei mir die Loopbackadresse und nicht das Netzwerkinterface:

Ich denke, dass, wie schon von Marc Berg geschrieben, in Deinem InfluxDB_V2 Container etwas krankt. Der ioBroker bekommt die Zahlen nicht abgeliefert und läuft aus dem RAM.

"Irgendwann" spukt etwas auf Dein Netzwerkinterface, worauf der ioBroker seine Verbindung zu der internen JSON-DB verliert. So könnte ich mir die Kettenreaktion denken...An diesen zwei Stellen würde ich mal nachforschen.

-

@marc-berg

Herzlichen Dank!

Einen ähnlichen Gedanken hatte ich auch schon.

Die LXC mit der InfluxDB hat sich aber erst nach 05:00 gefüllt.

Bereits vorher hat der ioBroker die Instanzen neu gestartet.

Hier muss etwas mit der Verbindung nicht gepasst haben. Was schlussendlich zum Systemabsturz führte.Ich habe nun die influxdb Instanz auf Logstufe Debug gestellt, eventuell lässt sich etwas finden.

@bloop sagte in Nächtlicher Systemabsturz:

Die LXC mit der InfluxDB hat sich aber erst nach 05:00 gefüllt.

Gibt's auch eine Kurve für die Festplattennutzung?

-

@bloop sagte in Nächtlicher Systemabsturz:

Die LXC mit der InfluxDB hat sich aber erst nach 05:00 gefüllt.

Gibt's auch eine Kurve für die Festplattennutzung?

@marc-berg sagte in Nächtlicher Systemabsturz:

@bloop sagte in Nächtlicher Systemabsturz:

Die LXC mit der InfluxDB hat sich aber erst nach 05:00 gefüllt.

Gibt's auch eine Kurve für die Festplattennutzung?

Nichts wirklich brauchbares.

Die Belastung scheint völlig normal zu sein.

Ab 5:34 bricht jedoch die Aufzeichnung bis zum Neustart ab. Die angezeigten Daten kommen nicht aus iobroker sondern direkt aus Proxmox.