NEWS

InfluxDB 2.0 Measurement löschen

-

noch eine Frage.

Ich habe in Grafana einen Datenpunkt (2022-11-26 12:46:30) was sicher ein Messfehler ist und der mir die Grafik vermakelt.Ich hatte jetzt folgenden Syntax:

sudo influx delete --token xxxxxxxxxxxxxxxxxxxx --org home --bucket iobroker --start 2022-11-26T12:46:10.000Z --stop 2022-11-26T12:46:50.000Z --predicate '_measurement="Heizung-Kesseltemperatur"'

Es kam kein Fehler aber der Datenpunkt in Grafana ist noch da.

Hast du eine Idee?

-

noch eine Frage.

Ich habe in Grafana einen Datenpunkt (2022-11-26 12:46:30) was sicher ein Messfehler ist und der mir die Grafik vermakelt.Ich hatte jetzt folgenden Syntax:

sudo influx delete --token xxxxxxxxxxxxxxxxxxxx --org home --bucket iobroker --start 2022-11-26T12:46:10.000Z --stop 2022-11-26T12:46:50.000Z --predicate '_measurement="Heizung-Kesseltemperatur"'

Es kam kein Fehler aber der Datenpunkt in Grafana ist noch da.

Hast du eine Idee?

-

Ich möchte mal mein Vorgehen zum Löschen von Datenreihen in InfluxDB 2.0 beschreiben. Vielleicht kann es jemand gebrauchen der wie ich nur Erklärungen für InfluxDB < 2.0 gefunden hat.

Auf jeden muss man als erstes das Aufzeichnen des Datenpunktes in ioBroker deaktivieren. Wenn eine ID vergeben wurde diese als Measurement Bezeichner nutzen.

Los geht's:

Eine Konsole auf der Installation öffnen auf der sich InfluxDB 2.0 befindet.Um nicht ständig den Token und die Organisation bei den Befehlen eingeben zu müssen hab ich eine config dafür erzeugt.

Den Token findet man in InfluxDB unter "Data - API Tokens". Die Datenbank auswählen, bei mir heißt sie ioBroker. Im sich öffnenden Fenster steht oben der Token. Dann einfach Copy to Clipboard geklickt dann kann man sie einfacher in der Konsole einsetzen.

InfluxDate schreibt dazu:

influx config create --config-name <config-name> \

--host-url http://localhost:8086 \

--org <your-org> \

--token <your-api-token> \

--activeDas nun angepasst in der Konsole eingegeben.

spacerx@InfluxDB-Grafana:~$ influx config create --config-name spacerx --host-url http://localhost:8086 --org RBE --token abcdefghijklmnop123456789 --activeNun der Befehl um den Eintrag komplett zu löschen.

InfluxDate schreibt dazu:influx delete \

--bucket example-bucket \

--start 1970-01-01T00:00:00Z \

--stop $(date +"%Y-%m-%dT%H:%M:%SZ") \

--predicate '_measurement="example-measurement"'Das angepasst auf meine Datenbank und die ID des Datenpunktes in der Konsole eingegeben.

spacerx@InfluxDB-Grafana:~$ influx delete --bucket ioBroker --start 1970-01-01T00:00:00Z --stop $(date +"%Y-%m-%dT%H:%M:%SZ") --predicate '_measurement="ID-Datenpunkt"'Schwups nun ist ID-Datenpunkt aus InfluxDB verschwunden.

@spacerx

Das löschen klappt soweit wie geplant, ich habe aber so meine Probleme wenn ich den Filter weiter eingrenzen will, vielleicht hast du ja ne Idee.

Ziel ist es die unnötigen Datenpunkte aus dem influx-Adapter zu löschen. Sollte sinngemäß so klappen:influx delete \ --bucket iobroker_short \ --start 1970-01-01T00:00:00Z \ --stop $(date +"%Y-%m-%dT%H:%M:%SZ") \ --predicate '_measurement="Azimut" AND from="system.adapter.influxdb.1"'Ergebnis ist aber:

Error: failed to delete data: 400 Bad Request: error decoding json body: bad logical expression, at position 26Versuche ich einen anderen Filter an einem Testdatenpunkt klappt es, z.B.:

influx delete \ --bucket iobroker_short \ --start 1970-01-01T00:00:00Z \ --stop $(date +"%Y-%m-%dT%H:%M:%SZ") \ --predicate '_measurement="0_userdata.0.Test.Test_Number" AND ack="false"'Kann es sein dass das "from" bei Influx schon vorbelegt ist? und wenn ja, wie kann ich alle Datenpunkte von system.adapter.influxdb.1 löschen?

-

Vielleicht hilft es einem der vor dem gleichen Problem steht. Der key from möchte mit "from" angesprochen werden.

influx delete \ --bucket iobroker_never \ --start 1970-01-01T00:00:00Z \ --stop $(date +"%Y-%m-%dT%H:%M:%SZ") \ --predicate '"from"="system.adapter.influxdb.0"'löscht dann alle Einträge vom Adapter influxdb.0 aus dem bucket iobroker_never.

-

Danke nochmal für den Tipp. Das löschen funktioniert damit einwandfrei.

Jetzt möchte ich den falschen Wert aber gerne korrigieren.

Dazu müsste ich ihn doch auch über die Konsole schreiben können, oder?

Funktioniert das?Gruß

-

@friemelkarl sagte in InfluxDB 2.0 Measurement löschen:

Jetzt möchte ich den falschen Wert aber gerne korrigieren.

Es gibt natürlich viele verschiedene Wege, Daten zu korrigieren. Eine Methode, die ich ich gern anwende ist über den Umweg CSV. Damit lassen sich bei Bedarf auch viele Werte am Stück korrigieren:

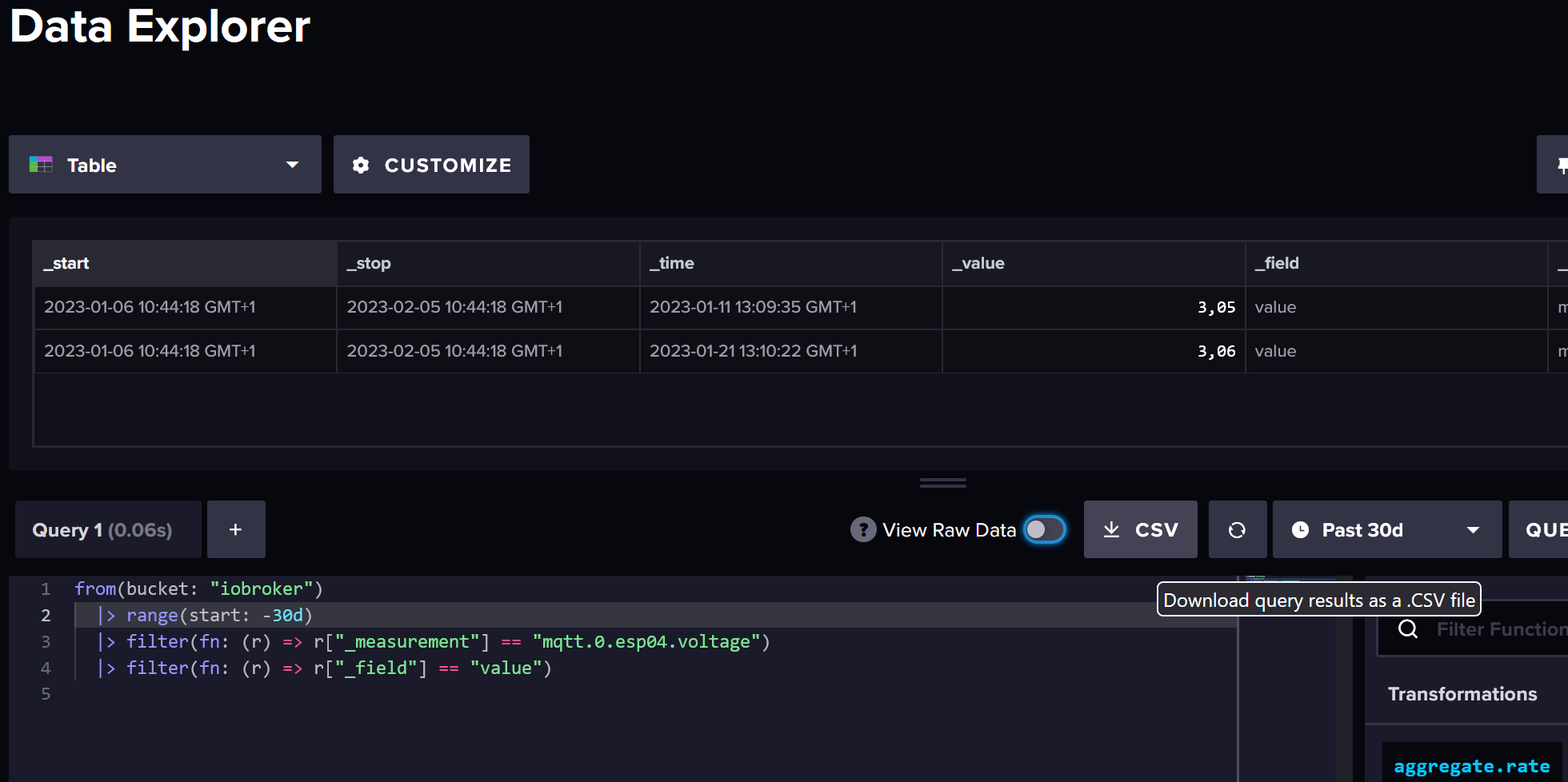

- Im Data Explorer eine Query ausführen, die die zu korrigierenden Werte umfasst, dabei am Besten den Zeitraum passend eingrenzen und unbedingt Aggregationen entfernen.

-

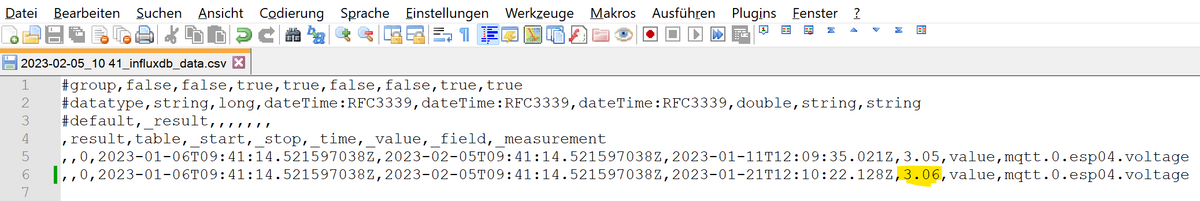

Als CSV speichern

-

Werte in der CSV wie gewünscht ändern und speichern (nicht in Excel)

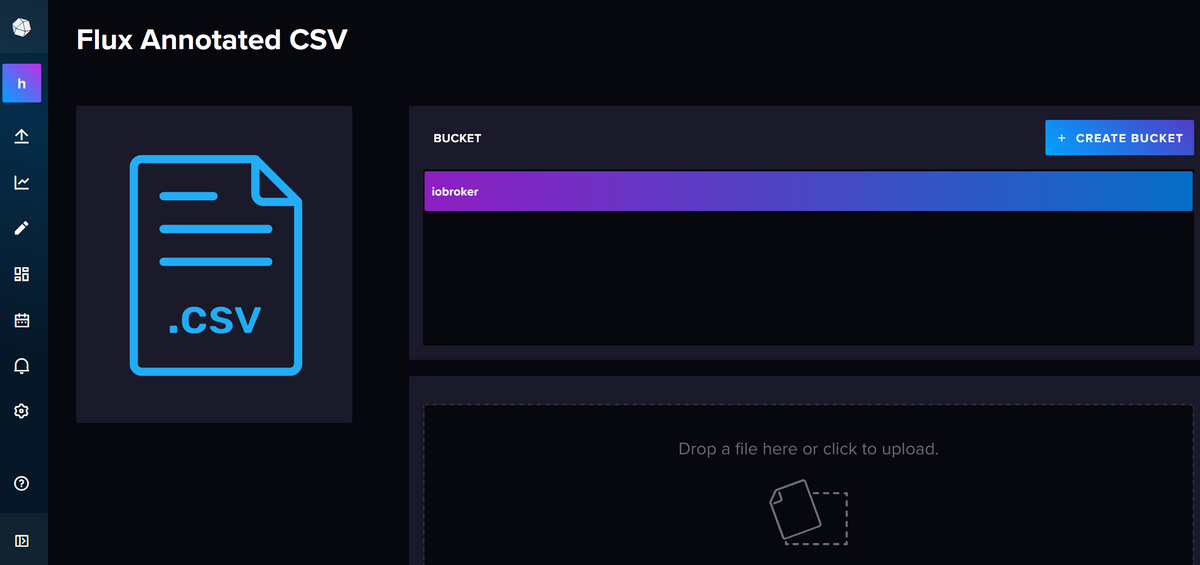

- Über "Data Sources --> File Upload --> Flux Annotated CSV" hochladen

Fertig.

-

@friemelkarl sagte in InfluxDB 2.0 Measurement löschen:

Jetzt möchte ich den falschen Wert aber gerne korrigieren.

Es gibt natürlich viele verschiedene Wege, Daten zu korrigieren. Eine Methode, die ich ich gern anwende ist über den Umweg CSV. Damit lassen sich bei Bedarf auch viele Werte am Stück korrigieren:

- Im Data Explorer eine Query ausführen, die die zu korrigierenden Werte umfasst, dabei am Besten den Zeitraum passend eingrenzen und unbedingt Aggregationen entfernen.

-

Als CSV speichern

-

Werte in der CSV wie gewünscht ändern und speichern (nicht in Excel)

- Über "Data Sources --> File Upload --> Flux Annotated CSV" hochladen

Fertig.

@marc-berg said in InfluxDB 2.0 Measurement löschen:

@friemelkarl sagte in InfluxDB 2.0 Measurement löschen:

Jetzt möchte ich den falschen Wert aber gerne korrigieren.

Es gibt natürlich viele verschiedene Wege, Daten zu korrigieren. Eine Methode, die ich ich gern anwende ist über den Umweg CSV. Damit lassen sich bei Bedarf auch viele Werte am Stück korrigieren:

- Im Data Explorer eine Query ausführen, die die zu korrigierenden Werte umfasst, dabei am Besten den Zeitraum passend eingrenzen und unbedingt Aggregationen entfernen.

-

Als CSV speichern

-

Werte in der CSV wie gewünscht ändern und speichern (nicht in Excel)

- Über "Data Sources --> File Upload --> Flux Annotated CSV" hochladen

Fertig.

Das klingt sehr charmant für mich und hab Dein Beitrag spontan über die Suche gefunden. Der Explorer funktioniert aber nur über eine influxdB 2 richtig? mmmh, müßte ich doch mal von 1 migrieren

-

@marc-berg said in InfluxDB 2.0 Measurement löschen:

@friemelkarl sagte in InfluxDB 2.0 Measurement löschen:

Jetzt möchte ich den falschen Wert aber gerne korrigieren.

Es gibt natürlich viele verschiedene Wege, Daten zu korrigieren. Eine Methode, die ich ich gern anwende ist über den Umweg CSV. Damit lassen sich bei Bedarf auch viele Werte am Stück korrigieren:

- Im Data Explorer eine Query ausführen, die die zu korrigierenden Werte umfasst, dabei am Besten den Zeitraum passend eingrenzen und unbedingt Aggregationen entfernen.

-

Als CSV speichern

-

Werte in der CSV wie gewünscht ändern und speichern (nicht in Excel)

- Über "Data Sources --> File Upload --> Flux Annotated CSV" hochladen

Fertig.

Das klingt sehr charmant für mich und hab Dein Beitrag spontan über die Suche gefunden. Der Explorer funktioniert aber nur über eine influxdB 2 richtig? mmmh, müßte ich doch mal von 1 migrieren

@dieter_p sagte in InfluxDB 2.0 Measurement löschen:

Das klingt sehr charmant für mich und hab Dein Beitrag spontan über die Suche gefunden. Der Explorer funktioniert aber nur über eine influxdB 2 richtig?

Ja, für die Version 2.x. Ich dachte, unter dieser Überschrift kann ich mir den Hinweis sparen ...

-

@dieter_p sagte in InfluxDB 2.0 Measurement löschen:

Das klingt sehr charmant für mich und hab Dein Beitrag spontan über die Suche gefunden. Der Explorer funktioniert aber nur über eine influxdB 2 richtig?

Ja, für die Version 2.x. Ich dachte, unter dieser Überschrift kann ich mir den Hinweis sparen ...

@marc-berg said in InfluxDB 2.0 Measurement löschen:

@dieter_p sagte in InfluxDB 2.0 Measurement löschen:

Das klingt sehr charmant für mich und hab Dein Beitrag spontan über die Suche gefunden. Der Explorer funktioniert aber nur über eine influxdB 2 richtig?

Ja, für die Version 2.x. Ich dachte, unter dieser Überschrift kann ich mir den Hinweis sparen ...

ist schon eindeutig, ja . komme gerade nur von einer anderen "Baustelle" und die Migration gab s jetzt als Bonus, den ich gerne zu passendere Zeit bekommen hätte

-

@marc-berg

Das mit dem importieren war mir so noch nicht bekannt!

Vielen Dank für die tolle Anleitung. Werde das später gleich in Angriff nehmen!Gruß

-

@marc-berg

Das mit dem importieren war mir so noch nicht bekannt!

Vielen Dank für die tolle Anleitung. Werde das später gleich in Angriff nehmen!Gruß

@friemelkarl sagte in InfluxDB 2.0 Measurement löschen:

@marc-berg

Das mit dem importieren war mir so noch nicht bekannt!

Vielen Dank für die tolle Anleitung. Werde das später gleich in Angriff nehmen!Gruß

Viel Erfolg beim ... ähh ... Friemeln.

-

@friemelkarl sagte in InfluxDB 2.0 Measurement löschen:

@marc-berg

Das mit dem importieren war mir so noch nicht bekannt!

Vielen Dank für die tolle Anleitung. Werde das später gleich in Angriff nehmen!Gruß

Viel Erfolg beim ... ähh ... Friemeln.

Vielen Dank! Hat alles wunderbar funktioniert!

So kann man falsche Werte "relativ" einfach korrigieren!

Gruß

-

@friemelkarl sagte in InfluxDB 2.0 Measurement löschen:

@marc-berg

Das mit dem importieren war mir so noch nicht bekannt!

Vielen Dank für die tolle Anleitung. Werde das später gleich in Angriff nehmen!Gruß

Viel Erfolg beim ... ähh ... Friemeln.

@marc-berg

Grundsätzlich klappt das mit dem CSV ganz gut, allerdings hab ich ein Problem mit der Zeit....

Ich wollte ein paar Daten vom Stromzähler nachtragen um die in Grafana nutzen zu können.

CSV heruntergeladen, meine Werte eingetragen und das Datum angepasst, jeden 1. des Monats 4 Uhr.

-

@bommel_030 sagte in InfluxDB 2.0 Measurement löschen:

@marc-berg

Grundsätzlich klappt das mit dem CSV ganz gut, allerdings hab ich ein Problem mit der Zeit....Irgendwie ist da beim Reinkopieren was schief gegangen, den Screenshot nicht mit in Code-Tags packen. Das "false" am Anfang jeder Zeile ist auch falsch.

Und zeige mal die zugrunde liegende Abfrage. Die musst Du auf "value" filtern.

|> filter(fn: (r) => r["_field"] == "value") -

@bommel_030 sagte in InfluxDB 2.0 Measurement löschen:

@marc-berg

Grundsätzlich klappt das mit dem CSV ganz gut, allerdings hab ich ein Problem mit der Zeit....Irgendwie ist da beim Reinkopieren was schief gegangen, den Screenshot nicht mit in Code-Tags packen. Das "false" am Anfang jeder Zeile ist auch falsch.

Und zeige mal die zugrunde liegende Abfrage. Die musst Du auf "value" filtern.

|> filter(fn: (r) => r["_field"] == "value")@marc-berg

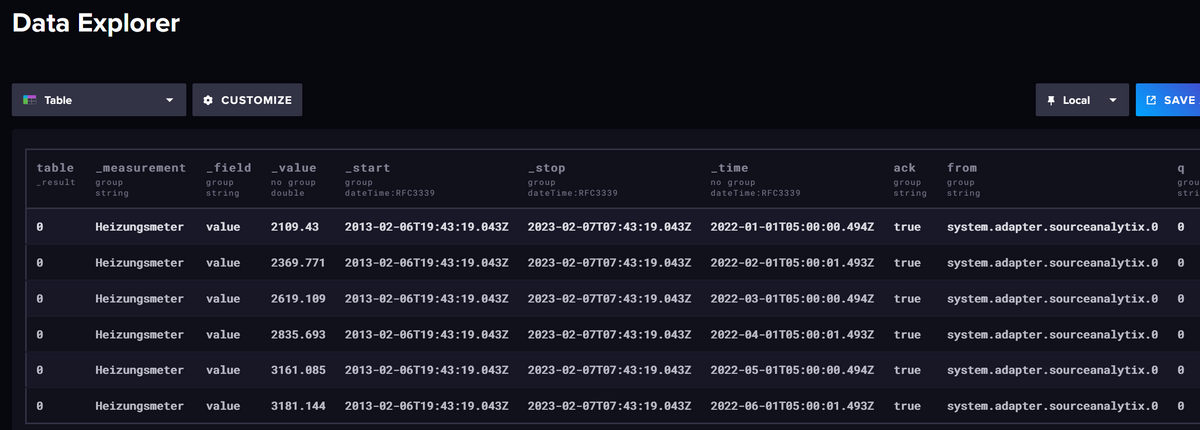

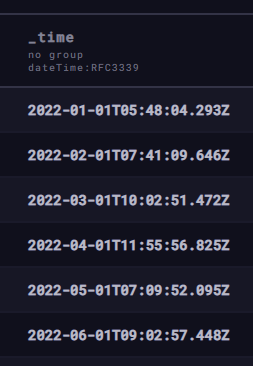

Sorry, da ist beim editieren wohl was daneben gegangen.#group,false,false,true,true,false,false,true,true,true,true,true #datatype,string,long,dateTime:RFC3339,dateTime:RFC3339,dateTime:RFC3339,double,string,string,string,string,string #default,_result,,,,,,,,,, ,result,table,_start,_stop,_time,_value,_field,_measurement,ack,from,q ,,0,2021-12-31T23:00:00Z,2022-06-03T05:20:10Z,2022-01-01T05:00:00.494Z,2109.43,value,Heizungsmeter,true,system.adapter.sourceanalytix.0,0 ,,0,2021-12-31T23:00:00Z,2022-06-03T05:20:10Z,2022-02-01T05:00:01.493Z,2369.771,value,Heizungsmeter,true,system.adapter.sourceanalytix.0,0 ,,0,2021-12-31T23:00:00Z,2022-06-03T05:20:10Z,2022-03-01T05:00:00.494Z,2619.109,value,Heizungsmeter,true,system.adapter.sourceanalytix.0,0 ,,0,2021-12-31T23:00:00Z,2022-06-03T05:20:10Z,2022-04-01T05:00:01.493Z,2835.693,value,Heizungsmeter,true,system.adapter.sourceanalytix.0,0 ,,0,2021-12-31T23:00:00Z,2022-06-03T05:20:10Z,2022-05-01T05:00:00.494Z,3161.085,value,Heizungsmeter,true,system.adapter.sourceanalytix.0,0 ,,0,2021-12-31T23:00:00Z,2022-06-03T05:20:10Z,2022-06-01T05:00:01.493Z,3181.144,value,Heizungsmeter,true,system.adapter.sourceanalytix.0,0Alle Daten sollten am 1. des Monats gegen 5 Uhr reinkommen. Erster des Monats passt, aber die Zeit halt nicht. Hier nicht so dramatisch aber für die Zukunft würde ich gerne wissen was da schief läuft.

Das war die Abfrage zum Download des CSV.

from(bucket: "iobroker_never") |> range(start: v.timeRangeStart, stop: v.timeRangeStop) |> filter(fn: (r) => r["_measurement"] == "Heizungsmeter") |> filter(fn: (r) => r["_field"] == "value") -

@marc-berg

Sorry, da ist beim editieren wohl was daneben gegangen.#group,false,false,true,true,false,false,true,true,true,true,true #datatype,string,long,dateTime:RFC3339,dateTime:RFC3339,dateTime:RFC3339,double,string,string,string,string,string #default,_result,,,,,,,,,, ,result,table,_start,_stop,_time,_value,_field,_measurement,ack,from,q ,,0,2021-12-31T23:00:00Z,2022-06-03T05:20:10Z,2022-01-01T05:00:00.494Z,2109.43,value,Heizungsmeter,true,system.adapter.sourceanalytix.0,0 ,,0,2021-12-31T23:00:00Z,2022-06-03T05:20:10Z,2022-02-01T05:00:01.493Z,2369.771,value,Heizungsmeter,true,system.adapter.sourceanalytix.0,0 ,,0,2021-12-31T23:00:00Z,2022-06-03T05:20:10Z,2022-03-01T05:00:00.494Z,2619.109,value,Heizungsmeter,true,system.adapter.sourceanalytix.0,0 ,,0,2021-12-31T23:00:00Z,2022-06-03T05:20:10Z,2022-04-01T05:00:01.493Z,2835.693,value,Heizungsmeter,true,system.adapter.sourceanalytix.0,0 ,,0,2021-12-31T23:00:00Z,2022-06-03T05:20:10Z,2022-05-01T05:00:00.494Z,3161.085,value,Heizungsmeter,true,system.adapter.sourceanalytix.0,0 ,,0,2021-12-31T23:00:00Z,2022-06-03T05:20:10Z,2022-06-01T05:00:01.493Z,3181.144,value,Heizungsmeter,true,system.adapter.sourceanalytix.0,0Alle Daten sollten am 1. des Monats gegen 5 Uhr reinkommen. Erster des Monats passt, aber die Zeit halt nicht. Hier nicht so dramatisch aber für die Zukunft würde ich gerne wissen was da schief läuft.

Das war die Abfrage zum Download des CSV.

from(bucket: "iobroker_never") |> range(start: v.timeRangeStart, stop: v.timeRangeStop) |> filter(fn: (r) => r["_measurement"] == "Heizungsmeter") |> filter(fn: (r) => r["_field"] == "value")@bommel_030

Wenn ich die Daten in meine Test-DB importiere, sieht das sauber aus:

Vielleicht schaust Du auf alte, schon vorhandene Daten, und hast versehentlich in ein falsches Bucket importiert?

Beim Import ist ja standardmäßig das erste Bucket selektiert, wenn man ein anderes haben möchte, muss man das aktiv auswählen.Wichtig: Wenn man am Zeitstempel rumspielt, werden natürlich keine Daten geändert, sondern neue hinzugefügt. Die alten muss man dann manuell löschen.

-

Mich sterngt die Handhabung der InfluxDB Daten auch etwas an. Gibts hier nicht nen Profi mit zuviel Freizeit der InfluxDBStudio für Influx 2.x und KlickKlickWindows User weiterntwickeln kann?

@Rushmed sagte in InfluxDB 2.0 Measurement löschen:

Mich sterngt die Handhabung der InfluxDB Daten auch etwas an. Gibts hier nicht nen Profi mit zuviel Freizeit der InfluxDBStudio für Influx 2.x und KlickKlickWindows User weiterntwickeln kann?

Ich habe noch dieses Tool gefunden:

https://github.com/JorgeMaker/InfluxDBWorkBenchIch gehe aber davon aus das das ebenfalls nicht für InfluxDBv2 funktioniert ?

-

@rushmed Profi ja, Zeit nein.... geht mit KlickKlickWindows und der Influx v2 API... siehe hier: https://docs.influxdata.com/influxdb/v2.2/api/#tag/Delete

@ftd sagte in InfluxDB 2.0 Measurement löschen:

@rushmed Profi ja, Zeit nein.... geht mit KlickKlickWindows und der Influx v2 API... siehe hier: https://docs.influxdata.com/influxdb/v2.2/api/#tag/Delete

Der beschriebene Weg über die Excel ist schon mal viel besser als Kommandozeile. Werde ich auch mal testen.

Ich würde aber gerne verstehen wie das über die API mit „KlickKlickWindows“ funktioniert, irgendwie weiß ich aber nicht wie da vorzugehen ist.

Kannst du mir das „KlickKlickWindows“ netterweise mal erklären ?