NEWS

Ordner auf neue Dateien überwachen

-

@tomily

Etwa so:if ( seconds > 3*86400 ) { sendTo("email.0", "send", { text: 'Body', to: 'test@gmx.de', subject: 'Betreff' }); }@ente34

Guten Morgen,herzlichen Dank. Wirkt beides plausibel. Sehr geil das hilft mir extrem.

Könntest du mir noch verraten, wo ich die Email-Scriptszeilen einfügen soll? Innerhalb des Scriptes oben, oder in einem separaten Aufruf?So ist es offensichtlich falsch :-D (Habe die Emailadresse absichtlich noch nicht ausgefüllt)

const fs = require('fs'); const util = require('util'); const readdir = util.promisify(fs.readdir); const stat = util.promisify(fs.stat); const lstat = util.promisify(fs.lstat); async function checkDir(dir) { let files = []; try { files = await readdir(dir); let newestFileAge = 0; let newestFile = ''; for (let file of files) { let fullpath = dir + '/' + file; const s = await lstat(fullpath); if (s.isFile()) { const stats = await stat(fullpath); if (stats.mtimeMs > newestFileAge) { newestFileAge = stats.mtimeMs; newestFile = file; } } } let seconds = (new Date().getTime() - new Date(newestFileAge).getTime()) / 1000; console.log(`newest file "${newestFile}" created before ${seconds} seconds`); } catch (e) { console.log(e); } } //################################ if ( seconds > 3*86400 ) { sendTo("email.0", "send", { text: 'Body', to: 'test@gmx.de', subject: 'Betreff' }); } //################################ checkDir('/etc/test1'); -

@ente34

Guten Morgen,herzlichen Dank. Wirkt beides plausibel. Sehr geil das hilft mir extrem.

Könntest du mir noch verraten, wo ich die Email-Scriptszeilen einfügen soll? Innerhalb des Scriptes oben, oder in einem separaten Aufruf?So ist es offensichtlich falsch :-D (Habe die Emailadresse absichtlich noch nicht ausgefüllt)

const fs = require('fs'); const util = require('util'); const readdir = util.promisify(fs.readdir); const stat = util.promisify(fs.stat); const lstat = util.promisify(fs.lstat); async function checkDir(dir) { let files = []; try { files = await readdir(dir); let newestFileAge = 0; let newestFile = ''; for (let file of files) { let fullpath = dir + '/' + file; const s = await lstat(fullpath); if (s.isFile()) { const stats = await stat(fullpath); if (stats.mtimeMs > newestFileAge) { newestFileAge = stats.mtimeMs; newestFile = file; } } } let seconds = (new Date().getTime() - new Date(newestFileAge).getTime()) / 1000; console.log(`newest file "${newestFile}" created before ${seconds} seconds`); } catch (e) { console.log(e); } } //################################ if ( seconds > 3*86400 ) { sendTo("email.0", "send", { text: 'Body', to: 'test@gmx.de', subject: 'Betreff' }); } //################################ checkDir('/etc/test1'); -

@ente34 Vielen Dank und sorry für die späte Rückmeldung.

Ich hatte ganz vergessen das positive Eregebnis hier zu posten :-(Es hat geklappt und ich bekomme jetzt eine Email, wenn die Datei zu alt ist. HERVORRAGEND.

Nun muss ich nur dafür sorgen, dass vor dem ausführen die Laufwerke verbunden werden.

Eine Frage hätte ich noch. Kann ich einen Trigger direkt in das Script einbauen? z.B. dass das Script immer zu einer bestimmten Tageszeit läuft? -

@ente34 Vielen Dank und sorry für die späte Rückmeldung.

Ich hatte ganz vergessen das positive Eregebnis hier zu posten :-(Es hat geklappt und ich bekomme jetzt eine Email, wenn die Datei zu alt ist. HERVORRAGEND.

Nun muss ich nur dafür sorgen, dass vor dem ausführen die Laufwerke verbunden werden.

Eine Frage hätte ich noch. Kann ich einen Trigger direkt in das Script einbauen? z.B. dass das Script immer zu einer bestimmten Tageszeit läuft?@tomily

Noch ein kleiner Nachtrag bzw. erneute Frage :-)Ich könnte natürlich im Filesystem der Linuxmaschine, auf der der ioBroker läuft die zu überwachenden Laufwerke mounten.

Würde diese aber ganz gerne vor dem Prüfen aus dem SCript heraus verbinden und anschließend wieder trennen.Kann ich den "Mountbefehl" aus dem JavaScript heraus ausführen?

-

@tomily

Noch ein kleiner Nachtrag bzw. erneute Frage :-)Ich könnte natürlich im Filesystem der Linuxmaschine, auf der der ioBroker läuft die zu überwachenden Laufwerke mounten.

Würde diese aber ganz gerne vor dem Prüfen aus dem SCript heraus verbinden und anschließend wieder trennen.Kann ich den "Mountbefehl" aus dem JavaScript heraus ausführen?

@tomily

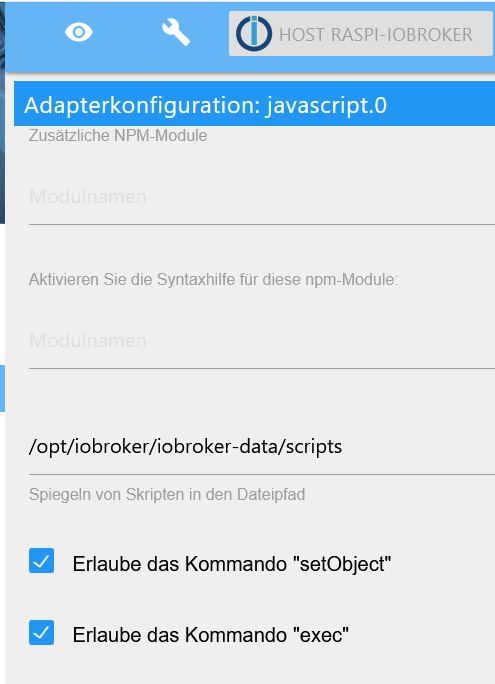

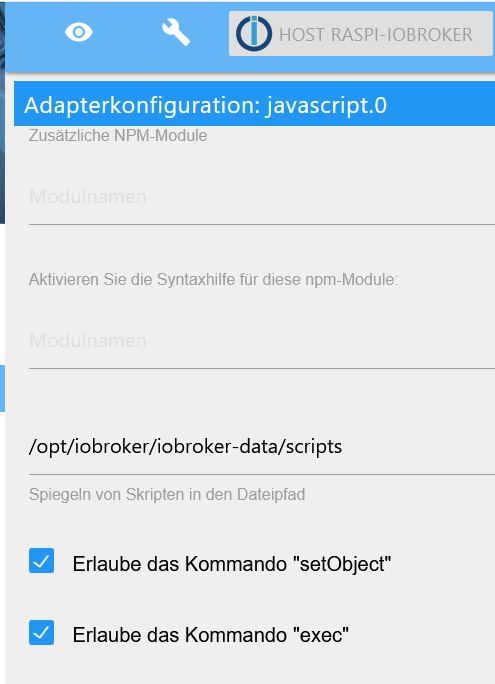

Basteln wir mal alles zusammen.const fs = require('fs'); const util = require('util'); const readdir = util.promisify(fs.readdir); const stat = util.promisify(fs.stat); const lstat = util.promisify(fs.lstat); const mountDir = '/home/pi/mount'; const nasDir = '//nas02/backup' const mountCmd = `sudo mount -t cifs -o username=...,password=...,vers=3.0 ${nasDir} ${mountDir}`; const umountCmd = `sudo umount ${nasDir}`; const warnSeconds = 5 * 86400; async function checkDir(dir) { let rc = false; try { let files = []; files = await readdir(dir); let newestFileAge = 0; let newestFile = ''; for (let file of files) { let fullpath = dir + '/' + file; const s = await lstat(fullpath); if (s.isFile()) { const stats = await stat(fullpath); if (stats.mtimeMs > newestFileAge) { newestFileAge = stats.mtimeMs; newestFile = file; } } } let seconds = (new Date().getTime() - new Date(newestFileAge).getTime()) / 1000; rc = seconds > warnSeconds; console.log(`newest file "${newestFile}" created before ${seconds} seconds`); } catch (e) { console.log(e); } finally { return rc; } } /** * Executes a shell command and return it as a Promise. * @param cmd {string} * @return {Promise<string>} */ function execShellCommand(cmd) { const exec = require('child_process').exec; return new Promise((resolve, reject) => { exec(cmd, (error, stdout, stderr) => { if (error) { console.warn(error); } resolve(stdout ? stdout : stderr); }); }); } async function checkBackup() { try { //hier mount-Kommando await execShellCommand(mountCmd); let result = await checkDir(mountDir); if (result) { // Mail abschicken console.log('Send Mail'); } //hier umount-Kommando await execShellCommand(umountCmd); } catch (e) { console.warn(e); } } // 22:30 schedule('30 22 * * *', () => { checkBackup(); });Im Javascript-Adapter "exec" erlauben!

-

Hallo zusammen,

hat jemand eine Idee, wie ich folgendes realisieren kann?

Ich möchte diverse Unterordner meiner NAS auf neue Dateien überprüfen.

In den Ordnern liegen unterschiedlich viele Dateien und unterschiedliche Dateitypen.Ziel ist es, eine Email auszulösen, wenn die neueste Datei im Verzeichnis älter ist, als X-Tage.

Damit möchte ich erreichen, dass mir zukünftig auffällt, wenn Datensicherungen nicht mehr erstellt werden.

Hat jemand eine Idee oder zufällig schon ein fertiges Skript für diesen Monitoring-Zweck?

Grüße

-

@tomily

Basteln wir mal alles zusammen.const fs = require('fs'); const util = require('util'); const readdir = util.promisify(fs.readdir); const stat = util.promisify(fs.stat); const lstat = util.promisify(fs.lstat); const mountDir = '/home/pi/mount'; const nasDir = '//nas02/backup' const mountCmd = `sudo mount -t cifs -o username=...,password=...,vers=3.0 ${nasDir} ${mountDir}`; const umountCmd = `sudo umount ${nasDir}`; const warnSeconds = 5 * 86400; async function checkDir(dir) { let rc = false; try { let files = []; files = await readdir(dir); let newestFileAge = 0; let newestFile = ''; for (let file of files) { let fullpath = dir + '/' + file; const s = await lstat(fullpath); if (s.isFile()) { const stats = await stat(fullpath); if (stats.mtimeMs > newestFileAge) { newestFileAge = stats.mtimeMs; newestFile = file; } } } let seconds = (new Date().getTime() - new Date(newestFileAge).getTime()) / 1000; rc = seconds > warnSeconds; console.log(`newest file "${newestFile}" created before ${seconds} seconds`); } catch (e) { console.log(e); } finally { return rc; } } /** * Executes a shell command and return it as a Promise. * @param cmd {string} * @return {Promise<string>} */ function execShellCommand(cmd) { const exec = require('child_process').exec; return new Promise((resolve, reject) => { exec(cmd, (error, stdout, stderr) => { if (error) { console.warn(error); } resolve(stdout ? stdout : stderr); }); }); } async function checkBackup() { try { //hier mount-Kommando await execShellCommand(mountCmd); let result = await checkDir(mountDir); if (result) { // Mail abschicken console.log('Send Mail'); } //hier umount-Kommando await execShellCommand(umountCmd); } catch (e) { console.warn(e); } } // 22:30 schedule('30 22 * * *', () => { checkBackup(); });Im Javascript-Adapter "exec" erlauben!

-

@mickym

Hmmmm, weil ich nicht weiß wie ich es damit lösen könnte? :-) Ginge das denn?In diesem Fall habe ich NodeRed gar nicht im Spiel. Wäre aber auch denkbar.

@tomily Nun ich hätte mich hier nie ;) eingemischt, aber nachdem ich ja weiß, dass Du bislang alles mit NodeRed gemacht hast, war ich etwas verwundert und vielleicht denkst Du ja auch über einen Systemwechsel nach.

Außerdem hat hier @ente34 Dir schon viel geholfen und Arbeit reingesteckt und das gebietet schon der Respekt, dass ich mich da nicht einmische.

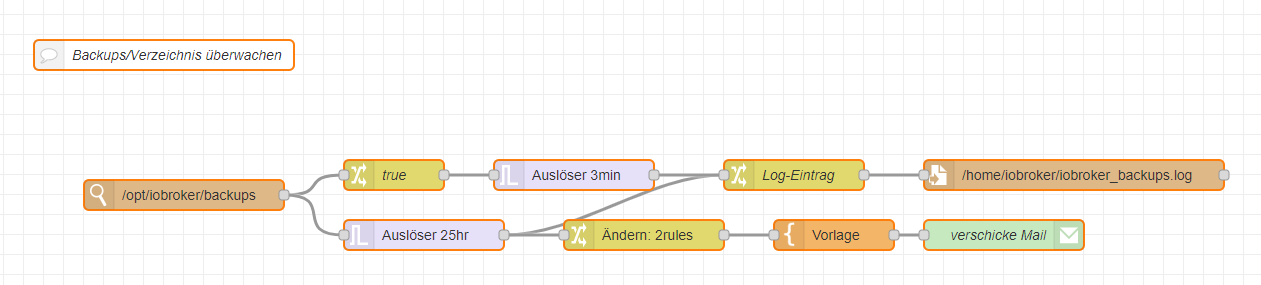

Als ich dann gestern diesen Thread hier entdeckt habe, habe ich mir Deine Anfordeung mal als Herausforderung gestellt und mal einen kleinen Flow gebastelt - wobei ich nicht im Detail weiß, ob das Deinen Bedürfnissen entspricht.

Hier mal nur der Flow mit ein paar Erklärungen:

Ich habe der Einfachheit einfach mal angenommen, dass nur ein Backup in ein Verzeichnis schreibt und deshalb nur dieser Task etwas an dem Verzeichnis ändert. Ich habe deshalb mal als Beispiel das iobroker backup genommen.

- Mit der Watch-Node beobachte ich also das "/opt/iobroker/backups" Verzeichnis - welche Änderungen sind mir wurscht - weil ich davon ausgehe, dass das nur der backitup-Adapter ist, der da was verändert.

- Findet eine Aktivität statt läuft z. Bsp der obere Ast los und schreibt einen Eintrag über ein erfolgreiches Backup in die Logdatei .

- Gleichzeitig wird der Trigger im unteren Ast getriggert, der solange nichts verschickt, solange 25 Stunden keine neue Nachricht (also Aktivität) stattfindet.

- Findet keine Aktivität statt schreibt er eine negativen Logeintrag und schickt Dir eine Mail

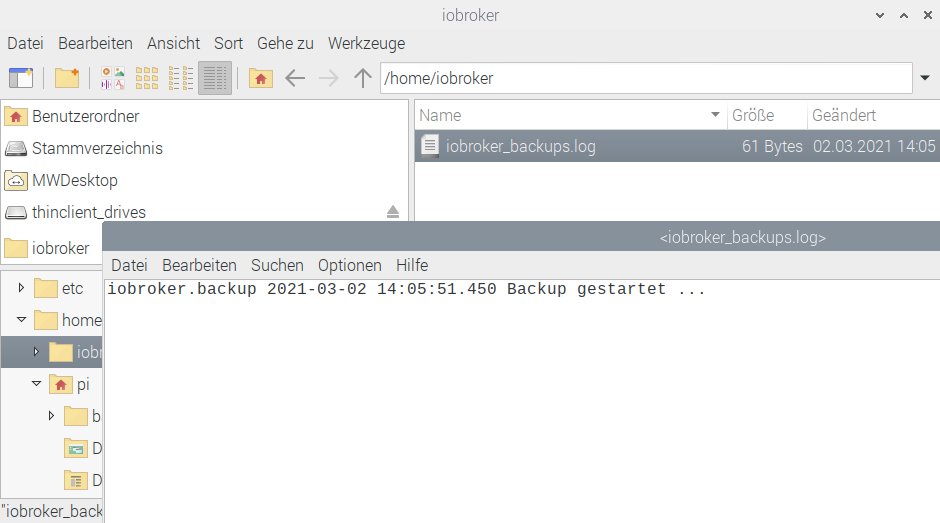

Die Logdatei in der diese Aktivität überwacht wird schaut dann einfach so aus:

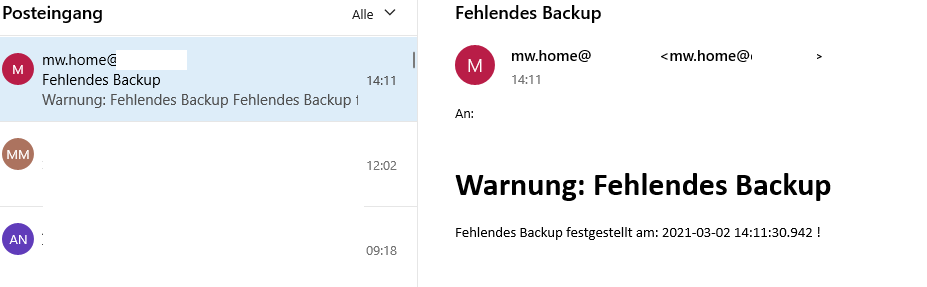

und die Mail im Fehlerfall würde dann so aussehen:

und dann kannst Du ja wieder mit Deinem anderen Projekt mehrere Logdateien zu überwachen ggf. fortfahren. ;) ;) ;)

-

Wenn es wirklich nur um neue Dateien (neuer Name, nicht überschrieben) geht, kann man im JS Skript auch lediglich

mtimedes Verzeichnisses prüfen und muss nicht erst alle Dateien enumerieren und deren Zeitstempel prüfen.Hallo zusammen,

erst mal einen herzlichen und fetten Dank an @ente34 für den geilen Support.

Ich habe das letzte Script noch etwas für mich angepasst und nun tut es EXAKT das was ich mir vorgestellt habe... Juhuuu :-)Danke auch an @mickym. Es ist immer interessant mehrere Wege zu testen. Somit lerne ich beide Systeme. Werde den NodeRed-Flow morgen früh gleich mal ausprobieren. Einfach aus Neugierde.

Ich mache viel mit NodeRed. In dem Fall wollte ich das Backup-Prüfscript aber absichtlich in einem anderen System betreiben. Es macht nie Sinn eine Datensicherung vom gleichen System zu prüfen, das es auch erstellt.

Spinnt das System, erhält man gar keine Infos mehr. Deshalb arbeite ich mit mehreren Instanzen und Servern.

Ich prüfe somit mehrere Verzeichnisse auf neue Sicherungen ab. Ganz egal, wie diese erstellt wurden. Manche kommen vom ioBroker direkt. Manche liefert das ESXi-Serverbackup und manche kopiere ich von Hand rein und werde somit nach einer Gewissen Zeit erinnert es wieder zu tun :-)

Das einzige, das nicht funktioniert ist, wenn die Sicherungen in Unterverzeichnissen liegen. Das wäre dann die nächste Hürde :-)

-

Hallo zusammen,

erst mal einen herzlichen und fetten Dank an @ente34 für den geilen Support.

Ich habe das letzte Script noch etwas für mich angepasst und nun tut es EXAKT das was ich mir vorgestellt habe... Juhuuu :-)Danke auch an @mickym. Es ist immer interessant mehrere Wege zu testen. Somit lerne ich beide Systeme. Werde den NodeRed-Flow morgen früh gleich mal ausprobieren. Einfach aus Neugierde.

Ich mache viel mit NodeRed. In dem Fall wollte ich das Backup-Prüfscript aber absichtlich in einem anderen System betreiben. Es macht nie Sinn eine Datensicherung vom gleichen System zu prüfen, das es auch erstellt.

Spinnt das System, erhält man gar keine Infos mehr. Deshalb arbeite ich mit mehreren Instanzen und Servern.

Ich prüfe somit mehrere Verzeichnisse auf neue Sicherungen ab. Ganz egal, wie diese erstellt wurden. Manche kommen vom ioBroker direkt. Manche liefert das ESXi-Serverbackup und manche kopiere ich von Hand rein und werde somit nach einer Gewissen Zeit erinnert es wieder zu tun :-)

Das einzige, das nicht funktioniert ist, wenn die Sicherungen in Unterverzeichnissen liegen. Das wäre dann die nächste Hürde :-)

@tomily

Ich hab mir nun aber mal das Skript von @ente34 genauer angeschaut und da wird das Verzeichnis ja zum Überprüfungszeitpunkt gemountet, analysiert und dann wieder unmounted.

Der flow geht aber einen ganz anderen Ansatz - der permanenten Überprüfung!

Deshalb dürfte der Flow für Dich doch nicht geeignet sein. Der Flow geht ja davon aus, dass Du eine permanente Verbindung zur Überwachung hälst (gemountete Verzeinchisse) und nicht nur zu einem bestimmten Zeitpunkt, wie das ja das Script macht. Also insofern vergiss einfach den Flow. ;) -

@tomily

Ich hab mir nun aber mal das Skript von @ente34 genauer angeschaut und da wird das Verzeichnis ja zum Überprüfungszeitpunkt gemountet, analysiert und dann wieder unmounted.

Der flow geht aber einen ganz anderen Ansatz - der permanenten Überprüfung!

Deshalb dürfte der Flow für Dich doch nicht geeignet sein. Der Flow geht ja davon aus, dass Du eine permanente Verbindung zur Überwachung hälst (gemountete Verzeinchisse) und nicht nur zu einem bestimmten Zeitpunkt, wie das ja das Script macht. Also insofern vergiss einfach den Flow. ;)@mickym

Ich danke Dir für den input. Für mich sind trotzdem beide Varianten sehr interessant.Der Ursprüngliche Zweck war ja zu erkennen, wenn keine neue Dateien mehr kommen. Der permanente Überwachung wäre sicherlich auch in einigen Situationen sinnvoll.

Zur NOT könnte ich das Verzeichnis dauerhaft mounten. Aber egtl muss und soll das nicht sein.

Die Prüfung würde mir 1-2x am Tag reichen. Weiss nicht, ob die „Dauerprüfung“ evtl traffic oder performance Probleme verursacht?

@ente34

Könnte ich mit dem Skript evtl. Auch zusätlich rekursiv in Unteeverzeichnissen suchen?

War zwar keine ursprüngliche Anforderung von mir, aber nachdem ich meine ganzen Check-Jobs eingerichtet habe, bin ich noch darauf gestossen. -

@tomily

Ich hab mir nun aber mal das Skript von @ente34 genauer angeschaut und da wird das Verzeichnis ja zum Überprüfungszeitpunkt gemountet, analysiert und dann wieder unmounted.

Der flow geht aber einen ganz anderen Ansatz - der permanenten Überprüfung!

Deshalb dürfte der Flow für Dich doch nicht geeignet sein. Der Flow geht ja davon aus, dass Du eine permanente Verbindung zur Überwachung hälst (gemountete Verzeinchisse) und nicht nur zu einem bestimmten Zeitpunkt, wie das ja das Script macht. Also insofern vergiss einfach den Flow. ;) -

@mickym hast du den Flow wieder rausgenommen?

Darf ich ihn mir trotzdem anschauen? Wäre total super, möchte diese Option nicht ausser Acht lassen. -

@mickym

Ich danke Dir für den input. Für mich sind trotzdem beide Varianten sehr interessant.Der Ursprüngliche Zweck war ja zu erkennen, wenn keine neue Dateien mehr kommen. Der permanente Überwachung wäre sicherlich auch in einigen Situationen sinnvoll.

Zur NOT könnte ich das Verzeichnis dauerhaft mounten. Aber egtl muss und soll das nicht sein.

Die Prüfung würde mir 1-2x am Tag reichen. Weiss nicht, ob die „Dauerprüfung“ evtl traffic oder performance Probleme verursacht?

@ente34

Könnte ich mit dem Skript evtl. Auch zusätlich rekursiv in Unteeverzeichnissen suchen?

War zwar keine ursprüngliche Anforderung von mir, aber nachdem ich meine ganzen Check-Jobs eingerichtet habe, bin ich noch darauf gestossen.@tomily sagte in Ordner auf neue Dateien überwachen:

Könnte ich mit dem Skript evtl. Auch zusätlich rekursiv in Unteeverzeichnissen suchen?

Man muss das Script nur ein wenig umstellen:

const fs = require('fs'); const util = require('util'); const readdir = util.promisify(fs.readdir); const stat = util.promisify(fs.stat); const lstat = util.promisify(fs.lstat); const mountDir = '/home/pi/mount'; const nasDir = '//nas02/backup/raspi-iobroker'; const mountCmd = `sudo mount -t cifs -o username=...,password=...,vers=3.0 ${nasDir} ${mountDir}`; const umountCmd = `sudo umount ${nasDir}`; const warnSeconds = 5 * 86400; async function NewestFile(dir) { let newestFileAge = 0; let newestFile = ''; //console.log('### '+dir); try { let files = []; files = await readdir(dir); for (let file of files) { let fullpath = dir + '/' + file; const s = await lstat(fullpath); if (s.isFile()) { const stats = await stat(fullpath); if (stats.mtimeMs > newestFileAge) { newestFileAge = stats.mtimeMs; newestFile = file; } } else { let values = await NewestFile(fullpath); if (values.age > newestFileAge) { newestFileAge = values.age; newestFile = values.file; } } } } catch (e) { console.log(e); } finally { return { file: newestFile, age:newestFileAge }; } } /** * Executes a shell command and return it as a Promise. * @param cmd {string} * @return {Promise<string>} */ function execShellCommand(cmd) { const exec = require('child_process').exec; return new Promise((resolve, reject) => { exec(cmd, (error, stdout, stderr) => { if (error) { console.warn(error); } resolve(stdout ? stdout : stderr); }); }); } async function checkBackup() { try { //hier mount-Kommando await execShellCommand(mountCmd); let result = await NewestFile(mountDir); let seconds = (new Date().getTime() - new Date(result.age).getTime()) / 1000; if (seconds > warnSeconds) { console.log(`newest file "${result.file}" created before ${seconds} seconds`); // Mail abschicken console.log('Send Mail'); } //hier umount-Kommando await execShellCommand(umountCmd); } catch (e) { console.warn(e); } } // 22:30 schedule('30 22 * * *', () => { checkBackup(); }); -

@tomily sagte in Ordner auf neue Dateien überwachen:

Könnte ich mit dem Skript evtl. Auch zusätlich rekursiv in Unteeverzeichnissen suchen?

Man muss das Script nur ein wenig umstellen:

const fs = require('fs'); const util = require('util'); const readdir = util.promisify(fs.readdir); const stat = util.promisify(fs.stat); const lstat = util.promisify(fs.lstat); const mountDir = '/home/pi/mount'; const nasDir = '//nas02/backup/raspi-iobroker'; const mountCmd = `sudo mount -t cifs -o username=...,password=...,vers=3.0 ${nasDir} ${mountDir}`; const umountCmd = `sudo umount ${nasDir}`; const warnSeconds = 5 * 86400; async function NewestFile(dir) { let newestFileAge = 0; let newestFile = ''; //console.log('### '+dir); try { let files = []; files = await readdir(dir); for (let file of files) { let fullpath = dir + '/' + file; const s = await lstat(fullpath); if (s.isFile()) { const stats = await stat(fullpath); if (stats.mtimeMs > newestFileAge) { newestFileAge = stats.mtimeMs; newestFile = file; } } else { let values = await NewestFile(fullpath); if (values.age > newestFileAge) { newestFileAge = values.age; newestFile = values.file; } } } } catch (e) { console.log(e); } finally { return { file: newestFile, age:newestFileAge }; } } /** * Executes a shell command and return it as a Promise. * @param cmd {string} * @return {Promise<string>} */ function execShellCommand(cmd) { const exec = require('child_process').exec; return new Promise((resolve, reject) => { exec(cmd, (error, stdout, stderr) => { if (error) { console.warn(error); } resolve(stdout ? stdout : stderr); }); }); } async function checkBackup() { try { //hier mount-Kommando await execShellCommand(mountCmd); let result = await NewestFile(mountDir); let seconds = (new Date().getTime() - new Date(result.age).getTime()) / 1000; if (seconds > warnSeconds) { console.log(`newest file "${result.file}" created before ${seconds} seconds`); // Mail abschicken console.log('Send Mail'); } //hier umount-Kommando await execShellCommand(umountCmd); } catch (e) { console.warn(e); } } // 22:30 schedule('30 22 * * *', () => { checkBackup(); });@ente34

Bitte entschuldigt die erneute späte Antwort. Ich bin wirklich schlimm! :)Habe mir das erste Skript schon etwas auf meine Bedürfnisse angepasst. Das gleiche musste ich mit dem zweiten nun auch tun und es FUNKTIONIERT TADELLOS :-)

Ich habe mir nun für mehrere Ordner und Dateien unterschiedliche Skripte zusammengebaut, die ich hinterinander laufen lasse.

Das passt für mich nun hervorragend.

An der Stelle möchte ich mich recht herzlich für eure konstruktive Vorschläge bedanken. Auch Dir @ente34 herzlichen Dank für die Mühe und Zeit.

Bin sehr happy über das Ergebnis :)

-

@ente34

Bitte entschuldigt die erneute späte Antwort. Ich bin wirklich schlimm! :)Habe mir das erste Skript schon etwas auf meine Bedürfnisse angepasst. Das gleiche musste ich mit dem zweiten nun auch tun und es FUNKTIONIERT TADELLOS :-)

Ich habe mir nun für mehrere Ordner und Dateien unterschiedliche Skripte zusammengebaut, die ich hinterinander laufen lasse.

Das passt für mich nun hervorragend.

An der Stelle möchte ich mich recht herzlich für eure konstruktive Vorschläge bedanken. Auch Dir @ente34 herzlichen Dank für die Mühe und Zeit.

Bin sehr happy über das Ergebnis :)

@tomily

Hey zusammen,habe die Skripte nun einige Zeit am laufen. Funktioniert super und hab mich schon mehrmals auf nicht mehr funktionierende Backups hingewiesen :-)

ZIEL ERREICHT =)

Eine Frage bzw. weitere Idee habe ich noch:

Kann ich das Skript auch "umdrehen", sodass auf NEUE DATEIEN geprüft wird?

Also: Verzeichniss sollte immer leer sein und sobald eine oder mehrer Dateien drin liegen, wird ausgelöst?Muss ich nur die Abfrage nach Zeit umdrehen?

Beste Grüße

Tom -

@tomily

Hey zusammen,habe die Skripte nun einige Zeit am laufen. Funktioniert super und hab mich schon mehrmals auf nicht mehr funktionierende Backups hingewiesen :-)

ZIEL ERREICHT =)

Eine Frage bzw. weitere Idee habe ich noch:

Kann ich das Skript auch "umdrehen", sodass auf NEUE DATEIEN geprüft wird?

Also: Verzeichniss sollte immer leer sein und sobald eine oder mehrer Dateien drin liegen, wird ausgelöst?Muss ich nur die Abfrage nach Zeit umdrehen?

Beste Grüße

Tom@tomily

Das geht leider nicht. Ich habe das Script mal erweitert,

Du musst chkDirNotEmpty() oder chkDirTreeNotEmpty() benutzen, je nachdem, ob Du ein einzelnes Directory oder rekursiv den ganzen Baum absuchen willstconst fs = require('fs'); const util = require('util'); const readdir = util.promisify(fs.readdir); const stat = util.promisify(fs.stat); const lstat = util.promisify(fs.lstat); const mountDir = '/home/pi/mount'; const nasDir = '//nas02/backup/raspi-iobroker/backitup'; const mountCmd = `sudo mount -t cifs -o username=rsync,password=...,vers=3.0 ${nasDir} ${mountDir}`; const umountCmd = `sudo umount ${nasDir}`; const warnSeconds = 5 * 86400; async function NewestFile(dir) { let newestFileAge = 0; let newestFile = ''; //console.log('### '+dir); try { let files = []; files = await readdir(dir); for (let file of files) { let fullpath = dir + '/' + file; const s = await lstat(fullpath); if (s.isFile()) { const stats = await stat(fullpath); if (stats.mtimeMs > newestFileAge) { newestFileAge = stats.mtimeMs; newestFile = file; } } else { let values = await NewestFile(fullpath); if (values.age > newestFileAge) { newestFileAge = values.age; newestFile = values.file; } } } } catch (e) { console.log(e); } finally { return { file: newestFile, age:newestFileAge }; } } async function chkDirNotEmpty(dir) { let files = await readdir(dir); if ( files.length ){ return files[0]; } return ""; } async function chkDirTreeNotEmpty(dir) { let foundFile = ''; try { let files = []; files = await readdir(dir); for (let file of files) { let fullpath = dir + '/' + file; const s = await lstat(fullpath); if (s.isFile()) { foundFile = fullpath; break; } else { let rc = await chkDirTreeNotEmpty(fullpath); if (rc != "") { foundFile = rc; break; } } } } catch (e) { console.log(e); } finally { return foundFile; } } /** * Executes a shell command and return it as a Promise. * @param cmd {string} * @return {Promise<string>} */ function execShellCommand(cmd) { const exec = require('child_process').exec; return new Promise((resolve, reject) => { exec(cmd, (error, stdout, stderr) => { if (error) { console.warn(error); } resolve(stdout ? stdout : stderr); }); }); } async function checkBackup() { try { //hier mount-Kommando await execShellCommand(mountCmd); //Nach leeren Directory suchen (nicht rekursiv, gefunden werden Files oder Directories) let file = await chkDirNotEmpty(mountDir); //Nach Files im Directory-Tree suchen (rekursiv) //file = await chkDirTreeNotEmpty(mountDir); if (file != "") { console.log(`directory tree ${mountDir} not empty, found file "${file}" `); // Mail abschicken console.log('Send Mail'); } let result = await NewestFile(mountDir); let seconds = (new Date().getTime() - new Date(result.age).getTime()) / 1000; if (seconds > warnSeconds) { console.log(`newest file "${result.file}" created before ${seconds} seconds`); // Mail abschicken console.log('Send Mail'); } //hier umount-Kommando await execShellCommand(umountCmd); } catch (e) { console.warn(e); } } // 22:30 schedule('30 22 * * *', () => { checkBackup(); }); checkBackup(); -

Hallo zusammen,

hat jemand eine Idee, wie ich folgendes realisieren kann?

Ich möchte diverse Unterordner meiner NAS auf neue Dateien überprüfen.

In den Ordnern liegen unterschiedlich viele Dateien und unterschiedliche Dateitypen.Ziel ist es, eine Email auszulösen, wenn die neueste Datei im Verzeichnis älter ist, als X-Tage.

Damit möchte ich erreichen, dass mir zukünftig auffällt, wenn Datensicherungen nicht mehr erstellt werden.

Hat jemand eine Idee oder zufällig schon ein fertiges Skript für diesen Monitoring-Zweck?

Grüße

@tomily sagte in Ordner auf neue Dateien überwachen:

Hallo zusammen,

hat jemand eine Idee, wie ich folgendes realisieren kann?

Ich möchte diverse Unterordner meiner NAS auf neue Dateien überprüfen.

In den Ordnern liegen unterschiedlich viele Dateien und unterschiedliche Dateitypen.Ziel ist es, eine Email auszulösen, wenn die neueste Datei im Verzeichnis älter ist, als X-Tage.

Damit möchte ich erreichen, dass mir zukünftig auffällt, wenn Datensicherungen nicht mehr erstellt werden.

Hat jemand eine Idee oder zufällig schon ein fertiges Skript für diesen Monitoring-Zweck?

Grüße

Warum nimmst du nicht eine Standard Bibliothek von Node?

Diese hat Cross Platform Support und funktioniert also für win linux und macos

35 mio downloads pro Woche können nicht irren

https://www.npmjs.com/package/chokidar