NEWS

[Linux Shell-Skript] WLAN-Wetterstation

-

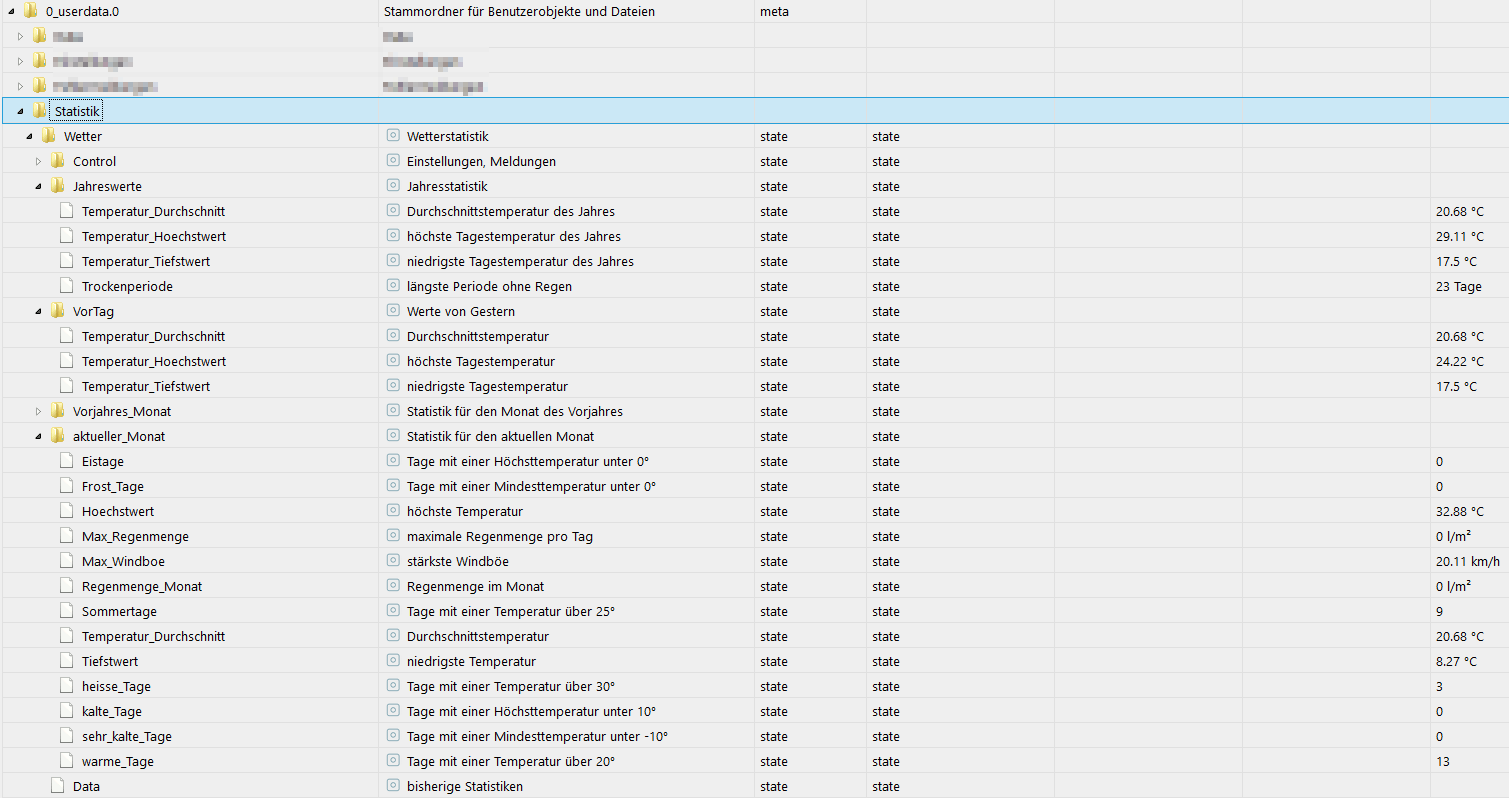

@sborg Ich brauche nochmals eure Hilfe: Ich hatte vor, meine Datenbanken etwas zu säubern. 'Jetzt' gibt es ja die longtermBuckets und die shorttermBuckets. Gibt es eine Übersicht, welche Datenpunkte ins long müssen und welche nicht? Dann noch die anschließende Frage: in der wetterstation.conf muss ich ja ein Bucket angeben, damit bestimmte Werte aus der Influx geholt werden können. Muss der Bezug dann hier auf shorttermBucket stehen?

@rene55

Prinzipiell kannst du das erst mal handeln wie du willst. Der Gedanke war dabei die Daten 1 Jahr vorzuhalten. Länger fragt das WLAN-Skript auch keine Daten ab ("Temperatur vor einem Jahr").

Alles was man darüber hinaus behalten wollte sollte dann ins Longterm.Das Konstrukt ist aber offen gestanden suboptimal (ich nutze es selbst nicht mehr). Hier sind die Influx-Tasks mit aggregieren deutlich besser. Ich weiß meine Zeiträume gerade nicht auswendig, aber bspw. eine "Windrichtung" braucht man kaum aufheben. Die wird aber im ~30 Sekundenraster (halt Sendeintervall der Station) geloggt und belegt nur Platz. Wer braucht denn aktuell die Windrichtung vom 29. November 2023 um 11:52:33 Uhr? Also schmeiße ich die per Task (glaube 7 Tage) kpl. aus der DB raus. Auch die Temperatur ist jetzt (mir) nicht sooo wichtig, als dass ich die Ewigkeiten bräuchte. Sie ändert sich ja auch nicht alle 30 Sekunden. Also aggregiere ich einen 15 Minutenmittelwert der Temperatur und schrinke die DB um das 30-fache oder von 30 Datensätzen auf einen. Da kann ich sie auch länger aufheben und dann zB. nach 365 Tagen auch sagen "aggregiere" jetzt auf eine Stunde. Dann habe ich nur noch 24 Datensätze pro Tag.

Der Bezug in der conf muss halt auf das Bucket verweisen welches zumindest für 365 Tage Daten vorhält. Ob die "roh" sind oder bereits aggregiert sind ist dabei unerheblich. Ich lese immer dynamisch so viele Datensätze ein wie vorhanden sind ;)

-

@rene55

Prinzipiell kannst du das erst mal handeln wie du willst. Der Gedanke war dabei die Daten 1 Jahr vorzuhalten. Länger fragt das WLAN-Skript auch keine Daten ab ("Temperatur vor einem Jahr").

Alles was man darüber hinaus behalten wollte sollte dann ins Longterm.Das Konstrukt ist aber offen gestanden suboptimal (ich nutze es selbst nicht mehr). Hier sind die Influx-Tasks mit aggregieren deutlich besser. Ich weiß meine Zeiträume gerade nicht auswendig, aber bspw. eine "Windrichtung" braucht man kaum aufheben. Die wird aber im ~30 Sekundenraster (halt Sendeintervall der Station) geloggt und belegt nur Platz. Wer braucht denn aktuell die Windrichtung vom 29. November 2023 um 11:52:33 Uhr? Also schmeiße ich die per Task (glaube 7 Tage) kpl. aus der DB raus. Auch die Temperatur ist jetzt (mir) nicht sooo wichtig, als dass ich die Ewigkeiten bräuchte. Sie ändert sich ja auch nicht alle 30 Sekunden. Also aggregiere ich einen 15 Minutenmittelwert der Temperatur und schrinke die DB um das 30-fache oder von 30 Datensätzen auf einen. Da kann ich sie auch länger aufheben und dann zB. nach 365 Tagen auch sagen "aggregiere" jetzt auf eine Stunde. Dann habe ich nur noch 24 Datensätze pro Tag.

Der Bezug in der conf muss halt auf das Bucket verweisen welches zumindest für 365 Tage Daten vorhält. Ob die "roh" sind oder bereits aggregiert sind ist dabei unerheblich. Ich lese immer dynamisch so viele Datensätze ein wie vorhanden sind ;)

@sborg sagte in [Linux Shell-Skript] WLAN-Wetterstation:

Also schmeiße ich die per Task (glaube 7 Tage) kpl. aus der DB raus

kannst du das genauer erklären?

Hab mir dazu schon öfter was im Netz gesucht. Aber so richtig schlau, wie wo was konfiguriert werden muss, hab ich nichts vernünftiges gefunden.

-

@rene55

Prinzipiell kannst du das erst mal handeln wie du willst. Der Gedanke war dabei die Daten 1 Jahr vorzuhalten. Länger fragt das WLAN-Skript auch keine Daten ab ("Temperatur vor einem Jahr").

Alles was man darüber hinaus behalten wollte sollte dann ins Longterm.Das Konstrukt ist aber offen gestanden suboptimal (ich nutze es selbst nicht mehr). Hier sind die Influx-Tasks mit aggregieren deutlich besser. Ich weiß meine Zeiträume gerade nicht auswendig, aber bspw. eine "Windrichtung" braucht man kaum aufheben. Die wird aber im ~30 Sekundenraster (halt Sendeintervall der Station) geloggt und belegt nur Platz. Wer braucht denn aktuell die Windrichtung vom 29. November 2023 um 11:52:33 Uhr? Also schmeiße ich die per Task (glaube 7 Tage) kpl. aus der DB raus. Auch die Temperatur ist jetzt (mir) nicht sooo wichtig, als dass ich die Ewigkeiten bräuchte. Sie ändert sich ja auch nicht alle 30 Sekunden. Also aggregiere ich einen 15 Minutenmittelwert der Temperatur und schrinke die DB um das 30-fache oder von 30 Datensätzen auf einen. Da kann ich sie auch länger aufheben und dann zB. nach 365 Tagen auch sagen "aggregiere" jetzt auf eine Stunde. Dann habe ich nur noch 24 Datensätze pro Tag.

Der Bezug in der conf muss halt auf das Bucket verweisen welches zumindest für 365 Tage Daten vorhält. Ob die "roh" sind oder bereits aggregiert sind ist dabei unerheblich. Ich lese immer dynamisch so viele Datensätze ein wie vorhanden sind ;)

@sborg Danke für die schnellen Antworten. Ja sicher, ob der Wind vor nem Jahr aus Osten kam ist sicher nicht wichtig. Ich hatte mich anhand des Dashboards hier angenähert. Da sah ich eigentlich nur vier Datenpunkte, die im long waren (Aussentemperatur, Temperatur_außen_Max_24h, Temperatur_außen_Min_24h und Solarenergie_Vortag). Wobei die Werte möglicherweise ja auch ins short könnten - oder liege ich da falsch? Welchen Ansatz verfolgst du denn, um den überflüssigen Datensalat zu entsorgen?

-

@rene55

Prinzipiell kannst du das erst mal handeln wie du willst. Der Gedanke war dabei die Daten 1 Jahr vorzuhalten. Länger fragt das WLAN-Skript auch keine Daten ab ("Temperatur vor einem Jahr").

Alles was man darüber hinaus behalten wollte sollte dann ins Longterm.Das Konstrukt ist aber offen gestanden suboptimal (ich nutze es selbst nicht mehr). Hier sind die Influx-Tasks mit aggregieren deutlich besser. Ich weiß meine Zeiträume gerade nicht auswendig, aber bspw. eine "Windrichtung" braucht man kaum aufheben. Die wird aber im ~30 Sekundenraster (halt Sendeintervall der Station) geloggt und belegt nur Platz. Wer braucht denn aktuell die Windrichtung vom 29. November 2023 um 11:52:33 Uhr? Also schmeiße ich die per Task (glaube 7 Tage) kpl. aus der DB raus. Auch die Temperatur ist jetzt (mir) nicht sooo wichtig, als dass ich die Ewigkeiten bräuchte. Sie ändert sich ja auch nicht alle 30 Sekunden. Also aggregiere ich einen 15 Minutenmittelwert der Temperatur und schrinke die DB um das 30-fache oder von 30 Datensätzen auf einen. Da kann ich sie auch länger aufheben und dann zB. nach 365 Tagen auch sagen "aggregiere" jetzt auf eine Stunde. Dann habe ich nur noch 24 Datensätze pro Tag.

Der Bezug in der conf muss halt auf das Bucket verweisen welches zumindest für 365 Tage Daten vorhält. Ob die "roh" sind oder bereits aggregiert sind ist dabei unerheblich. Ich lese immer dynamisch so viele Datensätze ein wie vorhanden sind ;)

-

@sborg Da ich gerade so schön tief im Dashboard stecke. Welcher Adapter liefert denn die Ozon-Werte?

-

@latzi Danke dafür! Jetzt habe ich auch Ozon-Werte. Hast du das Wetterstation-Dashboard_V3 am laufen? Ich hab da einige leere und blöd aussehende Felder drin.

-

@rene55 sagte in [Linux Shell-Skript] WLAN-Wetterstation:

Wetterstation-Dashboard_V3

nein, verwende ich nicht!

-

@latzi Danke dafür! Jetzt habe ich auch Ozon-Werte. Hast du das Wetterstation-Dashboard_V3 am laufen? Ich hab da einige leere und blöd aussehende Felder drin.

@rene55 sagte in [Linux Shell-Skript] WLAN-Wetterstation:

@latzi Danke dafür! Jetzt habe ich auch Ozon-Werte. Hast du das Wetterstation-Dashboard_V3 am laufen? Ich hab da einige leere und blöd aussehende Felder drin.

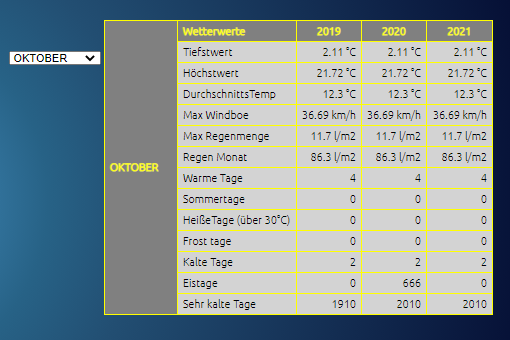

Wenn du sie füllen willst dann sag doch mal welche fehlen. Das Dashboard hatte ich für mich erstellt, wurde dann aber gebeten es öffentlich zu stellen. Deswegen sind da auch Dinge drin wie bspw. "Ozon" was überhaupt nichts mit dem WLAN-Skript zu tun hat. Ein oder zwei Dinge basieren auch auf einem JS (glaube Temperatur in 3 Stunden).

Solange es im Thema "Wetter" bleibt habe ich hier auch keine Probleme mit Fragen über Grafana/Influx, nur keine allgemeine Fragen diesbzgl. wie zB. "wie komme ich denn in Influx an die Daten meines Smartmeters..."

-

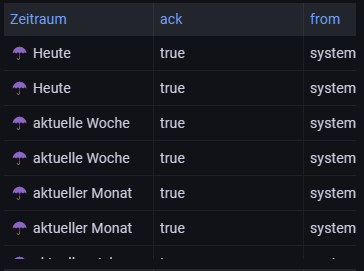

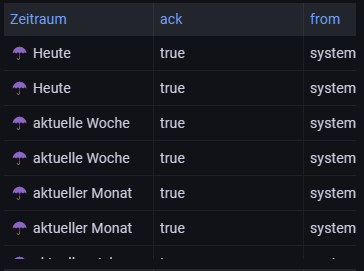

@sborg Besten Dank. Auch dafür, dass du das .json veröffentlicht hast. Vorweg: das alte Dashboard mit Influx1 habe ich derzeit auch noch laufen. Aber ich möchte den alten Ballast mal abwerfen. Ja konkret Ozon bekomme ich jetzt wahrscheinlich hin. Stimmt auch "Temperatur in 3 Stunden" fehlt (oder würde mir fehlen). Dann habe ich genau unter UV Index ein Panel, in dem keine Abfrage drin ist. OK, könnte ich löschen. Der größte Missstand ist der, dass ich z.B beim Regen dieses sehe:

Ich denke, ich hab da auch noch ein grundlegendes Problem mit Mehrfachdaten.

-

@sborg sagte in [Linux Shell-Skript] WLAN-Wetterstation:

Also schmeiße ich die per Task (glaube 7 Tage) kpl. aus der DB raus

kannst du das genauer erklären?

Hab mir dazu schon öfter was im Netz gesucht. Aber so richtig schlau, wie wo was konfiguriert werden muss, hab ich nichts vernünftiges gefunden.

@negalein sagte in [Linux Shell-Skript] WLAN-Wetterstation:

@sborg sagte in [Linux Shell-Skript] WLAN-Wetterstation:

Also schmeiße ich die per Task (glaube 7 Tage) kpl. aus der DB raus

kannst du das genauer erklären?

Hab mir dazu schon öfter was im Netz gesucht. Aber so richtig schlau, wie wo was konfiguriert werden muss, hab ich nichts vernünftiges gefunden.

+ @Rene55

Da wirst du so auch nichts "gutes" finden, denn Flux beherrscht kein "drop" von Datenreihen. Mit einem einfachen Task ist da nichts zu machen. Meine Lösung war (ich nutze sie auch nicht mehr) weder richtig praktikabel, geschweige denn massentauglich. Das war auslagern der gewünschten Daten, kpl. Reihe droppen und die ausgelagerte wieder importieren.

Sehr, sehr System lastig und durch den Im- und Export gehen auch definitiv Daten verloren, da alles was in dem Zeitraum Export - droppen - Import in die InfluxDB an neuen Daten geschrieben wird geht unweigerlich den Weg ins Nirvana.Aus Zeitmangel speichere ich aktuell einfach alles. Mein NAS hat im Moment 20TB, da ist noch Platz (auch für zusätzliche HDDs).

Der Zukunftsplan sieht dann aggregieren vor wo es Sinn macht (Temperatur genügt IMO alle 15 Minuten ein Messwert) und leider per Bash-Skript und Cronjob dann droppen der nicht benötigten Daten per Influx-CLI. Eine andere praktikable Lösung sehe ich aktuell nicht. Das Hauptproblem dabei ist, man kann halt nicht das aktuelle Bucket bearbeiten. Man muss immer alles in ein anderes Bucket schreiben. Verweist man bei Grafana auf das "neue" Bucket fehlen aktuelle Daten (außer man lässt den Task alle x Minuten laufen), nimmt man das "aktuelle" Bucket muss man die Daten in diesem auch zumindest für 365 Tage vorhalten :( -

@negalein sagte in [Linux Shell-Skript] WLAN-Wetterstation:

@sborg sagte in [Linux Shell-Skript] WLAN-Wetterstation:

Also schmeiße ich die per Task (glaube 7 Tage) kpl. aus der DB raus

kannst du das genauer erklären?

Hab mir dazu schon öfter was im Netz gesucht. Aber so richtig schlau, wie wo was konfiguriert werden muss, hab ich nichts vernünftiges gefunden.

+ @Rene55

Da wirst du so auch nichts "gutes" finden, denn Flux beherrscht kein "drop" von Datenreihen. Mit einem einfachen Task ist da nichts zu machen. Meine Lösung war (ich nutze sie auch nicht mehr) weder richtig praktikabel, geschweige denn massentauglich. Das war auslagern der gewünschten Daten, kpl. Reihe droppen und die ausgelagerte wieder importieren.

Sehr, sehr System lastig und durch den Im- und Export gehen auch definitiv Daten verloren, da alles was in dem Zeitraum Export - droppen - Import in die InfluxDB an neuen Daten geschrieben wird geht unweigerlich den Weg ins Nirvana.Aus Zeitmangel speichere ich aktuell einfach alles. Mein NAS hat im Moment 20TB, da ist noch Platz (auch für zusätzliche HDDs).

Der Zukunftsplan sieht dann aggregieren vor wo es Sinn macht (Temperatur genügt IMO alle 15 Minuten ein Messwert) und leider per Bash-Skript und Cronjob dann droppen der nicht benötigten Daten per Influx-CLI. Eine andere praktikable Lösung sehe ich aktuell nicht. Das Hauptproblem dabei ist, man kann halt nicht das aktuelle Bucket bearbeiten. Man muss immer alles in ein anderes Bucket schreiben. Verweist man bei Grafana auf das "neue" Bucket fehlen aktuelle Daten (außer man lässt den Task alle x Minuten laufen), nimmt man das "aktuelle" Bucket muss man die Daten in diesem auch zumindest für 365 Tage vorhalten :(@sborg Das hört sich für mich gerade so an, als ob das aufspalten in long/short eigentlich gar nichts bringt.

Ergo: speichern bis die Platte voll ist; ja oder bis kurz davor, damit man noch was retten kann. Oder einen Fummel schreiben, der aus dem Datenwust, irgendetwas komprimiertes macht. Noch keine Ahnung, was das sein könnte. -

@sborg Besten Dank. Auch dafür, dass du das .json veröffentlicht hast. Vorweg: das alte Dashboard mit Influx1 habe ich derzeit auch noch laufen. Aber ich möchte den alten Ballast mal abwerfen. Ja konkret Ozon bekomme ich jetzt wahrscheinlich hin. Stimmt auch "Temperatur in 3 Stunden" fehlt (oder würde mir fehlen). Dann habe ich genau unter UV Index ein Panel, in dem keine Abfrage drin ist. OK, könnte ich löschen. Der größte Missstand ist der, dass ich z.B beim Regen dieses sehe:

Ich denke, ich hab da auch noch ein grundlegendes Problem mit Mehrfachdaten.

@rene55

Jupp, da fehlt wohl bisserl was beim Regen. Irgendwie finde ich im neuen Grafana gerade nicht den JSON-Export für ein Panel...

Hier ist mal mein JSON, allerdings müsstest du da überall die"uid": "ssI1YtJ4z"durch die UID deiner InfluxDB vor dem Import ersetzen.

Temperatur in 3h geht über den Adapter "Das Wetter" und ein kleines JS:

const idTemp = '0_userdata.0.Data.Temperatur_in_3h'; if (!existsState(idTemp)) { createState(idTemp, 0, { name: "erwartete Aussentemperatur in 3 Stunden", type: "number", role: "state", unit: "°C" }); } schedule('2 * * * *', function () { let hours3 = new Date().getHours() + 3; let id = 'daswetter.0.NextHours.Location_1.Day_1.Hour_' + hours3 + '.temp_value'; if(hours3 > 24) { hours3 -= 24; id = 'daswetter.0.NextHours.Location_1.Day_2.Hour_' + hours3 + '.temp_value'; } setState(idTemp, getState(id).val, true); });Das leere Panel unter UV-Index existiert bei mir nicht mehr, aber das könnte das Panel für das "Boom-Theme" sein. Das ist eigentlich auf unsichtbar gestellt, darüber kann man aber das Hintergrundbild auswählen.

Mit dem long/short bin ich noch unschlüssig. Eine Idee wäre in ein "Tages-Bucket" zu schreiben. Hierauf würden dann aktuelle Werte von Grafana (short) verweisen. Per Tasks wird dann alles kopiert, aggregiert und ins long geshifftet. Hierauf verweist dann Grafana auf alles was eben nicht "heute" ist (zB. Temperaturgraf der letzten 365 Tage).

Die Retention für dieses "Tages-Bucket" könnte dann bspw. 5 Tage sein, sprich alles älter als 5 Tage wird automatisch aus diesem Bucket gelöscht. Deswegen ist die Idee mit mehreren Buckets nicht abwegig, da man pro Bucket die Retention wählen kann ;) -

@rene55

Jupp, da fehlt wohl bisserl was beim Regen. Irgendwie finde ich im neuen Grafana gerade nicht den JSON-Export für ein Panel...

Hier ist mal mein JSON, allerdings müsstest du da überall die"uid": "ssI1YtJ4z"durch die UID deiner InfluxDB vor dem Import ersetzen.

Temperatur in 3h geht über den Adapter "Das Wetter" und ein kleines JS:

const idTemp = '0_userdata.0.Data.Temperatur_in_3h'; if (!existsState(idTemp)) { createState(idTemp, 0, { name: "erwartete Aussentemperatur in 3 Stunden", type: "number", role: "state", unit: "°C" }); } schedule('2 * * * *', function () { let hours3 = new Date().getHours() + 3; let id = 'daswetter.0.NextHours.Location_1.Day_1.Hour_' + hours3 + '.temp_value'; if(hours3 > 24) { hours3 -= 24; id = 'daswetter.0.NextHours.Location_1.Day_2.Hour_' + hours3 + '.temp_value'; } setState(idTemp, getState(id).val, true); });Das leere Panel unter UV-Index existiert bei mir nicht mehr, aber das könnte das Panel für das "Boom-Theme" sein. Das ist eigentlich auf unsichtbar gestellt, darüber kann man aber das Hintergrundbild auswählen.

Mit dem long/short bin ich noch unschlüssig. Eine Idee wäre in ein "Tages-Bucket" zu schreiben. Hierauf würden dann aktuelle Werte von Grafana (short) verweisen. Per Tasks wird dann alles kopiert, aggregiert und ins long geshifftet. Hierauf verweist dann Grafana auf alles was eben nicht "heute" ist (zB. Temperaturgraf der letzten 365 Tage).

Die Retention für dieses "Tages-Bucket" könnte dann bspw. 5 Tage sein, sprich alles älter als 5 Tage wird automatisch aus diesem Bucket gelöscht. Deswegen ist die Idee mit mehreren Buckets nicht abwegig, da man pro Bucket die Retention wählen kann ;)@sborg Mega Danke. Ich werde mich jetzt erstmal um die uid kümmern und dein Script einbauen. Damit komme ich bestimmt weiter. (Hab aber bestimmt noch weitere Fragen) :blush:

Tasks wird dann alles kopiert, aggregiert und ins long geshifftet das wäre sowas, wie ich oben den Fummel betitelt hatte. -

@SBorg

welchen Adapter nutzt du für die Ozonwerte? -

@nashra

Keinen, mir ist auch keiner bekannt, ich nutze (wie bei mir fast üblich :blush: ) ein Linux Shell-Skript.

Bevor nun wieder die Frage kommt: nein, das kann ich schlecht zur Verfügung stellen, da es die Daten vom HLNUG bezieht und somit nur für Hessen gültig ist.Weil aber bestimmt hier wieder Begehrlichkeiten geweckt wurden (nehme ich mal an :innocent: ), habe ich mir heute morgen mal Gedanken gemacht und bin auf die Suche gegangen.

Übrig bleibt eigentlich nur das "Umwelt Bundesamt", da es für ganz Deutschland Daten liefert (sry @Negalein), auch kleinere Stationen. Leider keine API verfügbar und https://www.umweltbundesamt.de/daten/luft/luftdaten/luftqualitaet/ verlangt das ausfüllen der gewünschten Daten (ist hier nicht einfach zu automatisieren, da darüber ein Einmal-Token generiert wird).

Aber wird sind ja nicht blöd :joy:

Über die "Stationen" kommen wir zwar zu einer ähnlichen Eingabemaske, aber nach dem ausfüllen erhalten wir einen nutzbaren Link "Station herunterladen". Per MouseOver erkennen wir nun auch einen für uns nutzbaren Link 8)

Beispiel:https://www.umweltbundesamt.de/api/air_data/v3/measures/csv?date_from=2024-01-18&time_from=11&date_to=2024-01-18&time_to=11&data%5B0%5D%5Bco%5D=3&data%5B0%5D%5Bsc%5D=2&data%5B0%5D%5Bst%5D=533&lang=de

Also doch eine (nicht öffentliche) API. Die Daten könnte ich automatisieren, man muss es nur einmalig per Frontend ausfüllen damit man seine StationID bekommt. In der heruntergeladenen CSV steht dann der Ozonwert drin :grinning: -

@nashra

Keinen, mir ist auch keiner bekannt, ich nutze (wie bei mir fast üblich :blush: ) ein Linux Shell-Skript.

Bevor nun wieder die Frage kommt: nein, das kann ich schlecht zur Verfügung stellen, da es die Daten vom HLNUG bezieht und somit nur für Hessen gültig ist.Weil aber bestimmt hier wieder Begehrlichkeiten geweckt wurden (nehme ich mal an :innocent: ), habe ich mir heute morgen mal Gedanken gemacht und bin auf die Suche gegangen.

Übrig bleibt eigentlich nur das "Umwelt Bundesamt", da es für ganz Deutschland Daten liefert (sry @Negalein), auch kleinere Stationen. Leider keine API verfügbar und https://www.umweltbundesamt.de/daten/luft/luftdaten/luftqualitaet/ verlangt das ausfüllen der gewünschten Daten (ist hier nicht einfach zu automatisieren, da darüber ein Einmal-Token generiert wird).

Aber wird sind ja nicht blöd :joy:

Über die "Stationen" kommen wir zwar zu einer ähnlichen Eingabemaske, aber nach dem ausfüllen erhalten wir einen nutzbaren Link "Station herunterladen". Per MouseOver erkennen wir nun auch einen für uns nutzbaren Link 8)

Beispiel:https://www.umweltbundesamt.de/api/air_data/v3/measures/csv?date_from=2024-01-18&time_from=11&date_to=2024-01-18&time_to=11&data%5B0%5D%5Bco%5D=3&data%5B0%5D%5Bsc%5D=2&data%5B0%5D%5Bst%5D=533&lang=de

Also doch eine (nicht öffentliche) API. Die Daten könnte ich automatisieren, man muss es nur einmalig per Frontend ausfüllen damit man seine StationID bekommt. In der heruntergeladenen CSV steht dann der Ozonwert drin :grinning:@sborg

nö lass mal, so wichtig ist das nicht. Aber trotzdem danke fürs suchen :-) -

@nashra

Keinen, mir ist auch keiner bekannt, ich nutze (wie bei mir fast üblich :blush: ) ein Linux Shell-Skript.

Bevor nun wieder die Frage kommt: nein, das kann ich schlecht zur Verfügung stellen, da es die Daten vom HLNUG bezieht und somit nur für Hessen gültig ist.Weil aber bestimmt hier wieder Begehrlichkeiten geweckt wurden (nehme ich mal an :innocent: ), habe ich mir heute morgen mal Gedanken gemacht und bin auf die Suche gegangen.

Übrig bleibt eigentlich nur das "Umwelt Bundesamt", da es für ganz Deutschland Daten liefert (sry @Negalein), auch kleinere Stationen. Leider keine API verfügbar und https://www.umweltbundesamt.de/daten/luft/luftdaten/luftqualitaet/ verlangt das ausfüllen der gewünschten Daten (ist hier nicht einfach zu automatisieren, da darüber ein Einmal-Token generiert wird).

Aber wird sind ja nicht blöd :joy:

Über die "Stationen" kommen wir zwar zu einer ähnlichen Eingabemaske, aber nach dem ausfüllen erhalten wir einen nutzbaren Link "Station herunterladen". Per MouseOver erkennen wir nun auch einen für uns nutzbaren Link 8)

Beispiel:https://www.umweltbundesamt.de/api/air_data/v3/measures/csv?date_from=2024-01-18&time_from=11&date_to=2024-01-18&time_to=11&data%5B0%5D%5Bco%5D=3&data%5B0%5D%5Bsc%5D=2&data%5B0%5D%5Bst%5D=533&lang=de

Also doch eine (nicht öffentliche) API. Die Daten könnte ich automatisieren, man muss es nur einmalig per Frontend ausfüllen damit man seine StationID bekommt. In der heruntergeladenen CSV steht dann der Ozonwert drin :grinning:@sborg

Doch öffentliche Api ;)

Git-Hub zur Luftqualität-Api des Bundes

Dokumentation der ApiBeispiel Daten für Ulm:

(https://umweltbundesamt.api.proxy.bund.dev/api/air_data/v2/airquality/json?date_from=2024-01-18&time_from=13&date_to=2024-01-18&time_to=13&station=228&lang=de){ "request": { "station": "228", "date_from": "2024-01-18", "date_to": "2024-01-18", "time_from": "13:00:00", "time_to": "13:00:00", "lang": "de", "index": "id", "datetime_from": "2024-01-18 12:00:00", "datetime_to": "2024-01-18 12:00:00" }, "data": { "228": { "2024-01-18 12:00:00": [ "2024-01-18 13:00:00", 1, 0, [ 3, 64, 1, "1.051" ], [ 5, 9, 0, "0.45" ], [ 1, 7, 0, "0.35" ] ] } }, "indices": { "data": { "Id of station - string": { "Date of measure start in CET - string": [ "0: Date of measure end in CET - string", "1: Airquality index for all components - integer", "2: Data incomplete (0|1) - integer", [ "0: Id of component id - integer", "1: Value - number", "2: Airquality index of this component- integer", "3: Decimal representation of Airquality index of this component - string" ] ] } } }, "count": 1 }=> 64 µg/m³ Ozon / 9 µg/m³ NO2 / 7 µg/m³ Feinstaub PM10

Man kann anstatt der 228 auch die von der Stationsseite den angezeigten Code DEBW019 der Station verwenden

Und anscheinend gibts auch schon ne Api v3

Da kommt bei der Station dann sogar ein PM2.5-Wert mit

-

@boronsbruder Das schreit ja förmlich nach einem neuen Adapter

-

@nashra

Keinen, mir ist auch keiner bekannt, ich nutze (wie bei mir fast üblich :blush: ) ein Linux Shell-Skript.

Bevor nun wieder die Frage kommt: nein, das kann ich schlecht zur Verfügung stellen, da es die Daten vom HLNUG bezieht und somit nur für Hessen gültig ist.Weil aber bestimmt hier wieder Begehrlichkeiten geweckt wurden (nehme ich mal an :innocent: ), habe ich mir heute morgen mal Gedanken gemacht und bin auf die Suche gegangen.

Übrig bleibt eigentlich nur das "Umwelt Bundesamt", da es für ganz Deutschland Daten liefert (sry @Negalein), auch kleinere Stationen. Leider keine API verfügbar und https://www.umweltbundesamt.de/daten/luft/luftdaten/luftqualitaet/ verlangt das ausfüllen der gewünschten Daten (ist hier nicht einfach zu automatisieren, da darüber ein Einmal-Token generiert wird).

Aber wird sind ja nicht blöd :joy:

Über die "Stationen" kommen wir zwar zu einer ähnlichen Eingabemaske, aber nach dem ausfüllen erhalten wir einen nutzbaren Link "Station herunterladen". Per MouseOver erkennen wir nun auch einen für uns nutzbaren Link 8)

Beispiel:https://www.umweltbundesamt.de/api/air_data/v3/measures/csv?date_from=2024-01-18&time_from=11&date_to=2024-01-18&time_to=11&data%5B0%5D%5Bco%5D=3&data%5B0%5D%5Bsc%5D=2&data%5B0%5D%5Bst%5D=533&lang=de

Also doch eine (nicht öffentliche) API. Die Daten könnte ich automatisieren, man muss es nur einmalig per Frontend ausfüllen damit man seine StationID bekommt. In der heruntergeladenen CSV steht dann der Ozonwert drin :grinning:@sborg sagte in [Linux Shell-Skript] WLAN-Wetterstation:

sry @Negalein)

No Problem.

Ich brauch Ozon nicht.

Wenn doch, verwende ich einen deutschen Ort.

Kann von Ö nach DE rüber spucken. :joy: :joy: