NEWS

Yet another HomeKit adapter 0.6.0-beta

-

Bei mir startet der 0.5.5 nicht mehr. Start datei nicht gefunden oder so ähnlich

Gesendet von iPhone mit Tapatalk

-

Probier mal bitte Beta 3 `

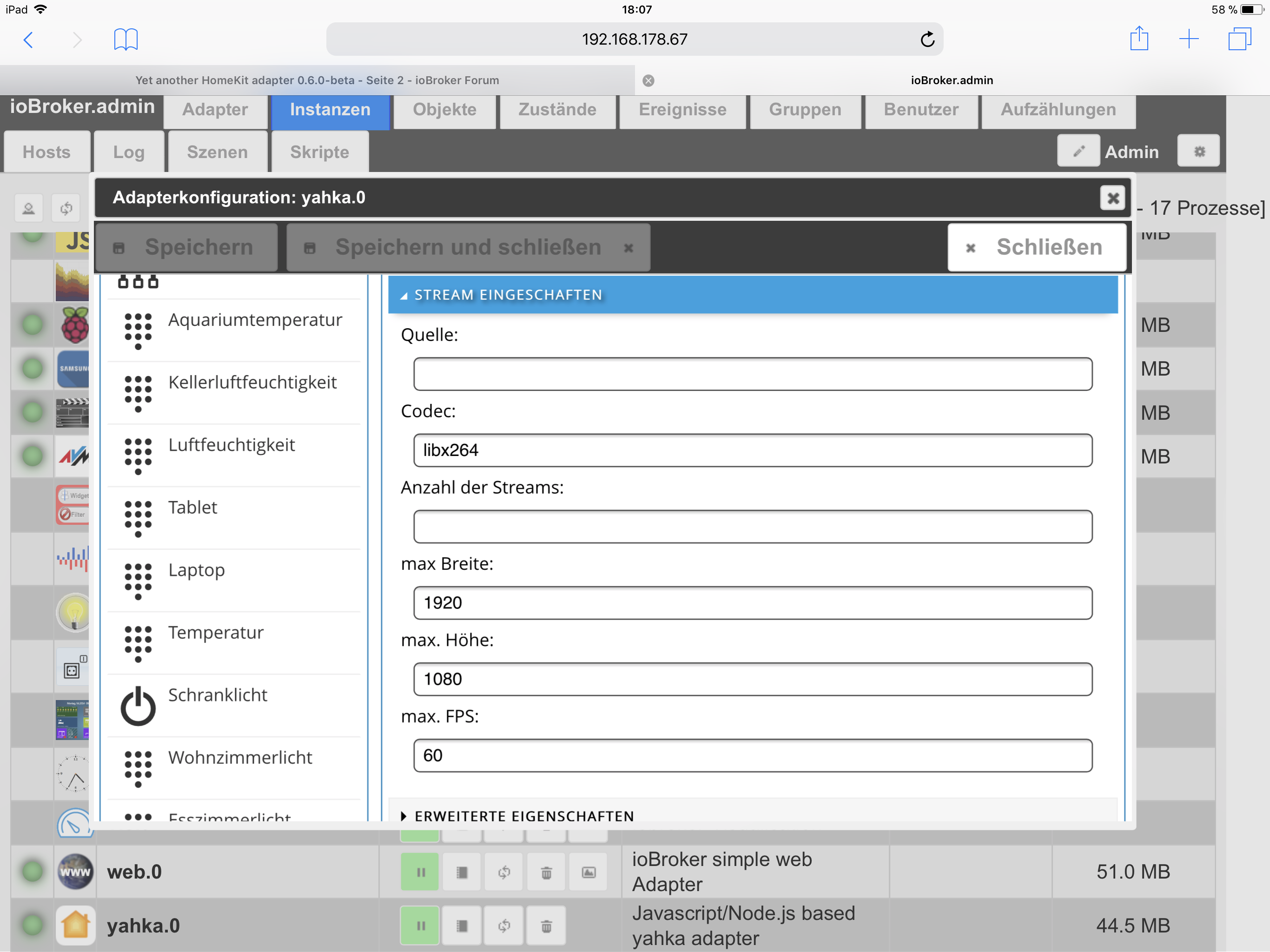

Mit beta3 geht das Hinzufügen der Kamera perfekt. Der Live Stream kann auch gestartet werden.

Nur das Standbild/Einzelbild wird nicht getriggert.

"Normalerweise" wird die Aktualisierung des Standbildes/Einzelbildes sofort bei dem Aufschalten der Kamera im HomeKit getriggert, dass hat man in der "geforkten" Variante am ffmpeg Aufruf im debug Modus gesehen. In der beta3 wird keine ffmpeg Aufruf für das Standbild/Einzelbild ausgegeben. Bei dem Livestram schon…

-

"Normalerweise" wird die Aktualisierung des Standbildes/Einzelbildes sofort bei dem Aufschalten der Kamera im HomeKit getriggert, dass hat man in der "geforkten" Variante am ffmpeg Aufruf im debug Modus gesehen. In der beta3 wird keine ffmpeg Aufruf für das Standbild/Einzelbild ausgegeben. Bei dem Livestram schon… `

Danke für den Hinweis. Mit Beta.4 wird nun auch das Standbild/Einzelbild abgerufen

-

Danke für den Hinweis. Mit Beta.4 wird nun auch das Standbild/Einzelbild abgerufen `

Danke für das schnelle Fixen. Folgenden Auffälligkeiten zur beta4:

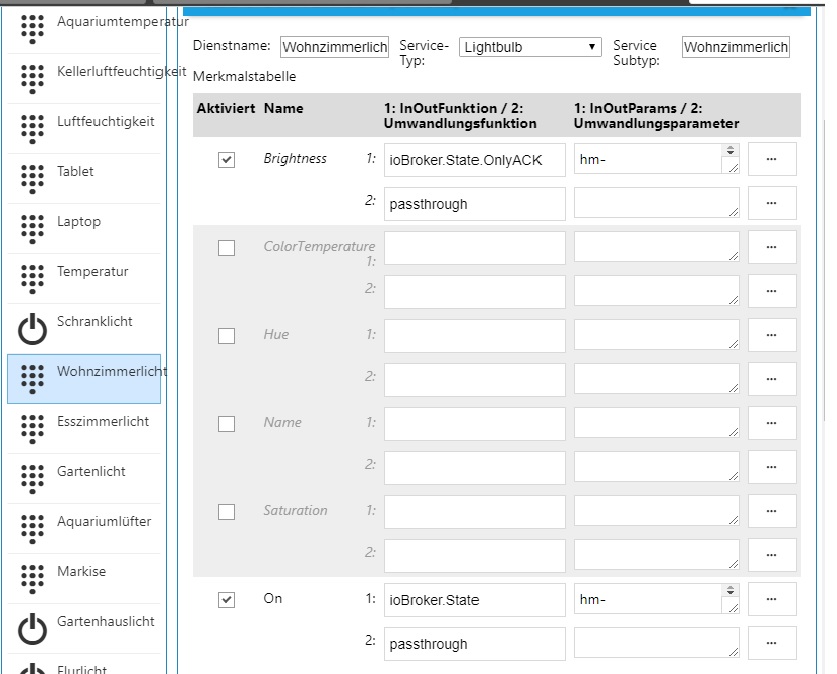

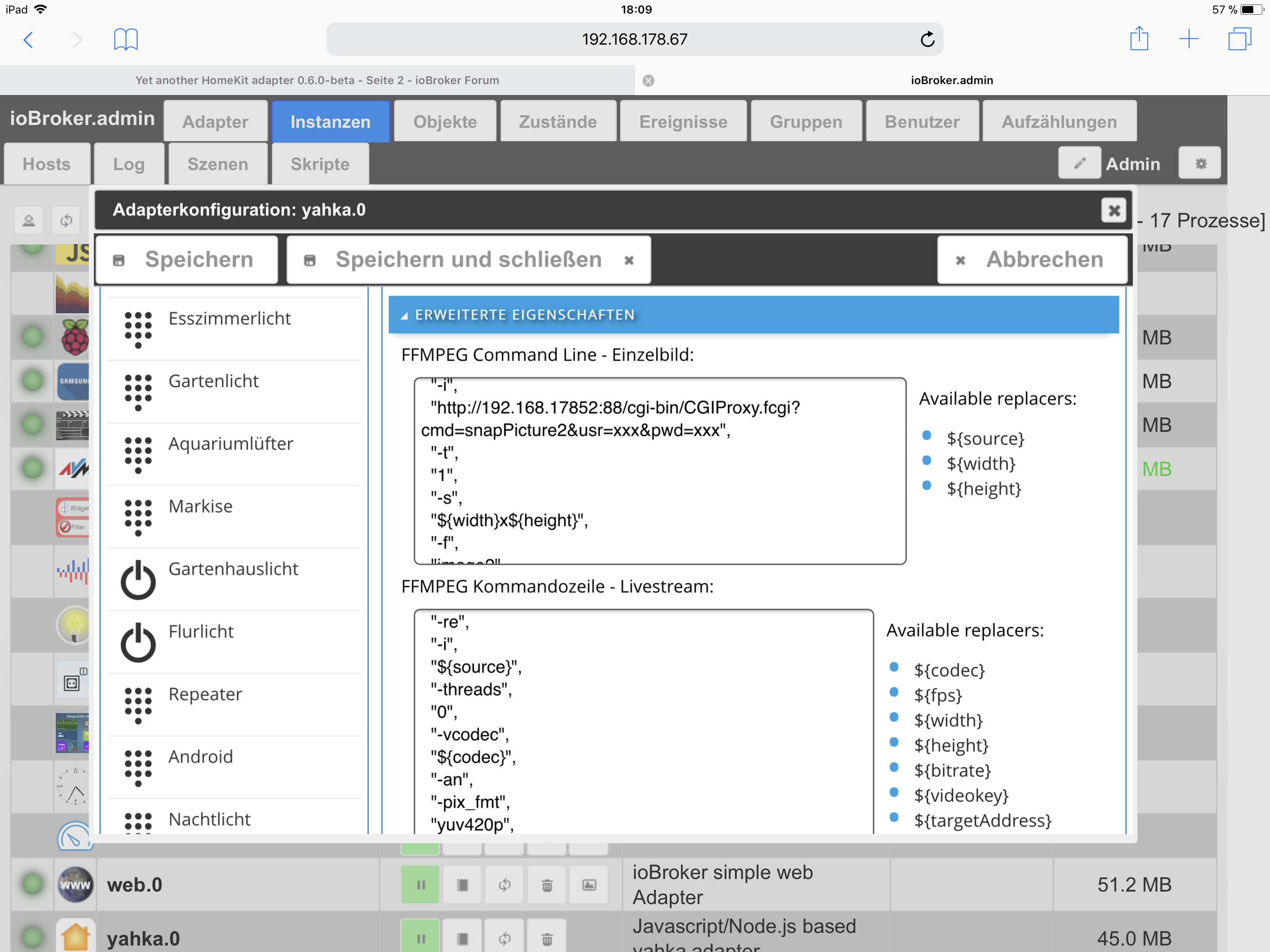

1. Bei "FFMPEG Command Line - Einzelbild:" ist "${resolution}" nicht definiert und sollte in der default Konfiguration durch "${width}x${height}" ersetzt werden. Sonst wird ffmpeg mit "-s undefined" aufgerufen.

2. Im Debug erscheint zwar nun das ffmpeg Kommando (Snapshot run: ffmpeg -re -ss 10 -i rtsp://user:pw@192.168.123.123:88/videoSub -t 1 -s 480x270 -f image2 -vframes 1 -) aber der Prozess wird nicht gestartet. Also ps ax zeigt kein ffmpeg Prozess an. Starte ich hingegen den Lifestream, ist bei ps ax der ffmpeg Prozess zu sehen.

3. Ich habe bei der Konfiguration folgenden eingetragen: Breite: 640, Höhe: 360. Beim Lifestream wird die Auflösung gemäß debug und Prozessliste übernommen. Hingegen beim Snapshot nicht. Da wird aus 640x360 ein 480x270. Ist das so gewollt?

-

Hallo,

hab auch mal auf 6.0Beta4 upgedatet.

Der Adapter läuft und sind keine Fehler im Log.

Allerdings ist die Auswahlliste immer noch die Alte, sind keine Neuen dabei

unter anderem fehlt die Camera Geschichte.

-

Hallo,

hab auch mal auf 6.0Beta4 upgedatet.

Der Adapter läuft und sind keine Fehler im Log.

Allerdings ist die Auswahlliste immer noch die Alte, sind keine Neuen dabei

unter anderem fehlt die Camera Geschichte. `

Versuch mal ein upload und danach yahka neu starten. Das hat bei mir geholfen.

-

Danke.

Ja, das hat geholfen.

-

Hallo,

hab auch mal auf 6.0Beta4 upgedatet.

Der Adapter läuft und sind keine Fehler im Log.

Allerdings ist die Auswahlliste immer noch die Alte, sind keine Neuen dabei

unter anderem fehlt die Camera Geschichte.

filename="Bild1.jpg" index="1">~~

filename="Bild2.jpg" index="0">~~ `

Das Bild der Admin-Oberfläche ist von 0.5.5, nicht von 0.6.0Wie hast du den Adapter installiert?

Gesendet von iPhone mit Tapatalk

-

Ich habe noch nicht die letzte Admin-Version, aber bei mir ist es das GitHub Zeichen um aus eigener Url zu installieren (links oben wenn man in der Übersicht der verfügbaren Adapter ist)

Gesendet von iPhone mit Tapatalk `

Hab das Problem gefunden. Er zeigt das Zeichen / Icon im Safari unter MacOs nicht an. Im Chrome erscheint das Icon….

Werde jetzt mal die Beta testen...

-

Hallo,

hab auch mal auf 6.0Beta4 upgedatet.

Der Adapter läuft und sind keine Fehler im Log.

Allerdings ist die Auswahlliste immer noch die Alte, sind keine Neuen dabei

unter anderem fehlt die Camera Geschichte.

Bild1.jpg

Bild2.jpg `

Das Bild der Admin-Oberfläche ist von 0.5.5, nicht von 0.6.0Wie hast du den Adapter installiert?

Gesendet von iPhone mit Tapatalk `

Ist alle ok jetzt.

Der Tip von Eumats mit Upload Button drücken hat funktioniert.

-

1. Bei "FFMPEG Command Line - Einzelbild:" ist "${resolution}" nicht definiert und sollte in der default Konfiguration durch "${width}x${height}" ersetzt werden. Sonst wird ffmpeg mit "-s undefined" aufgerufen. `

Das hatte ich vergessen zu erwähnen. In der Beta 4 ist der Standardwert geändert (wenn man eine neue Cam anlegt). Da du deine Kamera aber mit Beta 3 angelegt hast, hast du noch die falsche Kommandozeile.2. Im Debug erscheint zwar nun das ffmpeg Kommando (Snapshot run: ffmpeg -re -ss 10 -i rtsp://user:pw@192.168.123.123:88/videoSub -t 1 -s 480x270 -f image2 -vframes 1 -) aber der Prozess wird nicht gestartet. Also ps ax zeigt kein ffmpeg Prozess an. Starte ich hingegen den Lifestream, ist bei ps ax der ffmpeg Prozess zu sehen. `

Ich denke nicht das du den Programmaufruf mit ps ax finden wirst. Beim Standbild werden ja nur ganz wenige Frames geholt, d.h. der Prozess läuft vermutlich gerade mal eine Sekunde oder weniger. Siehst du den ein sich aktualisierendes Bild in der HomeKit App wenn du im Raum bist (nicht auf die Cam tappen)? (bei mir hat das funktioniert)3. Ich habe bei der Konfiguration folgenden eingetragen: Breite: 640, Höhe: 360. Beim Lifestream wird die Auflösung gemäß debug und Prozessliste übernommen. Hingegen beim Snapshot nicht. Da wird aus 640x360 ein 480x270. Ist das so gewollt? `

Ja das ist Absicht. Das Gerät schickt an den Adapter, welche Auflösung es gerne hätte und das Bild das angezeigt wird, wenn man nur "im Raum" ist, ist recht klein. Ich habe es nicht getestet, aber bei der Apple Watch sollte das Bild bspw. noch kleiner sein.

Danke für deine Tests und das Feedback!

-

Ich denke nicht das du den Programmaufruf mit ps ax finden wirst. Beim Standbild werden ja nur ganz wenige Frames geholt, d.h. der Prozess läuft vermutlich gerade mal eine Sekunde oder weniger. `

Bei der Forkvariante hat das Erzeugen des Bildes auf meinen Raspi3 so ca. 5 Sekunden gedauert. So das ich den Prozess immer in der Prozessliste gesehen haben. Deswegen wunder es mich ja.Siehst du den ein sich aktualisierendes Bild in der HomeKit App wenn du im Raum bist (nicht auf die Cam tappen)? (bei mir hat das funktioniert) `

Nope. Leider nein. Das war ja das von mir "erwartete" Verhalten…

Danke für deine Tests und das Feedback! `

Gerne. Danke Dir fürs Entwickeln und weiter Pflegen des Adapters… -

Bei der Forkvariante hat das Erzeugen des Bildes auf meinen Raspi3 so ca. 5 Sekunden gedauert. So das ich den Prozess immer in der Prozessliste gesehen haben. Deswegen wunder es mich ja. `

Ok. Ich mache meine Tests auf einem Laptop mit meiner WebCam… da ist das ganze ein wenig schneller

Ich schaue mir das nochmal an. Kannst du auf dem Raspi mal den Befehl ausführen, der im Log steht (ffmpeg .....)? Vielleicht kommt da eine Fehlermeldung - die werden aktuell nicht ins Log geleitet.

-

Ok. Ich mache meine Tests auf einem Laptop mit meiner WebCam… da ist das ganze ein wenig schneller

Ich schaue mir das nochmal an. Kannst du auf dem Raspi mal den Befehl ausführen, der im Log steht (ffmpeg .....)? Vielleicht kommt da eine Fehlermeldung - die werden aktuell nicht ins Log geleitet. `

Es geht nun. Ich habe einfach eine neue yahka Instanz erzeugt und die Cam neu eingerichtet. Und siehe da, beim Öffnen des "Raumes" wird das Standbild aktualisiert.

Leider sieht es bei mir noch pixelig aus, aber da muss ich mal mit den ffmpeg Optionen spielen.

Wird das Standbild den zyklisch (alle n Sekunden) aktualisiert?

PS Wunsch

:

:Was für Leistungsschwache Rechner wie dem Raspi auch noch richtig super wäre, wäre ein direkter Aufruf des Bildes für das Standbild von der Kamera. Also ohne ffmpeg.

Denn wie ich herausgefunden habe, kann man bei meiner Foscam das Bild direkt mit http://ip-cam:88/cgi-bin/CGIProxy.fcgi? … SER&pwd=PW abrufen...

Das geht sehr schnell und ffmpeg muss da nix rechnen...

-

Wird das Standbild den zyklisch (alle n Sekunden) aktualisiert? `

Ja, bei mir aktualisiert die Homekit App das Bild alle 10 Sekunden.

` > PS Wunsch

:

:Was für Leistungsschwache Rechner wie dem Raspi auch noch richtig super wäre, wäre ein direkter Aufruf des Bildes für das Standbild von der Kamera. Also ohne ffmpeg.

Denn wie ich herausgefunden habe, kann man bei meiner Foscam das Bild direkt mit http://ip-cam:88/cgi-bin/CGIProxy.fcgi? … SER&pwd=PW abrufen...

Das geht sehr schnell und ffmpeg muss da nix rechnen... `

Ich kann mir das mal anschauen. Ich weiß nicht ob die Homekit App damit zurecht kommt, wenn das Bild im falschen Format geliefert wird (wie oben erwähnt, wird das Bild ja resized).

Mir ist nicht ganz klar, warum du den "-ss" Parameter brauchst. Wenn ich die Doku richtig verstehe, seekt man damit - sprich du suchst das Bild bei Sekunde 10… oder das 10. Bild !?

Versuch doch mal folgende Parameter für den Snapshot:

[ "-re", "-i", "http://ip-cam:88/cgi-bin/CGIProxy.fcgi?cmd=snapPicture2&usr=USER&pwd=PW", "-t", "1", "-s", "${width}x${height}", "-f", "image2", "-" ] -

Ja, bei mir aktualisiert die Homekit App das Bild alle 10 Sekunden. `

Bei mir jetzt auch. Details siehe unten…

Mir ist nicht ganz klar, warum du den "-ss" Parameter brauchst. Wenn ich die Doku richtig verstehe, seekt man damit - sprich du suchst das Bild bei Sekunde 10… oder das 10. Bild !? `

Mir auch nicht. Hatte ich durch try and error rausgefunden… :oops:

Hatte ich durch try and error rausgefunden… :oops:Versuch doch mal folgende Parameter für den Snapshot:

[ "-re", "-i", "http://ip-cam:88/cgi-bin/CGIProxy.fcgi?cmd=snapPicture2&usr=USER&pwd=PW", "-t", "1", "-s", "${width}x${height}", "-f", "image2", "-" ] ```` `Wow, das klappt perfekt! Das Bild ist quasi sofort da und wird auch (wie oben beschrieben) alle 10 sek aktualisiert. Sehr cool!

-

Hallo,

Ich habe eine Foscam Fi9900P über der Haustür.

Diese Foscam hat keinen MPEG Stream.

In Vis gebe ich alle 2 Sekunden einen Snapshot wieder.

Das würde mir im yahka Adapter auch reichen.

Was muss ich den wo einstellen, das das funktioniert?

Gruß

Paulchen

-

Hallo,

Ich habe eine Foscam Fi9900P über der Haustür.

Diese Foscam hat keinen MPEG Stream. `

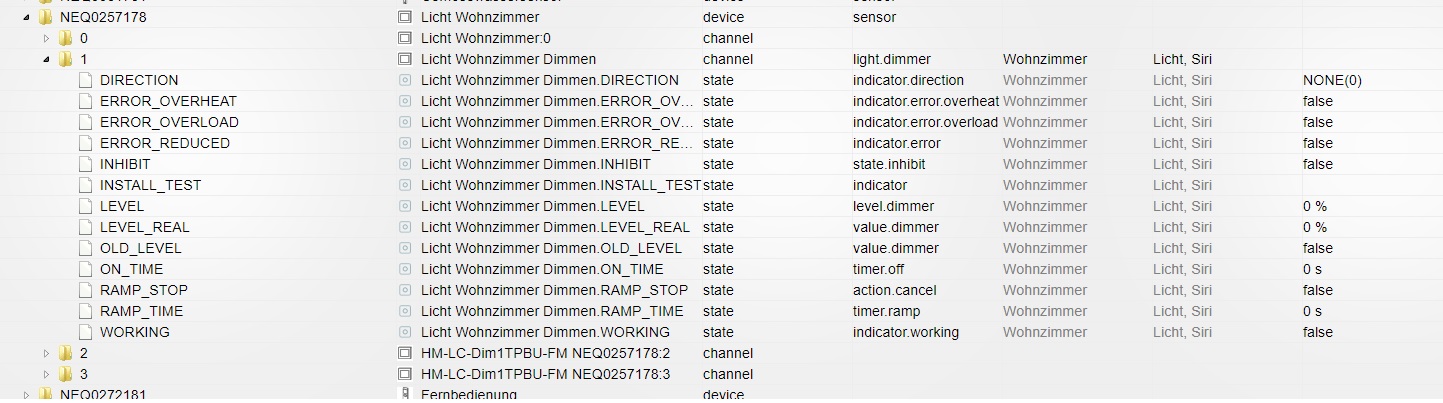

Aber dafür hat sie einen rtsp Stream….

Quelle: rtsp://<user>:<pw>@<ip>:88/videoSub

Codec: unverändert

Breite: 640

Höhe: 360

FPS: 15

Das in der Kamera im SubStream auch so einstellen..

Einzelbild

[ "-re", "-i", "http://<ip>:88/cgi-bin/CGIProxy.fcgi?cmd=snapPicture2&usr=<user>&pwd=<pw>", "-t", "1", "-s", "${width}x${height}", "-f", "image2", "-" ]</pw></user></ip>Livestreamunverändert.</ip></pw></user>

-

Muss da vorher sonst noch ein Plugin oder ähnliches auf dem Raspberry installiert werden?

z.Bsp. das FFMpeg Programm für den Raspberry.

Falls ja, was alles und wie?

Oder ist das alles im Yahka Adapter schon enthalten und sollte so funktionieren?

-

Servus, wie muss ich den Upload für das Beta durchführen. Da stehe ich aktuell kurz auf dem Schlauch

Danke Euch