NEWS

ReGa - Stabilität

-

Ich habe mit meiner lxccu auf dem bananpi in den letzten Tagen einige Probleme gehabt.

Der ReGa-Prozess auf dem bananaPi benötigte zuletzt >150% CPU

ich denke das war auch ein Rechenfehler von "top" bei einem Mehrkernsystem, denn unter der IP der LXCCU ausgeführt war es nur noch die Hälfte.

Daraufhin hatte ich mir die CPU-Nutzung auf der CuBox -4 und dem Cubietruck auf dem ich ioBroker laufen habe angesehen. Auch dort benötigte der io.Rega-HM Prozess deutlich zweistellige Prozentzahlen bei der CPU-Nutzung.

(EDIT: Im Moment ist dort jedoch Ruhe ???)

Jetzt habe ich dazu Fragen bezüglich zweier Gesichtspunkte:

Wie stark belasten ccu.io und ioBroker die CCU?

Zugegeben, ich hatte zeitweilig 3 ccu.io und 2 ioBroker-Installationen auf die lxCCU zugreifen zuzüglich noch 2x Homedroid.

Wie stark wird die Belastung des Prozessors im "Endstadium" von ioBroker sein?

Um das zu testen habe ich mir ja extra noch die QuadCore CuBox angeschafft.

Wenn ihr mal Zeit habt würde ich mich über eine Antwort freuen, bin auch gerne bereit zu testen.

Gruß

Rainer

614_hc_002.jpg -

Und ich muss leider noch einen draufsetzen.

Ich habe mal nacheinander alle Instanzen bis auf den admin.0 nacheinander deaktiviert.

Wenn man dabei den TOP beobachtet, sieht man, dass sich alle beenden, außer dem Rega.0. der bleibt und beansprucht weiterhin ungefähr 85% CPU. ?!

Gruß

Bernhard

-

ungefähr so:

top - 11:21:47 up 7 days, 14:38, 1 user, load average: 0.85, 0.91, 1.05 Tasks: 128 total, 2 running, 126 sleeping, 0 stopped, 0 zombie %Cpu(s): 25.7 us, 1.6 sy, 0.0 ni, 72.7 id, 0.0 wa, 0.0 hi, 0.0 si, 0.0 st KiB Mem: 2063624 total, 1209456 used, 854168 free, 50436 buffers KiB Swap: 0 total, 0 used, 0 free, 319256 cached PID USER PR NI VIRT RES SHR S %CPU %MEM TIME+ COMMAND 24213 root 20 0 116m 60m 6096 R 100.2 3.0 3757:16 io.hm-rega.0 2258 couchdb 20 0 113m 23m 3544 S 8.1 1.2 784:45.44 beam.smp 24333 pi 20 0 102m 54m 6108 S 0.0 2.7 51:38.19 ccu.io 24341 pi 20 0 80776 39m 6024 S 0.0 1.9 15:38.22 node 2568 redis 20 0 26840 2156 616 S 0.6 0.1 14:45.97 redis-server 47 root rt 0 0 0 0 S 0.0 0.0 14:10.42 cfinteractive 28655 root 20 0 168m 116m 6184 S 0.0 5.8 7:55.20 io.admin.0 28648 root 20 0 94776 50m 6240 S 0.0 2.5 7:47.25 io.js-controlle 28662 root 20 0 83712 37m 6080 S 0.0 1.9 5:39.15 io.history.0 107 root 20 0 0 0 0 S 0.0 0.0 4:13.20 mmcqd/1 7 root 20 0 0 0 0 S 0.0 0.0 3:01.17 rcu_sched 28684 root 20 0 98884 54m 6132 S 0.0 2.7 2:56.50 io.legacy.0 464 root 20 0 90872 45m 6092 S 0.0 2.3 1:52.67 io.ping.0 6503 root 20 0 110m 65m 6316 S 0.0 3.2 1:05.44 node-red 2591 ntp 20 0 4624 1804 1360 S 0.0 0.1 1:00.22 ntpd 24282 root 20 0 83768 38m 6080 S 0.0 1.9 0:52.77 io.hm-rpc.0 2462 root 20 0 2092 892 244 S 0.0 0.0 0:41.78 haveged 6496 root 20 0 81780 36m 6072 S 0.0 1.8 0:35.02 io.node-red.0 17117 root 20 0 83944 38m 6080 S 0.0 1.9 0:23.80 io.hm-rpc.0 13498 root 20 0 0 0 0 S 0.0 0.0 0:23.76 kworker/3:1 48 root 20 0 0 0 0 S 0.0 0.0 0:21.85 kworker/0:1 125 root 20 0 0 0 0 S 0.0 0.0 0:18.56 kworker/2:1 95 root 20 0 0 0 0 S 0.6 0.0 0:18.15 kworker/1:1 3 root 20 0 0 0 0 S 0.0 0.0 0:13.44 ksoftirqd/0 1 root 20 0 1660 616 512 S 0.0 0.0 0:12.44 init 23 root 20 0 0 0 0 S 0.0 0.0 0:09.83 ksoftirqd/3 2480 couchdb 20 0 1148 220 176 S 0.0 0.0 0:09.70 heart 2810 couchdb 20 0 29664 9916 2760 S 0.0 0.5 0:06.79 couchjs 13 root 20 0 0 0 0 S 0.0 0.0 0:06.68 ksoftirqd/1 2715 couchdb 20 0 1340 436 372 S 0.0 0.0 0:06.21 sh 18 root 20 0 0 0 0 S 0.0 0.0 0:06.15 ksoftirqd/2 10 root rt 0 0 0 0 S 0.0 0.0 0:05.42 watchdog/0 16 root rt 0 0 0 0 S 0.0 0.0 0:04.73 watchdog/2 21 root rt 0 0 0 0 S 0.0 0.0 0:04.73 watchdog/3 11 root rt 0 0 0 0 S 0.0 0.0 0:04.70 watchdog/1 24786 root 20 0 0 0 0 S 0.0 0.0 0:03.51 kworker/u8:0 16979 couchdb 20 0 42236 21m 2736 S 0.0 1.1 0:01.95 couchjs 28525 root 20 0 0 0 0 S 0.0 0.0 0:01.94 kworker/u8:1 121 root 20 0 0 0 0 S 0.0 0.0 0:01.43 jbd2/mmcblk0p1- 2487 root 20 0 3328 696 536 S 0.0 0.0 0:01.34 cron 435 root 0 -20 0 0 0 S 0.0 0.0 0:01.07 kworker/u9:0und das kommt noch dazu:

Auch nach update auf 0.0.34

Gruß

Rainer

-

ungefähr so:

und das kommt noch dazu:

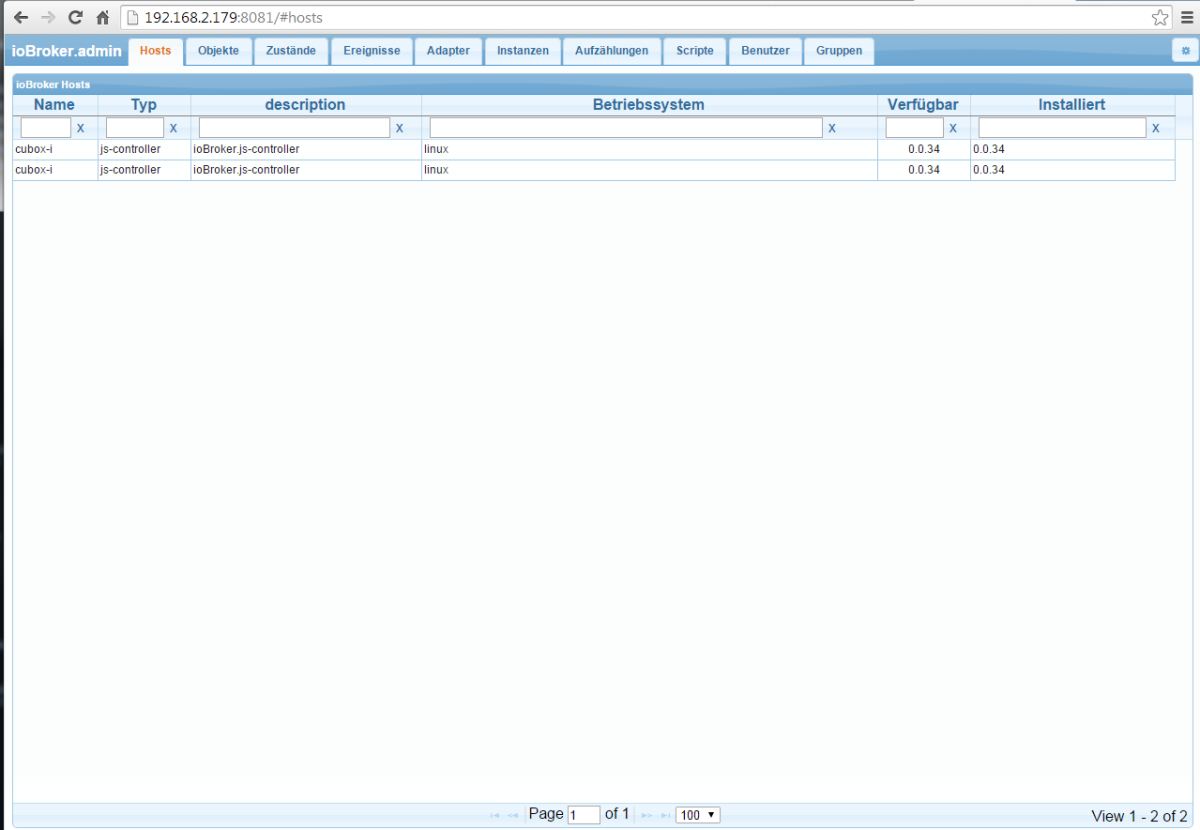

filename="ioBroker_js_controller_x2.jpg" index="0">~~Auch nach update auf 0.0.34

Gruß

Rainer `

Hast du die Kiste neu gestartet? js-controller ist zwei mal gestartet. -

Nein, bis vor 30 sec. nicht.

Nach dem Update gerade eben komm ich nicht mehr auf die webUI

der doppelte Eintrag ist nicht immer da. Nach dem einen Refresh mit F5 ist nur einer da. Bei einem anderen refresh dann wieder zwei!?

Bin heute nicht mehr am PC. Muss mal nach dem errorlog sehen

2014-11-09 20:58:27.029 - error: TypeError: Object # <adapter>has no method 'requireLog' at socketEvents (/opt/iobroker/adapter/admin/admin.js:460:13) at Namespace.initSocket (/opt/iobroker/adapter/admin/admin.js:451:9) at Namespace.EventEmitter.emit (events.js:95:17) at Namespace.emit (/opt/iobroker/adapter/admin/node_modules/socket.io/lib/namespace.js:205:10) at /opt/iobroker/adapter/admin/node_modules/socket.io/lib/namespace.js:172:14 at process._tickCallback (node.js:415:13) 2014-11-09 20:58:27.355 - error: controller instance system.adapter.admin.0 terminated with code 6 2014-11-09 20:58:39.031 - info: hm-rega.0 State alarms 0 2014-11-09 20:58:39.034 - info: hm-rega.0 State maintenance 7 2014-11-09 20:58:57.375 - info: controller instance system.adapter.admin.0 started with pid 2921 2014-11-09 20:59:00.907 - info: admin.0 starting. Version 0.1.7 2014-11-09 20:59:01.005 - info: admin.0 requesting all states 2014-11-09 20:59:01.012 - info: admin.0 requesting all objects 2014-11-09 20:59:01.030 - info: admin.0 http server listening on port 8081 2014-11-09 20:59:01.031 - info: admin.0 Use link "http"://localhost:8081" to configure. )</adapter>Edit: habe es über SSH geschafft mit ./iobroker upgrade anschließend wieder ins WebUI zu kommen. Jetzt ist nur noch eine controller Instanz da (im Moment) !

Jetzt sind auch alle io-datenpunkte da

Gruß

Rainer

Gesendet von meinem LIFETAB_E10320 mit Tapatalk

-

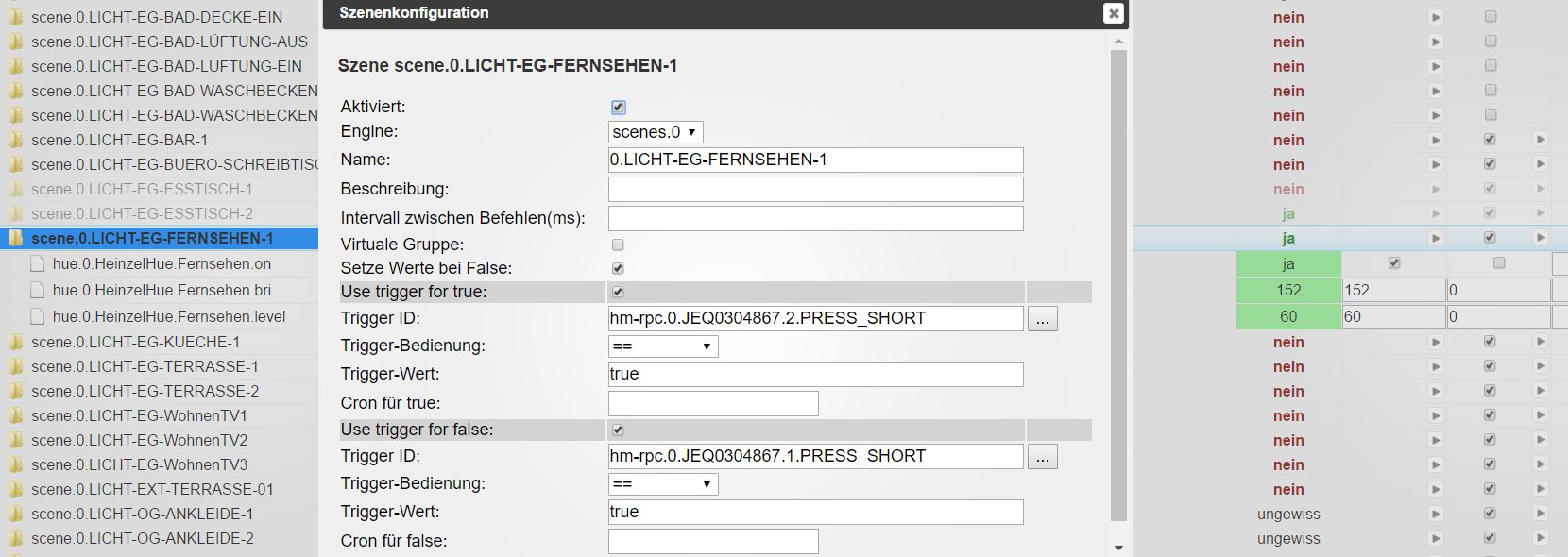

und jetzt, da die Logging Funktion da ist, sieht man in selbigen folgenden Eintrag:

In der Geschwindigkeit, in der der Prozess auf und wieder abgebaut wird, würde das natürlich die enorme Prozessorlast erklären.Gruß

Bernhard