NEWS

Influx DB schon wieder sehr groß

-

Ich habe eben mal geschaut wie groß meine InfluxDB 2 ist und da werden mir stolze 5,5GB angezeigt. Gut ich logge auch sehr viele Daten um sie dann in Grafana zu verwenden.

Meine Frage ist wie ich mir die Daten anzeigen lassen kann, die dem meisten Speicherplatz benötigen, ich dann das loggen wieder etwas runtersetzen kann um auf eine annehmbare Größe zu kommen, den 5,5 GB ist doch etwas viel denke ich. -

@damrak2022 na ja so einfach ist es nicht.. du kannst mal schauen was du alles logst.. und dann wie viele datenelemente pro measurement hast.. und die alten löschen

ich halte meine daten so 2 Jahre.. danach können die weg..

-

@damrak2022

Mit der Abfrage hier kannst du dir zwar nicht direkt die Speichergröße anzeigen lassen, aber zumindest die Measurements und die darin enthaltene Anzahl an Datensätzen:from(bucket: "iobroker") |> range(start: -10y) |> filter(fn: (r) => r["_field"] == "value") |> count() |> group() |> keep(columns: ["_measurement", "_value"]) |> sort(columns: ["_value"], desc: true) |> rename(columns: {_value: "Anzahl"}) -

@marc-berg Okay, also bei dem Shelly wo mein Mac dranhängt sind es z.B. 410200 Messpunkte. Da ich alle Datenpunkte auch weiterhin nutzen werde, sind die 5,5 GB wohl in Ordnung

-

@damrak2022 es bleibt dir ja noch Downsampling. Es ist je nach deinen Umständen vielleicht auch nicht nötig jede Sekunde einen Datenpunkt zu behalten.

-

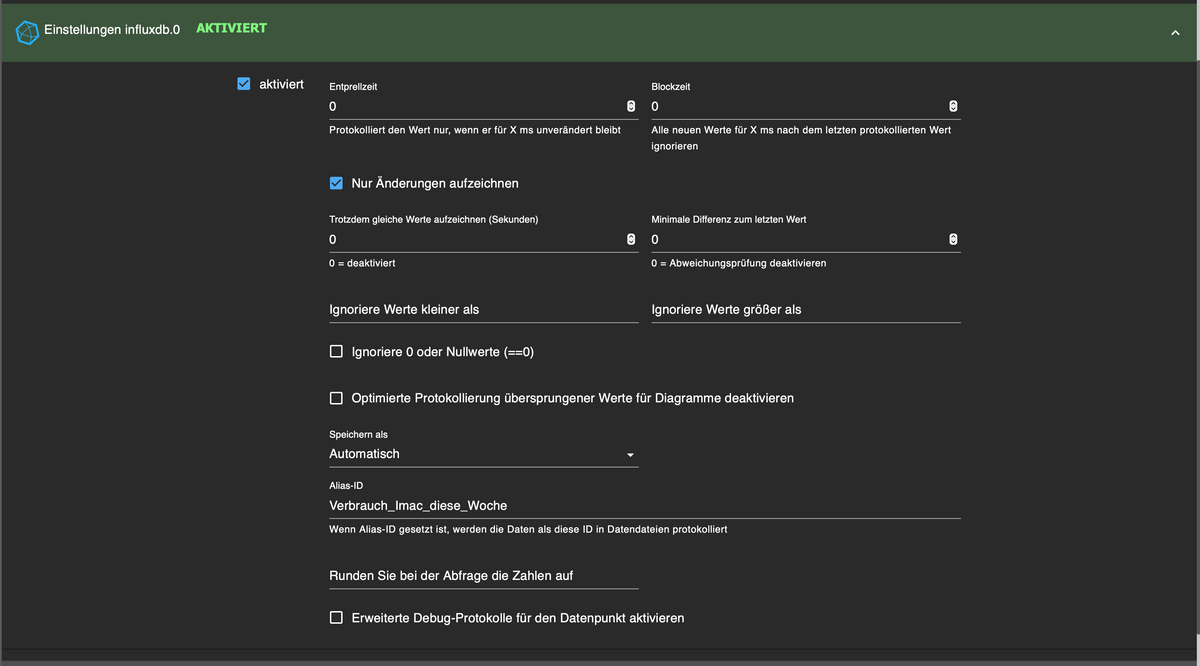

@spacerx Momentan sehen meine Einstellungen bei den geloggten Datenpunkten so aus:

Ist das richtig das ich bei der Blockzeit z.B. 5000 eintragen müsste, damit nur alle 5 Sekunden ein Wert geschrieben wird?