NEWS

Rhasspy Offline Sprachsteuerung

-

Die neue 2.5.8 ist draußen und nun kann man die Lautstärke(n) direkt im Webinterface anpassen!

-

@LichtAn

Ich habe mich nun endlich auch an die Installation des Rhasspy gemacht. Zunächst war es etwas mühsam, aber mit der Anleitung https://rhasspy.readthedocs.io/en/latest/tutorials/#from-scratch-on-a-raspberry-pi und Dank der Hilfe in Post 301 hat es funktioniert, sodass ich nun die Befehle im iobroker sehen kann.

Dabei bin ich auf einen möglichen Fehler im Befehl zum Starten des docker in Post 301 gestoßen. Meiner Meinung nach fehlt dort der MQTT-start, sodass der Startbefehl (auch nach Restart des Raspi) wie folgt lauten müsste (aktuelle Rhasspy-Version 2.5.8):docker run -d -p 12101:12101 \ --name rhasspy \ --restart unless-stopped \ -v "$HOME/.config/rhasspy/profiles:/profiles" \ -v "/etc/localtime:/etc/localtime:ro" \ --device /dev/snd:/dev/snd \ rhasspy/rhasspy \ --user-profiles /profiles \ --profile de \ --local-mqtt-port 13183 -

Der MQTT läuft ja auf dem Debian System nicht im Docker deshalb musst du den nicht mit dem Docker Start Befehl starten.

In der Config von 301wird ja auch auf external gestellt. Früher gab es nämlich Probeme mit dem internen MQTT Server wenn du nicht den Standard Port verwendet hast.

MQTT -> External

Host -> IP Rhasspy

Port -> 1883 -

Moin zusammen,

ich experimentiere gerade mit Rhasspy weiter.

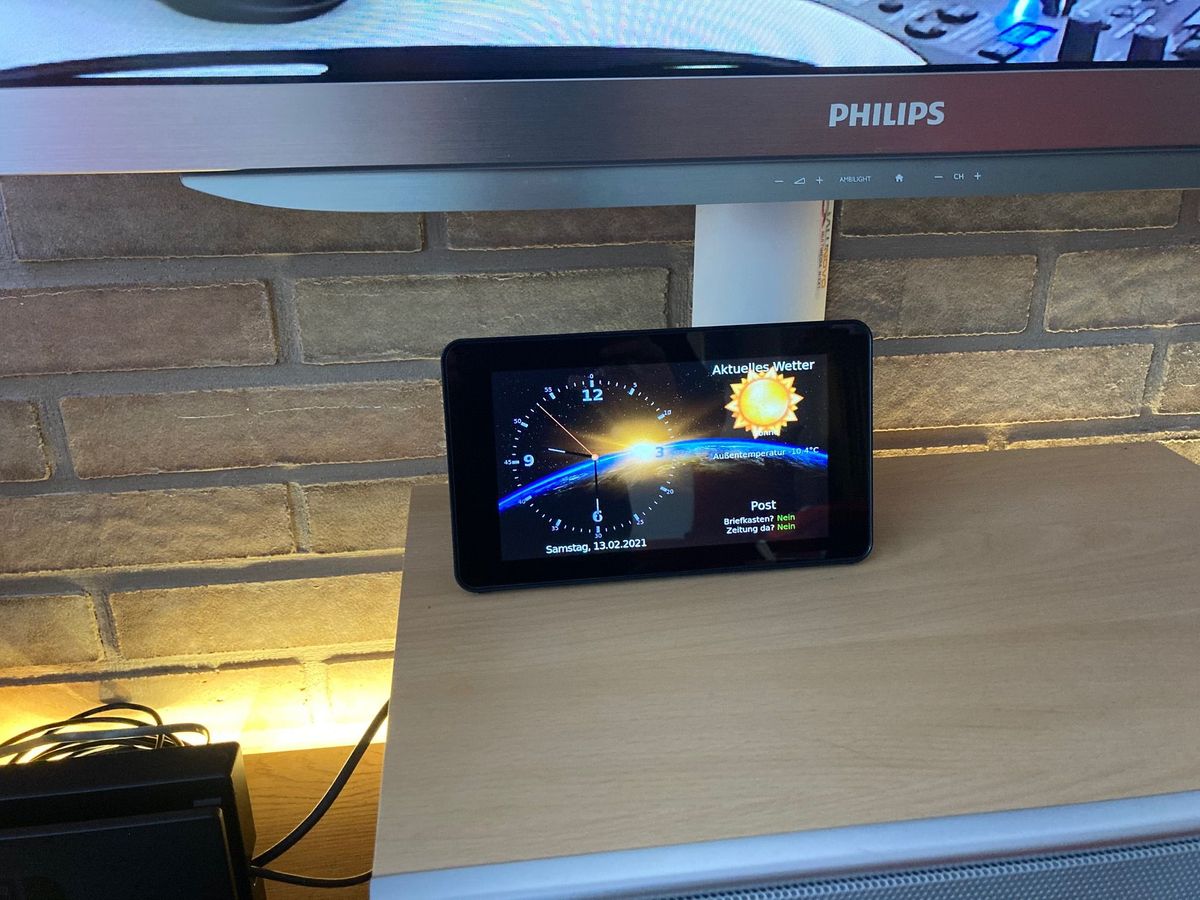

Ich bin weiterhin mit dem Gehäuse unzufrieden und habe jetzt mal etwas ausprobiert:

Ich habe mir das offizielle Raspberry 7" Display mit einem passenden Gehäuse bestellt.

In dem Gehäuse ist noch genug Platz für den Reespeaker2 und einem Lautsprecher:

Der Deckel hinten lässt einen Luftspalt für die Mikrofone... Bin noch am experimentieren, aber erste Tests waren ganz brauchbar.

Auf dem Pi3 b+ läuft jetzt Rhasspy 2.5.9 im Docker und der ioBroker als slave mit einem Browser im Kioskmode.

Ganz nebenbei habe ich so auch mein Bluetooth-Probleme mit den Xiaomi Pflanzensensoren gelöst, denn der Raspberry steht näher an den Sensoren.Leider ist das Display vom Blickwinkel nicht das beste, aber man steht ja selten direkt davor, oder man muss es noch etwas nach hinten kippen.

VG

Leif -

Wenn die Micro Schlitze nur nach hinten raus gehen hast du da keine Probleme mit der Akustik Versteht dich der jetzt genauso wie vorher.

mal eine andere Frage. Hat einer von euch schon die Bring Liste erfolgreich integriert. Kämpfe grade ein bisschen das Json so auszulesen das es Anständig mit 2,3 oder 4 Parametern funktioniert je nachdem was man sagt.

-

Hallo,

hat von euch schon jemand Rhasspy in einem Proxmox LXC Container

zum Laufen bekommen?Ich wäre für einen kurze Anleitung sehr dankbar. Denn wenn ich ehrlich bin, verstehe ich von der offiziellen Install Anleitung nur Bahnhof und weiß nicht, was ich machen muss.

z.B. Welches CT Template muss ich nehmen und dann welche Installationsanleitung (Docker, Debian oder Virtual Environment).

Hoffe ihr helft mir weiter.

Ich wünsche euch ein sonniges Wochenende.

Liebe Grüße

Peter -

Hi,

ich hab das ganze vor langem mal in einem Container zum laufen gebracht. Allerdings hat das mehr Probleme gemacht als es am Ende gebracht. Ich würde dir empfehlen eine VM aufzusetzen in der du docker betreibst. Dort kannst du dann alle Container betreiben die du brauchst.

Wen. Du Koch paar Infos dazu brauchst sag einfach Bescheid.

Gruß

T -

@dert

Hallo,Rhasspy läuft im Docker und ich kann auf das Web-Interface zugreifen.

Gibt es jetzt eine detaillierte Anleitung, wie es weiter geht, den die 349 Seiten, sind wirklich sehr unübersichtlich.

Wie muss ich den MQTT-Adapter in iobroker und in Rhasspy einrichten. Könntes du einen Screenshot hochladen?

Liebe Grüße

Peter -

Schau mal meinen Post 301 auf der Seite 16 an da wirst du geholfen.

-

Moin,

ich lese hier nun schon eine ganze Weile still mit.

Bin begeistert von euch.

Mein Iobroker und Rhasspy Projekt wäre eigentlich schon beendet, wenn ich nicht Schwierigkeiten mit den Mikrofonen der Satelliten hätte.

Mein Setup besteht aus einem zentralen Rhasspy Server v2.5.9, unter Proxmox LXC/Docker.- MQTT = external

- Speech to Text = Kaldi

- Intent Recognition = Fsticuffs

- Text to Speech = NanoTTS

- Dialog Management = Rhasspy

also alles weitestgehend Standard.

Meine Satelliten bestehen derzeit aus Raspberry Pi Zero WH + 2-Mic-HAT mit Seeed Treiber und Kernel 5.4.51+.

- MQTT = external

- Audio Recording = PyAudio

- Wake Word = Porqupine

-

- Keyword File = jarvis...

-

- Sensivity = 0.5

- Speech to Text = Hermes MQTT

- Intent Recognition = Hermes MQTT

- Text to Speech = Hermes MQTT

- Audio Playing = aplay

- Dialog Management = Disabled

- Intent Handling = Disabled

Lustige Gehäuse habe ich mir natürlich auch ausgedacht.

Also die Technik funktioniert.

Mein Problem sind bislang immer mal wieder die Mikrofone. Sofern es in dem Raum leise ist, funktioniert die Spracherkennung wunderbar.

Sofern Radio, TV oder eine Unterhaltung in dem Raum stattfindet, wird die Trefferquote schnell schlechter.

Das haben ja auch schon andere hier Erkannt.

Ich habe mit der Sensivity schon ein bisschen experimentiert, aber ohne großen Erfolg.

Hat jemand die Problematik mit den Nebengeräuschen schon gelöst oder eingegrenzt?

Hab mit jetzt zum Testen noch einen Rock Pi S bestellt. Der hat eine Soundkarte bereits Onboard.

Ich bin mir bei den Mikrofonen aber nicht sicher, welche und vor allem welche Technik da die bessere Wahl ist.

Hat hier jemand schon Erfahrung damit?

Danke und Gruß

Kuumaur -

@lichtan sagte in Rhasspy Offline Sprachsteuerung:

Hat einer von euch schon die Bring Liste erfolgreich integriert.

Hallo, ich hatte dazu mal einen Beitrag gepostet. Such mal in meinem Account. Komme leider gerade nicht dazu, dir das rauszusuchen. Bei Fragen: fragen...

-

@lichtan sagte in Rhasspy Offline Sprachsteuerung:

Hat einer von euch schon die Bring Liste erfolgreich integriert.

Hallo, ich habe dir meine Beschreibung vom 11.3.20, 23:39 herausgeucht. Falls noch interessant, schau mal hier:

https://forum.iobroker.net/topic/31110/rhasspy-sprachsteuerung-für-bring-adapter?_=1615936753622

-

Hallo zusammen

Da Alexa bei mir immer mal wieder Ärger macht und nicht ganz so zuverlässig funktioniert wie gewünscht, würde ich ebenfalls gerne Rhasspy eine Chance geben um die Sprachsteuerung ohne Online-Zwang und Einschränkungen zum Laufen zu bekommen.

Ich möchte mich entschuldigen, falls die folgenden Fragen weiter oben schon beantwortet wurde, es hat aber inzwischen doch schon so einige Posts hier.

Wie funktioniert Rhasspy mit diversen Standorten in einem Haus?

Ich würde gerne wirklich alle Räume mit einer Spracherkennung abdecken können, bin mir aber nicht sicher, ob das zuverlässig funktioniert.Wenn ich also z.B. im Eingangsbereich und im Wohnzimmer Rhasspy am Laufen habe, ich irgendwo zwischendrin stehe und das Wakeword sage, erkennt Rhasspy automatisch, wo die beste Aufnahme ist?

Wie ist zudem generell eure Langzeiterfahrung betreffend Stabilität? Unabhängig von der Überwachung geht es mir beim Wechsel vor allem darum, dass ich ein System habe, welches ich einmalig aufsetzen kann und welches dann auch zuverlässig macht, was es soll.

-

@dert

hallo ich habe soweit alles eingefügt. Leider ohne Erfolg. Wenn ich snowboy mit dem Befehl Stehlampe aus sage, dann wird es im Rhasspy webif erkannt, aber ansonsten passiert nichts.

Habe im Skript bei Stehlampe den homematic-Pfad angepasst, ansonsten habe ich nichts im Skript verändert.

Wo könnte der Fehler liegen?

Außerdem werden bei mir die hermes/intents nicht angezeigt. Woran könnte das liegen? -

@jwerlsdf

Hi,

kannst du mir kurz sagen auf welches Skript du dich beziehst? Hast du mehrere rhasspys oder nur einen?Gruß

T -

@dert

danke für deine Rückmeldung.

Ich habe bisher nur einen Rhasspy. Dieser läuft aber auf einem anderen Raspberry 4 als iobroker läuft. Die Verbindung mit dem iobroker steht (Adapter ist grün)

Ich beziehen mich auf das Skript, welches du auf Seite 315 gepostet hast.Noch ein Hinweis:

@LichtAn hat auf Seite 290 ein Bild gepostet, bei dem darauf einen Ordner mit Intents mit den entsprechenden Einträgen zu sehen sind. Diese fehlen mir. Werden diese automatisch erstellt oder muss ich diese manuell anlegen?OK. Es scheint, jetzt zu gehen. Musste im MQTT-Adapter folgendes ändern:

#hermes/intent/#,hermes/asr/startListening,hermes/nlu/intentNotRecognized,hermes/intent/#,hermes/asr/#,hermes/dialogueManager/#,hermes/nlu/#Damit werden nun die intents angezeigt und ich kann nun die Befehle per Sprache absetzen. Schaue mir jetzt noch mal deinen code an. Ggf. habe ich noch ein paar Fragen dazu.

Eine andere Frage hätte ich noch: Wie kann ich die Sprachausgabe über Sonos API ausgeben? Hat da jemand eine Idee?

-

WoW dein Script finde ich klasse ich habe allerdings eine sache die ich anders machen würde und zwar die tts ausgaben. Statt über die api würde ich dies ebenfalls über mqtt zu erledigen um nicht zwei protokolle zu vermischen.

in etwa so:

function extractIntentData(message) { const parsedMessage = JSON.parse(message); let extractedJSON = {}; extractedJSON.slots = {}; extractedJSON.intentName = parsedMessage.intent.intentName; extractedJSON.siteId = parsedMessage.siteId; extractedJSON.Id = parsedMessage.SessionId; parsedMessage.slots.forEach(slot => { extractedJSON.slots[slot.slotName] = slot.value.value; }); return extractedJSON; } //Damit kann jeder Rhasspy sprechen function speakRhasspy(text, rhasspySiteId ,sid) { console.log(rhasspySiteId); let sendData = { sessionId: sid, siteId: site, text: msg }; let jsonObj = JSON.stringify(sendData); if(sid != "0") { sendTo('mqtt.0', 'sendMessage2Client', {topic:"hermes/dialogueManager/endSession", message:jsonObj}); } else { sendTo('mqtt.0', 'sendMessage2Client', {topic:"hermes/tts/say", message:jsonObj}); } }lässt sich sicher auch eleganter lösen

bin in JS noch nicht so gut.

bin in JS noch nicht so gut.

Übrigens ist diese lösung aus dem FHEM modul abgekupfert, da dieses bereits schon weit entwickelt ist.Zu 1. ich arbeite mit snowboy werde allerdings versuchen auf raven zu wechseln

Zu 2. ich nutze google Wavenet (shame on me doch wieder Cloud aber es hört sich gut an)

Zu 3. Da mein Produktives Rhasspy noch unter FHEM läuft habe ich meinen Logitechmediaserver über rhasspy angebunden und dies funktioniert recht gut ich weiß nur noch nicht wie ich das über iobroker abbilden werde da ich aktuell umsteiger bin (u.A wegen dem fehlenden multithreading in fhem das nervt echt )

)einen schönen abend gewünscht

Carsten

-

Hallo,

folgendes Szenario würde ich gerne umsetzen:

Wenn ich einen Sprachbefehl gebe, wird dies ja in iobroker in den intents abgebildet. Hat jemand ein blockly, der die intents nach diesem Befehl durchsucht und dann ein Datenpunkt schaltet? So wäre es ja prinzipiell möglich, jedes beliebige Skript zu schalten? Könnte mir jemand helfen? -

@jwerlsdf

Hi,

Ich hatte ganz am Anfang dieses Threads mal ein JavaScript vorgestellt, mit dem die Intents ausgewertet können:

https://forum.iobroker.net/topic/28411/rhasspy-offline-sprachsteuerung/8Das war aber noch bevor Hermes in Rhasspy implementiert wurde, d.h. die MQTT-Variablen müssen angepasst werden.

Ist zwar kein blockly, aber evtl. hilft es Dir weiter? -

@joergeli

danke für deine Rückmeldung. In der Zwischenzeit habe ich es noch mal mit dem Skript von @DerT probiert (315). Habe es damit nun hinbekommen. Ich schalte damit einen Datenpunkt, der wiederrum dann ein anderes Skript (Blockly) schaltet. Sind zwar längere Wege, aber für jemanden wie mich einfacher umzusetzen.Jetzt hoffe noch, dass mir jemand beim bring-Adapter helfen könnte. Dort bekomme ich den Intent-befehl nicht in den Bring adapter geschrieben...