NEWS

NEU ioBroker Alexa Custom Skill verfügbar!

-

Funktioniert bei mir leider überhaupt nicht gut das Ganze.

Wenn ich Alexa frage: "Alexa, frage IOBroker wie warm es im Wohnzimmer ist" bekomme ich die Rückmeldung: "Ich verstehe 'warm ist wohnzimmer es' nicht".

Im Log steht dann ebenfalls: "processText: "askDevice warm ist wohnzimmer es"".

Habe ich irgendwo was falsch verstanden?

-

Naja deine Regel erwartet das Wort „wie“. Kommt das an? Steht’s im log bzw unser Antwort ? ;-)

Lass das wie in der Regel weg.

Das Fragewort an sich kommt nicht mit Durch. Statt dessen kannst du aber das askDevice als Anfragetyp reinnehmen.

Gesendet vom Handy …

-

Bei mir hat Alexa vorhin mehrfach gesagt dass die iot Instanz nicht verbunden wäre, was aber nicht stimmt.

Ich habe die 24 Monate Assistenz Lizenz, die von der heutigen Wartung ja nicht betroffen sein sollte.

Außerdem kommt der custom Skill (heute) anscheinend gar nicht mit meiner Stimme klar.

Ich sage: "Frage i o Broker nach Garage" und im Log steht "processText: "controlDevice garagentor""

oder "processText: "controlDevice garagentor zu""

oder "processText: "askWhen wann garage zeit der""

Es muss aber "askDevice Garage" ankommen und nichts anderes. Das hat alles schon mal funktioniert.

-

Naja deine Regel erwartet das Wort „wie“. Kommt das an? Steht’s im log bzw unser Antwort ? ;-)

Lass das wie in der Regel weg.

Das Fragewort an sich kommt nicht mit Durch. Statt dessen kannst du aber das askDevice als Anfragetyp reinnehmen.

Gesendet vom Handy … `

Ok, danke schon mal dafür. Werde ich machen.

Nichtsdestotrotz, wie mein Vorposter schon angemerkt hat, versteht Alexa in 90% der Fälle was falsches. Werde das die nächste Zeit mal beobachten, ob sich das bessern wird.

-

Habe nun auch den Custom Skill testweise im Einsatz und technisch funktioniert alles einwandfrei.

Allerdings habe auch ich das Gefühl, dass Alexa mich wesentlich schlechter als normal versteht. Ich habe ansonsten nur selten Verständnisprobleme mit ihr - ich spreche auch nicht Dialekt und nuschel nicht. Die Aufzeichnungen in der Alex-App klingen klar und verständlich.

Dennoch:

"frage ioBroker, wer anwesend ist" --> processText: "askWho wer ist wand des alle" "frage ioBroker, wer anwesend ist" --> processText: "askWho Sind wer ist PC IM" "frage ioBroker, wer online ist" --> processText: "askWho wer ist rollladen"Wenn ich mir das so ansehe, habe ich fast die Vermutung, dass Alexa zwanghaft versucht irgendwelche Begriffe aus dem Themengebiet "Haus"/"Geräte"/"SmartHome" zu verstehen, wie z.B. "Rolladen","PC" oder "Wand".

Sind in dem Skill denn irgendwelche hints hinterlegt, die das begünstigen? Oder versucht Amazon vielleicht sogar automatisch "wahrscheinliche" Begriffe für diesen Skill zu bestimmen?

-

Hi,

ja im Skill sind an ein paar Stellen "Hints" hinterlegt und ja auch dort sind solche Begriffe teilweise drin. Wir haben zuerst mitz komplett freier Erkennung experimentiert aber da ewaren die Ergebnisse noch grauenvoller.

Probiert es mal ein bissl. Meine Erfahrung ist das Sie nach etwas Zeit viel besser versteht

-

ja im Skill sind an ein paar Stellen "Hints" hinterlegt und ja auch dort sind solche Begriffe teilweise drin. Wir haben zuerst mitz komplett freier Erkennung experimentiert aber da ewaren die Ergebnisse noch grauenvoller.

Probiert es mal ein bissl. Meine Erfahrung ist das Sie nach etwas Zeit viel besser versteht `

Dann teste ich noch etwas weiter.

Ich vermute die hinterlegten Hints sind global, oder? Luxoriös wäre natürlich, wenn die text2command Triggerwörter benutzerspezifisch als Hint extrahiert werden könnten.

-

Es gibt ja mittlerweile auch den https://blueprints.amazon.de/ mit dem man einfache eigene Skills bauen kann.

Vielleicht wäre es zukünftig möglich nutzerspezifische Anpassungen implementieren zu können.

-

Der iot Adapter ist in v0.4.0 auf GitHub und bringt Erweiterungen für die Custom-Skill-Nutzung mit.

Ein neuer Datenpunkt enthält mehr Infos als nur den Text bei Anfragen und bei der ANtwort kann angegeben werde ob die Session offen bleibt oder nicht. So könnten in eigenen JavaScripts unter merken der Session-ID auch "unterhaltungen" geführt werden.

-

Ich versuche gerade frei Werte über den custom Skill in einen Datenpunkt zu bekommen. Bekomme aber alles mögliche aber nie das was ich sage.

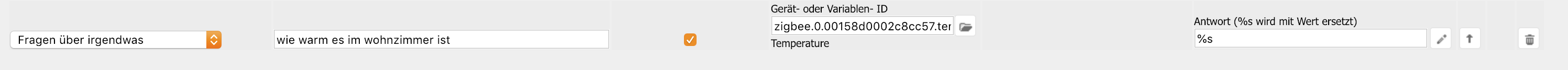

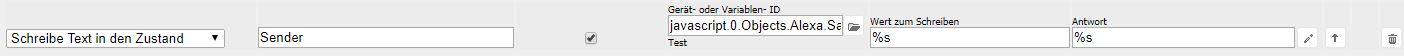

So sieht mein text2command aus:

Ich sage "Alexa, sage i o Broker schalte Sender eins".

Das passiert dann:

text2command.0 processText: "controlDevice eins sender schalte" text2command.0 Say ID javascript.0.Objects.Alexa.Samsung.Test: schalte text2command.0 Response: schalteAuch mit "setze Sender zwei" o.ä. bekomme ich alles mögliche in den Datenpunkt aber niemals die Zahl.

Warum bekomme ich das Befehlswort statt dem übergebenen Wert?.

Wie muss das text2command aussehen vom Trigger damit ich eine Zahl als Wort oder Ziffer in einem Datenpunkt bekomme?

-

Der iot Adapter ist in v0.4.0 auf GitHub und bringt Erweiterungen für die Custom-Skill-Nutzung mit.

Ein neuer Datenpunkt enthält mehr Infos als nur den Text bei Anfragen und bei der ANtwort kann angegeben werde ob die Session offen bleibt oder nicht. So könnten in eigenen JavaScripts unter merken der Session-ID auch "unterhaltungen" geführt werden.

Siehe https://github.com/ioBroker/ioBroker.iot#custom-skill `

Bin ich blind, sehe nur V 0.3.1

-

Der iot Adapter ist in v0.4.0 auf GitHub und bringt Erweiterungen für die Custom-Skill-Nutzung mit.

Ein neuer Datenpunkt enthält mehr Infos als nur den Text bei Anfragen und bei der ANtwort kann angegeben werde ob die Session offen bleibt oder nicht. So könnten in eigenen JavaScripts unter merken der Session-ID auch "unterhaltungen" geführt werden.

Siehe https://github.com/ioBroker/ioBroker.iot#custom-skill `

Bin ich blind, sehe nur V 0.3.1 `

Auf GitHub!! Nicht NPM

-

Der iot Adapter ist in v0.4.0 auf GitHub und bringt Erweiterungen für die Custom-Skill-Nutzung mit.

Ein neuer Datenpunkt enthält mehr Infos als nur den Text bei Anfragen und bei der ANtwort kann angegeben werde ob die Session offen bleibt oder nicht. So könnten in eigenen JavaScripts unter merken der Session-ID auch "unterhaltungen" geführt werden.

Siehe https://github.com/ioBroker/ioBroker.iot#custom-skill `

Bin ich blind, sehe nur V 0.3.1 `

Auf GitHub!! Nicht NPM `

Ich gehe dann ins Bett….......... :?

-

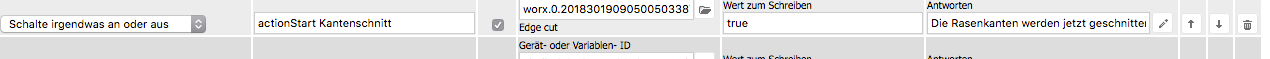

Ich bin bei meinen ersten Gehversuchen, was Custom Skills angeht.

Ich möchte die Rasenkanten mit meinem Worx schneiden. Wenn ich sage ->

sage i. o. broker starte kanten schnittWird die Funktion nicht ausgeführt. So sieht es im text2command Adapter aus.

Was mache ich falsch?