NEWS

[Aufruf] Dringender Test sql 1.6.4

-

Hm, wüsste nicht wie das zu „duplicate key“ führen sollte. Das ist an sich eher das zum gleichen zeitstempel schon ein wert in der dB existiert.

Starte mal sql Adapter neu dann sollten pot Probleme vom manuellen löschen weg sein. `

Nach einem Neustart des SQL-Adapters sind die Meldungen weg.

-

Um die Duplicates zu verstehen bräuchte ich Debug Log bitte

Ingo `

Hallo,Leider tritt der Fehler nur sporadisch auf und der SQL-Adapter schreibt im debug solche Massen an Logdaten, dass ich den nicht für längere Zeit aktivieren möchte.

Es ist scheinbar meistens eine Datenpunkt der vom JavaScript-Adapter ausgelöst/geschrieben wird.

-

Hm … dann ist es echt schwierig dem auf die Spur zu kommen ... :-(

Ist es immer der gleiche Datenpunkt?

Wenn ja vllt zweite ssql-Instanz in Debug Log aufsetzen in zweite DB schreiben und nur wenige Datenpunkte dort aktivieren (die halt wo sowas passiert). Ich kann es aktuell nicht nachvollziehen. Ich brauche aber die Info was passiert wenn es das erste mal passiert

-

Hm … dann ist es echt schwierig dem auf die Spur zu kommen ... :-(

Ist es immer der gleiche Datenpunkt?

Wenn ja vllt zweite ssql-Instanz in Debug Log aufsetzen in zweite DB schreiben und nur wenige Datenpunkte dort aktivieren (die halt wo sowas passiert). Ich kann es aktuell nicht nachvollziehen. Ich brauche aber die Info was passiert wenn es das erste mal passiert `

War die Woche auf Dienstreise, werde das mal ausprobieren. Habe ja noch einen 2. Server der die DB schon installiert hat und vor sich hinläuft.

-

Hm … wann vorher neu gestartet? `

Jede Nacht um 4:00.

Ist aber der erste Aufruf von vis.

-

Folgendes Script:

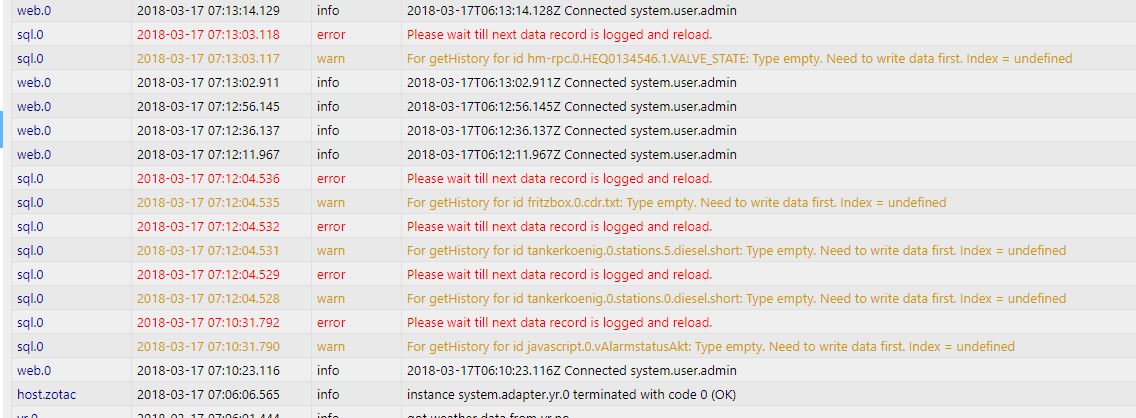

setState("vEreignissAkt","------------ NEUSTART ------------");führt beim Neustart zu:

error: sql.0 Cannot insert INSERT INTO `iobroker`.ts_string (id, ts, val, ack, _from, q) VALUES(1617, 1521256587638, '------------ NEUSTART ------------', 0, 13, 0);: Error: ER_DUP_ENTRY: Duplicate entry '1617-1521256587638' for key 'PRIMARY' 2018-03-17 04:16:28 error: sql.0 Cannot insert INSERT INTO `iobroker`.ts_string (id, ts, val, ack, _from, q) VALUES(1617, 1521256587637, '------------ NEUSTART ------------', 0, 13, 0);: Error: ER_DUP_ENTRY: Duplicate entry '1617-1521256587637' for key 'PRIMARY' error: sql.0 Cannot insert INSERT INTO `iobroker`.ts_string (id, ts, val, ack, _from, q) VALUES(1617, 1521256587638, '------------ NEUSTART ------------', 0, 13, 0);: Error: ER_DUP_ENTRY: Duplicate entry '1617-1521256587638' for key 'PRIMARY' error: sql.0 Cannot insert INSERT INTO `iobroker`.ts_string (id, ts, val, ack, _from, q) VALUES(1617, 1521256587637, '------------ NEUSTART ------------', 0, 13, 0);: Error: ER_DUP_ENTRY: Duplicate entry '1617-1521256587637' for key 'PRIMARY'Das sieht so aus als würde er beim Neustart das Skript 2x starten?

Alle anderen Datenpunkte mit den duplicates sind auch aus ähnlichen Aktion.

Meistens ist der Datenpunkt aus dem yr.0 Adapter: yr.0.forecast.day0.pressure

-

Habe auch mal eine Frage. Nutze den Adapter jetzt entsprechend mittels SQLite - läuft auch soweit. :) Nur beim Neustart loggt er mir haufenweise

Cannot queue new requests, because more than 100Ich schätze mal, dass er den alten Status nicht mehr kennt und versucht sämtliche abonnierte DPs auf ein mal in die DB zu schreiben, was die SQLite DB überfordert? Kann ich dem irgendwie entgegenwirken?

beste Grüße

fox

-

Ja das liegt an SQLite, Die kann immer nur eine Anfrage abarbeiten und ist daher (und auch aus anderen gründen) nur für nicht so viele Datenpunkte geeignet.

Und ja der Start schreibt den aktuellen Wert überall rein.

Du könntest mal versuchen das Limit höher zu setzen. Wenn Du das versuchen willst mach mal /opt/iobroker/node_modules/iobroker.sql/main.js in einem editor auf. und suche dort nach der Meldung. Gibts mehrfach. Ist immer so grob bei:

if (!multiRequests) { if (tasks.length > 100) { adapter.log.error('Cannot queue new requests, because more than 100');Da musst Du das 100 mal durch was anderes tauschen, also 500 oder 1000 :-)

Interessant wäre da vorher/nachher mal Speicherverbrauch und sowas zu vergleichen.

Eine Alternative wäre noch bei SQLite dieses Initiale Schreiben zu verhindern … Denke das ist eher noch "the way to go".

1.7.2 vom SQL Adapter vom Github schaltet WriteNulls bei SQLite automatisch aus

-

Du könntest mal versuchen das Limit höher zu setzen. Wenn Du das versuchen willst mach mal /opt/iobroker/node_modules/iobroker.sql/main.js in einem editor auf. und suche dort nach der Meldung. Gibts mehrfach. Ist immer so grob bei:

if (!multiRequests) { if (tasks.length > 100) { adapter.log.error('Cannot queue new requests, because more than 100');Da musst Du das 100 mal durch was anderes tauschen, also 500 oder 1000 :-)

Interessant wäre da vorher/nachher mal Speicherverbrauch und sowas zu vergleichen. `

Ich werde es bei Gelegenheit mal versuchen, allerdings war die DB wohl teilweise auch schon überfordert beim Neustart.

2018-03-24 09:48:11.319 - error: sql.0 Cannot queue new requests, because more than 100 2018-03-24 09:48:11.428 - error: sql.0 Cannot select SELECT id, type, name FROM datapoints WHERE name='harmony.0.fox.activities.Anzeige-Netflix';: Error: SQLITE_BUSY: database is locked 2018-03-24 09:48:11.430 - warn: sql.0 Cannot get index of "harmony.0.fox.activities.Anzeige-Netflix": Error: SQLITE_BUSY: database is lockedEine Alternative wäre noch bei SQLite dieses Initiale Schreiben zu verhindern … Denke das ist eher noch "the way to go". `

Das habe ich jetzt erst mal so gemacht. Danke - war mir nicht sicher ob ich das mit den NULL-Werten bei Start/Stop schreiben richtig interpretiert hatte. :D

-

Ich weiss aber das es sonderlogik für "Duplicates" gibt die das ganze mit +1ms Timestamp nochmals schreibt. Die ist schon ewig drin … `

Die Werte doppelt in die Datenbank zu schreiben ist aber auch nicht wirklich sehr Resourcen schonend.