NEWS

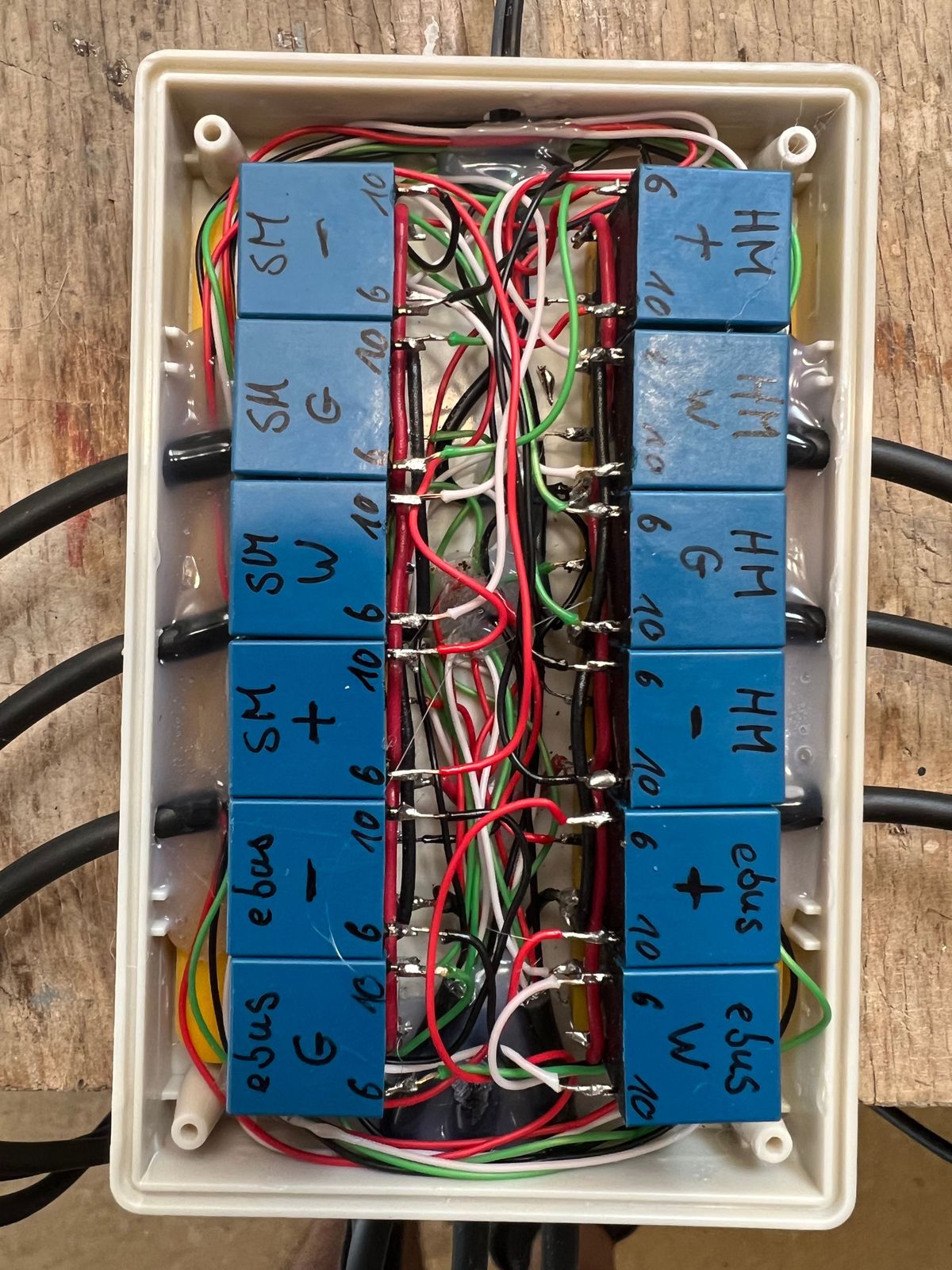

USB Switch zwischen zwei NUC Eigenbau

-

@saeft_2003 Cool. Und wie sieht das mit der Datenübertragung aus? Ist ja nicht geschirmt und da können so einige Interferenzen entstehen.

-

@saeft_2003 Cool. Und wie sieht das mit der Datenübertragung aus? Ist ja nicht geschirmt und da können so einige Interferenzen entstehen.

@dr-bakterius

Das ganze läuft jetzt seit 2 Wochen und ich konnte keine Probleme feststellen. Vielleicht machen die 15cm ungeschirmt nicht so viel aus?

Das eine ist für Smartmeter wo sekündlich Daten rein kommen und der andere ist für ein Homematic RF Stick wo auch viel drüber geht. Wie gesagt alles läuft.

-

Falls irgendwer Interesse an dem Skript (blockly) hat wo automatisch proxmox backup zurückspielt dann bitte melden.

@saeft_2003

Hallo,ich habe eine ähnliche Konfiguration mit 1 NUC und 1 GEEK (ist praktisch dasselbe) beide auch mit Proxmox.

Ich habe aktuell meine VM/CT auf beide Rechner gleichmäßig verteilt, also WEB-Server mit NC, iobroker, Grafana, InfluxDB, Dateiserver Musik/Film/Fotoserver, MariaDB, ....

Meine Rechner hängen an einer SUV, aber nur einer wird, nach dem wieder Strom da ist, auch wieder eingeschaltet.

Ich sichere das Ganze bisher eher sporadisch und auch nur manuell.Der Raspi mit CCU3 hängt mal ganz woanders.

Daher interessiert mich das Skript.

Gruß und vielen Dank im Voraus!

-

@saeft_2003

Hallo,ich habe eine ähnliche Konfiguration mit 1 NUC und 1 GEEK (ist praktisch dasselbe) beide auch mit Proxmox.

Ich habe aktuell meine VM/CT auf beide Rechner gleichmäßig verteilt, also WEB-Server mit NC, iobroker, Grafana, InfluxDB, Dateiserver Musik/Film/Fotoserver, MariaDB, ....

Meine Rechner hängen an einer SUV, aber nur einer wird, nach dem wieder Strom da ist, auch wieder eingeschaltet.

Ich sichere das Ganze bisher eher sporadisch und auch nur manuell.Der Raspi mit CCU3 hängt mal ganz woanders.

Daher interessiert mich das Skript.

Gruß und vielen Dank im Voraus!

Kann ich heute Abend posten und kurz dazu was erklären…

-

@saeft_2003

Hallo,ich habe eine ähnliche Konfiguration mit 1 NUC und 1 GEEK (ist praktisch dasselbe) beide auch mit Proxmox.

Ich habe aktuell meine VM/CT auf beide Rechner gleichmäßig verteilt, also WEB-Server mit NC, iobroker, Grafana, InfluxDB, Dateiserver Musik/Film/Fotoserver, MariaDB, ....

Meine Rechner hängen an einer SUV, aber nur einer wird, nach dem wieder Strom da ist, auch wieder eingeschaltet.

Ich sichere das Ganze bisher eher sporadisch und auch nur manuell.Der Raspi mit CCU3 hängt mal ganz woanders.

Daher interessiert mich das Skript.

Gruß und vielen Dank im Voraus!

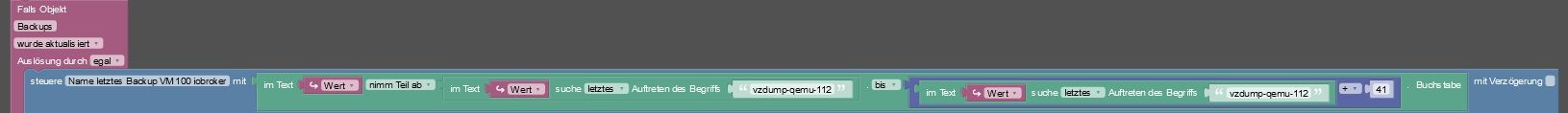

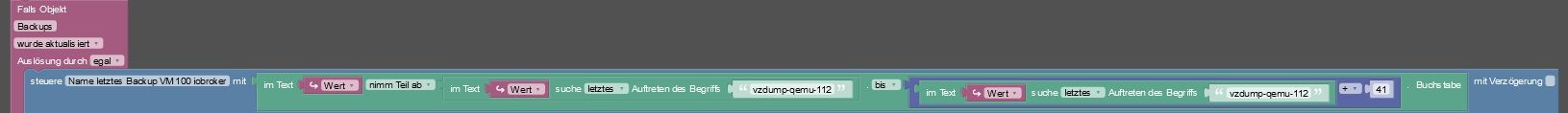

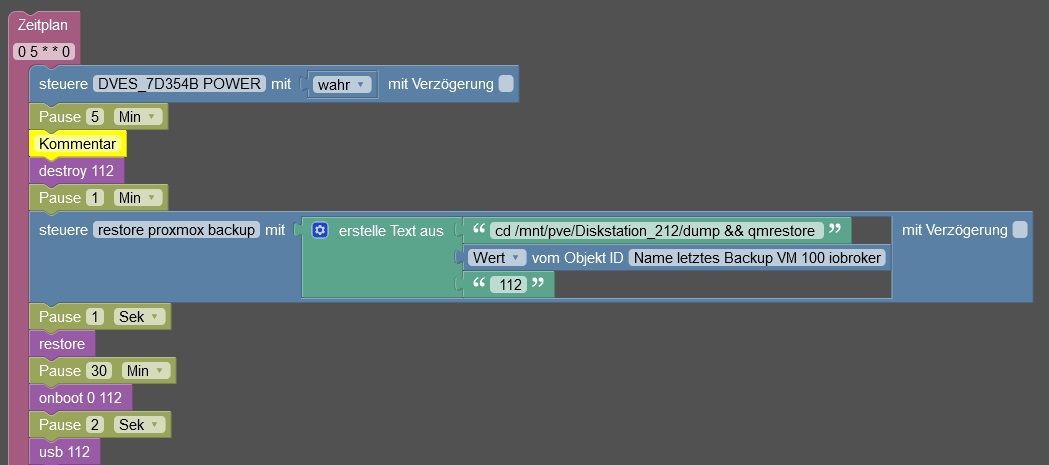

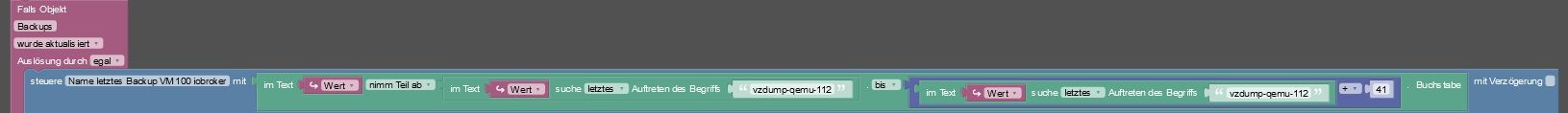

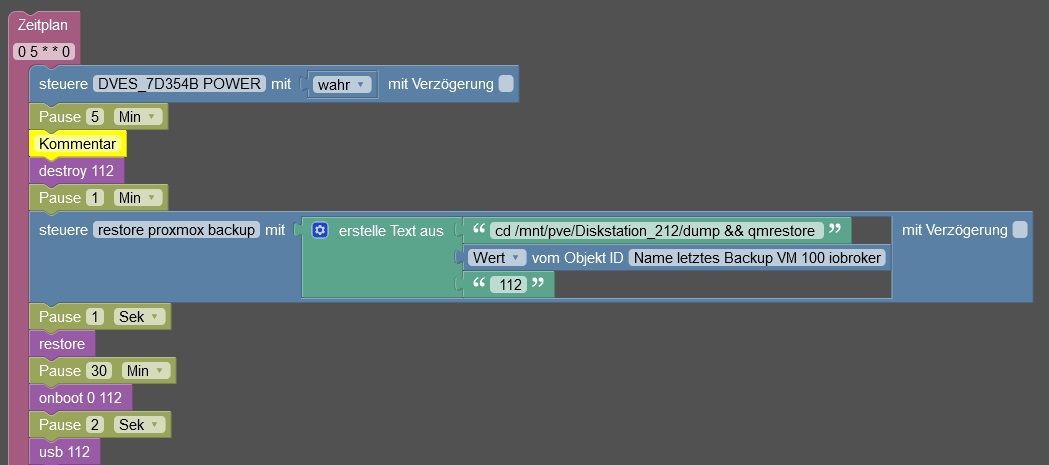

als erstes brauch man den linux-control Adapter. Mit dem kann ich anzeigen lassen wie die letzten Backups auf dem NAS heißen. Hier eine grobe Anleitung bezogen auf die VM 112. Ich mache das so mit mehreren VMs nacheinander.

Befehl:

cd /mnt/pve/Diskstation_212/dump && lsAusgabe:

vzdump-qemu-112-2024_06_23-01_15_02.vma.gz vzdump-qemu-112-2024_06_24-01_15_02.vma.gz vzdump-qemu-112-2024_06_26-01_15_02.vma.gz vzdump-qemu-112-2024_06_28-01_15_03.vma.gz vzdump-qemu-112-2024_06_29-01_15_02.vma.gz vzdump-qemu-112-2024_06_30-01_15_00.vma.gz vzdump-qemu-112-2024_07_01-01_15_02.vma.gz vzdump-qemu-112-2024_07_03-01_15_02.vma.gz vzdump-qemu-112-2024_07_05-01_15_02.vma.gz vzdump-qemu-112-2024_07_06-01_15_02.vma.gz vzdump-qemu-112-2024_07_07-01_15_05.vma.gz vzdump-qemu-112-2024_07_08-01_15_01.vma.gz vzdump-qemu-112-2024_07_10-01_15_04.vma.gz vzdump-qemu-112-2024_07_12-01_15_03.vma.gz vzdump-qemu-112-2024_07_13-01_15_02.vma.gzMit dem Block schreib ich den Name vom letzen Backup in einen DP.

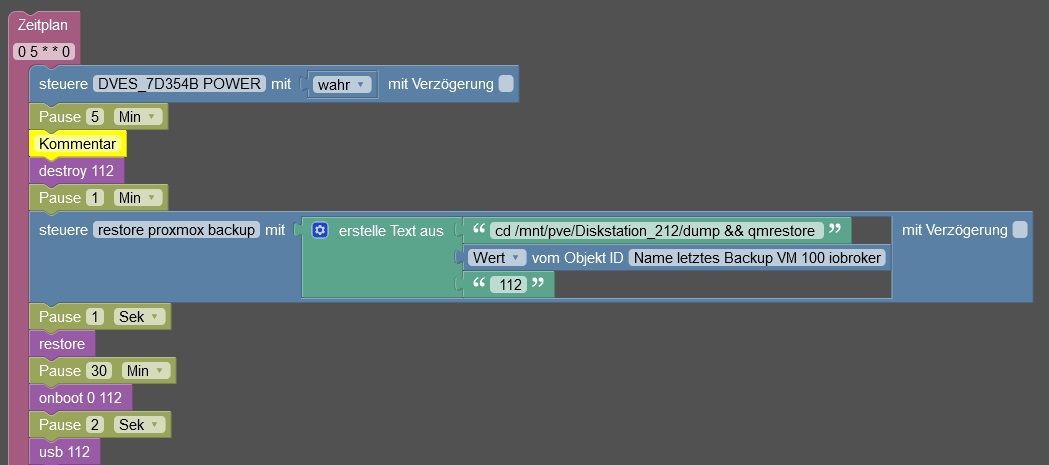

vzdump-qemu-112-2024_07_13-01_15_02.vma.gzJeden Sonntag um 5:00 Uhr wird über eine WLAN Steckdose der Backup NUC gestartet (muss man evtl im Bios einstellen).

Dann kommt folgender Ablauf.- destroy 112 --> löscht die alte VM

ssh.exec('qm destroy 112').start();- Danach wird ein restore DP geschrieben der das letzte backup beinhaltet

cd /mnt/pve/Diskstation_212/dump && qmrestore vzdump-qemu-112-2024_07_07-02_00_05.vma.gz 112- restore --> startet das zurückspielen der VM

ssh.exec(getState('javascript.0.restore_proxmox_backup').val).start();- onboot 0 112 --> bewirkt das beim nächsten NUC start die VM nicht mit startet

ssh.exec('qm set 112 --onboot 0').start();- usb 112 --> ändert den durchgereichten USB port passend zum backup NUC

ssh.exec('qm set 112 -usb1 host=1-3').start();

Hier das komplette skript. Es müssen natürlich einige Sachen angepasst werden und DP erstellt. Falls Fragen stehe ich gerne bereit.

-

als erstes brauch man den linux-control Adapter. Mit dem kann ich anzeigen lassen wie die letzten Backups auf dem NAS heißen. Hier eine grobe Anleitung bezogen auf die VM 112. Ich mache das so mit mehreren VMs nacheinander.

Befehl:

cd /mnt/pve/Diskstation_212/dump && lsAusgabe:

vzdump-qemu-112-2024_06_23-01_15_02.vma.gz vzdump-qemu-112-2024_06_24-01_15_02.vma.gz vzdump-qemu-112-2024_06_26-01_15_02.vma.gz vzdump-qemu-112-2024_06_28-01_15_03.vma.gz vzdump-qemu-112-2024_06_29-01_15_02.vma.gz vzdump-qemu-112-2024_06_30-01_15_00.vma.gz vzdump-qemu-112-2024_07_01-01_15_02.vma.gz vzdump-qemu-112-2024_07_03-01_15_02.vma.gz vzdump-qemu-112-2024_07_05-01_15_02.vma.gz vzdump-qemu-112-2024_07_06-01_15_02.vma.gz vzdump-qemu-112-2024_07_07-01_15_05.vma.gz vzdump-qemu-112-2024_07_08-01_15_01.vma.gz vzdump-qemu-112-2024_07_10-01_15_04.vma.gz vzdump-qemu-112-2024_07_12-01_15_03.vma.gz vzdump-qemu-112-2024_07_13-01_15_02.vma.gzMit dem Block schreib ich den Name vom letzen Backup in einen DP.

vzdump-qemu-112-2024_07_13-01_15_02.vma.gzJeden Sonntag um 5:00 Uhr wird über eine WLAN Steckdose der Backup NUC gestartet (muss man evtl im Bios einstellen).

Dann kommt folgender Ablauf.- destroy 112 --> löscht die alte VM

ssh.exec('qm destroy 112').start();- Danach wird ein restore DP geschrieben der das letzte backup beinhaltet

cd /mnt/pve/Diskstation_212/dump && qmrestore vzdump-qemu-112-2024_07_07-02_00_05.vma.gz 112- restore --> startet das zurückspielen der VM

ssh.exec(getState('javascript.0.restore_proxmox_backup').val).start();- onboot 0 112 --> bewirkt das beim nächsten NUC start die VM nicht mit startet

ssh.exec('qm set 112 --onboot 0').start();- usb 112 --> ändert den durchgereichten USB port passend zum backup NUC

ssh.exec('qm set 112 -usb1 host=1-3').start();

Hier das komplette skript. Es müssen natürlich einige Sachen angepasst werden und DP erstellt. Falls Fragen stehe ich gerne bereit.

@saeft_2003

Hallo,Erst mal vielen Dank!!

Das ist ja mal eine spannende Aufgabe, ich denke damit werde ich ein Weilchen beschäftigt sein.

Ich melde mich damn mal wenn ich wenn ich damit fertig bin

Gruß -

als erstes brauch man den linux-control Adapter. Mit dem kann ich anzeigen lassen wie die letzten Backups auf dem NAS heißen. Hier eine grobe Anleitung bezogen auf die VM 112. Ich mache das so mit mehreren VMs nacheinander.

Befehl:

cd /mnt/pve/Diskstation_212/dump && lsAusgabe:

vzdump-qemu-112-2024_06_23-01_15_02.vma.gz vzdump-qemu-112-2024_06_24-01_15_02.vma.gz vzdump-qemu-112-2024_06_26-01_15_02.vma.gz vzdump-qemu-112-2024_06_28-01_15_03.vma.gz vzdump-qemu-112-2024_06_29-01_15_02.vma.gz vzdump-qemu-112-2024_06_30-01_15_00.vma.gz vzdump-qemu-112-2024_07_01-01_15_02.vma.gz vzdump-qemu-112-2024_07_03-01_15_02.vma.gz vzdump-qemu-112-2024_07_05-01_15_02.vma.gz vzdump-qemu-112-2024_07_06-01_15_02.vma.gz vzdump-qemu-112-2024_07_07-01_15_05.vma.gz vzdump-qemu-112-2024_07_08-01_15_01.vma.gz vzdump-qemu-112-2024_07_10-01_15_04.vma.gz vzdump-qemu-112-2024_07_12-01_15_03.vma.gz vzdump-qemu-112-2024_07_13-01_15_02.vma.gzMit dem Block schreib ich den Name vom letzen Backup in einen DP.

vzdump-qemu-112-2024_07_13-01_15_02.vma.gzJeden Sonntag um 5:00 Uhr wird über eine WLAN Steckdose der Backup NUC gestartet (muss man evtl im Bios einstellen).

Dann kommt folgender Ablauf.- destroy 112 --> löscht die alte VM

ssh.exec('qm destroy 112').start();- Danach wird ein restore DP geschrieben der das letzte backup beinhaltet

cd /mnt/pve/Diskstation_212/dump && qmrestore vzdump-qemu-112-2024_07_07-02_00_05.vma.gz 112- restore --> startet das zurückspielen der VM

ssh.exec(getState('javascript.0.restore_proxmox_backup').val).start();- onboot 0 112 --> bewirkt das beim nächsten NUC start die VM nicht mit startet

ssh.exec('qm set 112 --onboot 0').start();- usb 112 --> ändert den durchgereichten USB port passend zum backup NUC

ssh.exec('qm set 112 -usb1 host=1-3').start();

Hier das komplette skript. Es müssen natürlich einige Sachen angepasst werden und DP erstellt. Falls Fragen stehe ich gerne bereit.

@saeft_2003

Ich habe das Script soweit nachbauen können, und ich denke es funktioniert soweit.

Der erste Container wird ohne Probleme in Proxmox angelegt. Aber beim zweiten kommt dann folgende Fehlermeldung:recovering backed-up configuration from 'vzdump-lxc-102-2024_07_14-01_06_18.tar.lzo' WARNING: You have not turned on protection against thin pools running out of space. WARNING: Set activation/thin_pool_autoextend_threshold below 100 to trigger automatic extension of thin pools before they get full. Logical volume "vm-102-disk-2" created. WARNING: Sum of all thin volume sizes (216.00 GiB) exceeds the size of thin pool pve/data and the amount of free space in volume group (<16.00 GiB). Creating filesystem with 8388608 4k blocks and 2097152 inodes Filesystem UUID: 71e0c8ba-f330-42d9-9607-8798d9495b89 Superblock backups stored on blocks: 32768, 98304, 163840, 229376, 294912, 819200, 884736, 1605632, 2654208, 4096000, 7962624 restoring 'vzdump-lxc-102-2024_07_14-01_06_18.tar.lzo' now.. extracting archive '/mnt/pve/nfsBackup/dump/vzdump-lxc-102-2024_07_14-01_06_18.tar.lzo' TASK ERROR: broken pipeWenn ich diesen Container manuell in Proxmox wieder erstelle, wird er ohne Probleme angelegt. Auch wenn ich ihn mittels Befehl in Putty erstelle wird dieser wieder angelegt:

cd /mnt/pve/nfsBackup/dump && pct restore 102 vzdump-lxc-102-2024_07_14-01_06_18.tar.lzo --storage local-lvmHast du eine Idee an was dies liegen kann.

Danke

Heiko

-

@saeft_2003

Ich habe das Script soweit nachbauen können, und ich denke es funktioniert soweit.

Der erste Container wird ohne Probleme in Proxmox angelegt. Aber beim zweiten kommt dann folgende Fehlermeldung:recovering backed-up configuration from 'vzdump-lxc-102-2024_07_14-01_06_18.tar.lzo' WARNING: You have not turned on protection against thin pools running out of space. WARNING: Set activation/thin_pool_autoextend_threshold below 100 to trigger automatic extension of thin pools before they get full. Logical volume "vm-102-disk-2" created. WARNING: Sum of all thin volume sizes (216.00 GiB) exceeds the size of thin pool pve/data and the amount of free space in volume group (<16.00 GiB). Creating filesystem with 8388608 4k blocks and 2097152 inodes Filesystem UUID: 71e0c8ba-f330-42d9-9607-8798d9495b89 Superblock backups stored on blocks: 32768, 98304, 163840, 229376, 294912, 819200, 884736, 1605632, 2654208, 4096000, 7962624 restoring 'vzdump-lxc-102-2024_07_14-01_06_18.tar.lzo' now.. extracting archive '/mnt/pve/nfsBackup/dump/vzdump-lxc-102-2024_07_14-01_06_18.tar.lzo' TASK ERROR: broken pipeWenn ich diesen Container manuell in Proxmox wieder erstelle, wird er ohne Probleme angelegt. Auch wenn ich ihn mittels Befehl in Putty erstelle wird dieser wieder angelegt:

cd /mnt/pve/nfsBackup/dump && pct restore 102 vzdump-lxc-102-2024_07_14-01_06_18.tar.lzo --storage local-lvmHast du eine Idee an was dies liegen kann.

Danke

Heiko

tut mir leid wüsste jetzt nicht an was das liegen könnte. Ich kenn diesen broken pipe error nicht. Vielleicht kann dir da das proxmox forum helfen?

Meldest du dich per ssh mit root an?

-

tut mir leid wüsste jetzt nicht an was das liegen könnte. Ich kenn diesen broken pipe error nicht. Vielleicht kann dir da das proxmox forum helfen?

Meldest du dich per ssh mit root an?

@saeft_2003 said in USB Switch zwischen zwei NUC Eigenbau:

tut mir leid wüsste jetzt nicht an was das liegen könnte. Ich kenn diesen broken pipe error nicht. Vielleicht kann dir da das proxmox forum helfen?

Meldest du dich per ssh mit root an?

Ja, mit root. Sollte ich es mal mit einem anderen User probieren ?

-

@saeft_2003 said in USB Switch zwischen zwei NUC Eigenbau:

tut mir leid wüsste jetzt nicht an was das liegen könnte. Ich kenn diesen broken pipe error nicht. Vielleicht kann dir da das proxmox forum helfen?

Meldest du dich per ssh mit root an?

Ja, mit root. Sollte ich es mal mit einem anderen User probieren ?

@eve11 sagte in USB Switch zwischen zwei NUC Eigenbau:

Ja, mit root. Sollte ich es mal mit einem anderen User probieren ?

Man wurschtelt unter Linux nicht als root im System rum.