NEWS

Freies Modell bei OpenAI -gpt-4o-mini-

-

Moinsen,

ich wollte erstmal das KI vorsichtig probieren.

Bevor ich Geld investiere , möchte ich das Konstrukt verstehen.

Nun habe ich bei Google das Modell "gemini-2.5-flash" aktiviert.

Muss sagen, dass ich davon, wie gesagt keine Ahnung habe.

Jedenfalls gibt es , verständlich, ein Ratelimit.

Jetzt kommt das Verständnisproblem. Da tauchen Begriffe wie RPM, Ein -und Ausgabetoken etc.

Keinen Schimmer wie das berechnet wird. Deswegen auch die Angst , dass monetär zu versuchen.

Ich hab das Modell mal bei Bildbeschreibung eingesetzt und war schnell beim Ratelimit.

Also weitergesucht.

Bin dann bei OpenAI gelandet.

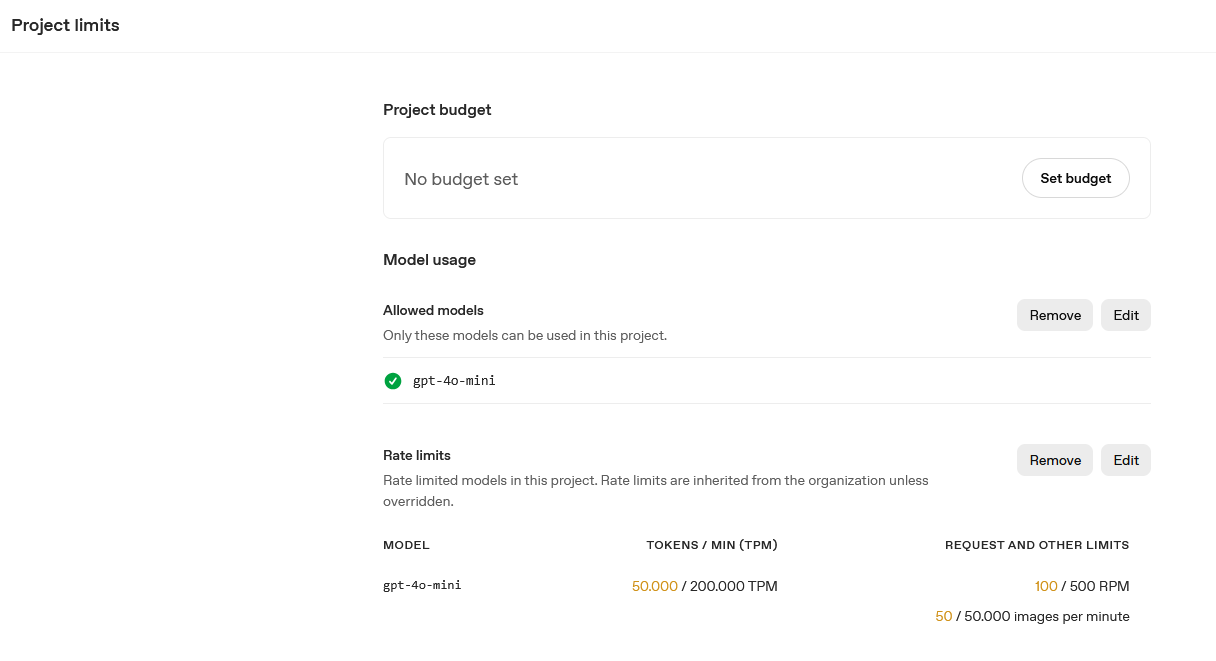

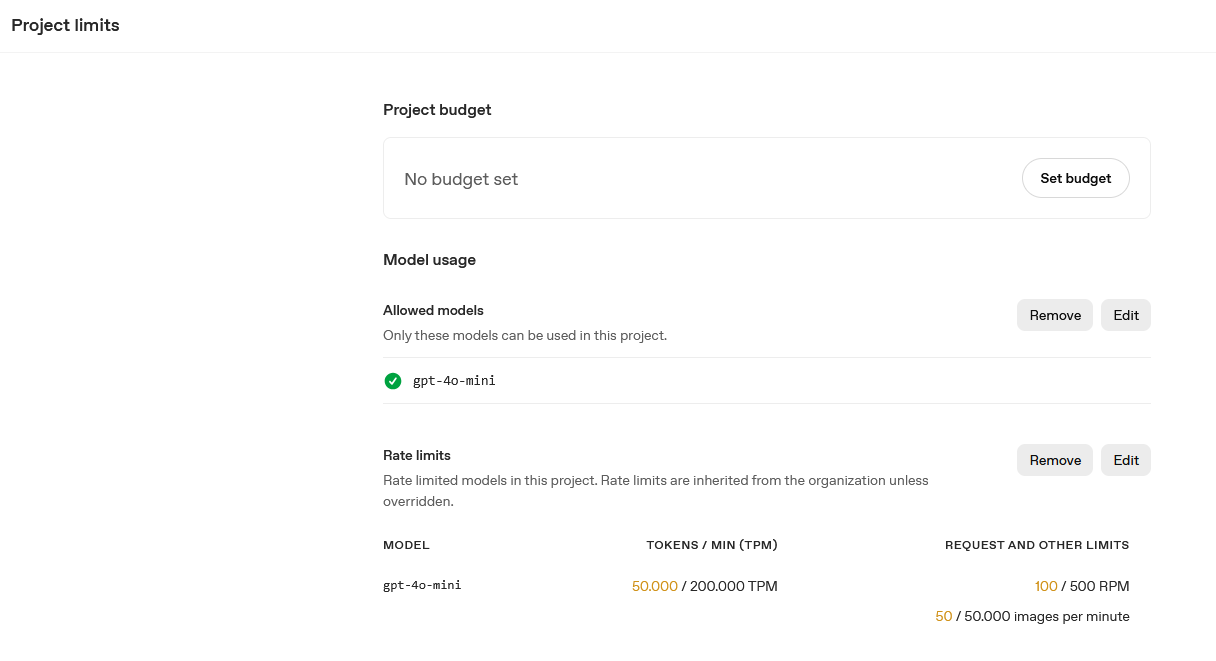

Dort gibt es, so habe ich es verstanden, ein freies Modell "gpt-4o-mini" , limitiert, aber kostenlos.

Um es zu nutzen muss man eine Kreditkarte hinterlegen.

Also das Modell in meine Software eingetragen.

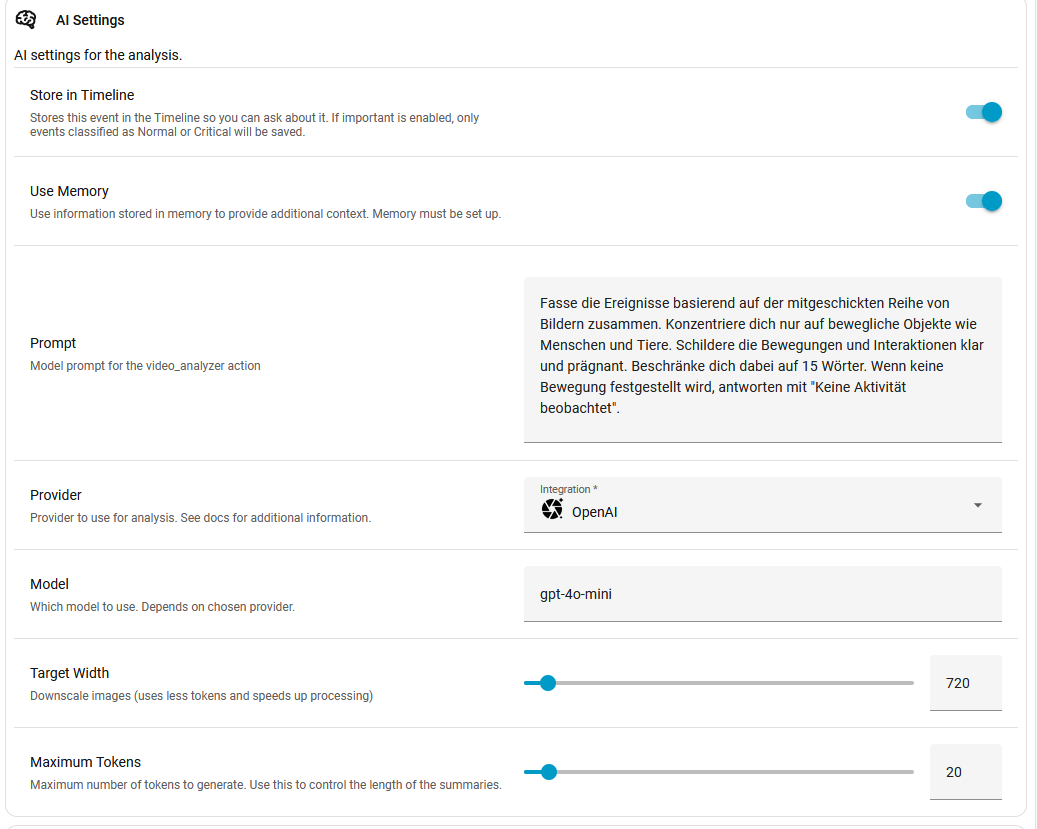

Ich habe den Abfragetoken auf 20 gestellt.

Jetzt gucke ich in Usage auf der OpenAI Seite und da steht , ich hab in 24 Std. 2,600.000 Token verbraucht.

Ich lasse bei Bewegung von 2 Kameras das Bild analysieren.Erleuchte mich mal bitte jemand.

Wenn es geht , verständlich :) -

Nun, erklären kann ich dir das nicht. Ein Token ist in etwa eine Silbe. Geld verballern war auch meine große Sorge aber für meinen Anwendungszweck kann ich sagen dass ich in 3Monaten Abo (nennt sich PLUS, 23,-, mtl. kündbar) nie an das Limit gekommen bin. Mein Vorschlag, hau rein und schau wann du das Limit erreicht hast. Die 20 scheint mir in Millionen zu sein, das ist was auch bei den Modellen immer steht. Ich gehe davon aus dass die KK nur zur Verifizierung angegeben wurde, nicht um dir ohne dein Wollen das Konto zu räumen

Es gibt auch noch die API Nutzung, die wird getrennt abgerechnet und ist für Programmierer bzw. programmatische Abfragen. Da lädst du einen Betrag hoch und kannst noch einstellen wieviel Geld du max. zuschiessen willst pro Monat. Ich denke dass dein Programm diese Schnittstelle nutzt, du müsstest dann eig einen API-Key haben und den dort eintragen?

Ich programmiere gerade einen Bot für einen Freund und hab da gefühlt unendlich viele Abfragen gemacht. Etwas besorgt wieviel ich denn verbraten habe waren das gerade mal 1,78Eur.Also mit der mtl. Kündigung und diesem 'Prepaid' (für API) konnte ich keine Fallstricke erkennen. Wenn irgendwelche Limits erreicht werden(modellabhängig, zb. Token/Minute) sagt dir das OpenAi und dann geht es nach Ablauf dieser Minute wieder weiter.

-

Nun, erklären kann ich dir das nicht. Ein Token ist in etwa eine Silbe. Geld verballern war auch meine große Sorge aber für meinen Anwendungszweck kann ich sagen dass ich in 3Monaten Abo (nennt sich PLUS, 23,-, mtl. kündbar) nie an das Limit gekommen bin. Mein Vorschlag, hau rein und schau wann du das Limit erreicht hast. Die 20 scheint mir in Millionen zu sein, das ist was auch bei den Modellen immer steht. Ich gehe davon aus dass die KK nur zur Verifizierung angegeben wurde, nicht um dir ohne dein Wollen das Konto zu räumen

Es gibt auch noch die API Nutzung, die wird getrennt abgerechnet und ist für Programmierer bzw. programmatische Abfragen. Da lädst du einen Betrag hoch und kannst noch einstellen wieviel Geld du max. zuschiessen willst pro Monat. Ich denke dass dein Programm diese Schnittstelle nutzt, du müsstest dann eig einen API-Key haben und den dort eintragen?

Ich programmiere gerade einen Bot für einen Freund und hab da gefühlt unendlich viele Abfragen gemacht. Etwas besorgt wieviel ich denn verbraten habe waren das gerade mal 1,78Eur.Also mit der mtl. Kündigung und diesem 'Prepaid' (für API) konnte ich keine Fallstricke erkennen. Wenn irgendwelche Limits erreicht werden(modellabhängig, zb. Token/Minute) sagt dir das OpenAi und dann geht es nach Ablauf dieser Minute wieder weiter.

Hey, danke , dass Du Dich dem Thema annimmst.

Ich musste 5$ Dollar "hochladen" von meiner Kreditkarte.

Habe eingestellt, dass nicht nachgeladen werden soll.

Ich habe da auch nichts wildes abgeschlossen.

Eigentlich das kostenlose Abo.

Hab das KI Modell gewählt gpt-4o-mini.

Und den Secret Key eingetragen in HA (Blueprint)Es handelt sich um das Projekt:

https://www.youtube.com/watch?v=95qyHtzljsU

Ich hab das Limit schon runtergesetzt.

In ein paar Stunden sind 55 Cent zusammengekommen. Wenn ich das mal hochrechne....

Ich wollte das eigentlich in meiner VIS abbilden (Bild mit Beschreibung). Aber , wie ich schon sagte, gerät das Kostentechnisch ausser Kontrolle.

-

Hey, danke , dass Du Dich dem Thema annimmst.

Ich musste 5$ Dollar "hochladen" von meiner Kreditkarte.

Habe eingestellt, dass nicht nachgeladen werden soll.

Ich habe da auch nichts wildes abgeschlossen.

Eigentlich das kostenlose Abo.

Hab das KI Modell gewählt gpt-4o-mini.

Und den Secret Key eingetragen in HA (Blueprint)Es handelt sich um das Projekt:

https://www.youtube.com/watch?v=95qyHtzljsU

Ich hab das Limit schon runtergesetzt.

In ein paar Stunden sind 55 Cent zusammengekommen. Wenn ich das mal hochrechne....

Ich wollte das eigentlich in meiner VIS abbilden (Bild mit Beschreibung). Aber , wie ich schon sagte, gerät das Kostentechnisch ausser Kontrolle.

Bilder sind halt immer viele Daten und damit Inputtoken

Je nachdem wie dein prompt lautet gibt die KI viel aus. Das sind dann die Output Token. Per prompt kann man aber vorgeben wie umfangreich ausgegeben werden soll. Bspw könntest du sagen:

Liste mir alle Objekte kommasepariert auf.

Dann wird es schon weniger.4o mini ist jetzt aber auch nicht ganz so intelligent wie die aktuellen Modelle.

Für kontinuierliche Bildanalyse wirst du dich aktuell wahrscheinlich schon tot zahlen.

Da bleibt eigentlich nur ein lokales Modell.

Die passende Hardware ist aber leider auch nicht so ganz günstig und Strom schluckt das dann auch entsprechend.Alles mit Text ist eigentlich unproblematisch von der Menge. OpenAI hat zwar auch ein paar spezielle Modelle, bei denen auch bei Text der Input Output entsprechend teuer ist.. Die braucht der normale Mensch aber nicht.

-

Bilder sind halt immer viele Daten und damit Inputtoken

Je nachdem wie dein prompt lautet gibt die KI viel aus. Das sind dann die Output Token. Per prompt kann man aber vorgeben wie umfangreich ausgegeben werden soll. Bspw könntest du sagen:

Liste mir alle Objekte kommasepariert auf.

Dann wird es schon weniger.4o mini ist jetzt aber auch nicht ganz so intelligent wie die aktuellen Modelle.

Für kontinuierliche Bildanalyse wirst du dich aktuell wahrscheinlich schon tot zahlen.

Da bleibt eigentlich nur ein lokales Modell.

Die passende Hardware ist aber leider auch nicht so ganz günstig und Strom schluckt das dann auch entsprechend.Alles mit Text ist eigentlich unproblematisch von der Menge. OpenAI hat zwar auch ein paar spezielle Modelle, bei denen auch bei Text der Input Output entsprechend teuer ist.. Die braucht der normale Mensch aber nicht.

-

Da ist so das Sparsamste, was man eingeben kann, so denke ich.

Es kommt ein Bild mit max. 15 Wörtern als Beschreibung. Ich, als Laie würde sagen, spartanisch.

Wenn es um Analyse von beweglichen Bildern geht, Gesichtserkennung, Objekterkennung, Tracking

Dann könnte man es auch mit opencv probieren.

Das ist Open Source, läuft auf normaler Hardware und hat auch KI Fähigkeiten (eine andere Art von KI, die aktuell bekannten sind ja alles sogenannte LLMs)

https://opencv.org/Das kann das sogar auf normale Hardware

-

Bilder sind halt immer viele Daten und damit Inputtoken

Je nachdem wie dein prompt lautet gibt die KI viel aus. Das sind dann die Output Token. Per prompt kann man aber vorgeben wie umfangreich ausgegeben werden soll. Bspw könntest du sagen:

Liste mir alle Objekte kommasepariert auf.

Dann wird es schon weniger.4o mini ist jetzt aber auch nicht ganz so intelligent wie die aktuellen Modelle.

Für kontinuierliche Bildanalyse wirst du dich aktuell wahrscheinlich schon tot zahlen.

Da bleibt eigentlich nur ein lokales Modell.

Die passende Hardware ist aber leider auch nicht so ganz günstig und Strom schluckt das dann auch entsprechend.Alles mit Text ist eigentlich unproblematisch von der Menge. OpenAI hat zwar auch ein paar spezielle Modelle, bei denen auch bei Text der Input Output entsprechend teuer ist.. Die braucht der normale Mensch aber nicht.

@OliverIO sagte in Freies Modell bei OpenAI -gpt-4o-mini-:

Bilder sind halt immer viele Daten und damit Inputtoken

Ja und Nein. Ich hab vor ein paar Wochen gelesen das Forscher fest gestellt haben das Bilder mit der selben Token Anzahl wie ein Text deutlich mehr Informationen beinhalten als wenn sie als Text in ein LLM geladen werden.

@haselchen sagte in Freies Modell bei OpenAI -gpt-4o-mini-:

Da ist so das Sparsamste, was man eingeben kann, so denke ich.

LLMs kommen gut damit klar wenn die Bild Auflösung niedriger ist. Je nachdem was man erkennen will kann man also durch Reduzierung der Auflösung auch Token Sparen.

Das machst du bereits wie im Screenshot zu sehen.

Je nachdem was deine Kameras können, kannst du jetzt noch die Bild Anzahl reduzieren. Die Reolink Kameras erkennen Menschen, Tiere und Autos, das kann man sich zu nutze machen und entsprechend nur Bilder nehmen auf denen mindestens eins davon erkannt wurde.@OliverIO sagte in Freies Modell bei OpenAI -gpt-4o-mini-:

Dann könnte man es auch mit opencv probieren.

Damit hab ich auch schon gespielt und das ist wirklich gut. Der größte Vorteil ist das es auch mit Intel Grafik Chips beschleunigt werden kann, die meistens in den Mini PCs zu finden sind.

@OliverIO sagte in Freies Modell bei OpenAI -gpt-4o-mini-:

Da bleibt eigentlich nur ein lokales Modell.

Ich hab qwen3-vl auf dem Smartphone getestet und muss sagen es war Überraschend schnell und hat gute Ergebnisse geliefert.

-

Kleines Update:

Mit dem OpenAI war ich nach Stunden soweit, dass meine 5 Dollar aufgebraucht waren.

Also hab ich auf Google umgestellt.

Erst wieder auf gemini-2.5-flash-lite.

Da wurde dann mal nen Bild interpretiert und dann wieder gabs nen Fehler (Couldn't generate content. Check logs for details.)

Vermutlich das Ratelimit.

Komischerweise wurde dann das nächste Bild wieder interpretiert.

Das macht natürlich wenig Sinn, wenn man vernünftig damit arbeiten will.

Also das nächste Modell genommen. Angeblich die Speerspitze aktuell bei Google: gemini-3-flash-preview

Leute, Leute, was da für ein Mist rauskam. Unglaublich.

"Fehler bei System gesehen oder Fehler bei Inhaltsgenerierung gesehen" war noch das Harmlostete, was die gute KI als Bildüberschrift da rausgeschmissen hat.

Wie gesagt, es soll ein Bild(Snapshot) mit einem Tier interpretiert werden.@oliverio

@jey-cee

Für die KIs, die ihr mir genannt habt, da fehlt mir das Wissen zu und definitiv die Zeit, mich da sicher einzuarbeiten.

Ich geb gerne 5 oder 10€ aus im Monat für die "Spielerei", aber nicht für ne Sache, die ausser Kontrolle gerät.

Und das tut es vermutlich, weil mir das Wissen fehlt.Wenn jemand ein KI Modell kennt, welches sich einfach integrieren lässt und transparent/überschaubar von Nutzen & Kosten ist, immer her damit.

-

Kleines Update:

Mit dem OpenAI war ich nach Stunden soweit, dass meine 5 Dollar aufgebraucht waren.

Also hab ich auf Google umgestellt.

Erst wieder auf gemini-2.5-flash-lite.

Da wurde dann mal nen Bild interpretiert und dann wieder gabs nen Fehler (Couldn't generate content. Check logs for details.)

Vermutlich das Ratelimit.

Komischerweise wurde dann das nächste Bild wieder interpretiert.

Das macht natürlich wenig Sinn, wenn man vernünftig damit arbeiten will.

Also das nächste Modell genommen. Angeblich die Speerspitze aktuell bei Google: gemini-3-flash-preview

Leute, Leute, was da für ein Mist rauskam. Unglaublich.

"Fehler bei System gesehen oder Fehler bei Inhaltsgenerierung gesehen" war noch das Harmlostete, was die gute KI als Bildüberschrift da rausgeschmissen hat.

Wie gesagt, es soll ein Bild(Snapshot) mit einem Tier interpretiert werden.@oliverio

@jey-cee

Für die KIs, die ihr mir genannt habt, da fehlt mir das Wissen zu und definitiv die Zeit, mich da sicher einzuarbeiten.

Ich geb gerne 5 oder 10€ aus im Monat für die "Spielerei", aber nicht für ne Sache, die ausser Kontrolle gerät.

Und das tut es vermutlich, weil mir das Wissen fehlt.Wenn jemand ein KI Modell kennt, welches sich einfach integrieren lässt und transparent/überschaubar von Nutzen & Kosten ist, immer her damit.

Dann musst du genauer beschreiben was du eigentlich erreichen willst.

Bisher hast du nur von den Erfahrungen mit Bilder und ki geschrieben -

Dann musst du genauer beschreiben was du eigentlich erreichen willst.

Bisher hast du nur von den Erfahrungen mit Bilder und ki geschriebenIch hatte doch oben genau beschrieben worum es geht (mit Link zum Video)

Ich habe das Projekt von Simon42 "nachgebastelt".

Es wird ein Bild gemacht bei Bewegung und die KI beschreibt es.

Ziel ist es, dass mir dann Alexa sagt, wer auf der Terrasse ist.

Dazu müsste das alles schon perfekt funktionieren. -

Ich hatte doch oben genau beschrieben worum es geht (mit Link zum Video)

Ich habe das Projekt von Simon42 "nachgebastelt".

Es wird ein Bild gemacht bei Bewegung und die KI beschreibt es.

Ziel ist es, dass mir dann Alexa sagt, wer auf der Terrasse ist.

Dazu müsste das alles schon perfekt funktionieren.Habe keine detaillierte Beschreibung gefunden, auch jetzt nicht,

Videos schaue ich mir nicht an, um ein Nutzerproblem zu verstehen. Kostet mir etwas zu viel Zeit und wenn es dem nutzer auch zu viel ist, dann passt es für mich schon -

Ich hatte doch oben genau beschrieben worum es geht (mit Link zum Video)

Ich habe das Projekt von Simon42 "nachgebastelt".

Es wird ein Bild gemacht bei Bewegung und die KI beschreibt es.

Ziel ist es, dass mir dann Alexa sagt, wer auf der Terrasse ist.

Dazu müsste das alles schon perfekt funktionieren.Soweit ich mich an das Video erinnern kann soll alles was den Tag über passiert ist zusammengefasst werden.

Du Schreibst jetzt aber:

@haselchen sagte in Freies Modell bei OpenAI -gpt-4o-mini-:

Ziel ist es, dass mir dann Alexa sagt, wer auf der Terrasse ist.

Da liegen Welten dazwischen. Zum einen könnte man eben die Bild Anzahl drastisch reduzieren wenn man eine Kamera hat die Menschen erkennt. Dann ist Personenerkennung (also wer ist das) nur möglich wenn das LLM entsprechende Informationen hat oder bekommt.

@haselchen sagte in Freies Modell bei OpenAI -gpt-4o-mini-:

Angeblich die Speerspitze aktuell bei Google: gemini-3-flash-preview

Leute, Leute, was da für ein Mist rauskam. Unglaublich.Wundert mich nicht, LLMs werden auf bestimmte Inhalte trainiert. Für Bild braucht es ein LLM das entsprechend darauf trainiert wurde.

Deswegen hab ich ja qwen3-vl in den Raum geworfen das wurde dafür trainiert.

Das ist auch nicht so schwer zu installieren mit ollama, ähnlich wie die ioBroker Installation.

Die Frage ist halt ob deine Software ollama als Anbieter anbietet.