NEWS

Python-Zugriff auf InfluxDB im Docker

-

@oliverio said in Python-Zugriff auf InfluxDB im Docker:

kannst du mal die query noch weiter vereinfachen?

einfach nur eine tabelle abfragen mit möglichst wenig parameter?Habe die Abfrage nun auf ein Minimum reuziert. Bei der Gelegenheit ist mir an dieser Stelle ein Fehler aufgefallen. "my-bucket" gibt es nicht. Dennoch ist das Ergebnis unverändert.

In diesem Beitrag (es geht allerdings um den C# Client, gab es auch ein problem mit einer Angabe. Dazwischen war aber auch ein Hinweis auf ein Token mit Permission_All

https://community.influxdata.com/t/influx-cloud-compatibility-with-c-client-library/25920Der Token hat permission ALL.

In der javabibliothek bedeutet 405: Method not allowed, also könnte auch ein Hinweis auf einen Fehler in der Abfrage sein

https://influxdata.github.io/influxdb-client-java/influxdb-client-core/apidocs/com/influxdb/exceptions/class-use/InfluxException.htmlFühre ich die Abfrage im UI von InfluxDB aus bekomme ich ein Ergebnis...

dein fehlerlog ist vom client?

du könntest mal noch influxdb serverlog anschauen, ob da noch ein genauerer hinweis drin stehtwenn ich das richtig verstanden habe, dann werden die Logs in einer Datei im Docker abgelegt. Vom UI aus komme ich da vermutlich nicht hin.

@dp20eic said in Python-Zugriff auf InfluxDB im Docker:

ist denn im

api_client.pyauchGETdas Du oben benutzt auch definiert/korrekt?Den von mir geschriebenen Code habe ich vollständig hier rein kopiert. Alles andere steckt in fertigen Bibliotheken. Ich gehe momentan davon aus, dass dort nicht der Fehler liegt.

@marc-berg said in Python-Zugriff auf InfluxDB im Docker:

Sehe ich das richtig, und da sitzt ein NGINX als Reverse Proxy vor der Datenbank? Dann könnte die Fehlermeldung "Not Allowed" natürlich ein ganz andere Bedeutung haben und hätte nichts mit der Datenbank/Abfrage zu tun.

Habe nun erstmal die Vokabeln "NGINX" und "Reverse Proxy" gegoogelt. So richtig aussagefähig bin ich hier leider noch nicht.

Mein System ist ein Synology NAS mit installiertem Docker. InfluxDB läuft in dem Docker und wird über die IP des NAS angesprochen.

@OliverIO hat ja geschlussfolgert, dass die Verbindung bereits durch geht. Kann ich das irgendwie prüfen?@OliverIO bisher habe ich es noch nicht geschfft die Logs zu finden.

@marc-berg Wo der NGINX herkommt weiß ich nicht. Vermutlich gehört der zum NAS/ Docker.Ich habe mal probiert einen fehlerhaften Token zu nutzen. Die Fehlermeldung ist die gleiche. Ich glaube also nicht, dass ich schon auf der Datenbank angekommen bin.

-

@OliverIO bisher habe ich es noch nicht geschfft die Logs zu finden.

@marc-berg Wo der NGINX herkommt weiß ich nicht. Vermutlich gehört der zum NAS/ Docker.Ich habe mal probiert einen fehlerhaften Token zu nutzen. Die Fehlermeldung ist die gleiche. Ich glaube also nicht, dass ich schon auf der Datenbank angekommen bin.

https://docs.influxdata.com/influxdb/v2.7/admin/logs/

Wahrscheinlich musst du erst konfigurieren bevor da was rauskommt.Entweder du führst den Pfad per volume Parameter nach außen oder du verbindest dich auf die Shell im laufenden Container und schaust dann auf die Innere verzeichnisstruktur

https://kodekloud.com/blog/docker-exec/#Wenn du eine UI deines NAS verwendest müsste es da einen Knopf geben. So ist es zumindest im portainer

-

@OliverIO bisher habe ich es noch nicht geschfft die Logs zu finden.

@marc-berg Wo der NGINX herkommt weiß ich nicht. Vermutlich gehört der zum NAS/ Docker.Ich habe mal probiert einen fehlerhaften Token zu nutzen. Die Fehlermeldung ist die gleiche. Ich glaube also nicht, dass ich schon auf der Datenbank angekommen bin.

Habe jetzt auch erstmal keine Idee mehr dazu. Meine Vermutung ist, dass Grafana funktioniert, weil du es auch im Docker zu laufen hast und damit direkt auf die InfluxDB zugegriffen werden kann, ohne den NGINX der Synology zu benutzen.

Hast du die Möglichkeit, deinen Python-Code in einen Container zu packen, um diese Theorie auszuschließen/zu bestätigen?

Vielleicht ist es ja ein Konfigurationsproblem der Synology/des Containers. Kenne mich aber Null mit den NAS aus. -

@OliverIO In der Doku steht: "By default, InfluxDB outputs all logs to stdout."

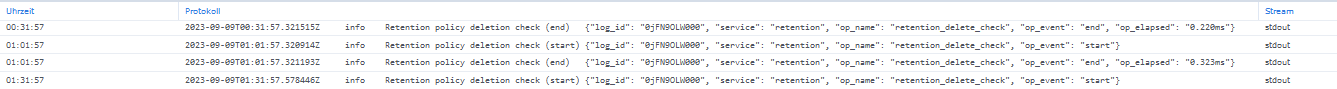

Wenn ich das richtig sehe, dann habe ich diesen Stream in meinem UI vom Docker sichtbar:

Allerdings taucht da nix nenneswertes auf.

Da der Default Log-Level auf "Info" steht sollte hier nicht das Problem sein, sondern ich gehe davon aus, dass meine Queries gar nicht erst ankommen und daher nicht im Log auftauchen.@Marc-Berg Leider kenne ich mich auch nicht wirklich mit Docker aus. Ich habe es nur genutzt, um unkompliziert eine InfluxDB aufzusetzen. Ich habe auch schon darüber nachgedacht die Daten in die Cloud zu stecken, so richtig begeistert bin ich von dem Gedanken allerdings nicht.

Oder ich setze doch wieder auf MySQL. Das läuft auf meinem NAS als direkte Applikation ohne Docker und war von außen immer problemlos erreichbar.

Leider gibt es für InfluxDB keine Software, die unkompliziert Queries ausführen könnte (analog MySQL Workbench).

Ich hatte TimeSeriesAdmin ausprobiert, allerdings ohne Erfolg.

Ich wollte auch Power BI ausprobieren, allerdings hat das Probleme mit Anaconda, sodass ich hier erstmal Python ans Laufen bekommen muss. Power BI bietet noch andere Verbindungsmöglichkeiten, die ich jedoch alle ebenfalls nicht beherrsche. -

@OliverIO Das log wirft nur "info" aus, kein "debug".

Wenn ich in der Konsoleinfluxd --log-level=infostarte, dann kommen wesentlich mehr Meldungen. Dieser werden allerdings nicht gelogt.

Also habe ich die config-Datei gesucht. Im Verzeichnis/etc/influxdb2/gibt es nur eine Datei:influxdb-configs.

Folgender Inhalt:

Da habe ich nun als erste Zeile folgendes ergänzt:log-level="debug"

Auch nach Docker-Neustart wird noch immer ausschließlich "info" geloggt.In der Konsole das Kommando

influxd --log-level=infoeingegeben bekomme ich einen aktuellen log in der konsole:

Ich bin irritiert, was die letzte Zeile angeht. Sieht irgendwie nach Port-Problemen aus.Da es allerdings mit Grafana problemlos klappt komme ich immer darauf zurück und vermute, dass mit dem Python-Script etwas nicht stimmt.

-

@OliverIO Das log wirft nur "info" aus, kein "debug".

Wenn ich in der Konsoleinfluxd --log-level=infostarte, dann kommen wesentlich mehr Meldungen. Dieser werden allerdings nicht gelogt.

Also habe ich die config-Datei gesucht. Im Verzeichnis/etc/influxdb2/gibt es nur eine Datei:influxdb-configs.

Folgender Inhalt:

Da habe ich nun als erste Zeile folgendes ergänzt:log-level="debug"

Auch nach Docker-Neustart wird noch immer ausschließlich "info" geloggt.In der Konsole das Kommando

influxd --log-level=infoeingegeben bekomme ich einen aktuellen log in der konsole:

Ich bin irritiert, was die letzte Zeile angeht. Sieht irgendwie nach Port-Problemen aus.Da es allerdings mit Grafana problemlos klappt komme ich immer darauf zurück und vermute, dass mit dem Python-Script etwas nicht stimmt.

@christiansr sagte in Python-Zugriff auf InfluxDB im Docker:

Ich bin irritiert, was die letzte Zeile angeht. Sieht irgendwie nach Port-Problemen aus.

Moin,

nein, wenn Du den Docker Container startest, dann wird auch

influxDBgestartet, dann versuchst Du den Datenbankmanager nochmals zu starten, aber mit der gleichen Konfiguration, das geht nicht, da der Port 8086 schon in Benutzung ist.VG

Bernd -

@christiansr sagte in Python-Zugriff auf InfluxDB im Docker:

Ich bin irritiert, was die letzte Zeile angeht. Sieht irgendwie nach Port-Problemen aus.

Moin,

nein, wenn Du den Docker Container startest, dann wird auch

influxDBgestartet, dann versuchst Du den Datenbankmanager nochmals zu starten, aber mit der gleichen Konfiguration, das geht nicht, da der Port 8086 schon in Benutzung ist.VG

Bernd@dp20eic den Datenbankmanager zweimal zu starten macht natürlich keinen Sinn. Eigentlich will ich nur den log-level erhöhen, was mir jedoch nicht gelungen ist. In der Doku klingt das so einfach :

log-level = "info"ergänzen.

Ist es richtig die Zeile einfach an den Anfang der Config-Datei zu schreiben oder gehört das unter irgend einen[Abschnitt]? -

@dp20eic den Datenbankmanager zweimal zu starten macht natürlich keinen Sinn. Eigentlich will ich nur den log-level erhöhen, was mir jedoch nicht gelungen ist. In der Doku klingt das so einfach :

log-level = "info"ergänzen.

Ist es richtig die Zeile einfach an den Anfang der Config-Datei zu schreiben oder gehört das unter irgend einen[Abschnitt]?@christiansr sagte in Python-Zugriff auf InfluxDB im Docker:

Ist es richtig die Zeile einfach an den Anfang der Config-Datei zu schreiben oder gehört das unter irgend einen [Abschnitt]?

Moin,

nope und ja :)

Ich schau’ mal, melde mich später noch einmal.

Edit

Also, da habe ich mich wohl getäuscht, ist anscheinend doch egal wo es steht, ich würde Änderungen, aber immer am Ende machen.Vielleicht ist nur die Schreibweise falsch.

Wenn Konfig eineyamlDatei, dannlog-level: infoWenn Konfig eine

tomlDatei, dannlog-level = "info"Wenn Konfig eine

json, dann{ "log-level": "info" }Ich würde es mal so versuchen

[default] url = "http://localhost:8086" token = "5kPlL7izVhHLQXMJN81lRWjiC7iNGGHQtBIWvxmbxUGIXMV2GfMnZNGzYnqkJ5ktY_Ly5Fp-ddr0ODbHqvM2nA==" org = "hausautomation" active = true log-level = debugVG

Bernd -

@christiansr sagte in Python-Zugriff auf InfluxDB im Docker:

Ist es richtig die Zeile einfach an den Anfang der Config-Datei zu schreiben oder gehört das unter irgend einen [Abschnitt]?

Moin,

nope und ja :)

Ich schau’ mal, melde mich später noch einmal.

Edit

Also, da habe ich mich wohl getäuscht, ist anscheinend doch egal wo es steht, ich würde Änderungen, aber immer am Ende machen.Vielleicht ist nur die Schreibweise falsch.

Wenn Konfig eineyamlDatei, dannlog-level: infoWenn Konfig eine

tomlDatei, dannlog-level = "info"Wenn Konfig eine

json, dann{ "log-level": "info" }Ich würde es mal so versuchen

[default] url = "http://localhost:8086" token = "5kPlL7izVhHLQXMJN81lRWjiC7iNGGHQtBIWvxmbxUGIXMV2GfMnZNGzYnqkJ5ktY_Ly5Fp-ddr0ODbHqvM2nA==" org = "hausautomation" active = true log-level = debugVG

Bernd@dp20eic said in Python-Zugriff auf InfluxDB im Docker:

Vielleicht ist nur die Schreibweise falsch.

Ich habe keine Ahnung, ob ich TOML oder YAML brauche. Die bereits vorhandene Syntax ließ mich auf TOML schließen.Ich würde es mal so versuchen

[default] url = "http://localhost:8086" token = "5kPlL7izVhHLQXMJN81lRWjiC7iNGGHQtBIWvxmbxUGIXMV2GfMnZNGzYnqkJ5ktY_Ly5Fp-ddr0ODbHqvM2nA==" org = "hausautomation" active = true log-level = debuggetestet - keine Änderung.

-

@dp20eic said in Python-Zugriff auf InfluxDB im Docker:

Vielleicht ist nur die Schreibweise falsch.

Ich habe keine Ahnung, ob ich TOML oder YAML brauche. Die bereits vorhandene Syntax ließ mich auf TOML schließen.Ich würde es mal so versuchen

[default] url = "http://localhost:8086" token = "5kPlL7izVhHLQXMJN81lRWjiC7iNGGHQtBIWvxmbxUGIXMV2GfMnZNGzYnqkJ5ktY_Ly5Fp-ddr0ODbHqvM2nA==" org = "hausautomation" active = true log-level = debuggetestet - keine Änderung.

@christiansr sagte in Python-Zugriff auf InfluxDB im Docker:

getestet - keine Änderung.

Moin,

habs vielleicht überlesen, aber welches Docker Image nutzt Du denn?

Würde das dann mal, morgen nachstellen.VG

Bernd -

@christiansr sagte in Python-Zugriff auf InfluxDB im Docker:

getestet - keine Änderung.

Moin,

habs vielleicht überlesen, aber welches Docker Image nutzt Du denn?

Würde das dann mal, morgen nachstellen.VG

Bernd@dp20eic said in Python-Zugriff auf InfluxDB im Docker:

habs vielleicht überlesen, aber welches Docker Image nutzt Du denn?

influxdb:latest

https://registry.hub.docker.com/_/influxdb/ -

@dp20eic said in Python-Zugriff auf InfluxDB im Docker:

habs vielleicht überlesen, aber welches Docker Image nutzt Du denn?

influxdb:latest

https://registry.hub.docker.com/_/influxdb/@christiansr sagte in Python-Zugriff auf InfluxDB im Docker:

@dp20eic said in Python-Zugriff auf InfluxDB im Docker:

habs vielleicht überlesen, aber welches Docker Image nutzt Du denn?

influxdb:latest

https://registry.hub.docker.com/_/influxdb/Moin,

so wie es aussieht, muss der

Log Levelbeim Start mittels Environment mitgegeben werden

Beispiel:docker run -d -p 8086:8086 \ -v $PWD/data:/var/lib/influxdb2 \ -v $PWD/config:/etc/influxdb2 \ -e DOCKER_INFLUXDB_INIT_MODE=setup \ -e DOCKER_INFLUXDB_INIT_USERNAME=my-user \ -e DOCKER_INFLUXDB_INIT_PASSWORD=my-password \ -e DOCKER_INFLUXDB_INIT_ORG=my-org \ -e DOCKER_INFLUXDB_INIT_BUCKET=my-bucket \ -e INFLUXD_LOG_LEVEL=info influxdb:2.0Oder Du musst

INFLUXD_LOG_LEVEL=infoda mit angeben, wo Du auch die anderen Einstellungen vorgenommen hast.VG

Bernd