NEWS

Einbindung (IP) Kamera über "Motion"

-

@lobomau Vielen Dank.

Was für ein Format streamen denn deine Kameras?

Ich streame grade via rstp im Videoformat VBR. Bitrate habe ich 2000 Kbits eingestellt und Frames aktuell 10 pro Sekunde. Videogröße ist 1270x720.

@martinschm muss ich mal genau schauen. Ich glaube meistens habe ich 10 frames in den cameras eingestellt. Die wansview ist über rtsp, die anderen beiden über http.

-

@martinschm muss ich mal genau schauen. Ich glaube meistens habe ich 10 frames in den cameras eingestellt. Die wansview ist über rtsp, die anderen beiden über http.

@lobomau wäre super, wenn du mal schauen könntest. Hatte irgendwo was gelesen, das motioneye den Stream decodiert und wieder codiert, das erzeugt dann wohl auch Last

-

@lobomau wäre super, wenn du mal schauen könntest. Hatte irgendwo was gelesen, das motioneye den Stream decodiert und wieder codiert, das erzeugt dann wohl auch Last

@martinschm also bei meinen cameras steht:

FDT 720p: http, 1280 x 720, bitrate: 4096 kbps, 10 frames, bitcontrol: VBR,

wansview w2: rtsp, 1920 x 1080, bitrate: 2048 kbps, 10 frames, bitcontrol: VBR,

Edimax: http, 1280 x 960, 20 frames -

@martinschm also bei meinen cameras steht:

FDT 720p: http, 1280 x 720, bitrate: 4096 kbps, 10 frames, bitcontrol: VBR,

wansview w2: rtsp, 1920 x 1080, bitrate: 2048 kbps, 10 frames, bitcontrol: VBR,

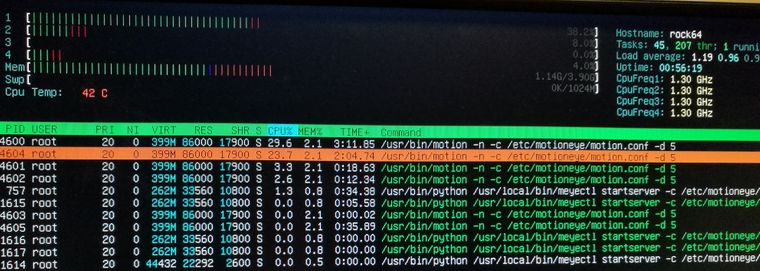

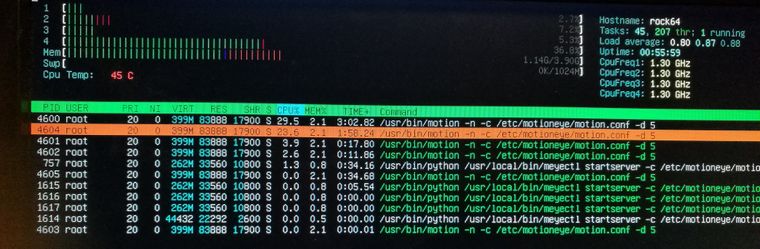

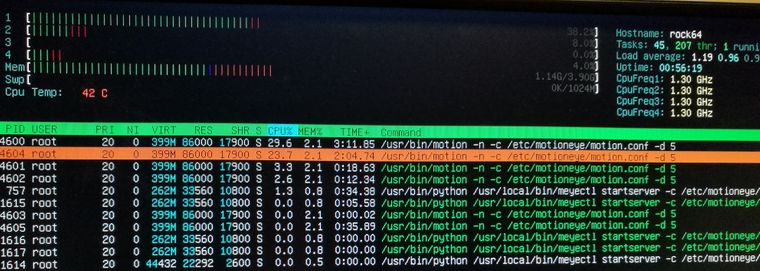

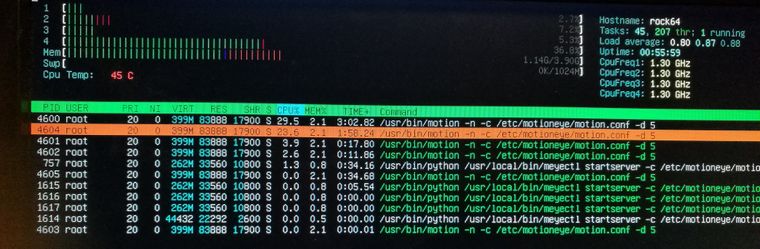

Edimax: http, 1280 x 960, 20 frames@lobomau bei mir sieht es in htop so aus mit zwei Kameras und Bewegungsüberwachung

Beide via rstp 7 frames bei 2000 kbps mit VBR und 960x540 Auflösung. Da hat jeder motion process über 25% CPU oder lese ich das falsch?

-

@lobomau bei mir sieht es in htop so aus mit zwei Kameras und Bewegungsüberwachung

Beide via rstp 7 frames bei 2000 kbps mit VBR und 960x540 Auflösung. Da hat jeder motion process über 25% CPU oder lese ich das falsch?

@martinschm ich kenne mich damit nicht aus. Bei mir zeigt "top" wenn ich im server einlogge 50-70% für motion an. Und manchmal >200% kvm. Für motioneye hab ich aber einen eigenen Container laufen. Eigentlich dachte ich dass ich keinen motion process sehen würde beim Server.

-

Ok. Super. Fangen wir mal an.

Grundvoraussetzung um den iobroker Motion Adapter zu nutzen ist natürlich ein funktionierender motion daemon. Dieser Dienst muss nicht zwangsweise auf dem gleichen System laufen wie iobroker, da der Adapter mit diesem via Netzwerk spricht.

Da Motion rtsp nativ erst in einer neueren Version unterstützt (ich benutze 4.0.1) ergeben sich zwei unterschiedliche Möglichkeiten. Beide haben vor und Nachteile.

1.) Man nutzt eine aktuelle Version von Motion.

2.) Man benutzt eine ältere Version von Motion und macht rtsp und decodierung des h264 streams extern.

Die Vorteile von Variante 1 liegen auf der Hand. Weniger Komplexität und daher vermeintlich höhere Stabilität.

Die Nachteile von Variante 1: H264 decodierung in Software (daher höhere cpu last)

Die Vorteile von Variante 2: Höhere Flexibilität bei Quelle und Decodierung. Alles was gstreamer kann, kann auch mit motion verwendet werden. (inkl. omxdecode auf der rpi gpu)

Die Nachteile von Variante 2: Höhere Komplexität. Vor dem Motion dameon muss noch ein loopback modul geladen werden und eine gstreamer pipeline muss eingerichtet werden. Das sind alles Dinge die abspacken können.

Vorschlag:

Wenn motion auf einer Kiste läuft, die wenig CPU aber die Möglichkeit von GPU Decoding hat (vaapi, omx usw.) wie z.b. der rpi dann empfehle ich Variante 2.

Wenn man keine Möglichkeit des GPU Decodings hat, oder genug cpu power dann empfehle ich Variante 1.

Wenn das alles läuft, können wir uns um den Adapter kümmern.

@ruhigundrelaxed sag mal, ist das Thema mit dem GPU decoden immer nur noch in der "alten" Version von Motioneye und mit Loopback möglich oder hat sich da in den letzten Monaten was getan? Habe eine VM mit GPU erstellt und würde Motioneye hier möglichst CPU-Ressourcensparend laufen lassen => GPU soll die möglichen Aufgaben übernehmen... Wie kann ich das einstellen und vor allem am System sehen / testen?

-

Das Thema ist zwar schon ein paar Tage alt, aber vielleicht hat der eine oder andere MotionEye Nutzer einen Tip für mich.

Bei mir laufen 5 Kameras über einen RPI 3B+. Ich nutze den rtsp Stream Link um die Kamera Bilder in ioB anzuzeigen.

Dabei ist mir schon vor einiger Zeit aufgefallen, das die Bilder die über MotionEyeOS ruaskommen, teilweise mehrere MINUTEN gegenüber dem Livebild der Kamera verzögert sind.

Hat jemand eine Idee woran das liegen kann? An der Menge der Kameras liegt es nicht, denn das Phänomen tritt auch im "Ein Kamera Modus" auf.

-

Das Thema ist zwar schon ein paar Tage alt, aber vielleicht hat der eine oder andere MotionEye Nutzer einen Tip für mich.

Bei mir laufen 5 Kameras über einen RPI 3B+. Ich nutze den rtsp Stream Link um die Kamera Bilder in ioB anzuzeigen.

Dabei ist mir schon vor einiger Zeit aufgefallen, das die Bilder die über MotionEyeOS ruaskommen, teilweise mehrere MINUTEN gegenüber dem Livebild der Kamera verzögert sind.

Hat jemand eine Idee woran das liegen kann? An der Menge der Kameras liegt es nicht, denn das Phänomen tritt auch im "Ein Kamera Modus" auf.

Internetleitung ausgelastet?

Zuviele Geräte?

Hab ne 50er Leitung und die ist arg strapaziert mit knapp 35 Geräten. -

Internet dürfte damit nichts zu tun haben, weil alle Geräte, einschließlich ioB im selben IP Kreis unterwegs sind.

Internet ist eine 200er Leitung - das nur am Rand und 60 aktive Geräte sollten jetzt auch Netzintern nicht so das Problem sein.

-

Internet dürfte damit nichts zu tun haben, weil alle Geräte, einschließlich ioB im selben IP Kreis unterwegs sind.

Internet ist eine 200er Leitung - das nur am Rand und 60 aktive Geräte sollten jetzt auch Netzintern nicht so das Problem sein.

Beim Kamera streamen hat die Leitung schon ein besonderes Augenmerk ;)

Aber ich denke die 200er sollte tatsächlich reichen.

Bin über dein Post gestolpert weil ich gerade in MotionEye rumfummel :)

3 Kameras, ruckelfreies streamen sieht anders aus :( -

Ich verwende auch keinen echten Livestream, sondern hole mir alle 1 Sekunde ein neues Standbild ab. Für meine Zwecke reicht das - es nervt nur kolossal, wenn es an der Haustür klingelt und lt. Kamerabild ist niemand da weil die Bilder 2-3 Minuten hinter dem echten Livebild hinterher hinken.

-

Ich verwende auch keinen echten Livestream, sondern hole mir alle 1 Sekunde ein neues Standbild ab. Für meine Zwecke reicht das - es nervt nur kolossal, wenn es an der Haustür klingelt und lt. Kamerabild ist niemand da weil die Bilder 2-3 Minuten hinter dem echten Livebild hinterher hinken.

Das kenne ich :) :)

Wie hast du das umgesetzt?

Bei mir war es der Versatz von Bild machen und bereitstellen.

Da war die Zeit zu kurz.

Nun geht es so lala. -

was meinst du mit umgesetzt?

-

was meinst du mit umgesetzt?

Ich hab das über MotionEye, Javascript und dann in die VIS

-

Ja, genau, in MotionEye als Video Device den RTSP Stream der Kamera ausgewählt. Dann in MotionEye unter Video Streaming die Snapshot URL ausgewählt und diese dann im VIS Editor als "basic - Image 8" unter Symbol URL diese Snapshot URL eingetragen - Updatezeit 1000 ms.

Wie hast du das gemacht?

-

Ja, genau, in MotionEye als Video Device den RTSP Stream der Kamera ausgewählt. Dann in MotionEye unter Video Streaming die Snapshot URL ausgewählt und diese dann im VIS Editor als "basic - Image 8" unter Symbol URL diese Snapshot URL eingetragen - Updatezeit 1000 ms.

Wie hast du das gemacht?

Ich hab nen HTTP Stream und im Javascript dann die Snapshot URL.

Mit der lasse ich das Bild in den VIS.0 Ordner speichern und rufe das Foto in der VIS mit dem Basic Image ab. -

Warum dieser Zwischenschritt mit dem Javaskript (was steht da drin)?

-

Warum dieser Zwischenschritt mit dem Javaskript (was steht da drin)?

Weil ich das Bild noch an Telegram sende.

var timeout, timeout1, timeout2; var fs = require('fs'); on({id: 'hm-XXXXXXXXXXXXX.1.PRESS_SHORT', change: "any"}, function (obj) { var value = obj.state.val; var oldValue = obj.oldState.val; timeout = setTimeout(function () { exec('wget --output-document /opt/iobroker/iobroker-data/tmp/alarm.jpg \'http://192.XX.XX.XX:X/picture/1/current/\''); }, 2000); timeout1 = setTimeout(function () { const bild = fs.readFileSync('/opt/iobroker/iobroker-data/tmp/alarm.jpg'); writeFile('vis.0','alarm.jpg', bild); }, 4000); timeout2 = setTimeout(function () { sendTo("telegram.1", "send", { text: '/opt/iobroker/iobroker-data/files/vis.0/alarm.jpg' }); }, 6000); // ab hier so oft wiederholen wie man es möchte }); -

Internet dürfte damit nichts zu tun haben, weil alle Geräte, einschließlich ioB im selben IP Kreis unterwegs sind.

Internet ist eine 200er Leitung - das nur am Rand und 60 aktive Geräte sollten jetzt auch Netzintern nicht so das Problem sein.

@JB_Sullivan sagte in Einbindung (IP) Kamera über "Motion":

Internet dürfte damit nichts zu tun haben, weil alle Geräte, einschließlich ioB im selben IP Kreis unterwegs sind.

Internet ist eine 200er Leitung - das nur am Rand und 60 aktive Geräte sollten jetzt auch Netzintern nicht so das Problem sein.

Du hast schon recht. Deine Internet Anbindung hat bei interner Nutzung nicht mit ruckeln oder Verzögerungen zu tun.

Allerdings denke ich das je nach Einstellungen in motioneye und Art der Kameras (Auflösung) der Pi an seiner Leistungsgrenze ist.

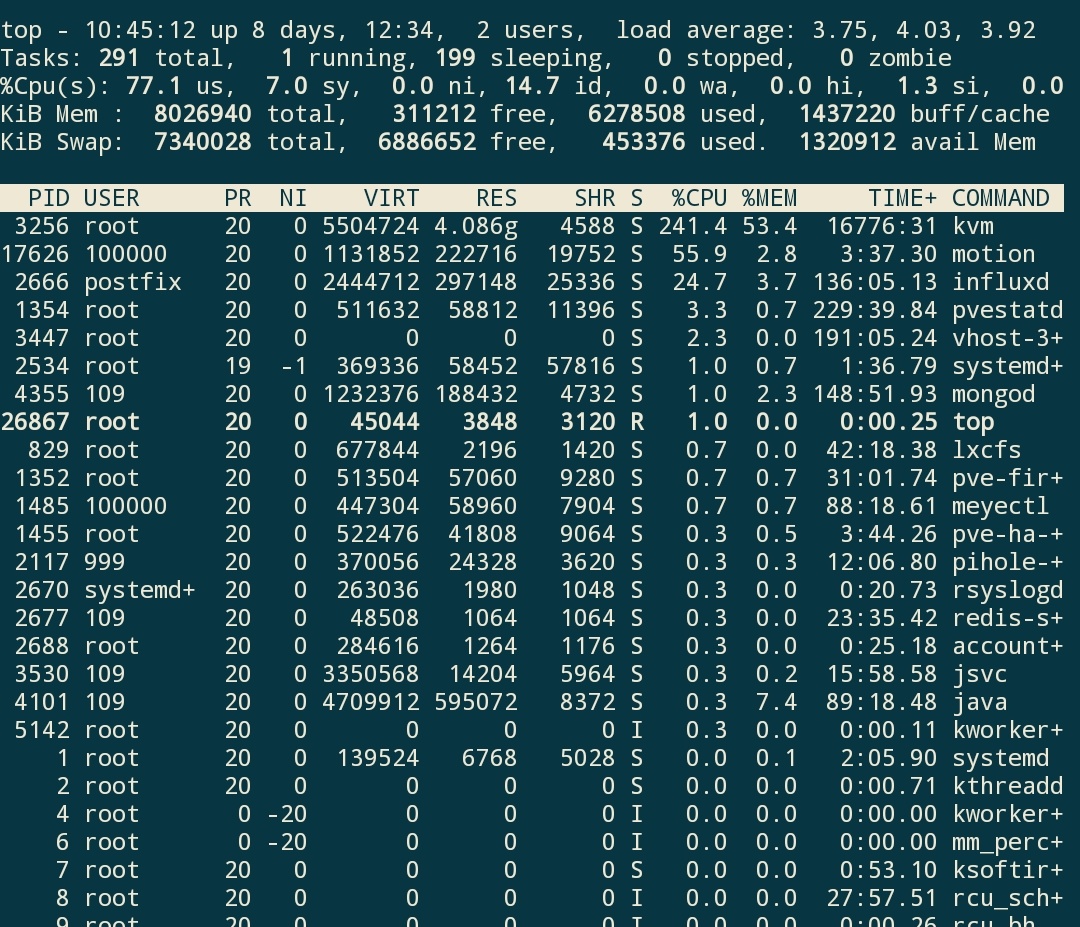

Hast du dir mal mit

topDie Prozessor Auslastung angesehen oder das Motion log?

-

@JB_Sullivan sagte in Einbindung (IP) Kamera über "Motion":

Internet dürfte damit nichts zu tun haben, weil alle Geräte, einschließlich ioB im selben IP Kreis unterwegs sind.

Internet ist eine 200er Leitung - das nur am Rand und 60 aktive Geräte sollten jetzt auch Netzintern nicht so das Problem sein.

Du hast schon recht. Deine Internet Anbindung hat bei interner Nutzung nicht mit ruckeln oder Verzögerungen zu tun.

Allerdings denke ich das je nach Einstellungen in motioneye und Art der Kameras (Auflösung) der Pi an seiner Leistungsgrenze ist.

Hast du dir mal mit

topDie Prozessor Auslastung angesehen oder das Motion log?

Das LOG habe ich mir schon angeguckt, aber wirklich anfangen kann ich damit nichts

[0:motion] [NTC] [ALL] conf_load: Processing thread 0 - config file /data/etc/motion.conf [0:motion] [NTC] [ALL] config_camera: Processing camera config file camera-2.conf [0:motion] [NTC] [ALL] config_camera: Processing camera config file camera-1.conf [0:motion] [NTC] [ALL] config_camera: Processing camera config file camera-4.conf [0:motion] [NTC] [ALL] config_camera: Processing camera config file camera-3.conf [0:motion] [NTC] [ALL] config_camera: Processing camera config file camera-5.conf [0:motion] [NTC] [ALL] motion_startup: Logging to syslog [0:motion] [NTC] [ALL] motion_startup: Motion 4.2.2+gitUNKNOWN Started [0:motion] [NTC] [ALL] motion_startup: Using default log type (ALL) [0:motion] [NTC] [ALL] motion_startup: Using log type (ALL) log level (WRN) [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [7:nc7:Kellereinga] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] Above message repeats 1 times [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [9:nc9:PTZDach] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [7:nc7:Kellereinga] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] Above message repeats 1 times [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [9:nc9:PTZDach] [ERR] [NET] Above message repeats 1 times [9:nc9:PTZDach] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [7:nc7:Kellereinga] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [9:nc9:PTZDach] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [9:nc9:PTZDach] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [7:nc7:Kellereinga] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [9:nc9:PTZDach] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [9:nc9:PTZDach] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [7:nc7:Kellereinga] [ERR] [NET] Above message repeats 1 times [7:nc7:Kellereinga] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [9:nc9:PTZDach] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [7:nc7:Kellereinga] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [9:nc9:PTZDach] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] Above message repeats 1 times [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [9:nc9:PTZDach] [ERR] [NET] Above message repeats 1 times [9:nc9:PTZDach] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [7:nc7:Kellereinga] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] Above message repeats 1 times [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] Above message repeats 1 times [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [7:nc7:Kellereinga] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [9:nc9:PTZDach] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [9:nc9:PTZDach] [ERR] [NET] Above message repeats 1 times [9:nc9:PTZDach] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [7:nc7:Kellereinga] [ERR] [NET] Above message repeats 1 times [7:nc7:Kellereinga] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [7:nc7:Kellereinga] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] Above message repeats 1 times [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [7:nc7:Kellereinga] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] Above message repeats 3 times [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [7:nc7:Kellereinga] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [9:nc9:PTZDach] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [6:nc6:HaustuerHD] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] Above message repeats 1 times [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [9:nc9:PTZDach] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [7:nc7:Kellereinga] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [9:nc9:PTZDach] [ERR] [NET] Above message repeats 1 times [9:nc9:PTZDach] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [7:nc7:Kellereinga] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [7:nc7:Kellereinga] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [8:nc8:Terrasse] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [9:nc9:PTZDach] [ERR] [NET] Above message repeats 4 times [9:nc9:PTZDach] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [8:nc8:Terrasse] [ERR] [NET] Above message repeats 6 times [8:nc8:Terrasse] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [8:nc8:Terrasse] [ERR] [NET] Above message repeats 9 times [8:nc8:Terrasse] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [8:nc8:Terrasse] [ERR] [NET] Above message repeats 20 times [8:nc8:Terrasse] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [8:nc8:Terrasse] [ERR] [NET] Above message repeats 2 times [8:nc8:Terrasse] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [8:nc8:Terrasse] [ERR] [NET] Above message repeats 9 times [8:nc8:Terrasse] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [7:nc7:Kellereinga] [ERR] [NET] Above message repeats 4 times [7:nc7:Kellereinga] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [10:nc10:EzViz] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera.... [9:nc9:PTZDach] [ERR] [NET] Above message repeats 1 times [9:nc9:PTZDach] [ERR] [NET] netcam_rtsp_handler_reconnect: Normal resolution: Reconnecting with camera....Top sieht so aus:

Mem: 408056K used, 357540K free, 2364K shrd, 8224K buff, 57348K cached CPU: 73% usr 1% sys 0% nic 24% idle 0% io 0% irq 0% sirq Load average: 2.74 3.02 3.14 4/136 18911Ich denke für 5 Kameras ist 73 - 77% CPU Last OK. Mein Pi wird ohnehin mit einem aktiven Lüfter gekühlt.

Was halt Auffällig ist, das scheinbar immer wieder ein Network Restart gemacht wird.