NEWS

NEU ioBroker Alexa Custom Skill verfügbar!

-

Habe inzwischen auch den Custom iobroker skill und den iot Adapter laufen.

Soweit so gut, text2command tut auch was es soll, und eine Antwort lasse ich aktuell per script generieren und gebe diese über Alexa2 >> speak wieder aus.

Wirklich klasse wäre es jedoch, wenn Text2 command auch wüsste/mitteilen könnte, von welchem meiner Echo dots die Anfrage kam, damit die Antwort am selben Gerät ausgegeben werden kann.

-

Bei text2Command kannst Du die Antwort direkt definieren die zurückgegeben wird bzw nutze die text2command Möglichkeiten, dann kommt die Antwort genau da raus wo Du reingesprochen hast.

Nur wenn Du sowas wie an der Stelle mit Alexa2-Speak machst dann ist das so.

-

Das war mir im Prinzip klar, jedoch wird meine Antwort von einem script erstellt.

Wie bekomme ich die Ausgabe vom Script in die Ausgabe vom text2command?

Die Info, von welchem Gerät der Befehl kommt, wäre aber auch in vielen anderen Anwendungen sinnvoll und hilfreich!

Zum Adapter selbst: Klasse Sache, da habe ch jede Menge Ideen!

Den 8ten Ansprache-Typ könnte ich übrigens ganz gut brauchen…

Da "Sage iobroker gute Nacht " nicht funktioniert und "schalte gute nacht ein" nicht gut klingt, wäre "sage iobroker, ich gehe schlafen" eine gute Möglichkeit.

Ich verlasse das Haus, ich bin bis 15 Uhr außer Haus, ich .....

wären andere Beispiele... "Du" wäre sicher auch manchmal nützlich..

"Er", "Sie" etc halte ich auch nicht für sehr hilfreich...

-

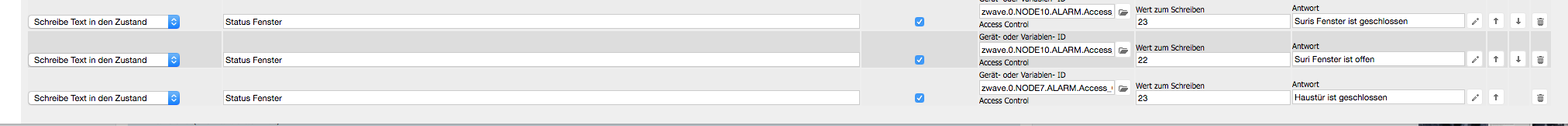

Bei mir läuft der Skill nach dem heutigen Upgrade auf den Pro Account auch. Aber ein Problem habe ich aktuell, ich möchte den Status der Fenster abfragen (dafür habe ich ein ZWave Sensor vor mir liegen und einen an der Haustür bereits installiert den ich als Fenster missbrauche) ich habe in Text2Command alles korrekt eingetragen und er sagt mir auch Fenster ist geöffnet/geschlossen aber er arbeitet nur den ersten Eintrag im T2C ab und stoppt dann. Ich möchte aber das er mir alle "Fenster" Stati ansagt. Wo ist mein Ansatz im T2C falsch?

-

Okayyy jetzt habe ich es gerafft. Er liesst mir alle Stati, vor unabhängig vom Status.

Sprich, er sagt mir welches "Fenster" sich in welchen Zustand befindet.

Ich dachte aufgrund der Doku,

…..

1.) Statusabfragen (Typ-Text für Text2Command: askDevice) - Implementiert

- ... welche (Fenster offen sind)

.....

habe ich die Möglichkeit, nur die offenen Fenster abzufragen. Aber Echo sagt mir eigentlich nur in welchen Zustand, sich die jeweiligen Fenster befinden (Auf oder Zu) und das arbeitet er für jeden eingetragenen T2C bzw. Aktor ab.

Also nur die offenen Fenster aufzuzählen ist an der Stelle nicht möglich.

Sry für mein Denkfehler :-(

-

Das geht über Helfer-States. Also ich habe mehrere "Zähl-Skripte" die Dinge prüfen und Anzahlen und Listen in States schreiben weil ich die an mehreren Stellen verwende. Die nutze ich dann hier für die Ausgabe und auch für Telegram und all sowas.

-

Das war mir im Prinzip klar, jedoch wird meine Antwort von einem script erstellt.

Wie bekomme ich die Ausgabe vom Script in die Ausgabe vom text2command?

Die Info, von welchem Gerät der Befehl kommt, wäre aber auch in vielen anderen Anwendungen sinnvoll und hilfreich!

Zum Adapter selbst: Klasse Sache, da habe ch jede Menge Ideen!

Den 8ten Ansprache-Typ könnte ich übrigens ganz gut brauchen…

Da "Sage iobroker gute Nacht " nicht funktioniert und "schalte gute nacht ein" nicht gut klingt, wäre "sage iobroker, ich gehe schlafen" eine gute Möglichkeit.

Ich verlasse das Haus, ich bin bis 15 Uhr außer Haus, ich .....

wären andere Beispiele... "Du" wäre sicher auch manchmal nützlich..

"Er", "Sie" etc halte ich auch nicht für sehr hilfreich... `

Also die Worte kommen schon durch, aber ggf als "komischer Anfragetyp".

"… Guten Tag", "ich gehe schlafen" kommt bei mir mit askDevice problemlos an

"... ich bin bis um 3 unterwegs" kommt als "controlDevice ich bin um drei unterwegs bis" an

Also von daher ist es so das das alles schon ankommt, nur der Anfragetyp ist ggf unpassend. Der Aufwand diese Optionen alle zu erkennen und mit einem eigenen Anfragetyp durchzureichen ohne das wieder bestimmte "trigger-Worte" verschwinden ist recht hoch.

Faktisch kannst Du unter "ignoranz" des Anfragetyps (der in dem Fall eh nicht "mehrfach verwendet" sinn macht) alles schon genau so umsetzen.

-

Danke, ich werde das ausprobieren! 8-)

Was mir noch aufgefallen ist:

Wenn man eine Anfrage stellt, wird ab und an eine Alexa Standard-Ansage gestartet, irgendwas von wegen " ich kann kein…", welche dann aber sofort von der gewünschten Ansage unterbrochen wird.

MfG Mike

-

Kurze Frage. Ich nutze aktuell noch den ioBroker.pro Skill auf meinem Echo Spot. Den brauche ich dann ja nicht mehr und kann ihn entfernen, oder?

Den text2command-Adapter hatte ich in der Vergangenheit für den direkten Zugriff per Telegram konfiguriert. Kann ich diese Text-Kommandos 1:1 für den Alexa Custom Skill verwenden?

Gruß,

Thorsten

-

@dtp:Kurze Frage. Ich nutze aktuell noch den ioBroker.pro Skill auf meinem Echo Spot. Den brauche ich dann ja nicht mehr und kann ihn entfernen, oder? `

Depends. Custom-Skill macht nur text2command. Der pro-Skill erlaubt Smart-Home devices direkt über Alex aohne das du "sage iobroker" sagen musst. ALso As you like :-)

@dtp:Den text2command-Adapter hatte ich in der Vergangenheit für den direkten Zugriff per Telegram konfiguriert. Kann ich diese Text-Kommandos 1:1 für den Alexa Custom Skill verwenden? `

Wenn Du das willst und je nachdem wie deine text-Matches dort gestrickt sind: ja, sonst geht auch eine eigene text2command Instanz.

-

Danke für die schnelle Antwort. Eine Frage noch.

Ist es nicht etwas umständlich, jedes mal "Alexa, frage/sage i o broker…" sagen zu müssen? Schön wäre doch, wenn man hier ein individuelles Schlüsselwort wie z.B. "Haus" oder dergleichen vergeben könnte. "Alexa, frage/sage haus..." gefällt mir irgendwie besser.

-

> Dazu müssen wir aber die "Satzanfänge" definieren (alles und immer alles geht leider doch nicht).Hallo apollon, ist damit gemeint, dass du in diesem Skill noch sinnvolle Anfängssätze bzw. Startsätze für den Skil suchst?

Das man also nicht mehr vorhergehende "Alexa, frage ioBroker […]" sagen mus?

Wenn ich das falsch verstanden habe, verstehe ich noch nicht ganz, warum hier eine Unterscheidung bspw. zum Pro Skill ist. Also warum muss hier der Satzanfang mit ioBroker genannt werden?

Vielen lieben Dank für deine Antwort.

Grüße

-

Jetzt habe ich hier mal eine Frage.

Ich nutze den ioBroker.pro Beta Skill und den iot Adapter.

Nun habe ich auch den Custom Skill installiert und mit meinem Konto verknüpft.

Wie kann ich diesen nun nutzen. Im iot Adapter steht unter "Benutze text2command Instanz" nur "deaktivert" und da lässt sich auch nicht ändern.

Danke und Grüße

-

> Dazu müssen wir aber die "Satzanfänge" definieren (alles und immer alles geht leider doch nicht).Hallo apollon, ist damit gemeint, dass du in diesem Skill noch sinnvolle Anfängssätze bzw. Startsätze für den Skil suchst?

Das man also nicht mehr vorhergehende "Alexa, frage ioBroker […]" sagen mus? `

Ne das lässt sich nicht ändern. EIn Skill wird genau so angesprochen und das definiert Amazon so.

Wenn ich das falsch verstanden habe, verstehe ich noch nicht ganz, warum hier eine Unterscheidung bspw. zum Pro Skill ist. Also warum muss hier der Satzanfang mit ioBroker genannt werden? `

Normaler Skill/Pro Skill: Ist ein sog. "SMart Home SKill". Darüber werden Deine geräte bekannt gemacht und können mit von Amazon vordefinierten Begriffen und Wort/Satzstellungen abgefragt oder geändert werden. Alles sehr starr und alles muss exakt so sein wie es vorgegeben ist

Custom-Skill ist flexibler und erkennt so viel vom gesprochenen text wie geht und liefert diesen text an deine ioBroker Instanz. Dort kannst Du dann per text2command oder Javascript frei entscheiden was Du mit dem text machen willst. Du kannst also so reden wie du willst und musst dich nicht an Amazons konventionen halten (ausser halt dasd der start immer "sage/frage iobroker, …" ist)